Python을 사용하여 CSDN 인기 댓글 URL을 크롤링하고 이를 Redis에 저장하는 방법

1. 웹드라이버를 구성하세요

구글 크롬 드라이버를 다운로드해서 구성하세요

import timeimport randomfrom PIL import Imagefrom selenium import webdriverfrom selenium.webdriver.common.by import Byfrom selenium.webdriver.support.ui import WebDriverWaitfrom selenium.webdriver.support import expected_conditions as ECif __name__ == '__main__':options = webdriver.ChromeOptions()options.binary_location = r'C:UsershhhAppDataLocalGoogleChromeApplication谷歌浏览器.exe'# driver=webdriver.Chrome(executable_path=r'D:360Chromechromedriverchromedriver.exe')driver = webdriver.Chrome(options=options)#以java模块为例driver.get('https://www.csdn.net/nav/java')for i in range(1,20):driver.execute_script("window.scrollTo(0, document.body.scrollHeight)")time.sleep(2)2. URL을 받아보세요

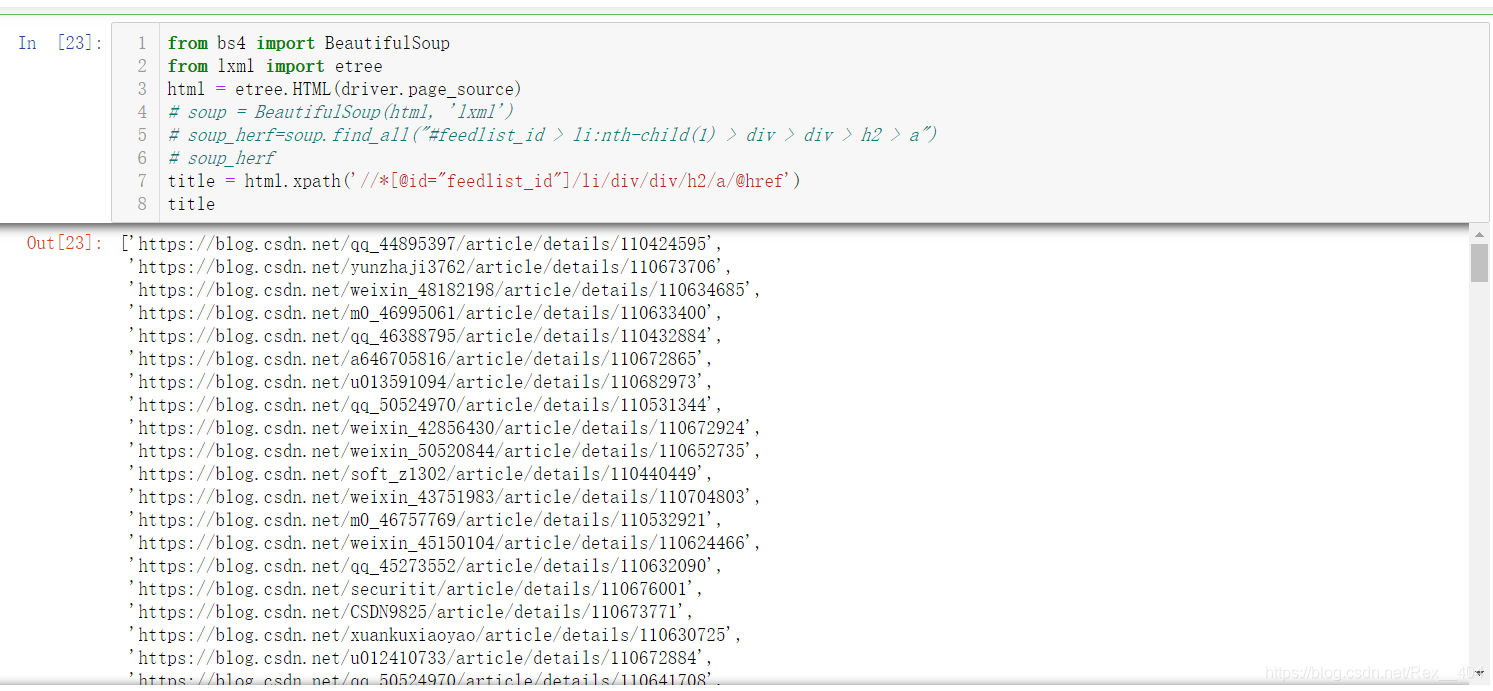

from bs4 import BeautifulSoupfrom lxml import etree

html = etree.HTML(driver.page_source)# soup = BeautifulSoup(html, 'lxml')# soup_herf=soup.find_all("#feedlist_id > li:nth-child(1) > div > div > h2 > a")# soup_herftitle = html.xpath('//*[@id="feedlist_id"]/li/div/div/h2/a/@href')한 번에 많은 내용이 크롤링되고 속도도 엄청 빠른 걸 볼 수 있어요

3. Redis에 쓰기

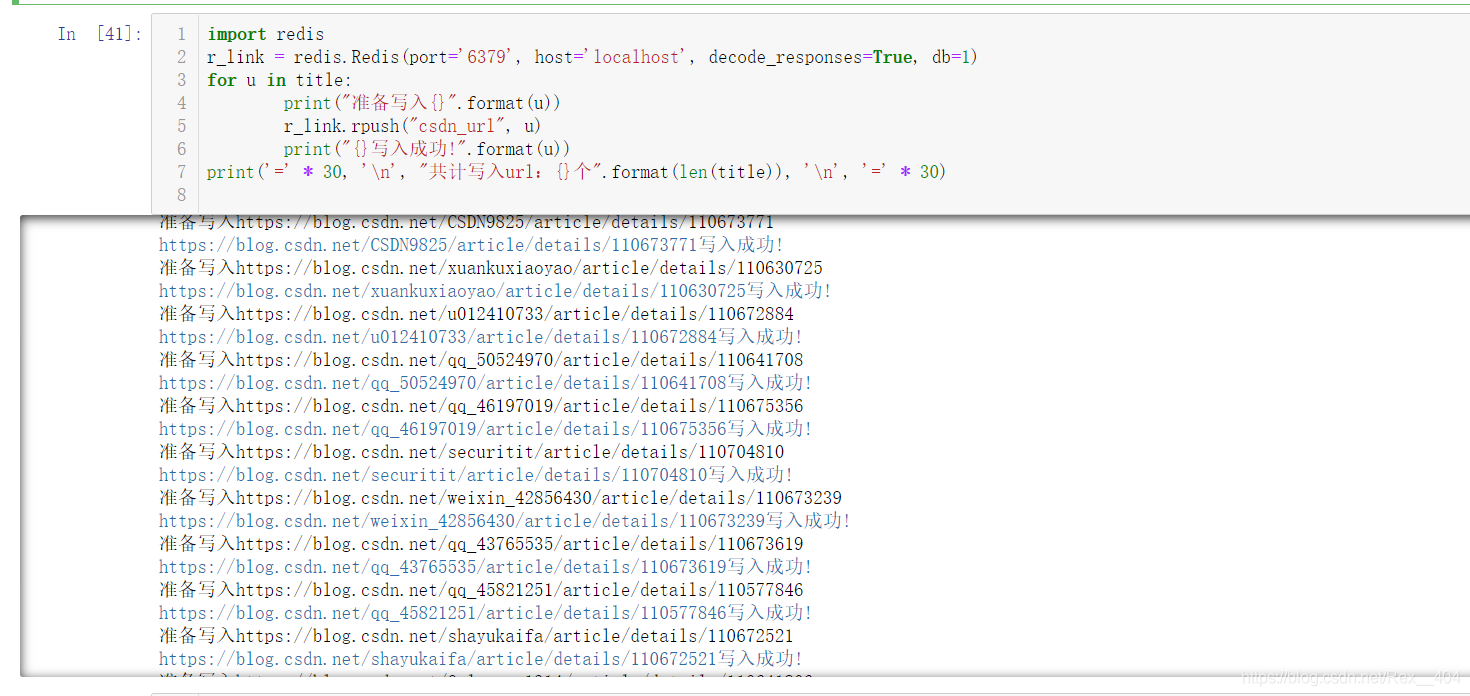

redis 패키지를 가져온 후 ,redis 포트 및 redis 데이터베이스 구성,rpush 함수를 사용하여 쓰기

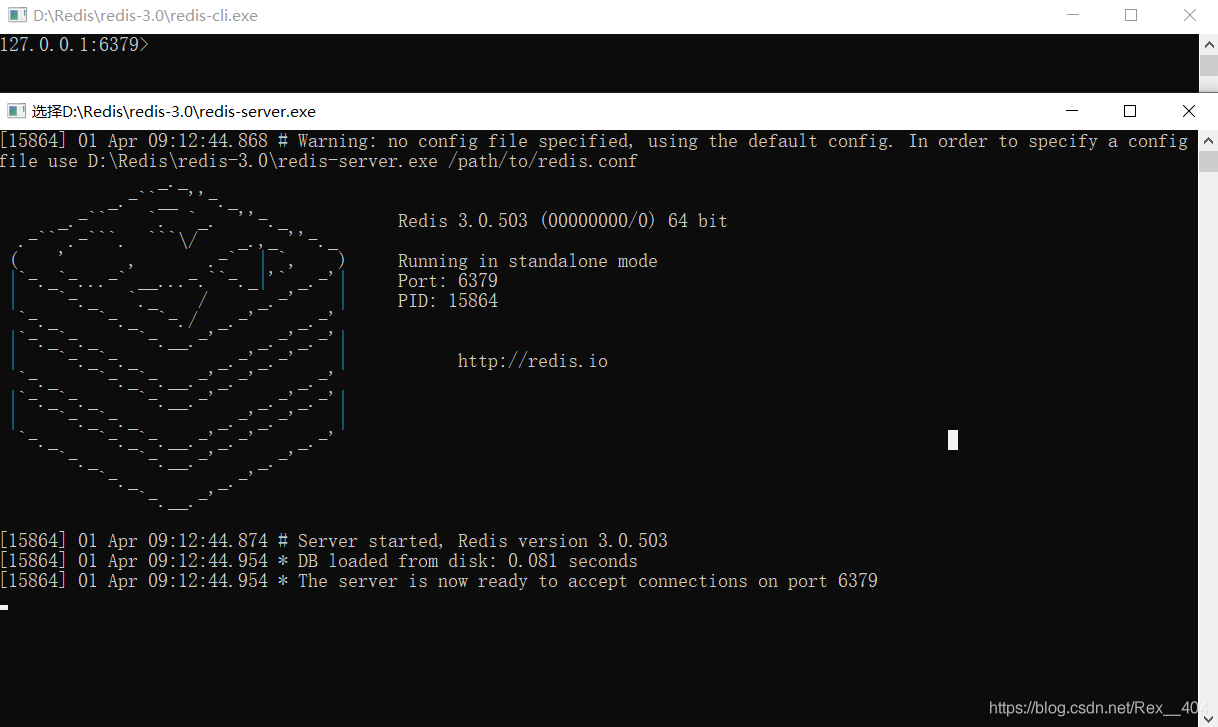

Redis 열기

import redis

r_link = redis.Redis(port='6379', host='localhost', decode_responses=True, db=1)for u in title:print("准备写入{}".format(u))r_link.rpush("csdn_url", u)print("{}写入成功!".format(u))print('=' * 30, 'n', "共计写入url:{}个".format(len(title)), 'n', '=' * 30)

완료되었습니다!

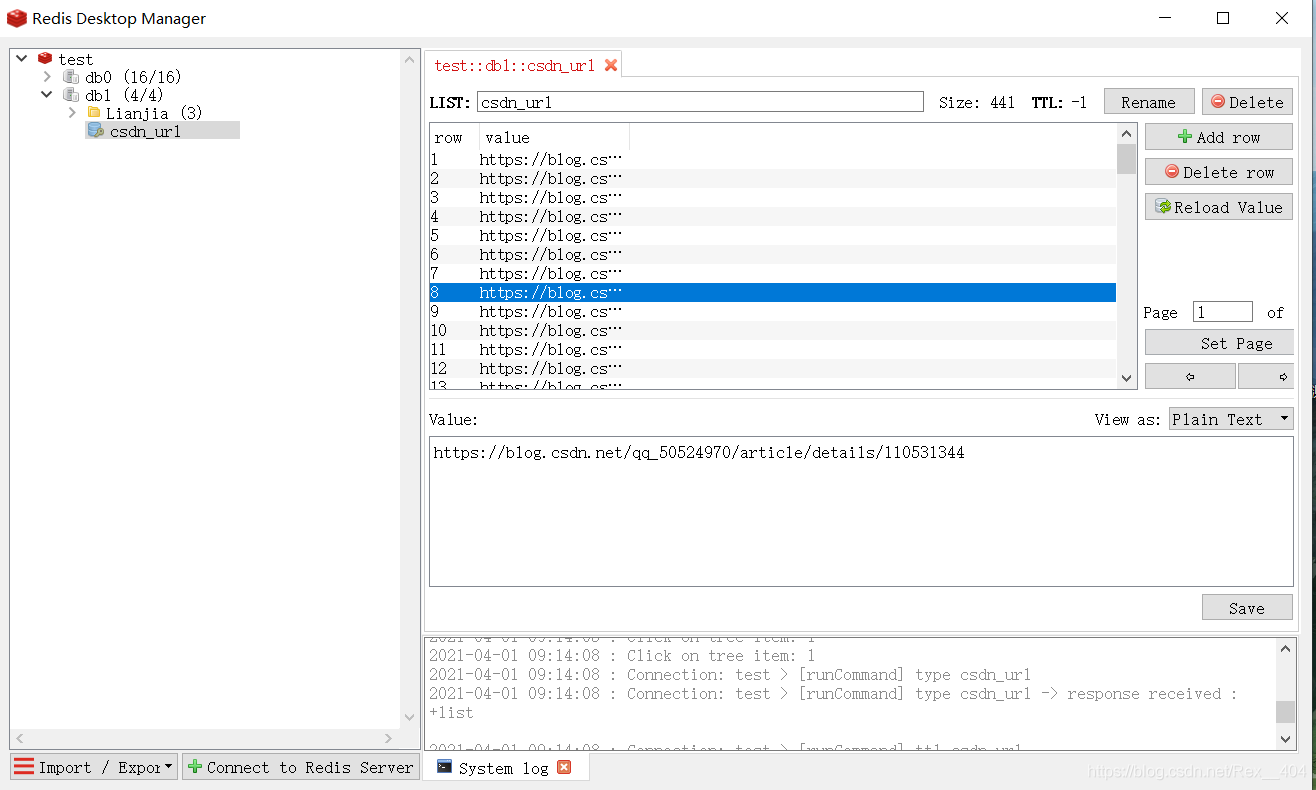

Redis Desktop Manager에서 크롤링 및 쓰기 속도가 매우 빠른 것을 확인할 수 있습니다.

사용하시려면 rpop으로 튀어나오시면 됩니다

one_url = r_link.rpop("csdn_url)")while one_url:print("{}被弹出!".format(one_url))위 내용은 Python을 사용하여 CSDN 인기 댓글 URL을 크롤링하고 이를 Redis에 저장하는 방법의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7467

7467

15

15

1376

1376

52

52

77

77

11

11

47

47

19

19

18

18

20

20

Redis 클러스터 모드를 구축하는 방법

Apr 10, 2025 pm 10:15 PM

Redis 클러스터 모드를 구축하는 방법

Apr 10, 2025 pm 10:15 PM

Redis Cluster Mode는 Sharding을 통해 Redis 인스턴스를 여러 서버에 배포하여 확장 성 및 가용성을 향상시킵니다. 시공 단계는 다음과 같습니다. 포트가 다른 홀수 redis 인스턴스를 만듭니다. 3 개의 센티넬 인스턴스를 만들고, Redis 인스턴스 및 장애 조치를 모니터링합니다. Sentinel 구성 파일 구성, Redis 인스턴스 정보 및 장애 조치 설정 모니터링 추가; Redis 인스턴스 구성 파일 구성, 클러스터 모드 활성화 및 클러스터 정보 파일 경로를 지정합니다. 각 redis 인스턴스의 정보를 포함하는 Nodes.conf 파일을 작성합니다. 클러스터를 시작하고 Create 명령을 실행하여 클러스터를 작성하고 복제본 수를 지정하십시오. 클러스터에 로그인하여 클러스터 정보 명령을 실행하여 클러스터 상태를 확인하십시오. 만들다

기본 Redis를 구현하는 방법

Apr 10, 2025 pm 07:21 PM

기본 Redis를 구현하는 방법

Apr 10, 2025 pm 07:21 PM

Redis는 해시 테이블을 사용하여 데이터를 저장하고 문자열, 목록, 해시 테이블, 컬렉션 및 주문한 컬렉션과 같은 데이터 구조를 지원합니다. Redis는 Snapshots (RDB)를 통해 데이터를 유지하고 WRITE 전용 (AOF) 메커니즘을 추가합니다. Redis는 마스터 슬레이브 복제를 사용하여 데이터 가용성을 향상시킵니다. Redis는 단일 스레드 이벤트 루프를 사용하여 연결 및 명령을 처리하여 데이터 원자력과 일관성을 보장합니다. Redis는 키의 만료 시간을 설정하고 게으른 삭제 메커니즘을 사용하여 만료 키를 삭제합니다.

Redis에서 모든 키를 보는 방법

Apr 10, 2025 pm 07:15 PM

Redis에서 모든 키를 보는 방법

Apr 10, 2025 pm 07:15 PM

Redis에서 모든 키를 보려면 세 가지 방법이 있습니다. 키 명령을 사용하여 지정된 패턴과 일치하는 모든 키를 반환하십시오. 스캔 명령을 사용하여 키를 반복하고 키 세트를 반환하십시오. 정보 명령을 사용하여 총 키 수를 얻으십시오.

Redis-Server를 찾을 수없는 경우해야 할 일

Apr 10, 2025 pm 06:54 PM

Redis-Server를 찾을 수없는 경우해야 할 일

Apr 10, 2025 pm 06:54 PM

Redis-Server가 찾을 수없는 문제를 해결하기위한 단계 : Redis가 올바르게 설치되어 있는지 확인하십시오. 환경 변수를 설정 redis_host 및 redis_port; Redis Server Redis-Server를 시작하십시오. 서버가 Redis-Cli Ping을 실행 중인지 확인하십시오.

Redis Zset을 사용하는 방법

Apr 10, 2025 pm 07:27 PM

Redis Zset을 사용하는 방법

Apr 10, 2025 pm 07:27 PM

Redis 순서 세트 (ZSETS)는 순서가있는 요소를 저장하고 관련 점수별로 정렬하는 데 사용됩니다. ZSET을 사용하는 단계에는 다음이 포함됩니다. 1. ZSET을 만듭니다. 2. 회원 추가; 3. 회원 점수를 얻으십시오. 4. 순위를 얻으십시오. 5. 순위 범위에서 멤버를 받으십시오. 6. 회원 삭제; 7. 요소 수를 얻으십시오. 8. 점수 범위에서 멤버 수를 얻으십시오.

Redis 명령을 사용하는 방법

Apr 10, 2025 pm 08:45 PM

Redis 명령을 사용하는 방법

Apr 10, 2025 pm 08:45 PM

Redis 지시 사항을 사용하려면 다음 단계가 필요합니다. Redis 클라이언트를 엽니 다. 명령 (동사 키 값)을 입력하십시오. 필요한 매개 변수를 제공합니다 (명령어마다 다름). 명령을 실행하려면 Enter를 누르십시오. Redis는 작업 결과를 나타내는 응답을 반환합니다 (일반적으로 OK 또는 -err).

Redis 카운터 사용 방법

Apr 10, 2025 pm 07:00 PM

Redis 카운터 사용 방법

Apr 10, 2025 pm 07:00 PM

Redis 카운터는 카운터를 저장 및 운영하기위한 데이터 구조를 제공합니다. 특정 단계에는 다음이 포함됩니다. 카운터 생성 : ext 명령을 사용하여 기존 키에 1을 추가하십시오. 카운터 값 가져 오기 : get 명령을 사용하여 현재 값을 얻으십시오. 증분 카운터 : incrby 명령을 사용하고 그 뒤에 금액이 증가합니다. 감소 카운터 : DET 또는 DECBY 명령을 사용하여 1만큼 감소하거나 금액을 지정하십시오. 카운터 재설정 : 세트 명령을 사용하여 값을 0으로 설정하십시오. 또한 카운터를 사용하여 요금, 세션 추적 및 투표 시스템을 생성 할 수 있습니다.

Redis의 소스 코드를 읽는 방법

Apr 10, 2025 pm 08:27 PM

Redis의 소스 코드를 읽는 방법

Apr 10, 2025 pm 08:27 PM

Redis 소스 코드를 이해하는 가장 좋은 방법은 단계별로 이동하는 것입니다. Redis의 기본 사항에 익숙해집니다. 특정 모듈을 선택하거나 시작점으로 기능합니다. 모듈 또는 함수의 진입 점으로 시작하여 코드를 한 줄씩 봅니다. 함수 호출 체인을 통해 코드를 봅니다. Redis가 사용하는 기본 데이터 구조에 익숙해 지십시오. Redis가 사용하는 알고리즘을 식별하십시오.