ZTE New Pivot 운영 체제는 Linux 안정 커널을 기반으로 하며 임베디드 운영 체제(NewStart CGEL), 서버 운영 체제(NewStart CGSL), 데스크톱 운영 체제(NewStart NSDL)로 구분됩니다. ). 10년간의 전문 R&D팀 축적과 개발로 안전성 강화, 독립적인 제어성, 사용하기 쉬운 관리 등 뛰어난 장점을 갖고 있는 제품입니다. 현재 ZTE의 새로운 피벗 운영 체제는 국내외 주요 통신 사업자, 국영 대기업 및 중견 기업, 전자 정부 솔루션에 사용되고 있으며 스위칭 네트워크, 코어 네트워크, 백본 네트워크, 스마트 시티, 비디오 감시 및 기타 시스템. 위의 내용은 누군가로부터 복제되었습니다.

국가적인 디지털 전환과 현지화 대체, 특히 정부 업무 프로젝트의 맥락에서 이제 기본적으로 현지화된 CPU와 운영 체제를 사용하여 비즈니스를 수행하고 독립적인 혁신, 안전 및 신뢰성을 달성합니다. 이 기사에서는 ZTE CGSL(New Fulcrum System)과 Haiguang 프로세서를 사용하여 ceph의 오프라인 배포를 수행했습니다. 다음 방법은 Dragon Lizard 및 centos8에도 적용됩니다.

ceph의 오프라인 rpm 소스 만들기를 시작하려면 먼저 네트워크에 연결된 ZTE 새 피벗 머신을 찾아야 합니다. ZTE의 새로운 피벗 시스템은 기본적으로 일부 구성 요소(예: libvirt, qemu)를 설치합니다. ceph 설치 시 다른 패키지와의 종속성 충돌을 방지하려면 시스템 설치 시 최소 설치를 선택할 수 있습니다. 설치해야 하는 프로젝트의 다른 구성 요소는 나중에 설치됩니다. ceph 외에도 libvirt 패키지도 사용합니다. 시스템에서는 기본적으로 더 낮은 버전의 libvirt를 설치하고 오프라인 rpm 패키지를 수동으로 생성합니다.

ZTE New Pivot System은 현재 공식 온라인 yum 소스 주소를 찾을 수 없습니다. 온라인 설치의 경우 Dragon Lizard 및 epel8의 yum 소스를 사용할 수 있습니다. 다음은 yum 소스의 구성입니다.

AnolisOS.repo[AppStream]name=AnolisOS-8.6 - AppStreambaseurl=http://mirrors.openanolis.cn/anolis/8.6/AppStream/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[BaseOS]name=AnolisOS-8.6 - BaseOSbaseurl=http://mirrors.openanolis.cn/anolis/8.6/BaseOS/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[DDE]name=AnolisOS-8.6 - DDEbaseurl=http://mirrors.openanolis.cn/anolis/8.6/DDE/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[AppStream-debuginfo]name=AnolisOS-8.6 - AppStream Debuginfobaseurl=http://mirrors.openanolis.cn/anolis/8.6/AppStream/x86_64/debugenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[BaseOS-debuginfo]name=AnolisOS-8.6 - BaseOS Debuginfobaseurl=http://mirrors.openanolis.cn/anolis/8.6/BaseOS/x86_64/debugenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[Plus-debuginfo]name=AnolisOS-8.6 - Plus Debuginfobaseurl=http://mirrors.openanolis.cn/anolis/8.6/Plus/x86_64/debugenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[PowerTools-debuginfo]name=AnolisOS-8.6 - PowerTools Debuginfobaseurl=http://mirrors.openanolis.cn/anolis/8.6/PowerTools/x86_64/debugenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[DDE-debuginfo]name=AnolisOS-8.6 - DDE Debuginfobaseurl=http://mirrors.openanolis.cn/anolis/8.6/DDE/x86_64/debugenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[Extras]name=AnolisOS-8.6 - Extrasbaseurl=http://mirrors.openanolis.cn/anolis/8.6/Extras/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[HighAvailability]name=AnolisOS-8.6 - HighAvailabilitybaseurl=http://mirrors.openanolis.cn/anolis/8.6/HighAvailability/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[Plus]name=AnolisOS-8.6 - Plusbaseurl=http://mirrors.openanolis.cn/anolis/8.6/Plus/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[PowerTools]name=AnolisOS-8.6 - PowerToolsbaseurl=http://mirrors.openanolis.cn/anolis/8.6/PowerTools/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6

epel.repo[epel]name=Extra Packages for Enterprise Linux 8 - $basearch# It is much more secure to use the metalink, but if you wish to use a local mirror# place its address here.baseurl=https://mirrors.aliyun.com/epel/8/Everything/$basearchmetalink=https://mirrors.fedoraproject.org/metalink?repo=epel-8&arch=$basearch&infra=$infra&content=$contentdirenabled=1gpgcheck=1countme=1gpgkey=file:///etc/yum.repos.d/RPM-GPG-KEY-EPEL-8

ceph.repo[Ceph]name=Ceph packages for $basearchbaseurl=http://download.ceph.com/rpm-pacific/el8/$basearchenabled=1gpgcheck=0type=rpm-mdgpgkey=https://download.ceph.com/keys/release.asc[Ceph-noarch]name=Ceph noarch packagesbaseurl=http://download.ceph.com/rpm-pacific/el8/noarchenabled=1gpgcheck=0type=rpm-mdgpgkey=https://download.ceph.com/keys/release.asc[ceph-source]name=Ceph source packagesbaseurl=http://download.ceph.com/rpm-pacific/el8/SRPMSenabled=1gpgcheck=0type=rpm-mdgpgkey=https://download.ceph.com/keys/release.asc

yum 캐시 구성:

[main]gpgcheck=1installonly_limit=3clean_requirements_on_remove=Truebest=Trueskip_if_unavailable=Falsecachedir=/data/yumkeepcache=1

yum install ceph -y

find /data/cache -name "*.rpm" -exec cp {} /mnt \;createrepo /mnttar -zcvf offline.tar.gz mnt/만든 오프라인 rpm 패키지를 사용하여 ceph를 설치하세요.

tar -zxvf offline.tar.gz cd mntrpm -ivh *.rpm --nodeps --force

Ceph 클러스터에는 하나 이상의 모니터가 있어야 하며, 필요한 OSD 수는 최소한 클러스터에 저장된 객체 복제본 수와 동일해야 합니다. 초기 mon 부팅은 Ceph 스토리지 클러스터 배포의 첫 번째 단계입니다. 여기서는 node1, node2 및 node3에 직접 세 개의 mon을 생성합니다.

클러스터에 대한 고유 fsid를 생성합니다. fsid는 클러스터의 고유 식별자이며 주로 Ceph 파일 시스템에 사용되는 Ceph 스토리지 클러스터의 파일 시스템 ID를 나타냅니다.

uuidgen

ceph 구성 파일을 생성하고 생성된 fsid를 구성 파일에 추가합니다.

vim /etc/ceph/ceph.conf[global]fsid=9c079a1f-6fc2-4c59-bd4d-e8bc232d33a4mon initial members = node1mon host = 192.168.2.16public network = 192.168.2.0/24auth cluster required = cephxauth service required = cephxauth client required = cephxosd journal size = 1024osd pool default size = 3osd pool default min size = 2osd pool default pg num = 8osd pool default pgp num = 8osd crush chooseleaf type = 1

클러스터를 준비하기 위해 키링을 생성하고 모니터 키링을 생성합니다. 모니터는 키를 통해 서로 통신합니다. 초기 모니터링 부팅 시 모니터링 키와 함께 생성된 키링을 제공해야 합니다.

ceph-authtool --create-keyring /tmp/ceph.mon.keyring --gen-key -n mon. --cap mon 'allow *'

관리자 키링을 생성하고 client.admin 키링에 사용자를 추가하세요. CLI 도구를 사용하려면 사용자를 생성하고 모니터 키링에 추가해야 합니다.

ceph-authtool --create-keyring /etc/ceph/ceph.client.admin.keyring --gen-key -n client.admin --cap mon 'allow *' --cap osd 'allow *' --cap mds 'allow *' --cap mgr 'allow *'

부트스트랩 OSD 키를 생성하고, 사용자를 생성하고, client.bootstrap-osd 키링에 사용자를 추가합니다.

ceph-authtool --create-keyring /var/lib/ceph/bootstrap-osd/ceph.keyring --gen-key -n client.bootstrap-osd --cap mon 'profile bootstrap-osd' --cap mgr 'allow r'

생성된 키를 ceph.mon.keyring에 추가하세요.

ceph-authtool /tmp/ceph.mon.keyring --import-keyring /etc/ceph/ceph.client.admin.keyringceph-authtool /tmp/ceph.mon.keyring --import-keyring /var/lib/ceph/bootstrap-osd/ceph.keyring

ceph.mon.keyring의 소유자를 변경하세요.

chown ceph:ceph /tmp/ceph.mon.keyring

모니터 매핑을 생성할 때 호스트 이름, 호스트 IP 주소 및 FSID가 필요합니다. :/tmp/monmap으로 저장하세요.

monmaptool --create --add `hostname` 192.168.2.16--fsid 9c079a1f-6fc2-4c59-bd4d-e8bc232d33a4 /tmp/monmap

모니터 호스트에 기본 데이터 디렉터리를 생성합니다. 디렉터리 이름은 {cluster-name}-{hostname} 형식입니다.

sudo -u ceph mkdir /var/lib/ceph/mon/ceph-`hostname`

node1 노드에서 모니터를 초기화합니다.

sudo -u ceph ceph-mon --mkfs -i `hostname` --monmap /tmp/monmap --keyring /tmp/ceph.mon.keyring

월 시작하세요.

systemctl start ceph-mon@`hostname` && systemctl enable ceph-mon@`hostname`

키와 구성 파일을 다른 노드에 복사하세요.

scp /tmp/ceph.mon.keyring ceph2:/tmp/ceph.mon.keyringscp /etc/ceph/* root@ceph2:/etc/ceph/scp /var/lib/ceph/bootstrap-osd/ceph.keyring root@ceph2:/var/lib/ceph/bootstrap-osd/scp /tmp/ceph.mon.keyring ceph3:/tmp/ceph.mon.keyringscp /etc/ceph/* root@ceph3:/etc/ceph/scp /var/lib/ceph/bootstrap-osd/ceph.keyring root@ceph3:/var/lib/ceph/bootstrap-osd/

ceph.mon.keyring 소유자 및 그룹을 두 노드 모두에서 ceph로 수정합니다.

chown ceph.ceph /tmp/ceph.mon.keyring

몬맵 정보를 받아보세요.

ceph mon getmap -o /tmp/ceph.mon.mapgot monmap epoch 1

mon 노드에서 mon 초기화를 수행합니다.

sudo -u ceph ceph-mon --mkfs -i `hostname` --monmap /tmp/ceph.mon.map --keyring /tmp/ceph.mon.keyringsudo -u ceph ceph-mon --mkfs -i `hostname` --monmap /tmp/ceph.mon.map --keyring /tmp/ceph.mon.keyring

두 노드 모두에서 mon을 시작합니다.

systemctl start ceph-mon@`hostname` && systemctl enable ceph-mon@`hostname`

ceph.conf를 수정하고 ceph-mon을 다시 시작하세요(모든 노드 작업).

vim /etc/ceph/ceph.confmon initial members = node1,node2,node3mon host = 192.168.2.16,192.168.2.17,192.168.2.18systemctl restart ceph-mon@`hostname`

ceph mon remove {mon-id}Ceph는 ceph-volume 도구를 사용하여 논리 볼륨, 디스크 또는 파티션을 준비할 수 있습니다. ceph-volume 도구는 인덱스를 추가하여 OSD ID를 생성합니다.

를 생성하고 node1에서 실행합니다.

ceph-volume lvm create --data /dev/sdb

위 생성 프로세스는 두 단계(준비 및 활성화)로 나눌 수 있습니다.

ceph-volume lvm prepare --data /dev/sdb查看osd fsidceph-volume lvm listceph-volume lvm activate {ID} {FSID}각 노드 osd 프로세스를 시작합니다.

#node1systemctl restart ceph-osd@0systemctl enable ceph-osd@0 #node2systemctl restart ceph-osd@1systemctl enable ceph-osd@1#node3systemctl restart ceph-osd@2systemctl enable ceph-osd@2

ceph-mon 데몬을 실행하는 각 노드에서 ceph-mgr 데몬도 설정해야 합니다.

모든 mgr 노드가 실행되어야 합니다.

sudo -u ceph mkdir /var/lib/ceph/mgr/ceph-`hostname -s`cd /var/lib/ceph/mgr/ceph-`hostname -s`

ceph auth get-or-create mgr.`hostname -s` mon 'allow profile mgr' osd 'allow *' mds 'allow *' > keyringchown ceph.ceph /var/lib/ceph/mgr/ceph-`hostname`/keyring

systemctl enable ceph-mgr@`hostname -s` && systemctl start ceph-mgr@`hostname -s`或者ceph-mgr -i `hostname`

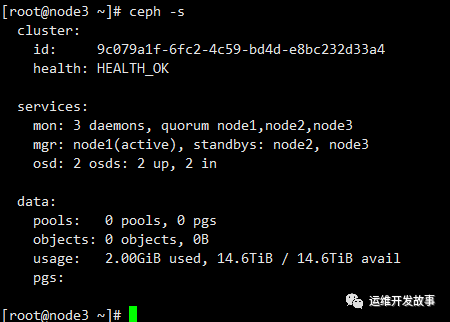

마지막으로 ceph 실행 상태를 확인하니 osd 2개만 추가했습니다.

위 내용은 ZTE 새로운 피벗 시스템 오프라인 설치 ceph 16.2.10의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!