2022년은 지능형 운전이 L2에서 L3/L4로 전환되는 창구 기간입니다. 점점 더 많은 자동차 제조업체가 더 높은 수준의 지능형 운전의 대량 생산을 계획하기 시작했습니다.

LiDAR 하드웨어의 기술 향상, 자동차 수준의 대량 생산 및 비용 절감으로 인해 수준 높은 지능형 주행 기능이 승용차 분야에서 LiDAR를 탑재한 다양한 모델의 양산을 촉진할 것입니다. 올해 인도될 예정이며, 2022년은 '도로 위 LiDAR의 원년'으로도 알려져 있습니다.

Lidar는 물체의 3차원 위치를 정확하게 파악하는 데 사용되는 센서입니다. 본질적으로 레이저 감지 및 거리 측정입니다. 목표 윤곽 측정 및 범용 장애물 감지 성능이 뛰어나 L4 자율주행의 핵심 구성으로 자리잡고 있습니다.

그러나 LiDAR의 범위 측정 범위(일반적으로 약 200m, 제조업체마다 양산 모델에 따라 표시기가 다름)로 인해 인식 범위가 이미지 센서보다 훨씬 작습니다.

그리고 각도 해상도(일반적으로 0.1° 또는 0.2°)가 상대적으로 작기 때문에 포인트 클라우드의 해상도는 이미지 센서의 해상도보다 훨씬 작습니다. 이미지가 매우 희박할 수도 있습니다. 포인트 클라우드 타겟 감지의 경우 알고리즘이 실제로 사용할 수 있는 효과적인 포인트 클라우드 거리는 약 100미터에 불과합니다.

이미지 센서는 높은 프레임 속도와 고해상도로 복잡한 주변 정보를 획득할 수 있으며 가격도 저렴합니다. 다양한 거리와 범위에서 시각적 인식을 위해 다양한 FOV와 해상도를 가진 여러 센서를 배치할 수 있습니다.

그러나 이미지 센서는 수동 센서이므로 깊이 인식이 부족하고 거리 측정 정확도가 좋지 않습니다. 특히 열악한 환경에서는 감지 작업을 완료하기가 훨씬 어렵습니다.

강한 빛, 밤의 낮은 조도, 비, 눈, 안개 및 기타 날씨와 조명 환경에서 지능형 주행은 센서 알고리즘에 대한 높은 요구 사항을 갖습니다. LiDAR는 주변광의 영향에 민감하지 않지만 거리 측정은 물에 젖은 도로, 유리벽 등에 의해 큰 영향을 받습니다.

라이다와 이미지 센서는 각각 장단점이 있음을 알 수 있습니다. 대부분의 고급 지능형 운전 승용차는 서로의 장점을 보완하고 중복성을 통합하기 위해 다양한 센서를 통합하는 것을 선택합니다.

이러한 융합 센싱 솔루션도 고도의 자율주행을 위한 핵심 기술 중 하나가 되었습니다.

포인트 클라우드와 이미지의 융합은 다중 센서 융합(MSF) 기술 분야에 속하며, 융합 시스템의 정보 처리 추상화 수준에 따라 크게 세 가지 수준으로 구분됩니다.

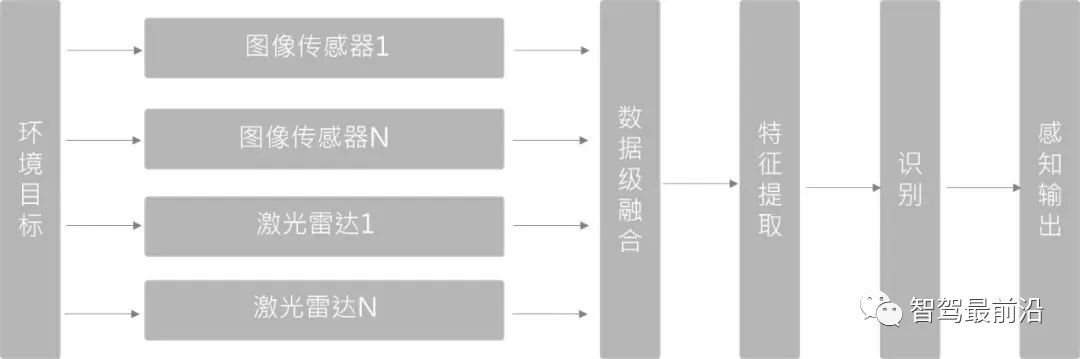

데이터 계층 융합(Early Fusion)

먼저 센서 관찰 데이터를 융합한 다음 융합합니다. 식별을 위해 융합된 데이터 특징이 추출됩니다. 3D 타겟 탐지에서는 PointPainting(CVPR20)이 이 방법을 채택합니다. PointPainting 방법은 먼저 이미지에 대해 의미론적 분할을 수행하고 분할된 특징을 점-이미지 픽셀 매트릭스를 통해 포인트 클라우드에 매핑한 다음 "점을 그립니다". 포인트 클라우드는 3D 포인트 클라우드 감지기로 전송되어 대상 Box에서 회귀를 수행합니다.

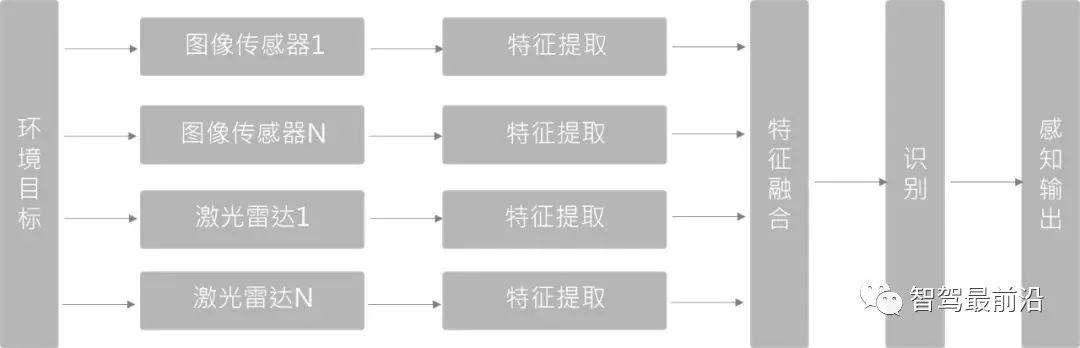

특징층 융합(Deep Fusion)

각 센서가 제공하는 관측 데이터에서 자연적인 데이터 특징을 먼저 추출하고 융합한 후 이러한 특징을 식별합니다. 딥러닝 기반의 융합 방법에서는 포인트 클라우드와 이미지 브랜치 모두에 대해 특징 추출기를 사용합니다. 이미지 브랜치와 포인트 클라우드 브랜치의 네트워크는 순방향 피드백 수준에서 레벨별로 의미론적으로 융합됩니다. 척도 정보.

딥러닝 기반의 특징 레이어 융합 방법은 여러 센서 간의 시공간 동기화에 대한 요구 사항이 높습니다. 동기화가 좋지 않으면 특징 융합 효과에 직접적인 영향을 미칩니다. 동시에, 규모와 시야각의 차이로 인해 LiDAR와 이미지 간의 특징 융합의 1+1>2 효과를 달성하기가 어렵습니다.

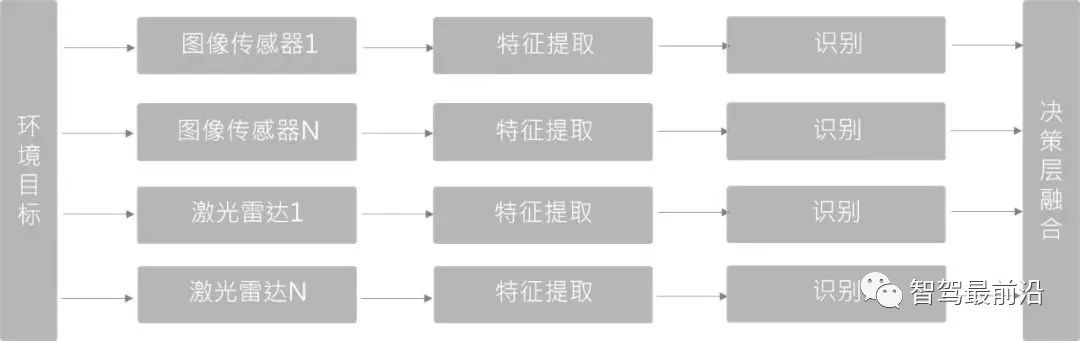

의사결정 계층 융합(Late Fusion)

처음 두 가지에 비해 가장 덜 복잡한 융합 방법입니다. 데이터 레이어나 피쳐 레이어에서 융합되지 않지만, 타겟 수준의 융합입니다. 서로 다른 센서 네트워크 구조는 서로 영향을 주지 않으며 독립적으로 학습하고 결합할 수 있습니다.

의사결정 계층에서 융합된 두 가지 유형의 센서와 감지기는 서로 독립적이기 때문에 센서에 장애가 발생하더라도 센서 중복 처리가 계속 수행될 수 있으며 엔지니어링 견고성이 더 좋습니다.

LiDAR 및 시각 융합 인식 기술의 지속적인 반복과 지식 시나리오 및 사례의 지속적인 축적으로 점점 더 많은 풀 스택 융합 컴퓨팅 솔루션이 자율주행차에 더 많은 이점을 가져올 것으로 나타날 것입니다. 안전하고 안전한 미래.

위 내용은 자율주행에 대한 LiDAR와 시각적 융합 인식을 이해하기 위한 기사 1편의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!