Scrapy의 힘: 인증 코드를 인식하고 처리하는 방법은 무엇입니까?

Scrapy는 웹사이트의 데이터를 쉽게 크롤링하는 데 도움이 되는 강력한 Python 프레임워크입니다. 하지만 크롤링하려는 웹사이트에 인증 코드가 있으면 문제가 발생합니다. CAPTCHA의 목적은 자동화된 크롤러가 웹사이트를 공격하는 것을 방지하는 것이므로 매우 복잡하고 해독하기 어려운 경향이 있습니다. 이 게시물에서는 크롤러가 이러한 방어를 우회할 수 있도록 Scrapy 프레임워크를 사용하여 CAPTCHA를 식별하고 처리하는 방법을 다룹니다.

인증코드란 무엇인가요?

A CAPTCHA는 사용자가 기계가 아닌 실제 인간임을 증명하는 데 사용되는 테스트입니다. 일반적으로 사용자가 표시되는 내용을 수동으로 입력하거나 선택해야 하는 난독화된 텍스트 문자열이거나 해독할 수 없는 이미지입니다. CAPTCHA는 자동화된 봇과 스크립트를 포착하여 악의적인 공격과 남용으로부터 웹사이트를 보호하도록 설계되었습니다.

일반적으로 세 가지 유형의 보안 문자가 있습니다:

- 텍스트 보안 문자: 사용자는 자신이 봇이 아닌 인간 사용자임을 증명하기 위해 텍스트 문자열을 복사하여 붙여 넣어야 합니다.

- 번호 인증코드: 사용자는 입력창에 표시된 숫자를 입력해야 합니다.

- 이미지 확인 코드: 사용자는 표시된 이미지의 문자나 숫자를 입력 상자에 입력하라는 요청을 받습니다. 이는 이미지의 문자나 숫자가 왜곡되거나 위치가 잘못되거나 시각적으로 왜곡될 수 있기 때문에 일반적으로 해독하기 가장 어려운 유형입니다. 소음. .

인증 코드를 처리해야 하는 이유는 무엇인가요?

크롤러는 대규모로 자동화되는 경우가 많기 때문에 로봇으로 쉽게 식별될 수 있으며 웹사이트에서 데이터를 얻는 것이 금지될 수 있습니다. 이러한 일이 발생하는 것을 방지하기 위해 CAPTCHA가 도입되었습니다. ep가 확인 코드 단계에 들어가면 Scrapy 크롤러는 사용자 입력 대기를 중단하므로 데이터 크롤링을 계속할 수 없으므로 크롤러의 효율성과 무결성이 저하됩니다.

따라서 크롤러가 자동으로 보안 문자를 전달하고 작업을 계속할 수 있도록 보안 문자를 처리할 방법이 필요합니다. 일반적으로 당사는 인증 코드 인식을 완료하기 위해 타사 도구나 API를 사용합니다. 이러한 도구와 API는 기계 학습 및 이미지 처리 알고리즘을 사용하여 이미지와 문자를 인식하고 결과를 당사 프로그램에 반환합니다.

Scrapy에서 인증 코드를 처리하는 방법은 무엇인가요? scrapy의 settings.py 파일을 OPENENE, Downloder_MiddleWares 필드를 수정하고 다음 프록시를 추가해야합니다. ': 350,'scrapy.contrib.downloadermiddleware.redirect.RedirectMiddleware': 400,

'scrapy.contrib.downloadermiddleware.cookies.CookiesMiddleware': 700,'scrapy.contrib.downloadermiddleware.httpproxy.HttpProxyMiddleware': 750,'scrapy .contrib.downloadermiddleware.useragent.UserAgentMiddleware': 400,'scrapy.contrib.downloadermiddleware.defaultheaders.DefaultHeadersMiddleware': 550,

'scrapy.contrib.downloadermiddleware.ajaxcrawl.AjaxCrawlMiddleware': 900,'scrapy.contrib.download ermiddleware. .HttpCompressionMiddleware': 800,'scrapy.contrib.downloadermiddleware.chunked.ChunkedTransferMiddleware': 830,'scrapy.contrib.downloadermiddleware.stats.DownloaderStats': 850,

'tutorial.middlewares.CaptchaMiddleware': 999}

In In 이 예에서는 CaptchaMiddleware를 사용하여 확인 코드를 처리합니다. CaptchMiddleware는 다운로드 요청을 처리하고 필요할 때 확인 코드를 식별하기 위해 API를 호출한 다음 요청에 확인 코드를 입력하고 반환하여 실행을 계속하는 사용자 정의 미들웨어 클래스입니다.

코드 예:

def __init__(self):

self.client = CaptchaClient()

self.max_attempts = 5

def process_request(self, request, spider):

# 如果没有设置dont_filter则默认开启

if not request.meta.get('dont_filter', False):

request.meta['dont_filter'] = True

if 'captcha' in request.meta:

# 带有验证码信息

captcha = request.meta['captcha']

request.meta.pop('captcha')

else:

# 没有验证码则获取

captcha = self.get_captcha(request.url, logger=spider.logger)

if captcha:

# 如果有验证码则添加到请求头

request = request.replace(

headers={

'Captcha-Code': captcha,

'Captcha-Type': 'math',

}

)

spider.logger.debug(f'has captcha: {captcha}')

return request

def process_response(self, request, response, spider):

# 如果没有验证码或者验证码失败则不重试

need_retry = 'Captcha-Code' in request.headers.keys()

if not need_retry:

return response

# 如果已经尝试过,则不再重试

retry_times = request.meta.get('retry_times', 0)

if retry_times >= self.max_attempts:

return response

# 验证码校验失败则重试

result = self.client.check(request.url, request.headers['Captcha-Code'])

if not result:

spider.logger.warning(f'Captcha check fail: {request.url}')

return request.replace(

meta={

'captcha': self.get_captcha(request.url, logger=spider.logger),

'retry_times': retry_times + 1,

},

dont_filter=True,

)

# 验证码校验成功则继续执行

spider.logger.debug(f'Captcha check success: {request.url}')

return response

def get_captcha(self, url, logger=None):

captcha = self.client.solve(url)

if captcha:

if logger:

logger.debug(f'get captcha [0:4]: {captcha[0:4]}')

return captcha

return None

인증 코드를 식별하고 처리하려면 타사 도구나 API를 사용해야 하며, 법적 라이센스가 있는지 확인해야 합니다. 제조업체의 요구 사항을 따르십시오.

미들웨어를 추가한 후에는 요청 프로세스가 더욱 복잡해지며 개발자는 프로그램이 제대로 작동할 수 있는지 확인하기 위해 신중하게 테스트하고 디버그해야 합니다.

- 결론

- 인증코드 인식 및 처리를 위한 Scrapy 프레임워크와 미들웨어를 사용하면 인증코드 방어 전략을 효과적으로 우회하고 대상 웹사이트의 효과적인 크롤링을 달성할 수 있습니다. 이 방법은 일반적으로 인증 코드를 수동으로 입력하는 것보다 시간과 노력을 절약하며 더 효율적이고 정확합니다. 그러나 타사 도구 및 API를 사용하기 전에 라이선스 계약과 요구 사항을 읽고 준수하는 것이 중요합니다.

위 내용은 Scrapy의 힘: 인증 코드를 인식하고 처리하는 방법은 무엇입니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7665

7665

15

15

1393

1393

52

52

1205

1205

24

24

91

91

11

11

73

73

19

19

CPU를 너무 많이 점유하는 WIN10 서비스 호스트의 동작 과정

Mar 27, 2024 pm 02:41 PM

CPU를 너무 많이 점유하는 WIN10 서비스 호스트의 동작 과정

Mar 27, 2024 pm 02:41 PM

1. 먼저 작업 표시줄의 빈 공간을 마우스 오른쪽 버튼으로 클릭하고 [작업 관리자] 옵션을 선택하거나, 시작 로고를 마우스 오른쪽 버튼으로 클릭한 후 [작업 관리자] 옵션을 선택합니다. 2. 열린 작업 관리자 인터페이스에서 맨 오른쪽에 있는 [서비스] 탭을 클릭합니다. 3. 열린 [서비스] 탭에서 아래의 [서비스 열기] 옵션을 클릭하세요. 4. 열리는 [서비스] 창에서 [InternetConnectionSharing(ICS)] 서비스를 마우스 오른쪽 버튼으로 클릭한 후 [속성] 옵션을 선택하세요. 5. 열리는 속성 창에서 [연결 프로그램]을 [사용 안 함]으로 변경하고 [적용]을 클릭한 후 [확인]을 클릭하세요. 6. 시작 로고를 클릭한 후 종료 버튼을 클릭하고 [다시 시작]을 선택한 후 컴퓨터를 다시 시작합니다.

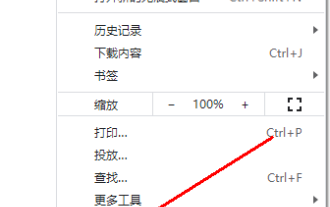

Chrome에 인증코드 이미지가 표시되지 않으면 어떻게 해야 하나요?

Mar 13, 2024 pm 08:55 PM

Chrome에 인증코드 이미지가 표시되지 않으면 어떻게 해야 하나요?

Mar 13, 2024 pm 08:55 PM

Google 크롬에 인증 코드 이미지가 표시되지 않으면 어떻게 해야 하나요? Google Chrome을 사용하여 웹페이지에 로그인할 때 인증 코드가 필요한 경우가 있습니다. 일부 사용자는 이미지 인증 코드를 사용할 때 Chrome에서 이미지 내용을 제대로 표시할 수 없다는 사실을 발견합니다. 무엇을 해야 합니까? 아래 편집기에서 Chrome 인증 코드가 표시되지 않는 문제를 해결하는 방법을 소개하겠습니다. 모든 분들께 도움이 되길 바랍니다! 방법 소개: 1. 소프트웨어를 입력하고 오른쪽 상단 모서리에 있는 "추가" 버튼을 클릭한 다음 아래 옵션 목록에서 "설정"을 선택하여 들어갑니다. 2. 새 인터페이스에 들어간 후 왼쪽의 "개인정보 설정 및 보안" 옵션을 클릭하세요. 3. 오른쪽의 '웹사이트 설정'을 클릭하세요.

CSV 파일 조작에 대한 빠른 가이드

Dec 26, 2023 pm 02:23 PM

CSV 파일 조작에 대한 빠른 가이드

Dec 26, 2023 pm 02:23 PM

CSV 형식 파일을 열고 처리하는 방법을 빠르게 배우십시오. 데이터 분석 및 처리의 지속적인 개발로 인해 CSV 형식은 널리 사용되는 파일 형식 중 하나가 되었습니다. CSV 파일은 다양한 데이터 필드가 쉼표로 구분되어 있는 간단하고 읽기 쉬운 텍스트 파일입니다. 학술 연구, 비즈니스 분석, 데이터 처리 등 CSV 파일을 열고 처리해야 하는 상황에 자주 직면하게 됩니다. 다음 가이드는 CSV 형식 파일을 열고 처리하는 방법을 빠르게 배우는 방법을 보여줍니다. 1단계: CSV 파일 형식 이해하기 먼저,

가상번호로 인증코드를 받을 수 있나요?

Jan 02, 2024 am 10:22 AM

가상번호로 인증코드를 받을 수 있나요?

Jan 02, 2024 am 10:22 AM

가상번호로 인증번호를 받으실 수 있습니다. 등록 시 기재한 휴대폰번호가 규정을 준수하고 휴대폰 번호가 정상적으로 연결될 수 있으면 SMS 인증번호를 받으실 수 있습니다. 다만, 가상휴대폰번호 이용시에는 주의가 필요합니다. 일부 웹사이트에서는 가상휴대폰번호 등록을 지원하지 않으므로 일반 가상휴대폰번호 서비스 제공업체를 선택하셔야 합니다.

PHP에서 특수 문자를 처리하고 작은따옴표를 변환하는 방법을 알아보세요.

Mar 27, 2024 pm 12:39 PM

PHP에서 특수 문자를 처리하고 작은따옴표를 변환하는 방법을 알아보세요.

Mar 27, 2024 pm 12:39 PM

PHP 개발 과정에서 특수 문자를 처리하는 것은 일반적인 문제이며, 특히 문자열 처리에서는 특수 문자가 이스케이프되는 경우가 많습니다. 그중에서도 특수 문자를 작은따옴표로 변환하는 것은 상대적으로 일반적인 요구 사항입니다. 왜냐하면 PHP에서는 작은따옴표가 문자열을 래핑하는 일반적인 방법이기 때문입니다. 이 기사에서는 PHP에서 특수 문자 변환 작은따옴표를 처리하는 방법을 설명하고 구체적인 코드 예제를 제공합니다. PHP에서 특수 문자에는 작은따옴표('), 큰따옴표("), 백슬래시() 등이 포함되지만 이에 국한되지는 않습니다.

C# 개발에서 XML 및 JSON 데이터 형식을 처리하는 방법

Oct 09, 2023 pm 06:15 PM

C# 개발에서 XML 및 JSON 데이터 형식을 처리하는 방법

Oct 09, 2023 pm 06:15 PM

C# 개발에서 XML 및 JSON 데이터 형식을 처리하려면 특정 코드 예제가 필요합니다. 최신 소프트웨어 개발에서는 XML과 JSON이 널리 사용되는 두 가지 데이터 형식입니다. XML(Extensible Markup Language)은 데이터를 저장하고 전송하는 데 사용되는 마크업 언어인 반면, JSON(JavaScript Object Notation)은 경량 데이터 교환 형식입니다. C# 개발에서는 XML 및 JSON 데이터를 처리하고 조작해야 하는 경우가 많습니다. 이 기사에서는 C#을 사용하여 이 두 가지 데이터 형식을 처리하고 첨부하는 방법에 중점을 둘 것입니다.

win7에서 win10으로의 업그레이드가 실패한 후 문제를 해결하는 방법은 무엇입니까?

Dec 26, 2023 pm 07:49 PM

win7에서 win10으로의 업그레이드가 실패한 후 문제를 해결하는 방법은 무엇입니까?

Dec 26, 2023 pm 07:49 PM

우리가 사용하는 운영 체제가 win7인 경우 일부 친구는 업그레이드할 때 win7에서 win10으로 업그레이드하지 못할 수도 있습니다. 편집자는 문제가 해결될 수 있는지 확인하기 위해 다시 업그레이드를 시도해 볼 수 있다고 생각합니다. 자세한 내용은 편집자가 어떻게 했는지 살펴보겠습니다~ win7이 win10으로 업그레이드하지 못한 경우 방법 1: 1. 먼저 드라이버를 다운로드하여 컴퓨터를 Win10으로 업그레이드할 수 있는지 평가하는 것이 좋습니다. 업그레이드 후 드라이버 테스트를 이용하여 드라이버에 이상이 있는지 확인하고 원클릭으로 수정하세요. 방법 2: 1. C:\Windows\SoftwareDistribution\Download 아래의 모든 파일을 삭제합니다. 2.win+R 실행 "wuauclt.e

JavaScript를 사용하여 인증 코드 기능을 구현하는 방법은 무엇입니까?

Oct 19, 2023 am 10:46 AM

JavaScript를 사용하여 인증 코드 기능을 구현하는 방법은 무엇입니까?

Oct 19, 2023 am 10:46 AM

JavaScript를 사용하여 인증 코드 기능을 구현하는 방법은 무엇입니까? 인터넷이 발전하면서 인증 코드는 웹사이트와 애플리케이션에서 없어서는 안 될 보안 메커니즘 중 하나가 되었습니다. VerificationCode는 사용자가 기계가 아닌 사람인지 판단하는 데 사용되는 기술입니다. CAPTCHA를 사용하면 웹사이트와 애플리케이션에서 스팸 제출, 악성 공격, 봇 크롤러 등을 방지할 수 있습니다. 이 글에서는 JavaScript를 사용하여 인증 코드 기능을 구현하고 특정 코드를 제공하는 방법을 소개합니다.