빅데이터 처리 및 분석을 지원하도록 Linux 시스템 구성

빅데이터 처리 및 분석을 지원하도록 Linux 시스템 구성

요약: 빅데이터 시대가 도래하면서 빅데이터 처리 및 분석에 대한 수요가 증가하고 있습니다. 이 문서에서는 빅 데이터 처리 및 분석을 지원하기 위해 Linux 시스템에서 애플리케이션과 도구를 구성하는 방법을 설명하고 해당 코드 예제를 제공합니다.

키워드: 리눅스 시스템, 빅데이터, 처리, 분석, 구성, 코드 예시

서론: 빅데이터는 최근 떠오르는 데이터 관리 및 분석 기술로 다양한 분야에서 널리 활용되고 있습니다. 빅데이터 처리 및 분석의 효율성과 신뢰성을 보장하기 위해서는 Linux 시스템을 올바르게 구성하는 것이 매우 중요합니다.

1. Linux 시스템 설치

먼저 Linux 시스템을 올바르게 설치해야 합니다. 일반적인 Linux 배포판에는 Ubuntu, Fedora 등이 포함됩니다. 필요에 따라 적합한 Linux 배포판을 선택할 수 있습니다. 설치 과정에서 시스템 설치가 완료된 후 보다 세부적인 구성이 가능하도록 서버 버전을 선택하는 것이 좋습니다.

2. 시스템 업데이트 및 필요한 소프트웨어 설치

시스템 설치가 완료되면 시스템을 업데이트하고 필요한 소프트웨어를 설치해야 합니다. 먼저 터미널에서 다음 명령을 실행하여 시스템을 업데이트합니다.

sudo apt update sudo apt upgrade

다음으로 OpenJDK(Java Development Kit)를 설치합니다. 대부분의 빅데이터 처리 및 분석 애플리케이션은 Java 기반으로 개발되기 때문입니다.

sudo apt install openjdk-8-jdk

설치 후 확인할 수 있습니다. 다음 명령어를 실행하여 Java가 성공적으로 설치되었는지 확인합니다.

java -version

Java 버전 정보가 출력되면 설치에 성공한 것입니다.

3. Hadoop 구성

Hadoop은 매우 큰 데이터 세트를 처리할 수 있는 오픈 소스 빅 데이터 처리 프레임워크입니다. Hadoop을 구성하는 단계는 다음과 같습니다.

Hadoop을 다운로드하고 압축을 풉니다.

wget https://www.apache.org/dist/hadoop/common/hadoop-3.3.0.tar.gz tar -xzvf hadoop-3.3.0.tar.gz

로그인 후 복사환경 변수 구성:

~/.bashrc파일에 다음 내용을 추가합니다.~/.bashrc文件中:export HADOOP_HOME=/path/to/hadoop-3.3.0 export PATH=$PATH:$HADOOP_HOME/bin

로그인 후 복사保存文件后,运行以下命令使配置生效:

source ~/.bashrc

로그인 후 복사로그인 후 복사配置Hadoop的核心文件:

进入Hadoop的解压目录,编辑etc/hadoop/core-site.xml文件,添加以下内容:<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property> </configuration>

로그인 후 복사接着,编辑

etc/hadoop/hdfs-site.xml文件,添加以下内容:<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> </configuration>

로그인 후 복사保存文件后,执行以下命令格式化Hadoop的文件系统:

hdfs namenode -format

로그인 후 복사最后,启动Hadoop:

start-dfs.sh

로그인 후 복사四、配置Spark

Spark是一个快速、通用的大数据处理和分析引擎,可以与Hadoop一起使用。下面是配置Spark的步骤:下载Spark并解压缩:

wget https://www.apache.org/dist/spark/spark-3.1.2/spark-3.1.2-bin-hadoop3.2.tgz tar -xzvf spark-3.1.2-bin-hadoop3.2.tgz

로그인 후 복사配置环境变量:

将下面的内容添加到~/.bashrc文件中:export SPARK_HOME=/path/to/spark-3.1.2-bin-hadoop3.2 export PATH=$PATH:$SPARK_HOME/bin

로그인 후 복사保存文件后,运行以下命令使配置生效:

source ~/.bashrc

로그인 후 복사로그인 후 복사配置Spark的核心文件:

进入Spark的解压目录,将conf/spark-env.sh.template文件复制一份并重命名为conf/spark-env.sh。编辑conf/spark-env.sh文件,添加以下内容:export JAVA_HOME=/path/to/jdk1.8.0_* export HADOOP_HOME=/path/to/hadoop-3.3.0 export SPARK_MASTER_HOST=localhost export SPARK_MASTER_PORT=7077 export SPARK_WORKER_CORES=4 export SPARK_WORKER_MEMORY=4g

로그인 후 복사其中,

JAVA_HOME需要设置为Java的安装路径,HADOOP_HOME需要设置为Hadoop的安装路径,SPARK_MASTER_HOST设置为当前机器的IP地址。

保存文件后,启动Spark:

start-master.sh

运行以下命令查看Spark的Master地址:

cat $SPARK_HOME/logs/spark-$USER-org.apache.spark.deploy.master*.out | grep 'Starting Spark master'

启动Spark Worker:

start-worker.sh spark://<master-ip>:<master-port>

其中,<master-ip>为Spark的Master地址中的IP地址,<master-port>rrreee

rrreee

🎜🎜Hadoop의 코어 파일 구성: 🎜Hadoop의 압축 해제 디렉터리에 들어가서etc/hadoop/core-site.xml을 편집합니다. 파일에 다음 내용을 추가합니다. 🎜rrreee🎜다음으로 etc/hadoop/hdfs-site.xml 파일을 편집하고 다음 내용을 추가합니다. 🎜rrreee🎜파일을 저장한 후, 다음 명령을 실행하여 Hadoop 파일 시스템을 포맷합니다. 🎜rrreee🎜 마지막으로 Hadoop을 시작합니다. 🎜rrreee🎜 IV. Spark 구성🎜Spark는 Hadoop과 함께 사용할 수 있는 빠르고 다양한 빅 데이터 처리 및 분석 엔진입니다. Spark를 구성하는 단계는 다음과 같습니다. 🎜🎜🎜🎜Spark를 다운로드하고 압축을 풉니다. 🎜rrreee🎜🎜🎜환경 변수 구성: 🎜~/.bashrc 파일에 다음 내용을 추가합니다. 🎜rrreee🎜 파일을 저장한 후 다음 명령을 실행하여 구성을 적용합니다. 🎜rrreee🎜🎜🎜Spark의 핵심 파일 구성: 🎜Spark 압축 해제 디렉터리에 들어가서 conf/spark-env.sh.template를 복사합니다. 파일 이름을 conf/spark-env.sh로 바꿉니다. conf/spark-env.sh 파일을 편집하고 다음 내용을 추가합니다. 🎜rrreee🎜 그 중 JAVA_HOME을 Java 설치 경로 로 설정해야 합니다. >HADOOP_HOME Hadoop 설치 경로로 설정해야 하며, SPARK_MASTER_HOST는 현재 머신의 IP 주소로 설정됩니다. 🎜🎜🎜파일을 저장한 후 Spark를 시작하세요: 🎜rrreee🎜Spark의 마스터 주소를 보려면 다음 명령을 실행하세요: 🎜rrreee🎜Spark Worker 시작: 🎜rrreee🎜 그 중 <master-ip> 는 Spark 마스터 주소의 IP 주소이고, <master-port>는 Spark 마스터 주소의 포트 번호입니다. 🎜🎜요약: 이 문서에서는 Hadoop 및 Spark를 포함하여 빅 데이터 처리 및 분석을 위한 애플리케이션과 도구를 지원하도록 Linux 시스템을 구성하는 방법을 설명합니다. Linux 시스템을 올바르게 구성하면 빅데이터 처리 및 분석의 효율성과 신뢰성을 향상시킬 수 있습니다. 독자는 이 기사의 지침과 샘플 코드를 기반으로 Linux 시스템의 구성 및 적용을 연습할 수 있습니다. 🎜위 내용은 빅데이터 처리 및 분석을 지원하도록 Linux 시스템 구성의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7692

7692

15

15

1639

1639

14

14

1393

1393

52

52

1287

1287

25

25

1229

1229

29

29

Pandas를 사용하여 CSV 파일을 읽고 데이터 분석을 수행합니다.

Jan 09, 2024 am 09:26 AM

Pandas를 사용하여 CSV 파일을 읽고 데이터 분석을 수행합니다.

Jan 09, 2024 am 09:26 AM

Pandas는 다양한 유형의 데이터 파일을 쉽게 읽고 처리할 수 있는 강력한 데이터 분석 도구입니다. 그중 CSV 파일은 가장 일반적이고 일반적으로 사용되는 데이터 파일 형식 중 하나입니다. 이 기사에서는 Pandas를 사용하여 CSV 파일을 읽고 데이터 분석을 수행하는 방법을 소개하고 구체적인 코드 예제를 제공합니다. 1. 필요한 라이브러리 가져오기 먼저 아래와 같이 필요할 수 있는 Pandas 라이브러리 및 기타 관련 라이브러리를 가져와야 합니다. importpandasasspd 2. Pan을 사용하여 CSV 파일 읽기

데이터 분석 방법 소개

Jan 08, 2024 am 10:22 AM

데이터 분석 방법 소개

Jan 08, 2024 am 10:22 AM

일반적인 데이터 분석 방법: 1. 비교 분석 방법 3. 교차 분석 방법 5. 원인 및 영향 분석 방법 8. , 주성분 분석 방법 9. 분산 분석 방법 10. 매트릭스 분석 방법. 세부 소개: 1. 비교 분석 방법: 둘 이상의 데이터를 비교 분석하여 차이점과 패턴을 찾습니다. 2. 구조 분석 방법: 전체의 각 부분을 비교 분석하는 방법 3. 교차 분석 방법. , 등.

C++ 기술의 빅 데이터 처리: 그래프 데이터베이스를 사용하여 대규모 그래프 데이터를 저장하고 쿼리하는 방법은 무엇입니까?

Jun 03, 2024 pm 12:47 PM

C++ 기술의 빅 데이터 처리: 그래프 데이터베이스를 사용하여 대규모 그래프 데이터를 저장하고 쿼리하는 방법은 무엇입니까?

Jun 03, 2024 pm 12:47 PM

C++ 기술은 그래프 데이터베이스를 활용하여 대규모 그래프 데이터를 처리할 수 있습니다. 구체적인 단계에는 TinkerGraph 인스턴스 생성, 정점 및 모서리 추가, 쿼리 공식화, 결과 값 가져오기, 결과를 목록으로 변환 등이 포함됩니다.

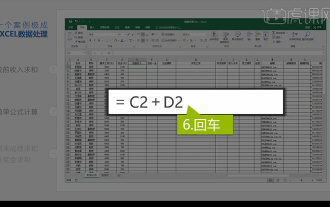

통합 엑셀 데이터 분석

Mar 21, 2024 am 08:21 AM

통합 엑셀 데이터 분석

Mar 21, 2024 am 08:21 AM

1. 이번 강의에서는 엑셀 통합 데이터 분석에 대해 설명하겠습니다. 강의 자료를 열고 E2 셀을 클릭하여 수식을 입력해 보겠습니다. 2. 그런 다음 E53 셀을 선택하여 다음 데이터를 모두 계산합니다. 3. 그런 다음 F2 셀을 클릭하고 수식을 입력하여 계산합니다. 마찬가지로 아래로 드래그하면 원하는 값을 계산할 수 있습니다. 4. G2 셀을 선택하고 데이터 탭을 클릭한 다음 데이터 유효성 검사를 클릭하고 선택하고 확인합니다. 5. 같은 방법으로 계산이 필요한 아래 셀도 자동으로 채워보겠습니다. 6. 다음으로 실제 임금을 계산하고 H2 셀을 선택하여 수식을 입력합니다. 7. 그런 다음 값 드롭다운 메뉴를 클릭하여 다른 숫자를 클릭합니다.

추천하는 데이터 분석 사이트는 무엇인가요?

Mar 13, 2024 pm 05:44 PM

추천하는 데이터 분석 사이트는 무엇인가요?

Mar 13, 2024 pm 05:44 PM

권장사항: 1. 비즈니스 데이터 분석 포럼, 2. 전국 인민대표대회 경제 포럼 - 계량경제학 및 통계 분야, 4. 데이터 마이닝 학습 및 교환 포럼, 6. 웹사이트 데이터 분석, 8. 데이터 마이닝 연구소 9. S-PLUS, R 통계 포럼.

C++ 기술의 빅 데이터 처리: 스트림 처리 기술을 사용하여 빅 데이터 스트림을 처리하는 방법은 무엇입니까?

Jun 01, 2024 pm 10:34 PM

C++ 기술의 빅 데이터 처리: 스트림 처리 기술을 사용하여 빅 데이터 스트림을 처리하는 방법은 무엇입니까?

Jun 01, 2024 pm 10:34 PM

스트림 처리 기술은 빅 데이터 처리에 사용됩니다. 스트림 처리는 데이터 스트림을 실시간으로 처리하는 기술입니다. C++에서는 스트림 처리에 Apache Kafka를 사용할 수 있습니다. 스트림 처리는 실시간 데이터 처리, 확장성 및 내결함성을 제공합니다. 이 예에서는 ApacheKafka를 사용하여 Kafka 주제에서 데이터를 읽고 평균을 계산합니다.

데이터 분석 및 과학 컴퓨팅을 위해 numpy 라이브러리를 사용하는 방법을 알아보세요.

Jan 19, 2024 am 08:05 AM

데이터 분석 및 과학 컴퓨팅을 위해 numpy 라이브러리를 사용하는 방법을 알아보세요.

Jan 19, 2024 am 08:05 AM

정보화 시대의 도래와 함께 데이터 분석과 과학 컴퓨팅은 점점 더 많은 분야에서 중요한 부분이 되었습니다. 이 과정에서 데이터 처리 및 분석을 위한 컴퓨터의 사용은 필수적인 도구가 되었습니다. Python에서 numpy 라이브러리는 데이터를 보다 효율적으로 처리 및 분석하고 결과를 더 빠르게 얻을 수 있는 매우 중요한 도구입니다. 이 기사에서는 numpy의 일반적인 기능과 사용법을 소개하고, 깊이 있게 학습하는 데 도움이 되는 몇 가지 구체적인 코드 예제를 제공합니다. Numpy 라이브러리 설치

C++ 기술의 빅데이터 처리: 효율적인 텍스트 마이닝 및 빅데이터 분석을 달성하는 방법은 무엇입니까?

Jun 02, 2024 am 10:39 AM

C++ 기술의 빅데이터 처리: 효율적인 텍스트 마이닝 및 빅데이터 분석을 달성하는 방법은 무엇입니까?

Jun 02, 2024 am 10:39 AM

C++는 텍스트 마이닝 및 데이터 분석에서 중요한 역할을 하며 복잡한 분석 작업을 위한 효율적인 텍스트 마이닝 엔진과 처리 기능을 제공합니다. 텍스트 마이닝 측면에서: C++는 빅 데이터 분석 측면에서 텍스트 데이터에서 정보를 추출하는 텍스트 마이닝 엔진을 구축할 수 있습니다. C++는 대규모 데이터 세트를 처리하는 복잡한 분석 작업에 적합하며 평균 및 표준 편차와 같은 통계를 계산할 수 있습니다. . 실제 사례: 한 소매 회사는 C++로 개발된 텍스트 마이닝 엔진을 사용하여 고객 리뷰를 분석하고 제품 품질, 고객 서비스 및 배송 시간에 대한 통찰력을 얻었습니다.