PHP 및 phpSpider: 크롤러 방지 웹사이트의 IP 금지를 처리하는 방법은 무엇입니까?

PHP 및 phpSpider: 크롤러 방지 웹사이트의 IP 금지를 처리하는 방법은 무엇입니까?

소개:

웹 크롤링이나 데이터 수집 과정에서 크롤러 방지 전략을 채택하고 자주 액세스 요청을 시작하는 IP를 차단하는 일부 웹사이트를 자주 접하게 됩니다. 이 기사에서는 PHP와 phpSpider 프레임워크를 사용하여 IP 차단 전략을 처리하는 방법을 소개하고 코드 예제를 제공합니다.

- IP 차단 원칙 및 대응 전략

웹사이트 IP 차단 원칙은 일반적으로 IP 주소의 접속 빈도나 주어진 규칙의 일치 여부에 따라 결정됩니다. 이 차단 전략을 처리하기 위해 다음 방법을 사용할 수 있습니다. - 프록시 IP 사용: 프록시 IP를 사용하면 각 요청이 다른 IP를 통해 액세스되므로 웹사이트에서 차단되는 것을 방지할 수 있습니다. 이는 비교적 간단하고 직접적인 방법으로 phpSpider 프레임워크의 프록시 플러그인을 사용하여 이 기능을 구현할 수 있습니다. 샘플 코드는 다음과 같습니다.

<?php

require 'vendor/autoload.php';

use phpspidercorephpspider;

use phpspidercoreequests;

// 设置代理ip

requests::set_proxy('http', 'ip地址', '端口号');

// 设置用户代理,模拟真实浏览器行为

requests::set_useragent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3');

// 其他请求设置...

$configs = array(

'name' => '代理ip示例',

'log_show' => true,

'user_agent' => 'Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html)',

'domains' => array(

'example.com',

),

'scan_urls' => array(

'http://example.com/',

),

'list_url_regex' => array(

"http://example.com/list/d+",

),

'content_url_regex' => array(

"http://example.com/content/d+",

),

// 其他爬虫配置...

);

$spider = new phpspider($configs);

$spider->start();- IP 프록시 풀 사용: 안정적이고 사용 가능한 IP 프록시를 유지합니다. 풀, 무작위로 액세스를 위해 다른 프록시 IP를 선택하여 금지될 위험을 줄이세요. 타사 IP 프록시 서비스를 사용하거나 자체 IP 프록시 풀을 구축할 수 있습니다. 샘플 코드는 다음과 같습니다.

<?php

require 'vendor/autoload.php';

use phpspidercorephpspider;

use phpspidercoreequests;

// 获取IP代理

function get_proxy_ip()

{

// 从代理池中随机选择一个IP

// ... 从代理池获取代理IP的代码

return $proxy_ip;

}

// 设置代理IP

requests::set_proxy('http', get_proxy_ip());

// 其他请求设置...

$configs = array(

// 爬虫配置

// ...

);

$spider = new phpspider($configs);

$spider->start();- 요청 빈도 조정: 금지된 이유가 요청을 자주 보내는 것인 경우 요청 빈도를 조정하고 요청 간격을 늘려 한 번에 많은 요청을 보내는 것을 방지할 수 있습니다. 짧은 시간. 샘플 코드는 다음과 같습니다.

<?php

require 'vendor/autoload.php';

use phpspidercorephpspider;

use phpspidercoreequests;

// 设置请求间隔时间

requests::set_sleep_time(1000); // 1秒

// 其他请求设置...

$configs = array(

// 爬虫配置

// ...

);

$spider = new phpspider($configs);

$spider->start();- phpSpider 프레임워크를 사용하여 크롤러 방지 전략 구현

phpSpider는 웹 크롤러의 개발 프로세스를 단순화하고 일반적으로 사용되는 일부 기능 플러그인을 제공하는 PHP 웹 크롤러 프레임워크입니다. 안티 크롤러를 처리해야 하는 웹사이트를 크롤링할 때 phpSpider 프레임워크에서 제공하는 기능을 사용하여 해당 전략을 구현할 수 있습니다. 다음은 몇 가지 일반적인 기능 플러그인 및 샘플 코드입니다. - Useragent 플러그인: 위장된 Useragent 헤더 정보를 설정하여 웹사이트에서 크롤러로 인식되는 것을 방지할 수 있는 브라우저 요청을 시뮬레이션합니다. 샘플 코드는 다음과 같습니다.

<?php

require 'vendor/autoload.php';

use phpspidercorephpspider;

use phpspidercoreequests;

use phpspidercoreselector;

// 设置Useragent

requests::set_useragent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3');

// 其他请求设置...

$configs = array(

// 爬虫配置

// ...

);

$spider = new phpspider($configs);

$spider->start();- Referer 플러그인: 사용자가 점프하는 페이지를 시뮬레이션하기 위해 유효한 Referer 값을 설정합니다. 이는 때때로 일부 크롤링 방지 감지를 우회할 수 있습니다. 샘플 코드는 다음과 같습니다.

<?php

require 'vendor/autoload.php';

use phpspidercorephpspider;

use phpspidercoreequests;

// 设置Referer

requests::referer('http://www.example.com');

// 其他请求设置...

$configs = array(

// 爬虫配置

// ...

);

$spider = new phpspider($configs);

$spider->start();요약:

이 글에서는 PHP 및 phpSpider 프레임워크에서 크롤러 방지 웹사이트의 IP 차단 전략을 처리하는 방법을 소개합니다. 프록시 IP, IP 프록시 풀, 요청 빈도 조정 및 기타 방법을 사용하면 차단될 위험을 효과적으로 피할 수 있습니다. 동시에 phpSpider 프레임워크는 Useragent 플러그인 및 Referer 플러그인과 같은 일부 기능 플러그인을 제공하여 브라우저 동작을 더 잘 시뮬레이션하고 크롤러 방지 전략에 추가로 대응하는 데 도움이 됩니다. 이 기사가 웹 크롤러 및 데이터 수집 개발자에게 도움이 되기를 바랍니다.

위 내용은 PHP 및 phpSpider: 크롤러 방지 웹사이트의 IP 금지를 처리하는 방법은 무엇입니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7440

7440

15

15

1370

1370

52

52

76

76

11

11

32

32

19

19

CakePHP 프로젝트 구성

Sep 10, 2024 pm 05:25 PM

CakePHP 프로젝트 구성

Sep 10, 2024 pm 05:25 PM

이번 장에서는 CakePHP의 환경 변수, 일반 구성, 데이터베이스 구성, 이메일 구성에 대해 알아봅니다.

Ubuntu 및 Debian용 PHP 8.4 설치 및 업그레이드 가이드

Dec 24, 2024 pm 04:42 PM

Ubuntu 및 Debian용 PHP 8.4 설치 및 업그레이드 가이드

Dec 24, 2024 pm 04:42 PM

PHP 8.4는 상당한 양의 기능 중단 및 제거를 통해 몇 가지 새로운 기능, 보안 개선 및 성능 개선을 제공합니다. 이 가이드에서는 Ubuntu, Debian 또는 해당 파생 제품에서 PHP 8.4를 설치하거나 PHP 8.4로 업그레이드하는 방법을 설명합니다.

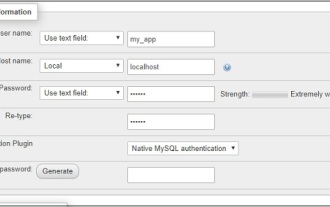

CakePHP 데이터베이스 작업

Sep 10, 2024 pm 05:25 PM

CakePHP 데이터베이스 작업

Sep 10, 2024 pm 05:25 PM

CakePHP에서 데이터베이스 작업은 매우 쉽습니다. 이번 장에서는 CRUD(생성, 읽기, 업데이트, 삭제) 작업을 이해하겠습니다.

CakePHP 토론

Sep 10, 2024 pm 05:28 PM

CakePHP 토론

Sep 10, 2024 pm 05:28 PM

CakePHP는 PHP용 오픈 소스 프레임워크입니다. 이는 애플리케이션을 훨씬 쉽게 개발, 배포 및 유지 관리할 수 있도록 하기 위한 것입니다. CakePHP는 강력하고 이해하기 쉬운 MVC와 유사한 아키텍처를 기반으로 합니다. 모델, 뷰 및 컨트롤러 gu