BigDL-LLM을 사용하여 수백억 개의 매개변수 LLM 추론을 즉시 가속화합니다.

대형 언어 모델(LLM)을 기반으로 한 AI의 새로운 시대를 맞이하고 있습니다. LLM은 고객 서비스, 가상 비서, 콘텐츠 제작, 프로그래밍 지원 등 다양한 애플리케이션에서 점점 더 중요한 역할을 하고 있습니다.

그러나 LLM의 규모가 계속 확장됨에 따라 대형 모델을 실행하는 데 필요한 리소스 소비도 증가하여 작업 속도가 점점 느려지고 이는 AI 응용 프로그램 개발자에게 상당한 어려움을 안겨줍니다.

이를 위해 Intel은 최근 BigDL-LLM[1]이라는 대규모 모델 오픈 소스 라이브러리를 출시했습니다. 이 라이브러리는 AI 개발자와 연구원이 Intel ® 플랫폼에서 대규모 언어 모델의 최적화를 가속화하고 Intel ® 플랫폼에서 대규모 언어 모델을 사용한 경험.

다음은 Intel® Xeon® Platinum 8468이 장착된 시스템에서 BigDL-LLM을 사용하여 가속되는 330억 매개변수의 대규모 언어 모델 Vicuna-33b-v1.3[2]을 보여줍니다. 프로세서는 서버에서 실시간 효과를 실행합니다.

ΔIntel® Xeon® Platinum 8468 프로세서(실시간 화면 녹화)가 탑재된 서버에서 330억 매개변수 대규모 언어 모델을 실행하는 실제 속도

BigDL-LLM: Intel® 플랫폼의 오픈 소스 대형 언어 모델 가속 라이브러리

BigDL-LLM은 BigDL의 일부이며 Apache 2.0 라이선스로 출시됩니다.

다양한 저급 언어 모델을 제공합니다. 수준의 정밀 최적화(예: INT4/INT5/INT8), 다양한 Intel® CPU 통합 하드웨어 가속 기술(AVX/VNNI/AMX 등) 및 최신 소프트웨어 최적화를 활용하여 대규모 언어 모델을 강화할 수 있습니다. Intel® 플랫폼에서 더 효율적인 최적화와 더 빠른 작동을 달성하세요.

BigDL-LLM의 중요한 기능은 Hugging Face Transformers API를 기반으로 하는 모델의 경우 코드 한 줄만 변경하면 모델을 가속화할 수 있다는 것입니다. 이론적으로는 anyTransformers 모델 실행을 지원할 수 있습니다. 이는 Transformers에 익숙한 사람들에게 유용합니다. API 개발자들은 매우 친절합니다.

Transformers API 외에도 많은 사람들이 LangChain을 사용하여 대규모 언어 모델 애플리케이션을 개발합니다.

이를 위해 BigDL-LLM은 사용하기 쉬운 LangChain 통합[3]도 제공하므로 개발자는 BigDL-LLM을 쉽게 사용하여 Transformers API 또는 LangChain API를 기반으로 새로운 애플리케이션을 개발하거나 기존 애플리케이션을 마이그레이션할 수 있습니다.

또한 일반 PyTorch 대규모 언어 모델(Transformer 또는 LangChain API를 사용하지 않는 모델)의 경우 BigDL-LLMoptim_model API 원클릭 가속을 사용하여 성능을 향상시킬 수도 있습니다. 자세한 내용은 GitHub README[4] 및 공식 문서[5]를 참조하세요.

BigDL-LLM은 또한 일반적으로 사용되는 다수의 오픈 소스 LLM 가속 샘플(예: Transformers API[6]을 사용하는 샘플 및 LangChain API[7]을 사용하는 샘플)과 튜토리얼(jupyter 노트북 지원 포함)을 제공합니다. [8], 개발자가 빠르게 시작하고 사용해 볼 수 있어 편리합니다.

설치 및 사용: 간단한 설치 과정과 사용하기 쉬운 API 인터페이스

BigDL-LLM을 설치하는 것이 매우 편리합니다. 다음을 실행하기만 하면 됩니다. 명령:

pip install --pre --upgrade bigdl-llm[all]

Δ코드가 완전히 표시되지 않으면 왼쪽이나 오른쪽으로 슬라이드하세요.

BigDL-LLM을 사용하여 대형 모델을 가속화하는 것도 매우 쉽습니다(여기서는 Transformers 스타일 API만 사용합니다) 예)

BigDL-LLM Transformer 스타일 API를 사용하면 모델을 로드하는 부분만 변경하면 됩니다. 이후의 사용 프로세스는 모델을 로드하는 방법과 완전히 동일합니다. BigDL-LLM API를 사용하는 것은 Transformers API와 거의 동일합니다. 사용자는 가져오기를 변경하고 from_pretrained 매개변수에 설정하기만 하면 됩니다.

load_in_4bit=True그렇습니다. 모델 로딩 과정에서 비트 저정밀 양자화를 수행하고 후속 추론 과정에서 최적화를 위해 다양한 소프트웨어 및 하드웨어 가속 기술을 사용합니다#Load Hugging Face Transformers model with INT4 optimizationsfrom bigdl.llm. transformers import AutoModelForCausalLMmodel = AutoModelForCausalLM.from_pretrained('/path/to/model/', load_in_4bit=True)

Δ

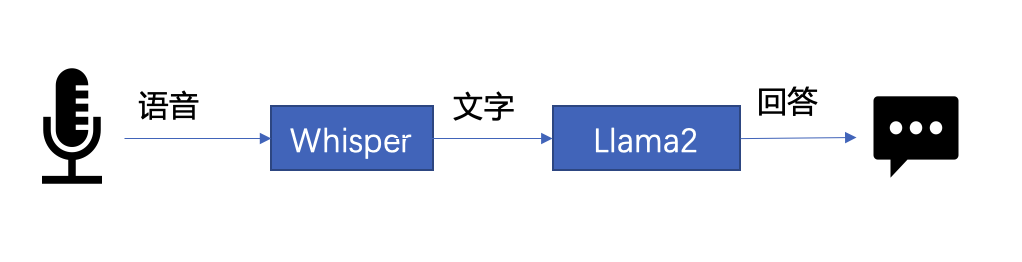

코드가 완전히 표시되지 않으면 왼쪽 또는 오른쪽으로 슬라이드하세요 下文将以 LLM 常见应用场景“语音助手”为例,展示采用 BigDL-LLM 快速实现 LLM 应用的案例。通常情况下,语音助手应用的工作流程分为以下两个部分: 以下是本文使用 BigDL-LLM 和 LangChain[11] 来搭建语音助手应用的过程: 在语音识别阶段:第一步,加载预处理器 processor 和语音识别模型 recog_model。本示例中使用的识别模型 Whisper 是一个 Transformers 模型。 只需使用 BigDL-LLM 中的 AutoModelForSpeechSeq2Seq 并设置参数 load_in_4bit=True,就能够以 INT4 精度加载并加速这一模型,从而显著缩短模型推理用时。 △若代码显示不全,请左右滑动 第二步,进行语音识别。首先使用处理器从输入语音中提取输入特征,然后使用识别模型预测 token,并再次使用处理器将 token 解码为自然语言文本。 △若代码显示不全,请左右滑动 在文本生成阶段,首先使用 BigDL-LLM 的 TransformersLLM API 创建一个 LangChain 语言模型(TransformersLLM 是在 BigDL-LLM 中定义的语言链 LLM 集成)。 可以使用这个 API 来加载 Hugging Face Transformers 的任何模型 △若代码显示不全,请左右滑动 然后,创建一个正常的对话链 LLMChain,并将已经创建的 llm 设置为输入参数。 △若代码显示不全,请左右滑动 以下代码将使用一个链条来记录所有对话历史,并将其适当地格式化为大型语言模型的输入。这样,我们可以生成合适的回复。只需将识别模型生成的文本作为 "human_input" 输入即可。代码如下: △若代码显示不全,请左右滑动 最后,将语音识别和文本生成步骤放入循环中,即可在多轮对话中与该“语音助手”交谈。您可访问底部 [12] 链接,查看完整的示例代码,并使用自己的电脑进行尝试。快用 BigDL-LLM 来快速搭建自己的语音助手吧! 黄晟盛是英特尔公司的资深架构师,黄凯是英特尔公司的AI框架工程师,戴金权是英特尔院士、大数据技术全球CTO和BigDL项目的创始人,他们都从事着与大数据和AI相关的工作示例:快速实现一个基于大语言模型的语音助手应用

△图 1. 语音助手工作流程示意

#processor = WhisperProcessor .from_pretrained(recog_model_path)recog_model = AutoModelForSpeechSeq2Seq .from_pretrained(recog_model_path, load_in_4bit=True)

input_features = processor(frame_data,sampling_rate=audio.sample_rate,return_tensor=“pt”).input_featurespredicted_ids = recogn_model.generate(input_features, forced_decoder_ids=forced_decoder_ids)text = processor.batch_decode(predicted_ids, skip_special_tokens=True)[0]

llm = TransformersLLM . from_model_id(model_id=llm_model_path,model_kwargs={"temperature": 0, "max_length": args.max_length, "trust_remote_code": True},)# The following code is complete the same as the use-casevoiceassistant_chain = LLMChain(llm=llm, prompt=prompt,verbose=True,memory=ConversationBufferWindowMemory(k=2),)

response_text = voiceassistant_chain .predict(human_input=text, stop=”\n\n”)

作者简介

위 내용은 BigDL-LLM을 사용하여 수백억 개의 매개변수 LLM 추론을 즉시 가속화합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7514

7514

15

15

1378

1378

52

52

79

79

11

11

53

53

19

19

19

19

64

64

Bytedance Cutting, SVIP 슈퍼 멤버십 출시: 연간 연속 구독료 499위안, 다양한 AI 기능 제공

Jun 28, 2024 am 03:51 AM

Bytedance Cutting, SVIP 슈퍼 멤버십 출시: 연간 연속 구독료 499위안, 다양한 AI 기능 제공

Jun 28, 2024 am 03:51 AM

이 사이트는 6월 27일에 Jianying이 ByteDance의 자회사인 FaceMeng Technology에서 개발한 비디오 편집 소프트웨어라고 보도했습니다. 이 소프트웨어는 Douyin 플랫폼을 기반으로 하며 기본적으로 플랫폼 사용자를 위한 짧은 비디오 콘텐츠를 제작합니다. Windows, MacOS 및 기타 운영 체제. Jianying은 멤버십 시스템 업그레이드를 공식 발표하고 지능형 번역, 지능형 하이라이트, 지능형 패키징, 디지털 인간 합성 등 다양한 AI 블랙 기술을 포함하는 새로운 SVIP를 출시했습니다. 가격면에서 SVIP 클리핑 월 요금은 79위안, 연간 요금은 599위안(본 사이트 참고: 월 49.9위안에 해당), 월간 연속 구독료는 월 59위안, 연간 연속 구독료는 59위안입니다. 연간 499위안(월 41.6위안)입니다. 또한, 컷 관계자는 "사용자 경험 향상을 위해 기존 VIP에 가입하신 분들도

Rag 및 Sem-Rag를 사용한 상황 증강 AI 코딩 도우미

Jun 10, 2024 am 11:08 AM

Rag 및 Sem-Rag를 사용한 상황 증강 AI 코딩 도우미

Jun 10, 2024 am 11:08 AM

검색 강화 생성 및 의미론적 메모리를 AI 코딩 도우미에 통합하여 개발자 생산성, 효율성 및 정확성을 향상시킵니다. EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG에서 번역됨, 저자 JanakiramMSV. 기본 AI 프로그래밍 도우미는 자연스럽게 도움이 되지만, 소프트웨어 언어에 대한 일반적인 이해와 소프트웨어 작성의 가장 일반적인 패턴에 의존하기 때문에 가장 관련성이 높고 정확한 코드 제안을 제공하지 못하는 경우가 많습니다. 이러한 코딩 도우미가 생성한 코드는 자신이 해결해야 할 문제를 해결하는 데 적합하지만 개별 팀의 코딩 표준, 규칙 및 스타일을 따르지 않는 경우가 많습니다. 이로 인해 코드가 애플리케이션에 승인되기 위해 수정되거나 개선되어야 하는 제안이 나타나는 경우가 많습니다.

미세 조정을 통해 LLM이 실제로 새로운 것을 배울 수 있습니까? 새로운 지식을 도입하면 모델이 더 많은 환각을 생성할 수 있습니다.

Jun 11, 2024 pm 03:57 PM

미세 조정을 통해 LLM이 실제로 새로운 것을 배울 수 있습니까? 새로운 지식을 도입하면 모델이 더 많은 환각을 생성할 수 있습니다.

Jun 11, 2024 pm 03:57 PM

LLM(대형 언어 모델)은 대규모 텍스트 데이터베이스에서 훈련되어 대량의 실제 지식을 습득합니다. 이 지식은 매개변수에 내장되어 필요할 때 사용할 수 있습니다. 이러한 모델에 대한 지식은 훈련이 끝나면 "구체화"됩니다. 사전 훈련이 끝나면 모델은 실제로 학습을 중단합니다. 모델을 정렬하거나 미세 조정하여 이 지식을 활용하고 사용자 질문에 보다 자연스럽게 응답하는 방법을 알아보세요. 그러나 때로는 모델 지식만으로는 충분하지 않을 때도 있으며, 모델이 RAG를 통해 외부 콘텐츠에 접근할 수 있더라도 미세 조정을 통해 모델을 새로운 도메인에 적응시키는 것이 유익한 것으로 간주됩니다. 이러한 미세 조정은 인간 주석 작성자 또는 기타 LLM 생성자의 입력을 사용하여 수행됩니다. 여기서 모델은 추가적인 실제 지식을 접하고 이를 통합합니다.

7가지 멋진 GenAI 및 LLM 기술 인터뷰 질문

Jun 07, 2024 am 10:06 AM

7가지 멋진 GenAI 및 LLM 기술 인터뷰 질문

Jun 07, 2024 am 10:06 AM

AIGC에 대해 자세히 알아보려면 다음을 방문하세요. 51CTOAI.x 커뮤니티 https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou는 인터넷 어디에서나 볼 수 있는 전통적인 문제 은행과 다릅니다. 고정관념에서 벗어나 생각해야 합니다. LLM(대형 언어 모델)은 데이터 과학, 생성 인공 지능(GenAI) 및 인공 지능 분야에서 점점 더 중요해지고 있습니다. 이러한 복잡한 알고리즘은 인간의 기술을 향상시키고 많은 산업 분야에서 효율성과 혁신을 촉진하여 기업이 경쟁력을 유지하는 데 핵심이 됩니다. LLM은 자연어 처리, 텍스트 생성, 음성 인식 및 추천 시스템과 같은 분야에서 광범위하게 사용될 수 있습니다. LLM은 대량의 데이터로부터 학습하여 텍스트를 생성할 수 있습니다.

대형 모델에 대한 새로운 과학적이고 복잡한 질문 답변 벤치마크 및 평가 시스템을 제공하기 위해 UNSW, Argonne, University of Chicago 및 기타 기관이 공동으로 SciQAG 프레임워크를 출시했습니다.

Jul 25, 2024 am 06:42 AM

대형 모델에 대한 새로운 과학적이고 복잡한 질문 답변 벤치마크 및 평가 시스템을 제공하기 위해 UNSW, Argonne, University of Chicago 및 기타 기관이 공동으로 SciQAG 프레임워크를 출시했습니다.

Jul 25, 2024 am 06:42 AM

편집자 |ScienceAI 질문 응답(QA) 데이터 세트는 자연어 처리(NLP) 연구를 촉진하는 데 중요한 역할을 합니다. 고품질 QA 데이터 세트는 모델을 미세 조정하는 데 사용될 수 있을 뿐만 아니라 LLM(대형 언어 모델)의 기능, 특히 과학적 지식을 이해하고 추론하는 능력을 효과적으로 평가하는 데에도 사용할 수 있습니다. 현재 의학, 화학, 생물학 및 기타 분야를 포괄하는 과학적인 QA 데이터 세트가 많이 있지만 이러한 데이터 세트에는 여전히 몇 가지 단점이 있습니다. 첫째, 데이터 형식이 비교적 단순하고 대부분이 객관식 질문이므로 평가하기 쉽지만 모델의 답변 선택 범위가 제한되고 모델의 과학적 질문 답변 능력을 완전히 테스트할 수 없습니다. 이에 비해 개방형 Q&A는

AI 스타트업들이 집단적으로 OpenAI로 직무를 전환했고, Ilya가 떠난 후 보안팀이 재편성되었습니다!

Jun 08, 2024 pm 01:00 PM

AI 스타트업들이 집단적으로 OpenAI로 직무를 전환했고, Ilya가 떠난 후 보안팀이 재편성되었습니다!

Jun 08, 2024 pm 01:00 PM

지난주 내부 사퇴와 외부 비판의 물결 속에서 OpenAI는 대내외적 난관에 봉착했다. - 미망인 여동생의 침해로 글로벌 열띤 논의가 촉발됐다. - '대군주 조항'에 서명한 직원들이 잇달아 폭로됐다. - 네티즌들은 울트라맨의 '' 일곱 가지 대죄" ” 소문 파기: Vox가 입수한 유출된 정보와 문서에 따르면 Altman을 포함한 OpenAI의 고위 경영진은 이러한 지분 회수 조항을 잘 알고 있었고 이에 서명했습니다. 또한 OpenAI가 직면한 심각하고 시급한 문제인 AI 보안이 있습니다. 최근 가장 눈에 띄는 직원 2명을 포함해 보안 관련 직원 5명이 퇴사하고, '슈퍼얼라인먼트' 팀이 해체되면서 OpenAI의 보안 문제가 다시 한 번 주목을 받고 있다. 포춘지는 OpenA가

당신이 모르는 머신러닝의 5가지 학교

Jun 05, 2024 pm 08:51 PM

당신이 모르는 머신러닝의 5가지 학교

Jun 05, 2024 pm 08:51 PM

머신 러닝은 명시적으로 프로그래밍하지 않고도 컴퓨터가 데이터로부터 학습하고 능력을 향상시킬 수 있는 능력을 제공하는 인공 지능의 중요한 분야입니다. 머신러닝은 이미지 인식, 자연어 처리, 추천 시스템, 사기 탐지 등 다양한 분야에서 폭넓게 활용되며 우리의 삶의 방식을 변화시키고 있습니다. 기계 학습 분야에는 다양한 방법과 이론이 있으며, 그 중 가장 영향력 있는 5가지 방법을 "기계 학습의 5개 학교"라고 합니다. 5개 주요 학파는 상징학파, 연결주의 학파, 진화학파, 베이지안 학파, 유추학파이다. 1. 상징주의라고도 알려진 상징주의는 논리적 추론과 지식 표현을 위해 상징을 사용하는 것을 강조합니다. 이 사고 학교는 학습이 기존을 통한 역연역 과정이라고 믿습니다.

SOTA 성능, 샤먼 다중 모드 단백질-리간드 친화성 예측 AI 방법, 최초로 분자 표면 정보 결합

Jul 17, 2024 pm 06:37 PM

SOTA 성능, 샤먼 다중 모드 단백질-리간드 친화성 예측 AI 방법, 최초로 분자 표면 정보 결합

Jul 17, 2024 pm 06:37 PM

Editor | KX 약물 연구 및 개발 분야에서 단백질과 리간드의 결합 친화도를 정확하고 효과적으로 예측하는 것은 약물 스크리닝 및 최적화에 매우 중요합니다. 그러나 현재 연구에서는 단백질-리간드 상호작용에서 분자 표면 정보의 중요한 역할을 고려하지 않습니다. 이를 기반으로 Xiamen University의 연구자들은 처음으로 단백질 표면, 3D 구조 및 서열에 대한 정보를 결합하고 교차 주의 메커니즘을 사용하여 다양한 양식 특징을 비교하는 새로운 다중 모드 특징 추출(MFE) 프레임워크를 제안했습니다. 조정. 실험 결과는 이 방법이 단백질-리간드 결합 친화도를 예측하는 데 있어 최첨단 성능을 달성한다는 것을 보여줍니다. 또한 절제 연구는 이 프레임워크 내에서 단백질 표면 정보와 다중 모드 기능 정렬의 효율성과 필요성을 보여줍니다. 관련 연구는 "S"로 시작된다