Transformer를 기반으로 한 기본 시각적 모델은 분할 및 감지와 같은 다양한 다운스트림 작업에서 매우 강력한 성능을 보여주었으며, 자가 지도 학습 이후 DINO와 같은 모델은 의미론적 분할 속성을 가지고 등장했습니다.

지도 분류를 위한 훈련을 받은 후 시각적 Transformer 모델이 유사한 출현 능력을 나타내지 않는다는 것이 이상합니다

최근 Ma Yi 교수팀은 출현을 탐색하기 위해 Transformer 아키텍처 기반 모델을 연구했습니다. 분할 능력은 단순히 분할 능력입니까? 복잡한 자기 지도 학습 메커니즘의 결과 또는 모델 아키텍처를 적절하게 설계하여 보다 일반적인 조건에서 동일한 출현이 달성될 수 있는지 여부

코드 링크: https://github .com/Ma-Lab -Berkeley/CRATE

논문을 보려면 다음 링크를 클릭하세요: https://arxiv.org/abs/2308.16271

광범위한 실험 끝에 연구원들은 화이트박스 Transformer 모델을 사용하여 CRATE를 시연했습니다. 그 디자인은 데이터 분포에서 저차원 구조를 명시적으로 모델링하고 추구하며, 최소한의 감독 훈련 공식으로 전체 및 부분 수준 분할 속성이 나타납니다

계층적 세분화 분석을 통해 중요한 결론을 도출합니다. 창발 속성은 강력하게 확인합니다 화이트박스 네트워크의 설계 수학적 기능. 이 결과를 바탕으로 우리는 고성능일 뿐만 아니라 수학적으로 완벽하게 해석 가능한 화이트박스 기본 모델을 설계하는 방법을 제안했습니다.

마 이 교수는 또한 딥러닝에 대한 연구가 점차 경험적 설계는 이론적 지침으로 전환됩니다.

DINO의 분할 창발 능력은 언어 작업을 처리할 때 입력 문장을 더 작은 조각으로 분할하고 각 조각에 대해 분석을 수행하는 DINO 모델의 능력을 의미합니다. . 이 기능을 통해 DINO 모델은 복잡한 문장 구조와 의미 정보를 더 잘 이해할 수 있으므로 자연어 처리 분야의 성능이 향상됩니다.

지능형 시스템의 표현 학습은 표현의 고차원, 다중 모드 측면을 통합하는 것을 목표로 합니다. world 감각 데이터(이미지, 언어, 음성)를 기본 저차원 구조를 유지하면서 보다 컴팩트한 형태로 변환하여 효율적인 인식(분류 등), 그룹화(분할 등) 및 추적이 가능합니다.

딥 러닝 모델의 훈련은 일반적으로 대규모 데이터를 입력하고 자기 지도 방식으로 학습하는 데이터 중심 접근 방식을 채택합니다.

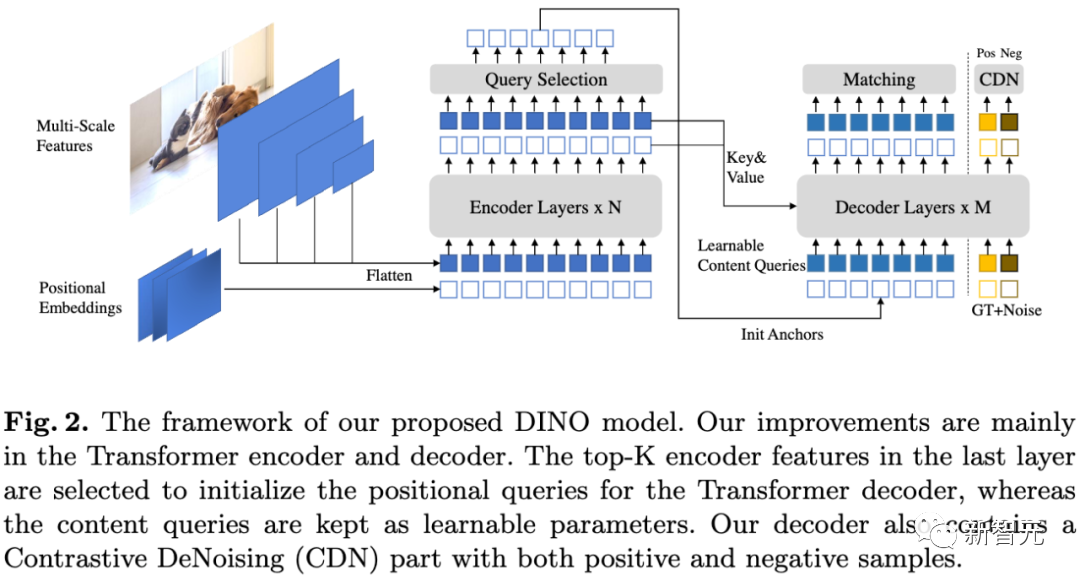

기본 시각적 모델 중에서 DINO 모델은 놀라운 Emergent 기능인 ViT는 감독된 분할 훈련 없이도 명시적인 의미론적 분할 정보를 인식할 수 있습니다. 자체 감독 Transformer 아키텍처의 DINO 모델은 이와 관련하여 좋은 성능을 발휘했습니다.

다음 작업에서는 DINO 모델에서 이 분할 정보를 활용하는 방법을 연구하고 다음과 같은 다운스트림 작업에서 최첨단 성능을 달성했습니다. 분할 및 감지 DINO로 훈련된 ViT의 두 번째 레이어 기능이 전경, 배경 및 객체 경계 구별과 같은 시각적 입력의 돌출성 정보와 밀접하게 관련되어 있음을 입증하는 작업도 있습니다. 다른 작업.

분할 속성을 강조하기 위해 DINO는 학습 과정에서 자기 지도 학습, 지식 증류 및 가중치 평균 방법을 능숙하게 결합해야 합니다.

DINO에 도입된 각 구성 요소가 세분화에 유용한지는 확실하지 않습니다. DINO도 ViT 아키텍처를 백본으로 사용하지만 분류 작업에 대해 훈련된 일반 지도 ViT 모델에서는 분할 출현 동작이 관찰되지 않았습니다.

CRATE의 출현

DINO의 성공을 기반으로 연구원들은 Transformer와 같은 시각적 모델에서 창발적 속성을 얻기 위해 복잡한 자기 지도 학습 파이프라인이 필요한지 여부를 탐구하고 싶었습니다.

연구원들은 Transformer 모델의 분할 속성을 촉진하는 유망한 방법은 입력 데이터 구조를 고려하여 Transformer 모델 아키텍처를 설계하는 것이라고 믿습니다. 이는 현대적인 데이터 기반 학습 통합으로 고전적인 방법을 학습하는 표현의 깊이도 나타냅니다. 프레임워크.

현재 주류를 이루는 Transformer 모델과 비교하면, 이 설계 방식은 화이트박스 Transformer 모델이라고도 할 수 있습니다.

Ma Yi 교수 그룹의 이전 작업을 기반으로 연구원들은 화이트 박스 아키텍처의 CRATE 모델에 대한 광범위한 실험을 수행하여 CRATE의 화이트 박스 디자인이 self-attention 그래프에서 분할 속성이 나타나는 이유임을 입증했습니다.

재공식화해야 할 것은: 정성적 평가

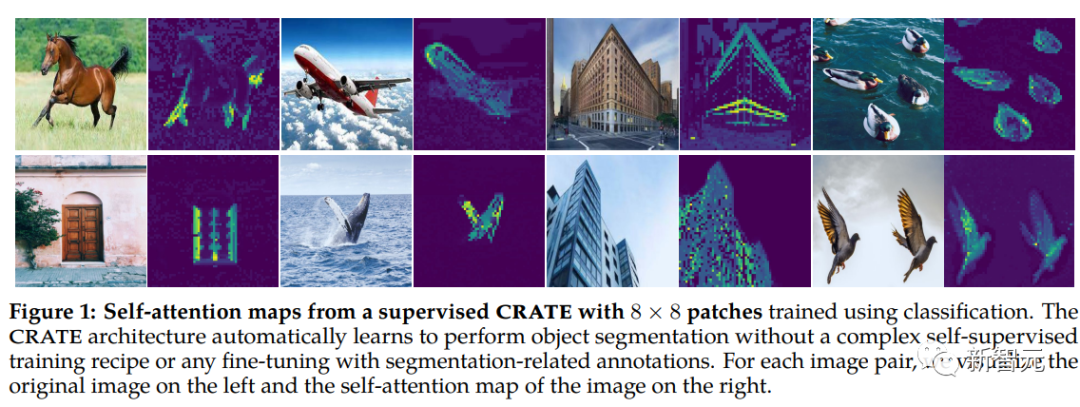

연구원들은 모델을 설명하고 시각화하기 위해 [CLS] 토큰 기반 어텐션 맵 방법을 사용했으며 CRATE에서 쿼리-키-값 행렬을 발견했습니다. 동일합니다

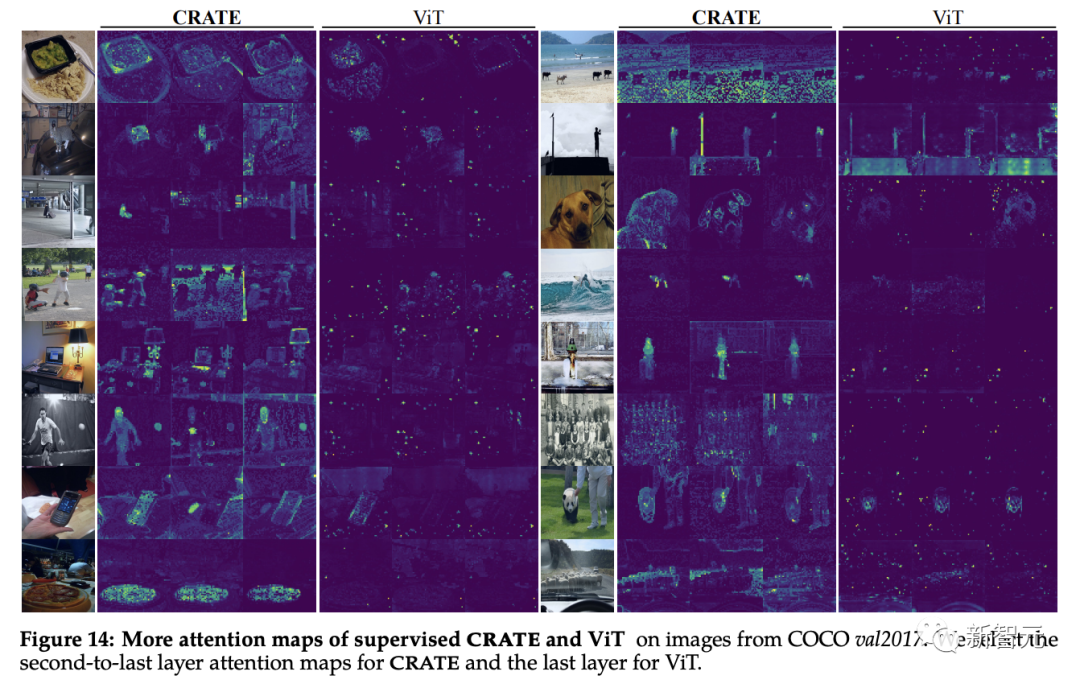

CRATE 모델의 self-attention 맵이 입력 이미지의 의미와 일치할 수 있음을 관찰할 수 있습니다. 모델의 내부 네트워크는 각 이미지에 대해 명확한 의미 분할을 수행합니다. DINO 모델과 유사한 효과를 얻었습니다.

일반 ViT는 감독 분류 작업을 훈련할 때 유사한 분할 속성을 나타내지 않습니다.

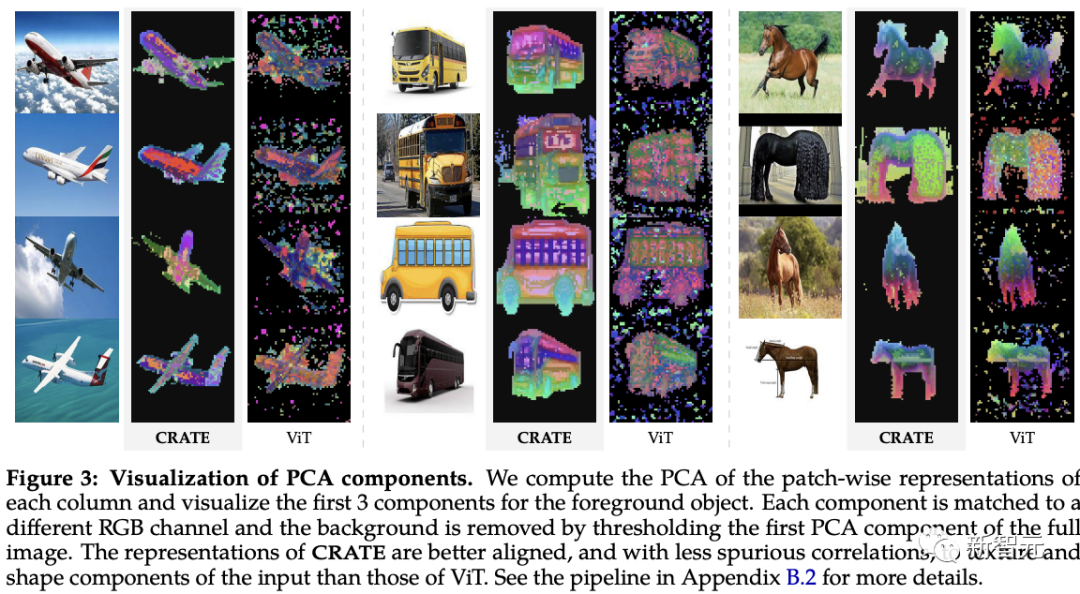

블록 단위 심층 기능의 시각적 이미지 학습에 대한 이전 연구를 기반으로 연구자들은 CRATE와 ViT를 비교했습니다. 모델은 주성분 분석(PCA)을 사용하여 연구되었으며 CRATE는 분할 지도 학습 없이도 이미지의 객체 경계를 캡처할 수 있음을 알 수 있습니다.

또한 주요 구성 요소는 말 다리에 해당하는 빨간색 채널과 같은 토큰과 개체 간의 유사한 부분의 기능 정렬을 나타내지만 감독 ViT 모델의 PCA 시각화는 구조가 매우 좋지 않습니다. .

또한 주요 구성 요소는 말 다리에 해당하는 빨간색 채널과 같은 토큰과 개체 간의 유사한 부분의 기능 정렬을 나타내지만 감독 ViT 모델의 PCA 시각화는 구조가 매우 좋지 않습니다. .

정량적 평가

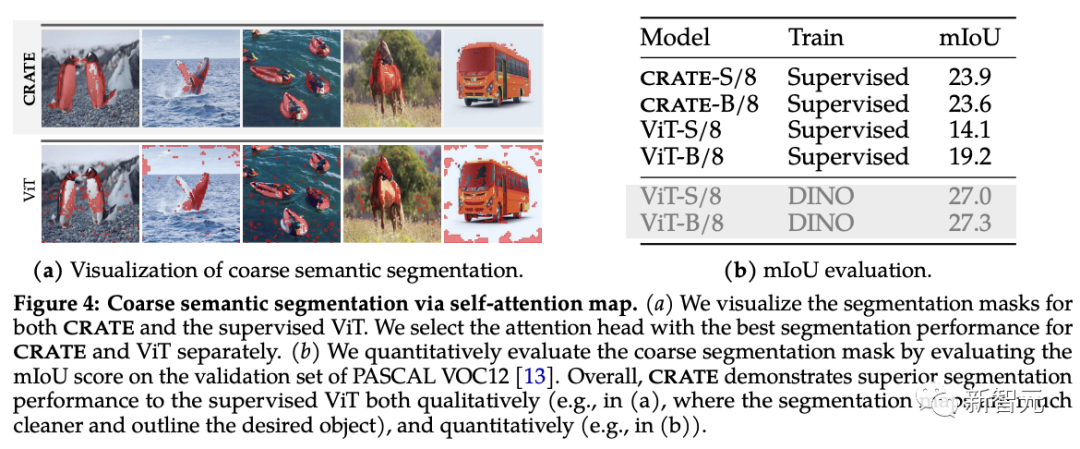

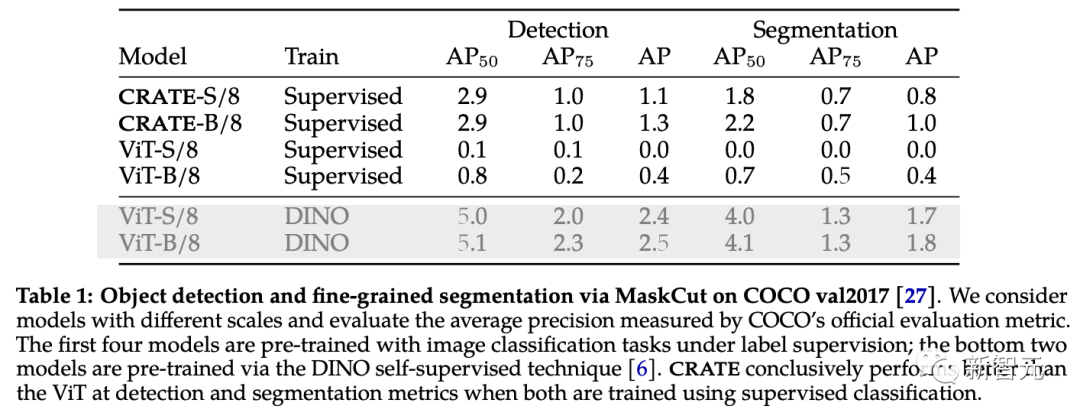

연구원들은 기존 분할 및 개체 감지 기술을 사용하여 CRATE의 새로운 분할 속성을 평가했습니다.

self-attention 그래프에서 볼 수 있듯이 CRATE는 명확한 경계를 사용하여 개체를 명시적으로 캡처합니다. 수준 의미론 분할 품질을 정량적으로 측정하기 위해 연구자는 self-attention 맵을 사용하여 분할 마스크를 생성하고 이를 실제 마스크 간의 표준 mIoU(평균 교차-결합 비율)와 비교합니다.

실험 결과에서 CRATE가 시각적 및 mIOU 점수 측면에서 ViT보다 훨씬 뛰어난 성능을 발휘한다는 것을 알 수 있습니다. 이는 CRATE의 내부 표현이 분할 마스크 생성 작업에 더 효과적이라는 것을 보여줍니다

Object 탐지 및 세분화된 세분화

CRATE가 캡처한 풍부한 의미 정보를 추가로 검증하고 평가하기 위해 연구원들은 수동 주석 없이 자동화된 평가 모델을 얻을 수 있는 효율적인 객체 탐지 및 세분화 방법인 MaskCut을 채택했습니다. CRATE Representation을 통해 학습된 토큰을 기반으로 이미지에서 세분화된 분할을 추출할 수 있습니다.

COCO val2017의 분할 결과에서 볼 수 있듯이 감지 및 분할 지표 모두에서 CRATE를 사용한 내부 표현이 감독 ViT 기능이 있는 MaskCut이 경우에 따라 더 좋습니다. 분할 마스크를 생성하는 것도 전혀 불가능합니다.

CRATE 세분화 기능에 대한 화이트박스 분석

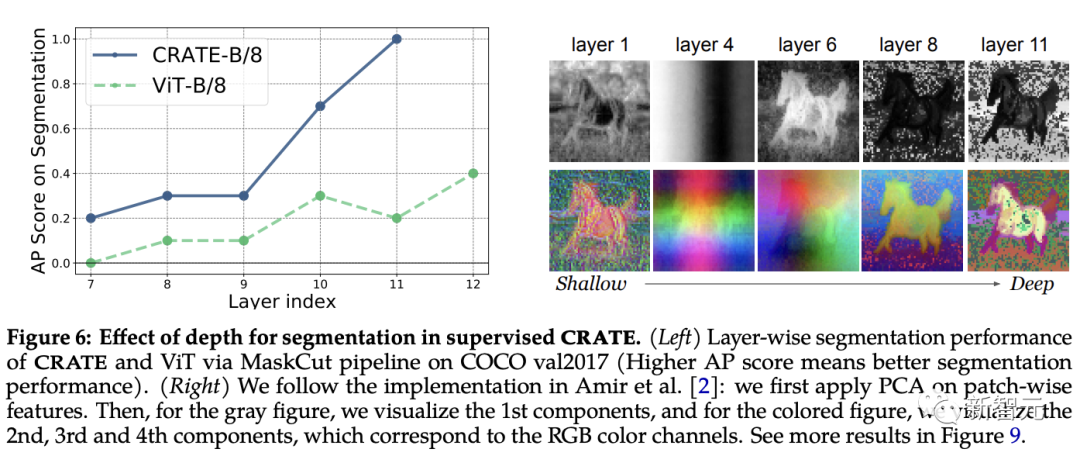

CRATE에서 깊이의 역할

CRATE에서 의미론적 분할 기능의 출현이 다음과 유사하다고 가정합니다. "유사한 의미 범주에 속하는 토큰의 클러스터를 Z로 표현"하면 깊이가 커질수록 CRATE의 분할 성능이 향상될 수 있을 것으로 예상됩니다. 이를 테스트하기 위해 연구원들은 MaskCut 파이프라인을 사용하여 다양한 계층의 내부 표현에 대한 분할 성능을 정량적으로 평가하는 동시에 PCA 시각화를 적용하여 분할이 깊이에 따라 나타나는 방식을 이해했습니다.

실험 결과에서 더 깊은 계층의 표현을 사용할 때 분할 점수가 향상되는 것을 볼 수 있으며 이는 CRATE의 증분 최적화 설계와 매우 일치합니다.

이와 대조적으로 ViT-B/8의 성능은 이후 계층에서 약간 향상되지만 분할 점수는 CRATE보다 상당히 낮으며 PCA 결과는 CRATE 심층 계층에서 추출된 표현이 점차 전경에 더 많은 주의를 기울이는 것을 보여줍니다. object 이며 텍스처 수준의 세부 정보를 캡처할 수 있습니다.

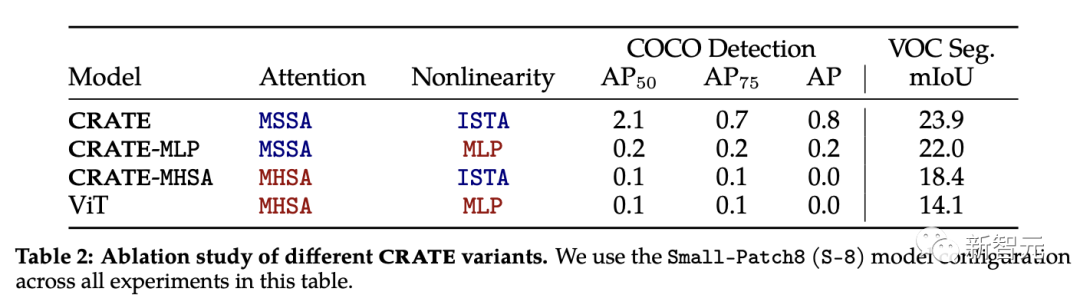

CRATE의 녹는 실험

CRATE의 어텐션 블록(MSSA)과 MLP 블록(ISTA)은 ViT의 어텐션 블록과 다릅니다

각 구성 요소를 연구하기 위해 CRATE의 긴급 분할 속성 중 연구자들은 CRATE, CRATE-MHSA 및 CRATE-MLP의 세 가지 CRATE 변형을 선택했습니다. 이러한 변형은 각각 ViT의 Attention 블록(MHSA)과 MLP 블록을 나타냅니다.

연구원들은 ImageNet-21k 데이터세트에 동일한 사전 훈련 설정을 적용한 다음 성긴 분할 평가와 마스크 분할 평가를 적용하여 성능을 정량적으로 비교했습니다. 다른 모델의.

실험 결과에 따르면 CRATE는 모든 작업에서 다른 모델 아키텍처보다 훨씬 뛰어난 성능을 발휘합니다. MHSA와 MSSA 간의 아키텍처 차이는 작지만 ViT의 MHSA를 CRATE의 MSSA로 바꾸는 것만으로도 ViT의 대략적인 분할 성능(즉, VOC 세그먼트 성능)을 크게 향상시킬 수 있다는 점은 주목할 가치가 있습니다. 이는 화이트박스 디자인의 효율성을 더욱 입증합니다

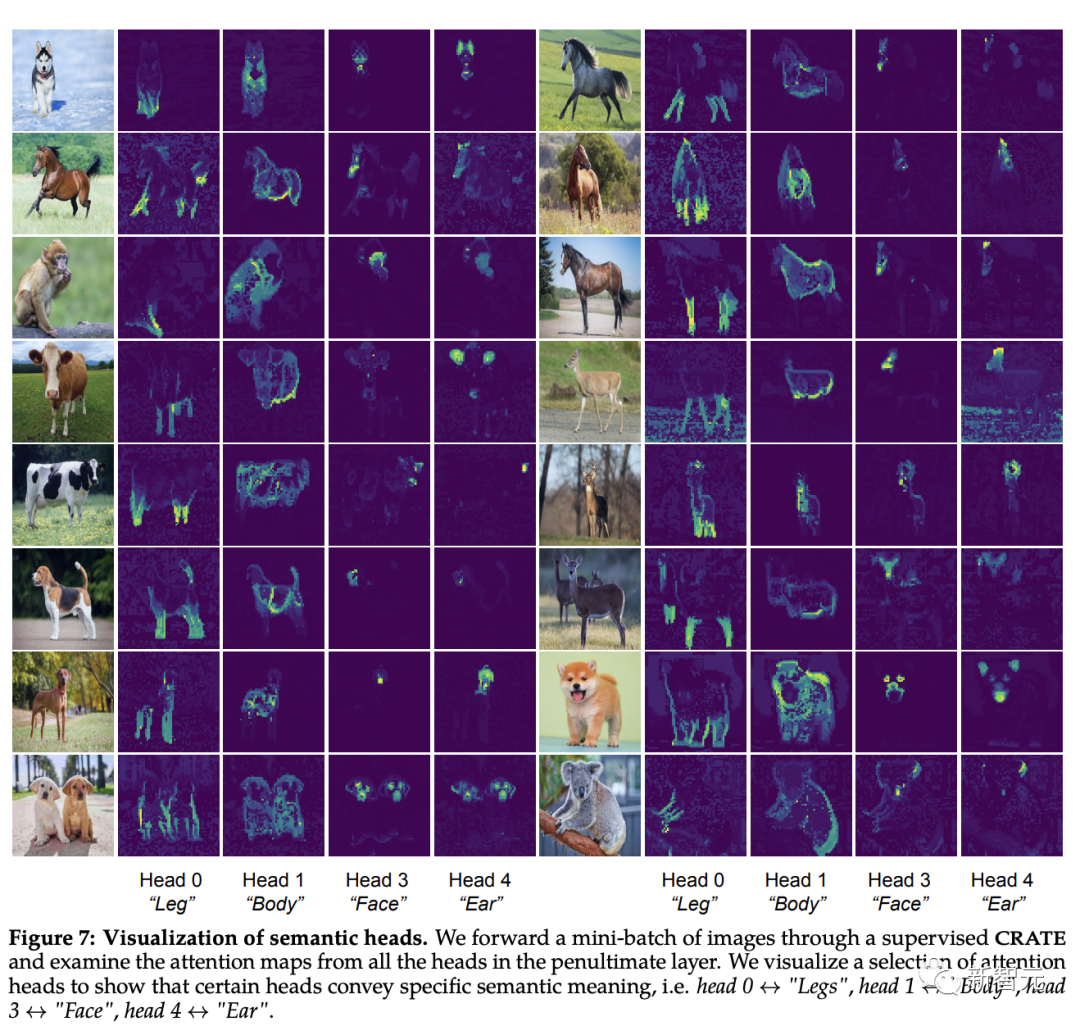

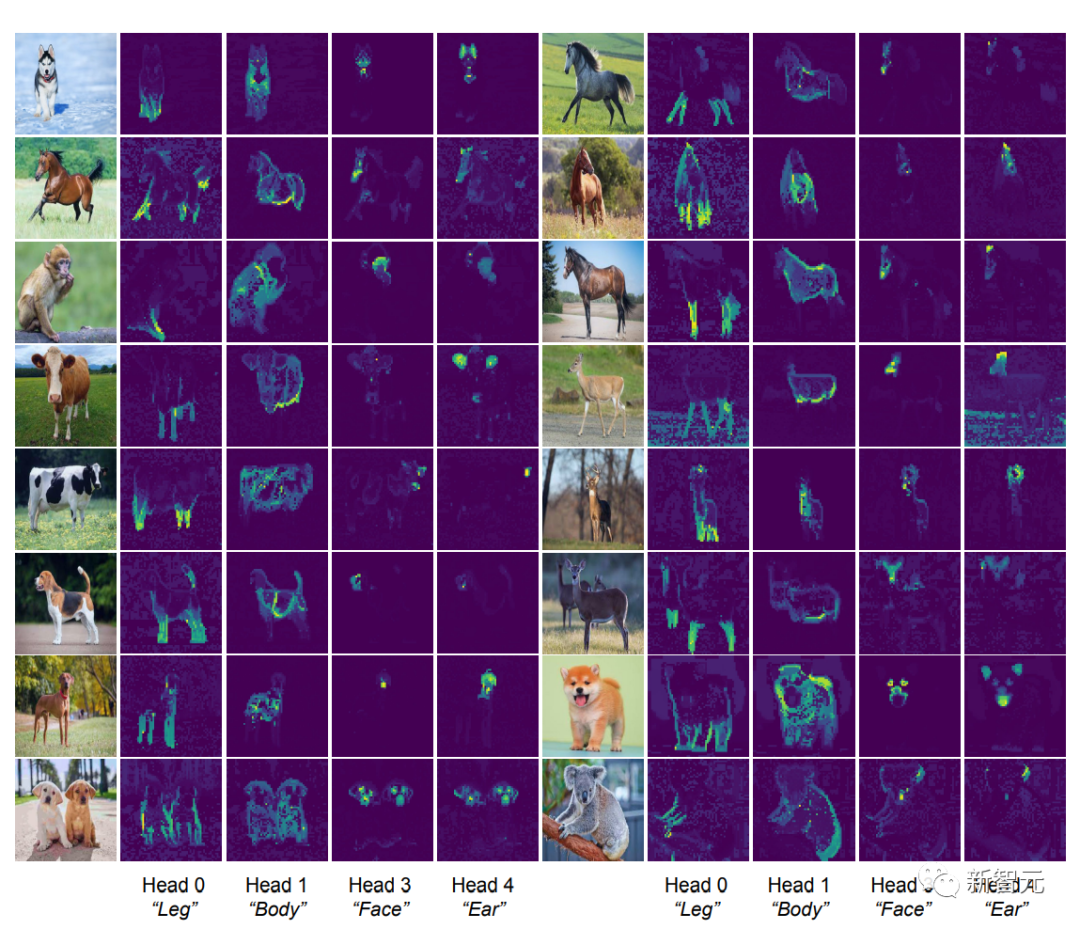

다시 작성해야 하는 콘텐츠는 어텐션 헤더의 의미적 속성 식별

[CLS] 토큰 간 self-attention 맵입니다. 명확한 분할 마스크를 위해서는 직관적으로 각 어텐션 헤드가 데이터의 일부 기능을 캡처할 수 있어야 합니다.

연구원들은 먼저 CRATE 모델에 이미지를 입력한 다음 인간에게 의미론적 의미가 있는 것으로 보이는 4개의 어텐션 헤드를 검사하고 선택한 다음 다른 입력 이미지에서 이러한 어텐션 헤드에 대한 자기 어텐션 맵 시각화를 수행했습니다.

각 어텐션 헤드가 객체의 서로 다른 부분과 심지어 서로 다른 의미를 포착할 수 있다는 관찰이 가능합니다. 예를 들어, 첫 번째 열의 Attention 헤드는 다양한 동물의 다리를 캡처할 수 있고, 마지막 열의 Attention 헤드는 귀와 머리를 캡처할 수 있습니다. -전체 계층은 캡슐 네트워크 출시 이후 인식 아키텍처의 목표였으며 화이트박스로 설계된 CRATE 모델에도 이 기능이 있습니다.

위 내용은 Ma Yi 교수의 신작: White-box ViT가 '분할된 출현'을 성공적으로 달성했습니다. 경험적 딥러닝 시대가 종말을 맞이하고 있습니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!