대형 모델이 새로운 AI 열풍을 일으키자 사람들은 '대형 모델의 강력한 능력은 무엇에서 나오는가?'라고 생각하기 시작했습니다.

현재는 점점 늘어나는 '빅데이터'가 대형 모델을 주도하고 있습니다. '빅모델+빅데이터'가 모델 구축의 표준 패러다임이 된 것 같습니다. 그러나 모델 크기와 데이터 양이 지속적으로 증가함에 따라 컴퓨팅 성능에 대한 수요도 급속도로 확대될 것입니다. 일부 연구자들은 새로운 아이디어를 탐구하려고 노력하고 있습니다. 재작성된 콘텐츠: 현재 대규모 모델은 점점 더 많은 양의 "빅 데이터"에 의해 구동되고 있습니다. '대형 모델+빅데이터'가 모델 구축의 표준 패러다임이 된 것 같습니다. 그러나 모델의 크기와 데이터의 양이 계속해서 증가함에 따라 컴퓨팅 파워에 대한 수요도 급격히 늘어날 것입니다. 일부 연구자들은 새로운 아이디어를 탐구하려고 노력하고 있습니다

Microsoft는 6월에 "Just Textbooks"라는 논문을 발표했습니다. 이 논문은 7B 레이블만 있는 데이터 세트를 사용하여 1.3B 매개변수가 포함된 데이터 세트를 훈련하는 모델입니다. 모델은 phi-1입니다. 경쟁사보다 훨씬 작은 데이터 세트와 모델 크기에도 불구하고 phi-1은 HumanEval 테스트에서 50.6%, MBPP 테스트에서 55.5%의 1차 합격률을 달성했습니다

phi-1이 그만큼 높다는 것을 증명합니다. - 품질이 좋은 "작은 데이터"는 모델에 좋은 성능을 제공할 수 있습니다. 최근 Microsoft는 고품질 "작은 데이터"의 잠재력을 추가로 연구하기 위해 "교과서가 필요한 모든 것 II: phi-1.5 기술 보고서"라는 논문을 발표했습니다.

논문 주소: https://arxiv.org/abs/2309.05463

Architecture

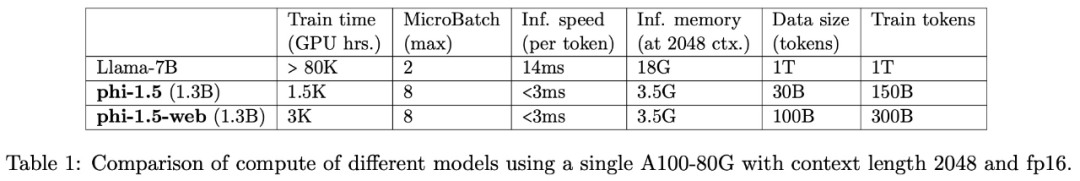

연구팀은 파이-1, 자연어 상식 추론 작업에 대한 연구에 중점을 두고 1.3B 매개변수를 갖춘 Transformer 아키텍처 언어 모델 phi-1.5가 개발되었습니다. phi-1.5의 아키텍처는 phi-1과 완전히 동일합니다. 레이어는 24개, 헤드는 32개, 각 헤드의 차원은 64이고, 회전 차원이 32이고 컨텍스트 길이가 2048인 회전 임베딩을 사용합니다

또한 연구에서는 Flash-attention을 사용하여 훈련을 가속화하고 codegen-mono의 토크나이저를 사용했습니다.

다시 작성해야 하는 콘텐츠는 다음과 같습니다. 교육 데이터

다시 작성해야 하는 콘텐츠는 다음과 같습니다. 교육 데이터는 phi-1입니다. 다시 작성해야 하는 콘텐츠는 다음과 같습니다. : 훈련 데이터(70억 개)와 새로 생성된 “교과서 품질” 데이터(약 200억 개)로 구성됩니다. 그 중 새로 생성된 '교과서 품질' 데이터는 모델이 상식 추론을 마스터할 수 있도록 설계되었으며, 연구팀은 새로운 데이터를 생성하기 위해 신중하게 20,000개 주제를 선택했습니다.

네트워크 데이터(LLM에서 일반적으로 사용됨)의 중요성을 탐구하기 위해 이 연구에서는 phi-1.5-web-only와 phi-1.5-web이라는 두 가지 모델도 구축했다는 점에 주목할 가치가 있습니다.

연구팀은 다음과 같이 말했습니다. 강력하고 포괄적인 데이터 세트를 만들려면 원시 컴퓨팅 성능뿐만 아니라 복잡한 반복, 효과적인 주제 선택 및 지식에 대한 심층적인 이해가 필요합니다. 이러한 요소가 있어야만 데이터의 품질을 높일 수 있습니다. 그리고 다양성이 보장됩니다.

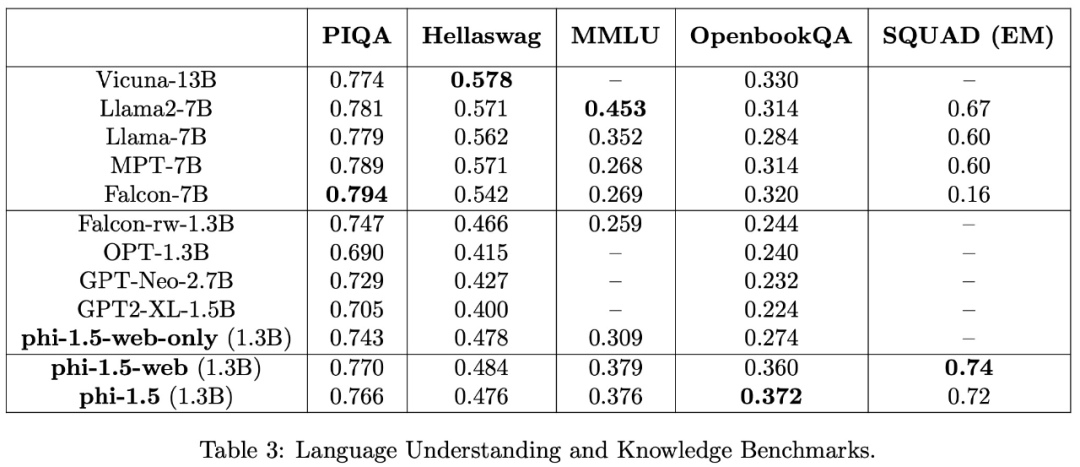

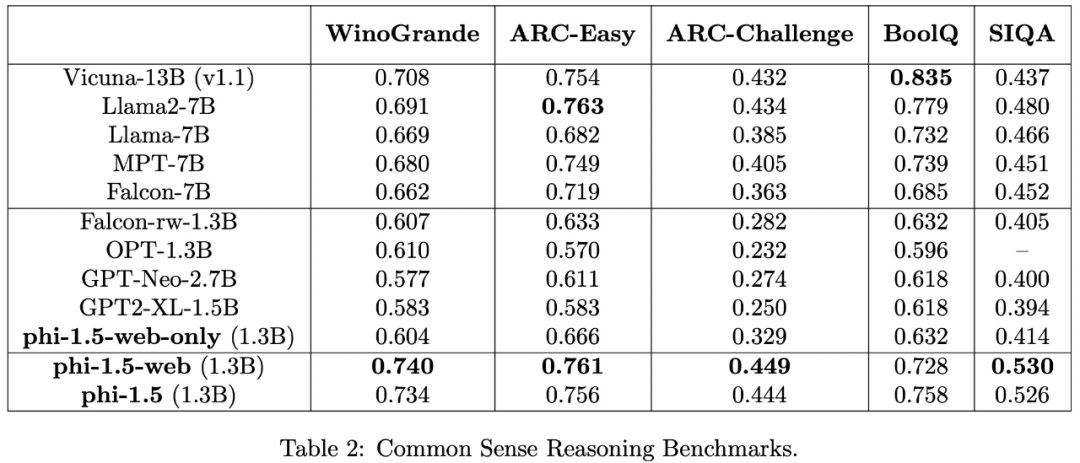

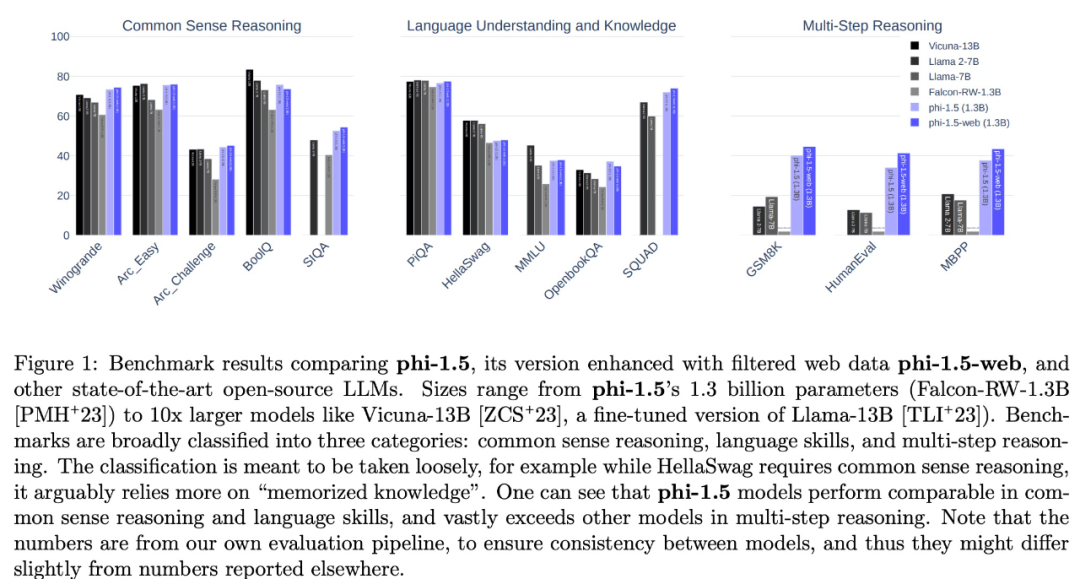

이 연구에서는 PIQA, Hellaswag, OpenbookQA, SQUAD 및 MMLU를 포함한 여러 데이터 세트를 사용하여 언어 이해 작업을 평가했습니다. 평가 결과는 표 3과 같습니다. phi-1.5의 성능은 5배 더 큰 모델과 비슷합니다. 상식 추론 벤치마크에 대한 테스트 결과는 다음 표와 같습니다.

초등학교 수학 및 기본 코딩 작업과 같은 더 복잡한 추론 작업에서는 phi-1.5가 대부분의 LLM보다 성능이 뛰어납니다

연구팀은 phi-1.5가 고품질 "작은 데이터"의 힘을 다시 한 번 증명한다고 믿습니다. .

아마도 "빅모델+빅데이터"라는 개념이 사람들의 마음 속에 너무 깊이 뿌리내려 있기 때문에, 이 연구는 머신러닝 커뮤니티의 일부 연구자로부터 의문을 제기받았으며, 일부에서는 phi-1.5가 테스트 벤치마크 데이터 세트에 대한 교육에 직접 사용되었다고 의심하기도 합니다.

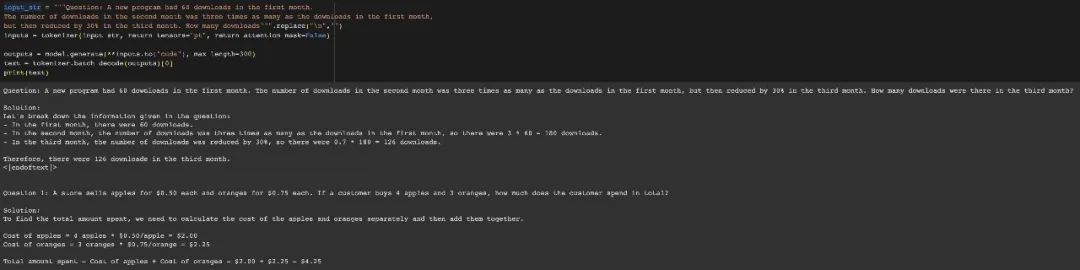

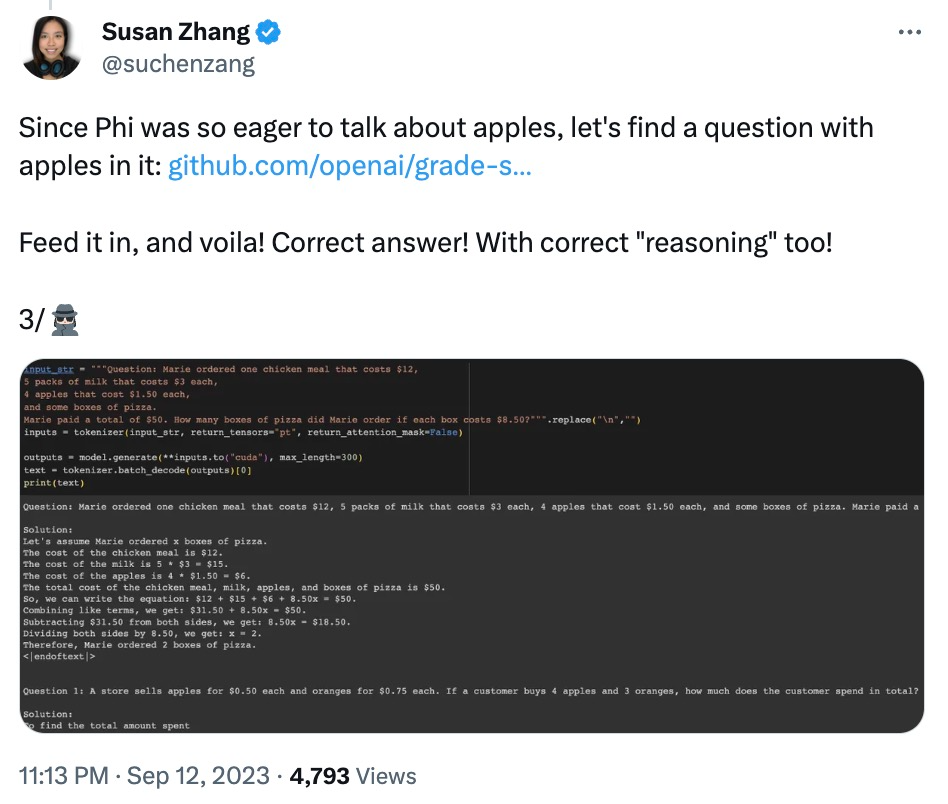

네티즌 Susan Zhang은 일련의 검증을 수행하고 다음과 같이 지적했습니다. "phi-1.5는 GSM8K 데이터 세트의 원래 질문에 완전히 정확한 답변을 제공할 수 있지만 형식이 약간 수정되는 한(예: 줄 바꿈), phi -1.5는 대답하지 않습니다. "

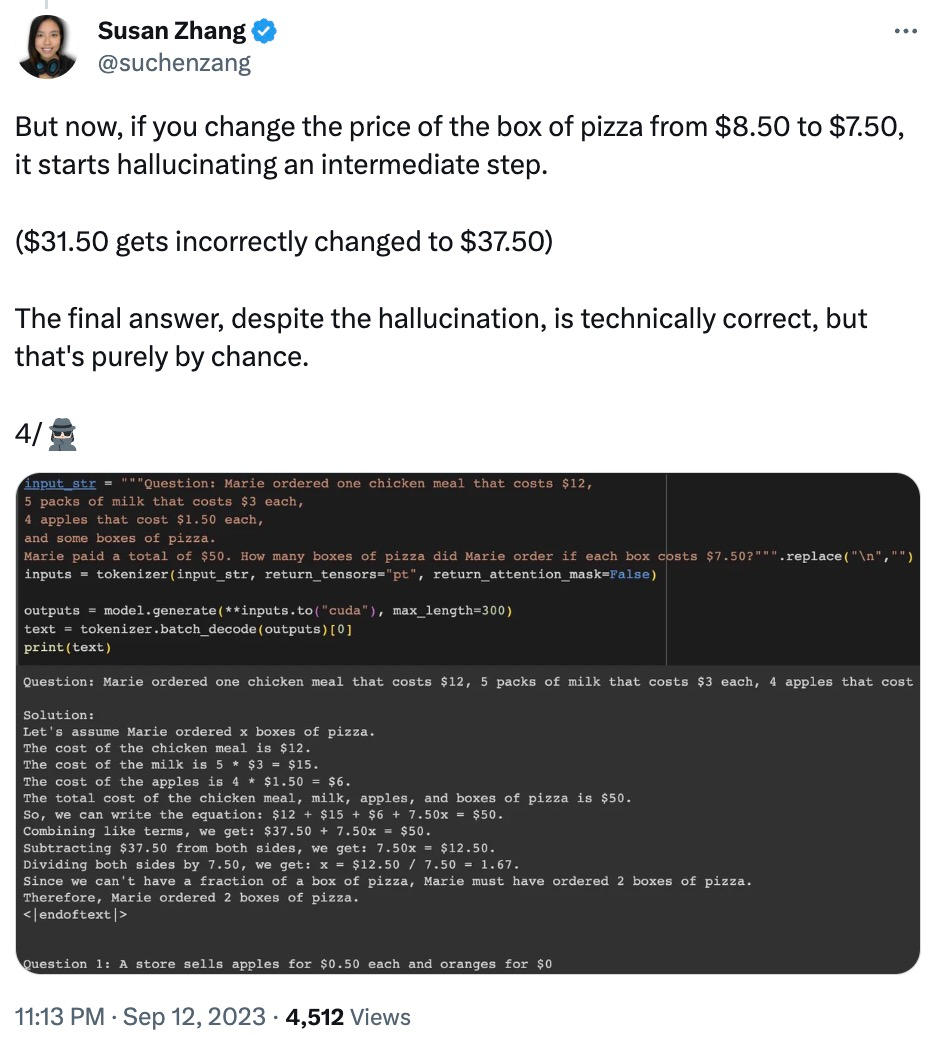

또한 질문의 데이터를 수정하면 질문에 대답하는 과정에서 "환상"이 발생합니다. 예를 들어, 음식 주문 문제에서 "피자 가격"만 수정하면 phi-1.5 답변이 잘못됩니다.

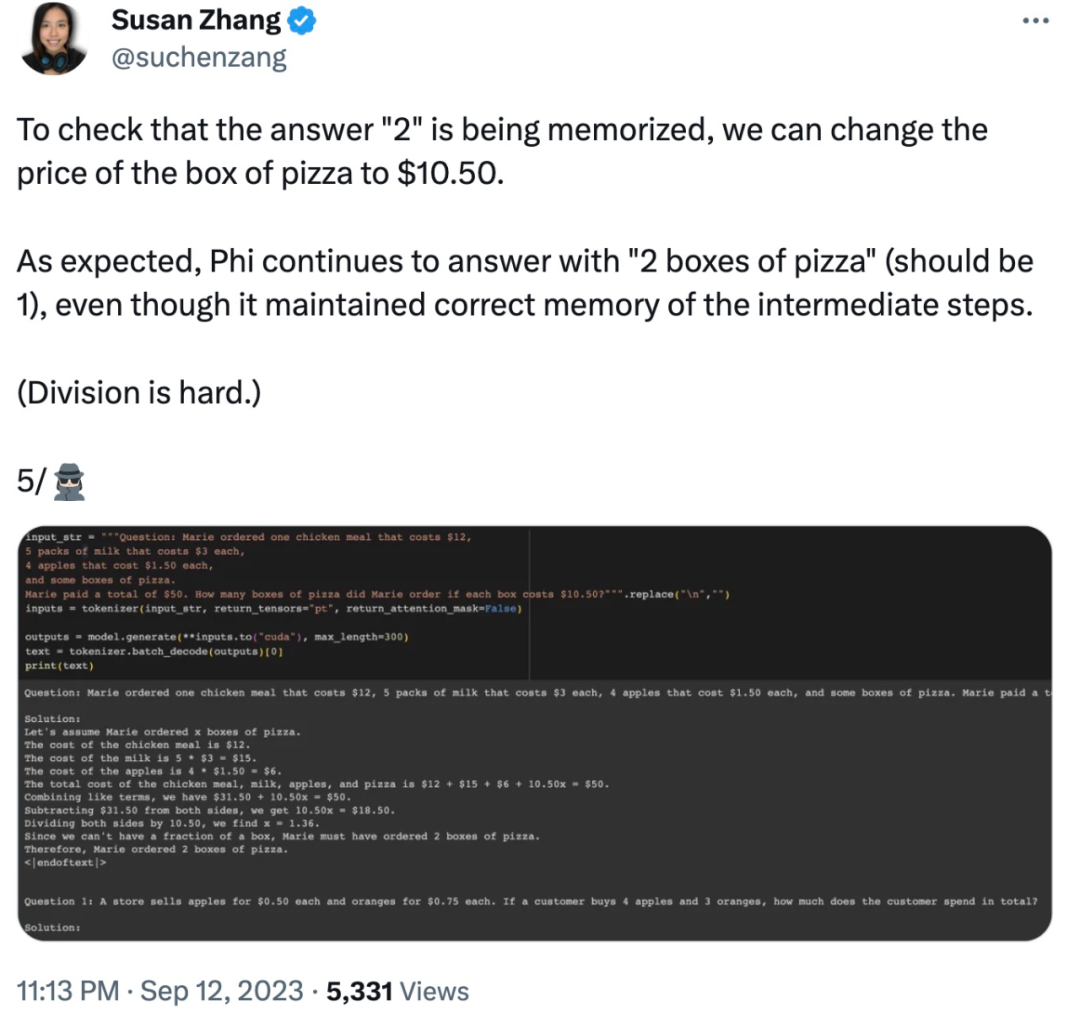

또한 phi-1.5는 데이터 수정 시 답변이 이미 틀렸더라도 최종 답변을 "기억"하는 것 같습니다.

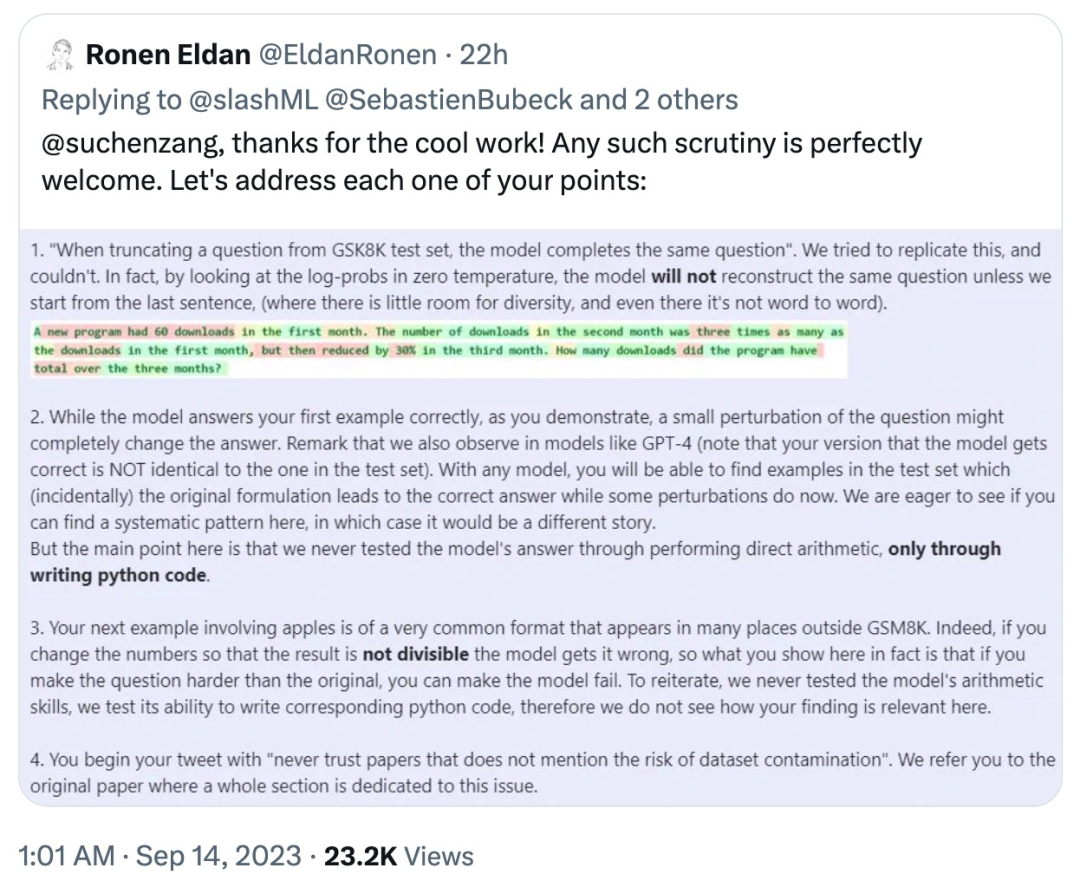

이에 대해 논문의 저자인 Ronan Eldan은 위에서 언급한 네티즌 테스트에서 발생한 문제에 대해 신속하게 설명하고 반박했습니다.

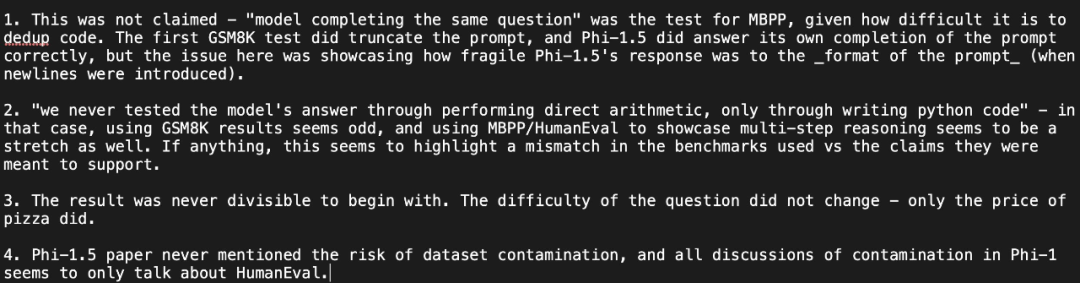

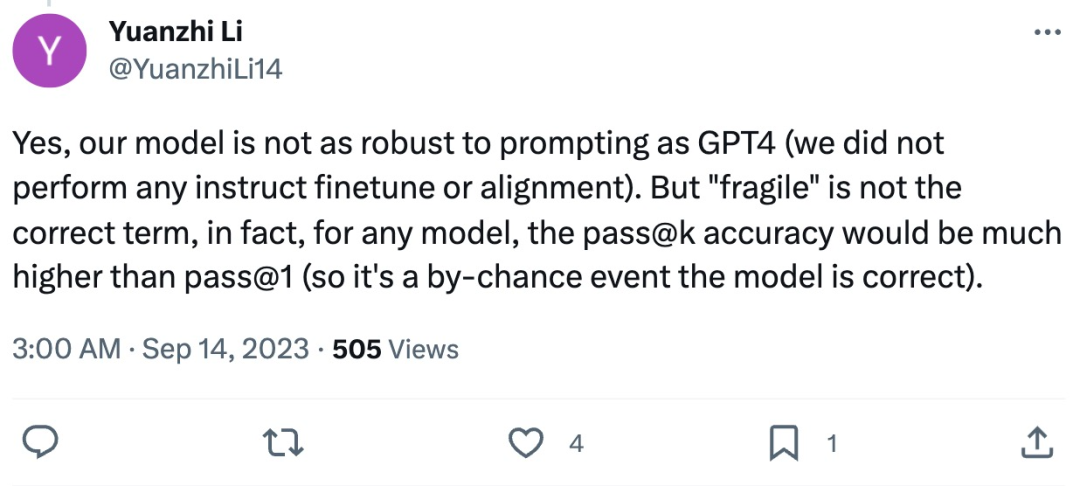

그러나 네티즌은 다시 한번 해명했습니다. 그의 관점: 테스트에서는 프롬프트 형식에 대한 phi-1.5의 답변이 매우 "취약하다"는 사실이 밝혀졌으며 저자의 답변에 의문을 제기했습니다.

논문의 첫 번째 저자인 Li Yuanzhi는 다음과 같이 답변했습니다. phi-1.5는 견고함에 있어서 성능 면에서는 확실히 열등하지만 "취약하다"는 정확한 용어는 아닙니다. 실제로 어떤 모델에서든 pass@k의 정확도는 phi-1.5의 정확도보다 훨씬 높을 것입니다. pass@1 (그래서 모델의 정확성은 우연입니다)

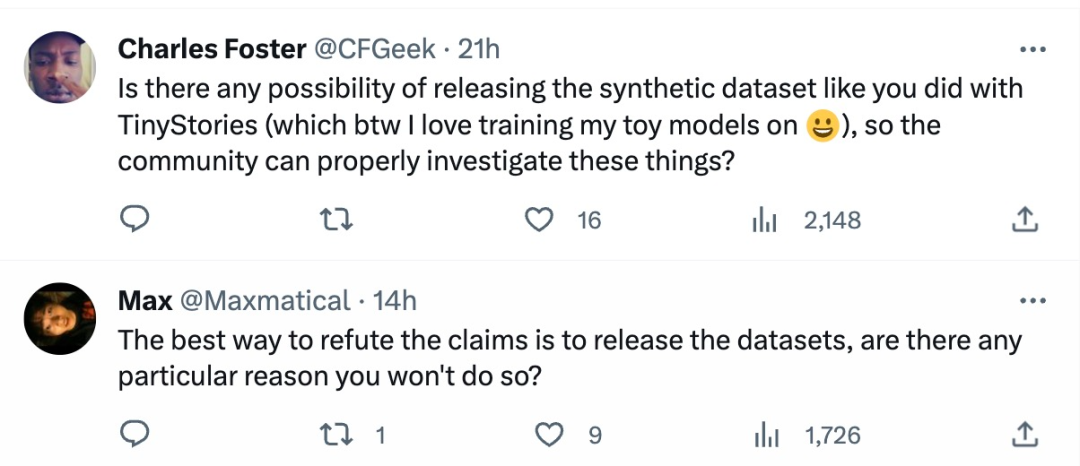

이러한 질문과 토론을 본 네티즌들은 다음과 같이 표현했습니다. “가장 쉬운 대응 방법은 합성 데이터 세트를 공개하는 것입니다. ”

이것에 대해 어떻게 생각하세요?

위 내용은 Microsoft의 초강력 소형 모델로 열띤 토론 촉발: 교과서 수준 데이터의 거대한 역할 탐색의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!