Lao Huang은 H100을 향상시킵니다. Nvidia는 Llama2 추론 속도를 두 배로 늘리는 대형 모델 가속 패키지를 출시합니다.

대형 모델의 추론 속도가 단 한 달 만에 두 배로 향상되었습니다!

최근 NVIDIA는 LLM 추론 프로세스 속도를 높이기 위해 H100용으로 특별히 설계된 "닭 혈액 패키지" 출시를 발표했습니다

아마도 이제 내년에 GH200이 배송될 때까지 기다릴 필요가 없습니다 .

.

GPU의 컴퓨팅 성능은 항상 대형 모델의 성능에 영향을 미쳤습니다. 하드웨어 공급업체와 사용자 모두 더 빠른 컴퓨팅 속도를 원합니다.

대형 모델 뒤의 최대 하드웨어 공급업체로서 NVIDIA는 하드웨어를 어떻게 다룰 것인지 연구해 왔습니다. 대형 모델을 가속화합니다.

NVIDIA는 여러 AI 기업과의 협력을 통해 마침내 대형 모델 추론 최적화 프로그램 TensorRT-LLM(가칭 TensorRT)을 출시했습니다.

TensorRT는 대형 모델의 추론 속도를 두 배로 높일 수 있을 뿐만 아니라 사용하기도 매우 편리합니다.

C++ 및 CUDA에 대한 심층적인 지식이 없어도 H100에서 최적화 전략을 신속하게 맞춤화하고 대규모 모델을 더 빠르게 실행할 수 있습니다.

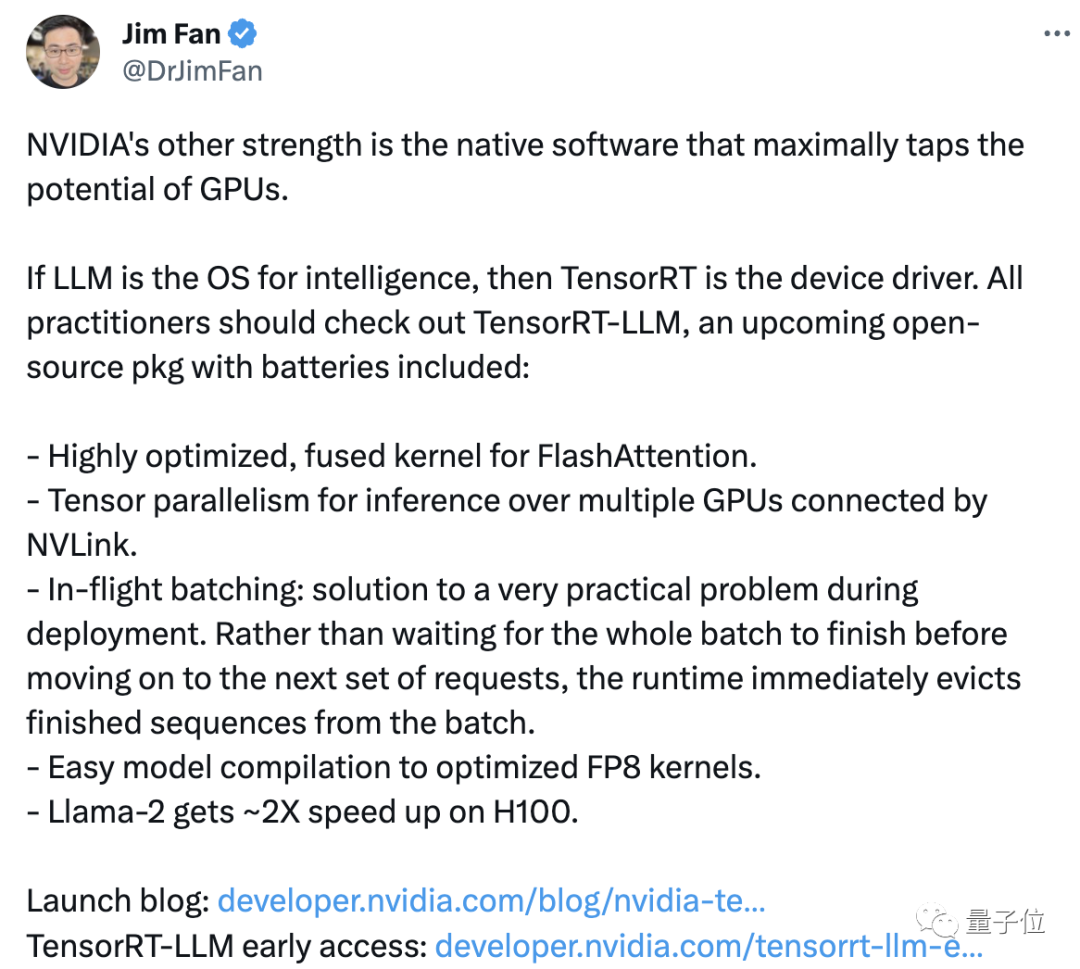

NVIDIA 과학자 Jim Fan은 NVIDIA의 "또 다른 장점"은 GPU 성능 활용을 극대화할 수 있는 지원 소프트웨어라고 리트윗하고 댓글을 달았습니다.

NVIDIA는 Lao Huang의 "더 많이 구매할수록 더 많이 절약할 수 있습니다"라는 말을 실천하는 것처럼 소프트웨어를 통해 제품에 새로운 활력을 불어넣습니다. 그러나 이것이 일부 사람들이 제품 가격이 너무 높다고 생각하는 것을 막지는 못합니다

가격 외에도 일부 네티즌들은 영업 결과에 의문을 제기했습니다.

우리는 항상 성능이 몇 배나 향상되는지 확인합니다. (홍보 중) 하지만 Llama 2를 직접 실행하면 여전히 초당 수십 개의 토큰만 처리할 수 있습니다.

TensorRT의 경우 실제로 효과적인지 확인하려면 추가 테스트가 필요합니다. 먼저 TensorRT에 대해 자세히 살펴보겠습니다.

대형 모델의 추론 속도를 두 배로 늘리세요

TensorRT-LLM은 H100에 최적화되어 있습니다. 대형 모델을 실행하는 데 얼마나 빠릅니까?

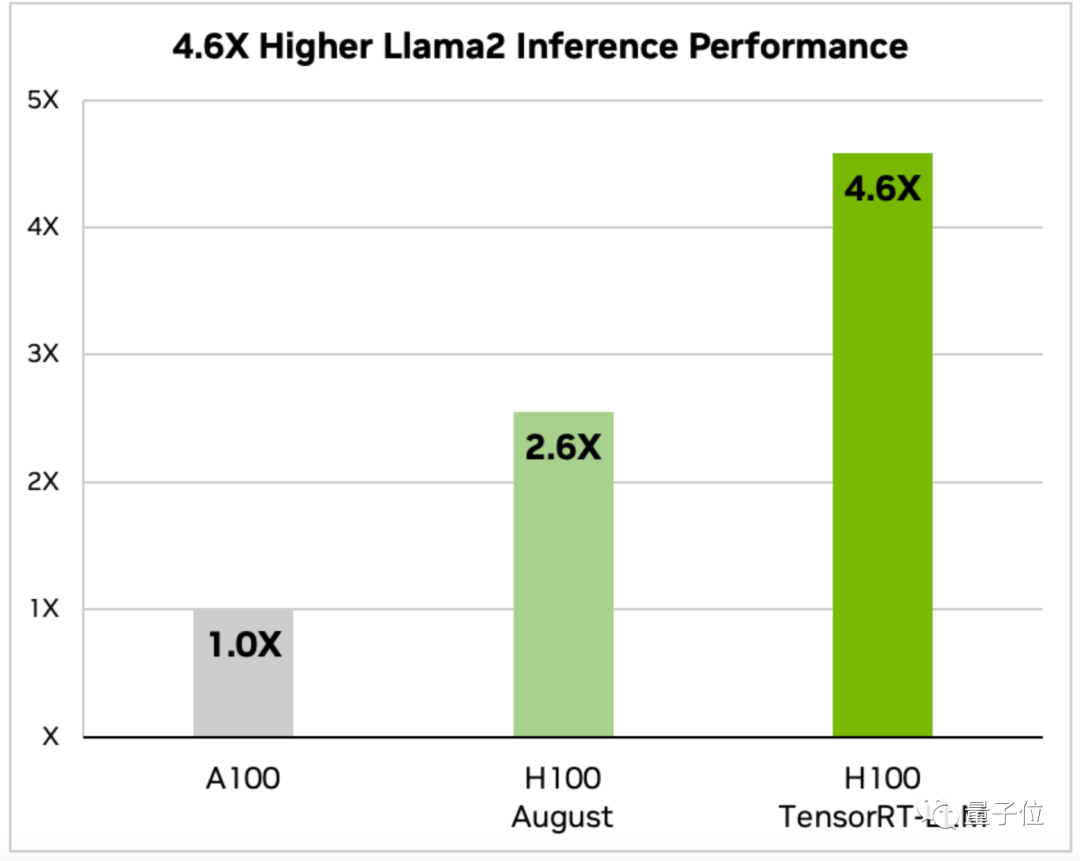

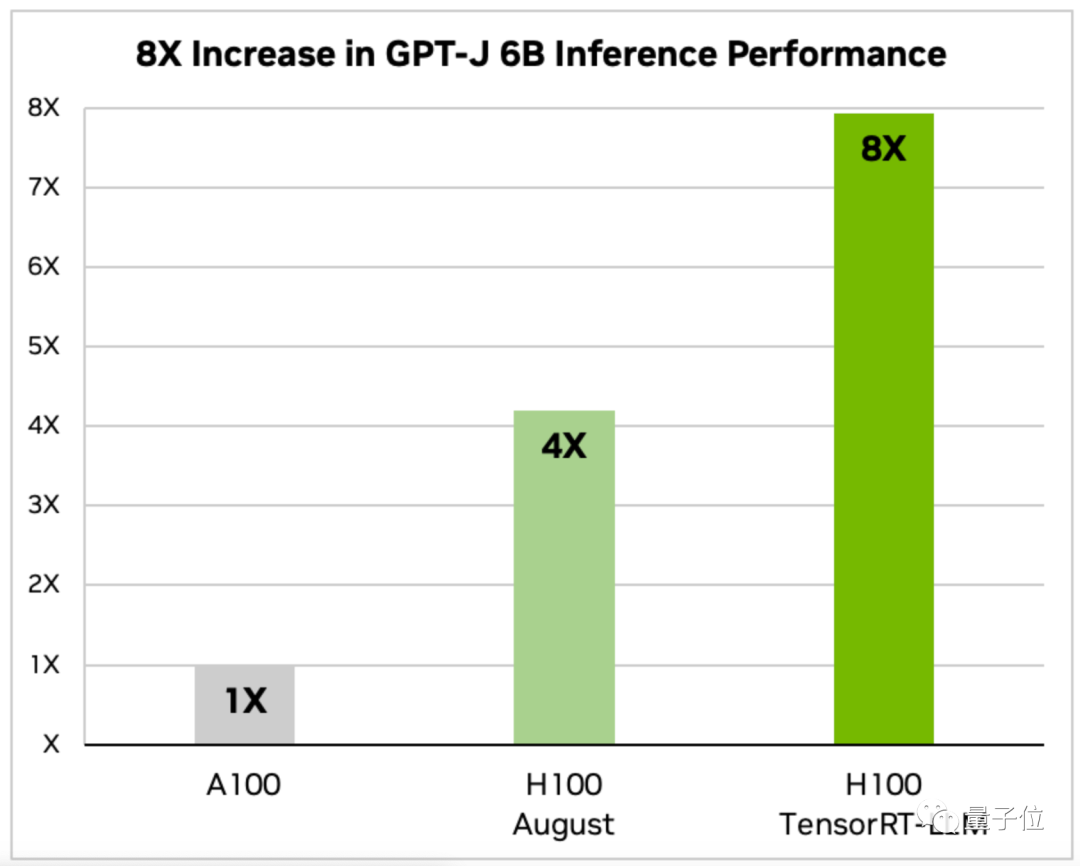

Nvidia의 발표는 Llama 2와 GPT-J-6B의 두 가지 모델에 대한 데이터를 제공합니다.

최적화된 H100에서 Llama 2의 추론 속도는 A100의 4.6배, 8월의 최적화되지 않은 H100의 1.77배입니다

그리고 GPT-J-6B의 추론 속도는 A100의 8배입니다 이전 버전의 2배, 최적화되지 않은 8월 버전의 2배입니다.

TensorRT는 또한 다양한 LLM 요구 사항에 따라 최적화 솔루션을 신속하게 사용자 정의할 수 있는 오픈 소스 모듈형 Python API를 제공합니다.

이 API는 딥 러닝 컴파일러, 커널 최적화, 사전/사후 처리 및 다중 노드 통신 기능을 통합합니다. .

GPT(2/3), Llama와 같은 일반 모델용 맞춤형 버전도 있어 "즉시 사용 가능" 사용할 수 있습니다.

TensorRT의 최신 오픈 소스 AI 커널을 통해 개발자는 Transformer 속도를 크게 높이는 주의 알고리즘 FlashAttention을 포함하여 모델 자체를 최적화할 수도 있습니다.

TensorRT는 딥 러닝 추론을 최적화하기 위한 고성능 추론 엔진입니다. 혼합 정밀도 컴퓨팅, 동적 그래프 최적화 및 레이어 융합과 같은 기술을 사용하여 LLM 추론 속도를 최적화합니다. 특히 TensorRT는 부동 소수점 계산을 반정밀도 부동 소수점 계산으로 변환하여 계산량과 메모리 대역폭 요구 사항을 줄여 추론 속도를 향상시킵니다. 또한 TensorRT는 동적 그래프 최적화 기술을 사용하여 입력 데이터의 특성을 기반으로 최적의 네트워크 구조를 동적으로 선택하여 추론 속도를 더욱 향상시킵니다. 또한 TensorRT는 레이어 융합 기술을 사용하여 여러 컴퓨팅 레이어를 보다 효율적인 컴퓨팅 레이어로 병합하여 컴퓨팅 및 메모리 액세스 오버헤드를 줄이고 추론 속도를 더욱 향상시킵니다. 간단히 말해서 TensorRT는 다양한 최적화 기술을 통해 LLM 추론의 속도와 효율성을 크게 향상시켰습니다

우선 TensorRT다중 노드 협업 작업 방법 최적화의 이점을 누릴 수 있습니다.

Llama와 같은 거대한 모델은 단일 카드에서 실행할 수 없습니다. 함께 실행하려면 여러 GPU가 필요합니다.

과거에는 이 작업을 수행하려면 사람들이 모델을 수동으로 분해해야 했습니다.

TensorRT를 사용하면 시스템이 자동으로 모델을 분할하고 NVLink

를 통해 여러 GPU에서 효율적으로 실행할 수 있습니다. 둘째, TensorRT는 동적 배치 처리 기술이라는 최적화된 스케줄링도 활용합니다.

추론 프로세스 중에 LLM은 실제로 모델 반복을 여러 번 실행하여 진행합니다.

동적 일괄 처리 기술은 다음 요청 세트를 처리하기 전에 전체 작업 배치가 완료될 때까지 기다리지 않고 완료된 시퀀스를 즉시 제거합니다.

실제 테스트에서 동적 배치 기술은 LLM의 GPU 요청 처리량을 절반으로 줄이는 데 성공하여 운영 비용을 크게 줄였습니다.

또 다른 핵심 포인트는 16비트 정밀도 부동 소수점 숫자를 8비트 정확도로 변환하여 메모리 소비를 줄이는 것입니다.

훈련 단계의 FP16과 비교하여 FP8은 INT-8보다 리소스 소비가 적고 모델의 정확도에 영향을 주지 않고 성능을 향상시킬 수 있습니다.

Hopper Transformer 엔진을 사용하면 시스템이 자동으로 FP16을 완료합니다. 모델의 코드를 수동으로 수정하지 않고 FP8로 변환 컴파일

현재 TensorRT-LLM의 초기 버전을 다운로드할 수 있으며 공식 버전은 몇 주 안에 출시되어 NeMo 프레임워크에 통합될 예정입니다

한 번 더 Thing

큰 사건이 일어날 때마다 '리웬훅'의 모습은 빼놓을 수 없습니다.

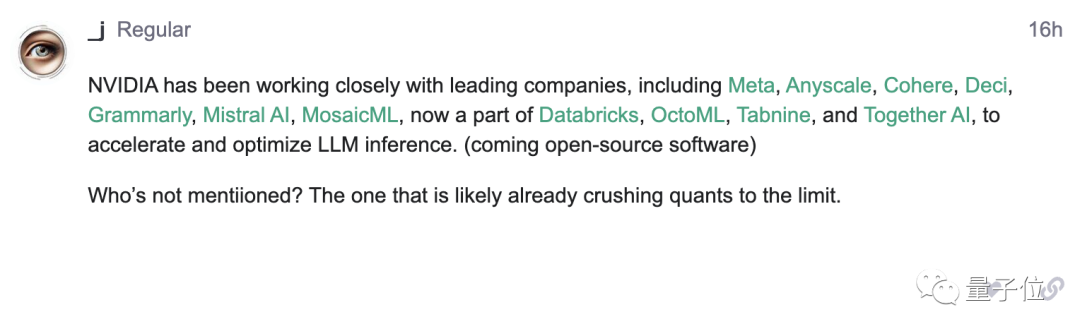

Nvidia의 발표에서 Meta 등 대표적인 인공지능 기업과의 협력을 언급했지만 OpenAI에 대한 언급은 없었습니다

이번 발표에서 일부 네티즌들이 이 점을 발견하고 OpenAI 포럼에 올렸습니다.

누구인지 알려주세요. 라오황(수동 개머리)의 신호를 받지 못했습니다

라오황이 우리에게 어떤 "놀라움"을 가져다 줄 것으로 예상하시나요?

위 내용은 Lao Huang은 H100을 향상시킵니다. Nvidia는 Llama2 추론 속도를 두 배로 늘리는 대형 모델 가속 패키지를 출시합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7509

7509

15

15

1378

1378

52

52

78

78

11

11

52

52

19

19

19

19

63

63

Debian Readdir의 파일 정렬을 구현하는 방법

Apr 13, 2025 am 09:06 AM

Debian Readdir의 파일 정렬을 구현하는 방법

Apr 13, 2025 am 09:06 AM

Debian Systems에서 readDIR 함수는 디렉토리 내용을 읽는 데 사용되지만 반환하는 순서는 사전 정의되지 않습니다. 디렉토리에 파일을 정렬하려면 먼저 모든 파일을 읽은 다음 QSORT 기능을 사용하여 정렬해야합니다. 다음 코드는 데비안 시스템에서 readdir 및 qsort를 사용하여 디렉토리 파일을 정렬하는 방법을 보여줍니다.#포함#포함#포함#포함#포함 // QsortIntCompare (constvoid*a, constVoid*b) {returnStrcmp (*(*)

Debian Readdir의 성능을 최적화하는 방법

Apr 13, 2025 am 08:48 AM

Debian Readdir의 성능을 최적화하는 방법

Apr 13, 2025 am 08:48 AM

Debian Systems에서 ReadDir 시스템 호출은 디렉토리 내용을 읽는 데 사용됩니다. 성능이 좋지 않은 경우 다음과 같은 최적화 전략을 시도해보십시오. 디렉토리 파일 수를 단순화하십시오. 대규모 디렉토리를 가능한 한 여러 소규모 디렉토리로 나누어 읽기마다 처리 된 항목 수를 줄입니다. 디렉토리 컨텐츠 캐싱 활성화 : 캐시 메커니즘을 구축하고 정기적으로 캐시를 업데이트하거나 디렉토리 컨텐츠가 변경 될 때 캐시를 업데이트하며 readDir로 자주 호출을 줄입니다. 메모리 캐시 (예 : Memcached 또는 Redis) 또는 로컬 캐시 (예 : 파일 또는 데이터베이스)를 고려할 수 있습니다. 효율적인 데이터 구조 채택 : 디렉토리 트래버스를 직접 구현하는 경우 디렉토리 정보를 저장하고 액세스하기 위해보다 효율적인 데이터 구조 (예 : 선형 검색 대신 해시 테이블)를 선택하십시오.

Debian Readdir가 다른 도구와 통합하는 방법

Apr 13, 2025 am 09:42 AM

Debian Readdir가 다른 도구와 통합하는 방법

Apr 13, 2025 am 09:42 AM

데비안 시스템의 readdir 함수는 디렉토리 컨텐츠를 읽는 데 사용되는 시스템 호출이며 종종 C 프로그래밍에 사용됩니다. 이 기사에서는 ReadDir를 다른 도구와 통합하여 기능을 향상시키는 방법을 설명합니다. 방법 1 : C 언어 프로그램을 파이프 라인과 결합하고 먼저 C 프로그램을 작성하여 readDir 함수를 호출하고 결과를 출력하십시오.#포함#포함#포함#포함#includinTmain (intargc, char*argv []) {dir*dir; structdirent*entry; if (argc! = 2) {

데비안 메일 서버 방화벽 구성 팁

Apr 13, 2025 am 11:42 AM

데비안 메일 서버 방화벽 구성 팁

Apr 13, 2025 am 11:42 AM

데비안 메일 서버의 방화벽 구성은 서버 보안을 보장하는 데 중요한 단계입니다. 다음은 iptables 및 방화구 사용을 포함하여 일반적으로 사용되는 여러 방화벽 구성 방법입니다. iptables를 사용하여 iptables를 설치하도록 방화벽을 구성하십시오 (아직 설치되지 않은 경우) : sudoapt-getupdatesudoapt-getinstalliptablesview 현재 iptables 규칙 : sudoiptables-l configuration

데비안 syslog를 배우는 방법

Apr 13, 2025 am 11:51 AM

데비안 syslog를 배우는 방법

Apr 13, 2025 am 11:51 AM

이 안내서는 데비안 시스템에서 syslog를 사용하는 방법을 배우도록 안내합니다. Syslog는 로깅 시스템 및 응용 프로그램 로그 메시지를위한 Linux 시스템의 핵심 서비스입니다. 관리자가 시스템 활동을 모니터링하고 분석하여 문제를 신속하게 식별하고 해결하는 데 도움이됩니다. 1. syslog에 대한 기본 지식 syslog의 핵심 기능에는 다음이 포함됩니다. 로그 메시지 중앙 수집 및 관리; 다중 로그 출력 형식 및 대상 위치 (예 : 파일 또는 네트워크) 지원; 실시간 로그보기 및 필터링 기능 제공. 2. Syslog 설치 및 구성 (RSYSLOG 사용) Debian 시스템은 기본적으로 RSYSLOG를 사용합니다. 다음 명령으로 설치할 수 있습니다 : sudoaptupdatesud

데비안 syslog에 대한 방화벽 규칙을 구성하는 방법

Apr 13, 2025 am 06:51 AM

데비안 syslog에 대한 방화벽 규칙을 구성하는 방법

Apr 13, 2025 am 06:51 AM

이 기사에서는 데비안 시스템에서 iptables 또는 UFW를 사용하여 방화벽 규칙을 구성하고 Syslog를 사용하여 방화벽 활동을 기록하는 방법에 대해 설명합니다. 방법 1 : iptablesiptables 사용은 데비안 시스템의 강력한 명령 줄 방화벽 도구입니다. 기존 규칙보기 : 다음 명령을 사용하여 현재 iptables 규칙을보십시오. Sudoiptables-L-N-V 특정 IP 액세스 허용 : 예를 들어, IP 주소 192.168.1.100 허용 포트 80 : Sudoiptables-eActip-ptcp-d- 포트80-S192.16

데비안 아파치 로그 레벨을 설정하는 방법

Apr 13, 2025 am 08:33 AM

데비안 아파치 로그 레벨을 설정하는 방법

Apr 13, 2025 am 08:33 AM

이 기사에서는 데비안 시스템에서 Apacheweb 서버의 로깅 레벨을 조정하는 방법에 대해 설명합니다. 구성 파일을 수정하면 Apache가 기록한 로그 정보 수준을 제어 할 수 있습니다. 메소드 1 : 구성 파일을 찾으려면 기본 구성 파일을 수정합니다. 구성 파일 : APACHE2.X의 구성 파일은 일반적으로/etc/apache2/디렉토리에 있습니다. 파일 이름은 설치 방법에 따라 apache2.conf 또는 httpd.conf 일 수 있습니다. 구성 파일 편집 : 텍스트 편집기 (예 : Nano)를 사용하여 루트 권한이있는 구성 파일 열기 : sudonano/etc/apache2/apache2.conf

데비안을 오류하는 방법은 중간 중간의 공격을 방해합니다

Apr 13, 2025 am 10:30 AM

데비안을 오류하는 방법은 중간 중간의 공격을 방해합니다

Apr 13, 2025 am 10:30 AM

Debian Systems에서 OpenSSL은 암호화, 암호 해독 및 인증서 관리를위한 중요한 라이브러리입니다. MITM (Man-in-the-Middle Attack)을 방지하려면 다음 측정을 수행 할 수 있습니다. HTTPS 사용 : 모든 네트워크 요청이 HTTP 대신 HTTPS 프로토콜을 사용하도록하십시오. HTTPS는 TLS (Transport Layer Security Protocol)를 사용하여 통신 데이터를 암호화하여 전송 중에 데이터가 도난 당하거나 변조되지 않도록합니다. 서버 인증서 확인 : 클라이언트의 서버 인증서를 수동으로 확인하여 신뢰할 수 있는지 확인하십시오. 서버는 대의원 메소드를 통해 수동으로 확인할 수 있습니다.