ReLU는 시각적 Transformer의 Softmax를 대체하고 DeepMind의 새로운 트릭은 비용을 빠르게 절감합니다.

Transformer 아키텍처는 현대 기계 학습 분야에서 널리 사용되었습니다. 핵심은 토큰의 확률 분포를 생성하는 데 사용되는 소프트맥스를 포함하는 변환기의 핵심 구성 요소 중 하나에 초점을 맞추는 것입니다. Softmax는 지수 계산과 시퀀스 길이 합산을 수행하여 병렬화를 수행하기 어렵게 만들기 때문에 비용이 더 높습니다.

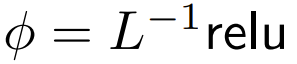

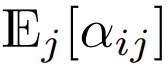

Google DeepMind가 새로운 아이디어를 내놓았습니다. 소프트맥스 연산을 반드시 확률 분포를 출력하지 않는 새로운 방법으로 교체하세요. 또한 그들은 ReLU를 시퀀스 길이로 나누어 사용하면 시각적 변환기와 함께 사용할 때 기존 소프트맥스에 접근하거나 이에 필적할 수 있다는 것을 관찰했습니다.

문서 링크: https://arxiv.org/abs/2309.08586

이 결과는 병렬화에 대한 새로운 솔루션을 제공합니다. ReLU의 초점은 시퀀스 길이 차원 병렬화에 중점을 두는 것이기 때문입니다. 전통적인 방법보다 수집 작업이 적습니다

방법

핵심은

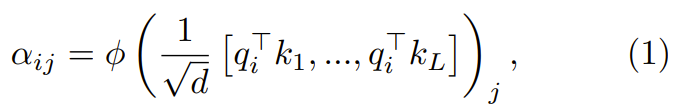

핵심은 d차원 쿼리, 키 및 값 변환 역할에 초점 {q_i, k_i, v_i}를 2단계 프로세스를 통해

첫 번째 단계에서 핵심은 가중치에 집중하는 것입니다  :

:

여기서 ф는 일반적으로 소프트맥스입니다.

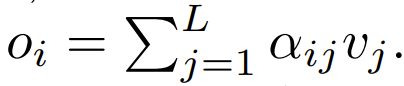

이를 사용하는 다음 단계는 가중치를 적용하여 출력을 계산하는 것입니다. 이 문서에서는 ф의 대안으로 점별 계산을 사용하는 방법을 살펴봅니다.

이 문서에서는 ф의 대안으로 점별 계산을 사용하는 방법을 살펴봅니다.

ReLU 요점은

DeepMind가 1의 ф = Softmax에 대해  이 더 나은 대안임을 관찰했습니다.

이 더 나은 대안임을 관찰했습니다.  ReLU라는 초점을 맞추는 것이 포인트입니다.

ReLU라는 초점을 맞추는 것이 포인트입니다.

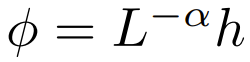

확장된 점별 초점은

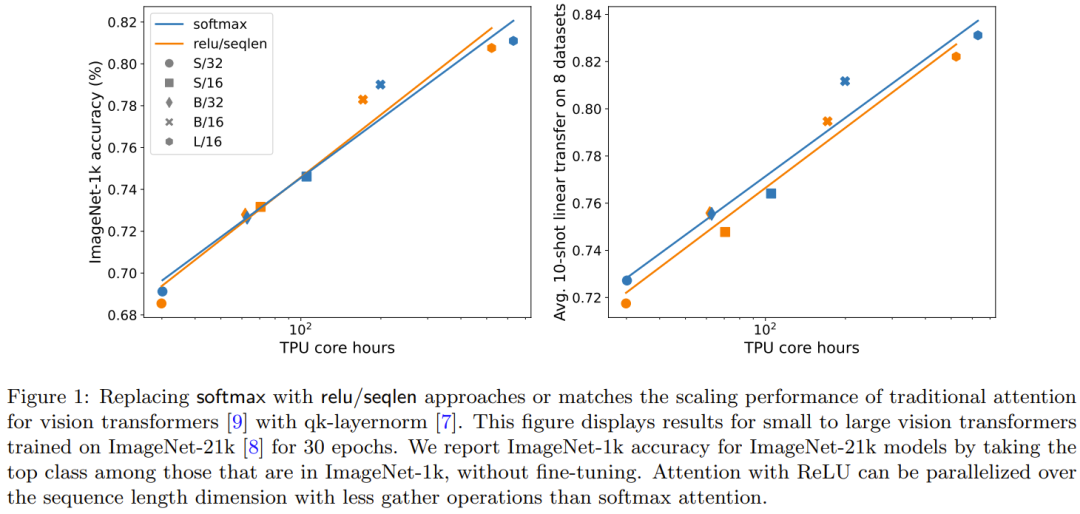

에 초점을 맞추는 것입니다. 연구원들은 또한 더 넓은 범위의  옵션을 실험적으로 탐색했습니다. relu², gelu,softplus, 신원,relu6,sigmoid}.

옵션을 실험적으로 탐색했습니다. relu², gelu,softplus, 신원,relu6,sigmoid}.

다시 작성해야 할 사항은 다음과 같습니다. 시퀀스 길이 확장

또한 시퀀스 길이 L과 관련된 프로젝트를 사용하여 확장하면 정확도가 향상될 수 있음을 발견했습니다. Softmax를 제거하려는 이전 연구에서는 이 스케일링 방식을 사용하지 않았습니다

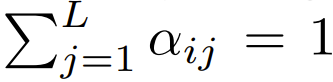

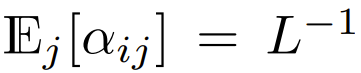

현재 소프트맥스를 사용하고 디자인에 집중하는 트랜스포머 중에는  가 있는데, 이는

가 있는데, 이는  필수 조건은 아닐지라도

필수 조건은 아닐지라도  초기화 중에 이를 보장할 수 있습니다.

초기화 중에 이를 보장할 수 있습니다.

, 이 조건을 유지하면 소프트맥스를 교체할 때 다른 하이퍼파라미터를 변경할 필요성이 줄어들 수 있습니다.

, 이 조건을 유지하면 소프트맥스를 교체할 때 다른 하이퍼파라미터를 변경할 필요성이 줄어들 수 있습니다.

초기화 중에 q와 k의 요소는 O(1)이므로  도 O(1)가 됩니다. ReLU와 같은 활성화 함수는 O(1)을 유지하므로

도 O(1)가 됩니다. ReLU와 같은 활성화 함수는 O(1)을 유지하므로  의 복잡성을

의 복잡성을  로 만들려면

로 만들려면  인수가 필요합니다.

인수가 필요합니다.

실험 및 결과

주요 결과

그림 1은 ImageNet-21k 훈련에 대한 ReLU focus on focus 및 Softmax focus on focus의 스케일링 추세를 보여줍니다. x축은 실험에 필요한 총 커널 계산 시간을 시간 단위로 표시합니다. ReLU의 가장 큰 장점은 시퀀스 길이 차원에서 병렬화할 수 있어 소프트맥스보다 수집 작업이 덜 필요하다는 것입니다.

다시 작성해야 하는 내용은 시퀀스 길이 확장의 효과입니다.

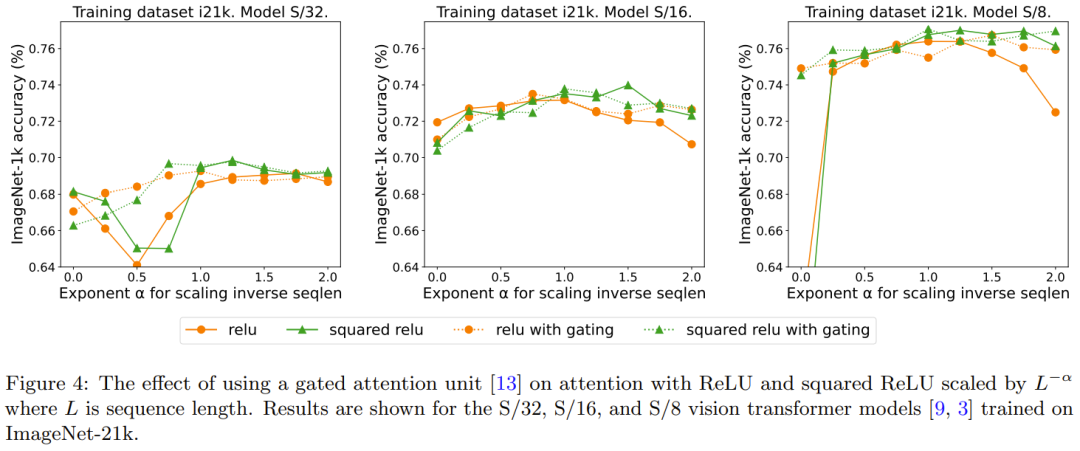

그림 2는 다시 작성해야 하는 내용을 비교합니다. 시퀀스 길이 확장 방법과 기타 방법 결과 Softmax에 대한 점별 대안입니다. 구체적으로는 소프트맥스를 대체하기 위해 relu, relu², gelu, Softplus, Identity 등의 방법을 사용하는 것입니다. X축은 α입니다. Y축은 S/32, S/16 및 S/8 Vision Transformer 모델의 정확도입니다. 일반적으로 α가 1에 가까울 때 최상의 결과를 얻습니다. 명확한 최적의 비선형성이 없기 때문에 더 빠르기 때문에 주요 실험에서 ReLU를 사용했습니다.

qk-layernorm의 효과는 다음과 같이 다시 설명할 수 있습니다.

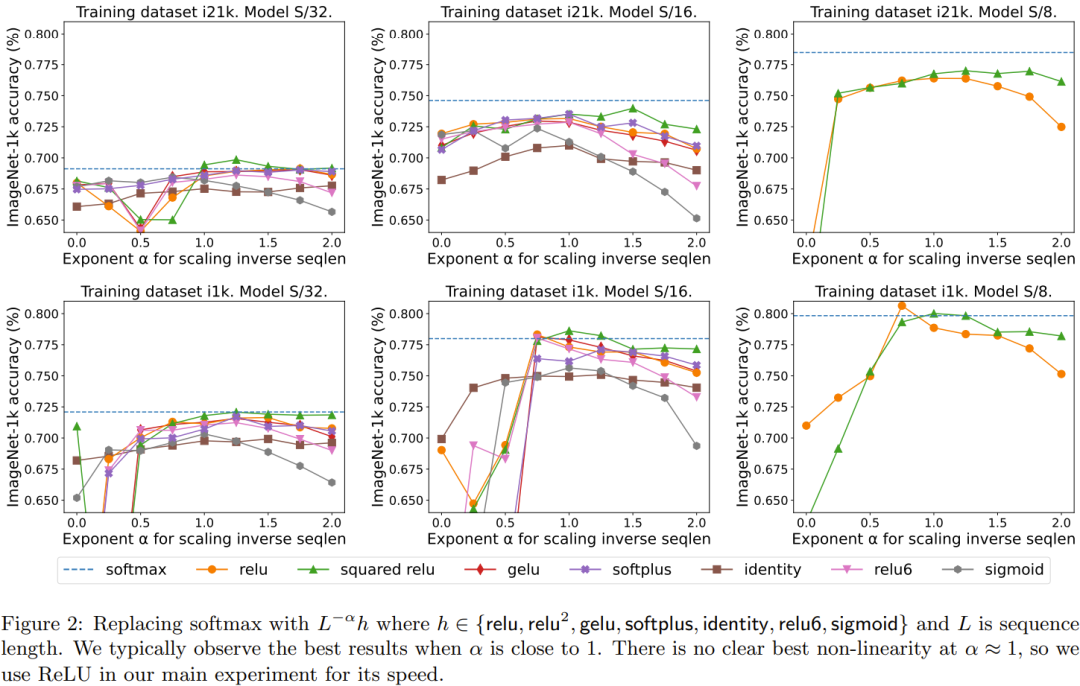

qk-layernorm은 쿼리와 키가 계산되는 주요 실험에 사용되었습니다. LayerNorm을 통과하기 전에 가중치에 집중하세요. DeepMind는 qk-layernorm을 기본적으로 사용하는 이유는 모델 크기를 확장할 때 불안정성을 방지하기 위해 필요하다고 말합니다. 그림 3은 qk-layernorm 제거의 영향을 보여줍니다. 이 결과는 qk-layernorm이 이러한 모델에 거의 영향을 미치지 않는다는 것을 나타냅니다. 그러나 모델 크기가 커지면 상황이 달라질 수 있습니다.

재설명: 문에 효과를 추가했습니다

소프트맥스 제거에 대한 이전 연구에서는 게이팅 유닛을 추가하는 방법을 채택했지만 이 방법은 시퀀스 길이에 따라 확장할 수 없습니다. 구체적으로, 게이트 어텐션 유닛에는 출력 투영 이전에 요소별 곱셈 조합으로 얻은 출력을 생성하는 추가 투영이 있습니다. 그림 4는 게이트가 있으면 다시 작성할 필요가 없는지 여부를 보여줍니다. 즉, 시퀀스 길이의 확장입니다. 전반적으로 DeepMind는 게이트가 있든 없든, 게이트가 있든 없든 재작성을 요구함으로써 최고의 정확도가 달성된다는 것을 관찰합니다. 시퀀스 길이 확장. 또한 ReLU를 사용하는 S/8 모델의 경우 이 게이팅 메커니즘은 실험에 필요한 코어 시간을 약 9.3% 증가시킵니다.

위 내용은 ReLU는 시각적 Transformer의 Softmax를 대체하고 DeepMind의 새로운 트릭은 비용을 빠르게 절감합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7518

7518

15

15

1378

1378

52

52

81

81

11

11

53

53

19

19

21

21

67

67

Google Pixel 9 Pro XL은 데스크톱 모드로 테스트되었습니다.

Aug 29, 2024 pm 01:09 PM

Google Pixel 9 Pro XL은 데스크톱 모드로 테스트되었습니다.

Aug 29, 2024 pm 01:09 PM

Google은 Pixel 8 시리즈에 DisplayPort 대체 모드를 도입했으며 새로 출시된 Pixel 9 라인업에 포함되어 있습니다. 주로 연결된 화면으로 스마트폰 디스플레이를 미러링할 수 있도록 하기 위해 존재하지만 데스크탑에서도 사용할 수 있습니다.

Google AI, 개발자를 위한 Gemini 1.5 Pro 및 Gemma 2 발표

Jul 01, 2024 am 07:22 AM

Google AI, 개발자를 위한 Gemini 1.5 Pro 및 Gemma 2 발표

Jul 01, 2024 am 07:22 AM

Google AI는 Gemini 1.5 Pro LLM(대형 언어 모델)부터 개발자에게 확장된 컨텍스트 창과 비용 절감 기능에 대한 액세스를 제공하기 시작했습니다. 이전에는 대기자 명단을 통해 제공되었으며 전체 200만 개의 토큰 컨텍스트 창

Google 앱 베타 APK 분해로 Gemini AI 비서에 추가되는 새로운 확장 기능 공개

Jul 30, 2024 pm 01:06 PM

Google 앱 베타 APK 분해로 Gemini AI 비서에 추가되는 새로운 확장 기능 공개

Jul 30, 2024 pm 01:06 PM

최신 업데이트(v15.29.34.29 베타)의 APK 분해를 고려하면 Google의 AI 비서인 Gemini가 더욱 강력해질 예정입니다. 거대 기술 기업의 새로운 AI 비서는 몇 가지 새로운 확장 기능을 얻을 수 있는 것으로 알려졌습니다. 이러한 확장 기능은

Pixel 9 Pro XL의 Google Tensor G4는 원신에서 Tensor G2보다 뒤떨어집니다.

Aug 24, 2024 am 06:43 AM

Pixel 9 Pro XL의 Google Tensor G4는 원신에서 Tensor G2보다 뒤떨어집니다.

Aug 24, 2024 am 06:43 AM

Google은 최근 Pixel 9 라인의 Tensor G4에 대한 성능 문제에 대응했습니다. 회사는 SoC가 벤치마크를 이길 수 있도록 설계되지 않았다고 말했습니다. 대신 팀은 Google이 C를 원하는 영역에서 좋은 성능을 발휘하도록 집중했습니다.

Google Pixel 9 스마트폰은 7년 업데이트 약속에도 불구하고 Android 15와 함께 출시되지 않습니다.

Aug 01, 2024 pm 02:56 PM

Google Pixel 9 스마트폰은 7년 업데이트 약속에도 불구하고 Android 15와 함께 출시되지 않습니다.

Aug 01, 2024 pm 02:56 PM

Pixel 9 시리즈는 8월 13일 출시로 예정되어 거의 다가왔습니다. 최근 소문에 따르면 Pixel 9, Pixel 9 Pro 및 Pixel 9 Pro XL은 128GB의 스토리지부터 시작하여 Pixel 8 및 Pixel 8 Pro(Amazon에서 현재 $749)를 미러링할 예정입니다.

새로운 Google Pixel 데스크탑 모드는 Motorola Ready For 및 Samsung DeX 대안으로 신선한 비디오로 선보였습니다.

Aug 08, 2024 pm 03:05 PM

새로운 Google Pixel 데스크탑 모드는 Motorola Ready For 및 Samsung DeX 대안으로 신선한 비디오로 선보였습니다.

Aug 08, 2024 pm 03:05 PM

Android Authority가 Google이 Android 14 QPR3 베타 2.1에 숨겨둔 새로운 Android 데스크톱 모드를 시연한 지 몇 달이 지났습니다. Pixel 8 및 Pixel 8에 대한 DisplayPort Alt 모드 지원을 추가하는 Google의 뒤를 이어 뜨거워졌습니다.

유출된 Google Pixel 9 광고는 \'Add Me\' 카메라 기능을 포함한 새로운 AI 기능을 보여줍니다.

Jul 30, 2024 am 11:18 AM

유출된 Google Pixel 9 광고는 \'Add Me\' 카메라 기능을 포함한 새로운 AI 기능을 보여줍니다.

Jul 30, 2024 am 11:18 AM

Pixel 9 시리즈와 관련된 더 많은 홍보 자료가 온라인에 유출되었습니다. 참고로 새로운 유출은 91mobiles가 Pixel Buds Pro 2와 Pixel Watch 3 또는 Pixel Watch 3 XL을 선보인 여러 이미지를 공유한 직후에 발생했습니다. 이 시간

Google은 대부분의 사용자에게 AI Test Kitchen 및 Imagen 3를 공개합니다.

Sep 12, 2024 pm 12:17 PM

Google은 대부분의 사용자에게 AI Test Kitchen 및 Imagen 3를 공개합니다.

Sep 12, 2024 pm 12:17 PM

사용자가 가지고 놀 수 있는 AI 디자인 도구 모음이 포함된 Google의 AI 테스트 키친은 이제 전 세계 100개가 넘는 국가의 사용자에게 공개되었습니다. 이번 움직임은 전 세계 많은 사람들이 Imagen 3, Googl을 사용할 수 있게 된 최초의 사례입니다.