컴퓨터 비전의 인간 자세 추정 문제

컴퓨터 비전에서 인간 자세 추정의 문제는 구체적인 코드 예제가 필요합니다

인간 자세 추정은 관절을 포함한 인체의 자세 정보를 정확하게 얻는 것이 컴퓨터 비전 분야의 중요한 연구 방향입니다. 위치, 이미지나 영상, 관절 각도 등 인간 자세 추정은 모션 캡처, 인간-컴퓨터 상호 작용, 가상 현실 등과 같은 다양한 응용 분야에서 폭넓게 응용됩니다. 이 기사에서는 인간 자세 추정의 기본 원리를 소개하고 구체적인 코드 예제를 제공합니다.

사람 자세 추정의 기본 원리는 이미지 속 인체의 핵심 포인트(예: 머리, 어깨, 손, 발 등)를 분석하여 인체 자세를 유추하는 것입니다. 이 목표를 달성하기 위해 CNN(Convolutional Neural Network) 또는 RNN(Recurrent Neural Network)과 같은 딥러닝 모델을 사용할 수 있습니다.

다음은 오픈 소스 라이브러리 OpenPose를 사용하여 인간 자세 추정을 구현하는 샘플 코드입니다.

import cv2

import numpy as np

from openpose import OpenPose

# 加载OpenPose模型

openpose = OpenPose("path/to/openpose/models")

# 加载图像

image = cv2.imread("path/to/image.jpg")

# 运行OpenPose模型

poses = openpose.detect(image)

# 显示姿态估计结果

for pose in poses:

# 绘制骨骼连接

image = openpose.draw_skeleton(image, pose)

# 绘制关节点

image = openpose.draw_keypoints(image, pose)

# 显示图像

cv2.imshow("Pose Estimation", image)

cv2.waitKey(0)

cv2.destroyAllWindows()위 샘플 코드에서는 먼저 필요한 라이브러리를 가져온 다음 OpenPose 모델을 로드하고 추정할 이미지를 로드합니다. 다음으로 OpenPose 모델을 실행하여 포즈를 감지하고 반환된 결과는 여러 포즈가 포함된 목록입니다. 마지막으로 OpenPose에서 제공하는 그리기 기능을 사용하여 포즈 추정 결과를 그리고 이미지를 표시합니다.

위의 예제 코드는 데모용일 뿐입니다. 실제로 인간 자세 추정을 구현하려면 더 복잡한 전처리, 후처리 및 매개변수 조정 프로세스가 필요합니다. 또한 OpenPose는 사용자가 사용할 수 있는 더 많은 기능과 옵션을 제공하는 오픈 소스 라이브러리입니다.

간단히 말하면, 인간 자세 추정은 이미지의 핵심 포인트를 분석하여 인체의 자세를 유추하는 컴퓨터 비전 분야에서 중요한 문제입니다. 이 기사에서는 오픈 소스 라이브러리 OpenPose를 사용하여 인간 자세 추정을 구현하기 위한 샘플 코드를 제공합니다. 독자는 자신의 필요에 따라 보다 심층적인 연구 및 개발을 수행할 수 있습니다.

위 내용은 컴퓨터 비전의 인간 자세 추정 문제의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7665

7665

15

15

1393

1393

52

52

1205

1205

24

24

91

91

11

11

73

73

19

19

ORB-SLAM3를 넘어! SL-SLAM: 저조도, 심한 흔들림, 약한 텍스처 장면을 모두 처리합니다.

May 30, 2024 am 09:35 AM

ORB-SLAM3를 넘어! SL-SLAM: 저조도, 심한 흔들림, 약한 텍스처 장면을 모두 처리합니다.

May 30, 2024 am 09:35 AM

이전에 작성했던 오늘은 딥 러닝 기술이 복잡한 환경에서 비전 기반 SLAM(동시 위치 파악 및 매핑)의 성능을 향상할 수 있는 방법에 대해 논의합니다. 심층 특징 추출과 깊이 일치 방법을 결합하여 저조도 조건, 동적 조명, 질감이 약한 영역 및 심한 지터와 같은 까다로운 시나리오에서 적응을 향상하도록 설계된 다목적 하이브리드 시각적 SLAM 시스템을 소개합니다. 우리 시스템은 확장 단안, 스테레오, 단안 관성 및 스테레오 관성 구성을 포함한 여러 모드를 지원합니다. 또한 시각적 SLAM을 딥러닝 방법과 결합하여 다른 연구에 영감을 주는 방법도 분석합니다. 공개 데이터 세트 및 자체 샘플링 데이터에 대한 광범위한 실험을 통해 위치 정확도 및 추적 견고성 측면에서 SL-SLAM의 우수성을 입증합니다.

NeRF란 무엇입니까? NeRF 기반 3D 재구성은 복셀 기반인가요?

Oct 16, 2023 am 11:33 AM

NeRF란 무엇입니까? NeRF 기반 3D 재구성은 복셀 기반인가요?

Oct 16, 2023 am 11:33 AM

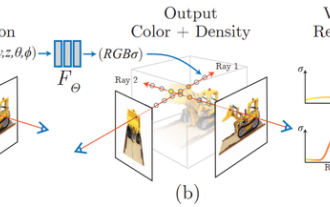

1 소개 NeRF(Neural Radiation Fields)는 딥 러닝 및 컴퓨터 비전 분야의 상당히 새로운 패러다임입니다. 이 기술은 ECCV2020 논문 "NeRF: Representing Scenes as Neural Radiation Fields for View Synesis"(Best Paper Award 수상)에 소개되었으며 이후 현재까지 거의 800회 인용될 정도로 인기가 높아졌습니다[1]. 이 접근 방식은 기계 학습이 3D 데이터를 처리하는 기존 방식에 큰 변화를 가져옵니다. 신경 방사선장 장면 표현 및 미분 가능한 렌더링 프로세스: 카메라 광선을 따라 5D 좌표(위치 및 시야 방향)를 샘플링하여 이미지를 합성하고 이러한 위치를 MLP에 공급하여 색상 및 체적 밀도를 생성하고 체적 렌더링 기술을 사용하여 이러한 값을 합성합니다. ; 렌더링 함수는 미분 가능하므로 전달될 수 있습니다.

자율주행의 최초 순수 시각적 정적 재구성

Jun 02, 2024 pm 03:24 PM

자율주행의 최초 순수 시각적 정적 재구성

Jun 02, 2024 pm 03:24 PM

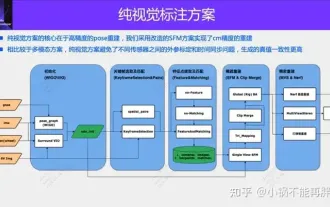

순수한 시각적 주석 솔루션은 주로 비전과 동적 주석을 위한 GPS, IMU 및 휠 속도 센서의 일부 데이터를 사용합니다. 물론 대량 생산 시나리오의 경우 순수 비전일 필요는 없습니다. 일부 대량 생산 차량에는 고체 레이더(AT128)와 같은 센서가 장착됩니다. 대량 생산 관점에서 데이터 폐쇄 루프를 만들고 이러한 센서를 모두 사용하면 동적 개체에 라벨을 붙이는 문제를 효과적으로 해결할 수 있습니다. 그러나 우리 계획에는 고체 레이더가 없습니다. 따라서 가장 일반적인 대량 생산 라벨링 솔루션을 소개하겠습니다. 순수한 시각적 주석 솔루션의 핵심은 고정밀 포즈 재구성에 있습니다. 재구성 정확도를 보장하기 위해 SFM(Structure from Motion)의 포즈 재구성 방식을 사용합니다. 하지만 통과

3D 비전을 위해서는 포인트 클라우드 등록이 필수입니다! 하나의 기사로 모든 주요 솔루션과 과제를 이해하세요

Apr 02, 2024 am 11:31 AM

3D 비전을 위해서는 포인트 클라우드 등록이 필수입니다! 하나의 기사로 모든 주요 솔루션과 과제를 이해하세요

Apr 02, 2024 am 11:31 AM

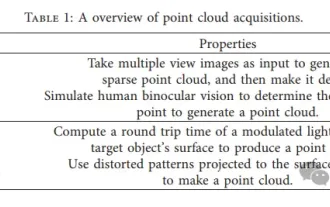

포인트의 집합체인 포인트 클라우드는 3차원 재구성, 산업검사, 로봇 운용 등을 통해 사물의 3차원(3D) 표면정보 획득과 생성에 변화를 가져올 것으로 기대된다. 가장 어렵지만 필수적인 프로세스는 포인트 클라우드 등록, 즉 서로 다른 두 좌표에서 얻은 두 포인트 클라우드를 정렬하고 일치시키는 공간 변환을 얻는 것입니다. 본 리뷰에서는 포인트 클라우드 등록의 개요와 기본 원리를 소개하고, 다양한 방법을 체계적으로 분류 및 비교하며, 포인트 클라우드 등록에 존재하는 기술적 문제를 해결하고, 현장 외부의 학술 연구자와 엔지니어에게 지침을 제공하고 통일된 비전에 대한 논의를 촉진하고자 합니다. 포인트 클라우드 등록을 위해. 일반적인 포인트 클라우드 획득 방법은 능동(Active) 방식과 수동(Passive) 방식으로 구분되며, 센서에 의해 능동적으로 획득되는 포인트 클라우드는 나중에 재구성되는 방식이다.

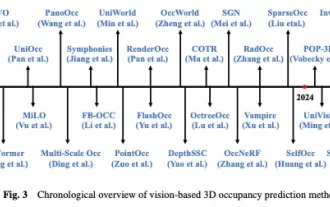

OCC와 자율주행의 과거와 현재를 살펴보세요! 첫 번째 검토에서는 기능 강화/양산 배포/효율적인 주석이라는 세 가지 주요 주제를 종합적으로 요약했습니다.

May 08, 2024 am 11:40 AM

OCC와 자율주행의 과거와 현재를 살펴보세요! 첫 번째 검토에서는 기능 강화/양산 배포/효율적인 주석이라는 세 가지 주요 주제를 종합적으로 요약했습니다.

May 08, 2024 am 11:40 AM

위 작성 및 저자 개인적 이해 최근 자율주행은 운전자의 부담을 줄이고 운전 안전성을 높일 수 있다는 점에서 주목을 받고 있다. 비전 기반 3차원 점유 예측은 자율 주행 안전에 대한 비용 효율적이고 포괄적인 조사에 적합한 새로운 인식 작업입니다. 많은 연구에서 객체 중심 인식 작업에 비해 3D 점유 예측 도구의 우수성을 입증했지만, 빠르게 발전하는 이 분야에 대한 리뷰는 여전히 남아 있습니다. 본 논문에서는 먼저 비전 기반 3D 점유 예측의 배경을 소개하고 이 작업에서 직면하는 과제에 대해 논의합니다. 다음으로, 기능 향상, 배포 친화성, 라벨링 효율성이라는 세 가지 측면에서 현재 3D 점유 예측 방법의 현황과 개발 동향을 종합적으로 논의합니다. 마침내

입만 움직여도 놀 수 있어요! AI를 사용하여 캐릭터를 바꾸고 적을 공격하십시오. 네티즌: '아야카, 카미리류 프로스트 파괴를 사용하세요.'

May 13, 2023 pm 07:52 PM

입만 움직여도 놀 수 있어요! AI를 사용하여 캐릭터를 바꾸고 적을 공격하십시오. 네티즌: '아야카, 카미리류 프로스트 파괴를 사용하세요.'

May 13, 2023 pm 07:52 PM

지난 2년 동안 전 세계적으로 인기를 얻은 국내 게임의 경우 Genshin Impact가 확실히 선두를 차지했습니다. 지난 5월 발표된 올해 1분기 모바일게임 매출 조사 보고서에 따르면 '원신임팩트'가 5억6700만달러의 절대우위로 카드드로잉 모바일게임 부문 1위를 굳건히 차지했다고 밝혔다. 불과 18년 만에 모바일 플랫폼의 총 수익이 30억 달러(약 RM130억)를 넘어섰습니다. 이제 Xumi가 개장하기 전 마지막 2.8 섬 버전이 기한이 지났습니다. 오랜 드래프트 기간을 거쳐 마침내 새로운 플롯과 플레이할 영역이 생겼습니다. 그런데 '간황제'가 몇 명인지는 모르겠습니다. 이제 섬을 완전히 탐험하고 나니 다시 풀이 자라기 시작했습니다. 총 182개의 보물 상자 + 1개의 모라 상자(포함되지 않음)가 있습니다. 긴 잔디 기간에 대해 걱정할 필요가 없습니다. 아니, 긴 풀밭에서

AAAI2024: Far3D - 150m 시각적 3D 표적 탐지에 직접 도달하는 혁신적인 아이디어

Dec 15, 2023 pm 01:54 PM

AAAI2024: Far3D - 150m 시각적 3D 표적 탐지에 직접 도달하는 혁신적인 아이디어

Dec 15, 2023 pm 01:54 PM

최근 Arxiv에서 순수 시각적 서라운드 인식에 관한 최신 연구를 읽었습니다. 이 연구는 PETR 시리즈 방법을 기반으로 하며 장거리 표적 탐지의 순수 시각적 인식 문제를 해결하여 인식 범위를 150미터로 확장하는 데 중점을 둡니다. 본 논문의 방법과 결과는 우리에게 큰 참고가치가 있어 이를 해석해 보았습니다. 원제: Far3D: Expanding the Horizon for Surround-view3DObjectDetection 논문 링크: https://arxiv.org/abs/2308.09616 저자 소속 :Beijing Institute of Technology & Megvii Technology 과제 배경 자율주행 이해에 있어서 3D 객체 검출

Yan Shuicheng이 책임을 맡아 '유니버설 비주얼 멀티 모드 대형 모델'의 궁극적인 형태를 확립했습니다! 통일된 이해/생성/분할/편집

Apr 25, 2024 pm 08:04 PM

Yan Shuicheng이 책임을 맡아 '유니버설 비주얼 멀티 모드 대형 모델'의 궁극적인 형태를 확립했습니다! 통일된 이해/생성/분할/편집

Apr 25, 2024 pm 08:04 PM

최근 Yan Shuicheng 교수 팀은 Vitron의 범용 픽셀 수준 시각적 다중 모드 대형 언어 모델을 공동으로 출시하고 오픈 소스화했습니다. 프로젝트 홈페이지 및 데모: https://vitron-llm.github.io/ 논문 링크: https://is.gd/aGu0VV 오픈 소스 코드: https://github.com/SkyworkAI/Vitron 일반 비전 다중 모드 대형 모델은 시각적 이해부터 시각적 생성까지, 낮은 수준에서 높은 수준까지 일련의 시각적 작업을 지원하고 오랫동안 대규모 언어 모델 업계를 괴롭혀온 이미지/비디오 모델 분리 문제를 해결합니다. 포괄적인 통합 정적 이미지 제공 동적 비디오 콘텐츠의 이해, 생성, 분할 및 편집