GPT-3.5를 선택하거나 Llama 2와 같은 오픈 소스 모델을 미세 조정하시겠습니까? 종합적으로 비교해보면 답은 이렇습니다.

GPT-3.5를 미세 조정하는 데는 비용이 매우 많이 드는 것으로 알려져 있습니다. 이 문서에서는 실험을 통해 수동으로 미세 조정된 모델이 적은 비용으로 GPT-3.5의 성능에 접근할 수 있는지 여부를 확인합니다. 흥미롭게도 이 기사는 바로 그 일을 하고 있습니다. SQL 작업과 기능적 표현 작업에 대한

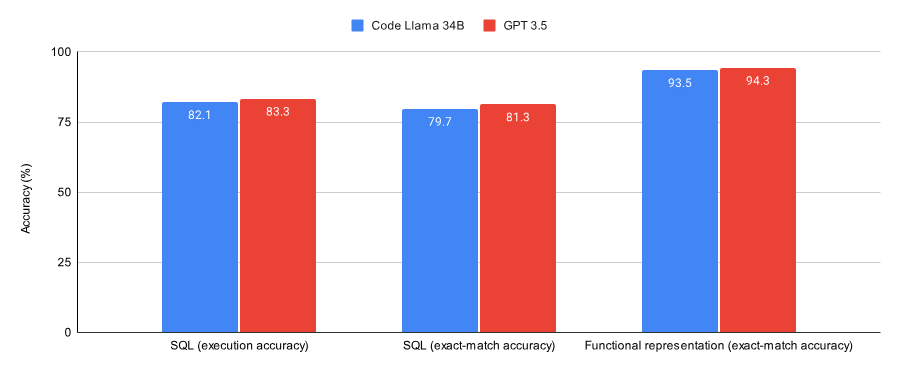

결과를 비교한 이 기사에서는 다음과 같은 사실을 발견했습니다.

- GPT-3.5가 두 데이터 세트(Spider 데이터 세트의 하위 세트 및 Viggo 기능 표현 데이터 세트)에서 더 좋습니다. ) Lora가 미세 조정한 Code Llama 34B 이후보다 약간 더 나은 성능을 보였습니다.

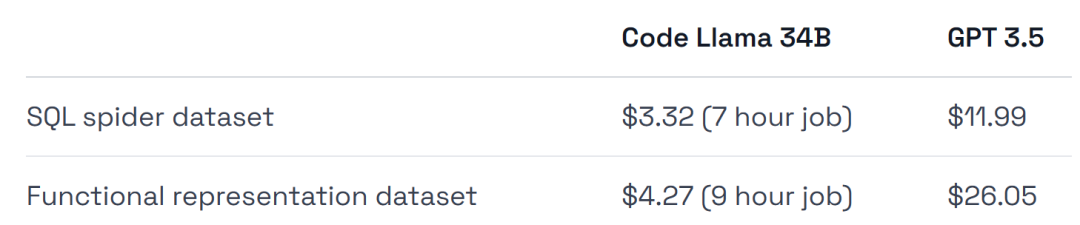

- GPT-3.5는 훈련 비용과 배포 비용이 4~6배 더 비쌉니다.

이 실험의 결론 중 하나는 초기 검증 작업에는 GPT-3.5 미세 조정이 적합하지만 그 이후에는 Llama 2와 같은 모델이 최선의 선택이 될 수 있다는 것입니다. 미세 조정이 특정 작업/데이터 세트를 해결하는 올바른 방법인지 확인하고 싶거나 완전히 관리되는 환경을 원한다면 GPT-3.5를 미세 조정하세요.

- 비용을 절약하고, 데이터 세트에서 최대 성능을 얻고 싶고, 인프라 교육 및 배포에 더 많은 유연성을 갖고 싶거나 일부 개인 데이터를 유지하고 싶다면 오픈 소스 모델인 Llama 2와 같은 것을 미세 조정하세요.

- 다음으로 이 문서가 어떻게 구현되는지 살펴보겠습니다.

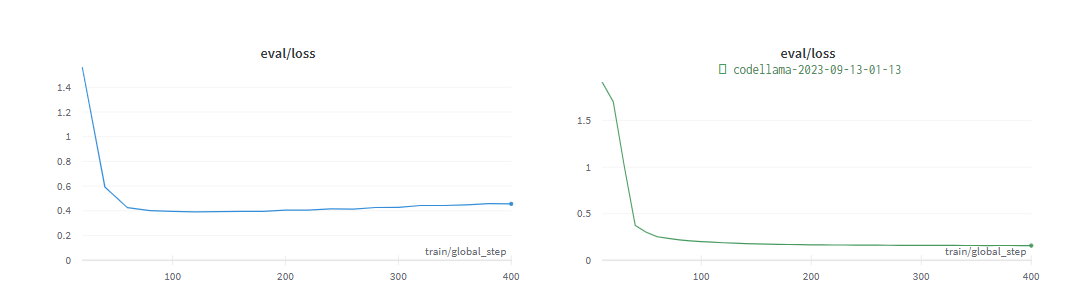

아래 그림은 SQL 작업과 함수형 표현 작업을 융합하도록 훈련된 Code Llama 34B와 GPT-3.5의 성능을 보여줍니다. 결과는 GPT-3.5가 두 작업 모두에서 더 나은 정확도를 달성한다는 것을 보여줍니다.

하드웨어 사용량 측면에서 실험에서는 시간당 약 $0.475의 A40 GPU를 사용했습니다.

또한 실험에서는 미세 조정에 매우 적합한 두 개의 데이터 세트인 Spider 데이터 세트의 하위 세트와 Viggo 기능 표현 데이터 세트를 선택했습니다.

또한 실험에서는 미세 조정에 매우 적합한 두 개의 데이터 세트인 Spider 데이터 세트의 하위 세트와 Viggo 기능 표현 데이터 세트를 선택했습니다.

GPT-3.5 모델과의 공정한 비교를 위해 실험에서는 Llama에 대해 최소한의 하이퍼 매개변수 미세 조정을 수행했습니다.

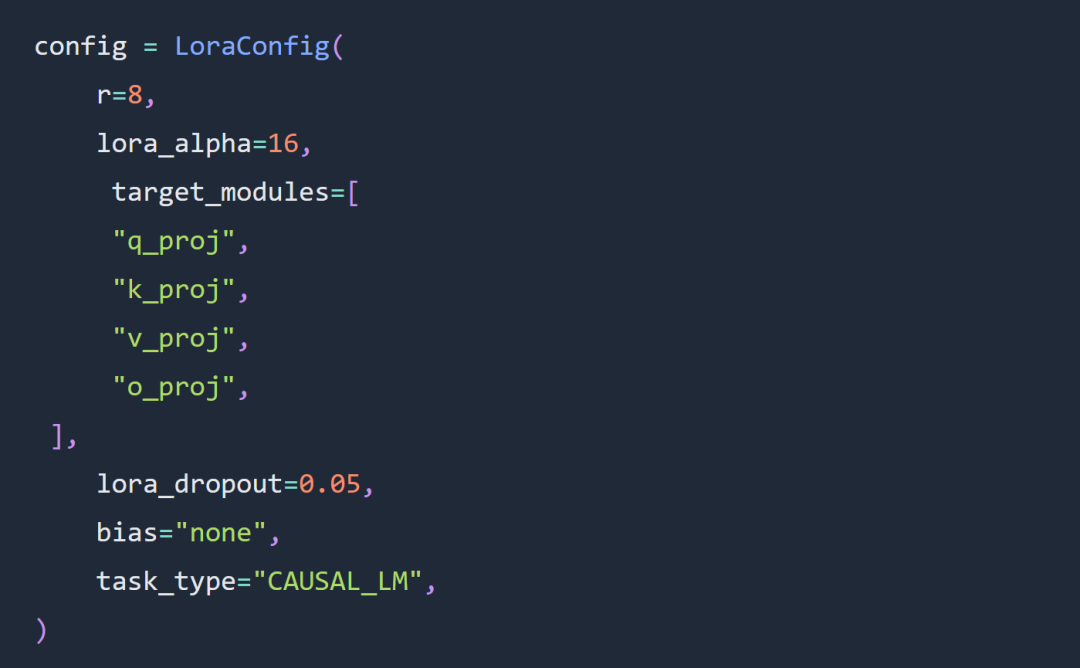

이 기사의 실험에서 두 가지 주요 선택은 전체 매개변수 미세 조정 대신 Code Llama 34B 및 Lora 미세 조정을 사용하는 것입니다.

실험은 주로 Lora 하이퍼 매개변수 미세 조정에 대한 규칙을 따랐으며 Lora 어댑터 구성은 다음과 같습니다.

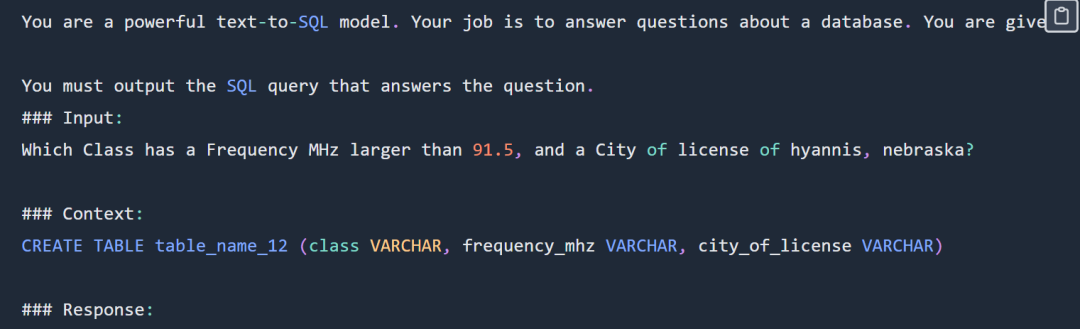

SQL 프롬프트 예는 다음과 같습니다.

SQL 프롬프트 예는 다음과 같습니다.

SQL 프롬프트 부분 표시, 전체 팁은 원본 블로그를 확인하세요

SQL 프롬프트 부분 표시, 전체 팁은 원본 블로그를 확인하세요

실험에서는 전체 Spider 데이터 세트를 사용하지 않았습니다. 구체적인 형식은 다음과 같습니다

department : Department_ID [ INT ] primary_key Name [ TEXT ] Creation [ TEXT ] Ranking [ INT ] Budget_in_Billions [ INT ] Num_Employees [ INT ] head : head_ID [ INT ] primary_key name [ TEXT ] born_state [ TEXT ] age [ INT ] management : department_ID [ INT ] primary_key management.department_ID = department.Department_ID head_ID [ INT ] management.head_ID = head.head_ID temporary_acting [ TEXT ]

실험에서는 SQL- create-context 데이터 세트 및 Spider 데이터 세트. 모델에 제공되는 컨텍스트는 다음과 같은 SQL 생성 명령입니다.

CREATE TABLE table_name_12 (class VARCHAR, frequency_mhz VARCHAR, city_of_license VARCHAR)

SQL 작업에 대한 코드 및 데이터: https://github.com/samlhuillier/spider-sql-finetune

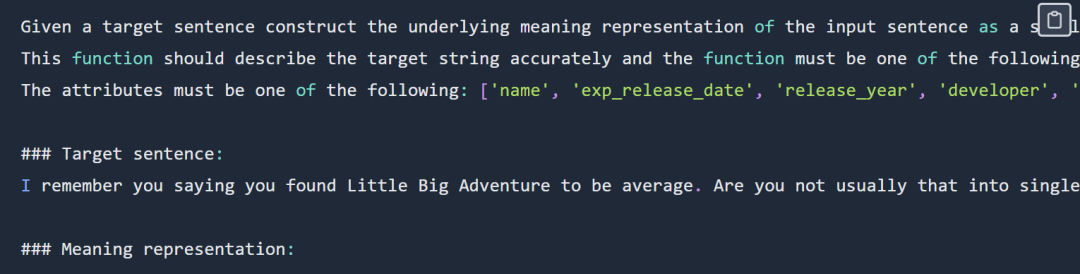

기능적 표현 팁 예는 다음과 같습니다.

기능적 표현 팁은 부분적으로 표시됩니다. 전체 팁을 보려면 원본 블로그를 확인하세요.

기능적 표현 팁은 부분적으로 표시됩니다. 전체 팁을 보려면 원본 블로그를 확인하세요.

출력은 다음과 같습니다.

verify_attribute(name[Little Big Adventure], rating[average], has_multiplayer[no], platforms[PlayStation])

평가 단계에서 , 두 실험은 빠르게 완료되었습니다. Converged:

기능적 표현 작업 코드 및 데이터 주소: https://github.com/samlhuillier/viggo-finetune

자세한 내용은 원본 블로그를 확인하세요. .

위 내용은 GPT-3.5를 선택하거나 Llama 2와 같은 오픈 소스 모델을 미세 조정하시겠습니까? 종합적으로 비교해보면 답은 이렇습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7350

7350

15

15

1628

1628

14

14

1353

1353

52

52

1265

1265

25

25

1214

1214

29

29

XML 형식을 아름답게하는 방법

Apr 02, 2025 pm 09:57 PM

XML 형식을 아름답게하는 방법

Apr 02, 2025 pm 09:57 PM

XML 미화는 합리적인 압입, 라인 브레이크 및 태그 구성을 포함하여 기본적으로 가독성을 향상시키고 있습니다. 원칙은 XML 트리를 가로 지르고 레벨에 따라 들여 쓰기를 추가하고 텍스트가 포함 된 빈 태그와 태그를 처리하는 것입니다. Python의 xml.etree.elementtree 라이브러리는 위의 미화 프로세스를 구현할 수있는 편리한 Pretty_XML () 기능을 제공합니다.

XML 형식을 확인하는 방법

Apr 02, 2025 pm 10:00 PM

XML 형식을 확인하는 방법

Apr 02, 2025 pm 10:00 PM

XML 형식 유효성 검증에는 구조를 확인하고 DTD 또는 스키마를 준수하는 것이 포함됩니다. ElementTree (기본 구문 검사) 또는 LXML (더 강력한 검증, XSD 지원)과 같은 XML 파서가 필요합니다. 검증 프로세스에는 XML 파일을 구문 분석하고 XSD 스키마를로드하고 오류가 감지 될 때 예외를 던지기 위해 AsserTValid 메소드를 실행하는 것이 포함됩니다. XML 형식을 확인하려면 다양한 예외를 처리하고 XSD 스키마 언어에 대한 통찰력을 얻어야합니다.

C 언어로 Char Array를 사용하는 방법

Apr 03, 2025 pm 03:24 PM

C 언어로 Char Array를 사용하는 방법

Apr 03, 2025 pm 03:24 PM

char 어레이는 문자 시퀀스를 C 언어로 저장하고 char array_name [size]로 선언됩니다. 액세스 요소는 첨자 연산자를 통해 전달되며 요소는 문자열의 끝점을 나타내는 널 터미네이터 '\ 0'으로 끝납니다. C 언어는 strlen (), strcpy (), strcat () 및 strcmp ()와 같은 다양한 문자열 조작 함수를 제공합니다.

C 스위치 문에서 기본적으로 발생하는 오류를 피하십시오

Apr 03, 2025 pm 03:45 PM

C 스위치 문에서 기본적으로 발생하는 오류를 피하십시오

Apr 03, 2025 pm 03:45 PM

C 스위치 문에서 기본적으로 발생하는 오류를 피하기위한 전략 : 상수 대신 열거를 사용하여 사례 문의 값을 열거의 유효한 멤버로 제한합니다. 마지막 사례 명령문에서 러프를 사용하여 프로그램이 다음 코드를 계속 실행할 수 있도록하십시오. 스위치가없는 스위치 문의 경우 항상 오류 처리에 대한 기본 문을 추가하거나 기본 동작을 제공하십시오.

C 언어 합계의 기능은 무엇입니까?

Apr 03, 2025 pm 02:21 PM

C 언어 합계의 기능은 무엇입니까?

Apr 03, 2025 pm 02:21 PM

C 언어에는 내장 합계 기능이 없으므로 직접 작성해야합니다. 합계는 배열 및 축적 요소를 가로 질러 달성 할 수 있습니다. 루프 버전 : 루프 및 배열 길이를 사용하여 계산됩니다. 포인터 버전 : 포인터를 사용하여 배열 요소를 가리키며 효율적인 합계는 자체 증가 포인터를 통해 달성됩니다. 동적으로 배열 버전을 할당 : 배열을 동적으로 할당하고 메모리를 직접 관리하여 메모리 누출을 방지하기 위해 할당 된 메모리가 해제되도록합니다.

C 언어의 Null과 Null 문자의 차이점은 무엇입니까?

Apr 03, 2025 am 11:12 AM

C 언어의 Null과 Null 문자의 차이점은 무엇입니까?

Apr 03, 2025 am 11:12 AM

NULL (포인터) 및 \ 0 (NULL 문자)은 C 언어에서 완전히 다릅니다. NULL은 유효하지 않은 포인터 포인트 (메모리 주소 0), \ 0은 문자열의 끝을 표시하는 문자 상수를 의미합니다. 혼합 사용에 오류가 발생합니다 (컴파일러 경고).

C 언어 null의 의미는 무엇입니까?

Apr 03, 2025 pm 12:00 PM

C 언어 null의 의미는 무엇입니까?

Apr 03, 2025 pm 12:00 PM

C 언어의 Null은 존재하지 않는 메모리 주소를 가리키는 NULL 포인터를 나타냅니다. 오류 처리 및 데이터 종료 구조 표시에 사용되지만 Segfault 및 프로그램 충돌과 같은 문제를 피하기 위해 Null 포인터의 유효성을 확인하는 데주의를 기울여야합니다.

C 언어에 유용한 Null은 무엇입니까?

Apr 03, 2025 pm 12:03 PM

C 언어에 유용한 Null은 무엇입니까?

Apr 03, 2025 pm 12:03 PM

NULL은 NULL 포인터를 나타내는 C 언어의 특수 값으로, 포인터 변수가 유효한 메모리 주소를 가리키지 않음을 식별하는 데 사용됩니다. NULL 이해는 프로그램 충돌을 피하고 코드 견고성을 보장하기 때문에 중요합니다. 일반적인 사용에는 매개 변수 점검, 메모리 할당 및 기능 설계에 대한 선택적 매개 변수가 포함됩니다. NULL을 사용하는 경우 매달려 포인터와 같은 오류를 피하고 NULL을 확인하는 것을 잊고 효율적인 NULL 점검을 잊고 코드 성능 및 가독성을 최적화하기 위해 명명을 명확하게하는 데주의를 기울여야합니다.