11월 16일 뉴스, 오늘 Microsoft Ignite 2023 컨퍼런스가 시작되었습니다. NVIDIA 경영진이 컨퍼런스에 참석하여 TensorRT-LLM에 대한 업데이트를 발표하고 OpenAI Chat API에 대한 지원을 추가했습니다.

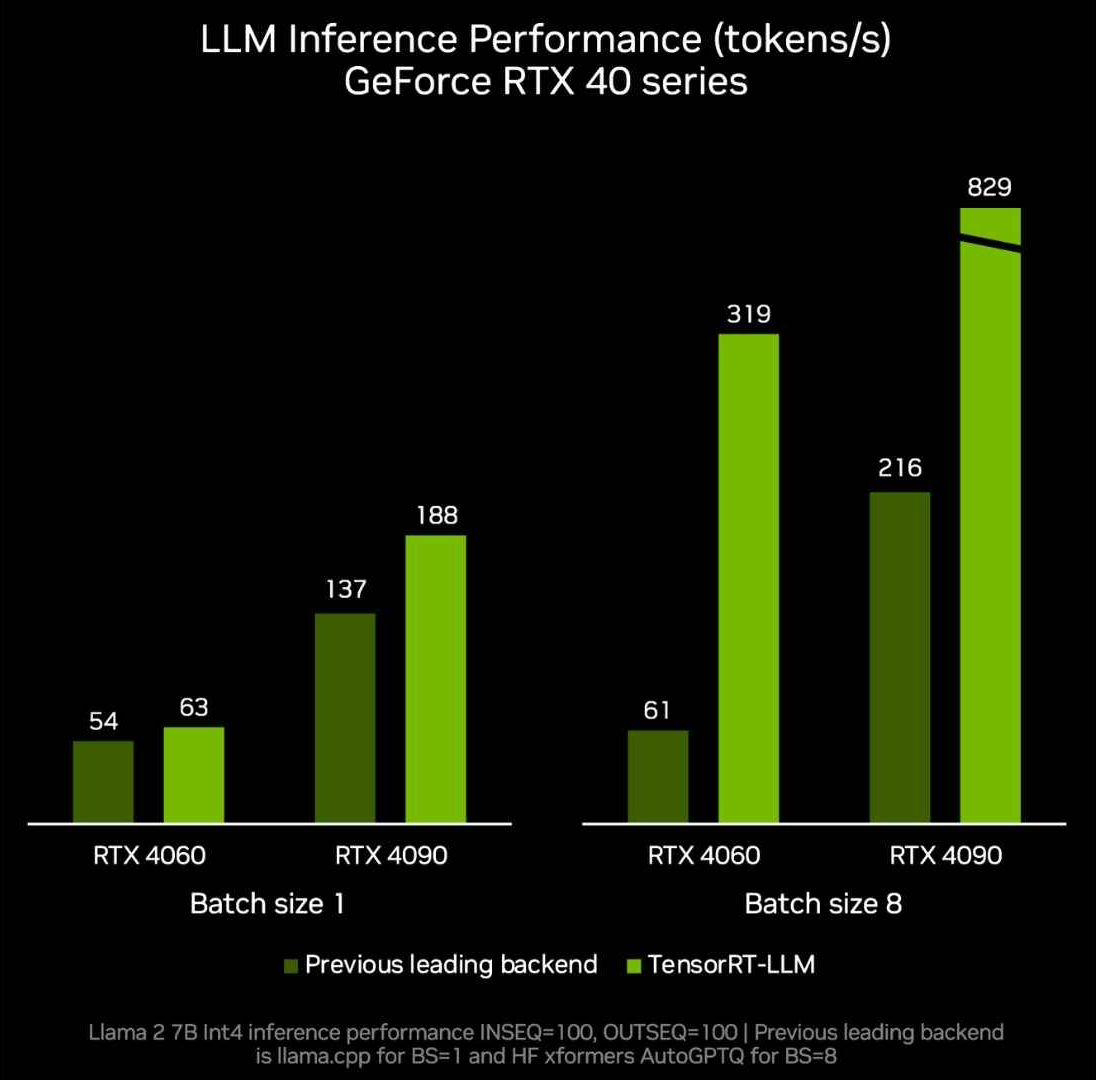

NVIDIA는 데이터 센터 및 Windows PC에 대한 지원 제공을 목표로 올해 10월 Tensor RT-LLM 오픈 소스 라이브러리를 출시했습니다. 이 오픈 소스 라이브러리의 가장 큰 특징은 Windows PC에 NVIDIA의 GeForce RTX GPU가 장착되면 TensorRT-LLM이 Windows PC에서 LLM의 실행 속도를 4배로 늘릴 수 있다는 것입니다

NVIDIA는 오늘 Ignite 2023 컨퍼런스에서 발표했습니다. TensorRT 업데이트- LLM, OpenAI의 Chat API 지원을 추가하고 DirectML 기능을 향상하여 Llama 2 및 Stable Diffusion과 같은 AI 모델의 성능을 향상시킵니다.

TensorRT-LLM은 NVIDIA의 AI Workbench를 사용하여 로컬에서 수행할 수 있습니다. 개발자는 이 통합되고 사용하기 쉬운 툴킷을 활용하여 PC 또는 워크스테이션에서 사전 훈련된 생성 AI 모델 및 LLM을 신속하게 생성, 테스트 및 사용자 지정할 수 있습니다. NVIDIA는 이에 대한 조기 액세스 등록 페이지도 출시했습니다.

NVIDIA는 이번 달 말에 TensorRT-LLM 0.6.0 버전 업데이트를 출시할 예정입니다. 이를 통해 추론 성능이 5배 향상되고 Mistral 7B 및 Nemotron과 같은 다른 주류 LLM을 지원할 예정입니다. 3 8B .

사용자는 8GB 이상의 비디오 메모리를 갖춘 GeForce RTX 30 시리즈 및 40 시리즈 GPU에서 실행할 수 있으며 일부 휴대용 Windows 장치에서도 빠르고 정확한 기본 LLM 기능을 사용할 수 있습니다

위 내용은 NVIDIA는 TensorRT-LLM의 새 버전을 공개합니다. 추론 기능이 5배 증가하고 8GB 이상의 그래픽 카드에서 로컬 작업에 적합하며 OpenAI의 Chat API를 지원합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!