기술 주변기기

기술 주변기기

일체 포함

일체 포함

13개의 시각적 언어 과제를 완료하세요! Harbin Institute of Technology, 성능이 5% 향상된 다중 모드 대형 모델 'Jiutian' 출시

13개의 시각적 언어 과제를 완료하세요! Harbin Institute of Technology, 성능이 5% 향상된 다중 모드 대형 모델 'Jiutian' 출시

13개의 시각적 언어 과제를 완료하세요! Harbin Institute of Technology, 성능이 5% 향상된 다중 모드 대형 모델 'Jiutian' 출시

다중 모드 대형 언어 모델에서 시각적 정보 추출이 부족한 문제를 해결하기 위해 하얼빈 공과대학(심천)의 연구진은 이중 계층 지식 강화 다중 모드 대형 언어 모델인 JiuTian-LION을 제안했습니다.

다시 작성해야 하는 내용은 다음과 같습니다. 논문 링크: https://arxiv.org/abs/2311.11860

GitHub: https://github.com/rshaojimmy/JiuTian

프로젝트 홈페이지: https://rshaojimmy.github.io/Projects/JiuTian-LION

기존 작업과 비교하여 JiuTian은 처음으로 이미지 수준의 이해 작업과 지역 수준의 포지셔닝 작업 간의 내부 갈등을 분석했습니다. , 그리고 두 작업의 상호 개선을 달성하기 위해 Segmented Instruction Fine-tuning 전략과 하이브리드 어댑터를 제안했습니다.

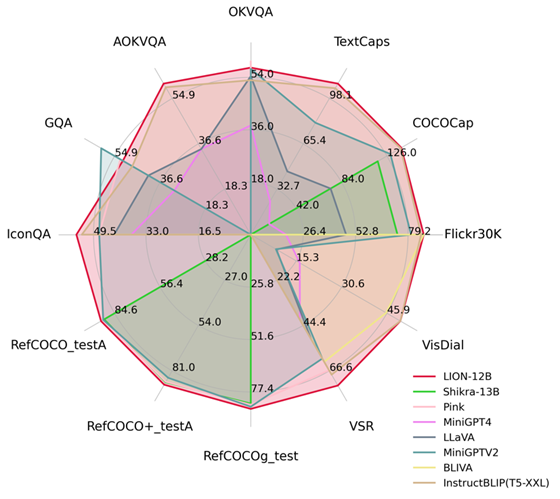

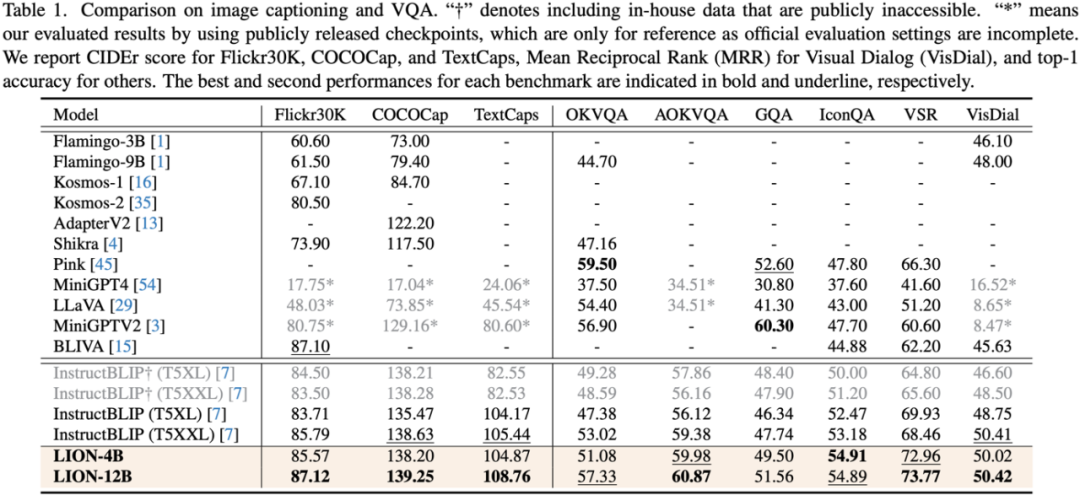

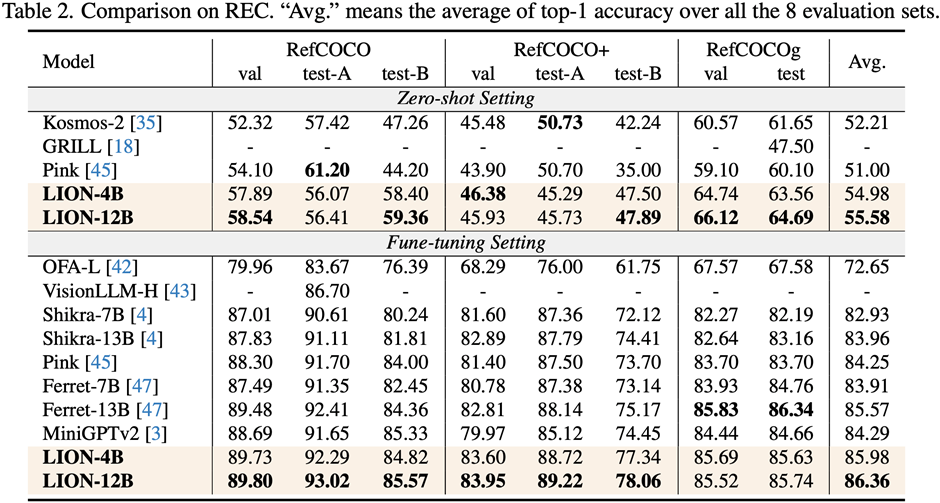

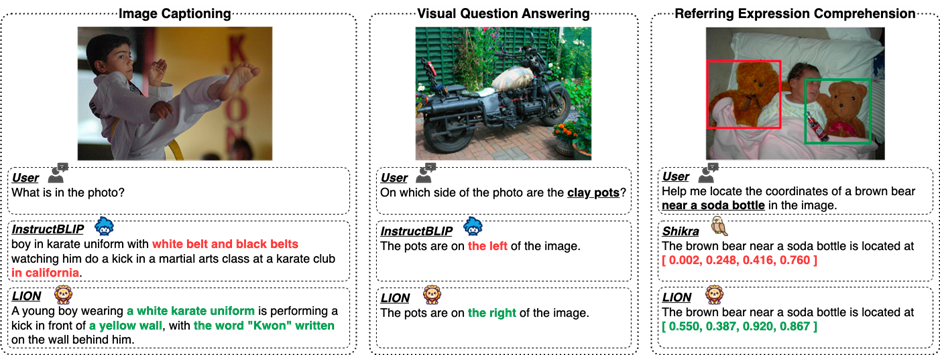

세밀한 공간 인식과 높은 수준의 의미론적 시각적 지식을 주입함으로써 Jiutian은 이미지 설명, 시각적 문제 및 시각적 위치 파악을 포함한 17가지 시각적 언어 작업에서 상당한 성능 향상을 달성했습니다(예: 시각적 공간 추론에서 최대 5개) ) % 성능 향상), 13개 평가 과제에서 국제 최고 수준에 도달했습니다. 성능 비교는 그림 1에 나와 있습니다.

그림 1: 다른 MLLM과 비교하여 Jiutian은 대부분의 작업에서 최적의 성능을 달성했습니다.

JiuTian-LION

대형 언어 모델(LLM) 다중 모드 인식 기능을 제공하여 일부 작업에서는 다중 모드 대형 언어 모델(MLLM)을 생성하기 시작했으며 많은 시각적 언어 작업에서 획기적인 진전을 이루었습니다. 그러나 기존 MLLM은 주로 CLIP-ViT

와 같이 이미지-텍스트 쌍에 대해 사전 훈련된 시각적 인코더를 사용합니다. 이러한 시각적 인코더의 주요 작업은 이미지 수준에서 대략적인 이미지-텍스트 모달 정렬을 학습하는 것입니다. 포괄적인 시각적 인식 및 정보 추출 기능이 부족하여 세밀한 시각적 이해를 수행할 수 없습니다

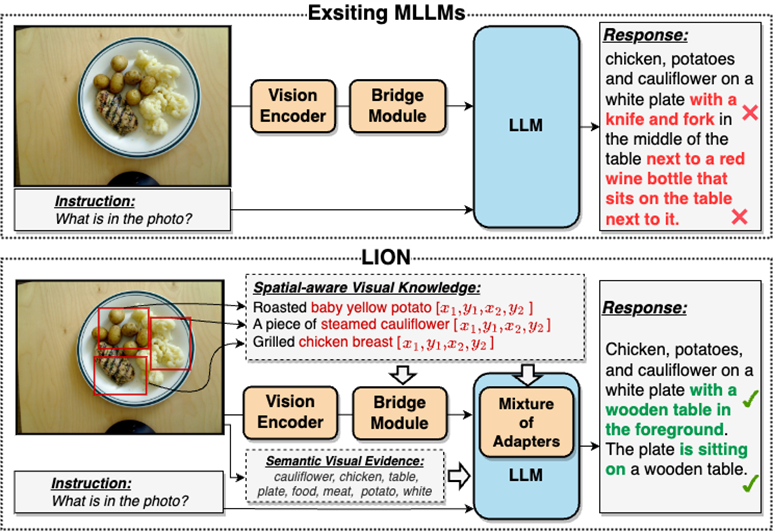

대부분 이러한 시각적 정보 추출 부족과 이해 부족의 문제는 시각적 위치 편향, 공간 추론 부족, 공간 추론 부족으로 이어질 것입니다. MLLM에 대한 이해는 그림 2

그림 2와 같이 객체 환상과 같은 결함이 많습니다. JiuTian-LION은 이중 계층 시각적 지식으로 강화된 다중 모드 대형 언어 모델입니다

기존 다중 모드 대형 언어 모델(MLLM)과 비교하여 Jiutian은 세분화된 공간 인식 시각적 지식과 높은 수준의 의미론적 시각적 증거를 주입하여 MLLM의 시각적 이해 능력을 효과적으로 향상시키고 보다 정확한 텍스트 응답을 생성하며 MLLM의 환각 현상

이층 시각 지식 강화 다중 모달 대형 언어 모델-JiuTian-LION

시각 정보 추출 및 이해에 있어 MLLM의 단점을 해결하기 위해 연구자들은 A를 제안했습니다. JiuTian-LION이라는 이중 계층 시각적 지식 강화 MLLM 방법이 제안되었습니다. 구체적인 방법 프레임워크는 그림 3에 나와 있습니다.

이 방법은 주로 세밀한 공간 인식 시각적 지식의 점진적 통합(세밀한 공간 인식 시각적 지식의 점진적 통합)과 높은 수준의 두 가지 측면에서 MLLM을 향상시킵니다. 소프트 프롬프트 하의 소프트웨어 높은 수준의 의미론적 시각적 증거에 대한 소프트 프롬프트.

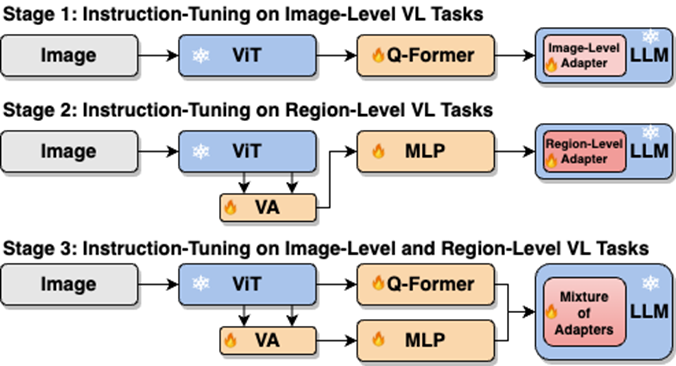

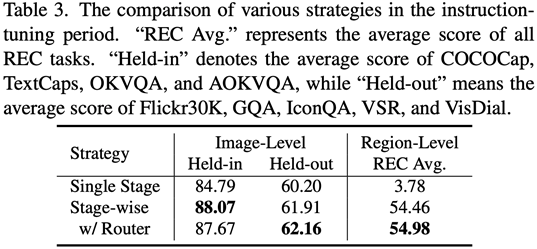

구체적으로 연구진은 이미지 수준 이해 작업과 지역 수준 위치 파악 작업 간의 내부 갈등을 해결하기 위해 분할된 명령 미세 조정 전략을 제안했습니다. 그들은 MLLM에 세분화된 공간 인식 지식을 점진적으로 주입합니다. 동시에 MLLM에 높은 수준의 의미론적 시각적 증거로 이미지 레이블을 추가하고 소프트 프롬프트 방법을 사용하여 잘못된 레이블이 가져올 수 있는 부정적인 영향을 완화했습니다. JiuTian-LION 모델 프레임워크 다이어그램은 다음과 같습니다. 이 작업은 분할된 훈련 전략을 사용하여 먼저 Q-Former 및 Vision Aggregator-MLP 분기를 기반으로 이미지 수준 이해 및 지역 수준 포지셔닝 작업을 학습한 다음 라우팅 메커니즘이 있는 하이브리드 어댑터를 사용하여 다양한 작업을 동적으로 융합합니다. 최종 훈련 단계에서 두 가지 작업에 대한 분기형 지식 개선 모델을 수행합니다. 이 작업도 RAM을 통해 이미지 라벨을 상위 의미 시각적 증거로 추출한 다음, 상위 의미 주입 효과를 향상시키기 위한 소프트 프롬프트 방법을 제안합니다. 세밀한 공간 인식 시각적 증거를 점진적으로 융합합니다. Knowledge 이미지 수준 이해 작업(이미지 설명 및 시각적 질문 답변 포함)과 지역 수준 현지화 작업(지시 표현 이해, 지시 표현 생성 등)에 대한 단일 단계 혼합 교육을 직접 수행할 때 MLLM은 두 작업 간에 내부 충돌이 발생하므로 모든 작업에서 전반적인 성능이 향상될 수 없습니다. 연구원들은 이러한 내부 갈등이 주로 두 가지 문제로 인해 발생한다고 믿습니다. 첫 번째 문제는 지역 수준의 모달 정렬 사전 훈련이 부족하다는 것입니다. 현재 지역 수준 포지셔닝 기능을 갖춘 대부분의 MLLM은 사전 훈련을 위해 많은 양의 관련 데이터를 사용합니다. 그렇지 않으면 이미지 수준을 사용하기가 어렵습니다. 제한된 훈련 자원을 기반으로 한 모달 정렬. 지역 수준 작업에 대한 시각적 기능 적응. 또 다른 문제는 이미지 수준 이해 작업과 지역 수준 현지화 작업 간의 입출력 패턴 차이입니다. 후자는 모델이 객체 좌표에 대한 특정 짧은 문장( 그림 4에서 볼 수 있듯이 연구원들은 단일 단계 명령 미세 조정 프로세스를 세 단계로 나눕니다. ViT, Q-Former 및 이미지 수준 어댑터를 사용하여 이미지 수준 이해 작업을 학습합니다. 글로벌 시각 지식, Vision Aggregator, MLP 및 지역 수준 어댑터를 사용하여 세밀한 공간 인식 시각 지식으로 지역 수준 포지셔닝 작업을 학습합니다. 가지. 표 3은 단일 단계 훈련에 비해 분할된 명령 미세 조정 전략의 성능 이점을 보여줍니다 그림 4: 소프트 주입을 위한 분할된 명령 미세 조정 전략 프롬프트 높은 수준의 의미론적 시각적 증거를 다시 작성해야 합니다 연구원은 MLLM의 전체 시각적 인식 이해 능력을 더욱 향상시키기 위해 이미지 레이블을 높은 수준의 의미론적 시각적 증거에 대한 효과적인 보완재로 사용할 것을 제안했습니다 구체적으로는 먼저 RAM을 통해 이미지의 태그를 추출한 다음 " 템플릿의 "사용 또는 부분 사용"이라는 특정 문구와 결합된 소프트 힌트 벡터는 모델이 잘못된 라벨의 잠재적인 부정적인 영향을 완화하도록 안내할 수 있습니다. 연구원들은 이미지 캡션, 시각적 질문 답변(VQA), 교육적 표현 이해(REC)를 포함한 17개의 작업 벤치마크 세트에 대한 평가를 수행했습니다. 실험 결과 Jiutian은 13개 평가 세트에서 국제 선두 수준에 도달한 것으로 나타났습니다. 특히 InstructBLIP 및 Shikra와 비교하여 Jiutian은 각각 이미지 수준 이해 작업과 지역 수준 위치 지정 작업에서 포괄적이고 일관된 성능 향상을 달성했으며 VSR(시각적 공간 추론) 작업에서 최대 5% 향상을 달성할 수 있습니다. 그림 5에서 볼 수 있듯이 다양한 시각적 언어 다중 모달 작업에서 Jiutian과 다른 MLLM의 기능에는 차이가 있습니다. 이는 Jiutian이 세밀한 시각적 이해 및 시각적 공간 추론 기능에서 더 나은 성능을 발휘하며 다음을 수행할 수 있음을 나타냅니다. 덜 환각적인 텍스트 응답으로 출력하려면 다시 작성된 내용은 다음과 같습니다. 다섯 번째 그림은 Jiutian Large Model, InstructBLIP 및 Shikra 의 기능 차이에 대한 정성 분석을 보여줍니다.그림 6 샘플 분석 , Jiutian 모델은 이미지 수준과 지역 수준의 시각 언어 작업 모두에서 뛰어난 이해 및 인식 능력을 가지고 있음을 보여줍니다. 여섯 번째 사진: 더 많은 예시 분석을 통해 이미지 관점과 지역 수준의 시각적 이해 측면에서 Jiutian 대형 모델의 역량을 입증합니다 (1) 이 작업은 새로운 다중 모드 대형 언어 모델을 제안합니다 - Jiutian: 이중 계층 시각적 지식으로 강화된 다중 모드 대형 언어 모델입니다. (2) 이 작품은 이미지 설명, 시각적 질문 답변, 수업 표현 이해 등 17개의 시각적 언어 작업 벤치마크 세트에서 평가되었으며, 그 중 13개의 평가 세트가 현재 최고 성능을 달성했습니다. (3) 본 연구에서는 이미지 수준의 이해와 지역 수준의 현지화 작업 간의 내부 갈등을 해결하고 두 작업 간의 상호 개선을 달성하기 위한 세분화된 지시 미세 조정 전략을 제안합니다 (4) 이 작업은 이미지 수준 이해와 지역 수준 포지셔닝 작업을 성공적으로 통합하여 여러 수준에서 시각적 장면을 포괄적으로 이해합니다. 미래에는 이 포괄적인 시각적 이해 기능을 구현된 지능형 장면에 적용하여 로봇이 더 효율적이고 지능적으로 수행할 수 있도록 지원할 수 있습니다. 효과적인 의사결정을 내리기 위해 현재 환경을 이해합니다.  형식)을 추가로 이해해야 합니다. . 위의 문제를 해결하기 위해 연구자들은 분할된 명령 미세 조정 전략과 라우팅 메커니즘을 갖춘 하이브리드 어댑터를 제안했습니다.

형식)을 추가로 이해해야 합니다. . 위의 문제를 해결하기 위해 연구자들은 분할된 명령 미세 조정 전략과 라우팅 메커니즘을 갖춘 하이브리드 어댑터를 제안했습니다.

실험 결과

요약

위 내용은 13개의 시각적 언어 과제를 완료하세요! Harbin Institute of Technology, 성능이 5% 향상된 다중 모드 대형 모델 'Jiutian' 출시의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7322

7322

9

9

1625

1625

14

14

1350

1350

46

46

1262

1262

25

25

1209

1209

29

29

2025 통화 서클의 상위 10 개 가상 통화 앱 교환의 최신 순위

Mar 27, 2025 pm 07:27 PM

2025 통화 서클의 상위 10 개 가상 통화 앱 교환의 최신 순위

Mar 27, 2025 pm 07:27 PM

2025 년 상위 10 개 가상 통화 거래 앱은 다음과 같습니다. 1. OKX, 2. BINANCE, 3. GATE.IO, 4. BYBIT, 5. KRAKEN, 6. KUCOIN, 7. BITGET, 8. HTX, 9. MEXC, 10. COINBASE. 이 순위는 보안, 유동성, 사용자 경험 및 기능 풍부함과 같은 포괄적 인 평가를 기반으로합니다.

2025 년 상위 10 개 디지털 가상 환전 앱 앱 요약

Mar 27, 2025 pm 07:18 PM

2025 년 상위 10 개 디지털 가상 환전 앱 앱 요약

Mar 27, 2025 pm 07:18 PM

2025 년 상위 10 개 디지털 가상 통화 거래 앱은 다음과 같습니다. 1. OKX, 2. BINANCE, 3. GATE.IO, 4. BYBIT, 5. KRAKEN, 6. KUCOIN, 7. BITGET, 8. HTX, 9. MEXC, 10. COINBASE. 이 순위는 보안, 유동성, 사용자 경험 및 기능 풍부함과 같은 포괄적 인 평가를 기반으로합니다.

Pi News를 출판하는 교환

Mar 28, 2025 pm 03:33 PM

Pi News를 출판하는 교환

Mar 28, 2025 pm 03:33 PM

PI Network는 아직 공식적으로 주류 거래소 거래를 시작하지 않았습니다. 2024 년 현재 PI는 여전히 주 네트워크를 폐쇄하는 단계에 있으며 중소 규모의 일부 교환 만 IOU 거래를 제공합니다. 공무원은 거래를 승인하지 않습니다. 공식 채널을 통해 채굴하고 주 네트워크가 준수 교환에서 열리고 거래 될 때까지 기다리는 것이 좋습니다.

Node.js 환경에서 403을 반환하는 타사 인터페이스 문제를 해결하는 방법은 무엇입니까?

Mar 31, 2025 pm 11:27 PM

Node.js 환경에서 403을 반환하는 타사 인터페이스 문제를 해결하는 방법은 무엇입니까?

Mar 31, 2025 pm 11:27 PM

Node.js 환경에서 403을 반환하는 타사 인터페이스의 문제를 해결하십시오. Node.js를 사용하여 타사 인터페이스를 호출 할 때 때때로 403을 반환하는 인터페이스에서 403의 오류가 발생합니다 ...

Top10 안전하고 사용하기 쉬운 가상 환전소 플랫폼

Mar 27, 2025 pm 07:06 PM

Top10 안전하고 사용하기 쉬운 가상 환전소 플랫폼

Mar 27, 2025 pm 07:06 PM

2025 년 상위 10 개 가상 통화 거래 앱은 다음과 같습니다. 1. OKX, 2. BINANCE, 3. GATE.IO, 4. BYBIT, 5. KRAKEN, 6. KUCOIN, 7. BITGET, 8. HTX, 9. MEXC, 10. COINBASE. 이 순위는 보안, 유동성, 사용자 경험 및 기능 풍부함과 같은 포괄적 인 평가를 기반으로합니다.

어떤 교환이 Heco를 지원합니다

Mar 28, 2025 pm 03:36 PM

어떤 교환이 Heco를 지원합니다

Mar 28, 2025 pm 03:36 PM

2024 년 현재 Heco Chain 또는 Heco Tokens를 여전히 지원하는 주요 거래소 : 1. HTX (이전 Huobi Huobi)는 공식적으로 HECO 체인 USDT 및 토큰 거래를 지원합니다. 2. Heco Dex를 기반으로 한 Mdex는 Heco 체인 토큰 거래를 지원합니다. 3. Gate.io, 일부 HECO 체인 토큰의 보충 및 철수를 지원합니다. 4. Kucoin, 일부 Heco 체인 토큰은 여전히 거래 될 수 있습니다. 5. 팬케이크 웨이 및 Uniswap과 같은 분산 된 거래소는 거래를 교차 거래하고 HECO 체인의 낮은 유동성 및 프로젝트 마이그레이션에주의를 기울여야합니다.

Laravel에서는 이메일로 확인 코드를 보내지 못하는 상황을 처리하는 방법은 무엇입니까?

Mar 31, 2025 pm 11:48 PM

Laravel에서는 이메일로 확인 코드를 보내지 못하는 상황을 처리하는 방법은 무엇입니까?

Mar 31, 2025 pm 11:48 PM

Laravel의 이메일을 처리하지 않는 방법은 LaRavel을 사용하는 것입니다.

시스템 재시작 후 UnixSocket의 권한을 자동으로 설정하는 방법은 무엇입니까?

Mar 31, 2025 pm 11:54 PM

시스템 재시작 후 UnixSocket의 권한을 자동으로 설정하는 방법은 무엇입니까?

Mar 31, 2025 pm 11:54 PM

시스템이 다시 시작된 후 UnixSocket의 권한을 자동으로 설정하는 방법. 시스템이 다시 시작될 때마다 UnixSocket의 권한을 수정하려면 다음 명령을 실행해야합니다.