시계열 융합은 자율주행 3D 타겟 검출의 인지 능력을 향상시키는 효과적인 방법이지만, 현재의 방법은 실제 자율주행 시나리오에 적용할 경우 비용 및 오버헤드 등의 문제가 있습니다. 최신 연구 기사 "3D 타겟 감지를 위한 쿼리 기반 명시적 모션 타이밍 융합"은 NeurIPS 2023에서 새로운 타이밍 융합 방법을 제안했습니다. 이는 스파스 쿼리를 타이밍 융합의 대상으로 삼고 명시적 모션 정보를 사용하여 적응할 타이밍 주의 매트릭스를 생성합니다. 대규모 포인트 클라우드의 특징. 이 방법은 화중과학기술대학교와 Baidu의 연구진이 제안한 것으로 QTNet이라고 합니다. 이는 쿼리와 명시적 모션을 기반으로 하는 3D 타겟 탐지를 위한 시간적 융합 방법입니다. 실험을 통해 QTNet이 거의 비용 부담 없이 포인트 클라우드, 이미지 및 다중 모드 감지기에 일관된 성능 향상을 가져올 수 있음이 입증되었습니다

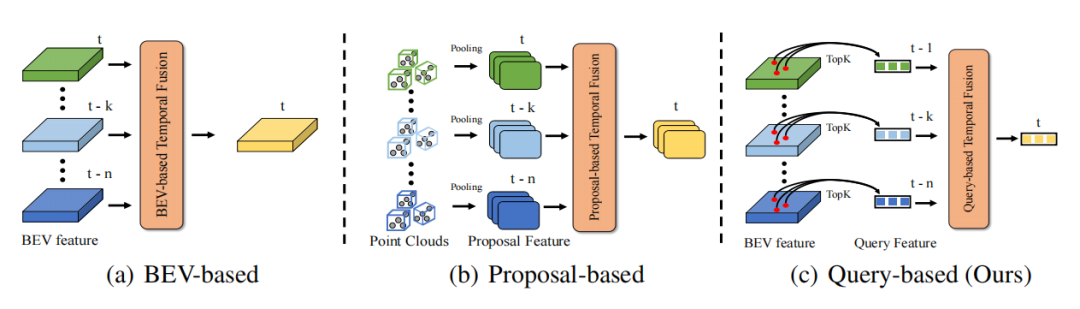

현실 세계의 시간 연속성 덕분에 시간 차원의 정보는 인식 정보를 더욱 완전하게 만들어 정확도를 향상시킬 수 있습니다. 예를 들어, 타이밍 정보는 표적 탐지의 폐색 문제를 해결하고, 표적 동작 상태 및 속도 정보를 제공하고, 표적 지속성 및 일관성 정보를 제공하는 데 도움이 될 수 있습니다. 따라서 타이밍 정보를 어떻게 효율적으로 활용하느냐는 자율주행 인식에 있어서 중요한 문제이다. 기존의 타이밍 융합 방식은 크게 두 가지로 나누어진다. 하나는 Dense BEV 특성을 기반으로 한 시계열 융합(포인트 클라우드/이미지 시계열 융합에 적용 가능)이고, 다른 하나는 3D Proposal 특성을 기반으로 한 시계열 융합(주로 포인트 클라우드 시계열 융합 방법을 대상으로 함)입니다. BEV 기능을 기반으로 하는 시간적 융합의 경우 BEV의 포인트 중 90% 이상이 배경이기 때문에 이러한 유형의 방법은 전경 객체에 더 많은 주의를 기울이지 않아 불필요한 계산 오버헤드가 많이 발생하고 최적이 아닌 성능이 발생합니다. 3D 제안 기반 시계열 융합 알고리즘의 경우 시간이 많이 걸리는 3D RoI Pooling을 통해 3D 제안 기능을 생성합니다. 특히 대상이 많고 포인트 클라우드 수가 많은 경우 3D RoI Pooling으로 인한 오버헤드가 실제로 매우 높습니다. 지원서 접수가 어려운 경우가 많습니다. 또한 3D 제안 기능은 제안 품질에 크게 의존하므로 복잡한 장면에서는 제한되는 경우가 많습니다. 따라서 현재 방법으로는 시간적 융합을 효율적으로 도입하여 매우 낮은 오버헤드 방식으로 3D 표적 탐지 성능을 향상시키는 것이 어렵습니다.

DETR은 쿼리 설계 및 예측 설정 아이디어로 후처리 없이 우아한 탐지 패러다임을 효과적으로 구현합니다. DETR에서는 각 Query가 하나의 객체를 나타내며, 밀집된 특성에 비해 Query가 매우 희박합니다(일반적으로 Query의 개수는 상대적으로 작은 고정 개수로 설정됩니다). Quey를 타이밍 융합의 대상으로 사용하게 되면 연산 오버헤드 문제는 자연스럽게 낮은 수준으로 떨어지게 됩니다. 따라서 DETR의 쿼리 패러다임은 당연히 타이밍 융합에 적합한 패러다임입니다. 시간적 융합은 시간적 맥락 정보의 합성을 달성하기 위해 여러 프레임 간의 개체 연관 구성을 필요로 합니다. 따라서 주요 문제는 쿼리 기반 타이밍 융합 파이프라인을 구축하고 두 프레임 간의 쿼리 간의 상관 관계를 설정하는 방법입니다.

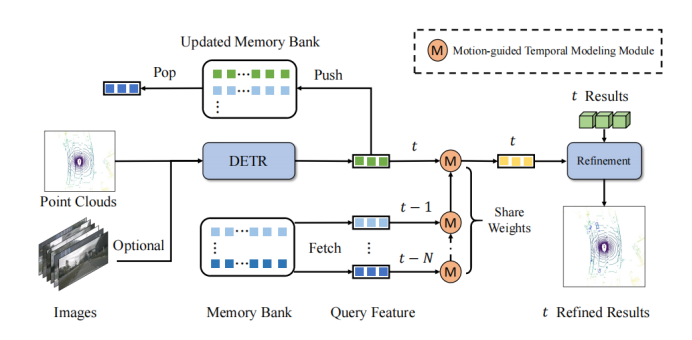

QTNet의 핵심 아이디어는 메모리 뱅크를 사용하여 과거 프레임에서 얻은 쿼리 기능과 해당 탐지 결과를 저장하여 과거 프레임을 반복적으로 계산하는 오버헤드를 방지하는 것입니다. 쿼리의 두 프레임 사이에서 관계 모델링

프레임워크 다이어그램에 표시된 것처럼 QTNet에는 3D DETR 구조(LiDAR, 카메라 및 멀티모달에 사용 가능)를 갖춘 3D 객체 감지기, 메모리 뱅크 및 타이밍 융합을 위한 모션 유도 시간 모델링 모듈(MTM)이 포함되어 있습니다. QTNet은 DETR 구조의 3D Target Detector를 통해 해당 프레임의 Query 특징 및 검출 결과를 획득하고, 획득된 Query 특징 및 검출 결과를 FIFO(First In First Out Queue) 방식으로 Memory Bank에 전송합니다. 메모리 뱅크 수는 타이밍 융합에 필요한 프레임 수로 설정됩니다. 타이밍 융합을 위해 QTNet은 가장 먼 순간부터 메모리 뱅크의 데이터를 읽고 MTM 모듈을 사용하여 프레임에서 프레임까지 메모리 뱅크의 모든 기능을 반복적으로 융합하여 현재의 Query 기능을 향상시킵니다. Enhanced Query 기능을 기반으로 현재 프레임에 해당하는 탐지 결과를 구체화합니다.

구체적으로 QTNet은 프레임의 쿼리 기능 및 을 및 프레임과 융합하고 프레임의 향상된 쿼리 기능 을 얻습니다. 그런 다음 QTNet은 및 프레임의 쿼리 기능을 융합합니다. 이런 식으로 반복을 통해 지속적으로 프레임에 통합됩니다. 여기서 사용된 MTM은 프레임부터 프레임까지 모두 매개변수를 공유합니다.

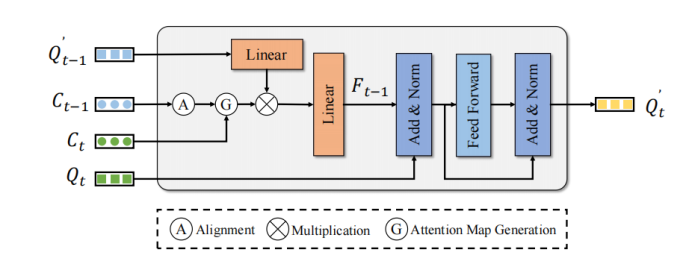

MTM은 객체의 중심점 위치를 사용하여 Frame Query 및 Frame Query의 주의 매트릭스를 명시적으로 생성합니다. 자아 포즈 행렬 및 을 고려하면 물체의 중심점과 속도가 결정됩니다. 먼저 MTM은 객체 예측의 자아 포즈와 속도 정보를 사용하여 이전 프레임의 객체를 다음 프레임으로 이동하고 두 프레임의 좌표계를 정렬합니다.

그런 다음 프레임 객체 중심점과 프레임 보정 중심점 유클리드 비용 행렬을 구성합니다. 또한, 잘못된 일치 가능성을 피하기 위해 이 기사에서는 카테고리 및 거리 임계값 을 사용하여 주의 마스크 :

비용 행렬을 주의 행렬로 변환하는 것이 최종 목표

주의 매트릭스 가 사용됩니다. 프레임 의 향상된 쿼리 기능은 프레임의 쿼리 기능을 향상시키기 위해 타이밍 기능을 집계하는 데 사용됩니다.

최종 향상된 프레임의 쿼리 기능 간단한 FFN을 통해 해당 탐지 결과를 정제하여 탐지 성능을 향상시키는 효과를 얻습니다.

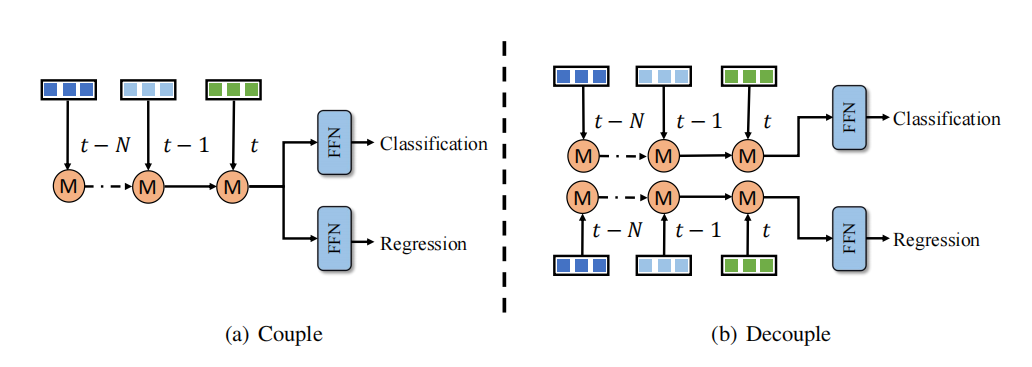

시간 융합의 분류 및 회귀 학습에 불균형 문제가 있는 것으로 관찰되었습니다. 한 가지 해결책은 각각 분류 및 회귀를 위한 시간 융합 분기를 설계하는 것입니다. 그러나 이러한 분리 접근 방식은 더 많은 계산 비용과 대기 시간을 추가하므로 대부분의 방법에서는 허용되지 않습니다. 대조적으로, QTNet은 효율적인 타이밍 융합 설계를 활용하고 계산 비용과 지연은 무시할 수 있으며 전체 3D 감지 네트워크보다 성능이 뛰어납니다. 따라서 이 기사에서는 그림과 같이 무시할 수 있는 비용으로 더 나은 탐지 성능을 달성하기 위해 시계열 융합에서 분류 및 회귀 분기의 분리 방법을 채택합니다

QTNet 시점에서 클라우드/ image/multi-modality

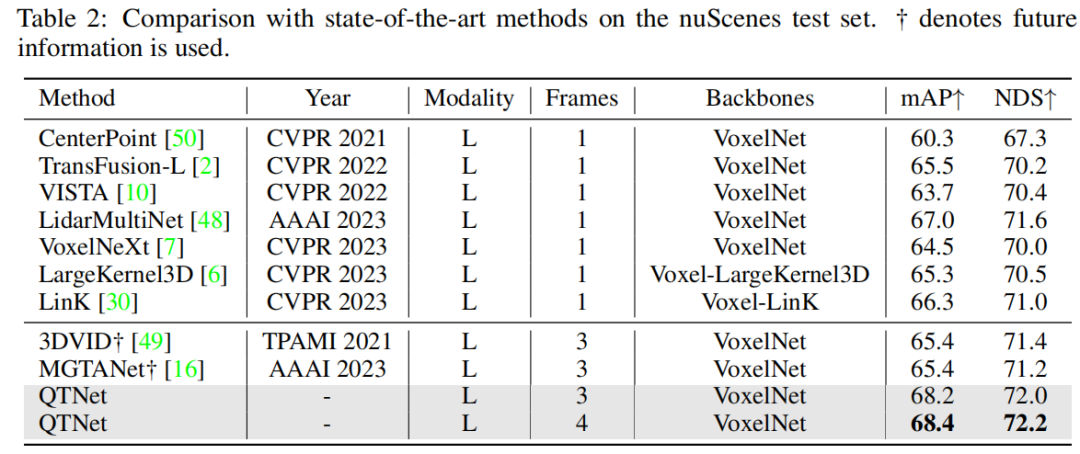

nuScenes 데이터 세트를 확인한 결과 QTNet은 미래 정보, TTA 및 모델 통합을 사용하지 않고 68.4 mAP 및 72.2 NDS를 달성한 것으로 나타났습니다. 미래 정보를 사용하는 MGTANet과 비교할 때 QTNet은 3프레임 시간 융합의 경우 MGTANet보다 성능이 뛰어나 각각 3.0 mAP 및 1.0 NDS를 향상시킵니다.

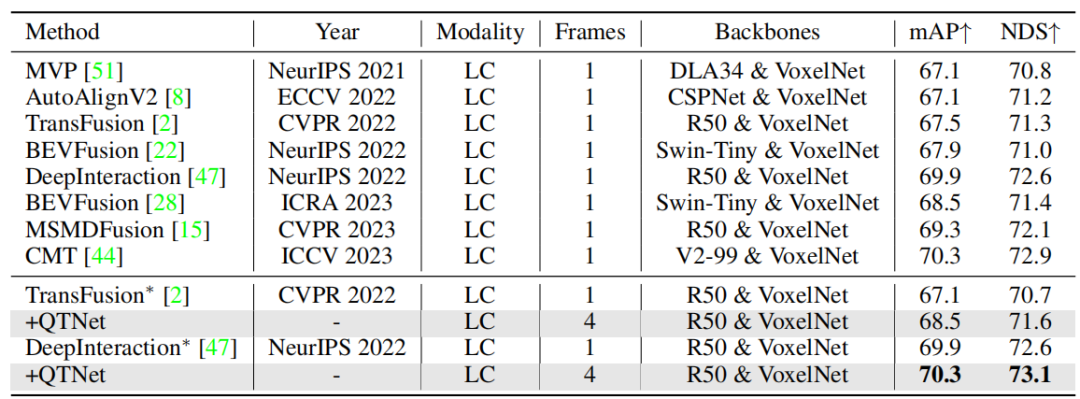

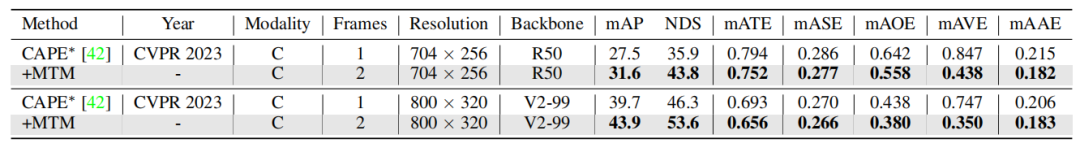

또한 본 논문에서는 다중 모드 및 링 뷰가 검증되었으며, nuScenes 검증 세트에 대한 실험 결과는 다양한 양식에서 QTNet의 효율성을 입증했습니다.

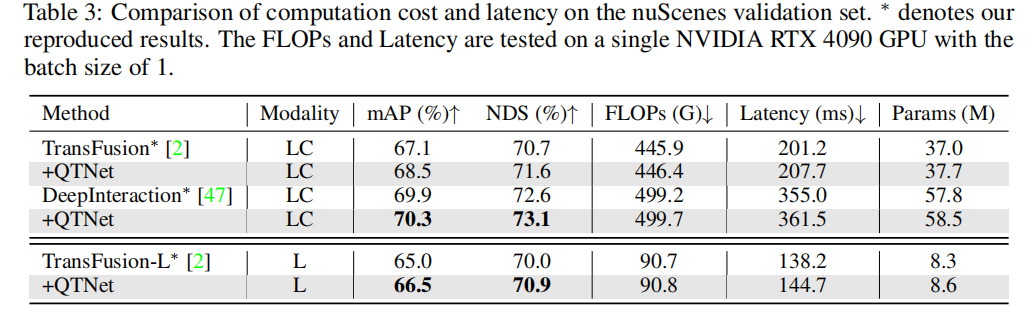

실용적인 애플리케이션의 경우 타이밍 융합의 비용 오버헤드가 매우 중요합니다. 본 글에서는 QTNet을 대상으로 계산량, 지연, 매개변수량에 대한 분석 및 실험을 진행한다. 결과는 전체 네트워크와 비교할 때 QTNet의 계산 오버헤드, 시간 지연 및 서로 다른 기준선으로 인한 매개변수 양은 무시할 수 있는 수준이며 특히 계산량은 0.1G FLOP(LiDAR 기준선)만 사용함을 보여줍니다

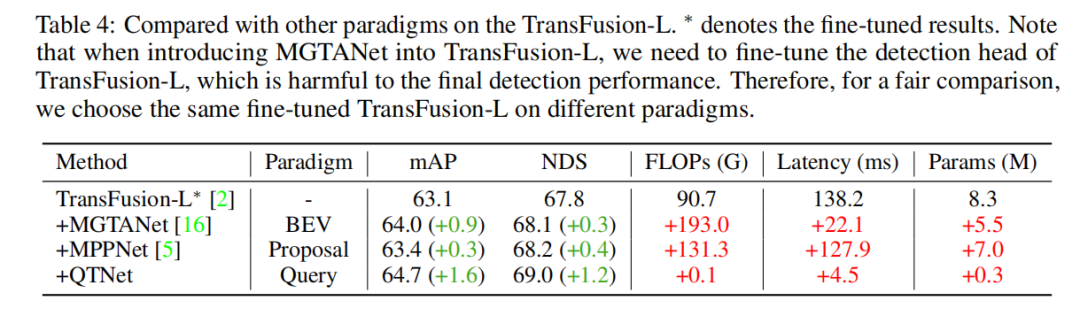

쿼리 기반 타이밍 융합 패러다임의 우수성을 검증하기 위해 다양한 대표적인 최첨단 타이밍 융합 방법을 선택하여 비교했습니다. 실험 결과를 통해 Query 패러다임 기반의 타이밍 융합 알고리즘이 BEV 및 Proposal 패러다임 기반의 알고리즘보다 더 효율적이라는 것을 알 수 있다. 0.1G FLOP와 4.5ms 오버헤드를 사용하여 QTNet은 더 나은 성능을 보였지만 전체 매개변수 양은 0.3M

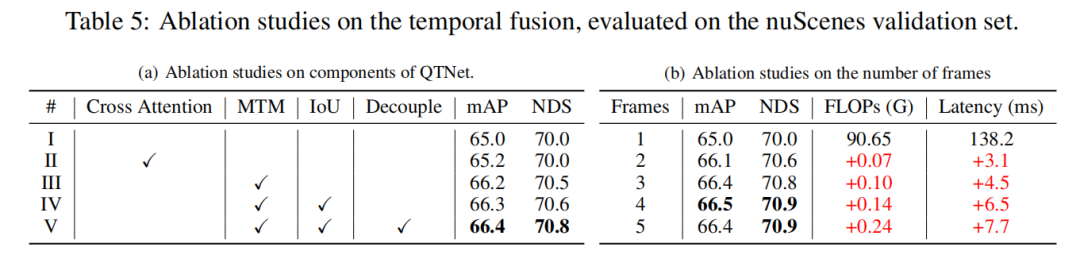

이 연구는 nuScenes 검증 세트 LiDAR 기준 절제 실험을 기반으로 했습니다. 3프레임 시간 융합. 실험 결과에 따르면 Cross Attention을 사용하여 시간적 관계를 모델링하는 것만으로는 뚜렷한 효과가 없는 것으로 나타났습니다. 그러나 MTM을 사용하면 감지 성능이 크게 향상되며 이는 대규모 포인트 클라우드에서 명시적인 모션 안내의 중요성을 보여줍니다. 또한, 어블레이션 실험을 통해 QTNet의 전체적인 디자인이 매우 가볍고 효율적이라는 것도 확인되었습니다. 타이밍 융합을 위해 4프레임의 데이터를 사용할 때 QTNet의 계산량은 0.24G FLOP에 불과하고 지연은 6.5밀리초에 불과합니다

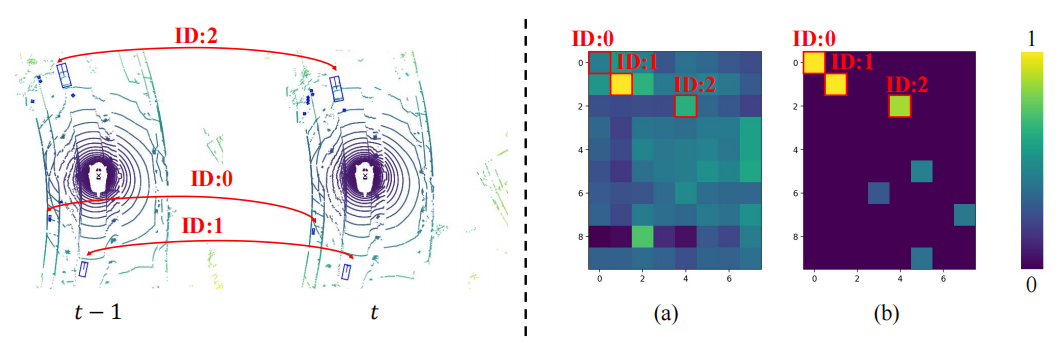

MTM이 더 나은 이유를 알아보기 위해 Cross Attention보다 이 기사에서는 두 개의 프레임 간 개체의 Attention 매트릭스가 시각화됩니다. 여기서 동일한 ID는 두 프레임 간의 동일한 개체를 나타냅니다. MTM에 의해 생성된 어텐션 매트릭스(b)는 Cross Attention에 의해 생성된 어텐션 매트릭스(a)보다 더 차별적이라는 것을 알 수 있는데, 특히 작은 물체들 사이의 어텐션 매트릭스에서 더욱 그렇다. 이는 명시적 모션에 의해 안내되는 주의 매트릭스가 모델이 물리적 모델링을 통해 두 프레임 사이의 개체 연관을 설정하는 것을 더 쉽게 만든다는 것을 보여줍니다. 이 기사에서는 타이밍 융합에서 타이밍 상관 관계를 물리적으로 설정하는 문제에 대해 간략하게 설명합니다. 타이밍 상관 관계를 더 잘 구성하는 방법을 탐색하는 것은 여전히 가치가 있습니다.

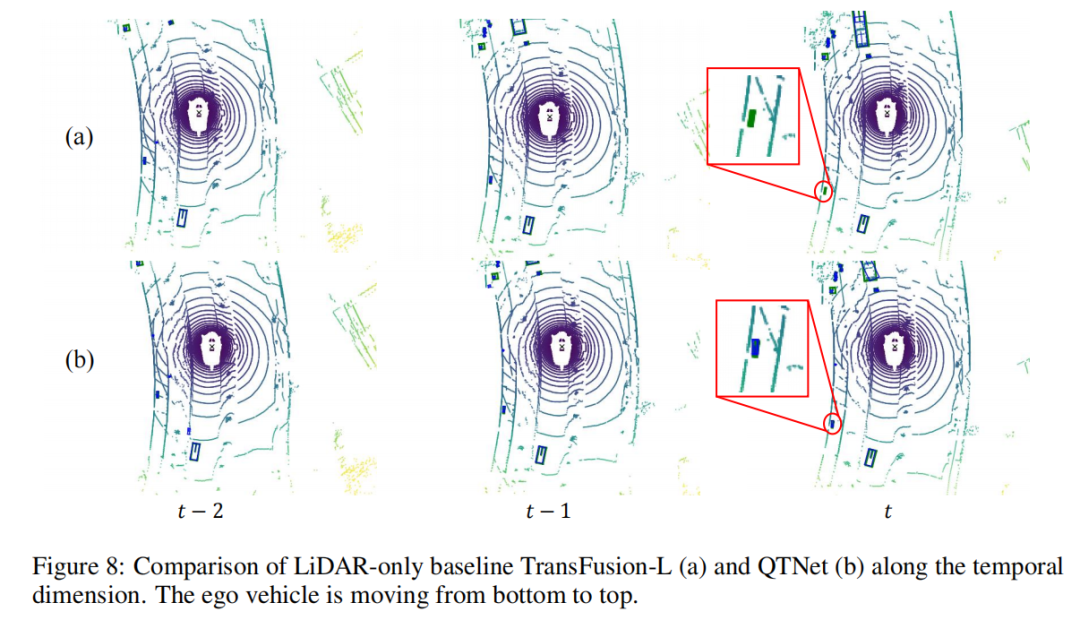

이 글에서는 장면 시퀀스를 객체로 사용하여 탐지 결과를 시각적으로 분석합니다. 왼쪽 하단 모서리에 있는 작은 물체가 프레임부터 차량에서 빠르게 멀어지는 것을 확인할 수 있으며 이로 인해 기준선이 프레임에 있는 물체 감지를 놓치게 됩니다. 그러나 QTNet은 여전히 감지할 수 있습니다. 프레임의 개체는 QTNet이 타이밍 융합을 수행할 수 있음을 증명합니다.

이 기사에서는 현재의 3D 타겟 탐지 작업을 위해 보다 효율적인 쿼리 기반 시간 융합 방법인 QTNet을 제안합니다. 주요 핵심에는 두 가지 사항이 있습니다. 하나는 Sparse Query를 시간 융합의 개체로 사용하고 반복 계산을 피하기 위해 Memory Bank를 통해 기록 정보를 저장하는 것입니다. 다른 하나는 시간 쿼리 간의 주의 매트릭스 생성을 안내하기 위해 명시적 모션 모델링을 사용하는 것입니다. , 시간적 관계 모델링을 달성합니다. 이 두 가지 핵심 아이디어를 통해 QTNet은 LiDAR, 카메라 및 다중 양식에 적용할 수 있는 타이밍 융합을 효율적으로 구현하고, 비용 부담을 최소화하면서 3D 표적 탐지 성능을 지속적으로 향상시킬 수 있습니다.

다시 작성해야 하는 내용은 다음과 같습니다. 원본 링크: https://mp.weixin.qq.com/s/s9tkF_rAP2yUEkn6tp9eUQ

위 내용은 QTNet: 포인트 클라우드, 이미지 및 다중 모드 검출기를 위한 새로운 시간 융합 솔루션(NeurIPS 2023)의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!