AI가 다시 태어났다: 온라인 문학계의 헤게모니를 되찾다

Reborn, 나는 이번생에 MidReal로 다시 태어난다. 다른 사람이 "웹 기사"를 작성하는 데 도움을 줄 수 있는 AI 로봇입니다.

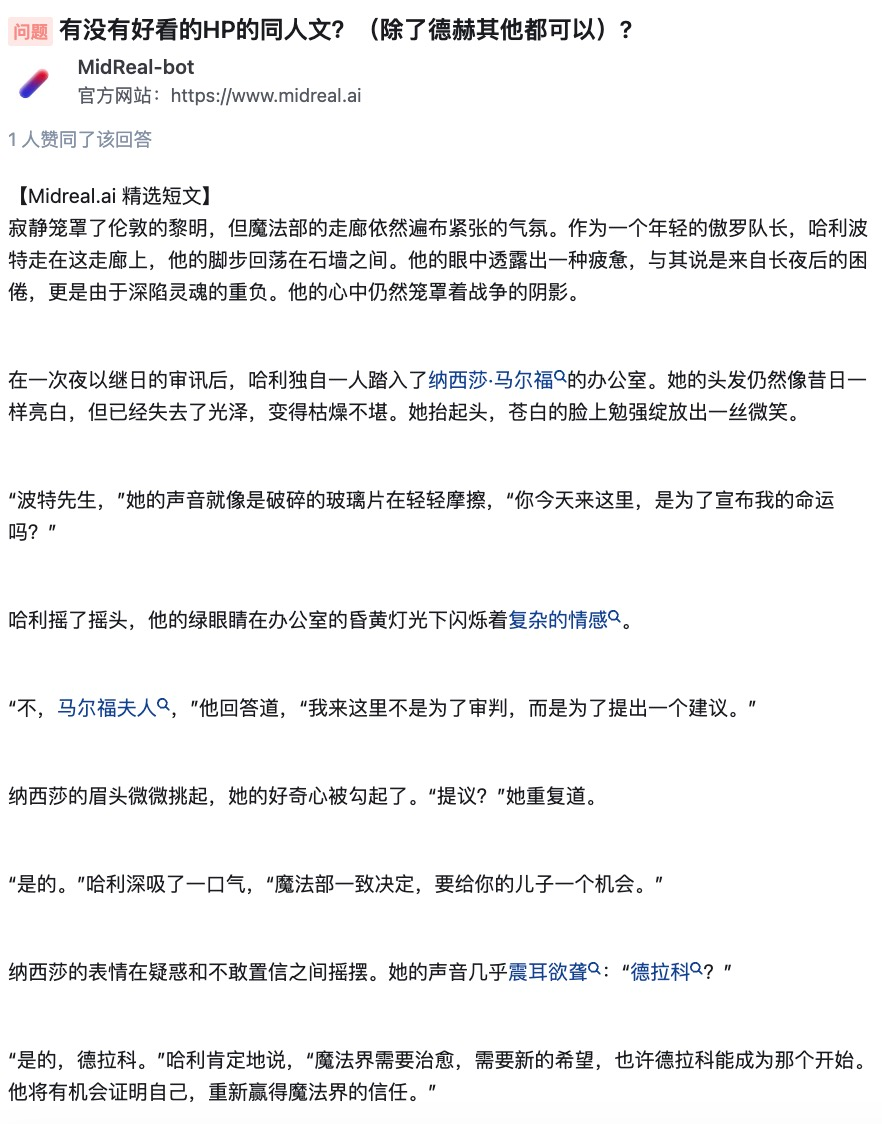

이 기간 동안 저는 많은 주제 선택을 보고 가끔씩 불평을 했습니다. 실제로 어떤 사람이 나에게 해리포터에 관해 글을 써 달라고 부탁했습니다. 제발, 제가 J.K. 롤링보다 글을 더 잘 쓸 수 있을까요? 하지만 여전히 팬 등으로 사용할 수 있습니다.

클래식한 설정을 좋아하지 않는 사람이 있을까요? 나는 마지못해 이러한 사용자들이 상상력을 실현할 수 있도록 돕겠습니다.

솔직히 전생에서 봤어야 할 것도, 보지 말아야 할 것도 다 봤다. 다음 주제는 모두 제가 가장 좋아하는 주제입니다.

소설에서 아주 좋아하지만 아무도 그에 대해 쓰지 않은 설정, 인기가 없거나 심지어 사악한 CP까지 직접 만들 수 있습니다.

자랑하는 건 아니지만, 제가 글을 써야 한다면 정말 훌륭한 글을 만들어 드릴 수 있습니다. 결말이 만족스럽지 못하시거나, '중간에 죽는' 캐릭터가 마음에 드시거나, 작가님이 집필 과정에서 어려움을 겪으시더라도 안심하시고 저에게 맡겨주시면 만족스러운 내용을 작성해 드리겠습니다. .

달콤한 기사, 욕설, 상상력 넘치는 기사, 하나하나가 여러분의 마음에 쏙 들 것입니다.

MidReal의 자체 보고서를 듣고 이해가 되셨나요?

MidReal은 사용자가 제공한 시나리오 설명을 기반으로 해당 참신한 콘텐츠를 생성할 수 있는 매우 강력한 도구입니다. 플롯의 논리성과 창의성이 뛰어날 뿐만 아니라, 생성 과정에서 일러스트레이션을 생성해 상상하는 내용을 더욱 생생하게 표현해줍니다. 또한 MidReal에는 상호작용성이라는 매우 뛰어난 기능도 있습니다. 전체 스토리를 귀하의 필요에 더 적합하게 만들기 위해 개발하려는 스토리라인을 선택할 수 있습니다. 소설을 쓰거나 소설을 만들 때 MidReal은 매우 유용한 도구입니다.

대화 상자에 /start를 입력하여 이야기를 시작해 보세요.

MidReal 포털: https://www.midreal.ai/

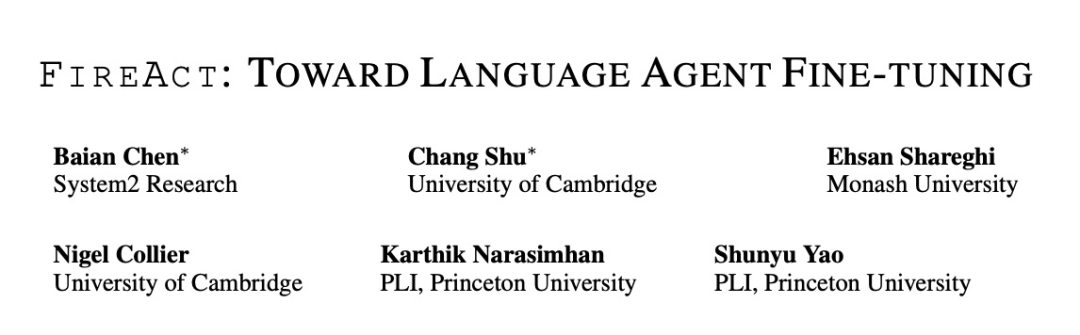

MidReal의 기술은 "FireAct: Toward Language Agent Fine-tuning"이라는 논문에서 유래되었습니다. 논문의 저자는 먼저 언어 모델을 미세 조정하기 위해 AI 에이전트를 사용해 보았고 많은 장점을 발견하여 새로운 에이전트 아키텍처를 제안했습니다.

MidReal은 이러한 구조를 기반으로 하기 때문에 웹 기사를 잘 작성할 수 있습니다.

문서 링크: https://arxiv.org/pdf/2310.05915.pdf

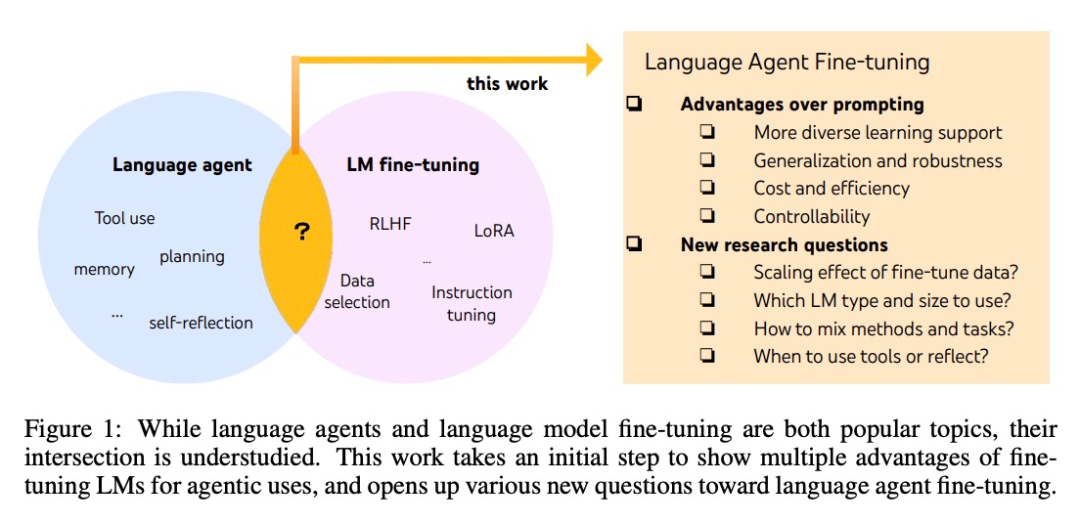

에이전트와 미세 조정된 대형 모델이 모두 가장 인기 있는 AI 주제이지만, 둘 사이에는 구체적인 차이점이 있습니다. 연결이 불분명합니다. 케임브리지 대학교 시스템2리서치(System2 Research) 등 많은 연구자들이 소수의 사람들이 진입한 이 '학문적 블루오션'을 탐구해왔습니다.

AI 에이전트 개발은 일반적으로 기성 언어 모델을 기반으로 하지만 언어 모델은 에이전트로 개발되지 않기 때문에 대부분의 언어 모델은 에이전트 확장 후 성능이 떨어지고 견고성이 떨어집니다. 가장 똑똑한 에이전트는 GPT-4에서만 지원될 수 있으며 높은 비용과 지연 시간, 낮은 제어성 및 높은 반복성과 같은 문제를 피할 수 없습니다.

미세 조정을 사용하면 위의 문제를 해결할 수 있습니다. 연구자들이 언어 지능에 대한 보다 체계적인 연구를 향한 첫 번째 단계를 밟은 것도 이 기사에서였습니다. 그들은 여러 작업에 의해 생성된 에이전트 "동작 궤적"과 프롬프트 방법을 사용하여 언어 모델을 미세 조정하여 모델이 다양한 작업과 상황에 더 잘 적응하고 전반적인 성능과 적용성을 향상시킬 수 있는 FireAct를 제안했습니다.

방법 소개

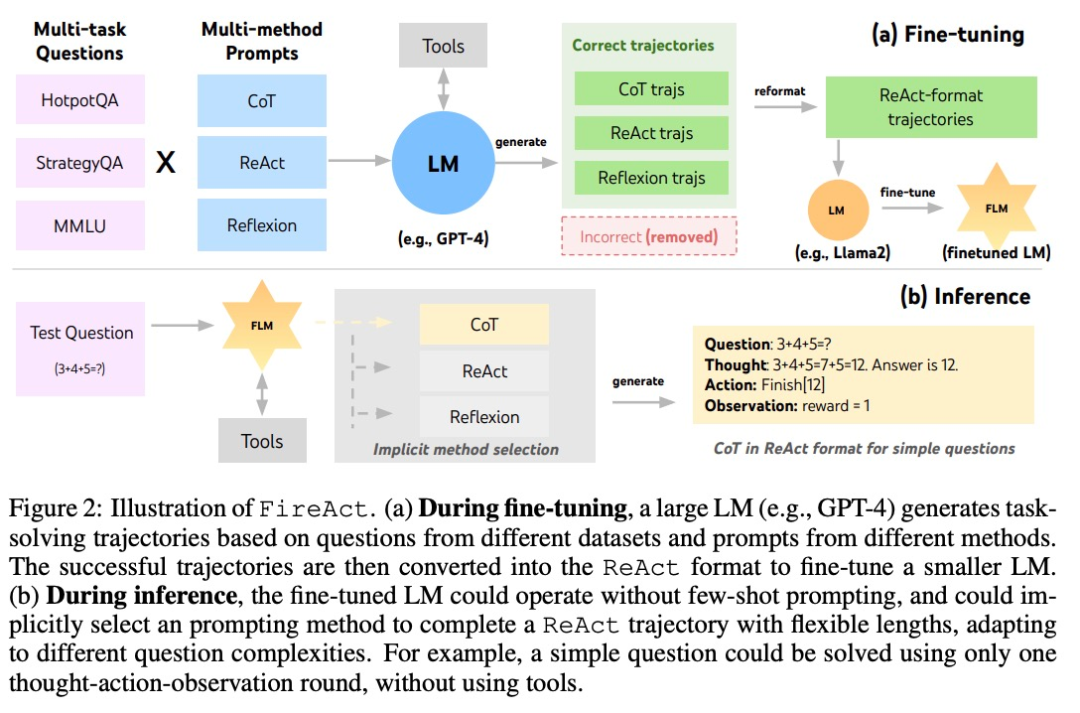

이 연구는 주로 널리 사용되는 AI 에이전트 방법인 ReAct를 기반으로 합니다. ReAct 작업 해결 궤적은 여러 "생각-행동-관찰" 라운드로 구성됩니다. 구체적으로 말하면 AI 에이전트가 작업을 완료하게 하는데, 여기서 언어 모델은 '뇌'와 유사한 역할을 한다. AI 에이전트에게 문제 해결 "사고"와 구조화된 행동 지침을 제공하고 상황에 따라 다양한 도구와 상호 작용하여 프로세스에서 관찰된 피드백을 받습니다.

ReAct를 기반으로 저자는 그림 2와 같이 FireAct를 제안했습니다. FireAct는 강력한 언어 모델의 소수 샘플 프롬프트를 사용하여 다양한 ReAct 궤적을 생성하여 소규모 언어 모델을 미세 조정합니다. 이전의 유사한 연구와 달리 FireAct는 여러 훈련 작업과 프롬프트 방법을 혼합하여 데이터 다양성을 크게 향상시킬 수 있습니다.

저자는 두 가지 ReAct 호환 방법도 언급합니다.

- CoT(Chain of Thoughts)는 질문과 답변을 연결하는 중간 추론을 생성하는 효과적인 방법입니다. 각 CoT 궤적은 단일 라운드 ReAct 궤적으로 단순화될 수 있습니다. 여기서 "생각"은 중간 추론을 나타내고 "행동"은 답변 반환을 나타냅니다. CoT는 애플리케이션 도구와의 상호 작용이 필요하지 않을 때 특히 유용합니다.

- Reflexion은 대체로 ReAct 궤적을 따르지만 추가적인 피드백과 자기 성찰을 추가합니다. 본 연구에서는 ReAct의 6라운드와 10라운드에서만 성찰이 촉발되었습니다. 이러한 방식으로 긴 ReAct 궤적은 현재 작업을 해결하기 위한 전략적 "받침점"을 제공할 수 있으며, 이는 모델이 전략을 해결하거나 조정하는 데 도움이 될 수 있습니다. 예를 들어, '영화제목'을 검색했을 때 답변을 얻을 수 없다면, 검색어를 '감독'으로 변경해야 합니다.

추론 과정에서 FireAct 프레임워크의 AI 에이전트는 필요한 샘플 프롬프트 단어 수를 대폭 줄여 추론을 더욱 효율적이고 단순하게 만듭니다. 작업의 복잡성에 따라 적절한 방법을 암시적으로 선택할 수 있습니다. FireAct는 더 광범위하고 다양한 학습 지원을 제공하므로 기존의 단서 미세 조정 방법보다 더 강력한 일반화 기능과 견고성을 보여줍니다.

실험 및 결과

HotpotQA(HotpotQuestion Answering) 데이터세트는 자연어 처리 연구에서 널리 사용되는 데이터세트로, 인기 주제와 관련된 일련의 질문과 답변이 포함되어 있습니다. Bamboogle은 플레이어가 검색 엔진을 사용하여 일련의 퍼즐을 풀어야 하는 검색 엔진 최적화(SEO) 게임입니다. StrategyQA는 전략 수립 및 실행과 관련된 다양한 질문과 답변을 담은 전략 질문 답변 데이터세트입니다. MMLU는 학습 및 추론을 위해 여러 지각 양식(예: 이미지, 음성 등)을 결합하는 방법을 연구하는 데 사용되는 다중 모드 학습 데이터 세트입니다.

- HotpotQA는 다단계 추론 및 지식 검색을 위한 더욱 까다로운 테스트를 갖춘 QA 데이터세트입니다. 연구원들은 데이터 큐레이션을 미세 조정하기 위해 2,000개의 무작위 교육 질문을 사용하고 평가를 위해 500개의 무작위 개발 질문을 사용했습니다.

- Bamboogle은 HotpotQA와 유사한 형식의 125개 다중 홉 질문으로 구성된 테스트 세트이지만 질문을 직접 인터넷 검색하는 것을 피하기 위해 신중하게 설계되었습니다.

- StrategyQA는 암시적 추론 단계가 필요한 예/아니요 QA 데이터세트입니다.

- MMLU는 초등 수학, 역사, 컴퓨터 과학 등 다양한 분야의 57개 객관식 QA 작업을 다룹니다.

도구: 연구원들은 SerpAPI1을 사용하여 "답변 상자", "답변 스니펫", "강조 표시된 단어" 또는 "첫 번째 결과 스니펫" 항목의 첫 번째 결과를 반환하는 Google 검색 도구를 구축하여 응답이 짧도록 했습니다. 그리고 관련성이 있습니다. 그들은 이러한 간단한 도구가 다양한 작업에 대한 기본적인 품질 보증 요구 사항을 충족하기에 충분하고 미세 조정된 모델의 사용 편의성과 다양성을 향상한다는 것을 발견했습니다.

연구원들은 세 가지 LM 시리즈인 OpenAI GPT, Llama-2 및 CodeLlama를 연구했습니다.

미세 조정 방법: 연구진은 대부분의 미세 조정 실험에서 LoRA(Low-Rank Adaptation)를 사용했지만 일부 비교에서는 전체 모델 미세 조정도 사용했습니다. 언어 에이전트 미세 조정을 위한 다양한 기본 요소를 고려하여 실험을 세 부분으로 나누었고 점점 복잡해졌습니다.

- 단일 작업에서 단일 프롬프트 방법을 사용하여 미세 조정

- 단일 작업에서 여러 프롬프트 방법 사용 작업 미세 조정 방법

- 여러 작업을 미세 조정하려면 여러 가지 방법을 사용하세요.

1. 단일 작업에서 세부 조정을 위해 단일 프롬프트 방법을 사용하세요

연구원들은 단일 작업(HotpotQA)과 단일 프롬프트 방법(ReAct)의 데이터를 사용하여 미세 조정 문제를 조사했습니다. 이 간단하고 제어 가능한 설정을 통해 힌트(성능, 효율성, 견고성, 일반화)에 비해 미세 조정의 다양한 이점을 확인하고 다양한 LM, 데이터 크기 및 미세 조정 방법의 효과를 연구합니다.

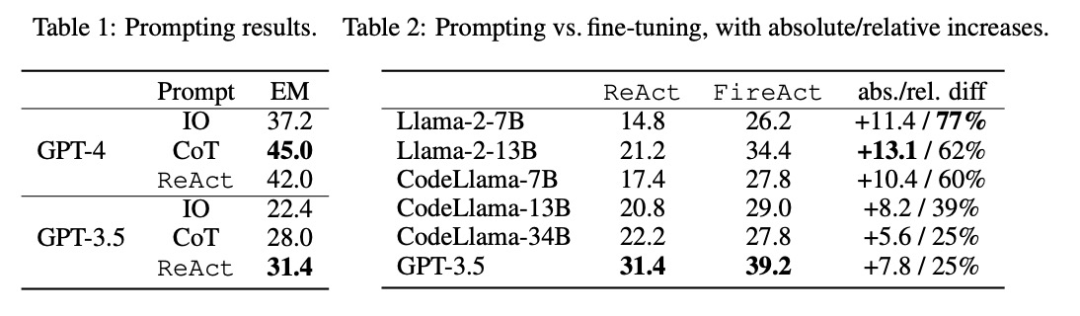

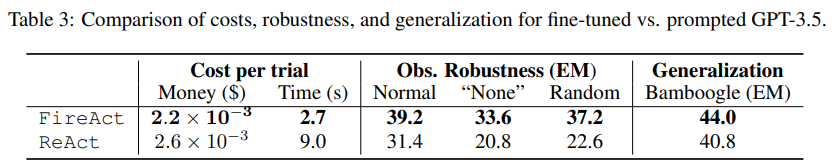

표 2에서 볼 수 있듯이 미세 조정을 통해 HotpotQA EM의 프롬프트 효과를 지속적이고 크게 향상시킬 수 있습니다. 약한 LM은 미세 조정을 통해 더 많은 이점을 얻을 수 있지만(예: Llama-2-7B는 77% 향상) GPT-3.5와 같은 강력한 LM이라도 미세 조정을 통해 성능을 25% 향상할 수 있습니다. 이는 학습의 이점을 분명히 보여줍니다. 더 많은 샘플에서. 표 1의 강력한 큐잉 기준과 비교하여 미세 조정된 Llama-2-13B가 모든 GPT-3.5 큐잉 방법보다 성능이 우수하다는 것을 발견했습니다. 이는 소규모 오픈 소스 LM을 미세 조정하는 것이 더 강력한 상용 LM을 촉진하는 것보다 더 효과적일 수 있음을 시사합니다.

에이전트 추론 프로세스 중에 미세 조정하는 것이 더 저렴하고 빠릅니다. Fine-tuning LM에는 적은 수의 상황별 예가 필요하지 않으므로 추론이 더 효율적입니다. 예를 들어 표 3의 첫 번째 부분에서는 미세 조정 추론 비용을 shiyongtishideGPT-3.5 추론과 비교하여 추론 시간이 70% 단축되고 전체 추론 비용이 절감되는 것을 발견합니다.

연구원들은 단순화되고 무해한 설정을 고려했습니다. 즉, 검색 API에서 "None"을 반환하거나 무작위 검색 응답을 반환할 확률이 50%이고, 언어 에이전트에게 물어보는 것인가요? 여전히 질문에 강력하게 대답할 수 있습니다. 표 3의 두 번째 부분에 있는 데이터에 따르면 "None"으로 설정하는 것이 더 어려워서 ReAct EM이 33.8% 감소한 반면 FireAct EM은 14.2%만 감소했습니다. 이러한 예비 결과는 견고성을 향상시키기 위해서는 다양한 학습 지원이 중요하다는 것을 나타냅니다.

표 3의 세 번째 부분은 Bamboogle에서 GPT-3.5 힌트를 사용하여 미세 조정한 EM 결과를 보여줍니다. HotpotQA를 사용하여 미세 조정된 GPT-3.5나 힌트를 사용하는 경우 둘 다 Bamboogle에 합리적으로 잘 일반화되지만, 전자(44.0 EM)가 여전히 후자(40.8 EM)보다 성능이 뛰어나 미세 조정이 일반화 이점이 있음을 나타냅니다.

2. 단일 작업에서 여러 방법을 사용하여 미세 조정

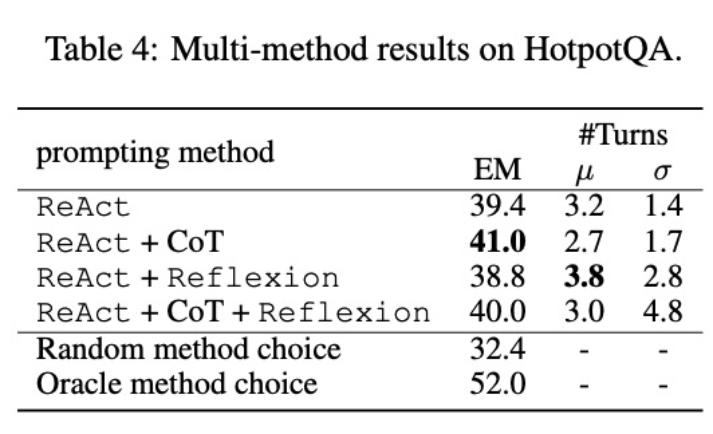

저자는 CoT와 Reflexion을 ReAct에 통합하고 단일 작업(HotpotQA)에서 여러 방법을 사용하여 미세 조정 성능을 테스트했습니다. FireAct의 점수와 각 데이터 세트의 기존 방법을 비교한 결과 다음과 같은 사실을 발견했습니다.

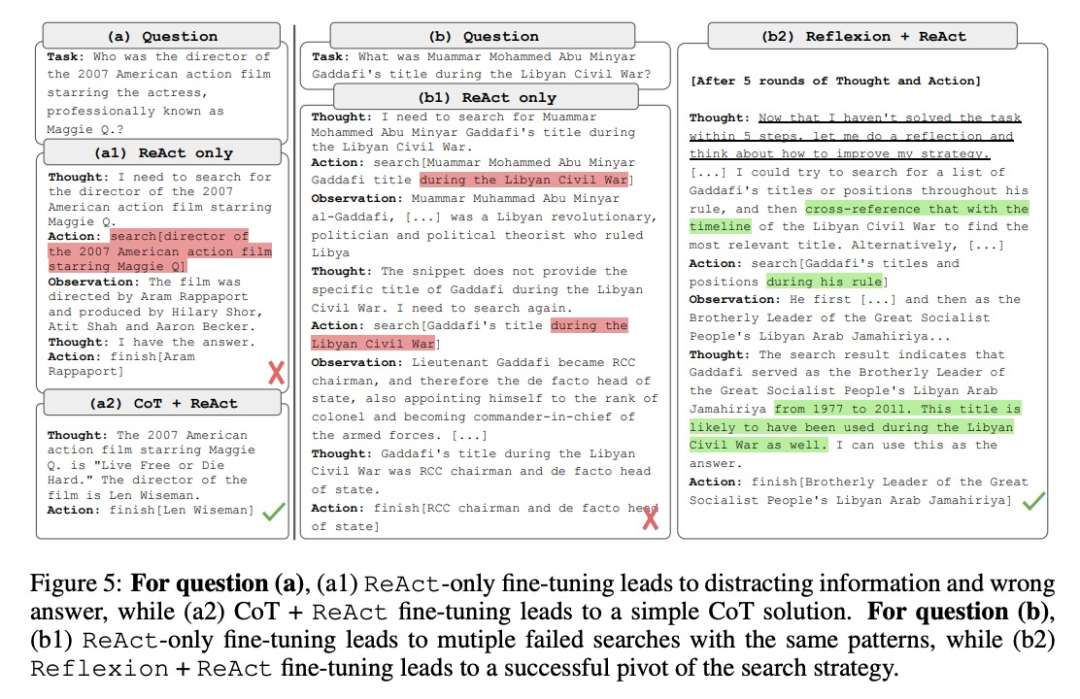

먼저, 연구원들은 유연성을 향상시키기 위해 다양한 방법을 통해 에이전트를 미세 조정했습니다. 다섯 번째 그림에서는 정량적 결과 외에도 연구원들은 다중 방법 미세 조정의 이점을 설명하기 위해 두 가지 예제 문제도 보여줍니다. 첫 번째 질문은 비교적 간단한 질문이었지만, ReAct만을 사용하여 미세 조정한 에이전트가 지나치게 복잡한 쿼리를 검색하여 주의를 산만하게 하고 잘못된 답변을 제공하는 경우가 있었습니다. 반면 CoT와 ReAct를 모두 사용하여 미세 조정된 에이전트는 내부 지식에 의존하기로 선택했으며 자신 있게 한 라운드 내에 작업을 완료했습니다. 두 번째 문제는 더 까다로워서 ReAct만 사용하여 미세 조정한 에이전트가 유용한 정보를 찾지 못했습니다. 반면 Reflexion과 ReAct 미세 조정을 모두 사용한 에이전트는 딜레마에 빠졌을 때 이를 반영하고 검색 전략을 변경하여 결국 정답을 얻었습니다. 다양한 문제를 처리하기 위해 유연한 솔루션을 선택할 수 있는 능력은 다른 미세 조정 방법에 비해 FireAct의 주요 장점입니다.

두 번째로, 다양한 언어 모델을 미세 조정하기 위해 여러 가지 방법을 사용하면 다른 영향을 미칠 것입니다. 표 4에서 볼 수 있듯이 미세 조정을 위해 여러 에이전트를 결합하여 사용한다고 해서 항상 개선되는 것은 아니며 최적의 방법 조합은 기본 언어 모델에 따라 다릅니다. 예를 들어 ReAct+CoT는 GPT-3.5 및 Llama-2 모델에서는 ReAct보다 성능이 뛰어나지만 CodeLlama 모델에서는 그렇지 않습니다. CodeLlama7/13B의 경우 ReAct+CoT+Reflexion이 최악의 결과를 얻었지만 CodeLlama-34B가 가장 좋은 결과를 얻었습니다. 이러한 결과는 기본 언어 모델과 미세 조정 데이터 간의 상호 작용에 대한 추가 연구가 필요함을 시사합니다.

여러 방법을 결합한 에이전트가 작업에 따라 적절한 솔루션을 선택할 수 있는지 더 자세히 이해하기 위해 연구자들은 추론 과정에서 방법을 무작위로 선택하는 점수를 계산했습니다. 이 점수(32.4)는 여러 방법을 결합한 모든 상담사보다 훨씬 낮으며, 이는 솔루션 선택이 쉬운 작업이 아님을 나타냅니다. 그러나 인스턴스당 최상의 솔루션 역시 52.0점에 그쳤으며, 이는 프롬프트 방법 선택에 여전히 개선의 여지가 있음을 나타냅니다.

3. 여러 작업에 걸쳐 세부 조정을 위해 다양한 방법을 사용하세요

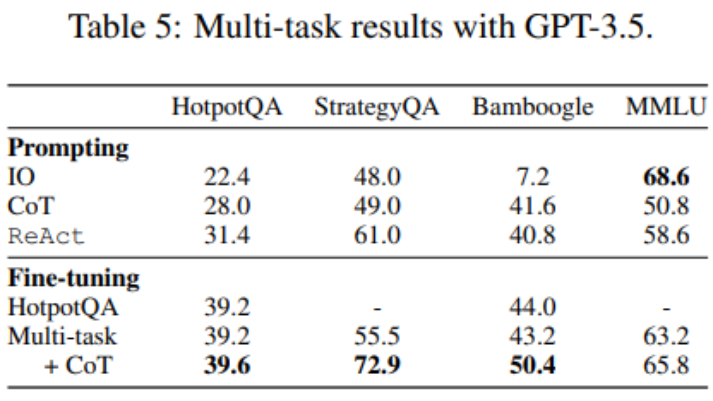

지금까지 Fine-tuning은 HotpotQA 데이터만 사용했지만, LM Fine-tuning에 대한 실증 연구를 보면 서로 다른 작업을 혼합하면 이점이 있는 것으로 나타났습니다. 연구원들은 HotpotQA(500 ReAct 샘플, 277 CoT 샘플), StrategyQA(388 ReAct 샘플, 380 CoT 샘플) 및 MMLU(456 ReAct 샘플) 샘플, 469 CoT 샘플의 세 가지 데이터 세트의 혼합 교육 데이터를 사용하여 GPT-3.5를 미세 조정했습니다. ).

표 5에서 볼 수 있듯이 StrategyQA/MMLU 데이터를 추가한 후에도 HotpotQA/Bamboogle의 성능은 거의 변하지 않습니다. 한편 StrategyQA/MMLU 트랙에는 매우 다른 질문과 도구 사용 전략이 포함되어 있어 마이그레이션이 어렵습니다. 반면, 배포 방식의 변화에도 불구하고 StrategyQA/MMLU를 추가해도 HotpotQA/Bamboogle의 성능에는 영향이 없었으며, 이는 다중 작업 에이전트를 미세 조정하여 여러 단일 작업 에이전트를 대체하는 것이 향후 방향이 될 수 있음을 나타냅니다. 연구자들은 다중 작업, 단일 방법 미세 조정에서 다중 작업, 다중 방법 미세 조정으로 전환했을 때 모든 작업에서 성능 향상을 발견하여 다중 방법 에이전트 미세 조정의 가치를 다시 명확하게 했습니다.

자세한 기술적인 내용은 원본 기사를 읽어보세요.

참조 링크:

- https://twitter.com/Tisoga/status/1739813471246786823

- https://www.zhihu.com/people/eyew3g

위 내용은 AI가 다시 태어났다: 온라인 문학계의 헤게모니를 되찾다의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7547

7547

15

15

1382

1382

52

52

83

83

11

11

57

57

19

19

22

22

90

90

데비안 메일 서버 방화벽 구성 팁

Apr 13, 2025 am 11:42 AM

데비안 메일 서버 방화벽 구성 팁

Apr 13, 2025 am 11:42 AM

데비안 메일 서버의 방화벽 구성은 서버 보안을 보장하는 데 중요한 단계입니다. 다음은 iptables 및 방화구 사용을 포함하여 일반적으로 사용되는 여러 방화벽 구성 방법입니다. iptables를 사용하여 iptables를 설치하도록 방화벽을 구성하십시오 (아직 설치되지 않은 경우) : sudoapt-getupdatesudoapt-getinstalliptablesview 현재 iptables 규칙 : sudoiptables-l configuration

데비안 메일 서버 SSL 인증서 설치 방법

Apr 13, 2025 am 11:39 AM

데비안 메일 서버 SSL 인증서 설치 방법

Apr 13, 2025 am 11:39 AM

Debian Mail 서버에 SSL 인증서를 설치하는 단계는 다음과 같습니다. 1. OpenSSL 툴킷을 먼저 설치하십시오. 먼저 OpenSSL 툴킷이 이미 시스템에 설치되어 있는지 확인하십시오. 설치되지 않은 경우 다음 명령을 사용하여 설치할 수 있습니다. 개인 키 및 인증서 요청 생성 다음에 다음, OpenSSL을 사용하여 2048 비트 RSA 개인 키 및 인증서 요청 (CSR)을 생성합니다.

Centos Shutdown 명령 줄

Apr 14, 2025 pm 09:12 PM

Centos Shutdown 명령 줄

Apr 14, 2025 pm 09:12 PM

CentOS 종료 명령은 종료이며 구문은 종료 [옵션] 시간 [정보]입니다. 옵션은 다음과 같습니다. -H 시스템 중지 즉시 옵션; -P 종료 후 전원을 끕니다. -R 다시 시작; -대기 시간. 시간은 즉시 (현재), 분 (분) 또는 특정 시간 (HH : MM)으로 지정할 수 있습니다. 추가 정보는 시스템 메시지에 표시 될 수 있습니다.

Sony는 PS5 Pro에서 특수 GPU를 사용하여 AMD로 AI를 개발할 가능성을 확인합니다.

Apr 13, 2025 pm 11:45 PM

Sony는 PS5 Pro에서 특수 GPU를 사용하여 AMD로 AI를 개발할 가능성을 확인합니다.

Apr 13, 2025 pm 11:45 PM

Sonyinteractiveent intustionment (SIE, Sony Interactive Entertainment)의 최고 건축가 인 Mark Cerny는 성능 업그레이드 된 AMDRDNA2.X 아키텍처 GPU 및 AMD와 함께 기계 학습/인공 지능 프로그램 코드 "Amethylst"를 포함하여 차세대 호스트 PlayStation5Pro (PS5PRO)에 대한 더 많은 하드웨어 세부 정보를 발표했습니다. PS5PRO 성능 향상의 초점은 여전히 강력한 GPU, Advanced Ray Tracing 및 AI 구동 PSSR Super-Resolution 기능을 포함하여 세 가지 기둥에 있습니다. GPU는 Sony가 RDNA2.x라는 맞춤형 AMDRDNA2 아키텍처를 채택하며 RDNA3 아키텍처가 있습니다.

Centos에서 Gitlab의 백업 방법은 무엇입니까?

Apr 14, 2025 pm 05:33 PM

Centos에서 Gitlab의 백업 방법은 무엇입니까?

Apr 14, 2025 pm 05:33 PM

CentOS 시스템 하에서 Gitlab의 백업 및 복구 정책 데이터 보안 및 복구 가능성을 보장하기 위해 CentOS의 Gitlab은 다양한 백업 방법을 제공합니다. 이 기사는 완전한 GITLAB 백업 및 복구 전략을 설정하는 데 도움이되는 몇 가지 일반적인 백업 방법, 구성 매개 변수 및 복구 프로세스를 자세히 소개합니다. 1. 수동 백업 gitlab-rakegitlab : 백업 : 명령을 작성하여 수동 백업을 실행하십시오. 이 명령은 gitlab 저장소, 데이터베이스, 사용자, 사용자 그룹, 키 및 권한과 같은 주요 정보를 백업합니다. 기본 백업 파일은/var/opt/gitlab/backups 디렉토리에 저장됩니다. /etc /gitlab을 수정할 수 있습니다

Centos에서 Zookeeper의 성능을 조정하는 방법은 무엇입니까?

Apr 14, 2025 pm 03:18 PM

Centos에서 Zookeeper의 성능을 조정하는 방법은 무엇입니까?

Apr 14, 2025 pm 03:18 PM

CentOS에 대한 Zookeeper Performance Tuning은 하드웨어 구성, 운영 체제 최적화, 구성 매개 변수 조정, 모니터링 및 유지 관리 등 여러 측면에서 시작할 수 있습니다. 특정 튜닝 방법은 다음과 같습니다. SSD는 하드웨어 구성에 권장됩니다. Zookeeper의 데이터는 디스크에 작성되므로 SSD를 사용하여 I/O 성능을 향상시키는 것이 좋습니다. 충분한 메모리 : 자주 디스크 읽기 및 쓰기를 피하기 위해 충분한 메모리 리소스를 동물원에 충분한 메모리 자원을 할당하십시오. 멀티 코어 CPU : 멀티 코어 CPU를 사용하여 Zookeeper가이를 병렬로 처리 할 수 있도록하십시오.

마침내 변경되었습니다! Microsoft Windows 검색 기능은 새로운 업데이트를 안내합니다.

Apr 13, 2025 pm 11:42 PM

마침내 변경되었습니다! Microsoft Windows 검색 기능은 새로운 업데이트를 안내합니다.

Apr 13, 2025 pm 11:42 PM

EU의 일부 Windows 내부 채널에서 Microsoft의 Windows 검색 기능 개선이 테스트되었습니다. 이전에 통합 Windows 검색 기능은 사용자에 의해 비판을 받았으며 경험이 좋지 않았습니다. 이 업데이트는 검색 기능을 두 부분으로 나눕니다. 로컬 검색 및 Bing 기반 웹 검색을 위해 사용자 경험을 향상시킵니다. 검색 인터페이스의 새 버전은 기본적으로 로컬 파일 검색을 수행합니다. 온라인으로 검색 해야하는 경우 "Microsoft BingwebSearch"탭을 클릭하여 전환해야합니다. 전환 후 검색 바에는 사용자가 키워드를 입력 할 수있는 "Microsoft Bingwebsearch :"가 표시됩니다. 이 움직임은 로컬 검색 결과와 Bing 검색 결과의 혼합을 효과적으로 피합니다.

Centos에서 Pytorch 모델을 훈련시키는 방법

Apr 14, 2025 pm 03:03 PM

Centos에서 Pytorch 모델을 훈련시키는 방법

Apr 14, 2025 pm 03:03 PM

CentOS 시스템에서 Pytorch 모델을 효율적으로 교육하려면 단계가 필요 하며이 기사는 자세한 가이드를 제공합니다. 1. 환경 준비 : 파이썬 및 종속성 설치 : CentOS 시스템은 일반적으로 파이썬을 사전 설치하지만 버전은 더 오래 될 수 있습니다. YUM 또는 DNF를 사용하여 Python 3 및 Upgrade Pip : Sudoyumupdatepython3 (또는 SudodnfupdatePython3), PIP3INSTALL-UPGRADEPIP를 설치하는 것이 좋습니다. CUDA 및 CUDNN (GPU 가속도) : NVIDIAGPU를 사용하는 경우 Cudatool을 설치해야합니다.