지식 그래프를 활용하여 RAG 모델의 기능을 향상하고 대형 모델의 잘못된 인상을 완화합니다.

환상은 LLM(대형 언어 모델)을 사용할 때 흔히 발생하는 문제입니다. LLM은 매끄럽고 일관된 텍스트를 생성할 수 있지만 생성되는 정보는 부정확하거나 일관성이 없는 경우가 많습니다. LLM의 환각을 방지하기 위해 데이터베이스나 지식 그래프와 같은 외부 지식 소스를 사용하여 사실 정보를 제공할 수 있습니다. 이러한 방식으로 LLM은 신뢰할 수 있는 데이터 소스를 활용하여 보다 정확하고 신뢰할 수 있는 텍스트 콘텐츠를 얻을 수 있습니다.

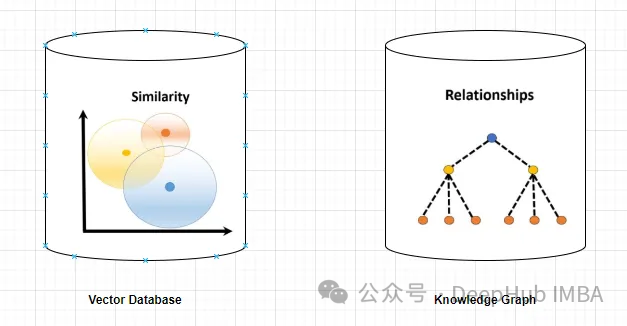

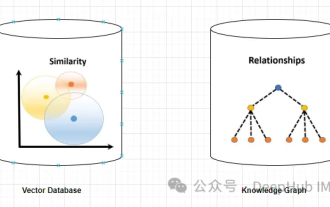

벡터 데이터베이스 및 지식 그래프

벡터 데이터베이스

벡터 데이터베이스는 개체나 개념을 나타내는 고차원 벡터 집합입니다. 이는 벡터 표현을 통해 계산된 다양한 엔터티 또는 개념 간의 유사성 또는 상관 관계를 측정하는 데 사용할 수 있습니다.

벡터 데이터베이스는 벡터 거리를 기반으로 "파리"와 "프랑스"가 "파리"와 "독일"보다 더 관련이 있음을 알려줄 수 있습니다.

벡터 데이터베이스 쿼리에는 일반적으로 유사한 벡터를 검색하거나 특정 기준에 따라 벡터를 검색하는 작업이 포함됩니다. 다음은 벡터 데이터베이스를 쿼리하는 간단한 예입니다.

고객 프로필을 저장하는 고차원 벡터 데이터베이스가 있다고 가정해 보겠습니다. 특정 참조 고객과 유사한 고객을 찾고 싶습니다.

먼저 고객을 벡터 표현으로 정의하기 위해 관련 특징이나 속성을 추출하여 벡터 형식으로 변환할 수 있습니다.

가장 유사한 이웃을 식별하기 위해 k-최근접 이웃 또는 코사인 유사성과 같은 적절한 알고리즘을 사용하여 벡터 데이터베이스에서 유사성 검색을 수행할 수 있습니다.

정의된 유사성 척도에 따라 참조 고객과 유사한 고객을 나타내는 결정된 가장 가까운 이웃 벡터에 해당하는 고객 프로필을 검색합니다.

검색된 고객 프로필이나 이름, 인구통계 데이터, 구매 내역 등 관련 정보를 사용자에게 표시합니다.

지식 그래프

지식 그래프는 엔터티나 개념 및 그 관계(예: 사실, 속성 또는 범주)를 나타내는 노드와 에지의 모음입니다. 노드 및 에지 속성을 기반으로 다양한 엔터티 또는 개념에 대한 사실 정보를 쿼리하거나 추론하는 데 사용할 수 있습니다.

예를 들어 지식 그래프는 에지 라벨을 기반으로 '파리'가 '프랑스'의 수도임을 알려줄 수 있습니다.

그래프 데이터베이스 쿼리에는 그래프 구조를 탐색하고 특정 기준에 따라 노드, 관계 또는 패턴을 검색하는 작업이 포함됩니다.

사용자가 노드이고 관계가 노드를 연결하는 가장자리로 표시되는 소셜 네트워크를 나타내는 그래프 데이터베이스가 있다고 가정합니다. 특정 사용자에 대해 친구의 친구(공통 연결)가 발견되면 다음을 수행해야 합니다.

1. 그래프 데이터베이스에서 참조 사용자를 나타내는 노드를 식별합니다. 이는 특정 사용자 식별자 또는 기타 관련 기준을 쿼리하여 수행할 수 있습니다.

2. Cypher(Neo4j에서 사용됨) 또는 Gremlin과 같은 그래프 쿼리 언어를 사용하여 참조 사용자 노드에서 그래프를 탐색합니다. 탐색할 패턴이나 관계를 지정하세요.

MATCH (:User {userId: ‘referenceUser’})-[:FRIEND]->()-[:FRIEND]->(fof:User) RETURN fof이 쿼리는 참조 사용자로 시작하여 FRIEND 관계를 따라 다른 노드(FRIEND)를 찾은 다음 또 다른 FRIEND 관계를 따라 친구의 친구(fof)를 찾습니다.

3. 그래프 데이터베이스에서 쿼리를 실행하고 쿼리 모드에 따라 결과 노드(친구의 친구)를 검색하고 검색된 노드에 대한 특정 속성이나 기타 정보를 얻습니다.

그래프 데이터베이스는 필터링, 집계, 복잡한 패턴 일치를 포함한 고급 쿼리 기능을 제공할 수 있습니다. 특정 쿼리 언어와 구문은 다를 수 있지만 일반적인 프로세스에는 필요한 기준을 충족하는 노드와 관계를 검색하기 위해 그래프 구조를 탐색하는 작업이 포함됩니다.

'환상' 문제 해결에 있어서 지식 그래프의 장점

지식 그래프는 벡터 데이터베이스보다 더 정확하고 구체적인 정보를 제공합니다. 벡터 데이터베이스는 두 엔터티 또는 개념 간의 유사성 또는 상관 관계를 나타내는 반면, 지식 그래프를 사용하면 둘 사이의 관계를 더 잘 이해할 수 있습니다. 예를 들어 지식 그래프는 '에펠탑'이 '파리'의 랜드마크임을 알려줄 수 있는 반면, 벡터 데이터베이스는 두 개념의 유사성만 보여줄 뿐, 어떻게 연관되어 있는지는 설명하지 못한다.

지식 그래프는 벡터 데이터베이스보다 더 다양하고 복잡한 쿼리를 지원합니다. 벡터 데이터베이스는 주로 벡터 거리, 유사성 또는 직접적인 유사성 측정으로 제한되는 가장 가까운 이웃을 기반으로 쿼리에 응답할 수 있습니다. 그리고 지식 그래프는 "속성 Z를 가진 모든 엔터티는 무엇입니까?" 또는 "W와 V의 공통 범주는 무엇입니까?"와 같은 논리 연산자를 기반으로 하는 쿼리를 처리할 수 있습니다. 이는 LLM이 더욱 다양하고 흥미로운 텍스트를 생성하는 데 도움이 될 수 있습니다.

지식 그래프는 벡터 데이터베이스보다 추론과 추론에 더 좋습니다. 벡터 데이터베이스는 데이터베이스에 저장된 직접적인 정보만 제공할 수 있습니다. 지식 그래프는 엔터티나 개념 간의 관계에서 파생된 간접적인 정보를 제공할 수 있습니다. 예를 들어 지식 그래프는 '파리는 프랑스의 수도이다'와 '프랑스는 유럽에 위치한다'라는 두 가지 사실을 바탕으로 '에펠탑은 유럽에 위치한다'라고 추론할 수 있다. 이는 LLM이 보다 논리적이고 일관된 텍스트를 생성하는 데 도움이 될 수 있습니다.

그래서 지식 그래프는 벡터 데이터베이스보다 더 나은 솔루션입니다. 이를 통해 LLM은 더욱 정확하고, 관련성이 높으며, 다양하고, 흥미롭고, 논리적이며 일관된 정보를 제공하여 정확하고 신뢰할 수 있는 텍스트를 생성하는 데 있어 더욱 신뢰할 수 있습니다. 하지만 여기서 핵심은 문서 문서 간에 명확한 관계가 있어야 한다는 것입니다. 그렇지 않으면 지식 그래프가 이를 포착할 수 없습니다.

但是,知识图谱的使用并没有向量数据库那么直接简单,不仅在内容的梳理(数据),应用部署,查询生成等方面都没有向量数据库那么方便,这也影响了它在实际应用中的使用频率。所以下面我们使用一个简单的例子来介绍如何使用知识图谱构建RAG。

代码实现

我们需要使用3个主要工具/组件:

1、LlamaIndex是一个编排框架,它简化了私有数据与公共数据的集成,它提供了数据摄取、索引和查询的工具,使其成为生成式人工智能需求的通用解决方案。

2、嵌入模型将文本转换为文本所提供的一条信息的数字表示形式。这种表示捕获了所嵌入内容的语义含义,使其对于许多行业应用程序都很健壮。这里使用“thenlper/gte-large”模型。

3、需要大型语言模型来根据所提供的问题和上下文生成响应。这里使用Zephyr 7B beta模型

下面我们开始进行代码编写,首先安装包

%%capture pip install llama_index pyvis Ipython langchain pypdf

启用日志Logging Level设置为“INFO”,我们可以输出有助于监视应用程序操作流的消息

import logging import sys # logging.basicConfig(stream=sys.stdout, level=logging.INFO) logging.getLogger().addHandler(logging.StreamHandler(stream=sys.stdout))

导入依赖项

from llama_index import (SimpleDirectoryReader,LLMPredictor,ServiceContext,KnowledgeGraphIndex) # from llama_index.graph_stores import SimpleGraphStore from llama_index.storage.storage_context import StorageContext from llama_index.llms import HuggingFaceInferenceAPI from langchain.embeddings import HuggingFaceInferenceAPIEmbeddings from llama_index.embeddings import LangchainEmbedding from pyvis.network import Network

我们使用Huggingface推理api端点载入LLM

HF_TOKEN = "api key DEEPHUB 123456" llm = HuggingFaceInferenceAPI(model_name="HuggingFaceH4/zephyr-7b-beta", token=HF_TOKEN )

首先载入嵌入模型:

embed_model = LangchainEmbedding(HuggingFaceInferenceAPIEmbeddings(api_key=HF_TOKEN,model_name="thenlper/gte-large") )

加载数据集

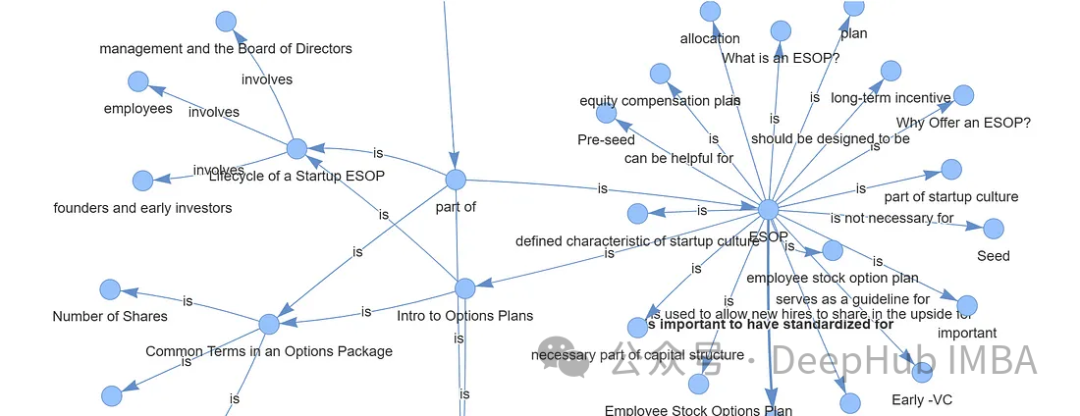

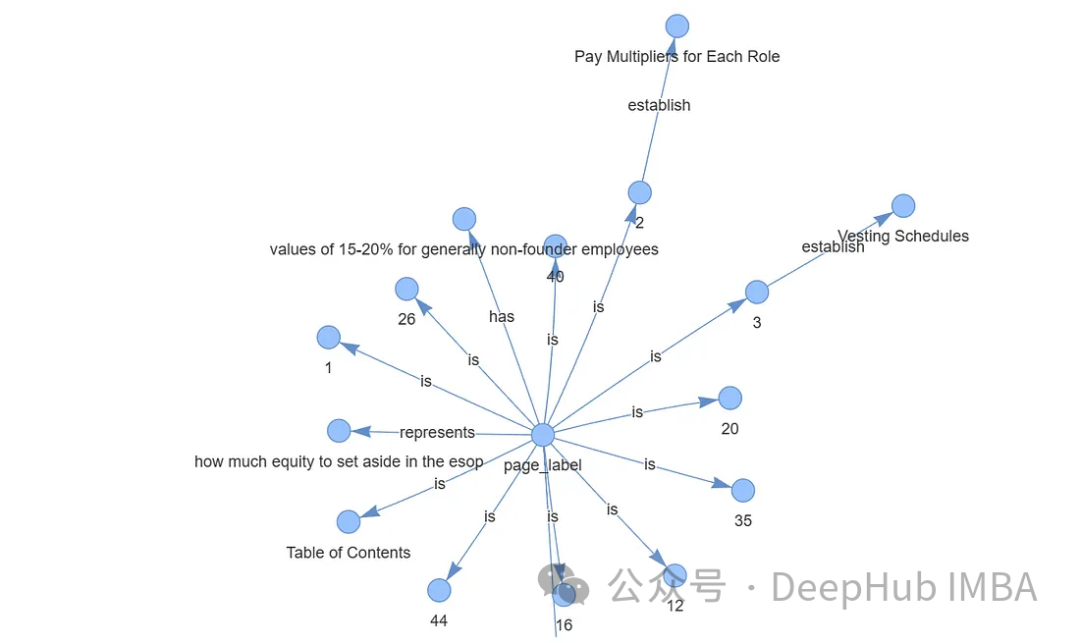

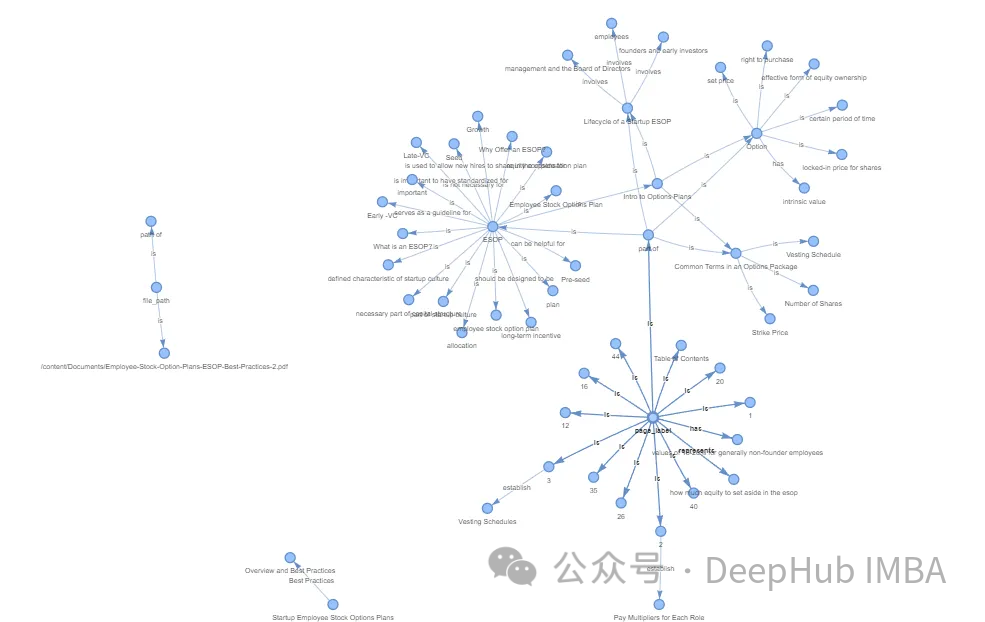

documents = SimpleDirectoryReader("/content/Documents").load_data() print(len(documents)) ####Output### 44构建知识图谱索引

创建知识图谱通常涉及专业和复杂的任务。通过利用Llama Index (LLM)、KnowledgeGraphIndex和GraphStore,可以方便地任何数据源创建一个相对有效的知识图谱。

#setup the service context service_context = ServiceContext.from_defaults(chunk_size=256,llm=llm,embed_model=embed_model ) #setup the storage context graph_store = SimpleGraphStore() storage_context = StorageContext.from_defaults(graph_store=graph_store) #Construct the Knowlege Graph Undex index = KnowledgeGraphIndex.from_documents( documents=documents,max_triplets_per_chunk=3,service_context=service_context,storage_context=storage_context,include_embeddings=True)

Max_triplets_per_chunk:它控制每个数据块处理的关系三元组的数量

Include_embeddings:切换在索引中包含嵌入以进行高级分析。

通过构建查询引擎对知识图谱进行查询

query = "What is ESOP?" query_engine = index.as_query_engine(include_text=True,response_mode ="tree_summarize",embedding_mode="hybrid",similarity_top_k=5,) # message_template =f"""Please check if the following pieces of context has any mention of the keywords provided in the Question.If not then don't know the answer, just say that you don't know.Stop there.Please donot try to make up an answer. Question: {query} Helpful Answer: """ # response = query_engine.query(message_template) # print(response.response.split("")[-1].strip()) #####OUTPUT ##################### ESOP stands for Employee Stock Ownership Plan. It is a retirement plan that allows employees to receive company stock or stock options as part of their compensation. In simpler terms, it is a plan that allows employees to own a portion of the company they work for. This can be a motivating factor for employees as they have a direct stake in the company's success. ESOPs can also be a tax-efficient way for companies to provide retirement benefits to their employees.可以看到,输出的结果已经很好了,可以说与向量数据库的结果非常一致。

最后还可以可视化我们生成的图谱,使用Pyvis库进行可视化展示

from pyvis.network import Network from IPython.display import display g = index.get_networkx_graph() net = Network(notebook=True,cdn_resources="in_line",directed=True) net.from_nx(g) net.show("graph.html") net.save_graph("Knowledge_graph.html") # import IPython IPython.display.HTML(filename="/content/Knowledge_graph.html")

通过上面的代码我们可以直接通过LLM生成知识图谱,这样简化了我们非常多的人工操作。如果需要更精准更完整的知识图谱,还需要人工手动检查,这里就不细说了。

数据存储,通过持久化数据,可以将结果保存到硬盘中,供以后使用。

storage_context.persist()

存储的结果如下:

总结

向量数据库和知识图谱的区别在于它们存储和表示数据的方法。向量数据库擅长基于相似性的操作,依靠数值向量来测量实体之间的距离。知识图谱通过节点和边缘捕获复杂的关系和依赖关系,促进语义分析和高级推理。

对于语言模型(LLM)幻觉,知识图被证明优于向量数据库。知识图谱提供了更准确、多样、有趣、有逻辑性和一致性的信息,减少了LLM产生幻觉的可能性。这种优势源于它们能够提供实体之间关系的精确细节,而不仅仅是表明相似性,从而支持更复杂的查询和逻辑推理。

在以前知识图谱的应用难点在于图谱的构建,但是现在LLM的出现简化了这个过程,使得我们可以轻松的构建出可用的知识图谱,这使得他在应用方面又向前迈出了一大步。对于RAG,知识图谱是一个非常好的应用方向。

위 내용은 지식 그래프를 활용하여 RAG 모델의 기능을 향상하고 대형 모델의 잘못된 인상을 완화합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7419

7419

15

15

1359

1359

52

52

76

76

11

11

27

27

19

19

대규모 언어 모델이 SwiGLU를 활성화 기능으로 사용하는 이유는 무엇입니까?

Apr 08, 2024 pm 09:31 PM

대규모 언어 모델이 SwiGLU를 활성화 기능으로 사용하는 이유는 무엇입니까?

Apr 08, 2024 pm 09:31 PM

대규모 언어 모델의 아키텍처에 관심을 가져왔다면 최신 모델과 연구 논문에서 "SwiGLU"라는 용어를 본 적이 있을 것입니다. SwiGLU는 대규모 언어 모델에서 가장 일반적으로 사용되는 활성화 함수라고 할 수 있습니다. 이 기사에서는 이에 대해 자세히 소개하겠습니다. SwiGLU는 실제로 Google이 2020년에 제안한 활성화 기능으로 SWISH와 GLU의 특성을 결합한 것입니다. SwiGLU의 전체 중국어 이름은 "양방향 게이트 선형 장치"입니다. SWISH와 GLU라는 두 가지 활성화 기능을 최적화하고 결합하여 모델의 비선형 표현 능력을 향상시킵니다. SWISH는 대규모 언어 모델에서 널리 사용되는 매우 일반적인 활성화 함수인 반면, GLU는 자연어 처리 작업에서 좋은 성능을 보였습니다.

Rag 및 Sem-Rag를 사용한 상황 증강 AI 코딩 도우미

Jun 10, 2024 am 11:08 AM

Rag 및 Sem-Rag를 사용한 상황 증강 AI 코딩 도우미

Jun 10, 2024 am 11:08 AM

검색 강화 생성 및 의미론적 메모리를 AI 코딩 도우미에 통합하여 개발자 생산성, 효율성 및 정확성을 향상시킵니다. EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG에서 번역됨, 저자 JanakiramMSV. 기본 AI 프로그래밍 도우미는 자연스럽게 도움이 되지만, 소프트웨어 언어에 대한 일반적인 이해와 소프트웨어 작성의 가장 일반적인 패턴에 의존하기 때문에 가장 관련성이 높고 정확한 코드 제안을 제공하지 못하는 경우가 많습니다. 이러한 코딩 도우미가 생성한 코드는 자신이 해결해야 할 문제를 해결하는 데 적합하지만 개별 팀의 코딩 표준, 규칙 및 스타일을 따르지 않는 경우가 많습니다. 이로 인해 코드가 애플리케이션에 승인되기 위해 수정되거나 개선되어야 하는 제안이 나타나는 경우가 많습니다.

미세 조정을 통해 LLM이 실제로 새로운 것을 배울 수 있습니까? 새로운 지식을 도입하면 모델이 더 많은 환각을 생성할 수 있습니다.

Jun 11, 2024 pm 03:57 PM

미세 조정을 통해 LLM이 실제로 새로운 것을 배울 수 있습니까? 새로운 지식을 도입하면 모델이 더 많은 환각을 생성할 수 있습니다.

Jun 11, 2024 pm 03:57 PM

LLM(대형 언어 모델)은 대규모 텍스트 데이터베이스에서 훈련되어 대량의 실제 지식을 습득합니다. 이 지식은 매개변수에 내장되어 필요할 때 사용할 수 있습니다. 이러한 모델에 대한 지식은 훈련이 끝나면 "구체화"됩니다. 사전 훈련이 끝나면 모델은 실제로 학습을 중단합니다. 모델을 정렬하거나 미세 조정하여 이 지식을 활용하고 사용자 질문에 보다 자연스럽게 응답하는 방법을 알아보세요. 그러나 때로는 모델 지식만으로는 충분하지 않을 때도 있으며, 모델이 RAG를 통해 외부 콘텐츠에 접근할 수 있더라도 미세 조정을 통해 모델을 새로운 도메인에 적응시키는 것이 유익한 것으로 간주됩니다. 이러한 미세 조정은 인간 주석 작성자 또는 기타 LLM 생성자의 입력을 사용하여 수행됩니다. 여기서 모델은 추가적인 실제 지식을 접하고 이를 통합합니다.

지식 그래프 검색을 위해 향상된 GraphRAG(Neo4j 코드를 기반으로 구현됨)

Jun 12, 2024 am 10:32 AM

지식 그래프 검색을 위해 향상된 GraphRAG(Neo4j 코드를 기반으로 구현됨)

Jun 12, 2024 am 10:32 AM

GraphRAG(Graph Retrieval Enhanced Generation)는 점차 대중화되고 있으며 기존 벡터 검색 방법을 강력하게 보완하는 수단이 되었습니다. 이 방법은 그래프 데이터베이스의 구조적 특성을 활용하여 데이터를 노드와 관계의 형태로 구성함으로써 검색된 정보의 깊이와 맥락적 관련성을 향상시킵니다. 그래프는 다양하고 상호 연관된 정보를 표현하고 저장하는 데 자연스러운 이점을 가지며, 다양한 데이터 유형 간의 복잡한 관계와 속성을 쉽게 캡처할 수 있습니다. 벡터 데이터베이스는 이러한 유형의 구조화된 정보를 처리할 수 없으며 고차원 벡터로 표현되는 구조화되지 않은 데이터를 처리하는 데 더 중점을 둡니다. RAG 애플리케이션에서 구조화된 그래프 데이터와 구조화되지 않은 텍스트 벡터 검색을 결합하면 이 기사에서 논의할 내용인 두 가지 장점을 동시에 누릴 수 있습니다. 구조

FAISS 벡터 공간을 시각화하고 RAG 매개변수를 조정하여 결과 정확도 향상

Mar 01, 2024 pm 09:16 PM

FAISS 벡터 공간을 시각화하고 RAG 매개변수를 조정하여 결과 정확도 향상

Mar 01, 2024 pm 09:16 PM

오픈 소스 대규모 언어 모델의 성능이 지속적으로 향상됨에 따라 코드, 권장 사항, 텍스트 요약 및 QA(질문 응답) 쌍 작성 및 분석 성능이 모두 향상되었습니다. 그러나 QA와 관련하여 LLM은 훈련되지 않은 데이터와 관련된 문제가 부족한 경우가 많으며 규정 준수, 영업 비밀 또는 개인 정보 보호를 보장하기 위해 많은 내부 문서가 회사 내에 보관됩니다. 이러한 문서를 쿼리하면 LLM은 환각을 느끼고 관련이 없거나 조작되었거나 일관성이 없는 콘텐츠를 생성할 수 있습니다. 이 문제를 처리할 수 있는 기술 중 하나는 검색 증강 생성(RAG)입니다. 여기에는 생성의 품질과 정확성을 향상시키기 위해 훈련 데이터 소스를 넘어 권위 있는 지식 기반을 참조하여 응답을 향상시키는 프로세스가 포함됩니다. RAG 시스템에는 코퍼스에서 관련 문서 조각을 검색하기 위한 검색 시스템이 포함되어 있습니다.

자가 게임 미세 조정 훈련을 위한 SPIN 기술을 활용한 LLM 최적화

Jan 25, 2024 pm 12:21 PM

자가 게임 미세 조정 훈련을 위한 SPIN 기술을 활용한 LLM 최적화

Jan 25, 2024 pm 12:21 PM

2024년은 LLM(대형 언어 모델)이 급속히 발전하는 해입니다. LLM 훈련에서 정렬 방법은 인간의 선호도에 의존하는 지도형 미세 조정(SFT) 및 인간 피드백을 통한 강화 학습(RLHF)을 포함하는 중요한 기술적 수단입니다. 이러한 방법은 LLM 개발에 중요한 역할을 해왔지만 정렬 방법에는 수동으로 주석을 단 대량의 데이터가 필요합니다. 이러한 과제에 직면하여 미세 조정은 활발한 연구 분야가 되었으며, 연구자들은 인간 데이터를 효과적으로 활용할 수 있는 방법을 개발하기 위해 적극적으로 노력하고 있습니다. 따라서 정렬 방법의 개발은 LLM 기술의 획기적인 발전을 촉진할 것입니다. 캘리포니아 대학교에서는 최근 SPIN(SelfPlayfInetuNing)이라는 신기술을 도입하는 연구를 진행했습니다. 에스

지식 그래프를 활용하여 RAG 모델의 기능을 향상하고 대형 모델의 잘못된 인상을 완화합니다.

Jan 14, 2024 pm 06:30 PM

지식 그래프를 활용하여 RAG 모델의 기능을 향상하고 대형 모델의 잘못된 인상을 완화합니다.

Jan 14, 2024 pm 06:30 PM

환각은 LLM(대형 언어 모델)으로 작업할 때 흔히 발생하는 문제입니다. LLM은 매끄럽고 일관된 텍스트를 생성할 수 있지만 생성되는 정보는 부정확하거나 일관성이 없는 경우가 많습니다. LLM의 환각을 방지하기 위해 데이터베이스나 지식 그래프와 같은 외부 지식 소스를 사용하여 사실 정보를 제공할 수 있습니다. 이러한 방식으로 LLM은 신뢰할 수 있는 데이터 소스를 활용하여 보다 정확하고 신뢰할 수 있는 텍스트 콘텐츠를 얻을 수 있습니다. 벡터 데이터베이스 및 지식 그래프 벡터 데이터베이스 벡터 데이터베이스는 개체나 개념을 나타내는 고차원 벡터 집합입니다. 이는 벡터 표현을 통해 계산된 다양한 엔터티 또는 개념 간의 유사성 또는 상관 관계를 측정하는 데 사용할 수 있습니다. 벡터 데이터베이스는 벡터 거리를 기반으로 "Paris"와 "France"가 "Paris"와 "France"보다 더 가깝다는 것을 알려줄 수 있습니다.

GraphRAG 이해(1): RAG의 과제

Apr 30, 2024 pm 07:10 PM

GraphRAG 이해(1): RAG의 과제

Apr 30, 2024 pm 07:10 PM

RAG(RiskAssessmentGrid)는 외부 지식 소스를 사용하여 기존 LLM(대형 언어 모델)을 강화하여 보다 상황에 맞는 답변을 제공하는 방법입니다. RAG에서 검색 구성 요소는 추가 정보를 얻고 응답은 특정 소스를 기반으로 한 다음 이 정보를 LLM 프롬프트에 제공하여 LLM의 응답이 이 정보를 기반으로 합니다(향상 단계). RAG는 트리밍과 같은 다른 기술에 비해 경제적입니다. 또한 이 정보(증강 단계)를 기반으로 추가 컨텍스트를 제공하여 환각을 줄이는 이점이 있습니다. RAG는 오늘날의 LLM 작업(예: 추천, 텍스트 추출, 감정 분석 등)을 위한 워크플로 방법이 됩니다. 사용자 의도에 따라 이 아이디어를 더 세분화하면 일반적으로 다음을 살펴봅니다.