HuggingFace: 두 마리의 알파카가 머리와 꼬리를 제거한 후 서로 이어져 있습니다.

HuggingFace 오픈소스 대형 모델 순위 목록이 다시 삭제되었습니다.

앞줄은 SOLAR 10.7B 미세 조정 버전이 독점적으로 점유하여 몇 주 전의 다양한 Mixtral 8x7B 미세 조정 버전을 짜냈습니다.

대형 SOLAR 모델의 유래는 무엇인가요?

관련 논문이 새로운 대형 모델 확장 방법인 뎁스 업스케일링(DUS)을 사용하여 한국 기업 Upstage AI에서 ArXiv에 방금 업로드되었습니다.

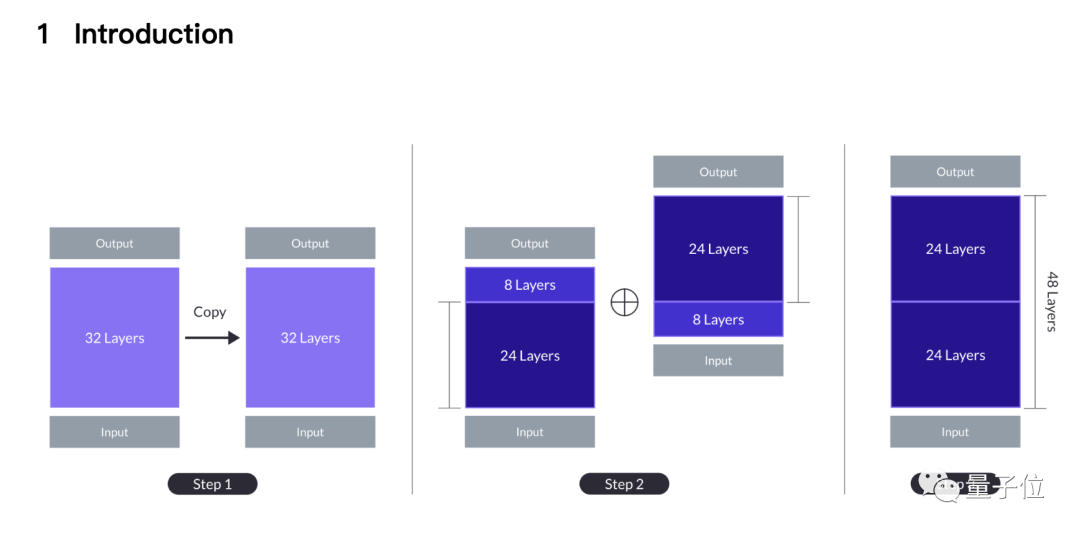

쉽게 말하면 7B 알파카 두 마리를 꼬집어 꼬리를 한 마리는 처음 8겹을 잘라내고, 다른 한 마리는 마지막 8겹을 잘라냅니다.

나머지 24개의 레이어가 서로 꿰매어집니다. 첫 번째 모델의 24번째 레이어가 두 번째 모델의 9번째 레이어와 접합되어 마침내 새로운 48레이어 10.7B 대형 모델이 됩니다.

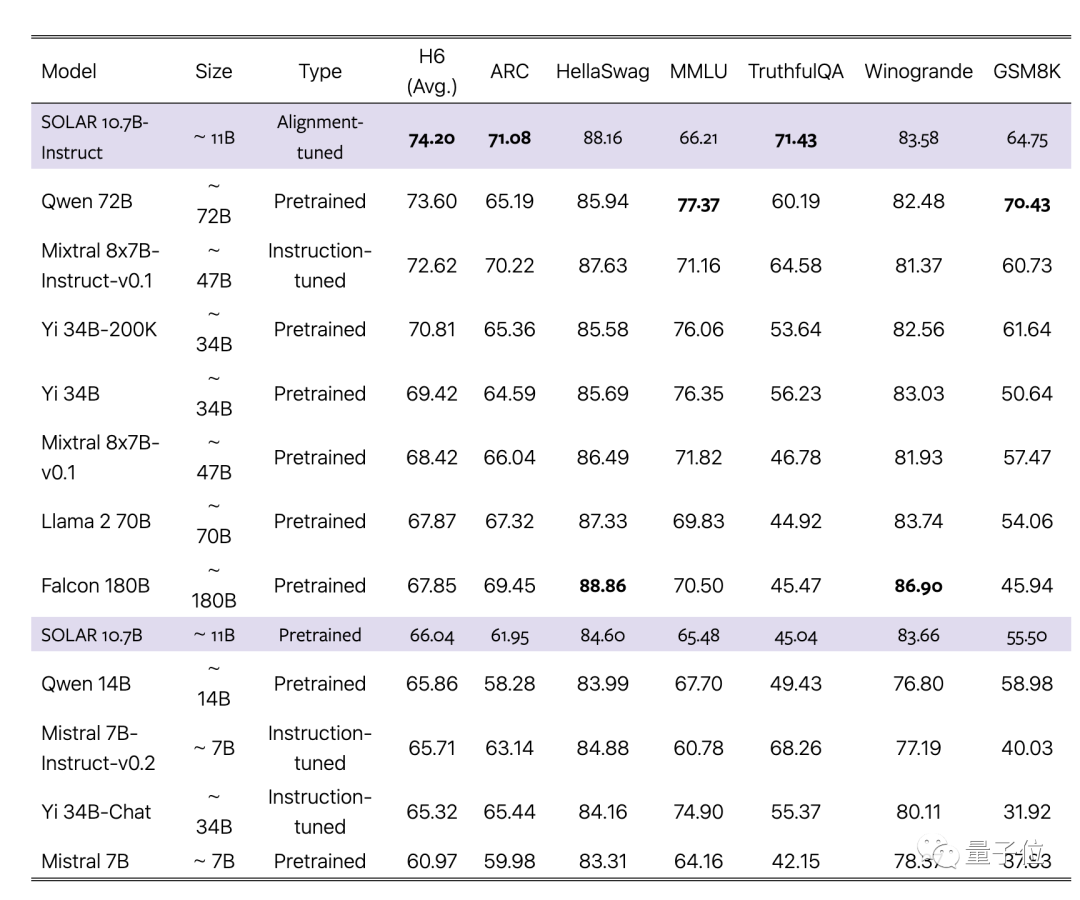

논문에서는 새로운 방법이 MoE와 같은 기존 확장 방법을 능가하며 기본 대형 모델과 정확히 동일한 인프라를 사용할 수 있다고 주장합니다.

게이트 네트워크와 같은 추가 모듈이 필요 없고 훈련 프레임워크는 MoE에 최적화되어 있으며 빠른 추론을 위해 CUDA 커널을 사용자 정의할 필요가 없으며 효율성을 유지하면서 기존 방법에 원활하게 통합될 수 있습니다.

팀은 7B 중 가장 강력한 단일 대형 모델인 미스트랄 7B를 기본 소재로 선택하고, 새로운 방식으로 접합해 기존 버전과 MoE 버전을 능가했습니다.

동시에 정렬된 Instruct 버전도 해당 MoE Instruct 버전을 능가합니다.

스티칭을 끝까지 진행하세요

이 접합 방법은 왜 종이의 소개는 직관에서 비롯된 것입니까?

32레이어 기본 대형 모델을 두 번 반복하여 64레이어가 되는 가장 간단한 확장 방법부터 시작하세요.

이것의 장점은 이질성이 없다는 것입니다. 모든 레이어는 기본 대형 모델에서 가져온 것이지만 레이어 32와 33은 (레이어 1과 동일) 솔기 거리에서 더 큰 " 레이어를 가집니다. 거리”(레이어 거리 ).

이전 연구에서는 Transformer의 여러 계층이 서로 다른 작업을 수행하는 것으로 나타났습니다. 예를 들어 더 깊은 계층이 더 추상적인 개념을 처리하는 데 더 좋습니다.

팀은 과도한 레이어 거리가 사전 훈련된 가중치를 효과적으로 활용하는 모델의 능력을 방해할 수 있다고 믿습니다.

한 가지 가능한 해결책은 중간 레이어를 희생하여 솔기 부분의 차이를 줄이는 것이며, 이것이 DUS 방법이 탄생한 곳입니다.

성능과 모델 크기 사이의 균형을 바탕으로 팀은 각 모델에서 8개의 레이어를 삭제하기로 결정했고, 이음새는 32레이어에서 레이어 1, 24레이어, 레이어 9로 변경되었습니다.

단순 접합 모델의 성능은 처음에는 원래 기본 모델보다 여전히 낮지만 지속적인 사전 훈련을 통해 빠르게 회복할 수 있습니다.

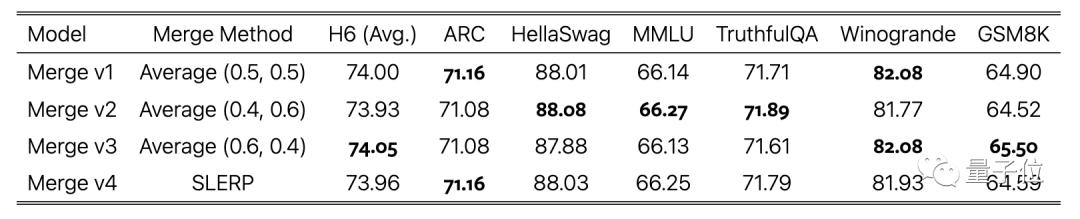

명령어 미세 조정 단계에서는 오픈 소스 데이터 세트를 사용하는 것 외에도 수학적으로 향상된 데이터 세트를 생성하고 정렬 단계에서 DPO를 사용했습니다.

마지막 단계는 다양한 데이터 세트를 사용하여 학습된 모델 버전의 평균에 가중치를 부여하는 것이며, 이는 또한 스티칭의 완성입니다.

일부 네티즌들은 테스트 데이터 유출 가능성에 의문을 제기했습니다.

팀에서도 이를 고려하여 낮은 수준을 보인 데이터 오염 테스트 결과를 논문 부록에 구체적으로 보고했습니다.

마지막으로 SOLAR 10.7B 기본 모델과 미세 조정 모델 모두 Apache 2.0 라이선스에 따른 오픈 소스입니다.

이를 사용해 본 네티즌들은 JSON 형식의 데이터에서 데이터를 추출하는 데 성능이 좋다고 보고했습니다.

논문 주소: https://arxiv.org/abs/2312.15166

위 내용은 HuggingFace: 두 마리의 알파카가 머리와 꼬리를 제거한 후 서로 이어져 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7467

7467

15

15

1376

1376

52

52

77

77

11

11

48

48

19

19

19

19

22

22

Laravel 's geospatial : 대화식지도의 최적화 및 많은 양의 데이터

Apr 08, 2025 pm 12:24 PM

Laravel 's geospatial : 대화식지도의 최적화 및 많은 양의 데이터

Apr 08, 2025 pm 12:24 PM

7 백만 레코드를 효율적으로 처리하고 지리 공간 기술로 대화식지도를 만듭니다. 이 기사는 Laravel과 MySQL을 사용하여 7 백만 개 이상의 레코드를 효율적으로 처리하고 대화식지도 시각화로 변환하는 방법을 살펴 봅니다. 초기 챌린지 프로젝트 요구 사항 : MySQL 데이터베이스에서 7 백만 레코드를 사용하여 귀중한 통찰력을 추출합니다. 많은 사람들이 먼저 프로그래밍 언어를 고려하지만 데이터베이스 자체를 무시합니다. 요구 사항을 충족시킬 수 있습니까? 데이터 마이그레이션 또는 구조 조정이 필요합니까? MySQL이 큰 데이터로드를 견딜 수 있습니까? 예비 분석 : 주요 필터 및 속성을 식별해야합니다. 분석 후, 몇 가지 속성만이 솔루션과 관련이 있음이 밝혀졌습니다. 필터의 타당성을 확인하고 검색을 최적화하기위한 제한 사항을 설정했습니다. 도시를 기반으로 한지도 검색

MySQL을 해결하는 방법을 시작할 수 없습니다

Apr 08, 2025 pm 02:21 PM

MySQL을 해결하는 방법을 시작할 수 없습니다

Apr 08, 2025 pm 02:21 PM

MySQL 시작이 실패하는 데는 여러 가지 이유가 있으며 오류 로그를 확인하여 진단 할 수 있습니다. 일반적인 원인에는 포트 충돌 (포트 점유 체크 및 구성 수정), 권한 문제 (서비스 실행 사용자 권한 실행), 구성 파일 오류 (파라미터 설정 확인), 데이터 디렉토리 손상 (데이터 복원 또는 테이블 공간 재건), IBDATA 테이블 공간 문제 (IBDATA1 파일 확인), 플러그로드 (확인 오류 로그)가 포함됩니다. 문제를 해결할 때 오류 로그를 기반으로 문제를 분석하고 문제의 근본 원인을 찾고 문제를 방지하고 해결하기 위해 정기적으로 데이터를 백업하는 습관을 개발해야합니다.

설치 후 MySQL을 사용하는 방법

Apr 08, 2025 am 11:48 AM

설치 후 MySQL을 사용하는 방법

Apr 08, 2025 am 11:48 AM

이 기사는 MySQL 데이터베이스의 작동을 소개합니다. 먼저 MySQLworkBench 또는 명령 줄 클라이언트와 같은 MySQL 클라이언트를 설치해야합니다. 1. MySQL-Uroot-P 명령을 사용하여 서버에 연결하고 루트 계정 암호로 로그인하십시오. 2. CreateABase를 사용하여 데이터베이스를 작성하고 데이터베이스를 선택하십시오. 3. CreateTable을 사용하여 테이블을 만들고 필드 및 데이터 유형을 정의하십시오. 4. InsertInto를 사용하여 데이터를 삽입하고 데이터를 쿼리하고 업데이트를 통해 데이터를 업데이트하고 DELETE를 통해 데이터를 삭제하십시오. 이러한 단계를 마스터하고 일반적인 문제를 처리하는 법을 배우고 데이터베이스 성능을 최적화하면 MySQL을 효율적으로 사용할 수 있습니다.

원격 선임 백엔드 엔지니어 (플랫폼)에는 원이 필요합니다

Apr 08, 2025 pm 12:27 PM

원격 선임 백엔드 엔지니어 (플랫폼)에는 원이 필요합니다

Apr 08, 2025 pm 12:27 PM

원격 선임 백엔드 엔지니어 구직 회사 : 원 위치 : 원격 사무실 직무 유형 : 전임 급여 : $ 130,000- $ 140,000 직무 설명 전체 소프트웨어 개발 라이프 사이클을 다루는 Circle Mobile 애플리케이션 및 공개 API 관련 기능의 연구 및 개발에 참여합니다. 주요 책임은 독립적으로 Rubyonrails를 기반으로 개발 작업을 완료하고 React/Redux/Relay 프론트 엔드 팀과 협력합니다. 웹 애플리케이션의 핵심 기능 및 개선을 구축하고 기능 설계 프로세스 전반에 걸쳐 설계자 및 리더십과 긴밀히 협력하십시오. 긍정적 인 개발 프로세스를 촉진하고 반복 속도를 우선시하십시오. 6 년 이상의 복잡한 웹 애플리케이션 백엔드가 필요합니다.

MySQL이 JSON을 반환 할 수 있습니다

Apr 08, 2025 pm 03:09 PM

MySQL이 JSON을 반환 할 수 있습니다

Apr 08, 2025 pm 03:09 PM

MySQL은 JSON 데이터를 반환 할 수 있습니다. json_extract 함수는 필드 값을 추출합니다. 복잡한 쿼리의 경우 where 절을 사용하여 JSON 데이터를 필터링하지만 성능 영향에주의하십시오. JSON에 대한 MySQL의 지원은 지속적으로 증가하고 있으며 최신 버전 및 기능에주의를 기울이는 것이 좋습니다.

산성 특성 이해 : 신뢰할 수있는 데이터베이스의 기둥

Apr 08, 2025 pm 06:33 PM

산성 특성 이해 : 신뢰할 수있는 데이터베이스의 기둥

Apr 08, 2025 pm 06:33 PM

데이터베이스 산 속성에 대한 자세한 설명 산 속성은 데이터베이스 트랜잭션의 신뢰성과 일관성을 보장하기위한 일련의 규칙입니다. 데이터베이스 시스템이 트랜잭션을 처리하는 방법을 정의하고 시스템 충돌, 전원 중단 또는 여러 사용자의 동시 액세스가 발생할 경우에도 데이터 무결성 및 정확성을 보장합니다. 산 속성 개요 원자력 : 트랜잭션은 불가분의 단위로 간주됩니다. 모든 부분이 실패하고 전체 트랜잭션이 롤백되며 데이터베이스는 변경 사항을 유지하지 않습니다. 예를 들어, 은행 송금이 한 계정에서 공제되지만 다른 계정으로 인상되지 않은 경우 전체 작업이 취소됩니다. BeginTransaction; updateAccountssetBalance = Balance-100WH

다운로드 후 MySQL을 설치할 수 없습니다

Apr 08, 2025 am 11:24 AM

다운로드 후 MySQL을 설치할 수 없습니다

Apr 08, 2025 am 11:24 AM

MySQL 설치 실패의 주된 이유는 다음과 같습니다. 1. 권한 문제, 관리자로 실행하거나 Sudo 명령을 사용해야합니다. 2. 종속성이 누락되었으며 관련 개발 패키지를 설치해야합니다. 3. 포트 충돌, 포트 3306을 차지하는 프로그램을 닫거나 구성 파일을 수정해야합니다. 4. 설치 패키지가 손상되어 무결성을 다운로드하여 확인해야합니다. 5. 환경 변수가 잘못 구성되었으며 운영 체제에 따라 환경 변수를 올바르게 구성해야합니다. 이러한 문제를 해결하고 각 단계를 신중하게 확인하여 MySQL을 성공적으로 설치하십시오.

MySQL의 주요 키는 Null 일 수 있습니다

Apr 08, 2025 pm 03:03 PM

MySQL의 주요 키는 Null 일 수 있습니다

Apr 08, 2025 pm 03:03 PM

기본 키는 데이터베이스의 각 행을 고유하게 식별하는 키 속성이기 때문에 MySQL 기본 키는 비어있을 수 없습니다. 기본 키가 비어 있으면 레코드를 고유하게 식별 할 수 없으므로 데이터 혼동으로 이어질 수 있습니다. 자체 점수 정수 열 또는 UUID를 기본 키로 사용하는 경우 효율성 및 우주 점유와 같은 요소를 고려하고 적절한 솔루션을 선택해야합니다.