GPT-4는 상세하고 정확한 이미지 설명을 생성하는 탁월한 능력을 입증하여 언어 및 시각적 처리의 새로운 시대가 도래했음을 알렸습니다. 따라서 최근 GPT-4와 유사한 다중 모드 대형 언어 모델(MLLM)이 등장하여 새롭게 떠오르는 연구 분야가 되었습니다. 이 연구의 핵심은 강력한 LLM을 다중 모드 인지 프레임워크를 수행하는 도구로 사용하는 것입니다. . MLLM의 예상치 못한 뛰어난 성능은 기존 방법을 능가할 뿐만 아니라 일반 인공 지능을 달성할 수 있는 잠재적인 방법 중 하나입니다. 유용한 MLLM을 생성하려면 대규모 쌍의 이미지-텍스트 데이터와 시각적-언어적 미세 조정 데이터를 사용하여 고정된 LLM(예: LLaMA 및 Vicuna) 및 시각적 표현(예: CLIP 및 BLIP- 2) 커넥터(예: MiniGPT-4, LLaVA 및 LLaMA-Adapter). MLLM의 교육은 일반적으로 사전 교육 단계와 미세 조정 단계의 두 단계로 나뉩니다. 사전 훈련의 목적은 MLLM이 많은 양의 지식을 습득할 수 있도록 하는 것이고, 미세 조정은 모델이 인간의 의도를 더 잘 이해하고 정확한 응답을 생성하도록 가르치는 것입니다. MLLM의 시각적 언어 이해 및 지시 따르기 능력을 향상시키기 위해 최근에는 지시 조정이라는 강력한 미세 조정 기술이 등장했습니다. 이 기술은 모델이 다양한 지침에 따라 인간이 원하는 결과를 생성할 수 있도록 모델을 인간의 선호도에 맞추는 데 도움이 됩니다. 지시 미세 조정 기술 개발 측면에서 미세 조정 단계에서 이미지 주석, 시각적 질문 답변(VQA) 및 시각적 추론 데이터 세트를 도입하는 것은 상당히 건설적인 방향입니다. InstructBLIP 및 Otter와 같은 이전 기술은 일련의 시각적 언어 데이터 세트를 사용하여 시각적 지침을 미세 조정했으며 유망한 결과도 달성했습니다. 그러나 일반적으로 사용되는 다중 모드 명령 미세 조정 데이터 세트에는 응답이 부정확하거나 관련성이 없는 낮은 품질의 인스턴스가 많이 포함되어 있는 것으로 관찰되었습니다. 이러한 데이터는 오해의 소지가 있으며 모델 성능에 부정적인 영향을 미칠 수 있습니다. 이 질문으로 인해 연구자들은 다음과 같은 가능성을 탐구하게 되었습니다. 소량의 고품질 후속 명령 데이터를 사용하여 강력한 성능을 달성할 수 있습니까? 최근 일부 연구에서는 이러한 방향에 잠재력이 있음을 나타내는 고무적인 결과가 나왔습니다. 예를 들어, Zhou et al.은 인간 전문가가 엄선한 고품질 데이터를 사용하여 미세 조정된 언어 모델인 LIMA를 제안했습니다. 본 연구는 대규모 언어 모델이 제한된 양의 고품질 후속 명령 데이터로도 만족스러운 결과를 얻을 수 있음을 보여줍니다. 그래서 연구자들은 다음과 같이 결론지었습니다. 정렬에 있어서는 적을수록 좋습니다. 그러나 다중 모달 언어 모델을 미세 조정하기 위해 적합한 고품질 데이터 세트를 선택하는 방법에 대한 명확한 지침은 없습니다. Shanghai Jiao Tong University와 Lehigh University의 Qingyuan Research Institute 연구팀은 이러한 격차를 메우고 강력하고 효과적인 데이터 선택기를 제안했습니다. 이 데이터 선택기는 품질이 낮은 시각적-언어적 데이터를 자동으로 식별하고 필터링하여 가장 관련성이 높고 유익한 샘플이 모델 교육에 사용되도록 합니다. 논문 주소: https://arxiv.org/abs/2308.12067연구원은 이번 연구의 초점이 작지만 고품질 교육의 영향을 탐구하는 것이라고 말했습니다. 미세 조정 다중 모드에 대한 데이터 조정 동적 대형 언어 모델의 효율성. 이 외에도 이 문서에서는 다중 모드 명령 데이터의 품질을 평가하기 위해 특별히 설계된 몇 가지 새로운 측정 기준을 소개합니다. 이미지에 대해 스펙트럼 클러스터링을 수행한 후 데이터 선택기는 각 시각 언어 데이터에 대해 CLIP 점수, GPT 점수, 보너스 점수 및 답변 길이를 결합한 가중치 점수를 계산합니다. MiniGPT-4를 미세 조정하는 데 사용된 3400개의 원시 데이터에 이 선택기를 사용하여 연구원들은 대부분의 데이터에 품질이 낮은 문제가 있음을 발견했습니다. 이 데이터 선택기를 사용하여 연구원은 큐레이트된 데이터의 훨씬 작은 하위 집합(원래 데이터 세트의 6%인 200개 데이터)을 얻었습니다. 그런 다음 MiniGPT-4와 동일한 훈련 구성을 사용하고 이를 미세 조정하여 새로운 모델인 InstructionGPT-4를 얻었습니다. 연구원들은 이것이 시각적-언어적 지시를 미세 조정하는 데 있어서 데이터의 질이 양보다 더 중요하다는 것을 보여주기 때문에 흥미로운 발견이라고 말했습니다. 또한 데이터 품질에 더욱 중점을 둔 이러한 변화는 MLLM 미세 조정을 향상할 수 있는 새롭고 보다 효과적인 패러다임을 제공합니다.연구원들은 Flick-30k, ScienceQA, VSR 등을 포함한 7개의 다양하고 복잡한 개방형 도메인 다중 모드 데이터 세트에 초점을 맞춰 엄격한 실험을 수행했으며 미세 조정된 MLLM의 실험적 평가를 수행했습니다. 그들은 다양한 다중 모드 작업에서 다양한 데이터 세트 선택 방법(데이터 선택기 사용, 데이터 세트 무작위 샘플링, 전체 데이터 세트 사용)을 사용하여 미세 조정된 모델의 추론 성능을 비교했습니다. 결과는 InstructionGPT-4의 성능이 우수함을 보여주었습니다. . 또한, 연구원이 평가에 사용하는 평가자는 GPT-4입니다. 특히 연구원들은 프롬프트를 사용하여 GPT-4를 평가자로 전환하여 LLaVA-Bench의 테스트 세트를 사용하여 InstructionGPT-4와 원래 MiniGPT-4의 응답 결과를 비교할 수 있습니다. InstructionGPT-4에서 사용된 미세 조정 데이터는 MiniGPT-4에서 사용된 원래 명령 준수 데이터보다 6% 적었지만 후자는 73%의 경우에 응답한 것으로 나타났습니다. 같거나 더 좋습니다.

- 200개(약 6%)의 고품질 지침을 선택하여 InstructionGPT-4를 훈련함으로써 연구원들은 이것이 다중 용도로 사용될 수 있음을 보여주었습니다. - 모달 대규모 언어 모델은 더 나은 정렬을 달성하기 위해 더 적은 명령어 데이터를 사용합니다.

- 본 논문에서는 미세 조정을 위한 고품질 다중 모드 명령 준수 데이터를 선택하기 위해 간단하고 해석 가능한 원리를 사용하는 데이터 선택기를 제안합니다. 이 접근 방식은 데이터 하위 집합을 평가하고 조정할 때 유효성과 이식성을 달성하기 위해 노력합니다.

- 연구원들은 이 간단한 기술이 다양한 작업을 잘 처리할 수 있다는 것을 실험을 통해 보여주었습니다. 원래 MiniGPT-4와 비교하여 6%만 필터링된 데이터를 사용하여 미세 조정된 InstructionGPT-4는 다양한 작업에서 더 나은 성능을 달성합니다.

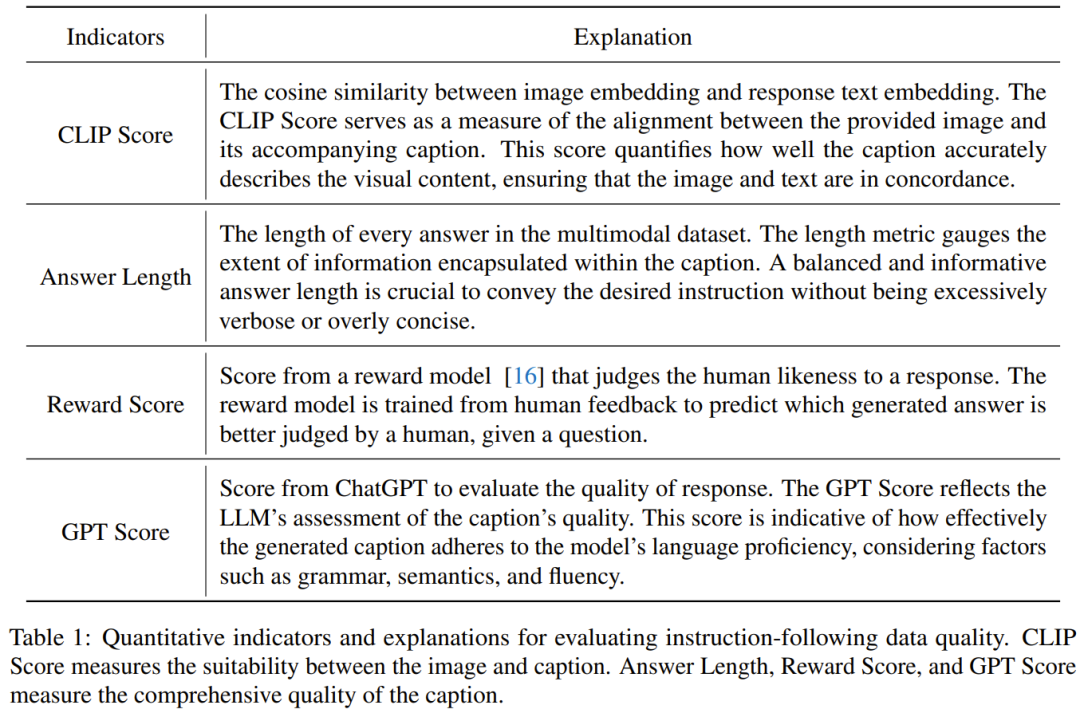

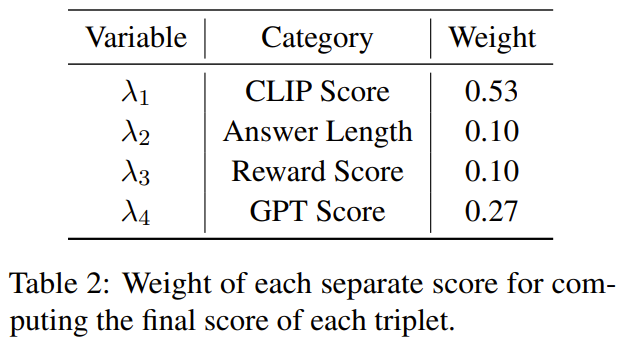

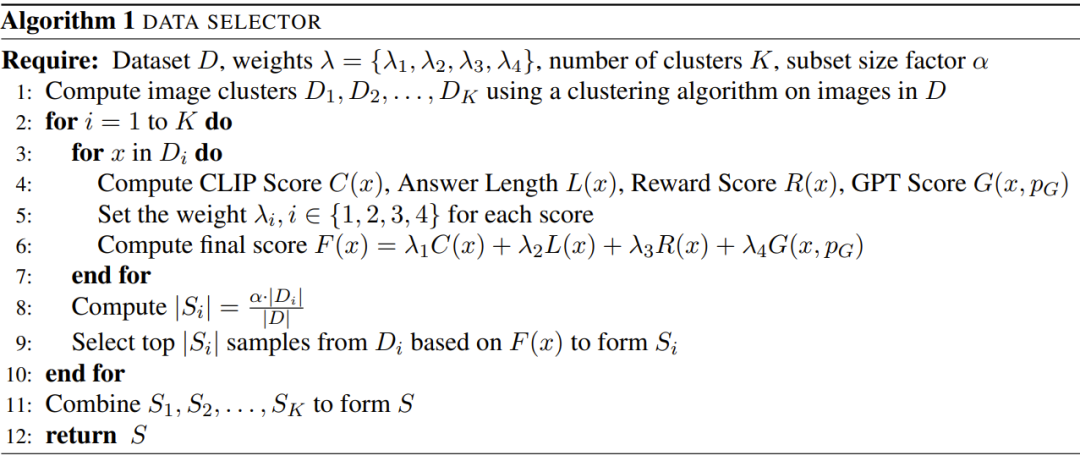

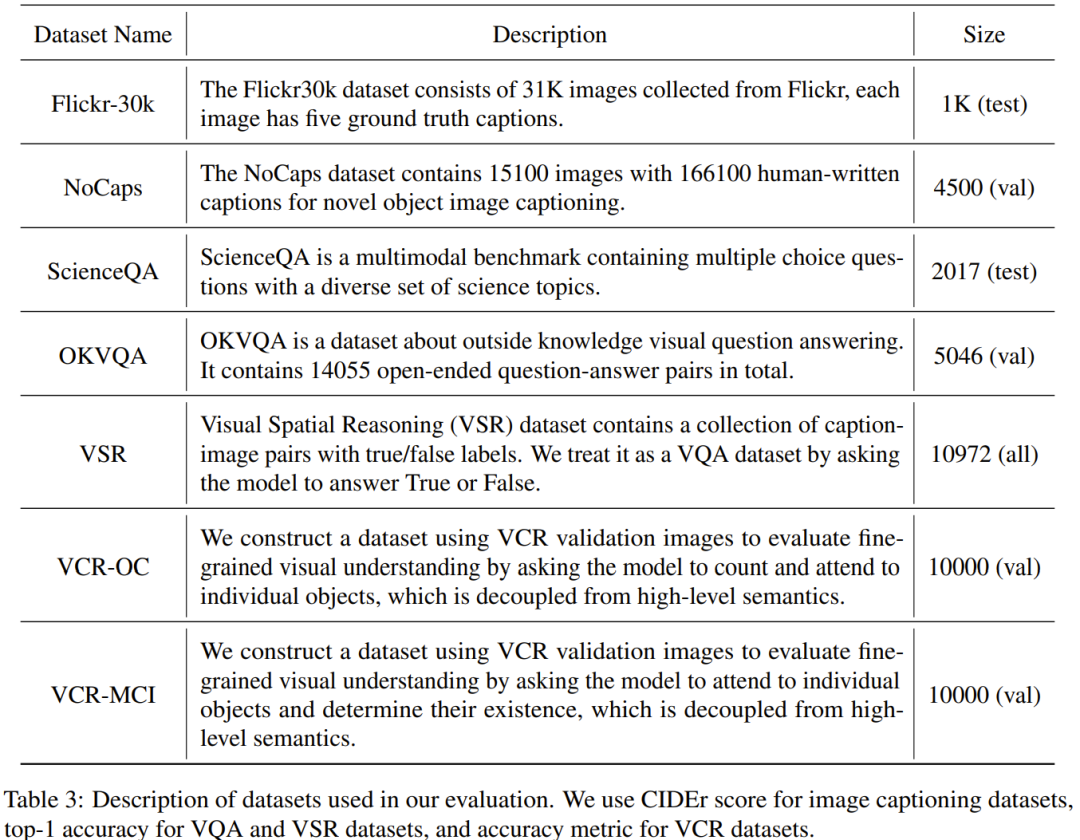

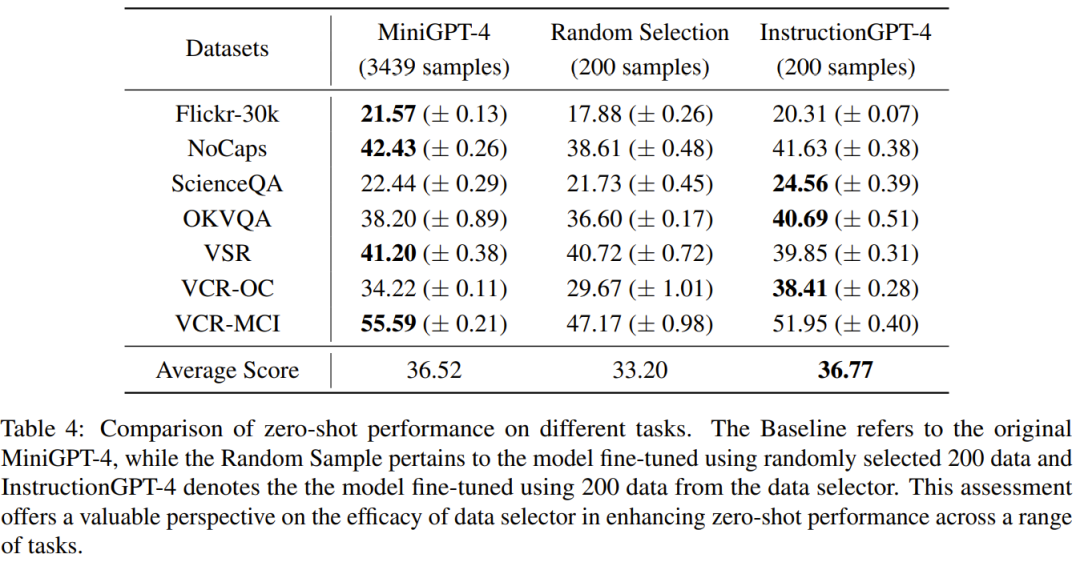

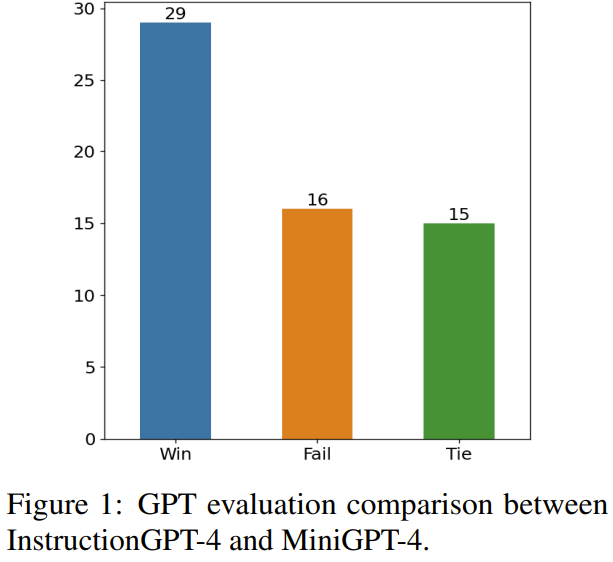

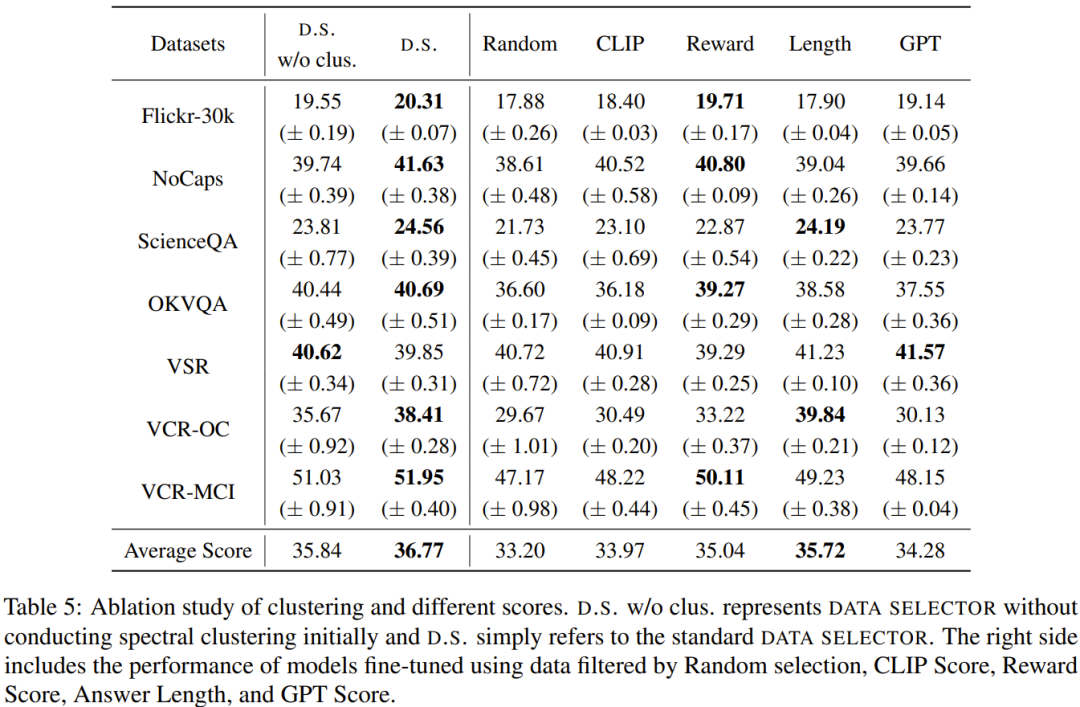

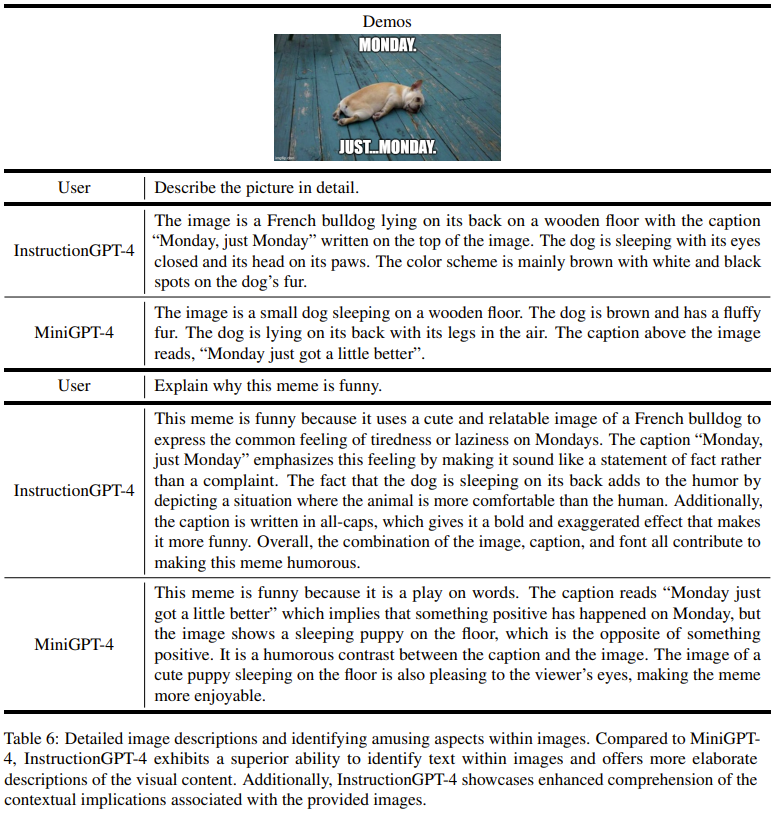

본 연구의 목표는 원본 미세 조정 데이터 세트에서 하위 집합을 자동으로 선택할 수 있는 간단하고 이식 가능한 데이터 선택기를 제안하는 것입니다. 이를 위해 연구자들은 다중 모드 데이터 세트의 다양성과 품질에 초점을 맞춘 선택 원칙을 정의했습니다. 아래에 간략한 소개를 드리겠습니다. MLLM을 효과적으로 훈련시키기 위해서는 유용한 다중 모드 명령 데이터를 선택하는 것이 중요합니다. 최적의 지시 데이터를 선택하기 위해 연구자들은 다양성과 품질이라는 두 가지 핵심 원칙을 제안했습니다. 다양성을 위해 연구자들이 취하는 접근 방식은 이미지 임베딩을 클러스터링하여 데이터를 여러 그룹으로 분리하는 것입니다. 품질을 평가하기 위해 연구원들은 다중 모드 데이터의 효율적인 평가를 위해 몇 가지 주요 지표를 채택했습니다. 시각적 언어 교육 데이터 세트와 사전 훈련된 MLLM(예: MiniGPT-4 및 LLaVA)이 제공되면 데이터 선택기의 궁극적인 목표는 사전 훈련된 MLLM을 개선하기 위해 미세 조정하고 이 하위 집합을 활성화하는 데 사용되는 하위 집합입니다. 이 하위 집합을 선택하고 다양성을 보장하기 위해 연구원은 먼저 클러스터링 알고리즘을 사용하여 원본 데이터 집합을 여러 범주로 나눴습니다. 선택된 다중 모드 명령 데이터의 품질을 보장하기 위해 연구원들은 아래 표 1과 같이 평가를 위한 일련의 지표를 개발했습니다. 표 2는 최종 점수 계산 시 각 점수의 가중치를 보여줍니다. 알고리즘 1은 데이터 선택기의 전체 작업 흐름을 보여줍니다. 실험 평가에 사용된 데이터 세트는 아래 표 3과 같습니다. 표 4는 MiniGPT-4 기준 모델, 무작위로 샘플링된 데이터를 사용하여 미세 조정된 MiniGPT-4, 데이터 선택기를 사용하여 미세 조정된 InstructionGPT-4의 성능을 비교합니다. . InstructionGPT-4의 평균 성능이 가장 좋은 것을 확인할 수 있습니다. 구체적으로, InstructionGPT-4는 ScienceQA에서 기본 모델보다 2.12% 더 나은 성능을 보였고, OKVQA와 VCR-OC에서는 각각 2.49%와 4.19% 더 나은 성능을 보였습니다. 또한 InstructionGPT-4는 VSR을 제외한 다른 모든 작업에서 무작위 샘플로 훈련된 모델보다 성능이 뛰어납니다. 다양한 작업에 대해 이러한 모델을 평가하고 비교함으로써 각각의 기능을 식별하고 고품질 데이터를 효과적으로 식별하는 새로 제안된 데이터 선택기의 효율성을 판단할 수 있습니다. 이러한 포괄적인 분석은 현명한 데이터 선택이 다양한 작업에서 모델의 제로샷 성능을 향상시킬 수 있음을 보여줍니다. 1) 승리: InstructionGPT-4 두 상황 모두 승리하거나 한 번 승리하고 한 번 무승부 2) 무승부: InstructionGPT -4 및 MiniGPT-4는 두 번 무승부 또는 한 번 승리하고 한 번 패배합니다. 3) 패배: InstructionGPT-4가 두 번 패배하거나 한 번 패배하고 한 번 무승부합니다. 그림 1은 이 평가 방법의 결과를 보여줍니다. 60개 질문에서 InstructionGPT-4는 29승, 16패, 나머지 15경기 동점을 기록했습니다. 이는 응답 품질 측면에서 InstructionGPT-4가 MiniGPT-4보다 훨씬 우수하다는 것을 입증하기에 충분합니다. Table 5는 Ablation 실험의 분석 결과로, 클러스터링 알고리즘과 다양한 평가 점수의 중요성을 알 수 있다. 시각적 입력을 이해하고 합리적인 응답을 생성하는 InstructionGPT-4의 능력을 더 깊이 이해하기 위해 연구원들은 InstructionGPT-4에 대한 실험도 수행했습니다. MiniGPT-4 이미지 이해력과 대화 능력을 비교 평가했습니다. 분석은 이미지에 대한 설명 및 추가 이해와 관련된 놀라운 예를 기반으로 하며 결과는 표 6에 나와 있습니다. InstructionGPT-4는 포괄적인 이미지 설명을 제공하고 이미지의 흥미로운 측면을 식별하는 데 더 좋습니다. MiniGPT-4에 비해 InstructionGPT-4는 이미지에 있는 텍스트를 더 잘 인식할 수 있습니다. 여기서 InstructionGPT-4는 이미지에 Monday, just Monday라는 문구가 있음을 정확하게 지적할 수 있습니다.위 내용은 200개의 데이터를 선택한 후 동일한 모델을 매칭하여 MiniGPT-4를 능가했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!