인과 컨벌루션 신경망

인과 컨벌루션 신경망은 시계열 데이터의 인과성 문제를 위해 설계된 특수 컨벌루션 신경망입니다. 기존 합성곱 신경망과 비교하여 인과 합성곱 신경망은 시계열의 인과 관계를 유지하는 데 고유한 장점이 있으며 시계열 데이터의 예측 및 분석에 널리 사용됩니다.

인과 컨볼루션 신경망의 핵심 아이디어는 컨볼루션 연산에 인과성을 도입하는 것입니다. 기존 컨벌루션 신경망은 현재 시점 이전과 이후의 데이터를 동시에 인식할 수 있지만, 시계열 예측에서는 이로 인해 정보 유출 문제가 발생할 수 있습니다. 왜냐하면 현재 시점의 예측 결과는 미래 시점의 데이터에 의해 영향을 받기 때문입니다. 인과 컨벌루션 신경망은 이 문제를 해결합니다. 현재 시점과 이전 데이터만 인식할 수 있고 미래 데이터는 인식할 수 없으므로 시계열 데이터의 인과 관계를 보장합니다. 따라서 인과 컨벌루션 신경망은 시계열 데이터의 예측 및 분석 문제를 더 잘 처리할 수 있습니다.

인과 컨벌루션 신경망을 구현하는 방법에는 여러 가지가 있으며, 일반적인 방법 중 하나는 인과 컨벌루션 커널을 사용하는 것입니다. 인과 컨볼루션 커널은 현재 시점과 이전 데이터만 인식할 수 있고 미래 데이터는 인식할 수 없는 특수 컨볼루션 커널입니다. 이 설계는 컨볼루션 결과가 미래 데이터에 의해 방해받지 않도록 보장하여 시계열 데이터의 인과성을 가능하게 합니다. 인과 컨벌루션 신경망은 이 속성을 활용하여 시계열 데이터를 처리할 때 인과 관계를 더 잘 포착합니다. 따라서 인과 컨벌루션 커널을 도입함으로써 시계열 데이터를 효과적으로 처리하고 모델의 성능을 향상시킬 수 있다.

인과 컨벌루션 커널 외에도 인과 풀링 및 잔차 구조 도입과 같은 인과 컨벌루션 신경망의 다른 구현이 있습니다. 인과풀링은 시계열 데이터의 인과관계를 보존하는 특수한 풀링 작업입니다. 인과 풀링에서 각 풀링 창에는 현재 시점과 이전의 데이터만 포함되며 미래 데이터는 포함되지 않습니다. 이는 정보 유출을 효과적으로 방지하고 모델의 안정성과 견고성을 향상시킵니다.

먼저 필요한 라이브러리와 모듈을 가져와야 합니다.

import torch import torch.nn as nn import torch.optim as optim import numpy as np import pandas as pd from sklearn.preprocessing import MinMaxScaler

그런 다음 데이터를 읽고 처리합니다.

data = pd.read_csv('temperature.csv') scaler = MinMaxScaler(feature_range=(-1, 1)) data['scaled_temperature'] = scaler.fit_transform(data['temperature'].values.reshape(-1, 1)) data.drop(['temperature'], axis=1, inplace=True)

그런 다음 데이터 세트를 훈련 세트와 테스트 세트로 나눕니다.

train_size = int(len(data) * 0.8) test_size = len(data) - train_size train_data, test_data = data.iloc[0:train_size], data.iloc[train_size:len(data)]

다음으로 인과 컨벌루션 신경망 모델을 정의합니다.

class CCN(nn.Module):

def __init__(self, input_size, output_size, num_filters, kernel_size):

super(CCN, self).__init__()

self.conv1 = nn.Conv1d(input_size, num_filters, kernel_size, padding=kernel_size - 1)

self.conv2 = nn.Conv1d(num_filters, num_filters, kernel_size, padding=kernel_size - 1)

self.conv3 = nn.Conv1d(num_filters, num_filters, kernel_size, padding=kernel_size - 1)

self.conv4 = nn.Conv1d(num_filters, num_filters, kernel_size, padding=kernel_size - 1)

self.conv5 = nn.Conv1d(num_filters, num_filters, kernel_size, padding=kernel_size - 1)

self.conv6 = nn.Conv1d(num_filters, num_filters, kernel_size, padding=kernel_size - 1)

self.conv7 = nn.Conv1d(num_filters, num_filters, kernel_size, padding=kernel_size - 1)

self.conv8 = nn.Conv1d(num_filters, num_filters, kernel_size, padding=kernel_size - 1)

self.conv9 = nn.Conv1d(num_filters, num_filters, kernel_size, padding=kernel_size - 1)

self.conv10 = nn.Conv1d(num_filters, output_size, kernel_size, padding=kernel_size - 1)

def forward(self, x):

x = torch.relu(self.conv1(x))

x = torch.relu(self.conv2(x))

x = torch.relu(self.conv3(x))

x = torch.relu(self.conv4(x))

x = torch.relu(self.conv5(x))

x = torch.relu(self.conv6(x))

x = torch.relu(self.conv7(x))

x = torch.relu(self.conv8(x))

x = torch.relu(self.conv9(x))

x = self.conv10(x)

return x모델 정의가 완료되면 데이터를 모델에 입력할 수 있도록 전처리해야 합니다. 데이터를 PyTorch의 Tensor 유형으로 변환하고 이를 3D 텐서, 즉 (batch_size, 시퀀스_길이, input_size) 형식으로 변환합니다.

def create_sequences(data, seq_length):

xs = []

ys = []

for i in range(len(data) - seq_length - 1):

x = data[i:(i + seq_length)]

y = data[i + seq_length]

xs.append(x)

ys.append(y)

return np.array(xs), np.array(ys)

sequence_length = 10

trainX, trainY = create_sequences(train_data['scaled_temperature'], sequence_length)

testX, testY = create_sequences(test_data['scaled_temperature'], sequence_length)

trainX = torch.from_numpy(trainX).float()

trainY = torch.from_numpy(trainY).float()

testX = torch.from_numpy(testX).float()

testY = torch.from_numpy(testY).float()

trainX = trainX.view(-1, sequence_length, 1)

trainY = trainY.view(-1, 1)

testX = testX.view(-1, sequence_length, 1)

testY = testY.view(-1, 1)다음으로 학습 프로세스를 정의합니다.

num_epochs = 1000

learning_rate = 0.001

num_filters = 64

kernel_size = 2

model = CCN(input_size=1, output_size=1, num_filters=num_filters, kernel_size=kernel_size)

criterion = nn.MSELoss()

optimizer= optim.Adam(model.parameters(), lr=learning_rate)

for epoch in range(num_epochs):

optimizer.zero_grad()

outputs = model(trainX)

loss = criterion(outputs, trainY)

loss.backward()

optimizer.step()

if epoch % 100 == 0:

print('Epoch [{}/{}], Loss: {:.4f}'.format(epoch+1, num_epochs, loss.item()))마지막으로 테스트 세트를 사용합니다. 모델 테스트하기 평가:

with torch.no_grad():

test_outputs = model(testX)

test_loss = criterion(test_outputs, testY)

print('Test Loss: {:.4f}'.format(test_loss.item()))

test_outputs = scaler.inverse_transform(test_outputs.numpy())

testY = scaler.inverse_transform(testY.numpy())

test_outputs = np.squeeze(test_outputs)

testY = np.squeeze(testY)

plt.plot(test_outputs, label='Predicted')

plt.plot(testY, label='True')

plt.legend()

plt.show()위는 시계열 데이터를 예측하는 데 사용할 수 있는 간단한 인과 컨벌루션 신경망 모델의 구현 과정입니다. 실제 애플리케이션에서는 더 나은 성능을 달성하기 위해 특정 작업에 따라 모델을 조정하고 최적화해야 할 수도 있습니다.

기존의 컨벌루션 신경망과 비교하여 인과 컨볼루션 신경망은 시계열 데이터를 처리할 때 고유한 이점을 갖습니다. 정보 유출 문제를 효과적으로 방지하고 시계열의 인과 관계를 더 잘 보존할 수 있습니다. 따라서 시계열 데이터의 예측 및 분석에서 인과 컨벌루션 신경망은 일부 작업에서 좋은 성능을 보였습니다. 예를 들어, 음성 인식, 자연어 처리, 주식 예측과 같은 분야에서는 인과 컨벌루션 신경망이 널리 사용되어 몇 가지 인상적인 결과를 얻었습니다.

위 내용은 인과 컨벌루션 신경망의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7510

7510

15

15

1378

1378

52

52

78

78

11

11

53

53

19

19

19

19

64

64

RNN, LSTM 및 GRU의 개념, 차이점, 장점 및 단점을 살펴보세요.

Jan 22, 2024 pm 07:51 PM

RNN, LSTM 및 GRU의 개념, 차이점, 장점 및 단점을 살펴보세요.

Jan 22, 2024 pm 07:51 PM

시계열 데이터에서는 관측값 간에 종속성이 있으므로 서로 독립적이지 않습니다. 그러나 기존 신경망은 각 관측값을 독립적인 것으로 취급하므로 시계열 데이터를 모델링하는 모델의 기능이 제한됩니다. 이 문제를 해결하기 위해 네트워크의 데이터 포인트 간의 종속성을 설정하여 시계열 데이터의 동적 특성을 캡처하는 메모리 개념을 도입한 RNN(Recurrent Neural Network)이 도입되었습니다. RNN은 반복 연결을 통해 이전 정보를 현재 관찰에 전달하여 미래 값을 더 잘 예측할 수 있습니다. 이는 RNN을 시계열 데이터와 관련된 작업을 위한 강력한 도구로 만듭니다. 그러나 RNN은 어떻게 이런 종류의 메모리를 달성합니까? RNN은 신경망의 피드백 루프를 통해 메모리를 구현합니다. 이것이 RNN과 기존 신경망의 차이점입니다.

신경망의 FLOPS(부동 소수점 피연산자) 계산

Jan 22, 2024 pm 07:21 PM

신경망의 FLOPS(부동 소수점 피연산자) 계산

Jan 22, 2024 pm 07:21 PM

FLOPS는 컴퓨터 성능 평가 표준 중 하나로 초당 부동 소수점 연산 횟수를 측정하는 데 사용됩니다. 신경망에서 FLOPS는 모델의 계산 복잡성과 컴퓨팅 리소스 활용도를 평가하는 데 자주 사용됩니다. 컴퓨터의 컴퓨팅 성능과 효율성을 측정하는 데 사용되는 중요한 지표입니다. 신경망은 데이터 분류, 회귀, 클러스터링과 같은 작업을 수행하는 데 사용되는 여러 계층의 뉴런으로 구성된 복잡한 모델입니다. 신경망의 훈련 및 추론에는 수많은 행렬 곱셈, 컨볼루션 및 기타 계산 작업이 필요하므로 계산 복잡성이 매우 높습니다. FLOPS(FloatingPointOperationsperSecond)는 신경망의 계산 복잡성을 측정하여 모델의 계산 리소스 사용 효율성을 평가하는 데 사용할 수 있습니다. 실패

텍스트 분류를 위한 양방향 LSTM 모델 사용 사례 연구

Jan 24, 2024 am 10:36 AM

텍스트 분류를 위한 양방향 LSTM 모델 사용 사례 연구

Jan 24, 2024 am 10:36 AM

양방향 LSTM 모델은 텍스트 분류에 사용되는 신경망입니다. 다음은 텍스트 분류 작업에 양방향 LSTM을 사용하는 방법을 보여주는 간단한 예입니다. 먼저 필요한 라이브러리와 모듈을 가져와야 합니다. importosimportnumpyasnpfromkeras.preprocessing.textimportTokenizerfromkeras.preprocessing.sequenceimportpad_sequencesfromkeras.modelsimportSequentialfromkeras.layersimportDense,Em

퍼지 신경망의 정의 및 구조 분석

Jan 22, 2024 pm 09:09 PM

퍼지 신경망의 정의 및 구조 분석

Jan 22, 2024 pm 09:09 PM

퍼지 신경망은 퍼지 논리와 신경망을 결합하여 기존 신경망으로 처리하기 어려운 퍼지 또는 불확실한 문제를 해결하는 하이브리드 모델입니다. 그 디자인은 인간 인지의 모호함과 불확실성에서 영감을 얻어 제어 시스템, 패턴 인식, 데이터 마이닝 및 기타 분야에서 널리 사용됩니다. 퍼지 신경망의 기본 아키텍처는 퍼지 하위 시스템과 신경 하위 시스템으로 구성됩니다. 퍼지 하위 시스템은 퍼지 논리를 사용하여 입력 데이터를 처리하고 이를 퍼지 세트로 변환하여 입력 데이터의 퍼지 및 불확실성을 표현합니다. 신경 하위 시스템은 신경망을 사용하여 분류, 회귀 또는 클러스터링과 같은 작업을 위한 퍼지 세트를 처리합니다. 퍼지 하위 시스템과 신경 하위 시스템 간의 상호 작용으로 인해 퍼지 신경망은 더욱 강력한 처리 능력을 갖게 되며 다음과 같은 작업을 수행할 수 있습니다.

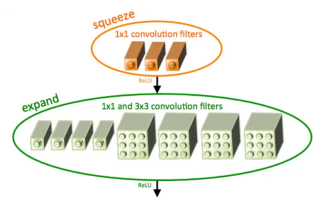

SqueezeNet 소개 및 특징

Jan 22, 2024 pm 07:15 PM

SqueezeNet 소개 및 특징

Jan 22, 2024 pm 07:15 PM

SqueezeNet은 높은 정확도와 낮은 복잡성 사이의 적절한 균형을 유지하는 작고 정밀한 알고리즘으로, 리소스가 제한된 모바일 및 임베디드 시스템에 이상적입니다. 2016년 DeepScale, University of California, Berkeley 및 Stanford University의 연구원들은 작고 효율적인 CNN(컨볼루션 신경망)인 SqueezeNet을 제안했습니다. 최근 몇 년 동안 연구원들은 SqueezeNetv1.1 및 SqueezeNetv2.0을 포함하여 SqueezeNet에 대한 몇 가지 개선 사항을 적용했습니다. 두 버전 모두의 개선으로 정확도가 향상될 뿐만 아니라 계산 비용도 절감됩니다. ImageNet 데이터 세트에서 SqueezeNetv1.1의 정확도

컨벌루션 신경망을 사용한 이미지 노이즈 제거

Jan 23, 2024 pm 11:48 PM

컨벌루션 신경망을 사용한 이미지 노이즈 제거

Jan 23, 2024 pm 11:48 PM

컨벌루션 신경망은 이미지 노이즈 제거 작업에서 좋은 성능을 발휘합니다. 학습된 필터를 활용하여 노이즈를 필터링하고 원본 이미지를 복원합니다. 본 논문에서는 컨볼루셔널 신경망을 기반으로 한 이미지 노이즈 제거 방법을 자세히 소개합니다. 1. 합성곱 신경망 개요 합성곱 신경망은 다중 합성곱 레이어, 풀링 레이어 및 완전 연결 레이어의 조합을 사용하여 이미지 특징을 학습하고 분류하는 딥러닝 알고리즘입니다. 컨볼루션 레이어에서는 컨볼루션 연산을 통해 이미지의 국소적 특징을 추출하여 이미지의 공간적 상관관계를 포착합니다. 풀링 레이어는 특징 차원을 줄여 계산량을 줄이고 주요 특징을 유지합니다. 완전 연결 계층은 학습된 특징과 레이블을 매핑하여 이미지 분류 또는 기타 작업을 구현하는 역할을 합니다. 이 네트워크 구조의 설계는 컨볼루션 신경망을 이미지 처리 및 인식에 유용하게 만듭니다.

트윈 신경망: 원리 및 응용 분석

Jan 24, 2024 pm 04:18 PM

트윈 신경망: 원리 및 응용 분석

Jan 24, 2024 pm 04:18 PM

Siamese Neural Network는 독특한 인공 신경망 구조입니다. 이는 동일한 매개변수와 가중치를 공유하는 두 개의 동일한 신경망으로 구성됩니다. 동시에 두 네트워크는 동일한 입력 데이터도 공유합니다. 이 디자인은 두 개의 신경망이 구조적으로 동일하기 때문에 쌍둥이에서 영감을 받았습니다. 샴 신경망의 원리는 두 입력 데이터 간의 유사성이나 거리를 비교하여 이미지 매칭, 텍스트 매칭, 얼굴 인식 등의 특정 작업을 완료하는 것입니다. 훈련 중에 네트워크는 유사한 데이터를 인접한 지역에 매핑하고 서로 다른 데이터를 먼 지역에 매핑하려고 시도합니다. 이러한 방식으로 네트워크는 서로 다른 데이터를 분류하거나 일치시키는 방법을 학습하여 해당 데이터를 달성할 수 있습니다.

Rust를 사용하여 간단한 신경망을 작성하는 단계

Jan 23, 2024 am 10:45 AM

Rust를 사용하여 간단한 신경망을 작성하는 단계

Jan 23, 2024 am 10:45 AM

Rust는 안전, 성능 및 동시성에 초점을 맞춘 시스템 수준 프로그래밍 언어입니다. 운영 체제, 네트워크 애플리케이션, 임베디드 시스템과 같은 시나리오에 적합한 안전하고 신뢰할 수 있는 프로그래밍 언어를 제공하는 것을 목표로 합니다. Rust의 보안은 주로 소유권 시스템과 차용 검사기라는 두 가지 측면에서 비롯됩니다. 소유권 시스템을 사용하면 컴파일러는 컴파일 타임에 코드에서 메모리 오류를 확인할 수 있으므로 일반적인 메모리 안전 문제를 피할 수 있습니다. 컴파일 타임에 변수 소유권 이전을 강제로 검사함으로써 Rust는 메모리 자원이 적절하게 관리되고 해제되도록 보장합니다. 빌림 검사기는 변수의 수명 주기를 분석하여 동일한 변수가 여러 스레드에서 동시에 액세스되지 않도록 하여 일반적인 동시성 보안 문제를 방지합니다. 이 두 가지 메커니즘을 결합함으로써 Rust는 다음을 제공할 수 있습니다.