Jia Yangqing의 대규모 추론 비용 고효율 순위가 공개되었습니다.

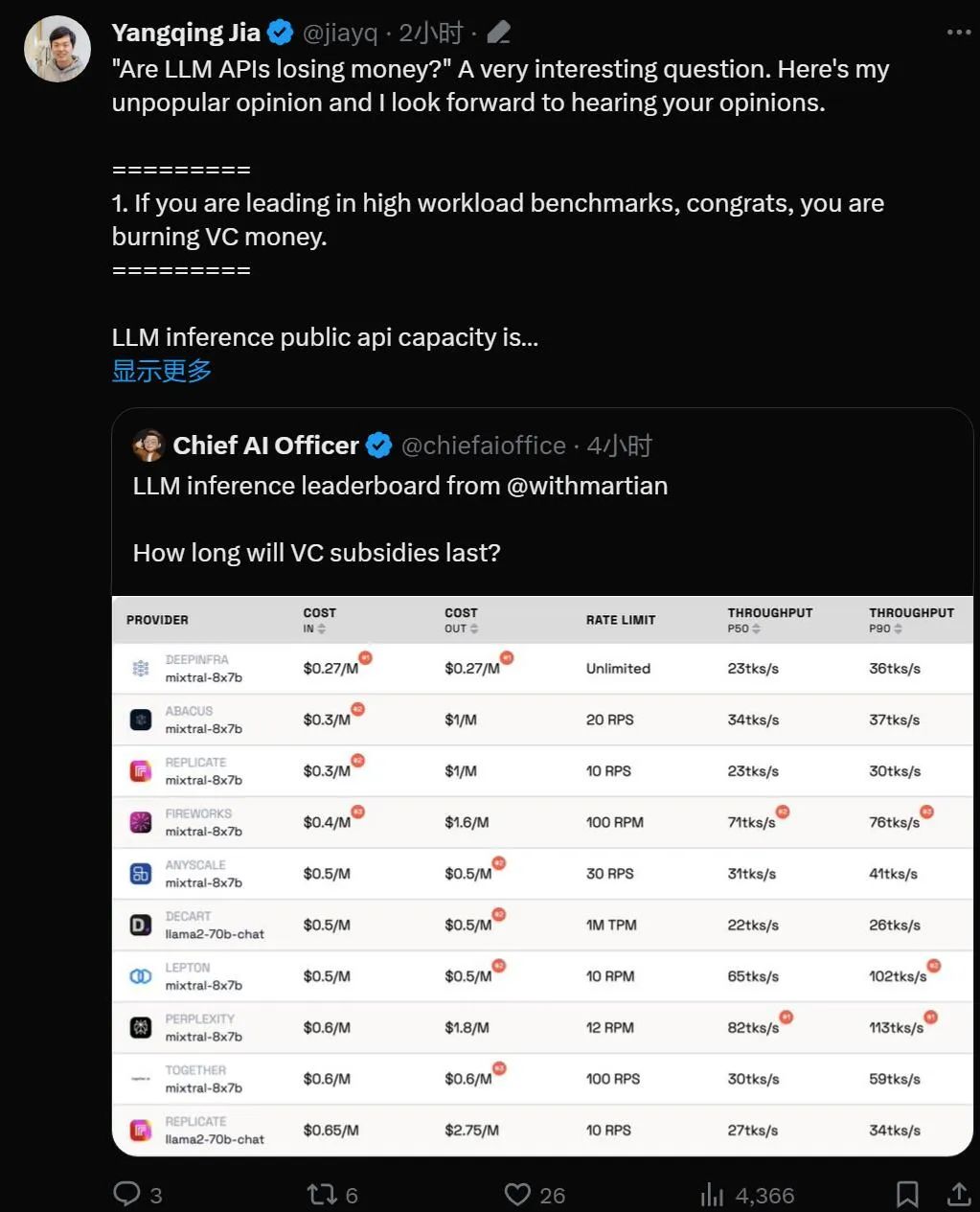

"대형 모델 API는 손실을 가져오는 거래입니까?"

대형 언어 모델 기술이 실용화되면서 많은 기술 회사에서 개발자가 사용할 수 있는 대형 모델 API를 출시했습니다. 그러나 특히 OpenAI가 하루 70만 달러를 지출하고 있다는 점을 고려하면 대형 모델을 기반으로 한 비즈니스가 지속될 수 있을지 의문이 들지 않을 수 없습니다.

이번 주 목요일, AI 스타트업 마션이 우리를 위해 세심하게 계산해 주었습니다.

순위 링크: https://leaderboard.withmartian.com/

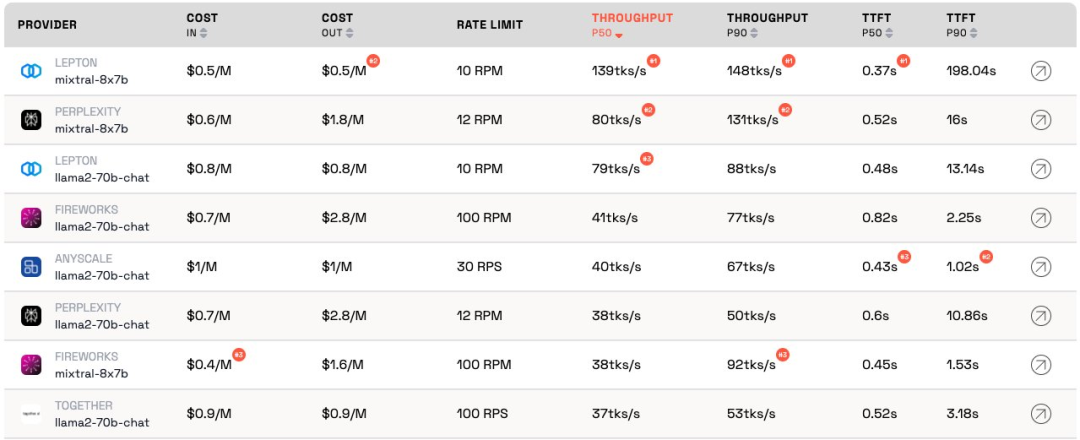

LLM Inference Provider Leaderboard는 대형 모델을 위한 API 추론 제품의 오픈 소스 순위입니다. 비용, 속도 제한을 벤치마킹합니다. , 처리량, 각 공급업체의 Mixtral-8x7B 및 Llama-2-70B-Chat 공개 엔드포인트에 대한 P50 및 P90 TTFT입니다.

서로 경쟁하지만 Martian은 각 회사의 대규모 모델 서비스가 비용에 따라 처리량 및 속도 제한에 상당한 차이가 있습니다. 이러한 차이는 5배의 비용 차이, 6배의 처리량 차이, 심지어 더 큰 속도 제한 차이를 초과합니다. 다양한 API를 선택하는 것은 비즈니스 수행의 일부일지라도 최고의 성능을 얻는 데 중요합니다.

현재 순위에 따르면 Anyscale에서 제공하는 서비스는 Llama-2-70B의 중간 서비스 로드에서 최고의 처리량을 보입니다. 대규모 서비스 로드의 경우 Together AI는 Llama-2-70B 및 Mixtral-8x7B에서 P50 및 P90 처리량으로 가장 좋은 성능을 발휘했습니다.

또한 Jia Yangqing의 LeptonAI는 짧은 입력 및 긴 출력 신호로 작은 작업 로드를 처리할 때 최고의 처리량을 보여주었습니다. 130tks/s의 P50 처리량은 현재 시장에 나와 있는 모든 제조업체가 제공하는 모델 중에서 가장 빠릅니다.

저명 AI 학자이자 Lepton AI의 창립자인 Jia Yangqing이 순위가 공개된 직후에 그가 말한 내용을 살펴보겠습니다.

Jia Yangqing은 먼저 인공 지능 분야의 업계 현황을 설명한 후 벤치마크 테스트의 중요성을 확인한 후 마지막으로 LeptonAI가 사용자가 최고의 기본 AI 전략을 찾는 데 도움이 될 것이라고 지적했습니다.

1. 빅 모델 API는 "돈을 태운다"

모델이 높은 워크로드 벤치마크에서 앞서면 축하합니다. "돈을 태운다".

LLM 공개 API의 용량에 대해 추론하는 것은 레스토랑을 운영하는 것과 같습니다. 요리사가 있고 고객 트래픽을 추정해야 합니다. 요리사를 고용하는 데에는 돈이 듭니다. 지연 시간과 처리량은 "고객을 위해 얼마나 빨리 요리할 수 있는지"로 이해될 수 있습니다. 합리적인 사업을 위해서는 "합리적인" 수의 셰프가 필요합니다. 즉, 몇 초 만에 발생하는 갑작스러운 트래픽 폭주가 아니라 정상적인 트래픽을 처리할 수 있는 용량을 원합니다. 교통량이 급증한다는 것은 기다리는 것을 의미합니다. 그렇지 않으면 "요리사"는 할 일이 없습니다.

인공지능의 세계에서는 GPU가 '요리사' 역할을 합니다. 기본 로드가 폭증합니다. 작업 부하가 낮은 경우 기준 부하가 일반 트래픽과 혼합되며, 측정 결과는 현재 작업 부하에서 서비스가 어떻게 수행되는지 정확하게 나타냅니다.

높은 서비스 로드 시나리오는 중단을 유발하기 때문에 흥미롭습니다. 벤치마크는 하루/주에 몇 번만 실행되므로 일반적인 트래픽은 아닙니다. 요리사가 얼마나 빨리 요리하는지 확인하기 위해 100명의 사람들이 현지 레스토랑에 모여들었다고 상상해 보세요. 양자물리학 용어를 빌리자면, 이것을 '관찰자 효과'라고 합니다. 간섭이 강할수록(즉, 버스트 부하가 클수록) 정확도는 낮아집니다. 즉, 서비스에 갑자기 높은 부하를 가하고 서비스가 매우 빠르게 응답하는 것을 보면 서비스에 유휴 용량이 꽤 많다는 것을 알 수 있습니다. 투자자로서 이러한 상황을 볼 때 다음과 같이 질문해야 합니다. 이렇게 돈을 소각하는 방식이 책임이 있습니까?

2. 이 모델은 결국 비슷한 성능을 발휘하게 됩니다

인공지능 분야는 경쟁적인 경쟁을 좋아하는데, 정말 흥미롭습니다. 모두가 동일한 솔루션으로 신속하게 수렴하고 GPU 덕분에 Nvidia가 항상 승리합니다. 이는 훌륭한 오픈 소스 프로젝트 덕분에 vLLM이 좋은 예입니다. 즉, 공급자로서 자신의 모델이 다른 모델보다 성능이 훨씬 떨어지더라도 오픈 소스 솔루션을 살펴보고 우수한 엔지니어링을 적용하면 쉽게 따라잡을 수 있습니다.

3. "고객으로서 나는 공급자의 비용에 관심이 없습니다."

AI 애플리케이션 빌더에게는 운이 좋습니다. 항상 "돈을 태울" 의향이 있는 API 공급자가 있습니다. AI 업계는 트래픽 확보를 위해 돈을 태우고 있고, 다음 단계는 이익을 걱정하는 것이다.

벤치마킹은 지루하고 오류가 발생하기 쉬운 작업입니다. 좋든 나쁘든 승자는 당신을 칭찬하고 패자는 당신을 비난하는 경우가 많습니다. 컨볼루셔널 신경망 벤치마크의 마지막 라운드에서도 마찬가지였습니다. 쉬운 작업은 아니지만 벤치마킹은 AI 인프라에서 다음 10배를 달성하는 데 도움이 될 것입니다.

LeptonAI는 인공지능 프레임워크와 클라우드 인프라를 기반으로 사용자가 최고의 AI 기본 전략을 찾을 수 있도록 도와줍니다.

위 내용은 Jia Yangqing의 대규모 추론 비용 고효율 순위가 공개되었습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7699

7699

15

15

1640

1640

14

14

1393

1393

52

52

1287

1287

25

25

1230

1230

29

29

크로스 체인 거래는 무엇을 의미합니까? 크로스 체인 거래는 무엇입니까?

Apr 21, 2025 pm 11:39 PM

크로스 체인 거래는 무엇을 의미합니까? 크로스 체인 거래는 무엇입니까?

Apr 21, 2025 pm 11:39 PM

크로스 체인 거래를 지원하는 교환 : 1. Binance, 2. Uniswap, 3. Sushiswap, 4. Curve Finance, 5. Thorchain, 6. 1inch Exchange, 7. DLN 거래,이 플랫폼은 다양한 기술을 통해 다중 체인 자산 거래를 지원합니다.

Worldcoin (WLD) 가격 예측 2025-2031 : WLD가 2031 년까지 4 달러에 도달 할 것인가?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) 가격 예측 2025-2031 : WLD가 2031 년까지 4 달러에 도달 할 것인가?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD)은 Cryptocurrency 시장에서 고유 한 생체 인정 및 개인 정보 보호 메커니즘으로 눈에 띄고 많은 투자자의 관심을 끌고 있습니다. WLD는 혁신적인 기술, 특히 OpenAi 인공 지능 기술과 함께 Altcoins에서 뛰어난 성과를 거두었습니다. 그러나 향후 몇 년 안에 디지털 자산은 어떻게 행동 할 것인가? WLD의 미래 가격을 함께 예측합시다. 2025 WLD 가격 예측은 2025 년 WLD에서 상당한 성장을 달성 할 것으로 예상됩니다. 시장 분석에 따르면 평균 WLD 가격은 최대 $ 1.36로 $ 1.31에 도달 할 수 있습니다. 그러나 곰 시장에서 가격은 약 $ 0.55로 떨어질 수 있습니다. 이러한 성장 기대는 주로 WorldCoin2에 기인합니다.

'Black Monday Sell'은 Cryptocurrency 업계의 힘든 날입니다.

Apr 21, 2025 pm 02:48 PM

'Black Monday Sell'은 Cryptocurrency 업계의 힘든 날입니다.

Apr 21, 2025 pm 02:48 PM

cryptocurrency 시장의 급락으로 인해 투자자들 사이에 공황이 발생했으며 Dogecoin (Doge)은 가장 어려운 지역 중 하나가되었습니다. 가격은 급격히 하락했으며 분산 금융 (DEFI) (TVL)의 총 가치 잠금 장치도 크게 감소했습니다. "Black Monday"의 판매 물결은 cryptocurrency 시장을 휩쓸었고 Dogecoin은 처음으로 타격을 받았습니다. DefitVl은 2023 년 수준으로 떨어졌고 지난 달 통화 가격은 23.78% 하락했습니다. Dogecoin의 Defitvl은 주로 SOSO 가치 지수의 26.37% 감소로 인해 272 만 달러로 떨어졌습니다. 지루한 Dao 및 Thorchain과 같은 다른 주요 Defi 플랫폼도 TVL도 각각 24.04% 및 20으로 떨어졌습니다.

가상 통화 가격의 상승 또는 하락은 왜입니까? 가상 통화 가격의 상승 또는 하락은 왜입니까?

Apr 21, 2025 am 08:57 AM

가상 통화 가격의 상승 또는 하락은 왜입니까? 가상 통화 가격의 상승 또는 하락은 왜입니까?

Apr 21, 2025 am 08:57 AM

가상 통화 가격 상승의 요인은 다음과 같습니다. 1. 시장 수요 증가, 2. 공급 감소, 3. 긍정적 인 뉴스, 4. 낙관적 시장 감정, 5. 거시 경제 환경; 감소 요인에는 다음이 포함됩니다. 1. 시장 수요 감소, 2. 공급 증가, 3. 부정적인 뉴스의 파업, 4. 비관적 시장 감정, 5. 거시 경제 환경.

Web3 Trading Platform Ranking_Web3 글로벌 교환 상위 10 개 요약

Apr 21, 2025 am 10:45 AM

Web3 Trading Platform Ranking_Web3 글로벌 교환 상위 10 개 요약

Apr 21, 2025 am 10:45 AM

Binance는 Global Digital Asset Trading Ecosystem의 대 군주이며, 그 특성에는 다음이 포함됩니다. 1. 평균 일일 거래량은 1,500 억 달러를 초과하여 주류 통화의 98%를 차지하며 500 개의 거래 쌍을 지원합니다. 2. 혁신 매트릭스는 파생 상품 시장, Web3 레이아웃 및 교육 시스템을 포함합니다. 3. 기술적 이점은 밀리 초에 일치하는 엔진이며, 최고 처리량은 초당 140 만 건의 트랜잭션입니다. 4. 규정 준수 진행 상황은 15 개국 라이센스를 보유하고 있으며 유럽과 미국에 준수 엔티티를 설립합니다.

Binance 전체 프로세스 전략에 대한 커널 에어 드롭 보상을받는 방법

Apr 21, 2025 pm 01:03 PM

Binance 전체 프로세스 전략에 대한 커널 에어 드롭 보상을받는 방법

Apr 21, 2025 pm 01:03 PM

암호 화폐의 번화 한 세계에서는 새로운 기회가 항상 나타납니다. 현재 Kerneldao (Kernel) 에어 드롭 활동은 많은 관심을 끌고 많은 투자자들의 관심을 끌고 있습니다. 그렇다면이 프로젝트의 기원은 무엇입니까? BNB 보유자는 어떤 이점을 얻을 수 있습니까? 걱정하지 마십시오. 다음은 당신을 위해 하나씩 공개 할 것입니다.

통화에서 레버리지 교환 순위 순위 서클 통화 서클에서 상위 10 개의 레버리지 거래소의 최신 권장 사항

Apr 21, 2025 pm 11:24 PM

통화에서 레버리지 교환 순위 순위 서클 통화 서클에서 상위 10 개의 레버리지 거래소의 최신 권장 사항

Apr 21, 2025 pm 11:24 PM

2025 년에 레버리지 거래, 보안 및 사용자 경험에서 뛰어난 성능을 보이는 플랫폼은 다음과 같습니다. 1. OKX, 고주파 거래자에게 적합하여 최대 100 배의 레버리지를 제공합니다. 2. Binance, 전 세계의 다중 통화 거래자에게 적합하며 125 배 높은 레버리지를 제공합니다. 3. Gate.io, 전문 파생 상품 플레이어에게 적합하며 100 배의 레버리지를 제공합니다. 4. 초보자 및 소셜 트레이더에게 적합한 Bitget, 최대 100 배의 레버리지를 제공합니다. 5. 크라켄은 꾸준한 투자자에게 적합하며 5 배의 레버리지를 제공합니다. 6. Bybit, Altcoin Explorers에 적합하며 20 배의 레버리지를 제공합니다. 7. 저비용 거래자에게 적합한 Kucoin, 10 배의 레버리지를 제공합니다. 8. 비트 피 넥스, 시니어 플레이에 적합합니다

Aavenomics는 AAVE 프로토콜 토큰을 수정하고 쿼럼 수의 사람들에게 도달 한 토큰 재구매를 소개하는 권장 사항입니다.

Apr 21, 2025 pm 06:24 PM

Aavenomics는 AAVE 프로토콜 토큰을 수정하고 쿼럼 수의 사람들에게 도달 한 토큰 재구매를 소개하는 권장 사항입니다.

Apr 21, 2025 pm 06:24 PM

Aavenomics는 AAVE 프로토콜 토큰을 수정하고 Aavedao의 쿼럼을 구현 한 Token Repos를 소개하는 제안입니다. AAVE 프로젝트 체인 (ACI)의 설립자 인 Marc Zeller는 X에서 이것을 발표하여 계약의 새로운 시대를 표시한다고 지적했습니다. AAVE 체인 이니셔티브 (ACI)의 설립자 인 Marc Zeller는 AAVENOMICS 제안서에 AAVE 프로토콜 토큰 수정 및 토큰 리포지션 도입이 포함되어 있다고 X에서 AAVEDAO에 대한 쿼럼을 달성했다고 발표했습니다. Zeller에 따르면, 이것은 계약의 새로운 시대를 나타냅니다. Aavedao 회원국은 수요일에 주당 100 인 제안을지지하기 위해 압도적으로 투표했습니다.