며칠 전 OpenAI는 두 개의 새로운 텍스트 임베딩 모델을 포함해 5개의 새로운 모델을 동시에 발표하는 대규모 업데이트를 선보였습니다.

임베딩은 자연어, 코드 등의 개념을 표현하기 위해 숫자 시퀀스를 사용하는 것입니다. 이를 통해 기계 학습 모델 및 기타 알고리즘이 콘텐츠 간의 관계를 더 잘 이해하고 클러스터링 또는 검색과 같은 작업을 더 쉽게 수행할 수 있습니다.

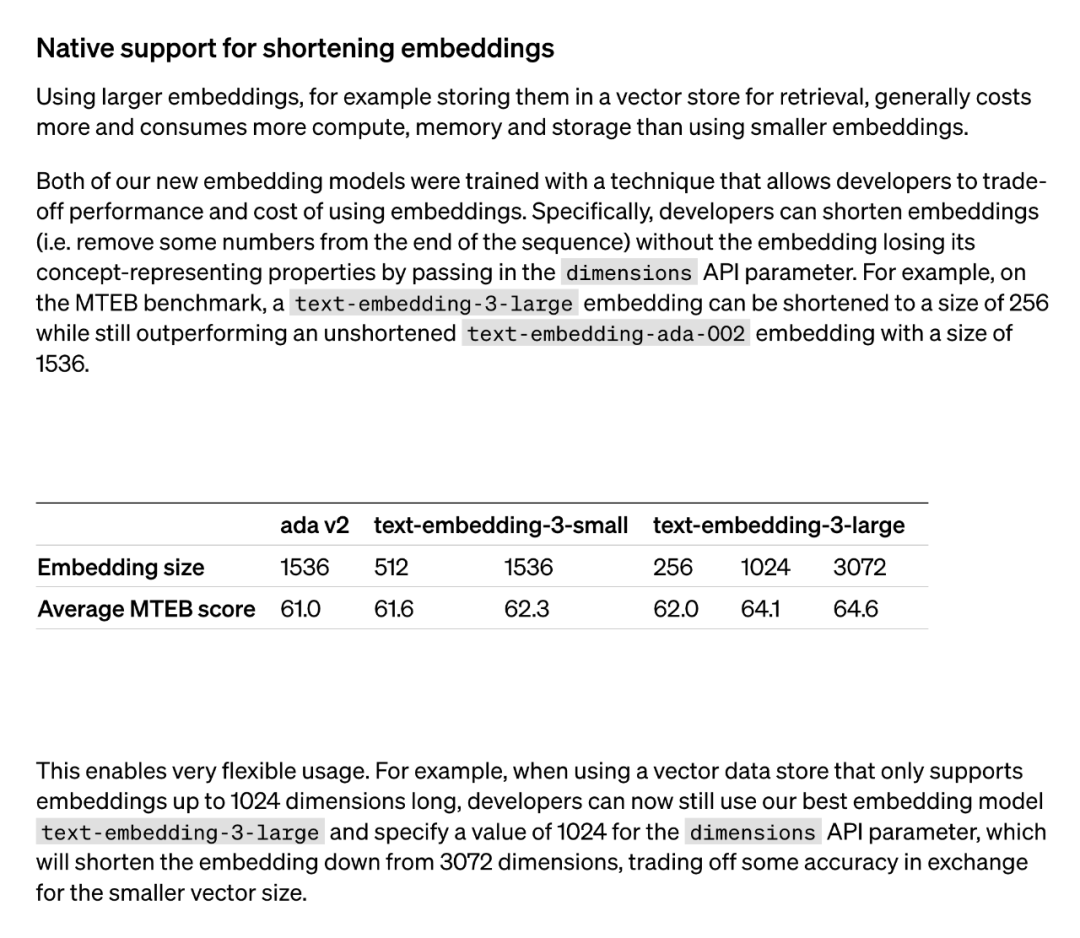

일반적으로 더 큰 임베딩 모델(예: 검색을 위해 벡터 메모리에 저장)을 사용하면 더 많은 비용, 컴퓨팅 성능, 메모리 및 스토리지 리소스가 소비됩니다. 그러나 OpenAI가 출시한 두 가지 텍스트 임베딩 모델은 서로 다른 옵션을 제공합니다. 첫째, text-embedding-3-small 모델은 작지만 효율적인 모델입니다. 리소스가 제한된 환경에서 사용할 수 있으며 텍스트 포함 작업을 처리할 때 성능이 좋습니다. 반면, 텍스트 임베딩-3-대형 모델은 더 크고 강력합니다. 이 모델은 더 복잡한 텍스트 임베딩 작업을 처리하고 더 정확하고 상세한 임베딩 표현을 제공할 수 있습니다. 그러나 이 모델을 사용하려면 더 많은 컴퓨팅 리소스와 저장 공간이 필요합니다. 따라서 특정 요구 사항과 리소스 제약 조건에 따라 비용과 성능 간의 관계 균형을 맞추는 데 적합한 모델을 선택할 수 있습니다.

두 가지 새로운 임베딩 모델 모두 개발자가 임베딩 성능과 비용을 절충할 수 있는 학습 기술을 사용하여 수행됩니다. 특히 개발자는 차원 API 매개변수에 임베딩을 전달하여 개념적 표현 속성을 잃지 않고 임베딩 크기를 줄일 수 있습니다. 예를 들어 MTEB 벤치마크에서 text-embedding-3-large는 크기를 256으로 줄일 수 있지만 여전히 단축되지 않은 text-embedding-ada-002 임베딩(크기 1536)보다 성능이 뛰어납니다. 이러한 방식으로 개발자는 성능 요구 사항을 충족할 뿐만 아니라 비용도 제어할 수 있는 특정 요구 사항에 따라 적합한 임베딩 모델을 선택할 수 있습니다.

이 기술의 적용은 매우 유연합니다. 예를 들어 최대 1024 차원의 임베딩만 지원하는 벡터 데이터 저장소를 사용하는 경우 개발자는 최상의 임베딩 모델 text-embedding-3-large를 선택하고 차원 API에 1024 값을 지정하여 임베딩 차원을 3072에서 변경할 수 있습니다. 매개변수는 1024로 단축됩니다. 이렇게 하면 정확도가 약간 희생될 수 있지만 더 작은 벡터 크기를 얻을 수 있습니다.

OpenAI에서 사용하는 "단축 임베딩" 방법은 이후 연구자들로부터 광범위한 관심을 끌었습니다.

이 방법은 2022년 5월 논문에서 제안한 '마트료시카 표현 학습' 방법과 동일한 것으로 밝혀졌습니다.

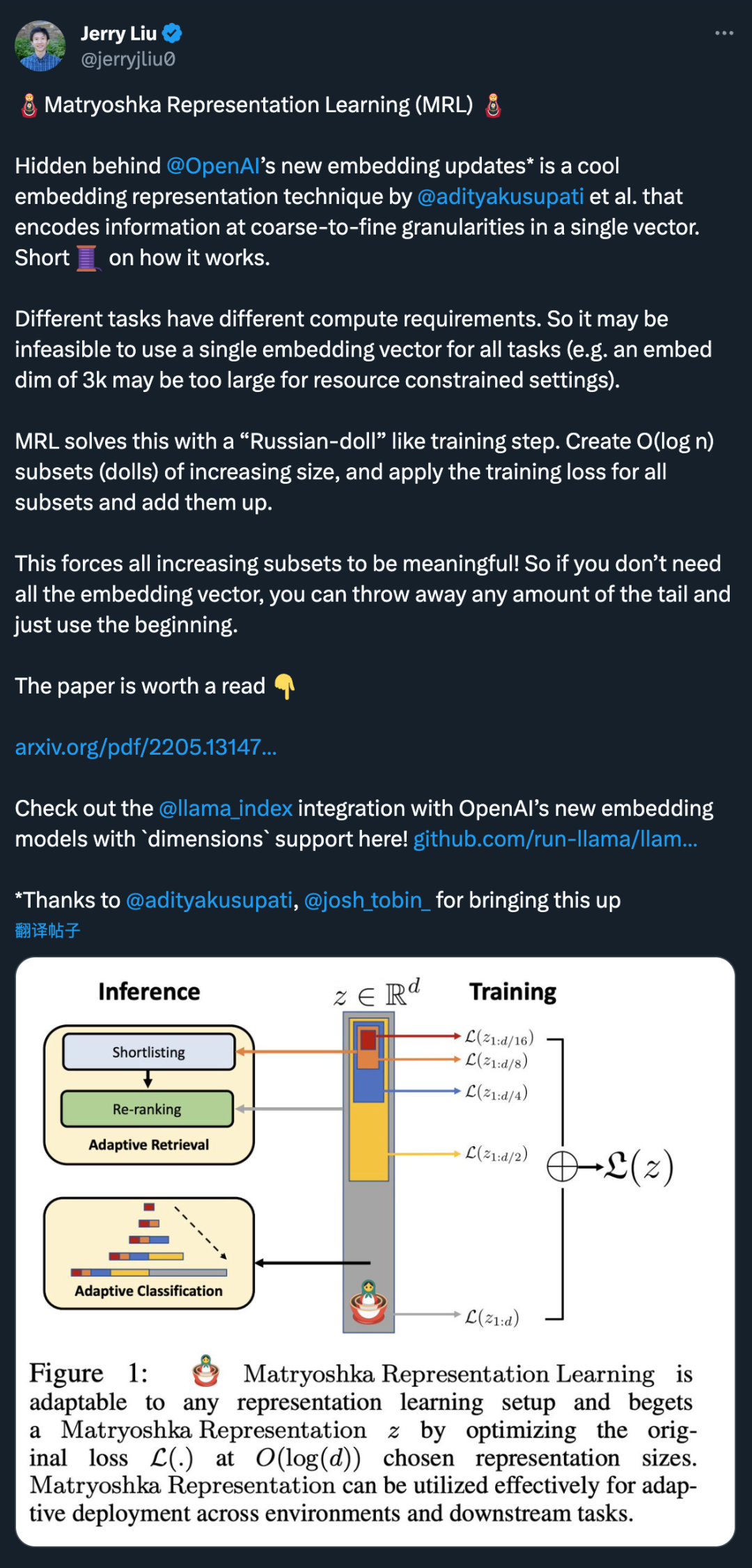

OpenAI의 새로운 임베딩 모델 업데이트 뒤에 숨겨진 것은 @adityakusupati 외 연구진이 제안한 멋진 임베딩 표현 기술입니다.

그리고 MRL의 저자 중 한 명인 Aditya Kusupati도 다음과 같이 말했습니다. "OpenAI는 검색 및 RAG를 위해 기본적으로 v3 내장 API에서 MRL을 사용합니다! 다른 모델과 서비스도 곧 따라잡을 것입니다." 그렇다면 MRL은 정확히 무엇인가요? 효과는 어때요? 아래 2022년 논문에 모두 나와 있습니다.

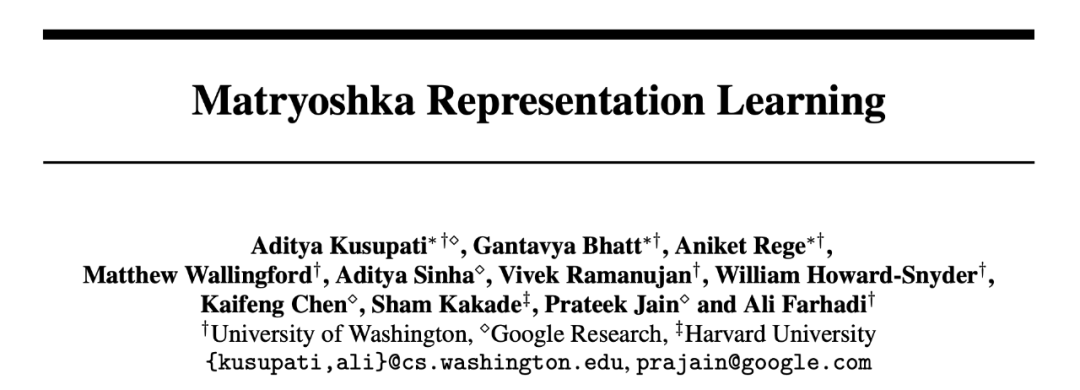

논문 제목: Matryoshka Representation Learning

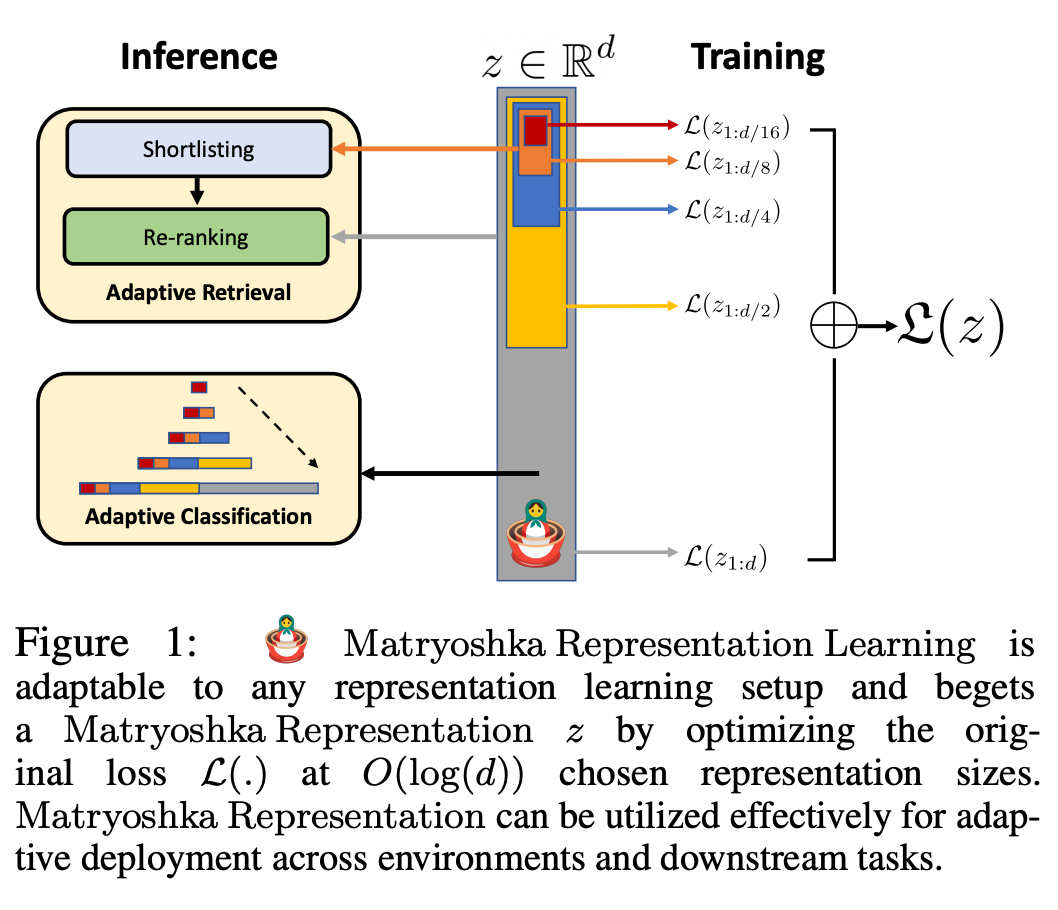

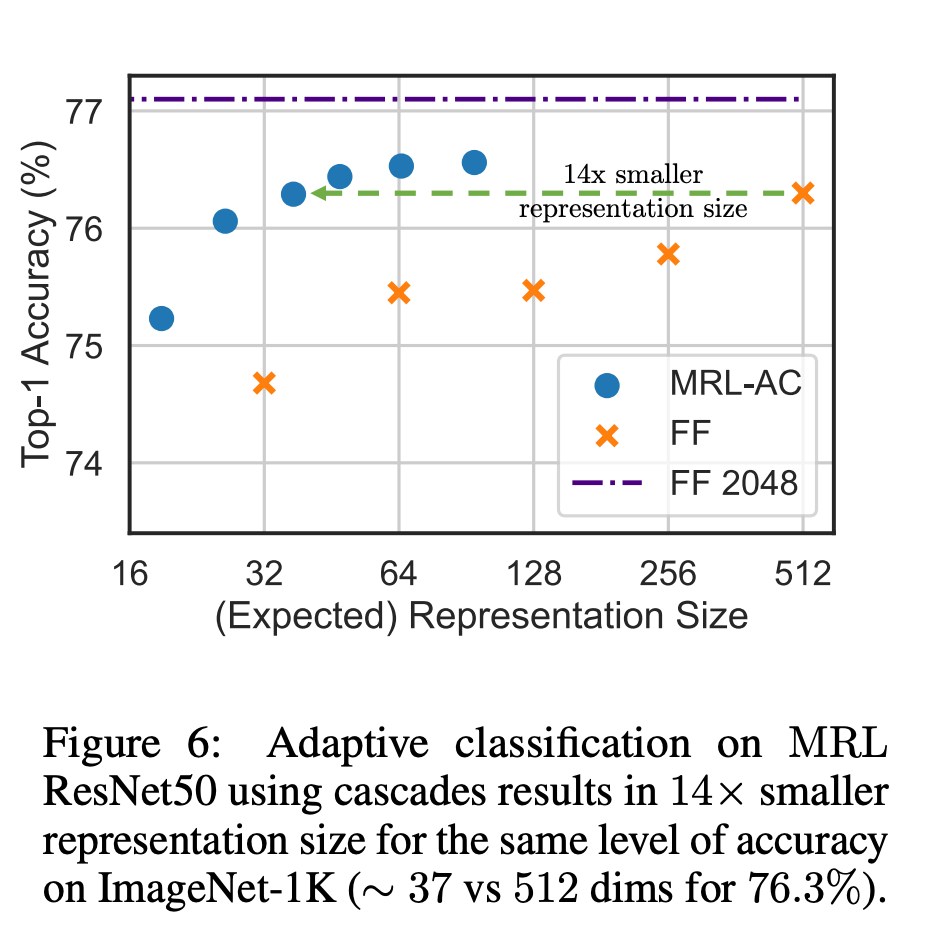

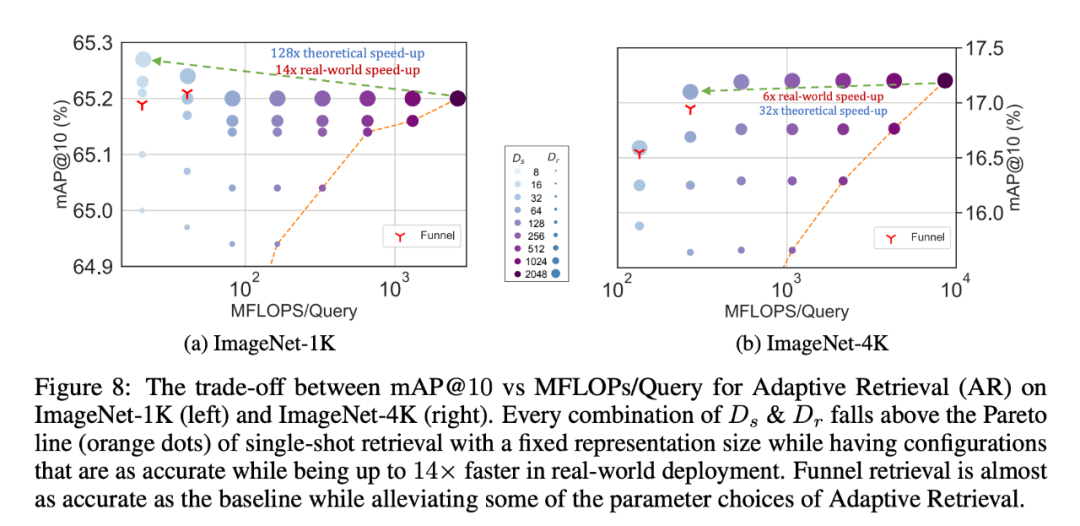

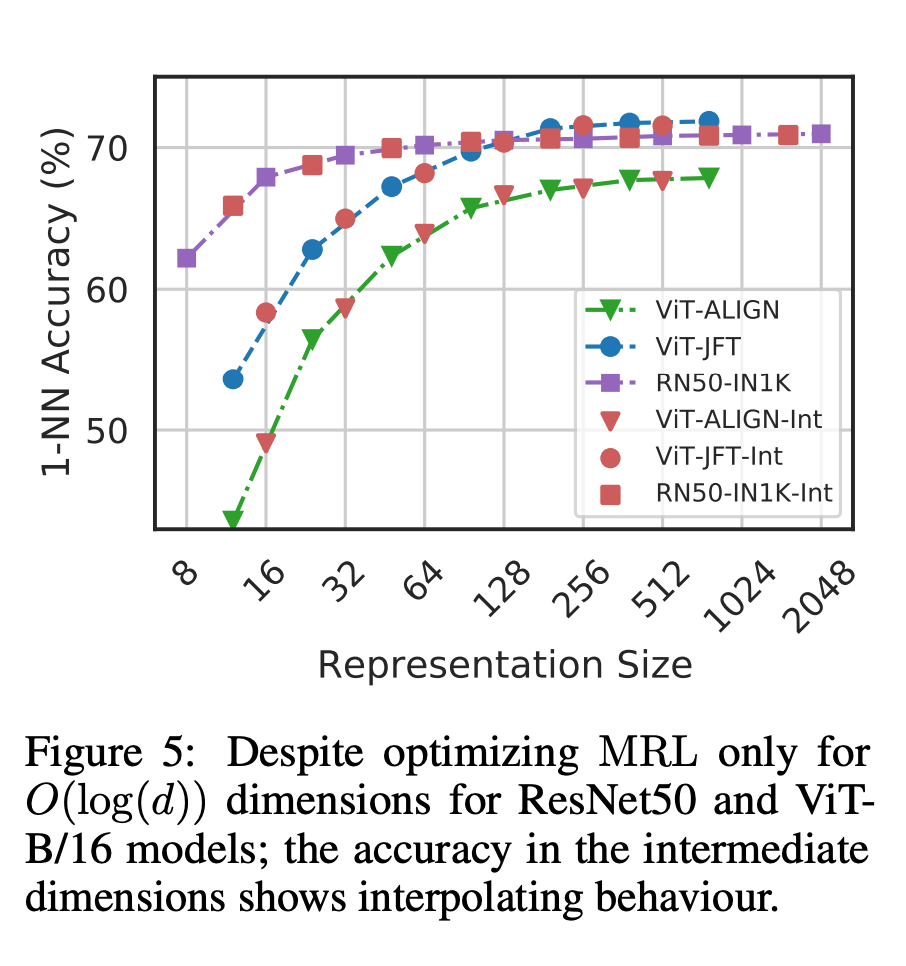

그림 1은 MRL의 핵심 아이디어와 학습된 Matryoshka 표현의 적응형 배포 설정을 보여줍니다. Matryoshka 표현의 첫 번째 m 차원(m∈[d])은 정보입니다. 풍부한 저차원 벡터를 갖고 있어 추가 훈련 비용이 필요하지 않으며, 그 정확도는 독립적으로 훈련된 m차원 표현 방법보다 낮지 않습니다. Matryoshka 표현의 정보 내용은 차원이 증가함에 따라 증가하여 광범위한 교육이나 추가 배포 오버헤드 없이 대략적인 표현을 형성합니다. MRL은 벡터 특성화에 필요한 유연성과 다중 충실도를 제공하여 정확성과 계산 노력 간의 거의 최적의 균형을 보장합니다. 이러한 장점을 통해 MRL은 정확성과 계산 제약 조건에 따라 적응적으로 배포될 수 있습니다. 이 연구에서 연구자들은 실제 ML 시스템의 두 가지 주요 구성 요소인 대규모 분류 및 검색에 중점을 둡니다. 분류를 위해 연구원들은 적응형 캐스케이드를 사용하고 MRL로 훈련된 모델에서 생성된 가변 크기 표현을 사용하여 특정 정확도를 달성하는 데 필요한 평균 내장 차원을 크게 줄였습니다. 예를 들어 ImageNet-1K에서 MRL + 적응형 분류를 사용하면 기준선과 동일한 정확도로 표현 크기를 최대 14배까지 줄일 수 있습니다. 마찬가지로 연구자들은 적응형 검색 시스템에도 MRL을 사용했습니다. 쿼리가 주어지면 쿼리 임베딩의 처음 몇 차원을 사용하여 검색 후보를 필터링한 다음 연속적으로 더 많은 차원을 사용하여 검색 세트를 재정렬합니다. 이 접근 방식을 간단하게 구현하면 표준 임베딩 벡터를 사용하는 단일 검색 시스템에 비해 이론적인 속도(FLOPS)는 128배, 벽시계 시간은 14배 향상됩니다. MRL의 검색 정확도는 다음과 같습니다. 단일 검색(섹션 4.3.1). 마지막으로 MRL은 표현 벡터를 거친 것부터 미세한 것까지 명시적으로 학습하므로 다양한 차원에서 더 많은 의미 정보를 공유해야 합니다(그림 5). 이는 롱테일 연속 학습 설정에 반영되어 원본 임베딩만큼 견고하면서도 정확도를 최대 2%까지 향상시킬 수 있습니다. 또한, MRL의 성긴 특성으로 인해 인스턴스 분류의 용이성 및 정보 병목 현상을 분석하는 방법으로도 사용할 수 있습니다. 자세한 연구 내용은 논문 원문을 참고해주세요.

위 내용은 네티즌들이 OpenAI의 새 모델에 사용된 임베딩 기술을 노출했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!