GPT 등 대형 모델 등장 이후 다음 토큰을 예측하는 사전 학습 작업인 언어 모델의 Transformer + autoregressive 모델링 방식이 큰 성공을 거두었습니다. 그렇다면 이 자동회귀 모델링 방법이 시각적 모델에서 더 나은 결과를 얻을 수 있을까요? 오늘 소개하는 글은 최근 Apple에서 Transformer + autoregressive pre-training을 기반으로 한 시각적 모델 학습에 관해 발표한 글입니다. 이 작업을 소개하겠습니다.

Pictures

Pictures

논문 제목: Scalable Pre-training of Large Autoregressive Image Models

다운로드 주소: https://arxiv.org/pdf/2401.08541v1.pdf

오픈 소스 코드: https://github .com/apple/ml-aim

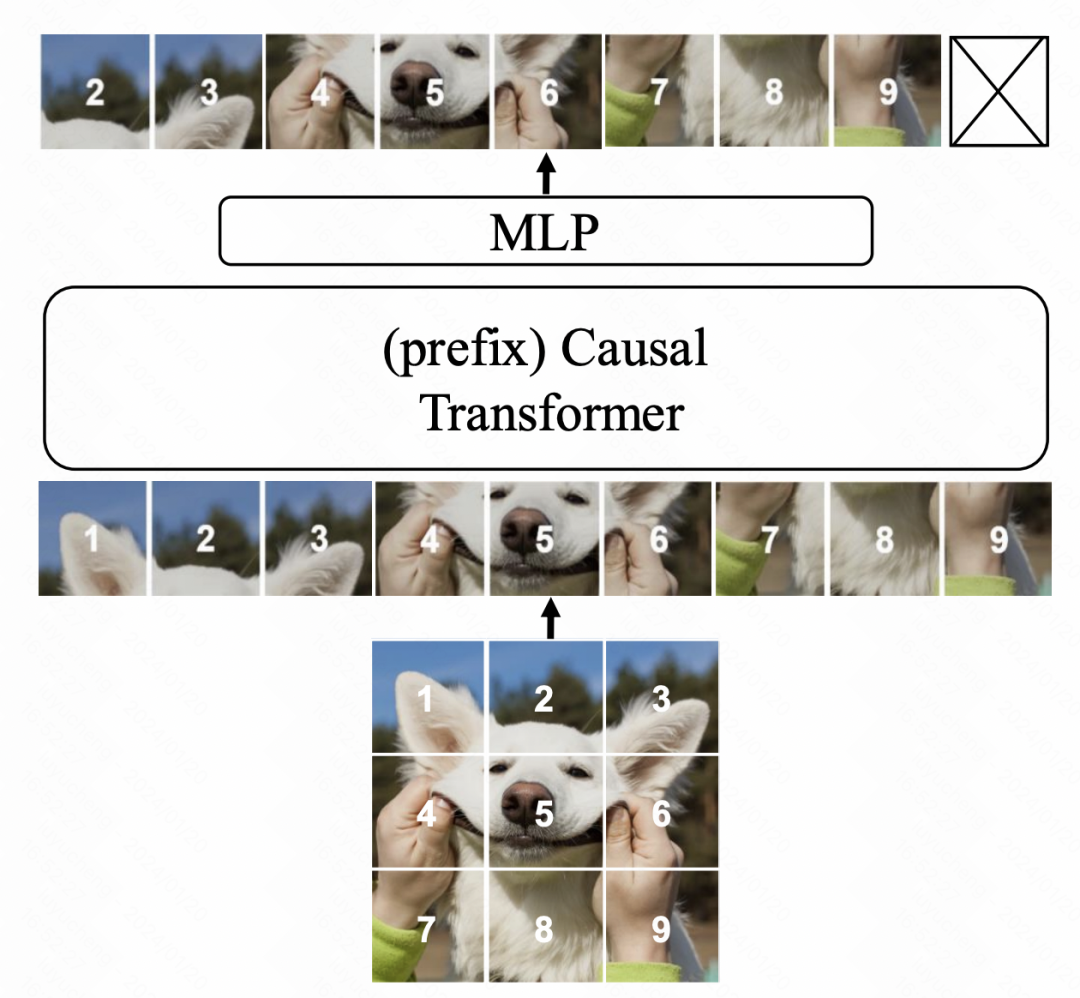

모델 구조는 Transformer를 기반으로 하며 언어 모델의 다음 토큰 예측을 최적화 목표로 사용합니다. 주요 수정 사항은 세 가지 측면입니다. 우선, ViT와 달리 이 글에서는 GPT의 단방향 Attention을 사용합니다. 즉, 각 위치의 요소는 이전 요소로만 Attention을 계산합니다. 둘째, 모델의 언어 이해 능력을 향상시키기 위해 더 많은 상황별 정보를 도입합니다. 마지막으로 성능을 더욱 향상시키기 위해 모델의 매개변수 설정을 최적화했습니다. 이러한 개선을 통해 우리 모델은 언어 작업에서 상당한 성능 향상을 달성합니다.

Picture

Picture

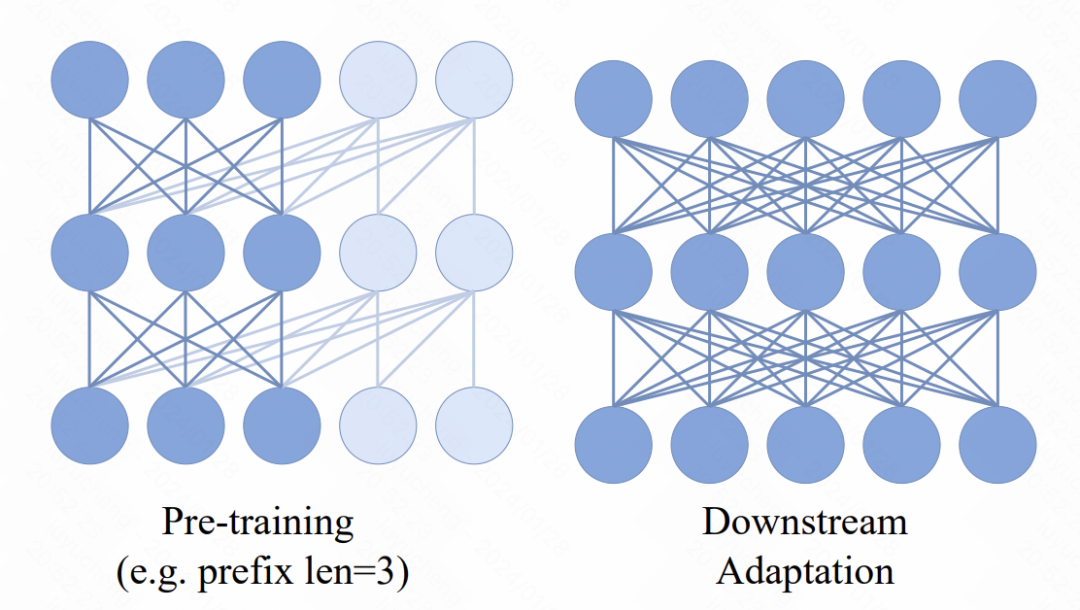

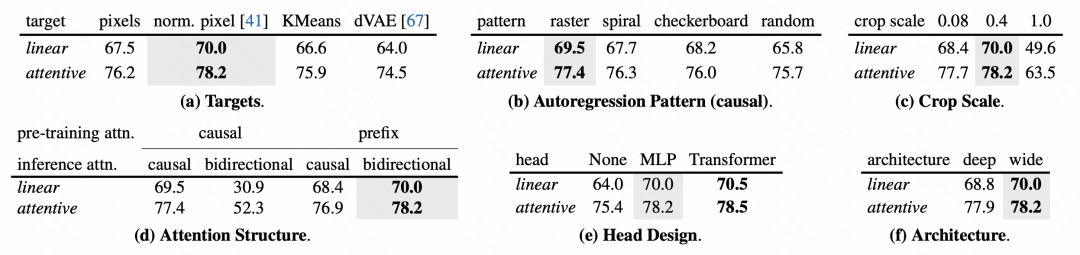

Transformer 모델에는 새로운 메커니즘이 도입되었습니다. 즉, 여러 개의 접두사 토큰이 입력 시퀀스 앞에 추가됩니다. 이 토큰은 양방향 주의 메커니즘을 사용합니다. 이 변경의 주요 목적은 사전 훈련과 다운스트림 애플리케이션 간의 일관성을 향상시키는 것입니다. 다운스트림 작업에서는 ViT와 유사한 양방향 주의 방법이 널리 사용됩니다. 사전 훈련 과정에서 접두사 양방향 주의를 도입함으로써 모델은 다양한 다운스트림 작업의 요구 사항에 더 잘 적응할 수 있습니다. 이러한 개선으로 모델의 성능과 일반화 기능이 향상될 수 있습니다.

Picture

Picture

모델의 최종 출력 MLP 계층을 최적화하는 측면에서 원래 사전 학습 방법은 일반적으로 MLP 계층을 삭제하고 다운스트림 작업에서 완전히 새로운 MLP를 사용합니다. 이는 사전 훈련된 MLP가 사전 훈련 작업에 너무 편향되어 다운스트림 작업의 효율성이 감소하는 것을 방지하기 위한 것입니다. 그러나 본 논문에서 저자는 새로운 접근 방식을 제안한다. 각 패치마다 독립적인 MLP를 사용하고, 각 패치의 표현과 관심을 융합하여 기존 풀링 작업을 대체합니다. 이러한 방식으로 다운스트림 작업에서 사전 훈련된 MLP 헤드의 유용성이 향상됩니다. 이 방법을 통해 작성자는 전체 이미지의 정보를 더 잘 유지할 수 있으며 사전 훈련 작업에 과도하게 의존하는 문제를 피할 수 있습니다. 이는 모델의 일반화 능력과 적응성을 향상시키는 데 매우 도움이 됩니다.

최적화 목표 측면에서 기사에서는 두 가지 방법을 시도했습니다. 첫 번째는 패치 픽셀을 직접 맞추고 MSE를 사용하여 예측하는 것입니다. 두 번째는 이미지 패치를 미리 토큰화하여 분류 작업으로 변환하고 교차 엔트로피 손실을 사용하는 것입니다. 그러나 기사의 후속 절제 실험에서 두 번째 방법을 사용하면 모델을 정상적으로 훈련할 수 있지만 그 효과는 픽셀 세분성 MSE를 기반으로 하는 것만큼 좋지 않은 것으로 나타났습니다.

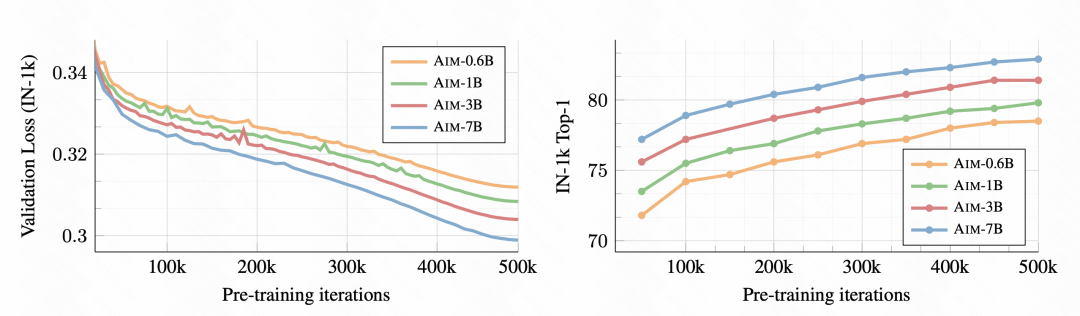

기사의 실험 부분에서는 이 자동 회귀 기반 이미지 모델의 효과와 각 부분이 효과에 미치는 영향을 자세히 분석합니다.

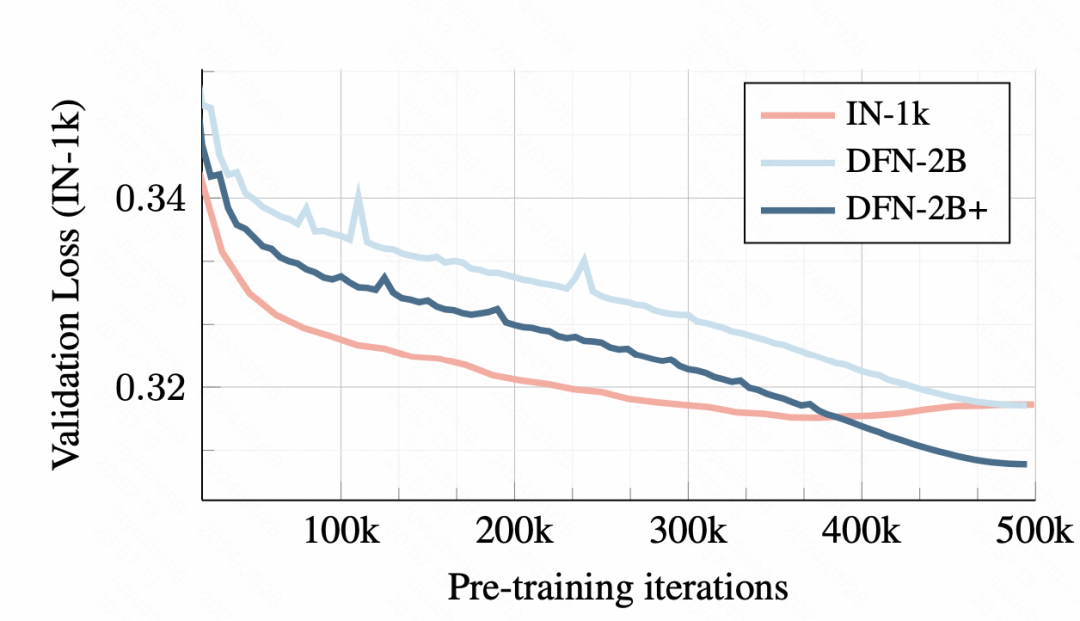

우선, 훈련이 진행됨에 따라 다운스트림 이미지 분류 작업이 점점 더 좋아지고 있으며, 이는 이 사전 훈련 방법이 실제로 좋은 이미지 표현 정보를 학습할 수 있음을 나타냅니다.

Picture

Picture

훈련 데이터에서 작은 데이터 세트로 훈련하면 과적합이 발생합니다. 그러나 DFN-2B를 사용하면 초기 검증 세트 손실이 더 크지만 뚜렷한 과적합 문제는 없습니다.

Pictures

Pictures

모델의 각 모듈 설계에 대해 기사에서는 자세한 절제 실험 분석도 수행합니다.

Pictures

Pictures

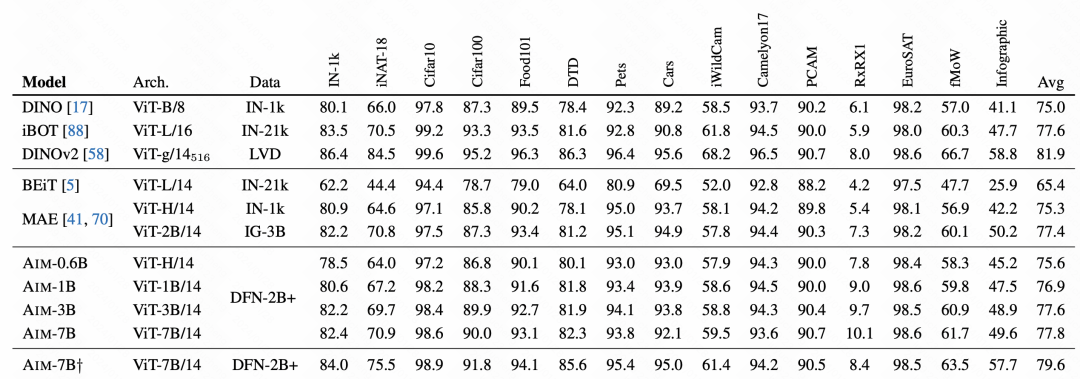

최종 효과 비교에서 AIM은 매우 좋은 결과를 얻었으며, 이는 또한 이 자동 회귀 사전 학습 방법이 이미지에서도 사용 가능하며 후속 대규모 이미지에 대한 사전 학습 방법이 될 수 있음을 확인했습니다. 모델. 훈련의 주요 방법 중 하나입니다.

사진

사진

위 내용은 Apple은 자동 회귀 언어 모델을 사용하여 이미지 모델을 사전 학습합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!