아직도 예전의 AI 마음읽기 기술을 기억하시나요? 최근 '소원을 모두 이루어준다'는 능력이 다시 진화했습니다.

- 인간은 자신의 생각을 통해 로봇을 직접 조종할 수 있습니다!

MIT 연구진이 Ddog 프로젝트를 공개했습니다. 이들은 보스턴 다이나믹스(Boston Dynamics)의 로봇견 스팟(Spot)을 제어하기 위한 뇌-컴퓨터 인터페이스(BCI) 장치를 독자적으로 개발했다.

개는 인간의 생각에 따라 특정 지역으로 이동하거나, 사람들이 물건을 가져오는 것을 돕거나, 사진을 찍을 수 있습니다.

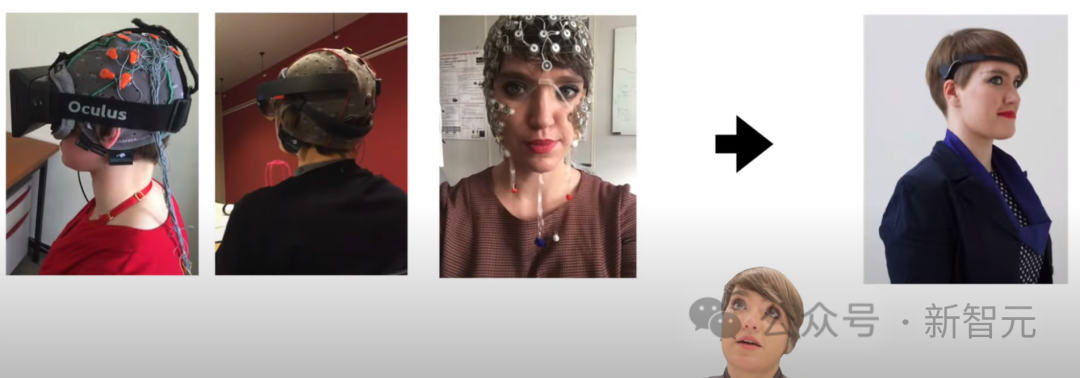

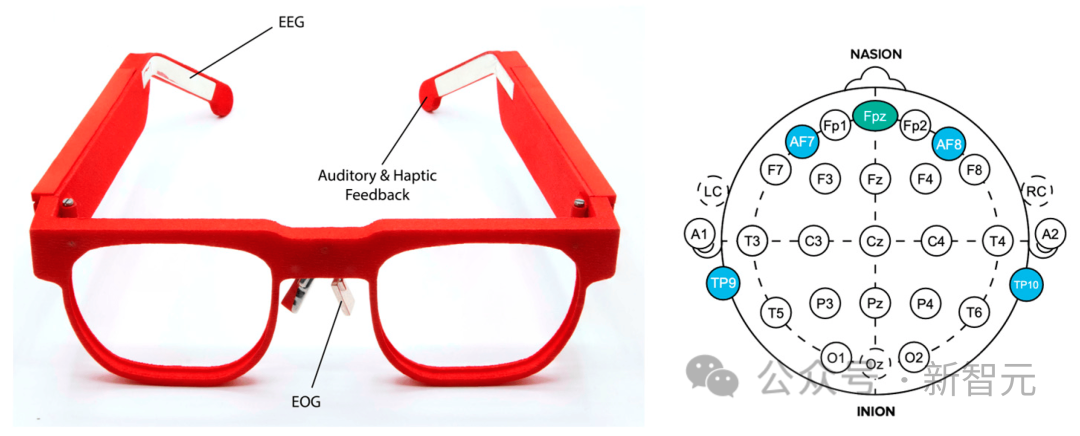

"마음을 읽기" 위해 수많은 센서를 사용해야 했던 기존 헤드기어에 비해, 이번에는 뇌-컴퓨터 인터페이스 장치가 무선 안경(AttentivU) 형태로 선보입니다.

영상에 나오는 동작은 간단하지만 이 시스템의 목적은 Spot을 ALS, 뇌성마비, 척수 손상과 같은 질병을 앓고 있는 사람들을 돕는 기본적인 의사소통 도구로 바꾸는 것입니다.

단지 두 대의 iPhone과 안경 하나만으로 절박한 사람들에게 실질적인 도움과 보살핌을 줄 수 있습니다.

그리고 관련 논문에서 볼 수 있듯이 이 시스템은 실제로 매우 복잡한 엔지니어링을 기반으로 구축되었습니다.

문서 주소: https://doi.org/10.3390/s24010080

Ddog 시스템은 AttentivU를 뇌-컴퓨터 인터페이스 시스템으로 사용하며 프레임에 센서가 내장되어 사람의 뇌파를 측정합니다. (EEG) 또는 뇌 활동, 전기 안구 조영술 또는 안구 운동.

이 연구의 기반은 사용자가 비언어적으로 간병인과 실시간으로 의사소통할 수 있는 실시간 폐쇄 루프 BCI인 MIT의 Brain Switch입니다.

Ddog 시스템 성공률은 83.4%이며, 개인 비서 사용 사례에서 무선, 비시각적 BCI 시스템이 Spot과 통합된 것은 이번이 처음입니다.

영상에서 뇌 인터페이스 장치의 진화와 일부 개발자의 생각을 볼 수 있습니다.

이전에 연구팀은 뇌-컴퓨터 인터페이스와 스마트홈 간의 상호작용을 완료했고, 이제 움직이고 작동할 수 있는 로봇의 제어를 완료했습니다.

이러한 연구는 특별한 사람들에게 한 줄기 빛을 주어 그들에게 생존하고 미래에 더 나은 삶을 살 수 있는 희망을 선사했습니다.

문어 모양의 센서 헤드기어에 비해 아래 안경은 정말 시원합니다.

전미희귀질환기구(National Organization for Rare Diseases)에 따르면 현재 미국에는 30,000명의 ALS 환자가 있으며 매년 약 5,000명의 새로운 사례가 진단됩니다. 또한 뇌성마비 가이드(Cerebral Palsy Guide)에 따르면 대략 100만 명의 미국인이 뇌성마비를 앓고 있습니다.

이들 중 많은 사람들은 걷고, 옷을 입고, 말하고, 쓰고, 숨을 쉬는 능력을 가지고 있거나 결국 잃게 될 것입니다.

의사소통 도구가 존재하기는 하지만 대부분은 사용자가 컴퓨터를 사용하여 의사소통할 수 있게 해주는 시선 장치입니다. 사용자가 주변 세계와 상호 작용할 수 있는 시스템은 많지 않습니다.

이 BCI 4족 로봇 시스템은 초기 프로토타입 역할을 하며 현대 개인 보조 로봇의 미래 개발을 위한 길을 닦습니다.

향후 반복에서 훨씬 더 놀라운 기능을 볼 수 있기를 바랍니다.

뇌 제어 4족 로봇

이 연구에서 연구원들은 무선 및 웨어러블 BCI 장치가 4족 로봇인 Boston Dynamics의 Spot을 제어할 수 있는 방법을 탐구합니다.

연구원이 개발한 장치는 안경 프레임에 내장된 전극을 통해 사용자의 뇌전도(EEG) 및 전기 안구전도(EOG) 활동을 측정합니다.

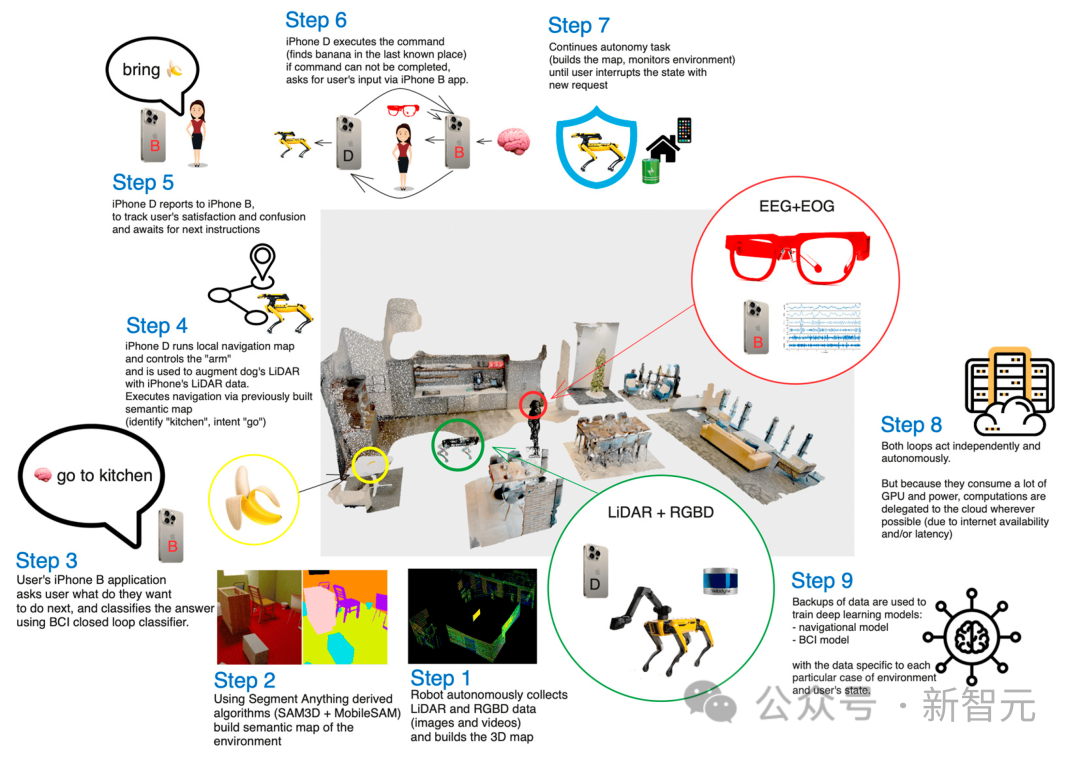

사용자는 마음 속으로 일련의 질문("예" 또는 "아니요")에 답하며, 각 질문은 미리 설정된 스팟 작업 세트에 해당합니다.

예를 들어 Spot이 방을 돌아다니며 물건(예: 물병)을 집은 다음 사용자를 위해 가져오도록 요청합니다.

오늘날까지 EEG는 가장 실용적이고 적용 가능한 비침습적 뇌-컴퓨터 인터페이스 방법 중 하나로 남아 있습니다.

BCI 시스템은 내인성(자발적) 또는 외인성(유발) 신호를 사용하여 제어할 수 있습니다.

외인성 뇌-컴퓨터 인터페이스에서 유발 신호는 사람이 시각적 또는 청각적 단서와 같은 외부 자극에 주의를 기울일 때 발생합니다.

이 방법의 장점은 최소한의 훈련과 최대 60비트/분의 높은 비트 전송률을 포함하지만, 이를 위해서는 사용자가 항상 자극에 집중해야 하므로 실제 생활에서의 적용 가능성이 제한됩니다. 게다가 외인성 BCI를 사용할 때 사용자는 빨리 피로해집니다.

내인성 뇌-컴퓨터 인터페이스에서 제어 신호는 외부 자극과 독립적으로 생성되며 사용자가 요청하면 완전히 실행할 수 있습니다. 감각 장애가 있는 사용자의 경우 이는 보다 자연스럽고 직관적인 상호 작용 방법을 제공하여 사용자가 자발적으로 시스템에 명령을 내릴 수 있도록 합니다.

그러나 이 방법은 일반적으로 훈련 시간이 더 길고 비트 전송률도 낮습니다.

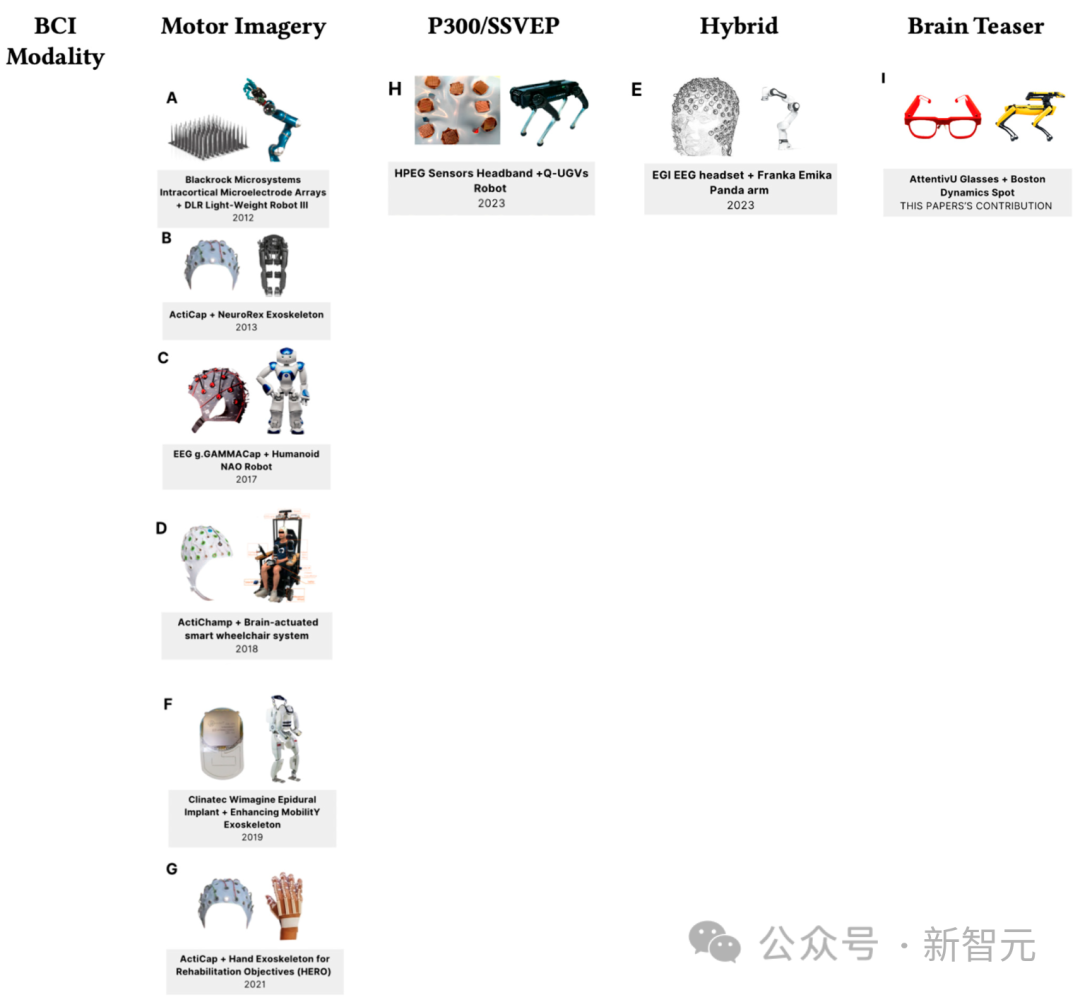

뇌-컴퓨터 인터페이스를 사용하는 로봇 애플리케이션은 도움이 필요한 사람들에게 적합한 경우가 많으며 휠체어와 외골격이 포함되는 경우가 많습니다.

아래 그림은 2023년 현재 뇌-컴퓨터 인터페이스와 로봇공학 기술의 최신 발전을 보여줍니다.

4족 로봇은 종종 복잡한 작업 환경이나 국방 분야에서 사용자를 지원하는 데 사용됩니다.

가장 유명한 4족 보행 로봇 중 하나는 Boston Dynamics의 Spot입니다. 이 로봇은 최대 15kg의 페이로드를 운반하고 터널과 같은 유지 관리 현장을 반복적으로 매핑할 수 있습니다. 부동산 및 광업 업계에서도 Spot과 같은 4족 로봇을 채택하여 복잡한 물류 작업 현장을 모니터링하는 데 도움을 주고 있습니다.

이 글은 모바일 BCI 솔루션으로 제어되는 Spot 로봇을 사용하며 암산 작업을 기반으로 하며 전체 아키텍처는 Ddog이라고 합니다.

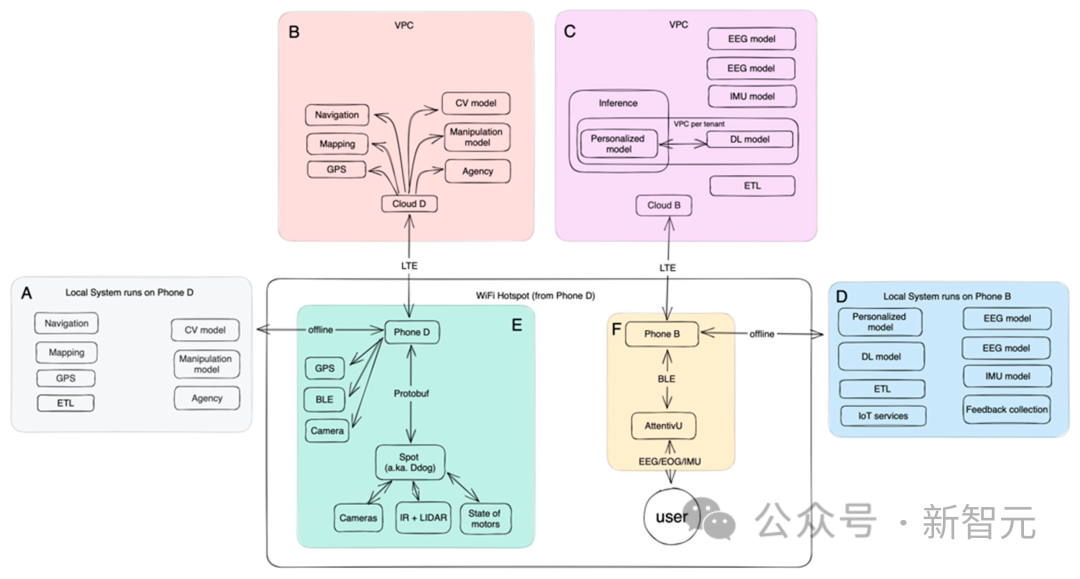

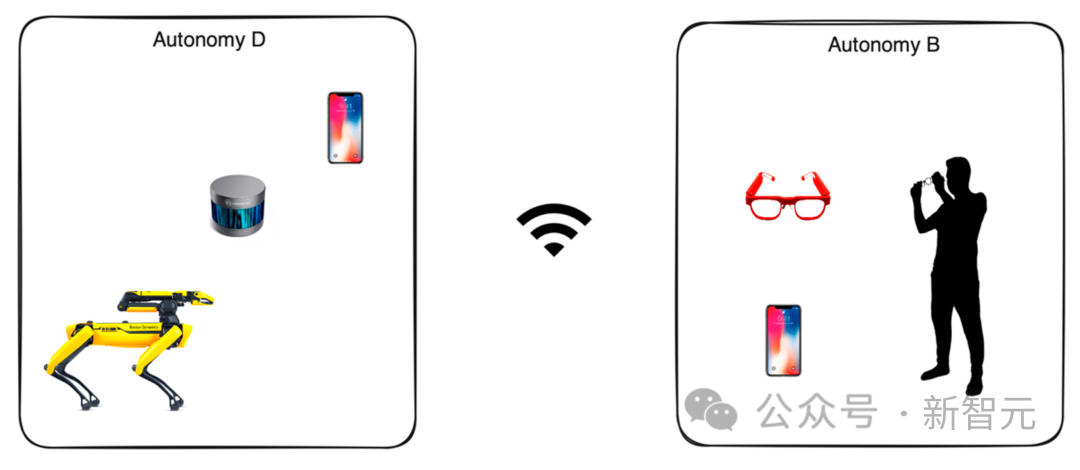

다음 그림은 Ddog의 전체 구조를 보여줍니다.

Ddog은 BCI의 입력을 통해 Spot 로봇을 제어할 수 있는 자율 애플리케이션입니다. 음성을 사용합니다. 사용자와 간병인에게 피드백을 제공합니다.

시스템은 완전히 오프라인 또는 온라인으로 작동하도록 설계되었습니다. 온라인 버전은 더욱 발전된 기계 학습 모델 세트와 더 나은 미세 조정 모델을 갖추고 있으며 로컬 장치에 대한 전력 효율성이 더 높습니다.

전체 시스템은 실제 시나리오를 위해 설계되었으며 대부분의 부분에서 빠른 반복이 가능합니다.

클라이언트 측에서 사용자는 BLE(Bluetooth Low Energy) 프로토콜을 사용하여 장치와 통신하는 모바일 애플리케이션을 통해 뇌-컴퓨터 인터페이스 장치(AttentivU)와 상호 작용합니다.

사용자의 모바일 장치는 Spot 로봇을 제어하는 다른 전화기와 통신하여 에이전시, 조작, 탐색 및 궁극적으로 사용자 지원을 가능하게 합니다.

휴대전화 간 통신은 Wi-Fi나 모바일 네트워크를 통해 이루어질 수 있습니다. 제어되는 휴대폰은 Wi-Fi 핫스팟을 구축하고, Ddog과 사용자의 휴대폰 모두 이 핫스팟에 연결됩니다. 온라인 모드를 사용하면 클라우드에서 실행되는 모델에 연결할 수도 있습니다.

서버 측에서는 Kubernetes(K8S) 클러스터를 사용하며, 각 클러스터는 자체 VPC(Virtual Private Cloud)에 배포됩니다.

클라우드는 일반적으로 최종 사용자에게 더 가까운 동일한 가용 영역에 배포되는 전용 VPC 내에서 작동하여 각 서비스에 대한 응답 대기 시간을 최소화합니다.

클러스터의 각 컨테이너는 단일 목적(마이크로서비스 아키텍처)을 위해 설계되었으며 각 서비스는 실행 중인 AI 모델이며 해당 작업에는 탐색, 매핑, 컴퓨터 비전, 조작, 위치 지정 및 에이전시가 포함됩니다.

매핑: 다양한 소스에서 로봇 주변 환경에 대한 정보를 수집하는 서비스입니다. 이는 고정적이고 움직일 수 없는 데이터(나무, 건물, 벽)를 매핑할 뿐만 아니라 시간이 지남에 따라 변하는 동적 데이터(자동차, 사람)도 수집합니다.

내비게이션: 이전 서비스에서 수집 및 보강된 지도 데이터를 기반으로 A지점과 B지점 사이의 시공간 경로를 구축하는 역할을 담당하는 내비게이션 서비스입니다. 또한 대체 경로를 구축하고 소요 시간을 예측하는 역할도 담당합니다.

컴퓨터 비전: 로봇 카메라에서 시각적 데이터를 수집하고 휴대폰의 데이터로 이를 보강하여 공간적, 시간적 표현을 생성합니다. 이 서비스는 또한 각 시각적 지점을 분할하고 개체를 식별하려고 시도합니다.

클라우드는 뇌전도(EEG), 안구전도(EOG) 및 관성 측정 장치(IMU)를 포함한 BCI 관련 모델 교육을 담당합니다.

휴대폰에 배포된 오프라인 모델은 데이터 수집 및 집계를 실행하는 동시에 실시간 추론을 위해 TensorFlow의 모바일 모델(더 작은 RAM 및 ARM 기반 CPU에 최적화됨)을 사용합니다.

분할 모델을 배포하는 데 사용된 원래 버전은 LIDAR 데이터를 활용하는 단일 TensorFlow 3D 모델이었습니다. 그런 다음 저자는 이를 몇 번의 샷 모델로 확장하고 NeRF(Neural Radiation Field) 및 RGBD 데이터에 대한 보완 모델을 실행하여 이를 향상시켰습니다.

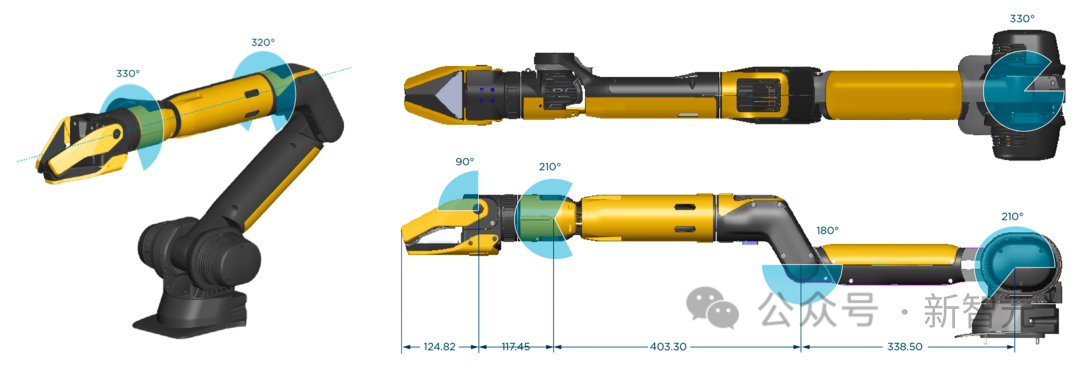

Ddog이 수집한 원시 데이터는 5대의 카메라에서 집계됩니다. 각 카메라는 그레이스케일, 어안, 깊이 및 적외선 데이터를 제공합니다. 또한 팔의 그리퍼 내부에는 4K 해상도와 LED 기능을 갖춘 여섯 번째 카메라가 있으며 사전 훈련된 TensorFlow 모델과 함께 작동하여 물체를 감지합니다.

포인트 클라우드는 Ddog 및 휴대폰의 LiDAR 데이터와 RGBD 데이터에서 생성됩니다. 데이터 수집이 완료된 후 단일 좌표계를 통해 정규화되고 모든 이미징 및 3D 포지셔닝 데이터를 통합하는 전역 상태와 일치됩니다.

Ddog에 장착된 로봇팔 그리퍼의 품질에 따라 동작이 전적으로 좌우됩니다. 아래 사진의 그리퍼는 보스턴 다이나믹스에서 제작한 제품입니다.

사용 사례를 미리 정의된 위치에 있는 개체와의 기본적인 상호 작용으로 제한하세요.

저자는 넓은 실험실 공간을 그려서 "주방" 공간(다양한 컵과 병이 담긴 쟁반 포함), 작은 "거실" 공간(베개 포함)을 포함하는 "아파트"로 설정했습니다. 소파와 작은 커피 테이블), 그리고 "창문 라운지" 공간이 있습니다.

사용 사례의 수가 지속적으로 증가하고 있으므로 대부분을 처리할 수 있는 유일한 방법은 일정 기간 동안 지속적으로 실행되는 시스템을 배포하고 데이터를 사용하여 이러한 시퀀스와 경험을 최적화하는 것입니다.

EEG 데이터는 AttentivU 장치에서 수집됩니다. AttentivU 안경의 전극은 천연 은으로 만들어지며 국제 10-20 전극 배치 시스템에 따라 TP9 및 TP10에 위치합니다. 또한 안경에는 코 패드에 위치한 두 개의 EOG 전극과 Fpz 위치에 있는 EEG 기준 전극이 포함되어 있습니다.

이러한 센서는 필요한 정보를 제공하고 필요할 때 실시간 폐쇄 루프 개입을 활성화할 수 있습니다.

장치에는 주의, 참여, 피로 및 인지 부하 신호를 실시간으로 캡처하는 데 사용할 수 있는 EEG와 EOG의 두 가지 모드가 있습니다. EEG는 각성 상태와 수면 사이의 전환을 나타내는 신경생리학적 지표로 사용되어 왔으며(

) EOG는 각막-망막 쌍극자 특성으로 인해 안구 운동 중에 유도되는 생체전기 신호를 측정하는 데 기반을 두고 있습니다. 연구에 따르면 눈의 움직임은 특정 작업을 수행하는 데 필요한 기억 접근 유형과 관련이 있으며 시각적 참여, 주의력 및 졸음을 나타내는 좋은 척도입니다.

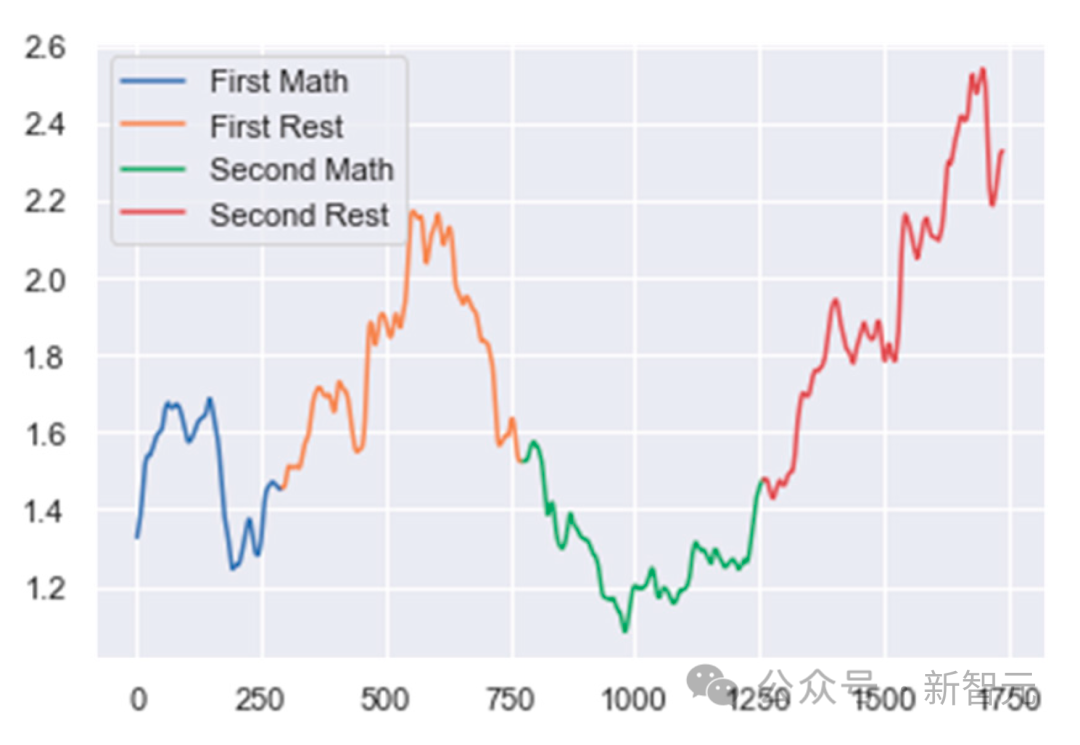

먼저 뇌파 데이터를 여러 창으로 나눕니다. 각 창을 이전 창과 75% 겹치는 1초 길이의 EEG 데이터로 정의합니다.

그런 다음 데이터 전처리 및 정리가 이루어집니다. 데이터는 전력선 잡음과 원치 않는 고주파수 제거를 보장하기 위해 50Hz 노치 필터와 0.5Hz ~ 40Hz의 통과대역을 갖는 대역통과 필터의 조합을 사용하여 필터링되었습니다.

다음으로 저자는 인공물 거부 알고리즘을 만들었습니다. 두 연속 에포크 간의 절대 전력 차이가 사전 정의된 임계값보다 크면 에포크가 거부됩니다.

분류의 마지막 단계에서 저자는 다양한 스펙트럼 대역 전력 비율을 혼합하여 각 피험자의 작업 기반 정신 활동을 추적했습니다. MA의 경우 비율은 (알파/델타)입니다. WA의 경우 비율은 (델타/낮은 베타)이고 ME의 경우 비율은 (델타/알파)입니다.

그런 다음 변화점 감지 알고리즘을 사용하여 이러한 비율의 변화를 추적합니다. 이러한 비율이 갑자기 증가하거나 감소하는 것은 사용자의 정신 상태에 변화가 있음을 나타냅니다.

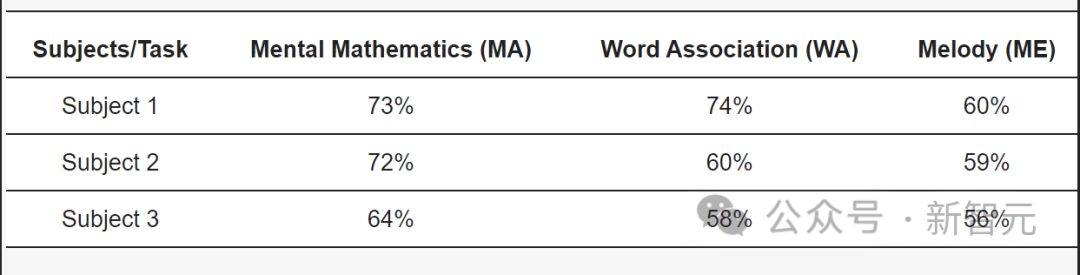

ALS가 있는 피험자의 경우 우리 모델은 MA 작업에서 73%, WA 작업에서 74%, ME 작업에서 60%의 정확도를 달성했습니다.

위 내용은 AI 마음읽기 기술이 업그레이드됐다! 안경으로 보스턴 로봇견을 직접 조종해 뇌로 조종되는 로봇을 현실로 만든다의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!