2GB DAYU200에 대규모 언어 모델을 로컬로 배포

구현 아이디어 및 단계

경량 LLM 모델 추론 프레임워크 InferLLM을 OpenHarmony 표준 시스템으로 이식하고 OpenHarmony에서 실행할 수 있는 바이너리 파일을 컴파일합니다. 이 추론 프레임워크는 LLM에서 정량적 모델을 로컬로 배포할 수 있는 간단하고 효율적인 LLM CPU 추론 프레임워크입니다.

OpenHarmony NDK를 사용하여 OpenHarmony에서 InferLLM 실행 파일을 컴파일합니다(특히 OpenHarmony lycium 크로스 컴파일 프레임워크를 사용한 다음 일부 스크립트를 작성합니다. 그런 다음 이를 tpc_c_cplusplusSIG 웨어하우스에 저장합니다.)

대규모 언어 모델을 로컬로 배포합니다. DAYU200에서

InferLLM 타사 라이브러리 컴파일 제품을 컴파일하고 얻습니다

OpenHarmony SDK를 다운로드하고 주소를 다운로드하세요:

http://ci.openharmony.cn/workbench/cicd/dailybuild/dailyList

이 웨어하우스를 다운로드하세요

git clone https://gitee.com/openharmony-sig/tpc_c_cplusplus.git --depth=1

# 设置环境变量export OHOS_SDK=解压目录/ohos-sdk/linux# 请替换为你自己的解压目录 cd lycium./build.sh InferLLM

InferLLM 타사 라이브러리 헤더 파일과 생성된 라이브러리를 가져옵니다.

InferLLM-405d866e4c11b884a8072b4b30659c는 tpc_c_cplusplus/thirdparty/InferLLM/ 디렉터리 63555be41d 디렉터리에 생성됩니다. 32비트 및 64비트 타사 라이브러리가 컴파일되었습니다. (해당 컴파일 결과는 lycium 디렉토리 아래 usr 디렉토리에 패키징되지 않습니다.)

InferLLM-405d866e4c11b884a8072b4b30659c63555be41d/arm64-v8a-buildInferLLM-405d866e4c11b884a8072b4b30659c63555be41d/armeabi-v7a-build

실행을 위해 컴파일된 제품 및 모델 파일을 개발 보드에 푸시하세요

- 모델 파일 다운로드: https://huggingface.co/kewin4933/InferLLM-Model/tree/main

- 컴파일 예정 InferLLM에서 생성된 llama 실행 파일인 OpenHarmony SDK의 libc++_shared.so와 다운로드한 모델 파일 Chinese-alpaca-7b-q4.bin이 llama_file

# 将llama_file文件夹发送到开发板data目录hdc file send llama_file /data

# hdc shell 进入开发板执行cd data/llama_file# 在2GB的dayu200上加swap交换空间# 新建一个空的ram_ohos文件touch ram_ohos# 创建一个用于交换空间的文件(8GB大小的交换文件)fallocate -l 8G /data/ram_ohos# 设置文件权限,以确保所有用户可以读写该文件:chmod 777 /data/ram_ohos# 将文件设置为交换空间:mkswap /data/ram_ohos# 启用交换空间:swapon /data/ram_ohos# 设置库搜索路径export LD_LIBRARY_PATH=/data/llama_file:$LD_LIBRARY_PATH# 提升rk3568cpu频率# 查看 CPU 频率cat /sys/devices/system/cpu/cpu*/cpufreq/cpuinfo_cur_freq# 查看 CPU 可用频率(不同平台显示的可用频率会有所不同)cat /sys/devices/system/cpu/cpufreq/policy0/scaling_available_frequencies# 将 CPU 调频模式切换为用户空间模式,这意味着用户程序可以手动控制 CPU 的工作频率,而不是由系统自动管理。这样可以提供更大的灵活性和定制性,但需要注意合理调整频率以保持系统稳定性和性能。echo userspace > /sys/devices/system/cpu/cpufreq/policy0/scaling_governor# 设置rk3568 CPU 频率为1.9GHzecho 1992000 > /sys/devices/system/cpu/cpufreq/policy0/scaling_setspeed# 执行大语言模型chmod 777 llama./llama -m chinese-alpaca-7b-q4.bin -t 4

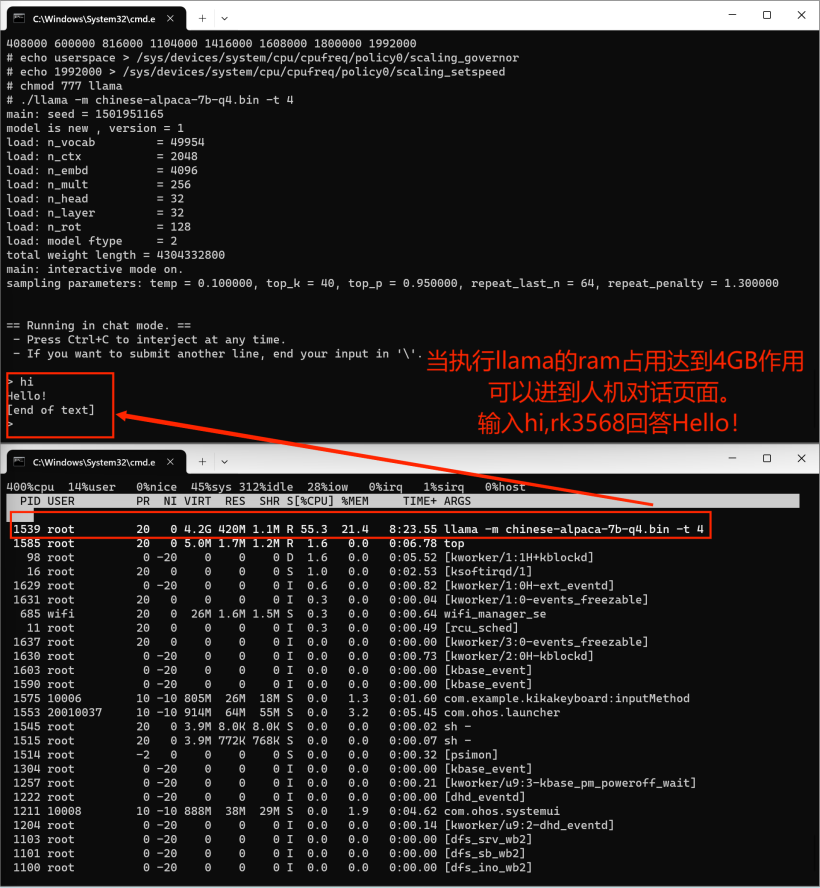

이식용 InferLLM 타사 라이브러리는 인간-컴퓨터 대화를 실현하기 위해 OpenHarmmony 장치 rk3568에 대규모 언어 모델을 배포합니다. 최종 실행 효과가 약간 느리고 인간-기계 대화 상자의 팝업도 약간 느립니다.

위 내용은 2GB DAYU200에 대규모 언어 모델을 로컬로 배포의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7464

7464

15

15

1376

1376

52

52

77

77

11

11

45

45

19

19

18

18

19

19

Groq Llama 3 70B를 로컬에서 사용하기 위한 단계별 가이드

Jun 10, 2024 am 09:16 AM

Groq Llama 3 70B를 로컬에서 사용하기 위한 단계별 가이드

Jun 10, 2024 am 09:16 AM

번역기 | Bugatti 리뷰 | Chonglou 이 문서에서는 GroqLPU 추론 엔진을 사용하여 JanAI 및 VSCode에서 초고속 응답을 생성하는 방법을 설명합니다. 모두가 AI의 인프라 측면에 초점을 맞춘 Groq와 같은 더 나은 대규모 언어 모델(LLM)을 구축하기 위해 노력하고 있습니다. 이러한 대형 모델의 빠른 응답은 이러한 대형 모델이 더 빠르게 응답하도록 보장하는 핵심입니다. 이 튜토리얼에서는 GroqLPU 구문 분석 엔진과 API 및 JanAI를 사용하여 노트북에서 로컬로 액세스하는 방법을 소개합니다. 이 기사에서는 코드 생성, 코드 리팩터링, 문서 입력 및 테스트 단위 생성을 돕기 위해 이를 VSCode에 통합합니다. 이 기사에서는 우리만의 인공 지능 프로그래밍 도우미를 무료로 만들 것입니다. GroqLPU 추론 엔진 Groq 소개

Yu Chengdong이 Huawei Terminal BG의 CEO 자리에서 물러나고 He Gang이 CEO가 됩니다.

May 02, 2024 pm 04:01 PM

Yu Chengdong이 Huawei Terminal BG의 CEO 자리에서 물러나고 He Gang이 CEO가 됩니다.

May 02, 2024 pm 04:01 PM

여러 언론 보도에 따르면 화웨이는 4월 30일 오후 내부적으로 인사 조정 문건을 발표해 위청둥(Yu Chengdong)이 화웨이 터미널 BG CEO직에서 물러날 것이라고 밝혔다. Yu Chengdong은 여전히 터미널BG 회장직을 유지합니다. 전 화웨이 터미널 BG 겸 최고운영책임자(COO)인 허강(He Gang)이 화웨이 터미널 BG의 CEO 자리를 맡게 된다. 보도에 따르면, 위에서 언급한 개인적인 변경 및 조정 외에 해당 문서에는 더 이상의 정보가 포함되어 있지 않습니다. 이번 대대적인 인사 변경 배경과 유청동이 터미널BG CEO에서 물러난 후 새로운 사업에 집중하게 된 배경에 대해서는 더 이상의 설명이 없다. 일부 소식통은 이번 조정이 일상적인 사업 구조 조정으로 Yu Chengdong이 소비자를 위한 고품질 제품을 만드는 데 더 많은 에너지를 갖게 될 것이라고 말했습니다. Yu Chengdong은 1969년에 태어났습니다. 그는 Tsinghua University에서 학사 및 석사 학위를 취득하고 Northwestern Polytechnical University의 자동 제어학과를 졸업했습니다.

7가지 멋진 GenAI 및 LLM 기술 인터뷰 질문

Jun 07, 2024 am 10:06 AM

7가지 멋진 GenAI 및 LLM 기술 인터뷰 질문

Jun 07, 2024 am 10:06 AM

AIGC에 대해 자세히 알아보려면 다음을 방문하세요. 51CTOAI.x 커뮤니티 https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou는 인터넷 어디에서나 볼 수 있는 전통적인 문제 은행과 다릅니다. 고정관념에서 벗어나 생각해야 합니다. LLM(대형 언어 모델)은 데이터 과학, 생성 인공 지능(GenAI) 및 인공 지능 분야에서 점점 더 중요해지고 있습니다. 이러한 복잡한 알고리즘은 인간의 기술을 향상시키고 많은 산업 분야에서 효율성과 혁신을 촉진하여 기업이 경쟁력을 유지하는 데 핵심이 됩니다. LLM은 자연어 처리, 텍스트 생성, 음성 인식 및 추천 시스템과 같은 분야에서 광범위하게 사용될 수 있습니다. LLM은 대량의 데이터로부터 학습하여 텍스트를 생성할 수 있습니다.

HarmonyOS NEXT 네이티브 인텔리전스가 AI 빅모델 시대에 새로운 OS 경험을 열어드립니다! 화웨이 샤오이(Huawei Xiaoyi)가 스마트한 몸으로 변신하다

Jun 22, 2024 am 02:30 AM

HarmonyOS NEXT 네이티브 인텔리전스가 AI 빅모델 시대에 새로운 OS 경험을 열어드립니다! 화웨이 샤오이(Huawei Xiaoyi)가 스마트한 몸으로 변신하다

Jun 22, 2024 am 02:30 AM

AI 대형 모델은 현재 기술계에서 뜨거운 주제가 되었습니다. 점점 더 많은 회사가 대형 모델 기능을 배포하기 시작하고 점점 더 많은 제품이 AI를 강조하기 시작했습니다. 그러나 현재의 경험으로 볼 때, 시장에 범람하는 대부분의 AI 제품은 단순히 애플리케이션 수준에서 대규모 모델 애플리케이션을 통합하고 상향식으로 체계적인 AI 기술 변화를 실현하지 못하는 경우가 많습니다. HDC2024에서 개발자와 선구적인 사용자에게 HarmonyOSNEXT 베타를 공개하면서 Huawei는 진정한 "네이티브 인텔리전스"가 무엇인지 업계에 시연했습니다. 시스템 수준의 AI 기능을 통해 AI는 더 이상 휴대폰의 추가 기능이 아니라 통합 운영 체제는 긴밀하게 통합되어 시스템 수준의 핵심 기능이 됩니다. 보고서에 따르면 HarmonyO는 소프트웨어, 하드웨어 및 코어 클라우드의 통합을 통해

Xiaoyi가 지능형 에이전트로 업그레이드되었습니다! HarmonyOS NEXT Hongmeng 네이티브 인텔리전스가 새로운 AI 시대를 엽니다

Jun 22, 2024 am 01:56 AM

Xiaoyi가 지능형 에이전트로 업그레이드되었습니다! HarmonyOS NEXT Hongmeng 네이티브 인텔리전스가 새로운 AI 시대를 엽니다

Jun 22, 2024 am 01:56 AM

6월 21일, 화웨이 개발자 컨퍼런스 2024(HDC2024)가 둥관 송산호에서 다시 모였습니다. 이번 컨퍼런스에서 가장 눈길을 끄는 점은 HarmonyOSNEXT가 개발자와 선구적인 사용자를 위한 베타를 공식적으로 출시하고 모든 시나리오, 기본 인텔리전스 및 기본 보안에서 HarmonyOSNEXT의 세 가지 "최고의" 혁신 기능을 포괄적으로 시연한다는 것입니다. HarmonyOSNEXT 네이티브 인텔리전스: 새로운 AI 시대를 열다 HarmonyOSNEXT는 안드로이드 프레임워크를 버리고 안드로이드와 iOS로부터 독립된 진정한 독립 운영체제가 되었으며, 이는 전례 없는 재탄생이라고 할 수 있습니다. 많은 새로운 기능 중에서 네이티브 인텔리전스는 의심할 여지 없이 사용자에게 직관적인 느낌과 업그레이드 경험을 가장 잘 제공할 수 있는 새로운 기능입니다.

OpenHarmony에서 대규모 언어 모델을 로컬로 배포

Jun 07, 2024 am 10:02 AM

OpenHarmony에서 대규모 언어 모델을 로컬로 배포

Jun 07, 2024 am 10:02 AM

이 기사는 제2회 OpenHarmony 기술 컨퍼런스에서 시연된 "OpenHarmony에서 대규모 언어 모델의 로컬 배포" 결과를 오픈 소스로 제공합니다. 오픈 소스 주소: https://gitee.com/openharmony-sig/tpc_c_cplusplus/blob/master/thirdparty /InferLLM/docs/hap_integrate.md. 구현 아이디어와 단계는 경량 LLM 모델 추론 프레임워크 InferLLM을 OpenHarmony 표준 시스템에 이식하고 OpenHarmony에서 실행할 수 있는 바이너리 제품을 컴파일하는 것입니다. InferLLM은 간단하고 효율적인 L입니다.

홍멍 스마트 트래블 S9과 풀시나리오 신제품 출시 컨퍼런스, 다수의 블록버스터 신제품이 함께 출시됐다

Aug 08, 2024 am 07:02 AM

홍멍 스마트 트래블 S9과 풀시나리오 신제품 출시 컨퍼런스, 다수의 블록버스터 신제품이 함께 출시됐다

Aug 08, 2024 am 07:02 AM

오늘 오후 Hongmeng Zhixing은 공식적으로 새로운 브랜드와 신차를 환영했습니다. 8월 6일, Huawei는 Hongmeng Smart Xingxing S9 및 Huawei 전체 시나리오 신제품 출시 컨퍼런스를 개최하여 파노라마식 스마트 플래그십 세단 Xiangjie S9, 새로운 M7Pro 및 Huawei novaFlip, MatePad Pro 12.2인치, 새로운 MatePad Air, Huawei Bisheng을 선보였습니다. 레이저 프린터 X1 시리즈, FreeBuds6i, WATCHFIT3 및 스마트 스크린 S5Pro를 포함한 다양한 새로운 올-시나리오 스마트 제품, 스마트 여행, 스마트 오피스, 스마트 웨어에 이르기까지 화웨이는 풀 시나리오 스마트 생태계를 지속적으로 구축하여 소비자에게 스마트한 경험을 제공합니다. 만물인터넷. Hongmeng Zhixing: 스마트 자동차 산업의 업그레이드를 촉진하기 위한 심층적인 권한 부여 화웨이는 중국 자동차 산업 파트너와 손을 잡고

Huawei Pura70에서 AI 클라우드 향상 기능을 사용하는 방법_Huawei AI 클라우드 향상 사용 튜토리얼

Apr 26, 2024 pm 02:20 PM

Huawei Pura70에서 AI 클라우드 향상 기능을 사용하는 방법_Huawei AI 클라우드 향상 사용 튜토리얼

Apr 26, 2024 pm 02:20 PM

Huawei의 AI 클라우드 향상 기능은 인공 지능 기술을 사용하여 사진 품질을 최적화하는 실용적인 기능입니다. 그렇다면 Huawei Pura70은 AI 클라우드 향상 기능을 어떻게 사용합니까? 어려운 친구들은 오셔서 아래 내용을 살펴보시기 바랍니다. 1. 최신 버전으로 업그레이드: 1. 최신 버전인 Hongmeng OS4.0.0.126을 다운로드하여 설치합니다. 2. 설치가 완료될 때까지 기다리면 새로운 클라우드 강화 기능을 사용할 수 있습니다. 2. 클라우드 향상 서비스를 켜십시오. 1. 사진 앨범을 열고 오른쪽 상단 모서리에 있는 점 4개를 클릭한 후 설정을 클릭하십시오. 2. AI 클라우드 강화 기능을 켜주세요. 3. 클라우드 향상 기능 사용: 1. 앨범에서 AI 클라우드 향상이 필요한 사진을 찾아 오른쪽 상단에 있는 마술 지팡이 아이콘을 클릭합니다. 2. 동의를 클릭합니다. 3. AI 클라우드 강화가 완료되면 앨범에 사진 한 장이 자동으로 추가됩니다. 오른쪽 하단에 마법이 보입니다.