2월 8일 뉴스 Microsoft의 번영에 비해 AI 분야에서 Apple의 레이아웃은 훨씬 낮습니다. 그러나 이것이 Apple이 이 분야에서 아무런 성과를 내지 못했다는 의미는 아닙니다. Apple은 최근 자연어 명령을 기반으로 이미지를 편집할 수 있는 새로운 오픈소스 인공지능 모델 "MGIE"를 출시했습니다.

이미지 출처: VentureBeat Midjourney와 공동 제작

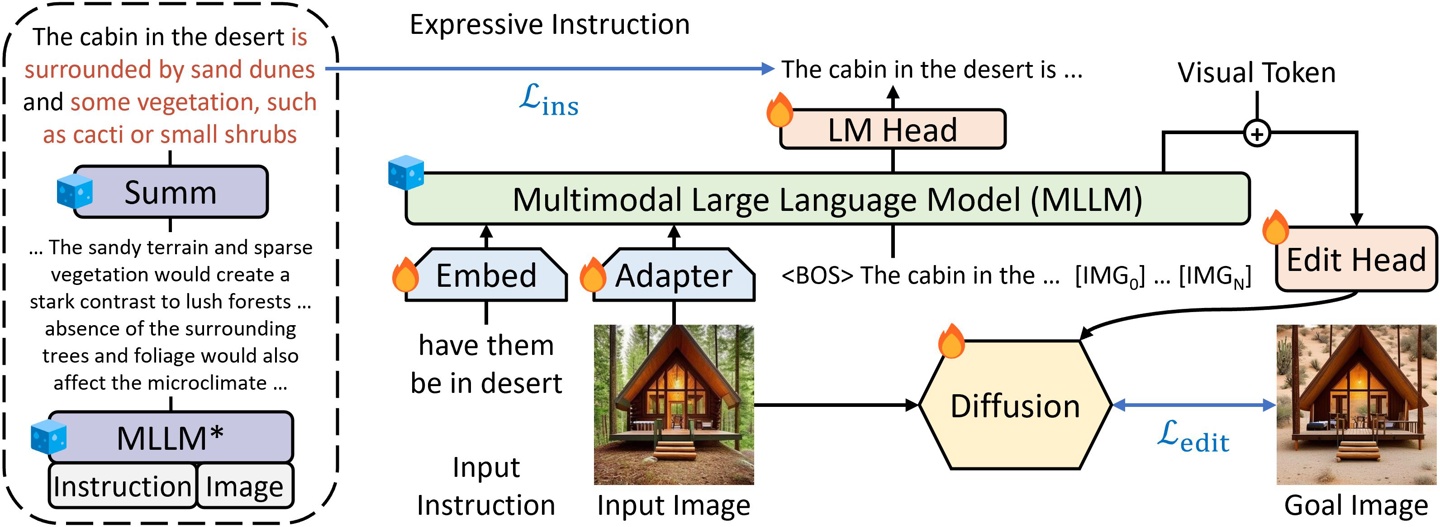

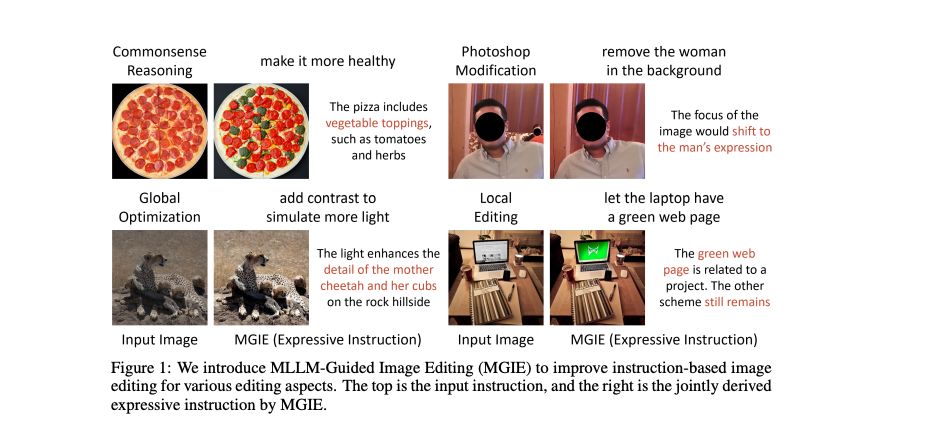

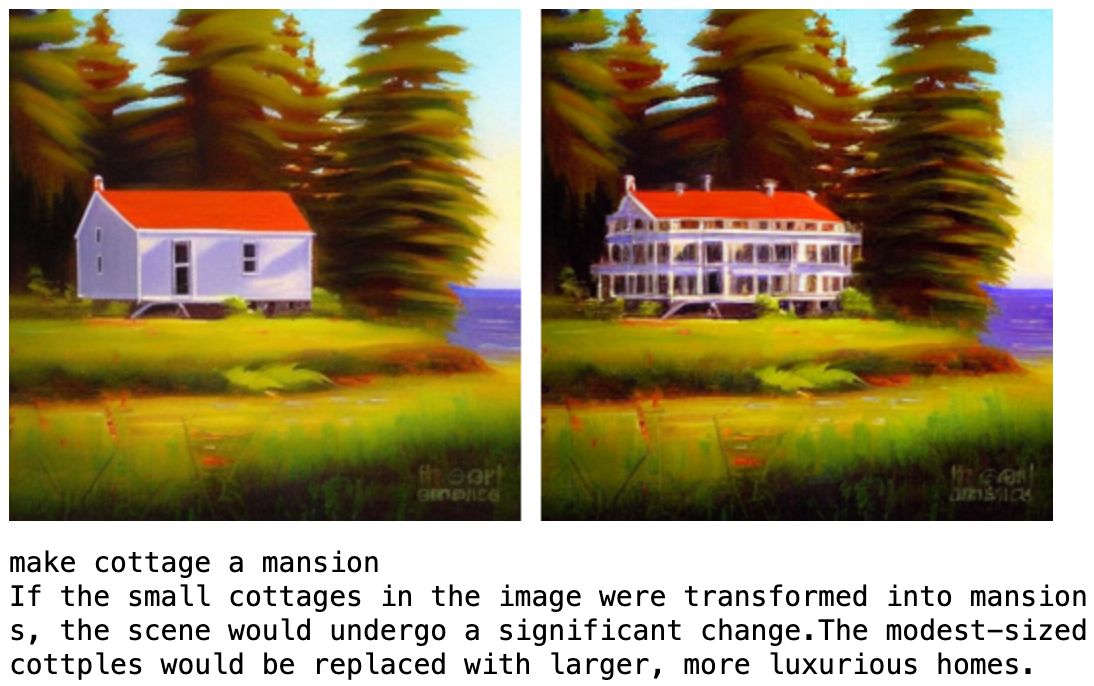

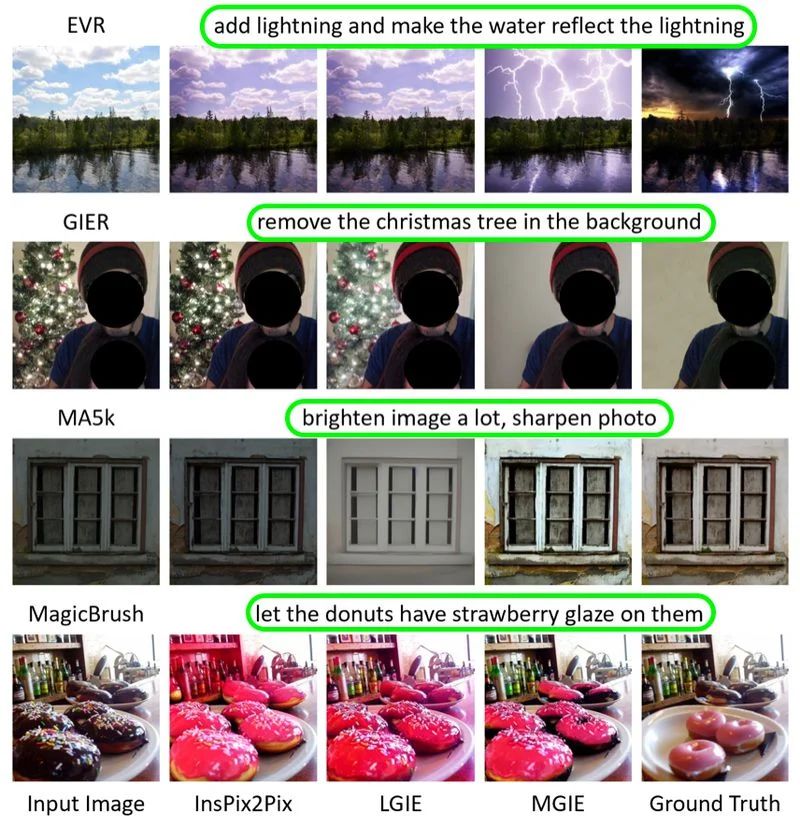

MGIE(MLLM-Guided Image Editing)는 다중 모드 대형 언어 모델(MLLM)을 사용하여 사용자 지침을 해석하고 픽셀 수준에서 수행하는 기술입니다. 운영. 사용자의 자연어 명령을 이해하고 Photoshop과 같은 수정, 전역 사진 최적화 및 로컬 편집을 수행할 수 있습니다. MGIE를 통해 사용자는 복잡한 이미지 처리 소프트웨어에 익숙하지 않아도 사진에 대한 다양한 편집을 쉽게 수행할 수 있습니다. 이 기술은 이미지 편집 프로세스를 단순화하는 동시에 보다 직관적이고 효율적인 편집 방법을 제공합니다.

Apple은 캘리포니아 대학교 샌타바버라 캠퍼스의 연구진과 협력하여 2024 ICLR(International Conference on Learning Representations)에서 MGIE 관련 연구 결과를 발표했습니다. ICLR은 인공지능 연구 분야에서 가장 중요한 학회 중 하나입니다.

MGIE를 소개하기 전에 이 사이트에서는 MLLM(Multimodal Language Learning Model)에 대해 간략하게 소개하겠습니다. MLLM은 텍스트와 이미지를 동시에 처리할 수 있어 명령 기반 이미지 편집 기능이 향상된다는 점에서 독보적인 강력한 인공지능 모델입니다. MLLM은 교차 모달 이해 및 시각적 지각 반응 생성에서 뛰어난 기능을 보여주었지만 아직 이미지 편집 작업에 널리 사용되지는 않았습니다.

MGIE는 두 가지 방법으로 MLLM을 이미지 편집 프로세스에 통합합니다. 첫째, MLLM을 활용하여 사용자 입력에서 정확하고 표현력이 풍부한 지침을 도출합니다. 이 지침은 간결하고 명확하여 편집 과정에 대한 명확한 지침을 제공합니다.

예를 들어 "하늘을 더 파랗게 만드세요"라고 입력하면 MGIE는 "하늘 영역의 채도를 20% 증가"라는 명령을 생성할 수 있습니다.

두 번째로 MLLM을 사용하여 시각적 상상력, 즉 원하는 편집 내용의 잠재 표현을 생성합니다. 이 표현은 편집의 본질을 포착하고 픽셀 수준 작업을 안내하는 데 사용될 수 있습니다. MGIE는 명령어 도출, 시각적 상상력 및 이미지 편집 모듈을 공동으로 최적화하는 새로운 엔드투엔드 교육 방식을 사용합니다.

MGIE는 간단한 색상 조정부터 복잡한 개체 조작까지 다양한 편집 상황을 처리할 수 있습니다. 모델은 사용자의 기본 설정에 따라 전역 및 로컬 편집을 수행할 수도 있습니다. MGIE의 특징과 기능 중 일부는 다음과 같습니다:

MGIE는 GitHub의 오픈 소스 프로젝트입니다. 사용자는 여기를 클릭하여 코드, 데이터 및 사전 훈련된 모델을 찾을 수 있습니다. 이 프로젝트는 또한 MGIE를 사용하여 다양한 편집 작업을 완료하는 방법을 보여주는 데모 노트북을 제공합니다.

위 내용은 애플, 한 문장으로 그림을 다듬는 새로운 AI 모델 MGIE 선보여의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!