이 기사는 0차 최적화의 확장성을 향상시키는 연구입니다. 코드는 오픈 소스이며 논문은 ICLR 2024에 승인되었습니다.

오늘은 미시간 주립대학교와 로렌스 리버모어 국립연구소가 공동으로 완성한 "DeepZero: Scaling up Zeroth-Order Optimization for Deep Model Training"이라는 제목의 논문을 소개하고자 합니다. 이 논문은 최근 ICLR 2024 컨퍼런스에서 승인되었으며, 연구팀은 코드를 오픈 소스로 만들었습니다. 본 논문의 주요 목표는 딥러닝 모델 훈련에서 0차 최적화 기술을 확장하는 것입니다. 0차 최적화는 기울기 정보에 의존하지 않고 고차원 매개변수 공간과 복잡한 모델 구조를 더 잘 처리할 수 있는 최적화 방법입니다. 그러나 기존의 0차 최적화 방법은 딥 러닝 모델을 다룰 때 규모 및 효율성 문제에 직면합니다. 이러한 과제를 해결하기 위해 연구팀은 DeepZero 프레임워크를 제안했습니다. 이 프레임워크는 새로운 샘플링 전략과 적응형 조정 메커니즘을 도입하여 대규모 딥 러닝 모델의 훈련을 효율적으로 처리할 수 있습니다. DeepZero는 영차 최적화를 활용하고 분산 컴퓨팅과 병렬화 기술을 결합하여 훈련을 가속화합니다

문서 주소: https://arxiv.org/abs/2310.02025

프로젝트 주소: https ://www.optml-group.com/posts/deepzero_iclr24

1. 배경

ZO(Zeroth-Order) 최적화는 기계 학습(Machine Learning)의 솔루션이 되었습니다. 특히 다음과 같은 문제에 대한 인기 있는 기술입니다. 1차(FO) 정보가 어렵거나 이용 가능하지 않음:

물리학 및 화학과 같은 분야: 기계 학습 모델은 복잡한 시뮬레이터 또는 실험과 결합될 수 있음 기본 시스템이 미분 불가능한 상호 작용.

블랙박스 학습 시나리오: 블랙박스 딥러닝 모델에 대한 적대적 공격 및 방어, 블랙박스 프롬프트 학습 등 딥러닝(Deep Learning) 모델이 타사 API와 통합되는 경우 언어 모델 서비스.

하드웨어 제한: 하드웨어 시스템에서 딥 러닝 모델을 구현할 때 1차 기울기를 계산하는 데 사용되는 기본 역전파 메커니즘이 지원되지 않을 수 있습니다.

그러나 현재 0차 최적화의 확장성은 해결되지 않은 문제로 남아 있습니다. 그 사용은 주로 샘플 수준의 적대적 공격 생성과 같은 비교적 소규모 기계 학습 문제로 제한됩니다. 문제의 차원이 증가함에 따라 기존 0차 방법의 정확성과 효율성은 감소합니다. 이는 0차 유한 차분을 기반으로 한 기울기 추정이 1차 기울기의 편향된 추정이고, 고차원 공간에서 편차가 더 뚜렷하기 때문입니다. 이러한 과제는 이 기사에서 논의된 핵심 질문인 딥 러닝 모델을 훈련할 수 있도록 0차 최적화를 확장하는 방법에 대한 동기를 부여합니다.

2. 0차 기울기 추정: RGE 또는 CGE?

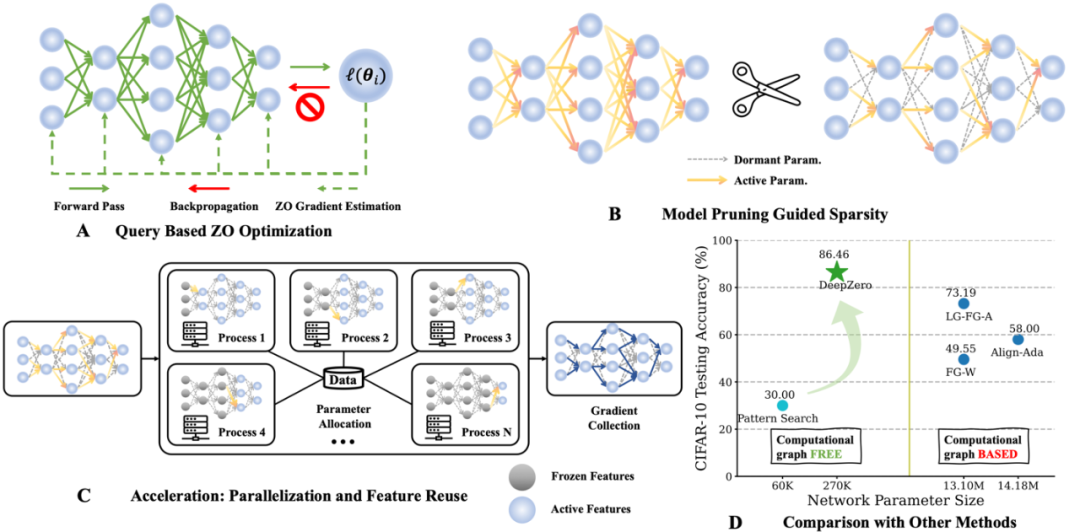

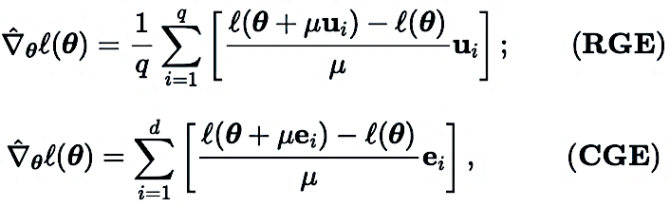

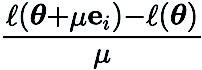

0차 최적화 프로그램은 입력을 제출하고 해당 함수 값을 수신하는 방식으로만 목적 함수와 상호 작용합니다. 아래와 같이 두 가지 주요 기울기 추정 방법이 있습니다: 좌표 기울기 추정(CGE) 및 무작위 기울기 추정(RGE) 네트워크의 모델 매개변수).

In(RGE),  은 표준 가우스 분포에서 추출된 임의의 섭동 벡터를 나타냅니다.

은 표준 가우스 분포에서 추출된 임의의 섭동 벡터를 나타냅니다.

In(CGE)에서  는 표준 기저 벡터를 나타내고

는 표준 기저 벡터를 나타내고  는 해당 좌표에서

는 해당 좌표에서  편도함수의 유한 차분 추정값을 제공합니다.

편도함수의 유한 차분 추정값을 제공합니다.

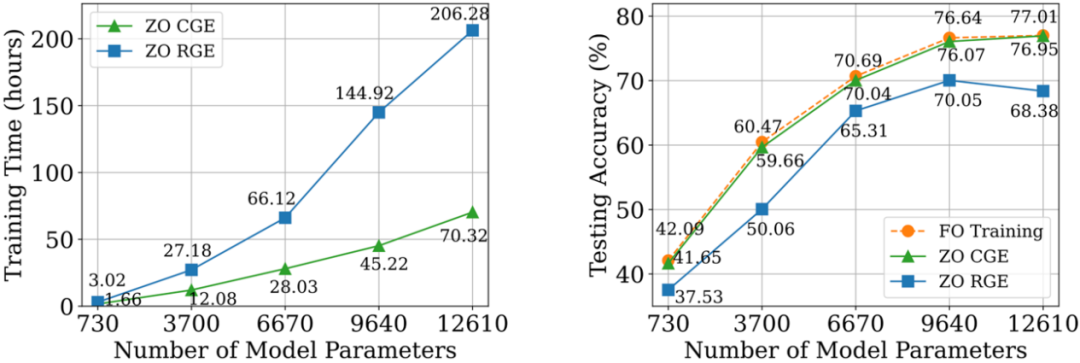

CGE와 비교하여 RGE는 함수 평가 횟수를 줄일 수 있는 유연성을 갖추고 있습니다. 높은 쿼리 효율성에도 불구하고 RGE가 처음부터 심층 모델을 학습할 때 만족스러운 정확도를 제공할 수 있는지 여부는 여전히 불확실합니다. 이를 위해 우리는 RGE와 CGE를 사용하여 CIFAR-10에서 다양한 크기의 소규모 CNN(Convolutional Neural Network)을 훈련시키는 조사를 수행했습니다. 아래 그림에서 볼 수 있듯이 CGE는 1차 최적화 훈련과 비슷한 테스트 정확도를 달성할 수 있으며 RGE보다 훨씬 더 효율적입니다.

정확성과 계산 효율성 측면에서 RGE에 비해 CGE의 장점을 기반으로 우리는 CGE를 선호하는 0차 기울기 추정기로 선택합니다. 그러나 CGE의 쿼리 복잡성은 모델 크기에 따라 확장되므로 병목 현상으로 남아 있습니다.

3. 0차 딥 러닝 프레임워크: DeepZero

우리가 아는 한, 심층 신경망(DNN)을 훈련할 때 성능을 크게 저하시키지 않고 ZO 최적화의 효과를 입증한 이전 연구는 없습니다. 이러한 장애물을 극복하기 위해 우리는 0차 최적화를 처음부터 신경망 훈련으로 확장할 수 있는 원칙적인 0차 최적화 딥 러닝 프레임워크인 DeepZero를 개발했습니다.

a) 0차 모델 가지치기(ZO-GraSP): 무작위로 초기화된 조밀한 신경망에는 고품질 희소 하위 네트워크가 포함되는 경우가 많습니다. 그러나 가장 효과적인 가지치기 방법에는 중간 단계로 모델 훈련이 포함됩니다. 따라서 0차 최적화를 통해 희소성을 찾는 데 적합하지 않습니다. 위의 문제를 해결하기 위해 우리는 초기화 프루닝(initialization pruning)이라는 훈련이 필요 없는 프루닝 방법에서 영감을 받았습니다. 이러한 방법 중 GraSP(Gradient Signal Preserving)가 선택되었는데, 이는 네트워크의 경사 흐름을 무작위로 초기화하여 신경망의 희소성 사전을 식별하는 방법입니다.

b) Sparse Gradient: 밀도가 높은 모델 교육의 정확성 이점을 유지하기 위해 CGE에서는 가중치 희소성 대신 경사 희소성을 통합합니다. 이를 통해 희소 모델을 훈련하는 대신 가중치 공간에서 조밀한 모델을 훈련할 수 있습니다. 구체적으로, 우리는 ZO-GraSP를 활용하여 DNN 압축성을 포착할 수 있는 레이어별 가지치기 비율(LPR)을 결정한 다음 0차 최적화는 부분 모델 매개변수 가중치를 지속적으로 반복적으로 업데이트하여 밀집 모델을 훈련할 수 있습니다. 여기서 희소 기울기 비율은 다음과 같습니다. LPR에 의해 결정됩니다.

c) 기능 재사용: CGE는 각 매개변수 요소별로 교란하므로 입력 계층에서 시작하는 대신 섭동 계층 바로 앞의 기능을 재사용하고 나머지 순방향 전파 작업을 수행 수행할 수 있습니다. 경험적으로 기능 재사용이 가능한 CGE는 학습 시간을 2배 이상 단축할 수 있습니다.

d) Front-pass 병렬화: CGE는 모델 훈련의 병렬화를 지원합니다. 이 분리 속성을 사용하면 분산 시스템 전반에 걸쳐 순방향 전파를 확장하여 0차 훈련 속도를 크게 높일 수 있습니다.

4. 실험 분석

a) 이미지 분류

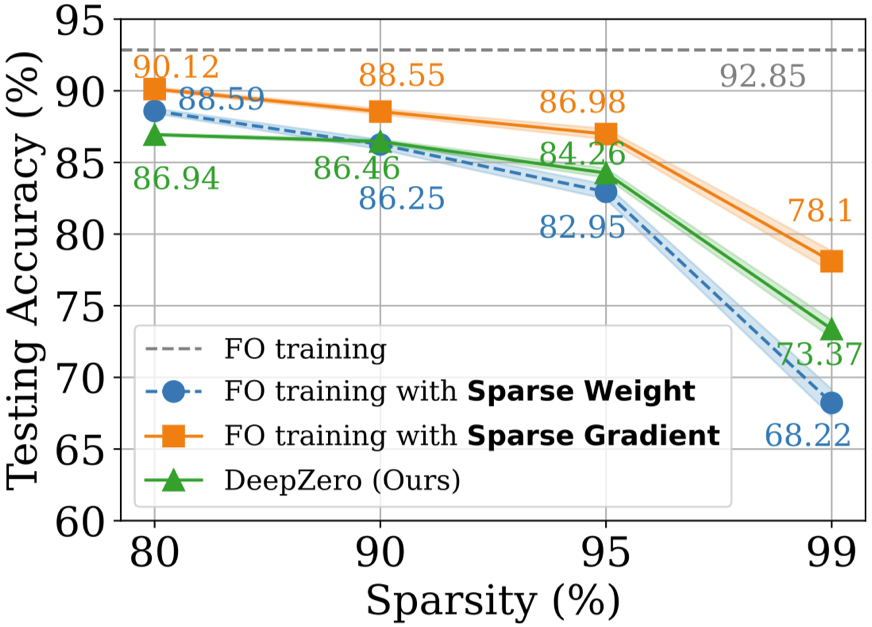

CIFAR-10 데이터 세트에서 DeepZero로 학습한 ResNet-20을 1차 최적화로 학습한 두 가지 변형과 비교합니다.

(1) Dense ResNet -20

1차 최적화 훈련으로 얻은 Sparse (2) Sparse ResNet-20은 아래 그림과 같이 1차 최적화 훈련으로 FO-GraSP로 얻은 80~99% sparse 구간이지만, (1), DeepZero를 사용하여 훈련된 모델에는 여전히 정확도 차이가 있습니다. 이는 높은 희소성 구현이 필요한 심층 모델 교육을 위한 ZO 최적화의 과제를 강조합니다. DeepZero가 90%~99% 희소성 구간에서 (2)보다 성능이 뛰어나다는 점은 주목할 가치가 있습니다. 이는

DeepZero의 가중치 희소성에 비해 경사 희소의 우월성을 입증합니다.

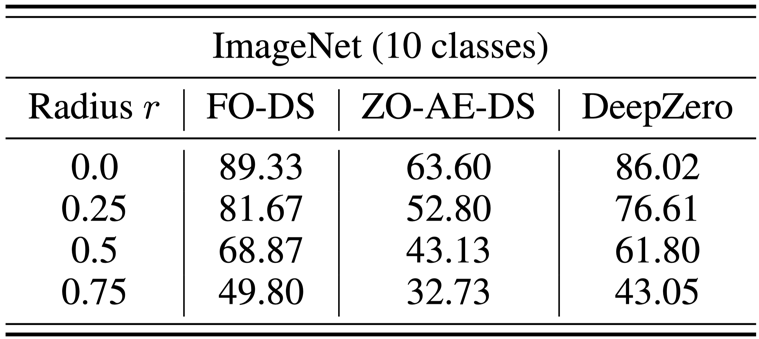

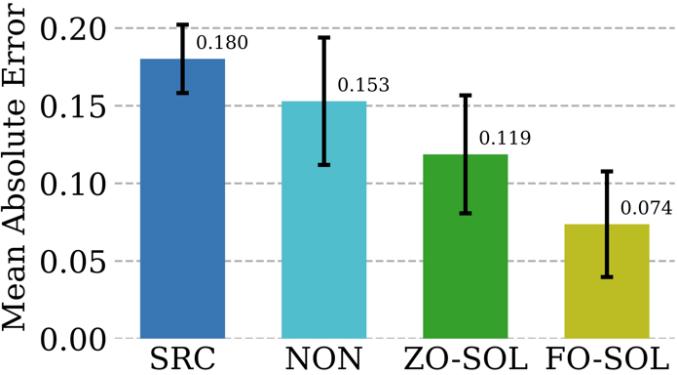

블랙박스 방어 문제는 모델 소유자가 모델 세부 정보를 방어자와 공유하기를 꺼릴 때 발생합니다. 이는 1차 최적화 훈련을 사용하여 화이트박스 모델을 직접 향상시키는 기존 견고성 향상 알고리즘에 대한 과제를 제기합니다. 이러한 문제를 극복하기 위해 화이트박스 DS(잡음 제거 평활화) 방어 작업과 블랙박스 이미지 분류기 사이에 AutoEncoder(AE)를 도입하여 훈련의 ZO 차원 문제를 해결하는 ZO-AE-DS가 제안되었습니다. ZO-AE-DS는 AE를 사용하면 블랙박스 이미지 분류기에 입력된 이미지의 충실도가 손상되고 방어 성능이 저하되므로 고해상도 데이터 세트(예: ImageNet)로 확장하기 어렵다는 단점이 있습니다. 반면, DeepZero는 자동 인코더 없이도 블랙박스 분류기와 통합되어 방어 연산을 직접 학습할 수 있습니다 . 아래 표에 표시된 것처럼 DeepZero는 CA(인증 정확도) 측면에서 모든 입력 섭동 반경에 걸쳐 지속적으로 ZO-AE-DS보다 우수한 성능을 발휘합니다. c) 시뮬레이션과 결합된 딥 러닝 수학적 방법은 물리적으로 유익한 시뮬레이션을 제공하는 데 없어서는 안 되는 필수 요소이지만 이산화에는 필연적으로 수치 오류가 발생한다는 자체적인 과제가 있습니다. 반복적인 PDE(편미분 방정식) 솔버를 사용한 순환 대화형 훈련을 통해 신경망을 수정하는 가능성을 SOL(Solver-in-the-Loop)이라고 합니다. 기존 작업은 모델 훈련을 위해 미분 가능 시뮬레이터를 사용하거나 개발하는 데 중점을 두고 있지만, DeepZero를 활용하여 SOL을 확장하여 미분 불가능 또는 블랙박스 시뮬레이터와 함께 사용할 수 있도록 합니다. 아래 표는 세 가지 다른 미분 방법을 사용하여 ZO-SOL(DeepZero에서 구현)의 테스트 오류 수정 성능을 비교합니다. (1) SRC(오류 수정 없는 저충실도 시뮬레이션) (2) NON( Non- 사전 생성된 저충실도 및 고충실도 시뮬레이션 데이터를 사용하여 시뮬레이션 루프 외부에서 수행되는 대화형 훈련) (3) FO-SOL(미분 가능한 시뮬레이터가 제공되는 SOL의 1차 훈련용). 각 테스트 시뮬레이션의 오류는 고충실도 시뮬레이션과 비교하여 수정된 시뮬레이션의 평균 절대 오류(MAE)로 계산됩니다. 결과는 DeepZero를 통해 구현된 ZO-SOL이 여전히 SRC 및 NON보다 성능이 뛰어나며 쿼리 기반 시뮬레이터 액세스만으로 FO-SOL과의 성능 격차를 줄이는 것으로 나타났습니다. NON과 비교한 ZO-SOL의 성능은 블랙박스 시뮬레이터 통합 시 ZO-SOL의 가능성을 강조합니다. 5. 요약 및 토론 본 논문에서는 딥 네트워크 훈련을 위한 0차 최적화 딥러닝 프레임워크(DeepZero)를 소개합니다. 특히 DeepZero는 좌표 기울기 추정, 0차 모델 가지치기로 인한 기울기 희소성, 기능 재사용 및 프런트패스 병렬화를 통합 교육 프로세스에 통합합니다. 이러한 혁신을 활용하여 DeepZero는 이미지 분류 및 다양한 실용적인 블랙박스 딥 러닝 시나리오를 포함한 작업에서 효율성과 효과를 입증했습니다. 또한 미분 불가능한 물리적 개체와 관련된 응용 프로그램, 계산 그래프 및 역전파 계산이 지원되지 않는 장치에 대한 교육과 같은 다른 영역에 DeepZero의 적용 가능성을 탐구합니다. 저자 소개 Zhang Yimeng, 미시간 대학교 OPTML 연구소 컴퓨터 과학 박사과정 그의 연구 관심 분야는 생성 AI, 다중 모드, 컴퓨터 비전, 안전 AI입니다. 효율적인 AI.

위 내용은 ICLR 2024 | 최초의 0차 최적화 딥 러닝 프레임워크인 MSU와 LLNL이 DeepZero를 제안합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!