Intel 오픈 소스 NPU 가속 라이브러리, Core Ultra 프로세서 AI PC는 경량의 대규모 언어 모델을 실행할 수 있습니다.

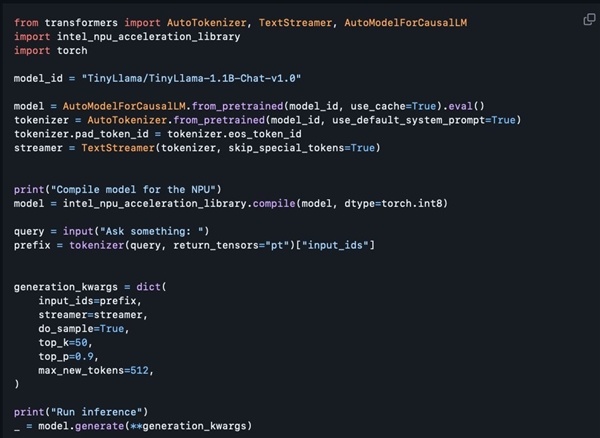

3월 4일자 뉴스에 따르면 Intel은 최근 GitHub에 NPU 가속 라이브러리를 공개했습니다. 이를 통해 Core Ultra 프로세서가 탑재된 AI PC에서 TinyLlama 및 Gemma-2b와 같은 경량의 대규모 언어 모델을 보다 원활하게 실행할 수 있습니다.

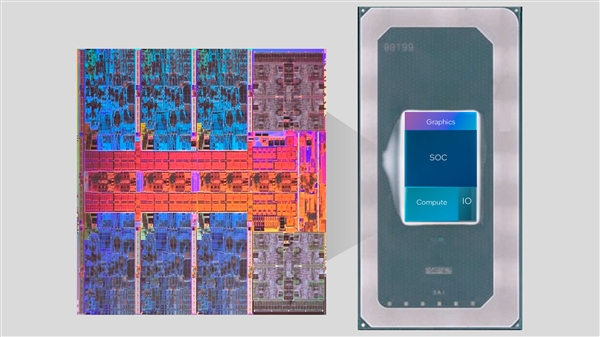

Core Ultra 시리즈는 처음으로 NPU AI 엔진을 통합합니다. 이 엔진은 일부 가벼운 AI 추론 작업을 처리하고 CPU 및 GPU와 함께 작동하여 다양한 AI 애플리케이션의 요구 사항을 충족할 수 있습니다.

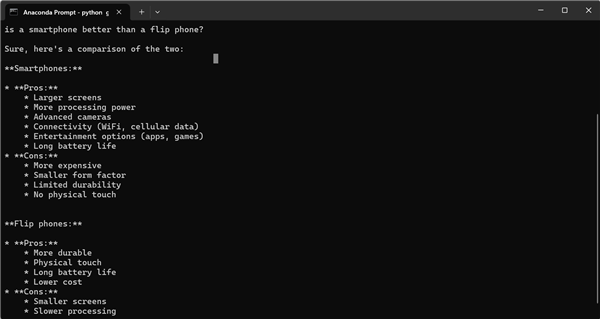

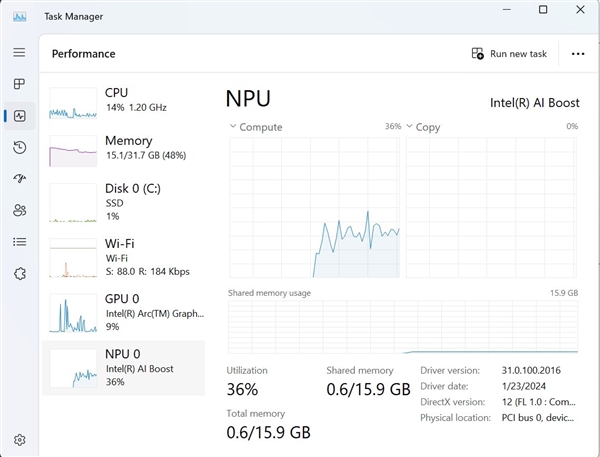

이번에 출시된 NPU 가속 라이브러리는 주로 개발자를 대상으로 준비되었지만 특정 프로그래밍 경험이 있는 사용자도 사용해 볼 수 있는 것으로 이해됩니다. Intel의 소프트웨어 설계자인 Tony Mongkolsmai는 간단한 대화를 수행할 수 있는 MSI Monarch 14 AI Evo 노트북에서 11억 개의 매개변수 TinyLlama 대형 모델을 기반으로 하는 AI 챗봇을 실행하는 방법을 시연했습니다. 동시에 Windows 작업 관리자에는 NPU에 대한 유효한 호출도 표시됩니다.

그러나 현재 오픈 소스 NPU 가속 라이브러리는 여전히 기능면에서 일부 단점이 있습니다. 8비트 양자화 및 FP16 정밀도를 지원하지만 아직 4비트 양자화, BF16 정밀도 및 NPU와 같은 고급 기능을 지원하지 않습니다. /GPU 하이브리드 컴퓨팅 및 관련 기술 문서가 아직 제공되지 않았습니다. 하지만 인텔은 앞으로 점진적으로 기능을 확장하겠다고 약속했는데, 이는 기존 기능을 두 배로 늘려 AI 개발자들에게 의심할 여지 없이 더 많은 편의성과 가능성을 가져다줄 것입니다.

위 내용은 Intel 오픈 소스 NPU 가속 라이브러리, Core Ultra 프로세서 AI PC는 경량의 대규모 언어 모델을 실행할 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7489

7489

15

15

1377

1377

52

52

77

77

11

11

52

52

19

19

19

19

40

40

누출로 Intel Arrow Lake-U, -H, -HX 및 -S의 주요 사양 공개

Jun 15, 2024 pm 09:49 PM

누출로 Intel Arrow Lake-U, -H, -HX 및 -S의 주요 사양 공개

Jun 15, 2024 pm 09:49 PM

Intel Arrow Lake는 Lunar Lake와 동일한 프로세서 아키텍처를 기반으로 할 것으로 예상됩니다. 즉, Intel의 새로운 LionCove 성능 코어가 경제적인 Skymont 효율성 코어와 결합될 것입니다. Lunar Lake는 Ava에서만 사용할 수 있습니다.

Beelink EQi12는 EQ12보다 더 강력한 미니 PC로 출시됩니다.

Aug 21, 2024 pm 08:37 PM

Beelink EQi12는 EQ12보다 더 강력한 미니 PC로 출시됩니다.

Aug 21, 2024 pm 08:37 PM

Beelink에서 새로운 미니 PC EQi12를 출시했습니다. 지난해 인텔 N100과 함께 선보인 EQ12의 업그레이드 버전이다. 최신 컴퓨터에는 고급 칩 중 하나인 Intel Core i7 12650H까지 장착할 수 있습니다.

LG, LG Gram 16 Pro 리프레시로 역대 가장 얇고 가벼운 Intel Lunar Lake 노트북 공개

Sep 10, 2024 am 06:44 AM

LG, LG Gram 16 Pro 리프레시로 역대 가장 얇고 가벼운 Intel Lunar Lake 노트북 공개

Sep 10, 2024 am 06:44 AM

LG는 이미 Intel Meteor Lake 프로세서(Amazon에서 현재 $1,699.99)를 탑재한 Gram 16 Pro를 제공하고 있습니다. 그러나 회사는 Intel이 지난주 베를린에서 열린 IFA 2024에서 선보인 Lunar Lake용 Intel의 Meteor Lake 아키텍처를 전환하기로 결정했습니다. 목

인텔 TXT란 무엇입니까?

Jun 11, 2023 pm 06:57 PM

인텔 TXT란 무엇입니까?

Jun 11, 2023 pm 06:57 PM

IntelTXT는 Intel에서 출시한 하드웨어 지원 보안 기술로, CPU와 BIOS 사이에 보호 공간을 구축하여 시작 시 서버의 무결성과 보안을 보장할 수 있습니다. TXT의 전체 이름은 TrustedExecutionTechnology, 즉 Trusted Execution Technology입니다. 간단히 말하면, TXT는 서버가 시작될 때 악성 프로그램이나 승인되지 않은 소프트웨어에 의해 서버가 수정되지 않도록 하드웨어 수준의 보호를 제공하는 보안 기술입니다. 이 하나

Intel 오픈 소스 NPU 가속 라이브러리, Core Ultra 프로세서 AI PC는 경량의 대규모 언어 모델을 실행할 수 있습니다.

Mar 05, 2024 am 11:13 AM

Intel 오픈 소스 NPU 가속 라이브러리, Core Ultra 프로세서 AI PC는 경량의 대규모 언어 모델을 실행할 수 있습니다.

Mar 05, 2024 am 11:13 AM

3월 4일 소식에 따르면, 인텔은 최근 GitHub에 NPU 가속 라이브러리를 공개했습니다. 이를 통해 Core Ultra 프로세서가 장착된 AIPC는 TinyLlama 및 Gemma-2b와 같은 경량의 대규모 언어 모델을 보다 원활하게 실행할 수 있습니다. Core Ultra 시리즈는 처음으로 NPUAI 엔진을 통합합니다. 이 엔진은 일부 경량 AI 추론 작업을 처리하고 CPU 및 GPU와 함께 작동하여 다양한 AI 애플리케이션의 요구 사항을 충족할 수 있습니다. 이번에 출시된 NPU 가속 라이브러리는 주로 개발자를 대상으로 준비됐지만 특정 프로그래밍 경험이 있는 사용자도 사용해 볼 수 있는 것으로 이해된다. Intel 소프트웨어 설계자 Tony Mongkolsmai가 다음 방법을 시연합니다.

Yoga Slim 7i Aura Edition: Lenovo는 새로운 경량 Intel Lunar Lake 노트북 출시로 삼성을 압도했습니다.

Sep 11, 2024 am 06:41 AM

Yoga Slim 7i Aura Edition: Lenovo는 새로운 경량 Intel Lunar Lake 노트북 출시로 삼성을 압도했습니다.

Sep 11, 2024 am 06:41 AM

Lenovo는 Intel Lunar Lake 기반 노트북을 처음 선보인 지 일주일도 채 안 되어 Yoga Slim 7i Aura Edition을 출시했습니다. 이 회사는 베를린에서 열린 IFA 2024에서 노트북에 대한 많은 세부 정보를 공개했지만,

Arc Battlemage: Leaks는 Intel의 차세대 게이밍 그래픽 카드용 GPU 3개에 대한 힌트를 제공합니다.

Jul 02, 2024 am 09:44 AM

Arc Battlemage: Leaks는 Intel의 차세대 게이밍 그래픽 카드용 GPU 3개에 대한 힌트를 제공합니다.

Jul 02, 2024 am 09:44 AM

Intel의 차세대 GPU 아키텍처는 Intel Lunar Lake의 일부로 9월에 출시될 예정입니다. Meteor Lake의 Arc Alchemist iGPU와 마찬가지로 iGPU에는 최대 8개의 Xe 코어가 있지만 새로운 아키텍처는 50% 더 높은 성능을 달성할 것으로 예상됩니다.

IFA 2024 | Lenovo ThinkPad X1 Carbon Gen 13 Aura Edition: X1 Nano만큼 가벼운 Lenovo 최초의 Lunar Lake ThinkPad

Sep 06, 2024 am 06:50 AM

IFA 2024 | Lenovo ThinkPad X1 Carbon Gen 13 Aura Edition: X1 Nano만큼 가벼운 Lenovo 최초의 Lunar Lake ThinkPad

Sep 06, 2024 am 06:50 AM

열셋은 나쁜 부족함으로 알려져 있다. 하지만 미신은 기술 사업에서 미덕이 아닙니다. Lenovo의 경우 13세대 프리미엄 노트북은 이전 12세대만큼 성공할 것으로 보입니다. 가장 큰 PC 제조업체인 IFA에서