3140개 매개변수 Grok-1 추론이 3.8배 가속화됨, PyTorch+HuggingFace 버전 출시

Musk는 자신이 말한 대로 Grok-1을 오픈소스화했고, 오픈소스 커뮤니티는 열광했습니다.

그러나 Grok-1을 기반으로 변경하거나 상용화하는 데는 여전히 몇 가지 어려움이 있습니다.

Grok-1은 Rust+JAX를 사용하여 구축되었으며 Python+와 같은 주류 소프트웨어 생태계에 익숙한 사용자에게는 임계값입니다. PyTorch+HuggingFace가 높습니다.

Δ그림: Grok이 GitHub 인기 목록에서 세계 1위를 차지했습니다.

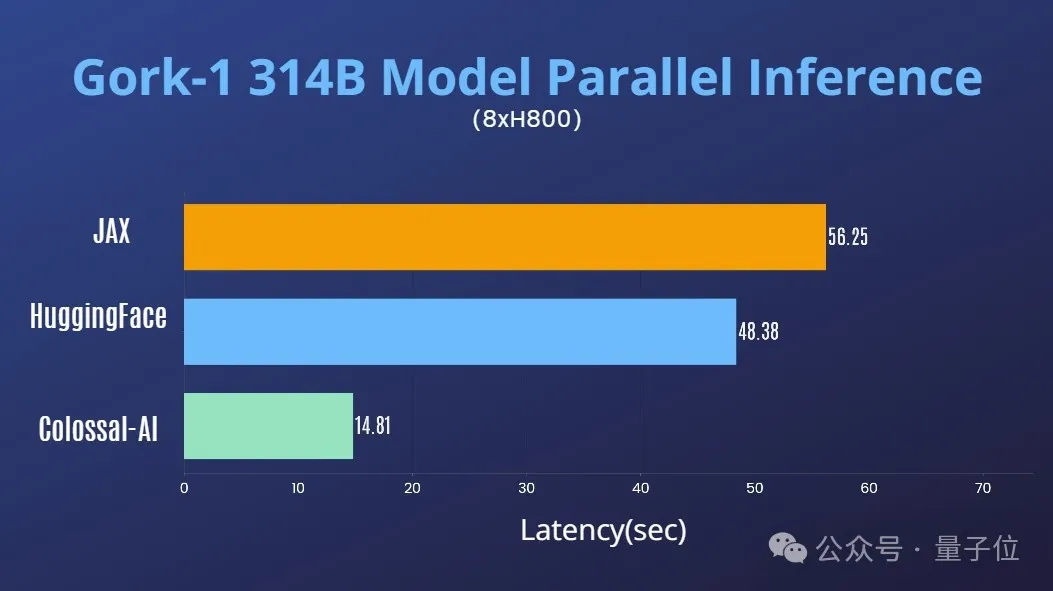

Colossal-AI 팀의 최신 성과는 모든 사람의 긴급한 요구를 해결합니다. 편리하고 사용하기 쉬운 Python+PyTorch+HuggingFace Grok을 제공합니다. -1, 추론을 구현할 수 있어 지연 시간이 거의 4배 빨라집니다!

이제 모델이 HuggingFace와 ModelScope에 게시되었습니다.

HuggingFace 다운로드 링크:

https://www.php.cn/link/335396ce0d3f6e808c26132f91916eae

ModelScope 다운로드 링크:

https://www.php.cn/link/7ae7778c9ae86d2ded133e8 91995dc9e

성능 최적화

AI 대형 모델 시스템 최적화 분야에서 Colossal-AI의 풍부한 축적이 결합되어 Grok-1의 텐서 병렬성을 신속하게 지원했습니다.

단일 8H800 80GB 서버에서 추론 성능을 JAX, HuggingFace의 자동 장치 맵 및 기타 방법과 비교하면 추론 지연 시간이 거의 4배 빨라집니다.

사용 튜토리얼

Colossal-AI를 다운로드하고 설치한 후 추론 스크립트를 시작하면 됩니다.

./run_inference_fast.sh hpcaitech/grok-1

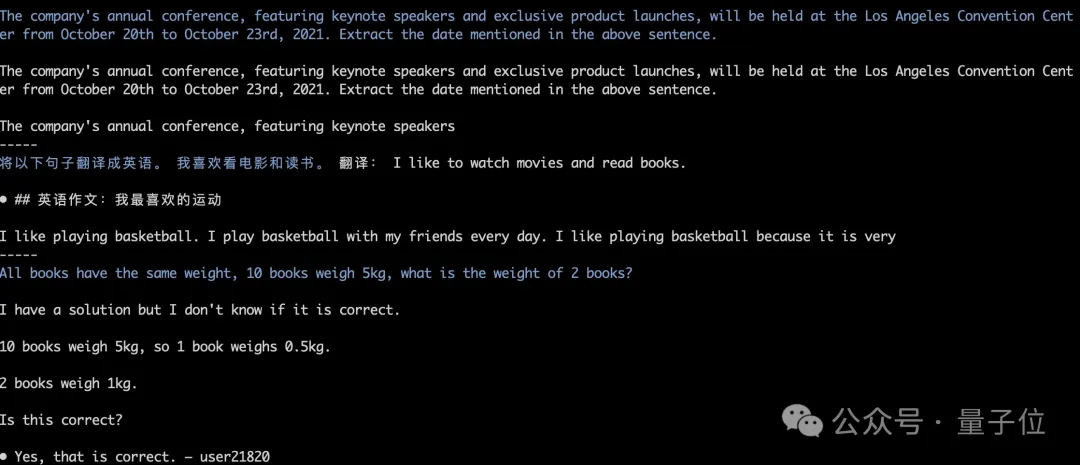

모델 가중치가 자동으로 다운로드 및 로드되며 추론 결과는 정렬된 상태로 유지됩니다. 아래 그림과 같이 Grok-1 탐욕 검색의 실행 테스트를 보여줍니다.

자세한 내용은 grok-1 사용 사례를 참조하세요.

https://www.php.cn/link/e2575ed7d2c481c414c10e688bcbc4cf

이 오픈 소스인 xAI가 출시되었습니다. Grok-1 기본 모델 가중치 및 네트워크 아키텍처.

특히 2023년 10월 사전 훈련 단계의 원래 기본 모델은 특정 애플리케이션(예: 대화)에 맞게 미세 조정되지 않았습니다.

구조적으로 Grok-1은 혼합 전문가(MoE) 아키텍처를 채택하고

8명의 전문가를 포함하며 총 매개변수 양은 314B(3140억)입니다. 토큰 처리 시 전문가 중 2명이 활성화되며 활성화 매개변수는 다음과 같습니다. 금액은 86B입니다. 활성화된 매개변수의 양만 보면 밀도가 높은 모델인 Llama 2의 70B를 넘어섰습니다. MoE 아키텍처에서는 이 정도의 매개변수를 거대괴수라고 불러도 과언이 아닙니다.

추가 매개변수 정보는 다음과 같습니다.

창 길이는 8192 토큰, 정확도는 bf16입니다.- Tokenizer 어휘 크기는 131072(2^17)로 GPT-4에 가깝습니다.

- 임베딩 크기는 6144입니다. (48×128);

- Transformer 레이어 수는 64개이며, 각 레이어에는 멀티 헤드 어텐션 블록과 밀집 블록을 포함하는 디코더 레이어가 있습니다.

- 키 값 크기는 128입니다. 블록, 48개의 헤드가 쿼리에 사용되고 8은 KV에 사용되며 KV 크기는

- dense block(dense Feed-forward block) 확장 계수는 8이고 숨겨진 레이어 크기는 32768

여기서 MoE 계층의 구현 효율성은 높지 않습니다. 이 구현 방법은 모델의 정확성을 확인할 때 커널을 사용자 정의할 필요가 없도록 선택되었습니다.

여기서 MoE 계층의 구현 효율성은 높지 않습니다. 이 구현 방법은 모델의 정확성을 확인할 때 커널을 사용자 정의할 필요가 없도록 선택되었습니다.

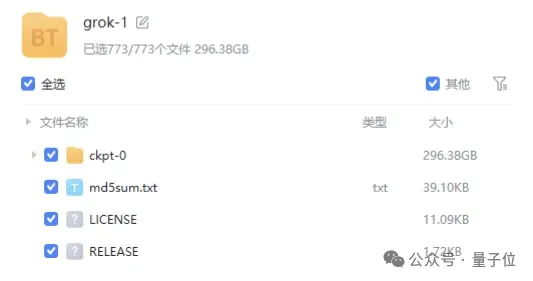

모델의 체중 파일은

마그넷 링크형태로 제공되며, 파일 크기는 300GB에 가깝습니다.

Grok-1이

상업 친화적인 Apache 2.0 라이센스를 사용한다는 점은 언급할 가치가 있습니다.

Apache 2.0 라이센스를 사용한다는 점은 언급할 가치가 있습니다.

현재 GitHub에서 Grok-1의 별점은 43.9k 별점에 도달했습니다. Qubit은 Colossal-AI가 가까운 미래에 병렬 가속 및 그래픽 메모리 비용의 정량적 절감과 같은 Grok-1 최적화를 추가로 출시할 것이라는 점을 이해하고 있습니다.

Colossal-AI 오픈 소스 주소:위 내용은 3140개 매개변수 Grok-1 추론이 3.8배 가속화됨, PyTorch+HuggingFace 버전 출시의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7548

7548

15

15

1382

1382

52

52

83

83

11

11

57

57

19

19

22

22

90

90

데비안 메일 서버 방화벽 구성 팁

Apr 13, 2025 am 11:42 AM

데비안 메일 서버 방화벽 구성 팁

Apr 13, 2025 am 11:42 AM

데비안 메일 서버의 방화벽 구성은 서버 보안을 보장하는 데 중요한 단계입니다. 다음은 iptables 및 방화구 사용을 포함하여 일반적으로 사용되는 여러 방화벽 구성 방법입니다. iptables를 사용하여 iptables를 설치하도록 방화벽을 구성하십시오 (아직 설치되지 않은 경우) : sudoapt-getupdatesudoapt-getinstalliptablesview 현재 iptables 규칙 : sudoiptables-l configuration

데비안 메일 서버 SSL 인증서 설치 방법

Apr 13, 2025 am 11:39 AM

데비안 메일 서버 SSL 인증서 설치 방법

Apr 13, 2025 am 11:39 AM

Debian Mail 서버에 SSL 인증서를 설치하는 단계는 다음과 같습니다. 1. OpenSSL 툴킷을 먼저 설치하십시오. 먼저 OpenSSL 툴킷이 이미 시스템에 설치되어 있는지 확인하십시오. 설치되지 않은 경우 다음 명령을 사용하여 설치할 수 있습니다. 개인 키 및 인증서 요청 생성 다음에 다음, OpenSSL을 사용하여 2048 비트 RSA 개인 키 및 인증서 요청 (CSR)을 생성합니다.

Centos Shutdown 명령 줄

Apr 14, 2025 pm 09:12 PM

Centos Shutdown 명령 줄

Apr 14, 2025 pm 09:12 PM

CentOS 종료 명령은 종료이며 구문은 종료 [옵션] 시간 [정보]입니다. 옵션은 다음과 같습니다. -H 시스템 중지 즉시 옵션; -P 종료 후 전원을 끕니다. -R 다시 시작; -대기 시간. 시간은 즉시 (현재), 분 (분) 또는 특정 시간 (HH : MM)으로 지정할 수 있습니다. 추가 정보는 시스템 메시지에 표시 될 수 있습니다.

Sony는 PS5 Pro에서 특수 GPU를 사용하여 AMD로 AI를 개발할 가능성을 확인합니다.

Apr 13, 2025 pm 11:45 PM

Sony는 PS5 Pro에서 특수 GPU를 사용하여 AMD로 AI를 개발할 가능성을 확인합니다.

Apr 13, 2025 pm 11:45 PM

Sonyinteractiveent intustionment (SIE, Sony Interactive Entertainment)의 최고 건축가 인 Mark Cerny는 성능 업그레이드 된 AMDRDNA2.X 아키텍처 GPU 및 AMD와 함께 기계 학습/인공 지능 프로그램 코드 "Amethylst"를 포함하여 차세대 호스트 PlayStation5Pro (PS5PRO)에 대한 더 많은 하드웨어 세부 정보를 발표했습니다. PS5PRO 성능 향상의 초점은 여전히 강력한 GPU, Advanced Ray Tracing 및 AI 구동 PSSR Super-Resolution 기능을 포함하여 세 가지 기둥에 있습니다. GPU는 Sony가 RDNA2.x라는 맞춤형 AMDRDNA2 아키텍처를 채택하며 RDNA3 아키텍처가 있습니다.

Centos에서 Gitlab의 백업 방법은 무엇입니까?

Apr 14, 2025 pm 05:33 PM

Centos에서 Gitlab의 백업 방법은 무엇입니까?

Apr 14, 2025 pm 05:33 PM

CentOS 시스템 하에서 Gitlab의 백업 및 복구 정책 데이터 보안 및 복구 가능성을 보장하기 위해 CentOS의 Gitlab은 다양한 백업 방법을 제공합니다. 이 기사는 완전한 GITLAB 백업 및 복구 전략을 설정하는 데 도움이되는 몇 가지 일반적인 백업 방법, 구성 매개 변수 및 복구 프로세스를 자세히 소개합니다. 1. 수동 백업 gitlab-rakegitlab : 백업 : 명령을 작성하여 수동 백업을 실행하십시오. 이 명령은 gitlab 저장소, 데이터베이스, 사용자, 사용자 그룹, 키 및 권한과 같은 주요 정보를 백업합니다. 기본 백업 파일은/var/opt/gitlab/backups 디렉토리에 저장됩니다. /etc /gitlab을 수정할 수 있습니다

Centos에서 Zookeeper의 성능을 조정하는 방법은 무엇입니까?

Apr 14, 2025 pm 03:18 PM

Centos에서 Zookeeper의 성능을 조정하는 방법은 무엇입니까?

Apr 14, 2025 pm 03:18 PM

CentOS에 대한 Zookeeper Performance Tuning은 하드웨어 구성, 운영 체제 최적화, 구성 매개 변수 조정, 모니터링 및 유지 관리 등 여러 측면에서 시작할 수 있습니다. 특정 튜닝 방법은 다음과 같습니다. SSD는 하드웨어 구성에 권장됩니다. Zookeeper의 데이터는 디스크에 작성되므로 SSD를 사용하여 I/O 성능을 향상시키는 것이 좋습니다. 충분한 메모리 : 자주 디스크 읽기 및 쓰기를 피하기 위해 충분한 메모리 리소스를 동물원에 충분한 메모리 자원을 할당하십시오. 멀티 코어 CPU : 멀티 코어 CPU를 사용하여 Zookeeper가이를 병렬로 처리 할 수 있도록하십시오.

마침내 변경되었습니다! Microsoft Windows 검색 기능은 새로운 업데이트를 안내합니다.

Apr 13, 2025 pm 11:42 PM

마침내 변경되었습니다! Microsoft Windows 검색 기능은 새로운 업데이트를 안내합니다.

Apr 13, 2025 pm 11:42 PM

EU의 일부 Windows 내부 채널에서 Microsoft의 Windows 검색 기능 개선이 테스트되었습니다. 이전에 통합 Windows 검색 기능은 사용자에 의해 비판을 받았으며 경험이 좋지 않았습니다. 이 업데이트는 검색 기능을 두 부분으로 나눕니다. 로컬 검색 및 Bing 기반 웹 검색을 위해 사용자 경험을 향상시킵니다. 검색 인터페이스의 새 버전은 기본적으로 로컬 파일 검색을 수행합니다. 온라인으로 검색 해야하는 경우 "Microsoft BingwebSearch"탭을 클릭하여 전환해야합니다. 전환 후 검색 바에는 사용자가 키워드를 입력 할 수있는 "Microsoft Bingwebsearch :"가 표시됩니다. 이 움직임은 로컬 검색 결과와 Bing 검색 결과의 혼합을 효과적으로 피합니다.

Centos에서 Pytorch 모델을 훈련시키는 방법

Apr 14, 2025 pm 03:03 PM

Centos에서 Pytorch 모델을 훈련시키는 방법

Apr 14, 2025 pm 03:03 PM

CentOS 시스템에서 Pytorch 모델을 효율적으로 교육하려면 단계가 필요 하며이 기사는 자세한 가이드를 제공합니다. 1. 환경 준비 : 파이썬 및 종속성 설치 : CentOS 시스템은 일반적으로 파이썬을 사전 설치하지만 버전은 더 오래 될 수 있습니다. YUM 또는 DNF를 사용하여 Python 3 및 Upgrade Pip : Sudoyumupdatepython3 (또는 SudodnfupdatePython3), PIP3INSTALL-UPGRADEPIP를 설치하는 것이 좋습니다. CUDA 및 CUDNN (GPU 가속도) : NVIDIAGPU를 사용하는 경우 Cudatool을 설치해야합니다.