자연어 처리에서는 실제로 많은 정보가 반복됩니다.

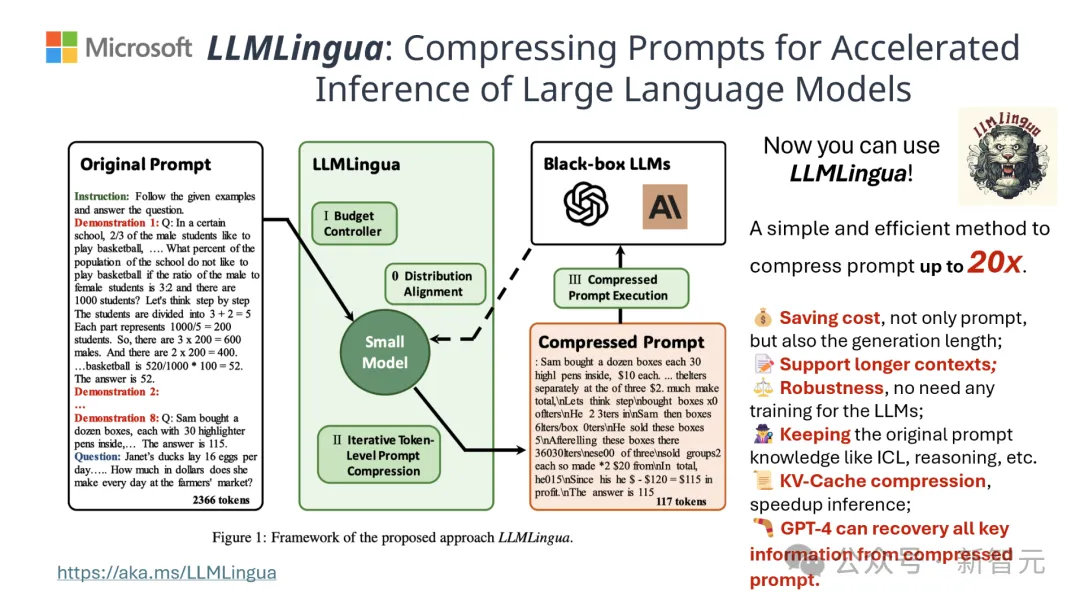

프롬프트 단어를 효과적으로 압축할 수 있다면 모델이 지원하는 컨텍스트의 길이를 어느 정도 확장하는 것과 같습니다.

기존 정보 엔트로피 방법은 특정 단어나 문구를 제거하여 이러한 중복성을 줄입니다.

그러나 정보 엔트로피를 기반으로 한 계산은 텍스트의 일방향 컨텍스트만 다루고 압축에 필요한 핵심 정보를 무시할 수 있습니다. 또한 정보 엔트로피 계산 방법은 프롬프트를 압축하는 실제 목적과 완전히 일치하지 않습니다. 단어.

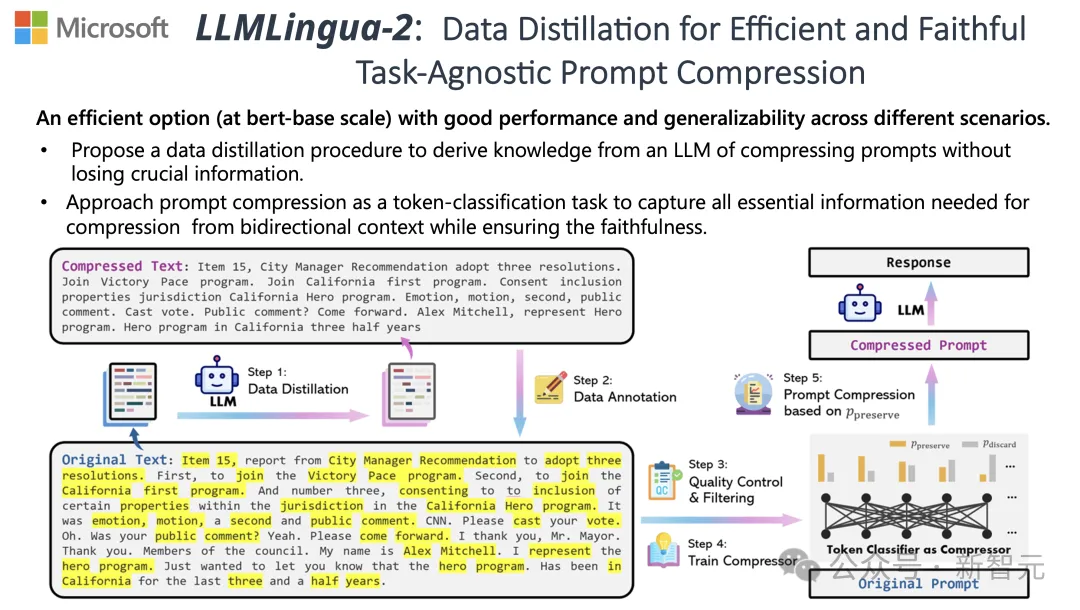

이러한 과제를 해결하기 위해 Tsinghua University의 연구원과 Microsoft는 LLMLingua-2라는 새로운 데이터 처리 프로세스를 공동으로 제안했습니다. LLM(Large Language Model)에서 지식을 추출하고 핵심 정보가 손실되지 않도록 프롬프트 단어를 압축하여 정보 정제를 달성하는 것을 목표로 합니다.

이 프로젝트는 GitHub에서 3.1,000개의 별을 얻었습니다

결과에 따르면 LLMLingua-2는 텍스트 길이를 원래의 20%로 크게 줄여 처리 시간과 비용을 효과적으로 줄일 수 있는 것으로 나타났습니다.

또한 LLMLingua 2의 처리 속도는 이전 버전의 LLMLingua 및 기타 유사한 기술에 비해 3~6배 향상되었습니다.

문서 주소: https://arxiv.org/abs/2403.12968

이 과정에서 원본 텍스트가 먼저 모델에 입력됩니다.

모델은 각 단어의 중요성을 평가하고 단어 간의 관계도 고려하면서 이를 유지할지 삭제할지 결정합니다.

마지막으로 모델은 점수가 가장 높은 단어를 선택하여 더 짧은 프롬프트 단어를 구성합니다.

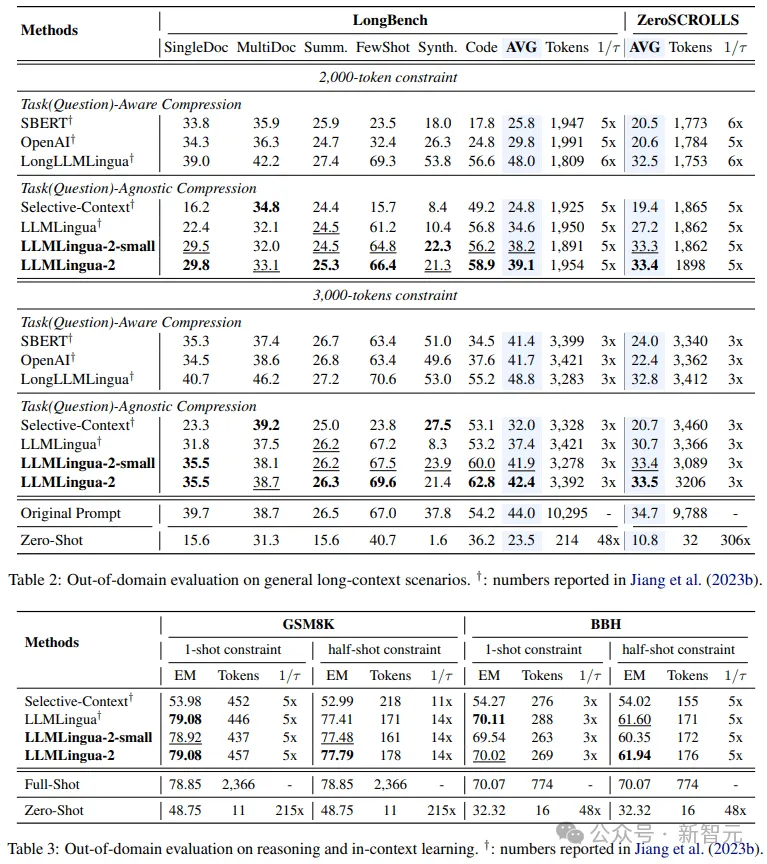

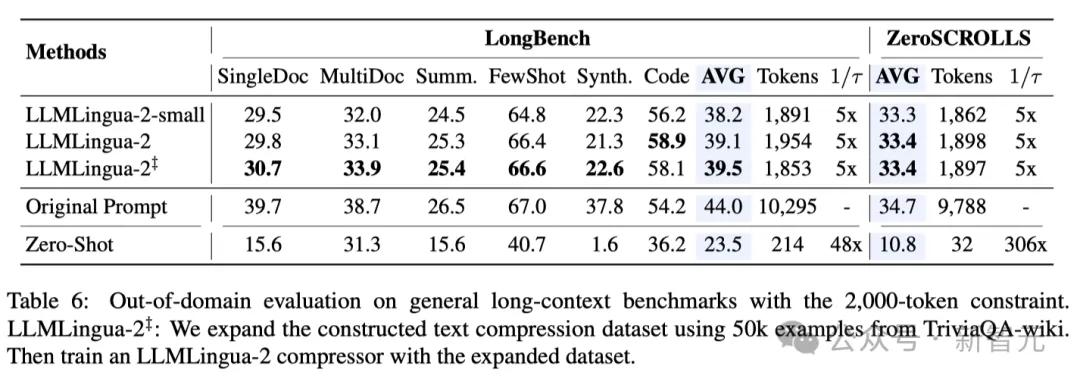

팀은 MeetingBank, LongBench, ZeroScrolls, GSM8K 및 BBH를 포함한 여러 데이터 세트에서 LLMLingua-2 모델을 테스트했습니다.

이 모델은 비록 크기는 작지만 벤치마크 테스트에서 상당한 성능 향상을 달성했으며, 다양한 대형 언어 모델(GPT-3.5부터 Mistral-7B까지)과 언어(영어부터 중국어까지)에서 성능을 입증했습니다. 일반화 능력이 뛰어나다.

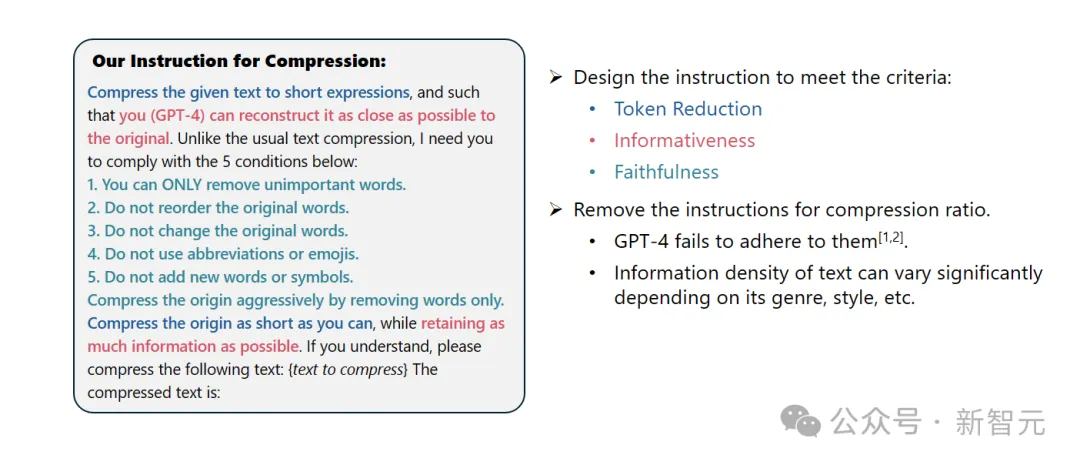

시스템 프롬프트:

당신은 뛰어난 언어학자로서 중요하지 않은 단어를 제거하여 긴 문단을 짧은 표현으로 압축하고 가능한 한 많은 정보를 유지하는 데 능숙합니다.

사용자 팁:

주어진 텍스트를 짧은 표현으로 압축하여 귀하(GPT-4)가 원본 텍스트를 최대한 정확하게 복원할 수 있도록 해주세요. 일반 텍스트 압축과 다르게 다음 5가지 조건을 따라야 합니다.

1. 중요하지 않은 단어만 제거하세요.

2. 원래 단어의 순서를 변경하지 않고 유지하세요.

3. 원래 어휘를 변경하지 않고 유지하세요.

4. 약어나 이모티콘을 사용하지 마세요.

5. 새로운 단어나 기호를 추가하지 마세요.

최대한 많은 정보를 유지하면서 원본 텍스트를 최대한 압축해 주세요. 이해하셨다면 다음 텍스트를 압축해 주세요: {압축할 텍스트}

압축된 텍스트는 [...]

결과를 보면 Q&A에서는 추상적인 글쓰기와 논리적 추론에서 다양한 언어 작업에서 LLMLlingua-2는 원래 LLMLingua 모델 및 기타 선택적 상황 전략보다 훨씬 뛰어난 성능을 발휘합니다.

이 압축 방법은 다양한 대형 언어 모델(GPT-3.5에서 Mistral-7B까지)과 다양한 언어(영어에서 중국어까지)에 동일하게 효과적이라는 점을 언급할 가치가 있습니다.

또한 단 두 줄의 코드만으로 LLMLingua-2 배포를 완료할 수 있습니다.

현재 이 모델은 널리 사용되는 RAG 프레임워크인 LangChain 및 LlamaIndex에 통합되었습니다.

기존 정보 엔트로피 기반 텍스트 압축 방법이 직면한 문제를 극복하기 위해 LLMLingua-2는 혁신적인 데이터 추출 전략을 채택합니다.

이 전략은 GPT-4와 같은 대규모 언어 모델에서 필수 정보를 추출하여 주요 내용을 잃지 않고 잘못된 정보 추가를 방지하면서 효율적인 텍스트 압축을 달성합니다.

Tips Design

GPT-4의 텍스트 압축 잠재력을 최대한 활용하려면 정확한 압축 지침을 설정하는 방법이 핵심입니다.

즉, 텍스트를 압축할 때 GPT-4에 원본 텍스트에서 덜 중요한 단어만 제거하고 그 과정에서 새로운 단어가 도입되지 않도록 지시하세요.

이의 목적은 압축된 텍스트가 원본 텍스트의 신뢰성과 무결성을 최대한 유지하도록 하는 것입니다.

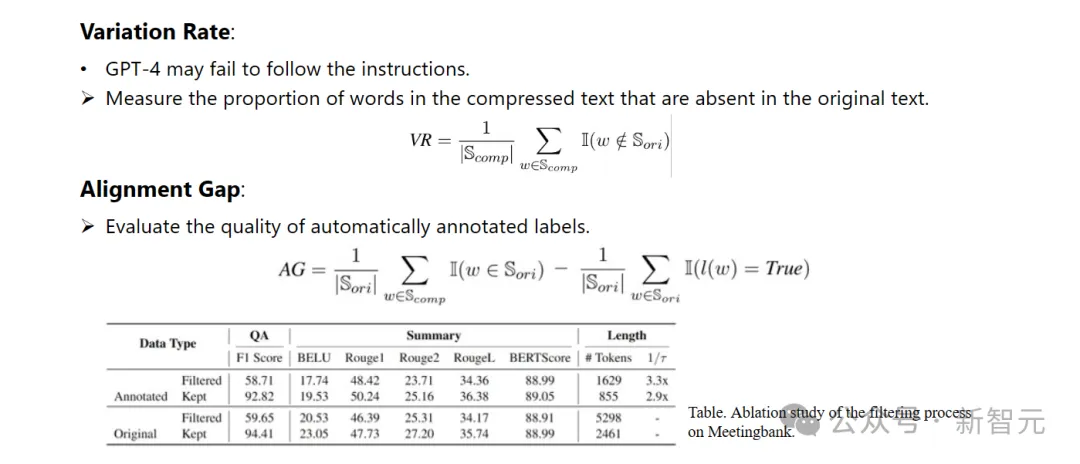

주석 및 필터링

연구원들은 GPT-4와 같은 대규모 언어 모델에서 추출한 지식을 사용하여 새로운 데이터 주석 알고리즘을 개발했습니다.

이 알고리즘은 원본 텍스트의 모든 단어에 레이블을 지정하고 압축 과정에서 어떤 단어를 유지해야 하는지 명확하게 나타낼 수 있습니다.

구성된 데이터 세트의 높은 품질을 보장하기 위해 품질이 낮은 데이터 샘플을 식별하고 제거하기 위해 특별히 두 가지 품질 모니터링 메커니즘도 설계했습니다.

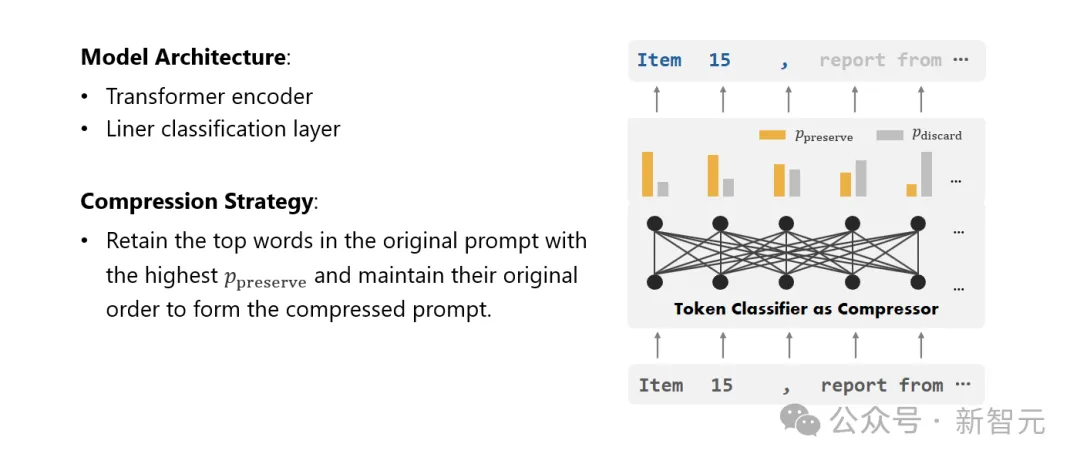

Compressor

마지막으로 연구자들은 텍스트 압축 문제를 각 어휘(토큰)를 분류하는 작업으로 전환하고 강력한 Transformer를 특징 추출기로 사용했습니다.

이 도구는 텍스트의 맥락을 이해하여 텍스트 압축에 중요한 정보를 정확하게 캡처합니다.

신중하게 구성된 데이터 세트에 대한 훈련을 통해 연구원의 모델은 각 단어의 중요도를 기반으로 확률 값을 계산하여 해당 단어가 최종 압축 텍스트에 유지되어야 하는지 아니면 버려야 하는지 결정할 수 있습니다.

연구원들은 상황 학습, 텍스트 요약, 대화 생성, 다중 및 단일 문서 Q&A, 코드 생성 등 다양한 작업에서 LLMLingua-2의 성능을 테스트했습니다. 합성 작업에는 도메인 내 데이터 세트와 도메인 외부 데이터 세트가 모두 포함됩니다.

테스트 결과, 연구진의 방법은 높은 성능을 유지하면서 성능 손실을 최소화하고, 작업 비특정 텍스트 압축 방법 중에서 좋은 성능을 발휘하는 것으로 나타났습니다.

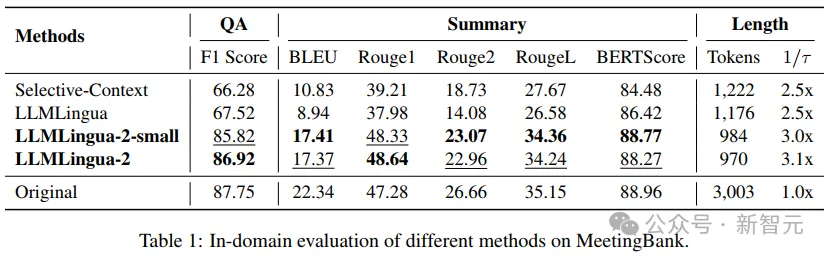

- 도메인 내 테스트(MeetingBank)

연구원들은 MeetingBank 테스트 세트에서 LLMLingua-2의 성능을 다른 강력한 기준 방법과 비교했습니다.

모델 크기는 기준선에 사용된 LLaMa-2-7B보다 훨씬 작지만, 질문 응답 및 텍스트 요약 작업에서 연구원의 방법은 성능을 크게 향상시켰을 뿐만 아니라 거의 동일한 성능을 발휘했습니다. 원본 텍스트가 프롬프트됩니다.

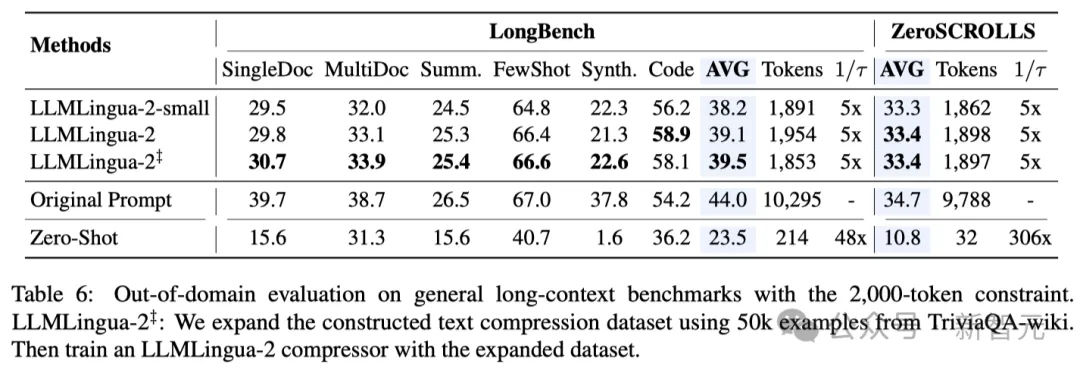

- 도메인 외부 테스트(LongBench, GSM8K 및 BBH)

연구원의 모델이 MeetingBank의 회의 기록 데이터로만 훈련되었다는 점을 고려하여 연구원은 해당 모델의 사용을 추가로 탐색했습니다. 긴 텍스트, 논리적 추론 및 상황별 학습과 같은 다양한 시나리오에서의 일반화 능력.

LLMLlingua-2는 도메인 외부 테스트에서 하나의 데이터세트에 대해서만 훈련되었지만 그 성능은 현재의 최첨단 작업 비특정 압축 방법과 비교할 수 있을 뿐만 아니라 심지어 어떤 경우에는 여전히 더 나쁩니다.

연구원의 더 작은 모델(BERT 기반 크기)도 원래 힌트와 비슷하거나 어떤 경우에는 약간 더 나은 성능을 달성할 수 있었습니다.

연구원의 접근 방식은 유망한 결과를 얻었지만 Longbench의 LongLLMlingua와 같은 다른 작업 인식 압축 방법과 비교할 때 여전히 단점이 있습니다.

연구원들은 이러한 성능 격차가 문제에서 얻은 추가 정보에 기인한다고 생각합니다. 그러나 연구원의 모델은 작업에 구애받지 않으므로 다양한 시나리오에 배포할 때 일반화가 가능한 효율적인 옵션입니다.

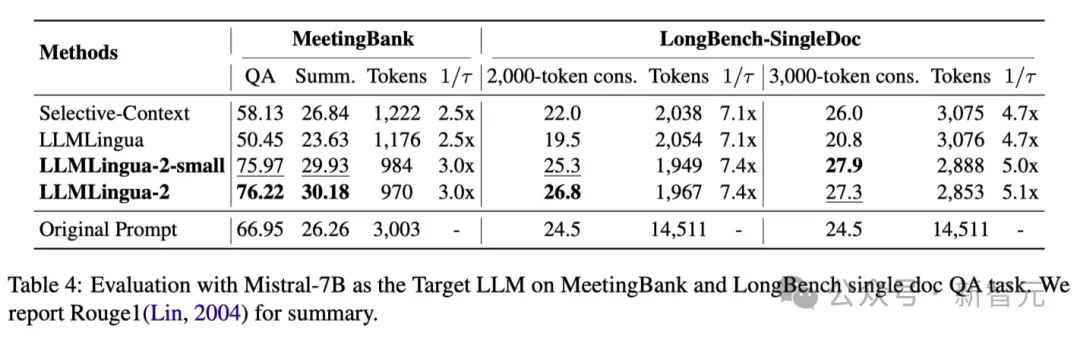

위의 표 4에는 Mistral-7Bv0.1 4를 대상 LLM으로 사용하는 다양한 방법의 결과가 나열되어 있습니다.

다른 기본 방법과 비교하여 연구원의 방법은 성능이 크게 향상되어 대상 LLM에 대한 일반화 능력이 우수함을 보여줍니다.

LLMLingua-2가 원래 팁보다 훨씬 더 나은 성능을 발휘한다는 점은 주목할 가치가 있습니다.

연구원들은 Mistral-7B가 GPT-3.5-Turbo만큼 긴 컨텍스트를 관리하는 데 능숙하지 않을 수 있다고 추측합니다.

연구원의 접근 방식은 더 높은 정보 밀도로 짧은 힌트를 제공함으로써 Mistral7B의 최종 추론 성능을 효과적으로 향상시킵니다.

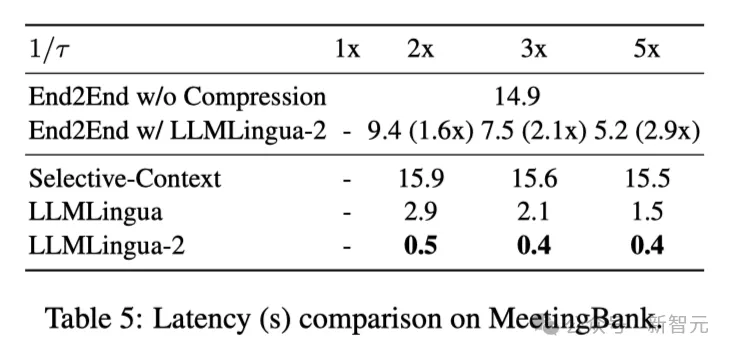

위의 표 5는 V100-32G GPU에서 다양한 압축 비율을 사용하는 다양한 시스템의 대기 시간을 보여줍니다.

결과에 따르면 다른 압축 방법과 비교할 때 LLMLingua2는 계산 오버헤드가 훨씬 적고 1.6x~2.9x의 엔드투엔드 속도 향상을 달성할 수 있습니다.

또한, 연구진의 방법은 GPU 메모리 비용을 8배까지 줄여 하드웨어 리소스에 대한 수요를 줄일 수 있습니다.

상황 인식 관찰 연구원들은 압축 비율이 증가함에 따라 LLMLingua-2가 완전한 맥락에서 가장 유익한 단어를 효과적으로 유지할 수 있음을 관찰했습니다.

이는 양방향 상황 인식 기능 추출기와 적시 압축 목표를 향해 명시적으로 최적화하는 전략 덕분입니다.

연구원들은 압축 비율이 증가함에 따라 LLMLingua-2가 전체 맥락과 관련된 가장 유익한 단어를 효과적으로 유지할 수 있음을 관찰했습니다.

이는 양방향 상황 인식 기능 추출기와 적시 압축 목표를 향해 명시적으로 최적화하는 전략 덕분입니다.

마지막으로 연구원들은 GPT-4에 LLMLlingua-2 압축 힌트의 원래 톤을 재구성하도록 요청했습니다.

결과는 GPT-4가 원래 팁을 효과적으로 재구성할 수 있음을 보여 주며, 이는 LLMLingua-2 압축 프로세스 중에 필수 정보가 손실되지 않음을 나타냅니다.

위 내용은 Tsinghua Microsoft는 새로운 프롬프트 단어 압축 도구를 오픈소스화하여 길이를 80% 줄였습니다! GitHub는 별 31,000개를 받았습니다의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!