이전에 AI 서클을 폭발시켰던 Mamba 아키텍처가 오늘 슈퍼 변형을 출시했습니다!

인공지능 유니콘 AI21 Labs가 세계 최초의 양산급 Mamba 대형 모델인 Jamba를 오픈소스화했습니다!

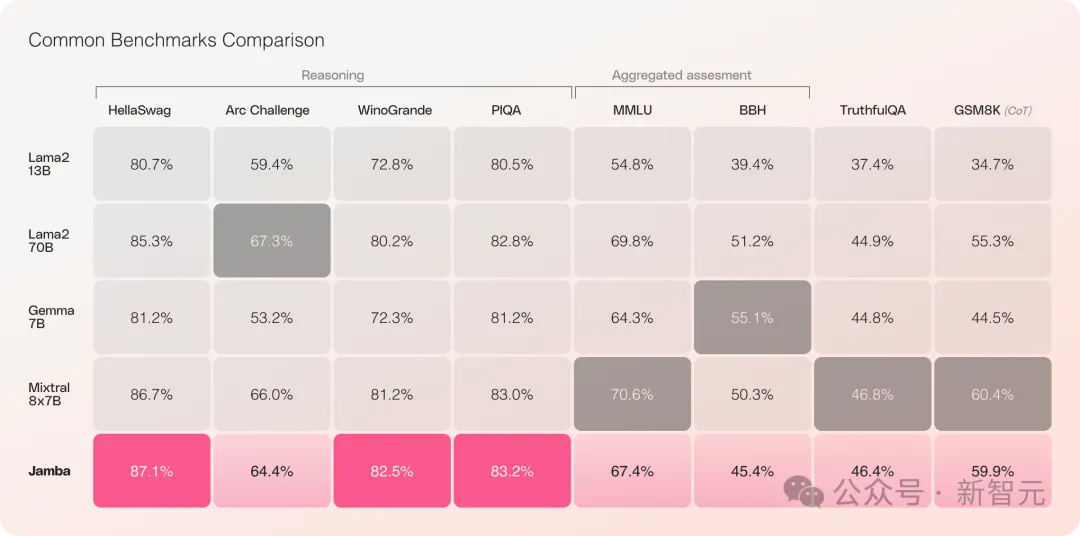

Jamba는 여러 벤치마크 테스트에서 좋은 성적을 거두었으며 현재 가장 강력한 오픈 소스 Transformer와 동등합니다.

특히 최고의 성능을 갖고 있으며 MoE 아키텍처이기도 한 Mixtral 8x7B를 비교할 때 승자와 패자도 있습니다.

구체적으로 -

이전의 Mamba는 3B까지만 도달할 수 있었습니다. 역시 선형 RNN 제품군인 Transformer의 배너를 차지할 수 있는지에 대한 의문도 있었습니다. 14B로 확장되었습니다.

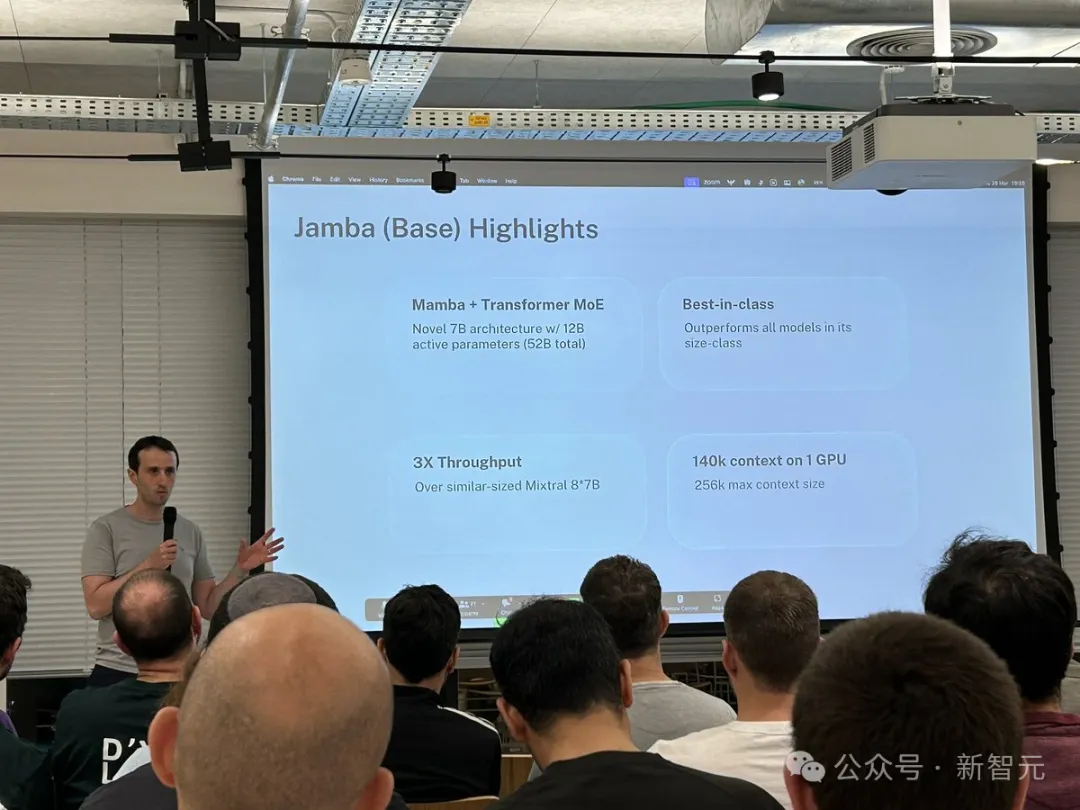

——Jamba는 이번에 직접 52B로 이동하여 Mamba 아키텍처가 처음으로 프로덕션 수준 Transformer와 정면으로 경쟁할 수 있게 되었습니다.

Jamba는 원래 Mamba 아키텍처를 기반으로 하며 상태 공간 모델(SSM)의 고유한 한계를 보완하기 위해 Transformer의 장점을 통합합니다.

이것은 실제로 Transformer와 Mamba의 하이브리드인 새로운 아키텍처라고 볼 수 있으며, 가장 중요한 것은 단일 A100에서 실행할 수 있다는 것입니다.

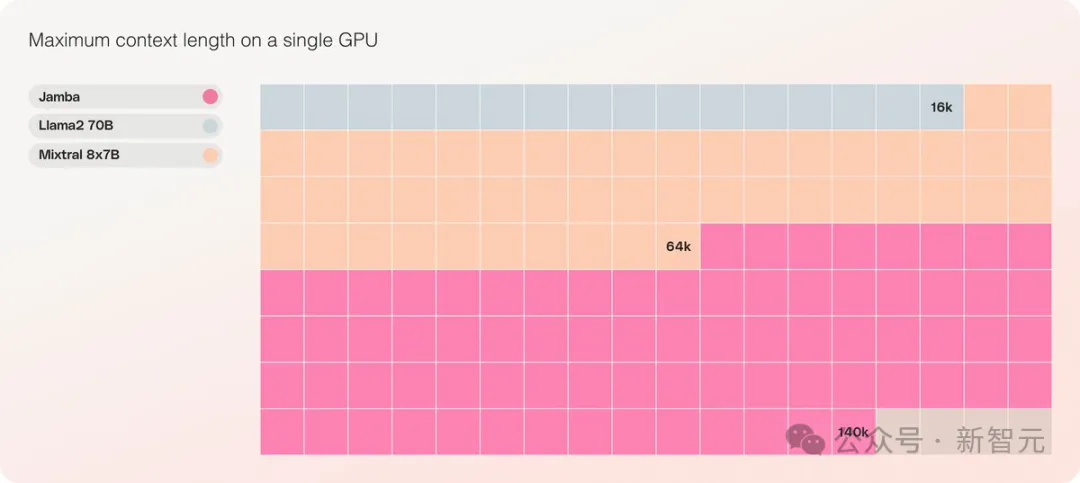

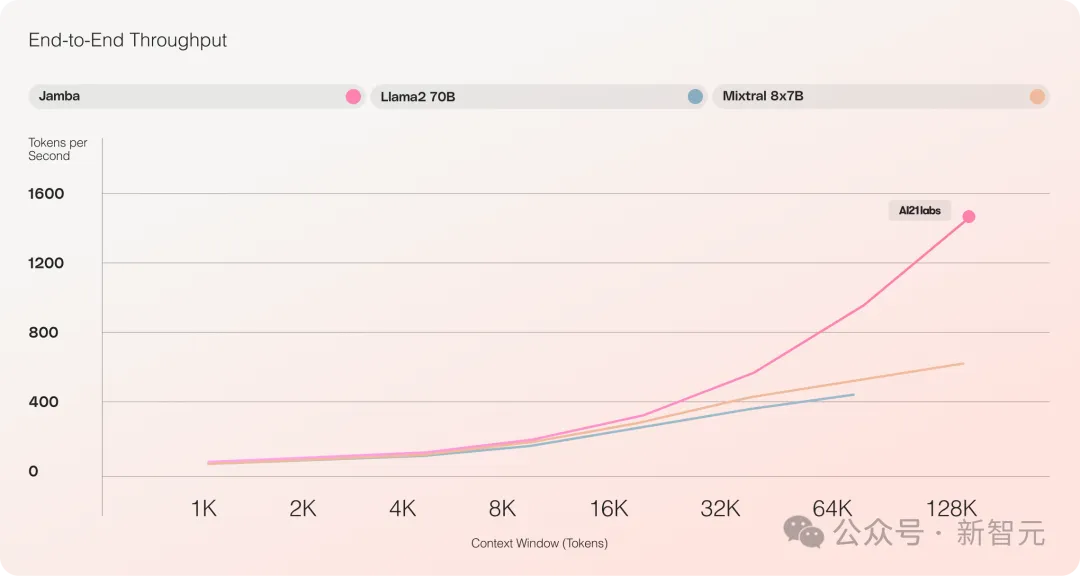

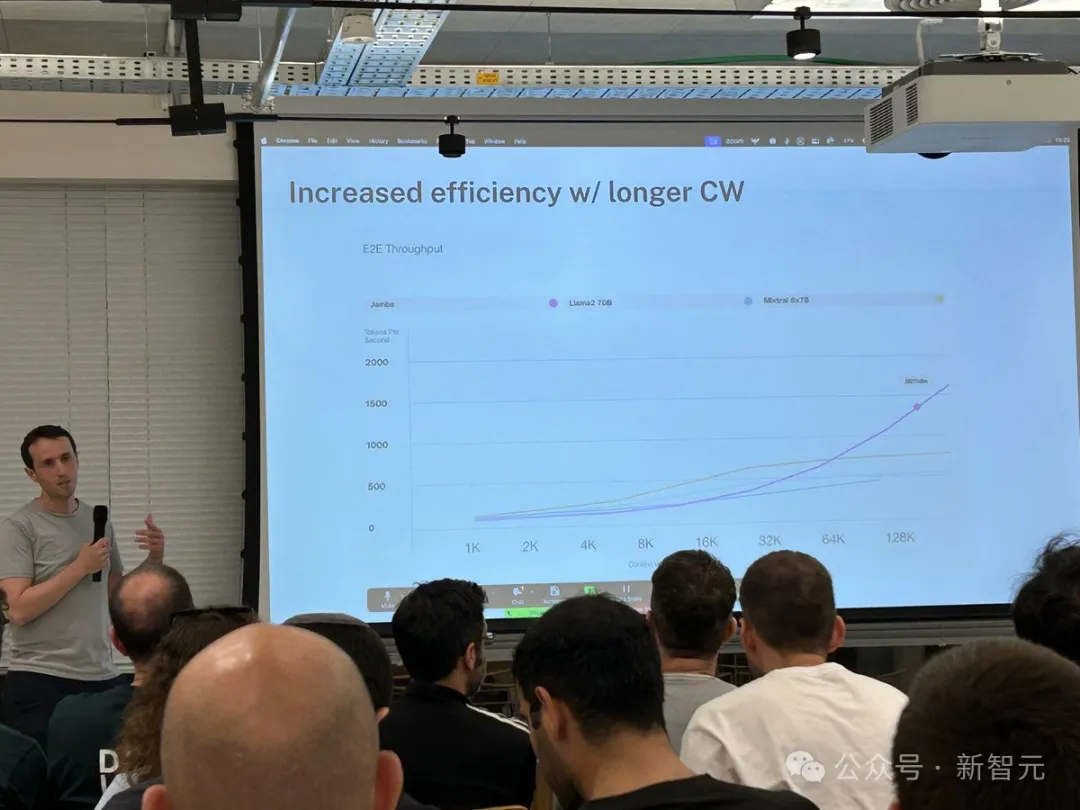

최대 256K의 매우 긴 컨텍스트 창을 제공하고 단일 GPU는 140K 컨텍스트를 실행할 수 있으며 처리량은 Transformer의 3배입니다!

Transformer와 비교하여 Jamba가 어떻게 거대한 컨텍스트 길이로 확장되는지 보는 것은 매우 충격적입니다.

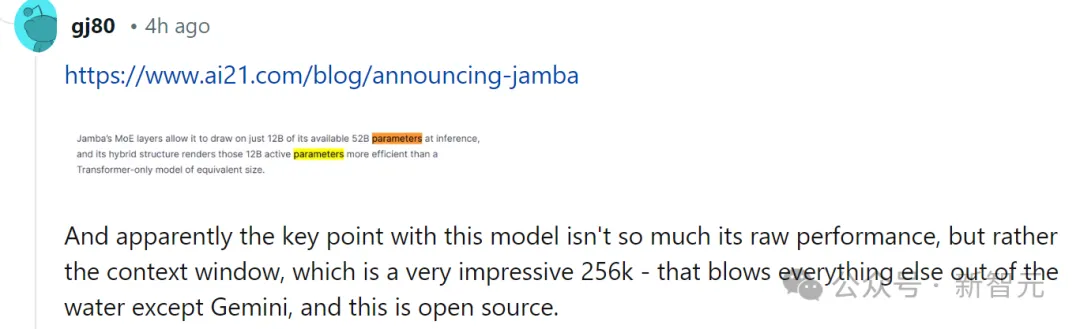

Jamba는 MoE 솔루션을 채택하고 52B 중 12B는 활성 매개변수이며 모델은 현재 Apache 2.0에서 열려 있습니다. 가중치는 Huggingface에서 다운로드할 수 있습니다.

모델 다운로드: https://huggingface.co/ai21labs/Jamba-v0.1

Jamba 출시는 LLM의 두 가지 중요한 이정표입니다.

첫 번째로 Mamba와 Transformer 아키텍처를 성공적으로 결합했으며, 두 번째로 새로운 형태의 모델(SSM-Transformer)을 생산 수준의 규모와 품질로 업그레이드하는 데 성공했습니다.

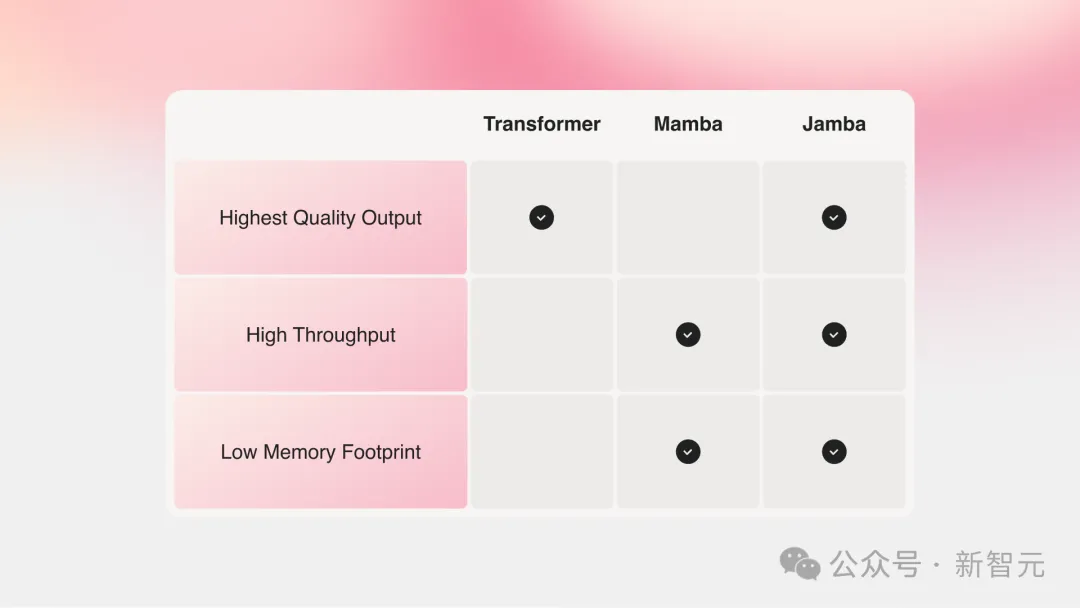

가장 강력한 성능을 지닌 현재 대형 모델은 모두 Transformer를 기반으로 하지만 모두가 Transformer 아키텍처의 두 가지 주요 단점도 깨달았습니다.

대형 메모리 공간: Transformer의 메모리 공간은 컨텍스트 길이에 따라 다릅니다. 확장하다. 긴 컨텍스트 창이나 대규모 병렬 배치 처리를 실행하려면 많은 하드웨어 리소스가 필요하므로 대규모 실험 및 배포가 제한됩니다.

컨텍스트가 증가함에 따라 추론 속도가 느려집니다. Transformer의 주의 메커니즘으로 인해 추론 시간이 시퀀스 길이에 비례하여 증가하고 처리량이 점점 더 느려집니다. 각 토큰은 이전의 전체 시퀀스에 의존하기 때문에 매우 긴 컨텍스트를 달성하기가 매우 어렵습니다.

몇 년 전, 카네기 멜론과 프린스턴 출신의 거물 두 명이 Mamba를 제안했는데, 이는 즉시 사람들의 희망에 불을 붙였습니다.

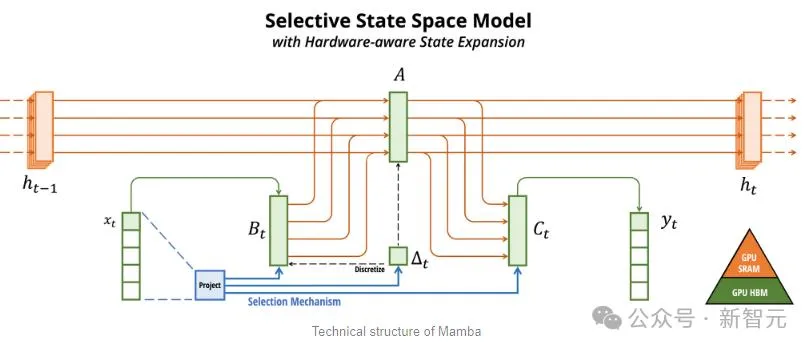

Mamba는 SSM을 기반으로 정보를 선택적으로 추출하는 기능과 하드웨어의 효율적인 알고리즘을 추가하여 Transformer의 문제를 단번에 해결합니다.

이 새로운 분야는 즉시 많은 연구자들의 관심을 끌었고, 비전을 위해 Mamba를 사용하는 Vision Mamba와 같은 수많은 Mamba 애플리케이션과 개선 사항이 arXiv에서 나타났습니다.

현재 과학 연구 분야가 정말 너무 바쁘다고 말씀드리고 싶습니다. Transformer into Vision(ViT)을 도입하는 데는 3년이 걸렸지만 Mamba에서 Vision Mamba까지는 한 달밖에 걸리지 않았습니다.

하지만 원본 Mamba의 컨텍스트 길이는 더 짧고 모델 자체가 확대되지 않기 때문에 특히 리콜과 관련된 작업에서는 SOTA Transformer 모델을 능가하기 어렵습니다.

Jamba는 한 단계 더 나아가 Joint Attention 및 Mamba 아키텍처를 통해 Transformer, Mamba 및 MoE(Mix of Experts)의 장점을 통합하는 동시에 메모리, 처리량 및 성능을 최적화합니다.

Jamba는 생산 규모(52B 매개변수)에 도달한 최초의 하이브리드 아키텍처입니다.

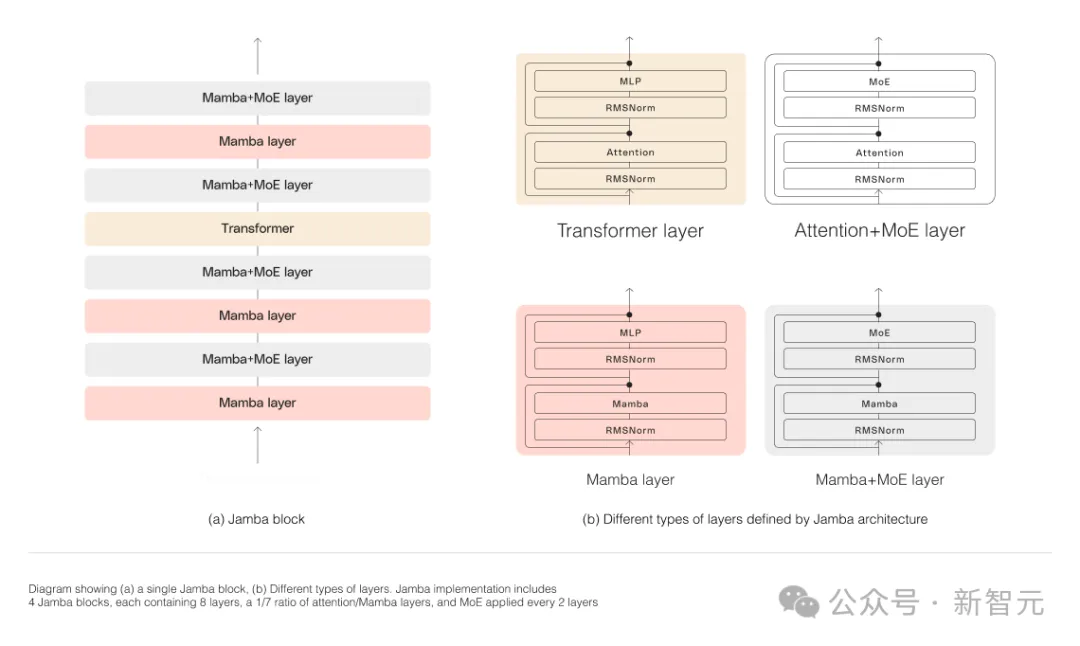

아래 그림과 같이 AI21의 Jamba 아키텍처는 블록 및 레이어 접근 방식을 채택하여 Jamba가 두 아키텍처를 성공적으로 통합할 수 있습니다.

각 Jamba 블록은 Attention 레이어 또는 Mamba 레이어와 MLP(Multilayer Perceptron)로 구성됩니다.

Jamba의 두 번째 기능은 MoE를 사용하여 모델 매개변수의 총 수를 늘리는 동시에 추론에 사용되는 활성 매개변수의 수를 단순화함으로써 계산 요구 사항을 늘리지 않고도 모델 용량을 늘릴 수 있다는 것입니다.

단일 80GB GPU에서 모델 품질과 처리량을 최대화하기 위해 연구원들은 MoE 레이어와 전문가가 사용하는 수를 최적화하여 일반적인 추론 워크로드에 충분한 메모리를 확보했습니다.

Mixtral 8x7B 등 유사한 크기의 Transformer 기반 모델과 비교하여 Jamba는 긴 컨텍스트에서 3배의 가속을 달성했습니다.

Jamba는 곧 NVIDIA API 디렉토리에 추가될 예정입니다.

최근 주요 기업들이 롱컨텍스트를 출시하고 있습니다.

컨텍스트 창이 더 작은 모델은 최근 대화의 내용을 잊어버리는 경향이 있는 반면, 컨텍스트가 더 큰 모델은 이러한 함정을 피하고 수신하는 데이터 스트림을 더 잘 파악할 수 있습니다.

그러나 컨텍스트 창이 긴 모델은 계산 집약적인 경향이 있습니다.

스타트업 AI21 Labs의 생성 모델은 이것이 사실이 아님을 증명합니다.

Jamba는 최소 80GB의 비디오 메모리를 갖춘 단일 GPU(예: A100)에서 실행할 때 최대 140,000개의 토큰을 처리할 수 있습니다.

이것은 약 105,000단어, 즉 210페이지에 해당하며, 이는 중편 소설의 길이입니다.

이에 비해 Meta Llama 2의 컨텍스트 창에는 토큰이 32,000개만 있고 12GB의 GPU 메모리가 필요합니다.

오늘날의 기준으로 볼 때 이 컨텍스트 창은 확실히 작습니다.

이와 관련하여 일부 네티즌은 성능이 중요하지 않다고 즉시 말했습니다. 핵심은 Jamba가 Gemini를 제외하고는 그렇게 긴 사람이 없으며 Jamba는 오픈 소스라는 것입니다.

표면적으로 Jamba는 평범해 보일 수 있습니다.

어제 각광을 받았던 DBRX든 Llama 2든 이제 무료로 다운로드할 수 있는 생성 AI 모델이 많이 있습니다.

Jamba의 독창성은 모델 아래에 숨겨져 있습니다. 이는 Transformer와 상태 공간 모델 SSM이라는 두 가지 모델 아키텍처를 동시에 결합합니다.

Transformer는 복잡한 추론 작업에 선호되는 아키텍처입니다. 핵심 정의 기능은 "주의 메커니즘"입니다. 각 입력 데이터에 대해 Transformer는 다른 모든 입력의 관련성을 평가하고 해당 입력에서 추출하여 출력을 생성합니다.

반면 SSM은 순환 신경망, 컨볼루션 신경망 등 이전 AI 모델의 많은 장점을 결합하여 긴 시퀀스 데이터를 더 높은 계산 효율성으로 처리할 수 있습니다.

SSM에는 자체적인 한계가 있지만. 그러나 Princeton과 CMU가 제안한 Mamba와 같은 일부 초기 대표자는 Transformer 모델보다 더 큰 출력을 처리할 수 있으며 언어 생성 작업에 더 뛰어납니다.

이와 관련하여 AI21 Labs의 제품 리더인 Dagan은 다음과 같이 말했습니다.

SSM 모델의 예비 사례가 있지만 Jamba는 생산 규모에서 최초의 상용급 모델입니다.

그의 견해에 따르면 Jamba는 커뮤니티에서 더 많은 연구를 할 수 있도록 혁신적이고 흥미로운 것 외에도 엄청난 효율성과 처리량 가능성을 제공합니다.

현재 Jamba는 Apache 2.0 라이선스로 출시되어 사용 제한이 적지만 상업적으로 사용할 수 없습니다. 후속 세부 조정 버전은 몇 주 내에 출시될 예정입니다.

아직 연구 초기 단계임에도 불구하고 Dagan은 Jamba가 의심할 여지 없이 SSM 아키텍처의 큰 가능성을 보여주고 있다고 주장합니다.

"이 모델의 부가가치는 크기와 아키텍처 혁신으로 인해 단일 GPU에 쉽게 장착될 수 있습니다."

위 내용은 맘바의 초진화 형태가 트랜스포머를 단숨에 전복시킵니다! 140K 컨텍스트를 실행하는 단일 A100의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!