CVPR 2024 | 새로운 프레임워크 CustomNeRF는 텍스트 또는 이미지 프롬프트만으로 3D 장면을 정확하게 편집합니다.

Meitu 이미징 연구소(MT Lab)는 중국과학원 정보공학연구소, 베이징 항공우주대학교, 쑨원대학교와 함께 3D 장면 편집 방법인 CustomNeRF를 공동으로 제안했습니다. 연구 결과는 CVPR 2024에 승인되었습니다. CustomNeRF는 3D 장면 편집 팁으로 텍스트 설명과 참조 사진을 지원할 뿐만 아니라, 사용자가 제공한 정보를 기반으로 고품질의 3D 장면을 생성합니다.

NeRF(Neural Radiance Field) NeRF(Neural Radiance Field)는 2020년에 제안된 이후 암시적 표현을 새로운 수준으로 끌어올렸습니다. NeRF는 현재 가장 최첨단 기술 중 하나로 컴퓨터 비전, 컴퓨터 그래픽, 증강 현실, 가상 현실 등의 분야에 빠르게 일반화 및 적용되어 계속해서 폭넓은 주목을 받고 있습니다. NeRF는 장면의 각 지점의 방사선 및 밀도를 모델링하여 고품질 이미지 합성을 가능하게 하며, 이는 컴퓨터 비전, 컴퓨터 그래픽, 증강 현실 및 가상 현실과 같은 분야의 응용 분야에 널리 매력적입니다. NeRF는 복잡한 3D 스캔이나 조밀한 원근 이미지 없이 입력 장면에서 고품질 이미지를 생성하는 능력이 독특합니다. 이 기능 덕분에 NeRF는 컴퓨터 비전, 컴퓨터 그래픽, 증강 현실, 가상 현실 등 다양한 분야에서 광범위한 응용 가능성을 갖게 되었으며 계속해서 폭넓은 관심을 받고 있습니다. NeRF는 장면의 모든 지점의 빛과 밀도를 모델링하여 고품질 이미지 합성을 가능하게 합니다. NeRF는 고품질 3D 렌더링을 생성하는 데에도 사용할 수 있으므로 가상 현실 및 증강 현실과 같은 분야의 애플리케이션에 매우 유망합니다. NeRF의 신속한 개발과 광범위한 적용은 계속해서 폭넓은 관심을 받을 것이며, NeRF를 기반으로 한 더 많은 혁신과 적용이 앞으로 나타날 것으로 예상됩니다.

NeRF(Neural Radiation Field)는 3D 장면 재구성에 많이 응용되는 최적화 및 연속 표현 기능입니다. 3D 개체나 장면의 텍스처 다시 그리기 및 스타일화와 같은 3D 장면 편집 분야의 연구도 주도했습니다. 3D 장면 편집의 유연성을 더욱 향상시키기 위해 사전 훈련된 모델을 기반으로 한 NeRF 편집 방법도 최근 NeRF의 암시적 표현과 3D 장면의 기하학적 특성으로 인해 광범위하게 연구되고 있으며, 텍스트 프롬프트를 준수하는 편집 결과가 있습니다. 얻을 수 있습니다. 구현하기가 매우 쉽습니다.

텍스트 기반 3D 장면 편집을 통해 정확한 제어를 달성하기 위해 메이투 이미징 연구소(MT Lab), 중국과학원 정보공학연구소, 베이항대학교, 쑨원대학교가 공동으로 제안한 텍스트 설명과 참조 이미지 통합을 결합하는 방법은 편집을 위한 CustomNeRF 프레임워크를 제공합니다. 프레임워크에는 일반 및 맞춤형 3D 장면 편집 요구 사항을 충족하기 위해 하이브리드 표현에 내장된 관점별 주제 V*가 내장되어 있습니다. 연구 결과는 CVPR 2024에 기록되었으며, 코드는 오픈소스로 공개되었습니다.

문서 링크: https://arxiv.org/abs/2312.01663

코드 링크: https://github.com/hrz2000/CustomNeRF

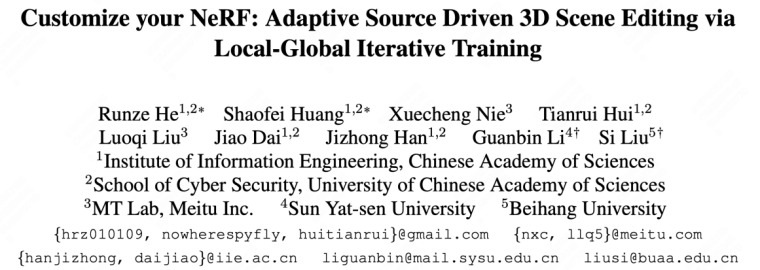

ㅋㅋㅋ 는 텍스트 기반(왼쪽) 및 이미지 기반(오른쪽)에서 CustomNeRF의 편집 효과

CustomNeRF가 해결한 두 가지 주요 과제

현재 사전 학습된 확산 모델을 기반으로 하는 3D 장면 편집의 주류 방법은 주로 다음과 같습니다. 두 가지 범주로 나뉜다. 하나는 이미지 편집 모델을 사용하여 데이터 세트의 이미지를 반복적으로 업데이트하는 것입니다. 그러나 이미지 편집 모델의 제한된 기능으로 인해 일부 편집 상황에서는 실패할 수 있습니다. 둘째, SDS(분별 증류 샘플링) 손실을 사용하여 장면을 편집합니다. 그러나 텍스트와 장면 간의 정렬 문제로 인해 이 방법은 실제 장면에 직접 적용할 수 없으며 비영상에서는 불필요한 왜곡이 발생합니다. 편집 영역에는 메시나 복셀과 같은 명시적인 중간 표현이 필요한 경우가 많습니다. 또한 현재 두 가지 유형의 방법은 주로 텍스트 중심의 3D 장면 편집 작업에 중점을 둡니다. 텍스트 설명은 사용자의 편집 요구 사항을 정확하게 표현하기 어렵고 이미지의 특정 개념을 3D 장면으로 사용자 정의할 수 없습니다. 원본 3D 장면은 일반적으로 편집되기 때문에 사용자가 기대하는 편집 결과를 얻기가 어렵습니다. 실제로 원하는 편집 결과를 얻는 열쇠는 이미지 전경 영역을 정확하게 식별하는 것입니다. 이를 통해 이미지 배경을 유지하면서 기하학적으로 일관된 이미지 전경 편집을 촉진할 수 있습니다. 따라서 본 논문에서는 이미지의 전경 영역만 정확하게 편집하기 위해 이미지 전경 영역 편집과 전체 이미지 편집을 번갈아가며 수행하는 로컬-글로벌 반복 편집(LGIE) 훈련 방식을 제안합니다. 이 솔루션은 이미지 전경 영역을 정확하게 찾을 수 있으며 이미지 배경을 유지하면서 이미지 전경에서만 작동할 수 있습니다.또한 이미지 기반 3D 장면 편집에서는 미세 조정된 확산 모델이 참조 이미지 관점에 과적합되어 편집 결과에 기하학적 불일치 문제가 있습니다. 이와 관련하여 본 논문에서는 로컬 편집 단계에서 참조 이미지의 주제를 표현하기 위해 클래스 단어만 사용하고 기하학적으로 일관된 편집을 촉진하기 위해 사전 훈련된 확산 모델에서 사전에 일반 클래스를 활용하는 클래스 기반 정규화를 설계합니다.

CustomNeRF의 전체 프로세스

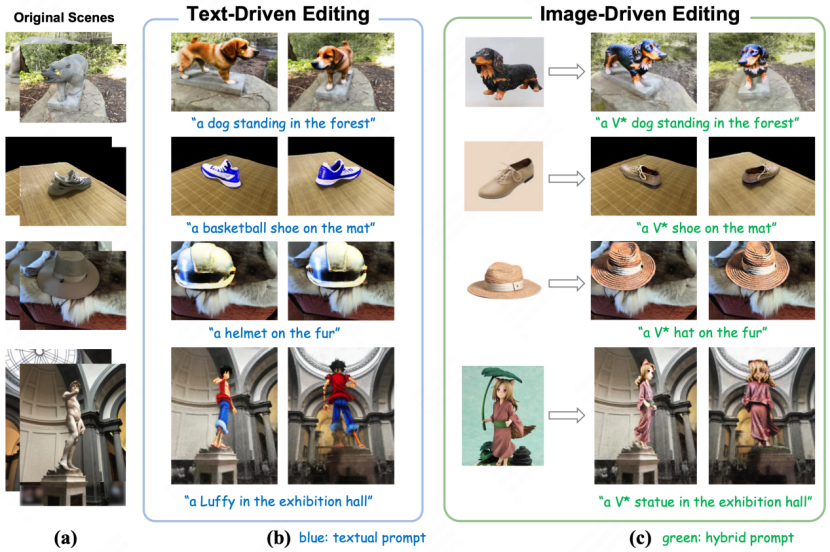

그림 2에 표시된 것처럼 CustomNeRF는 텍스트 프롬프트 또는 참조 이미지의 안내에 따라 3D 장면을 정확하게 편집하고 재구성하는 목표를 달성하기 위해 3단계를 사용합니다. ㅋㅋ 그림 2 CustomNeRF의 전체 흐름도

두 번째로, 이미지 기반 및 텍스트 기반 3D 장면 편집 작업을 통합하기 위해 그림 2(b)와 같이 논문에서는 Custom Diffusion 방법을 사용하여 이미지 기반 조건에서 참조 이미지를 미세 조정하여 학습합니다. 주제별 주요 특징. 훈련 후 특수 단어 V*를 일반 단어 태그로 사용하여 참조 이미지의 주제 개념을 표현함으로써 "V* 개 사진"과 같은 하이브리드 큐를 형성할 수 있습니다. 이러한 방식으로 CustomNeRF를 사용하면 이미지나 텍스트를 포함한 적응형 데이터를 일관되고 효율적으로 편집할 수 있습니다. 최종 편집 단계에서 NeRF의 암시적 표현으로 인해 SDS 손실을 사용하여 전체 3D 영역을 최적화하면 배경 영역에 상당한 변화가 발생하며 이는 편집 후 원본 장면과 일치해야 합니다. 그림 2(c)에서 볼 수 있듯이 본 논문에서는 레이아웃 영역을 편집하는 동안 배경 콘텐츠를 보존할 수 있는 분리된 SDS 훈련을 위한 LGIE(Local-Global Iterative Editing) 방식을 제안합니다.

구체적으로, 이 논문에서는 NeRF의 편집 교육 과정을 보다 세밀하게 나눕니다. 전경 인식 NeRF를 사용하면 CustomNeRF는 훈련 중에 NeRF의 렌더링 프로세스를 유연하게 제어할 수 있습니다. 즉, 고정된 카메라 관점에서 전경, 배경 및 전경과 배경을 포함하는 일반 이미지를 렌더링하도록 선택할 수 있습니다. 훈련 과정에서 현재 NeRF 장면은 해당 전경 또는 배경 큐와 결합된 전경 및 배경을 반복적으로 렌더링함으로써 SDS 손실을 사용하여 다양한 레벨에서 편집될 수 있습니다. 그 중 로컬 포그라운드 트레이닝을 사용하면 편집 과정에서 편집해야 하는 영역에만 집중할 수 있어 복잡한 장면에서 편집 작업의 어려움이 단순화되는 반면, 글로벌 트레이닝은 전체 장면을 고려하여 조정을 유지할 수 있습니다. 전경과 배경. 편집되지 않은 영역을 변경하지 않고 추가로 유지하기 위해 논문에서는 배경 픽셀의 일관성을 유지하기 위해 훈련을 편집하기 전에 배경 감독 훈련 프로세스 중에 새로 렌더링된 배경도 사용합니다. 또한 이미지 기반 3D 장면 편집에서는 기하학적 불일치가 더욱 악화됩니다. 왜냐하면 참조 이미지로 미세 조정된 확산 모델은 추론 과정에서 참조 이미지와 유사한 관점의 이미지를 생성하는 경향이 있기 때문에 편집된 3D 장면의 다중 관점이 정면의 기하학적 문제를 일으키는 원인이 됩니다. 이를 위해 논문에서는 사전 훈련된 확산 모델에 포함된 클래스 사전을 활용하기 위해 글로벌 큐에 특수 설명자 V*를 사용하고 로컬 큐에 클래스 단어만 사용하는 클래스 안내 정규화 전략을 설계하고 더 많은 새로운 개념 주입을 사용합니다. 기하학적으로 일관된 방식으로 장면에 들어갑니다.실험 결과

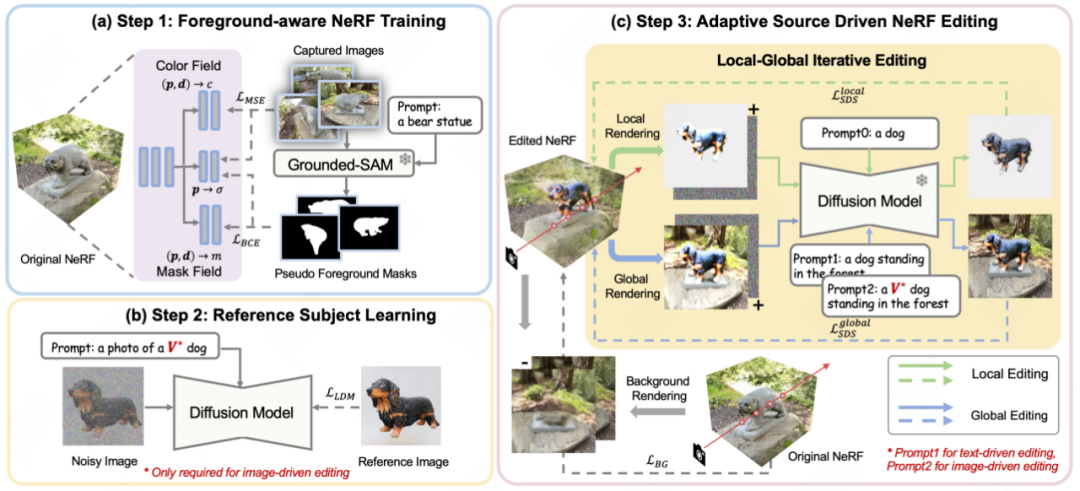

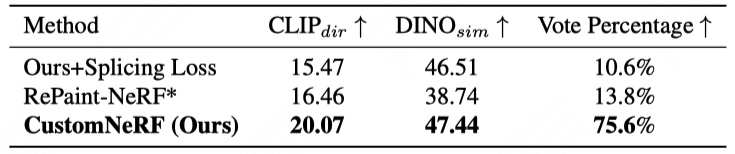

그림 3과 그림 4는 CustomNeRF의 3D 장면 재구성 결과와 기준 방법의 비교를 보여줍니다. 참조 이미지와 텍스트 기반 3D 장면 편집 작업 모두에서 CustomNeRF는 좋은 편집 결과를 얻었습니다. 편집 팁과의 올바른 정렬만 달성되고 배경 영역은 원본 장면과 일관되게 유지됩니다. 또한 표 1과 표 2는 이미지와 텍스트를 기반으로 구동할 때 CustomNeRF와 기준 방법을 정량적으로 비교한 결과를 보여줍니다. 결과는 CustomNeRF가 텍스트 정렬 측정항목, 이미지 정렬 측정항목 및 인간 평가에서 기준 방법을 능가한다는 것을 보여줍니다. ㅋㅋㅋ ~

~ > 편집 중인 기준선과의 정량적 비교

Summary

Summary

본 논문은 CustomNeRF 모델을 혁신적으로 제안하는 동시에 텍스트 설명 또는 참조 이미지에 대한 편집 메시지를 표시하고 두 가지 주요 문제를 해결합니다. 단일 뷰 참조 이미지를 사용할 때 전경 편집 및 여러 뷰 간의 일관성이 정확합니다. 이 체계에는 배경을 변경하지 않고 전경에 편집 작업을 집중할 수 있는 LGIE(로컬-글로벌 반복 편집) 훈련 체계와 이미지 기반 편집에서 보기 불일치를 완화하는 클래스 기반 정규화가 포함되어 있으며 검증되었습니다. 광범위한 실험을 통해 CustomNeRF는 다양한 실제 시나리오에서 텍스트 설명과 참조 이미지로 표시되는 3D 장면을 정확하게 편집할 수 있습니다.

위 내용은 CVPR 2024 | 새로운 프레임워크 CustomNeRF는 텍스트 또는 이미지 프롬프트만으로 3D 장면을 정확하게 편집합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7470

7470

15

15

1377

1377

52

52

77

77

11

11

48

48

19

19

19

19

29

29

GO에서 플로팅 포인트 번호 작업에 어떤 라이브러리가 사용됩니까?

Apr 02, 2025 pm 02:06 PM

GO에서 플로팅 포인트 번호 작업에 어떤 라이브러리가 사용됩니까?

Apr 02, 2025 pm 02:06 PM

Go Language의 부동 소수점 번호 작동에 사용되는 라이브러리는 정확도를 보장하는 방법을 소개합니다.

Gitee Pages 정적 웹 사이트 배포 실패 : 단일 파일 문제를 해결하고 해결하는 방법 404 오류?

Apr 04, 2025 pm 11:54 PM

Gitee Pages 정적 웹 사이트 배포 실패 : 단일 파일 문제를 해결하고 해결하는 방법 404 오류?

Apr 04, 2025 pm 11:54 PM

GiteEpages 정적 웹 사이트 배포 실패 : 404 오류 문제 해결 및 해결시 Gitee ...

H5 프로젝트를 실행하는 방법

Apr 06, 2025 pm 12:21 PM

H5 프로젝트를 실행하는 방법

Apr 06, 2025 pm 12:21 PM

H5 프로젝트를 실행하려면 다음 단계가 필요합니다. Web Server, Node.js, 개발 도구 등과 같은 필요한 도구 설치. 개발 환경 구축, 프로젝트 폴더 작성, 프로젝트 초기화 및 코드 작성. 개발 서버를 시작하고 명령 줄을 사용하여 명령을 실행하십시오. 브라우저에서 프로젝트를 미리보고 개발 서버 URL을 입력하십시오. 프로젝트 게시, 코드 최적화, 프로젝트 배포 및 웹 서버 구성을 설정하십시오.

GO의 어떤 라이브러리가 대기업에서 개발하거나 잘 알려진 오픈 소스 프로젝트에서 제공합니까?

Apr 02, 2025 pm 04:12 PM

GO의 어떤 라이브러리가 대기업에서 개발하거나 잘 알려진 오픈 소스 프로젝트에서 제공합니까?

Apr 02, 2025 pm 04:12 PM

GO의 어떤 라이브러리가 대기업이나 잘 알려진 오픈 소스 프로젝트에서 개발 했습니까? GO에 프로그래밍 할 때 개발자는 종종 몇 가지 일반적인 요구를 만납니다.

Beego ORM의 모델과 관련된 데이터베이스를 지정하는 방법은 무엇입니까?

Apr 02, 2025 pm 03:54 PM

Beego ORM의 모델과 관련된 데이터베이스를 지정하는 방법은 무엇입니까?

Apr 02, 2025 pm 03:54 PM

Beegoorm 프레임 워크에서 모델과 관련된 데이터베이스를 지정하는 방법은 무엇입니까? 많은 Beego 프로젝트에서는 여러 데이터베이스를 동시에 작동해야합니다. Beego를 사용할 때 ...

H5 페이지 생산에는 지속적인 유지 보수가 필요합니까?

Apr 05, 2025 pm 11:27 PM

H5 페이지 생산에는 지속적인 유지 보수가 필요합니까?

Apr 05, 2025 pm 11:27 PM

코드 취약점, 브라우저 호환성, 성능 최적화, 보안 업데이트 및 사용자 경험 개선과 같은 요소로 인해 H5 페이지를 지속적으로 유지해야합니다. 효과적인 유지 관리 방법에는 완전한 테스트 시스템 설정, 버전 제어 도구 사용, 페이지 성능을 정기적으로 모니터링하고 사용자 피드백 수집 및 유지 관리 계획을 수립하는 것이 포함됩니다.

Redis Stream을 사용하여 GO Language에서 메시지 대기열을 구현할 때 User_ID 유형 변환 문제를 해결하는 방법은 무엇입니까?

Apr 02, 2025 pm 04:54 PM

Redis Stream을 사용하여 GO Language에서 메시지 대기열을 구현할 때 User_ID 유형 변환 문제를 해결하는 방법은 무엇입니까?

Apr 02, 2025 pm 04:54 PM

Go Language에서 메시지 대기열을 구현하기 위해 Redisstream을 사용하는 문제는 Go Language와 Redis를 사용하는 것입니다 ...

파이썬 모래시 그래프 그리기 : 가변적 인 정의되지 않은 오류를 피하는 방법?

Apr 01, 2025 pm 06:27 PM

파이썬 모래시 그래프 그리기 : 가변적 인 정의되지 않은 오류를 피하는 방법?

Apr 01, 2025 pm 06:27 PM

Python : 모래 시계 그래픽 도면 및 입력 검증을 시작 하기이 기사는 모래 시계 그래픽 드로잉 프로그램에서 Python 초보자가 발생하는 변수 정의 문제를 해결합니다. 암호...