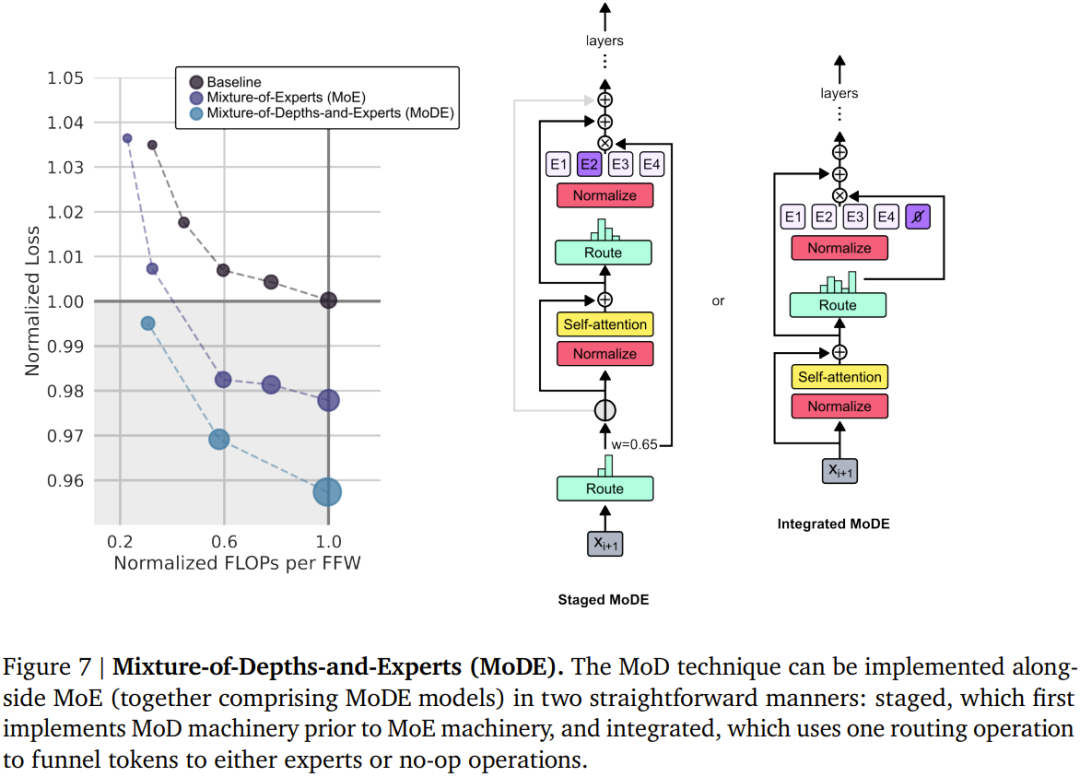

DeepMind는 Transformer를 업그레이드하여 순방향 패스 FLOP를 최대 절반까지 줄일 수 있습니다.

하이브리드 깊이를 도입한 DeepMind의 새로운 디자인은 Transformer 효율성을 크게 향상시킬 수 있습니다.

논문 제목: Mixture-of-Depths: 동적으로 컴퓨팅 할당 변환기 기반 언어 모델 논문 주소: https://arxiv.org/pdf/2404.02258.pdf

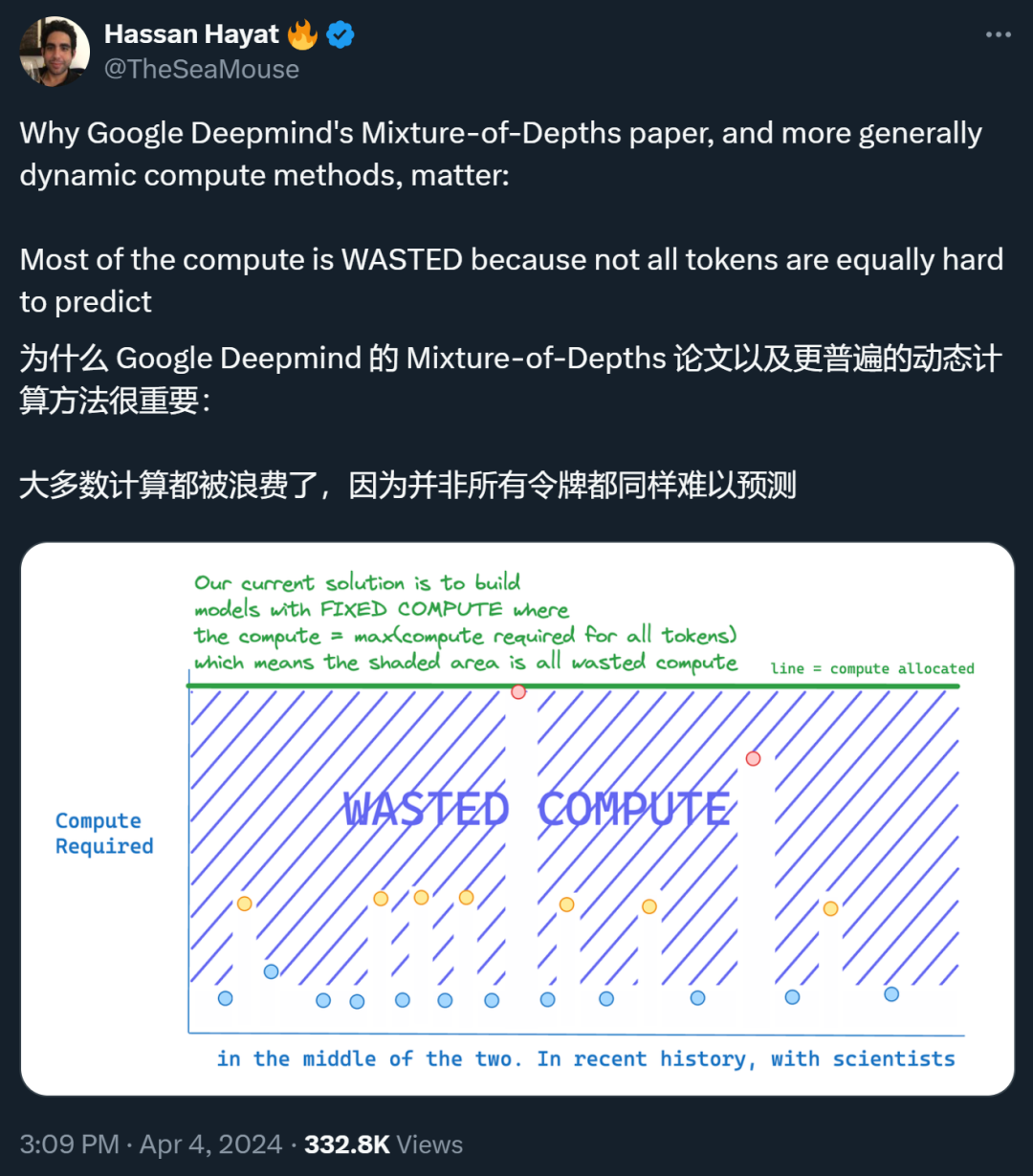

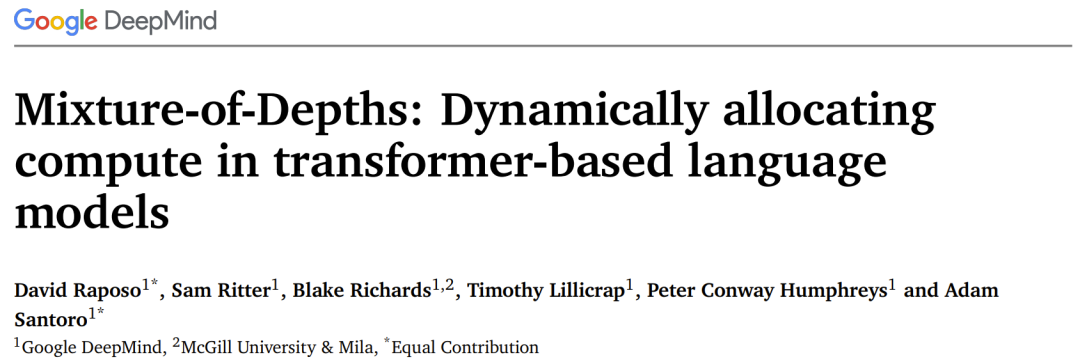

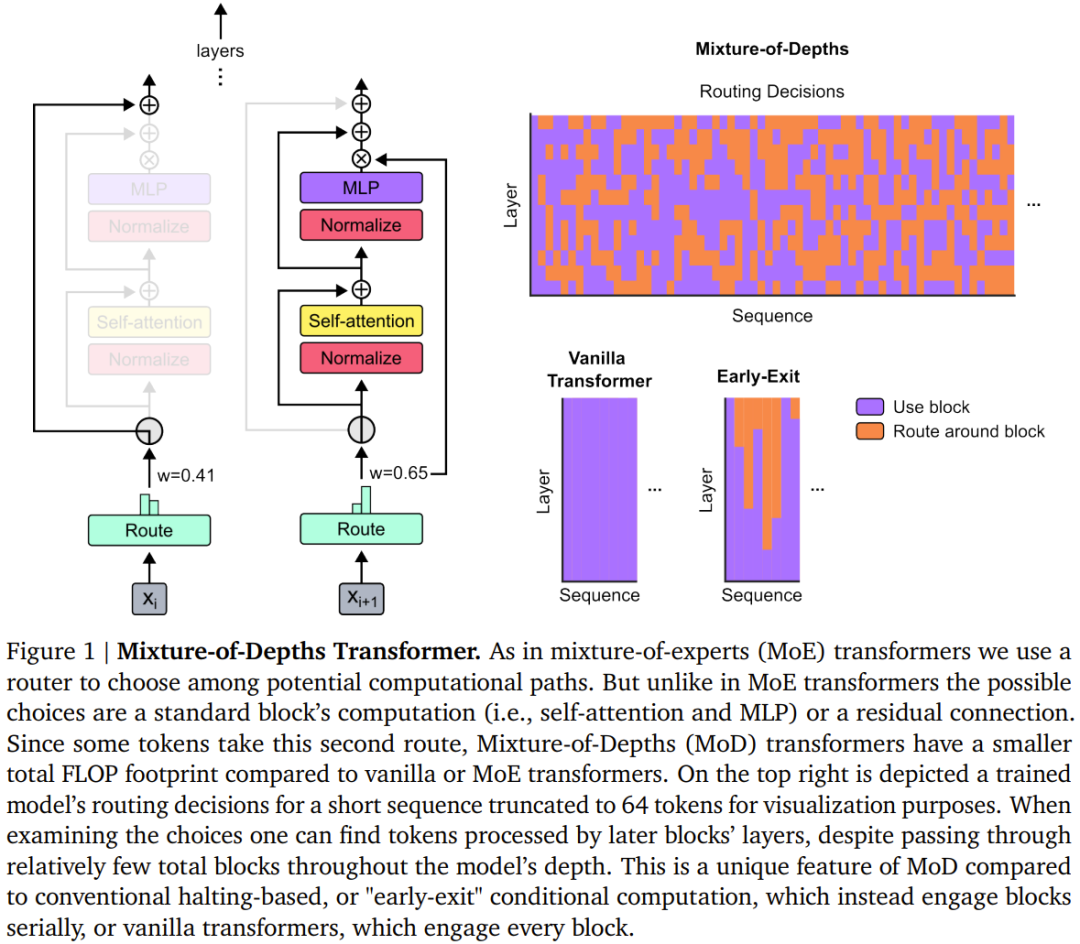

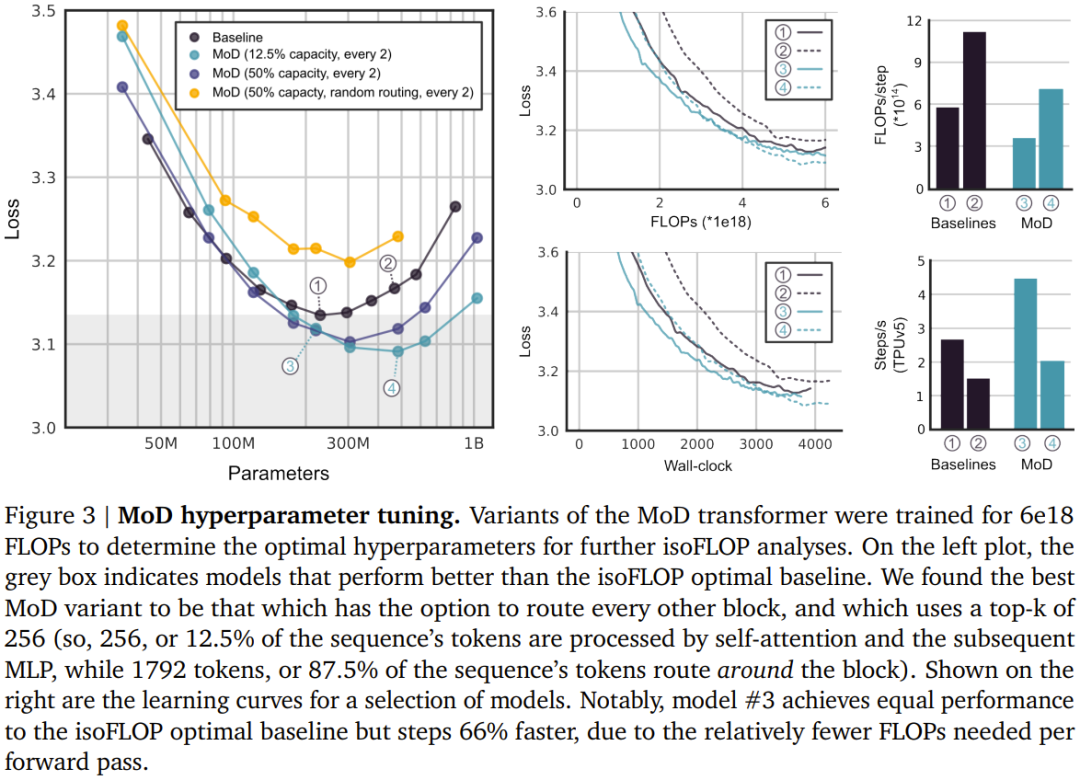

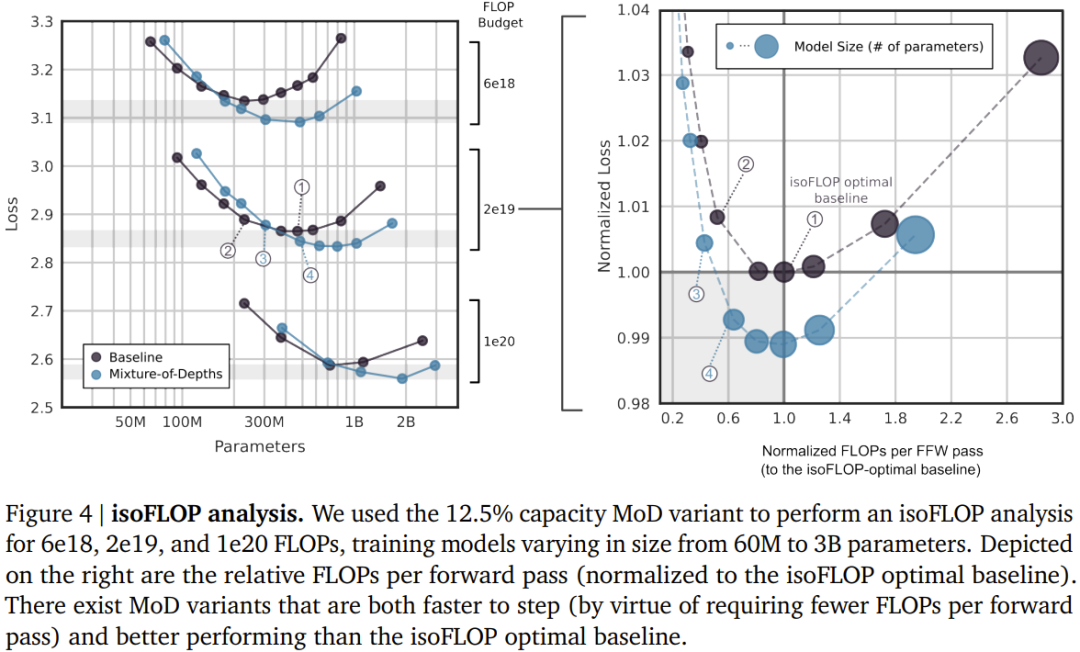

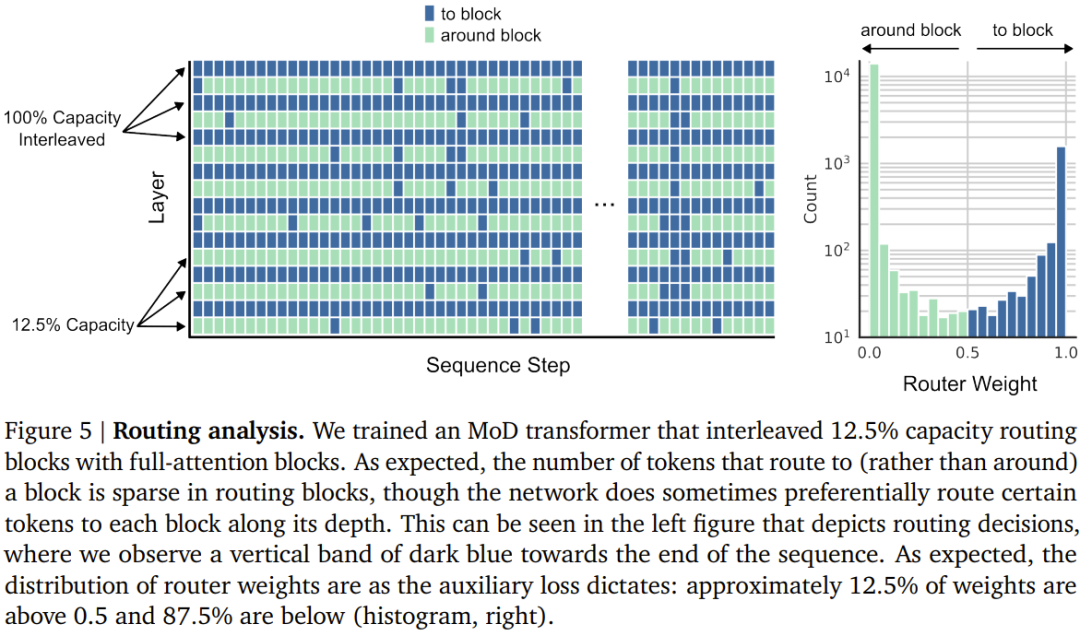

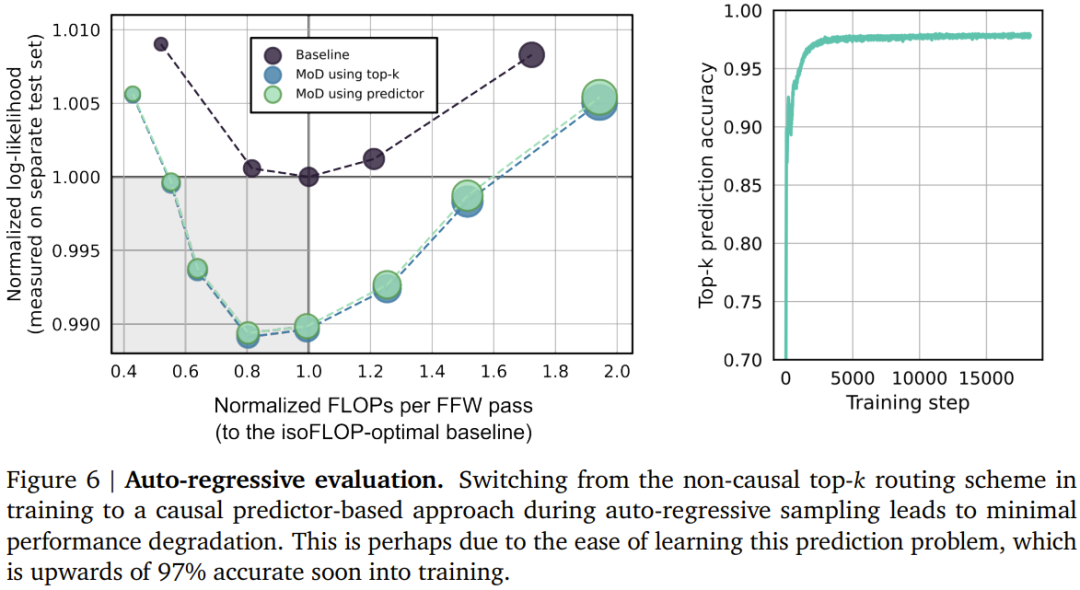

정적 컴퓨팅 예산을 기존의 동등한 수준보다 낮게 설정합니다. Transformer에 필요한 계산 방법은 모듈 계산(즉, self-attention 모듈 및 후속 MLP)에 참여할 수 있는 시퀀스의 토큰 수를 제한하는 것입니다. 예를 들어 일반 변환기는 시퀀스의 모든 토큰이 self-attention 계산에 참여하도록 허용할 수 있지만 MoD 변환기는 시퀀스에서 토큰의 50%만 사용하도록 제한할 수 있습니다. 각 토큰에는 스칼라 가중치를 제공하는 라우팅 알고리즘이 있습니다. 이 가중치는 모듈 계산에 참여할지 아니면 우회할지 여부와 같이 각 토큰의 라우팅 선호도를 나타냅니다. 각 모듈에서 상위 k개의 가장 큰 스칼라 가중치를 찾으면 해당 토큰이 모듈 계산에 참여합니다. k개의 토큰만 이 모듈의 계산에 참여해야 하므로 계산 그래프와 텐서 크기는 훈련 과정에서 정적입니다. 이러한 토큰은 라우팅 알고리즘에 의해 인식되는 동적 및 컨텍스트 관련 토큰입니다.

위 내용은 DeepMind는 Transformer를 업그레이드하여 순방향 패스 FLOP를 최대 절반까지 줄일 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7488

7488

15

15

1377

1377

52

52

77

77

11

11

52

52

19

19

19

19

40

40

GO에서 플로팅 포인트 번호 작업에 어떤 라이브러리가 사용됩니까?

Apr 02, 2025 pm 02:06 PM

GO에서 플로팅 포인트 번호 작업에 어떤 라이브러리가 사용됩니까?

Apr 02, 2025 pm 02:06 PM

Go Language의 부동 소수점 번호 작동에 사용되는 라이브러리는 정확도를 보장하는 방법을 소개합니다.

H5 프로젝트를 실행하는 방법

Apr 06, 2025 pm 12:21 PM

H5 프로젝트를 실행하는 방법

Apr 06, 2025 pm 12:21 PM

H5 프로젝트를 실행하려면 다음 단계가 필요합니다. Web Server, Node.js, 개발 도구 등과 같은 필요한 도구 설치. 개발 환경 구축, 프로젝트 폴더 작성, 프로젝트 초기화 및 코드 작성. 개발 서버를 시작하고 명령 줄을 사용하여 명령을 실행하십시오. 브라우저에서 프로젝트를 미리보고 개발 서버 URL을 입력하십시오. 프로젝트 게시, 코드 최적화, 프로젝트 배포 및 웹 서버 구성을 설정하십시오.

Gitee Pages 정적 웹 사이트 배포 실패 : 단일 파일 문제를 해결하고 해결하는 방법 404 오류?

Apr 04, 2025 pm 11:54 PM

Gitee Pages 정적 웹 사이트 배포 실패 : 단일 파일 문제를 해결하고 해결하는 방법 404 오류?

Apr 04, 2025 pm 11:54 PM

GiteEpages 정적 웹 사이트 배포 실패 : 404 오류 문제 해결 및 해결시 Gitee ...

Beego ORM의 모델과 관련된 데이터베이스를 지정하는 방법은 무엇입니까?

Apr 02, 2025 pm 03:54 PM

Beego ORM의 모델과 관련된 데이터베이스를 지정하는 방법은 무엇입니까?

Apr 02, 2025 pm 03:54 PM

Beegoorm 프레임 워크에서 모델과 관련된 데이터베이스를 지정하는 방법은 무엇입니까? 많은 Beego 프로젝트에서는 여러 데이터베이스를 동시에 작동해야합니다. Beego를 사용할 때 ...

GO의 어떤 라이브러리가 대기업에서 개발하거나 잘 알려진 오픈 소스 프로젝트에서 제공합니까?

Apr 02, 2025 pm 04:12 PM

GO의 어떤 라이브러리가 대기업에서 개발하거나 잘 알려진 오픈 소스 프로젝트에서 제공합니까?

Apr 02, 2025 pm 04:12 PM

GO의 어떤 라이브러리가 대기업이나 잘 알려진 오픈 소스 프로젝트에서 개발 했습니까? GO에 프로그래밍 할 때 개발자는 종종 몇 가지 일반적인 요구를 만납니다.

Redis Stream을 사용하여 GO Language에서 메시지 대기열을 구현할 때 User_ID 유형 변환 문제를 해결하는 방법은 무엇입니까?

Apr 02, 2025 pm 04:54 PM

Redis Stream을 사용하여 GO Language에서 메시지 대기열을 구현할 때 User_ID 유형 변환 문제를 해결하는 방법은 무엇입니까?

Apr 02, 2025 pm 04:54 PM

Go Language에서 메시지 대기열을 구현하기 위해 Redisstream을 사용하는 문제는 Go Language와 Redis를 사용하는 것입니다 ...

H5 페이지 생산에는 지속적인 유지 보수가 필요합니까?

Apr 05, 2025 pm 11:27 PM

H5 페이지 생산에는 지속적인 유지 보수가 필요합니까?

Apr 05, 2025 pm 11:27 PM

코드 취약점, 브라우저 호환성, 성능 최적화, 보안 업데이트 및 사용자 경험 개선과 같은 요소로 인해 H5 페이지를 지속적으로 유지해야합니다. 효과적인 유지 관리 방법에는 완전한 테스트 시스템 설정, 버전 제어 도구 사용, 페이지 성능을 정기적으로 모니터링하고 사용자 피드백 수집 및 유지 관리 계획을 수립하는 것이 포함됩니다.

sql.open을 사용할 때 DSN이 비어있을 때 오류가 발생하지 않습니까?

Apr 02, 2025 pm 12:54 PM

sql.open을 사용할 때 DSN이 비어있을 때 오류가 발생하지 않습니까?

Apr 02, 2025 pm 12:54 PM

sql.open을 사용할 때 DSN에 오류가 발생하지 않는 이유는 무엇입니까? Go Language, SQL.open ...