CVPR 2024 최고 점수 논문: NeRF 변환 작업을 통합하는 새로운 생성 편집 프레임워크 GenN2N

저희 웹사이트의 AIxiv 칼럼은 학술 및 기술 콘텐츠에 대한 칼럼입니다. 지난 몇 년 동안 당사 웹사이트의 AIxiv 칼럼에는 전 세계 주요 대학 및 기업의 최고 연구실을 다루는 2,000개 이상의 콘텐츠가 접수되어 학술 교류 및 보급을 촉진하는 데 도움이 되었습니다. 공유하고 싶은 훌륭한 작품이 있다면 자유롭게 기여하거나 보고를 위해 연락주시기 바랍니다. 제출 이메일 주소는 liyazhou@jiqizhixin.com입니다.

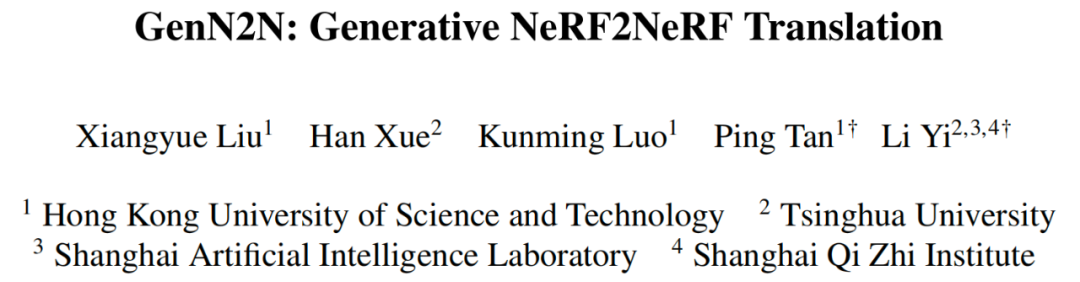

논문 주소: https://arxiv.org/abs/2404.02788 논문 홈페이지: https://xiangyueliu.github.io/GenN2N/ Github 주소: https://github.com/Lxiangyue/GenN2N 논문 제목: GenN2N: Generative NeRF2NeRF Translation

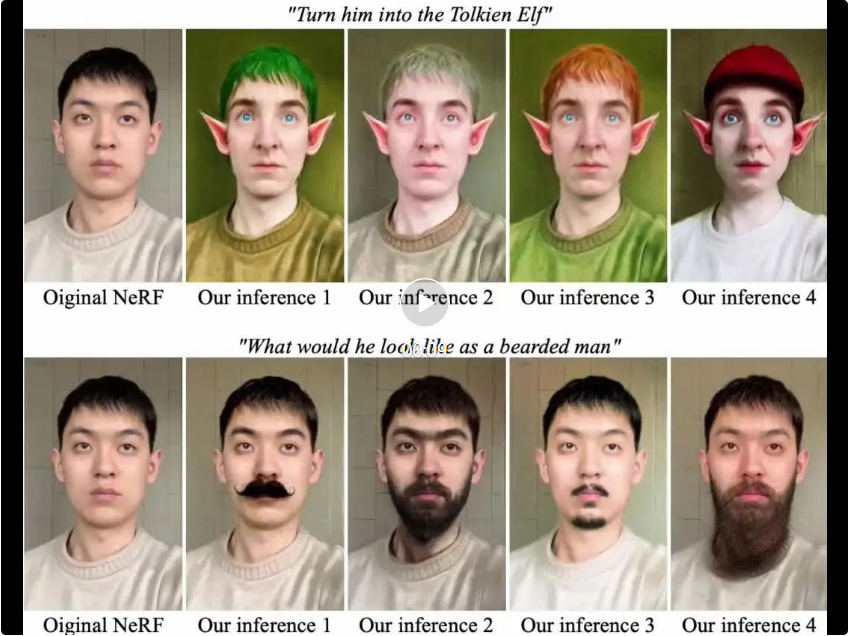

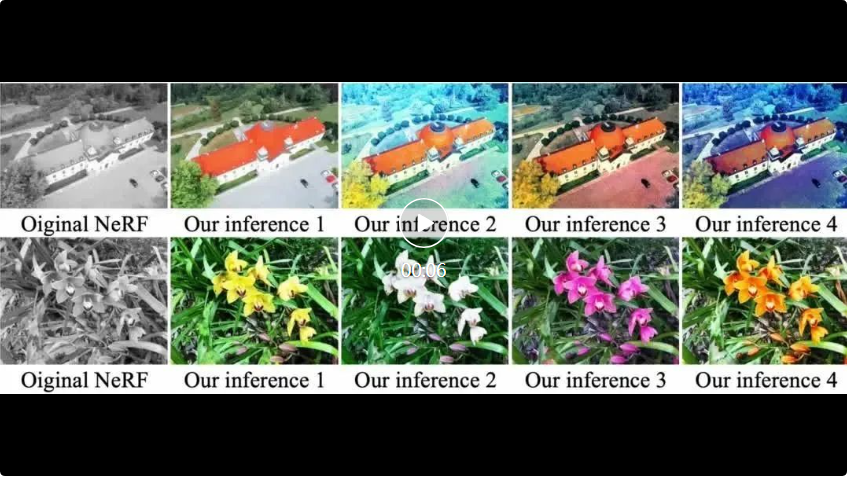

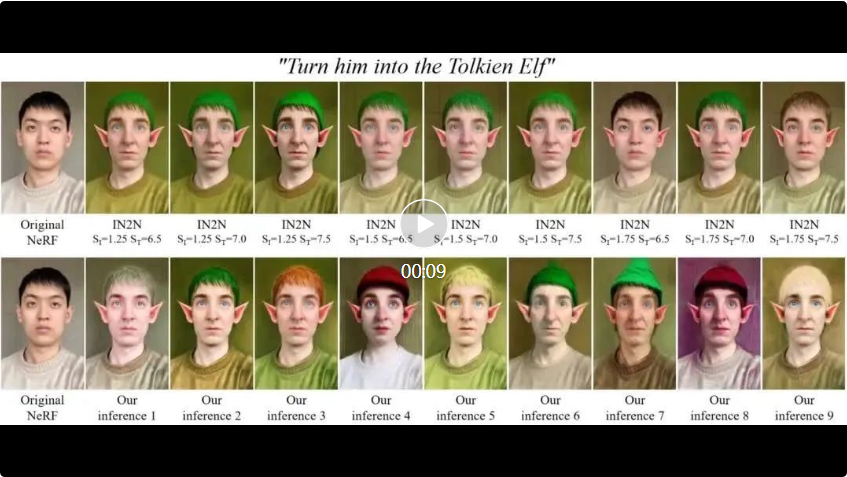

GenN2N의 핵심 부분에서는 1) 3D VAE-GAN의 생성 프레임워크가 도입되어 VAE를 사용하여 전체 편집 공간을 표현하고 입력 2D 편집 이미지 세트에 해당하는 가능한 모든 3D NeRF 편집 분포를 학습합니다. 2) 편집 결과의 신뢰성을 보장하기 위해 GAN을 사용하여 NeRF의 다양한 뷰 편집에 대한 합리적인 감독을 제공합니다. 2) 대조 학습을 사용하여 편집 콘텐츠와 관점을 분리하여 다양한 관점 간 편집 콘텐츠의 일관성을 보장합니다. , 사용자는 조건 생성 모델에서 여러 개의 편집 코드를 무작위로 샘플링하는 것만으로도 편집 대상에 해당하는 다양한 3D 편집 결과를 생성할 수 있습니다.

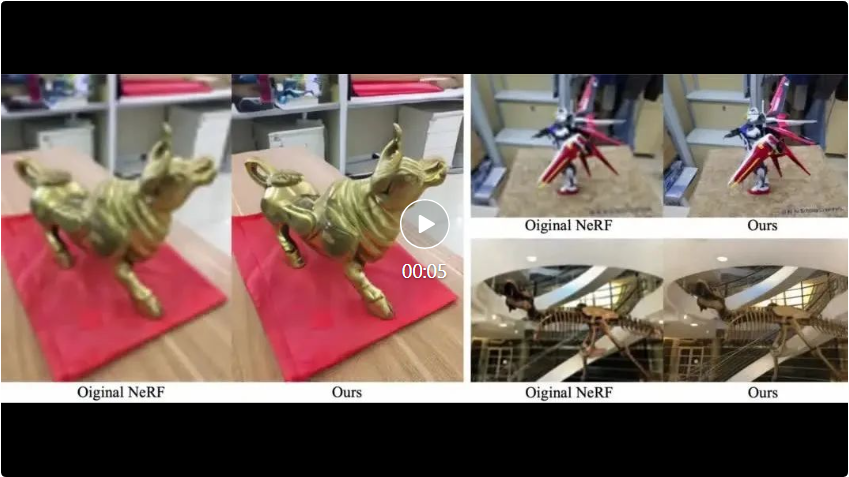

다양한 NeRF 편집 작업(ICCV2023 Oral 등)에서 SOTA 방식과 비교했을 때, GenN2N은 편집 품질, 다양성, 효율성 등의 측면에서 기존 방식보다 우수합니다.

먼저 2D 이미지 편집을 수행한 다음 이러한 2D 편집을 3D NeRF로 업그레이드하여 생성적인 NeRF에서 NeRF로의 변환을 달성합니다.

(음성 샘플) 또는 편집된 그림

(음성 샘플) 또는 편집된 그림 (양성 샘플)을 식별하면 훈련 데이터에서 동일한 관점의 편집된 그림

(양성 샘플)을 식별하면 훈련 데이터에서 동일한 관점의 편집된 그림 을 조건으로 선택합니다. 판별자는 양성 샘플과 음성 샘플을 구별할 때 관점 요인의 간섭을 받지 않습니다.

을 조건으로 선택합니다. 판별자는 양성 샘플과 음성 샘플을 구별할 때 관점 요인의 간섭을 받지 않습니다.  B.

B.  비교 실험

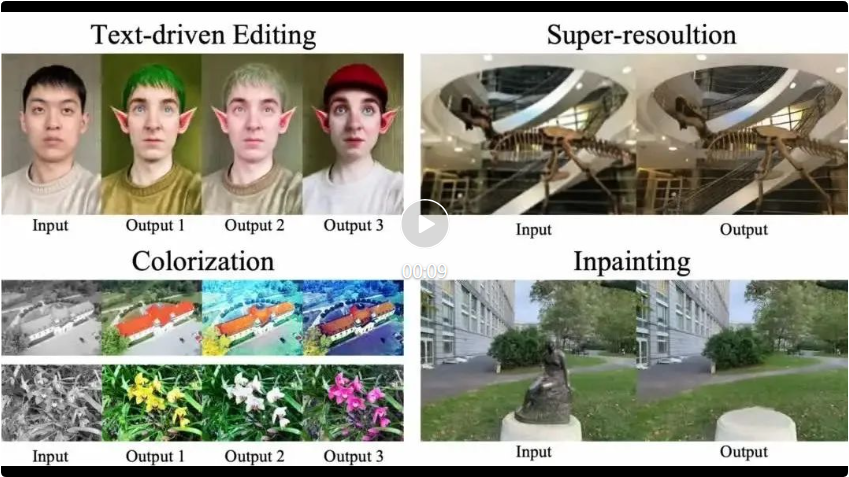

비교 실험  다양한 특정 NeRF 작업에 대한 SOTA 방법과 비교( 텍스트 기반 편집, 색상화, 초해상도 및 인페인팅 등 포함). 결과는 일반 프레임워크인 GenN2N이 작업별 SOTA와 같거나 더 나은 성능을 발휘하는 반면 편집 결과는 더 다양하다는 것을 보여줍니다. (다음은 텍스트 기반 NeRF 편집 작업에서 GenN2N과 Instruct-NeRF2NeRF 간의 비교입니다. ).

다양한 특정 NeRF 작업에 대한 SOTA 방법과 비교( 텍스트 기반 편집, 색상화, 초해상도 및 인페인팅 등 포함). 결과는 일반 프레임워크인 GenN2N이 작업별 SOTA와 같거나 더 나은 성능을 발휘하는 반면 편집 결과는 더 다양하다는 것을 보여줍니다. (다음은 텍스트 기반 NeRF 편집 작업에서 GenN2N과 Instruct-NeRF2NeRF 간의 비교입니다. ).

위 내용은 CVPR 2024 최고 점수 논문: NeRF 변환 작업을 통합하는 새로운 생성 편집 프레임워크 GenN2N의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

GIT 프로젝트를 로컬로 다운로드하는 방법

Apr 17, 2025 pm 04:36 PM

GIT 프로젝트를 로컬로 다운로드하는 방법

Apr 17, 2025 pm 04:36 PM

GIT를 통해 로컬로 프로젝트를 다운로드하려면 다음 단계를 따르십시오. GIT를 설치하십시오. 프로젝트 디렉토리로 이동하십시오. 다음 명령을 사용하여 원격 저장소 클로닝 : git 클론 https://github.com/username/repository-name.git

git에서 코드를 업데이트하는 방법

Apr 17, 2025 pm 04:45 PM

git에서 코드를 업데이트하는 방법

Apr 17, 2025 pm 04:45 PM

GIT 코드를 업데이트하는 단계 : 코드 확인 : git 클론 https://github.com/username/repo.git 최신 변경 사항 가져 오기 : Git Fetch Merge 변경 사항 : GIT 병합 원산지/마스터 푸시 변경 (옵션) : Git Push Origin Master

GIT 다운로드가 활성화되지 않은 경우해야 할 일

Apr 17, 2025 pm 04:54 PM

GIT 다운로드가 활성화되지 않은 경우해야 할 일

Apr 17, 2025 pm 04:54 PM

해결 : GIT 다운로드 속도가 느리면 다음 단계를 수행 할 수 있습니다. 네트워크 연결을 확인하고 연결 방법을 전환하십시오. GIT 구성 최적화 : 포스트 버퍼 크기를 늘리고 (GIT 구성-글로벌 http.postBuffer 524288000) 저속 제한 (git config --global http.lowspeedlimit 1000)을 줄입니다. git 프록시 (예 : git-proxy 또는 git-lfs-proxy)를 사용하십시오. 다른 git 클라이언트 (예 : Sourcetree 또는 Github 데스크탑)를 사용해보십시오. 화재 보호를 확인하십시오

git로 저장소를 삭제하는 방법

Apr 17, 2025 pm 04:03 PM

git로 저장소를 삭제하는 방법

Apr 17, 2025 pm 04:03 PM

git 저장소를 삭제하려면 다음 단계를 따르십시오. 삭제하려는 저장소를 확인하십시오. 로컬 리포지토리 삭제 : rm -rf 명령을 사용하여 폴더를 삭제하십시오. 원격으로 창고 삭제 : 창고 설정으로 이동하고 "창고 삭제"옵션을 찾은 후 작동을 확인하십시오.

git에서 코드를 병합하는 방법

Apr 17, 2025 pm 04:39 PM

git에서 코드를 병합하는 방법

Apr 17, 2025 pm 04:39 PM

GIT 코드 병합 프로세스 : 충돌을 피하기 위해 최신 변경 사항을 가져옵니다. 병합하려는 지점으로 전환하십시오. 병합을 시작하고 병합을 지정합니다. 병합 충돌을 해결하십시오 (있는 경우). 커밋 메시지를 제공하여 병합을 준비하고 커밋합니다.

PHP 프로젝트에서 효율적인 검색 문제를 해결하는 방법은 무엇입니까? Typesense는이를 달성하는 데 도움이됩니다!

Apr 17, 2025 pm 08:15 PM

PHP 프로젝트에서 효율적인 검색 문제를 해결하는 방법은 무엇입니까? Typesense는이를 달성하는 데 도움이됩니다!

Apr 17, 2025 pm 08:15 PM

전자 상거래 웹 사이트를 개발할 때 어려운 문제가 발생했습니다. 대량의 제품 데이터에서 효율적인 검색 기능을 달성하는 방법은 무엇입니까? 기존 데이터베이스 검색은 비효율적이며 사용자 경험이 좋지 않습니다. 일부 연구 후, 나는 검색 엔진 타입을 발견하고 공식 PHP 클라이언트 Typeense/Typeense-PHP를 통해이 문제를 해결하여 검색 성능을 크게 향상 시켰습니다.

Git Commit을 사용하는 방법

Apr 17, 2025 pm 03:57 PM

Git Commit을 사용하는 방법

Apr 17, 2025 pm 03:57 PM

Git Commit은 프로젝트의 현재 상태에 대한 스냅 샷을 저장하기 위해 파일 변경을 GIT 저장소에 기록하는 명령입니다. 사용 방법은 다음과 같습니다. 임시 저장 영역에 변경 사항 추가 제출 메시지를 저장하고 종료하기 위해 간결하고 유익한 제출 메시지를 작성하여 제출을 완료하기 위해 제출물을 완료하십시오. 제출자에 서명을 추가하여 제출 내용을보기 위해 GIT 로그를 사용하십시오.

Git에서 로컬 코드를 업데이트하는 방법

Apr 17, 2025 pm 04:48 PM

Git에서 로컬 코드를 업데이트하는 방법

Apr 17, 2025 pm 04:48 PM

로컬 git 코드를 업데이트하는 방법은 무엇입니까? Git Fetch를 사용하여 원격 저장소에서 최신 변경 사항을 가져옵니다. Git Merge Origin/& Lt; 원격 지점 이름 & gt; 합병으로 인해 발생하는 갈등을 해결합니다. git commit -m "merge branch & lt; 원격 브랜치 이름 & gt;" 병합 변경 사항을 제출하고 업데이트를 적용합니다.