기술 주변기기

기술 주변기기

일체 포함

일체 포함

CVPR 2024 | AI는 춤을 출 때 날아다니는 치마도 고도로 복원할 수 있다. 난양폴리테크닉은 역동적인 인체 렌더링을 위한 새로운 패러다임을 제안한다.

CVPR 2024 | AI는 춤을 출 때 날아다니는 치마도 고도로 복원할 수 있다. 난양폴리테크닉은 역동적인 인체 렌더링을 위한 새로운 패러다임을 제안한다.

CVPR 2024 | AI는 춤을 출 때 날아다니는 치마도 고도로 복원할 수 있다. 난양폴리테크닉은 역동적인 인체 렌더링을 위한 새로운 패러다임을 제안한다.

AIxiv 칼럼은 본 사이트에서 학술 및 기술 콘텐츠를 게재하는 칼럼입니다. 지난 몇 년 동안 이 사이트의 AIxiv 칼럼에는 전 세계 주요 대학 및 기업의 최고 연구실을 대상으로 한 2,000개 이상의 보고서가 접수되어 학술 교류 및 보급을 효과적으로 촉진하고 있습니다. 공유하고 싶은 훌륭한 작품이 있다면 자유롭게 기여하거나 보고를 위해 연락주시기 바랍니다. 제출 이메일: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

논문 제목: SurMo: Surface-based 4D Motion Modeling for Dynamic Human Rendering 논문 주소: https://arxiv.org/pdf/2404.01225.pdf 프로젝트 홈페이지: https //taohuumd.github.io/projects/SurMo Github 링크: https://github.com/TaoHuUMD/SurMo

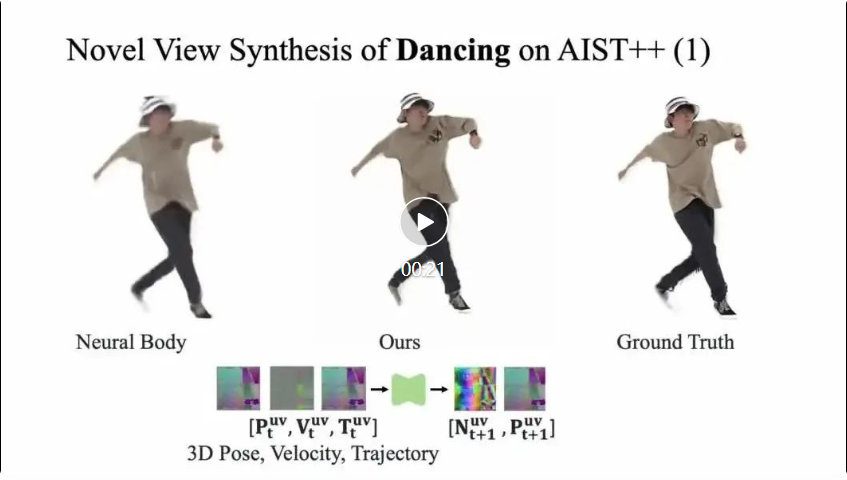

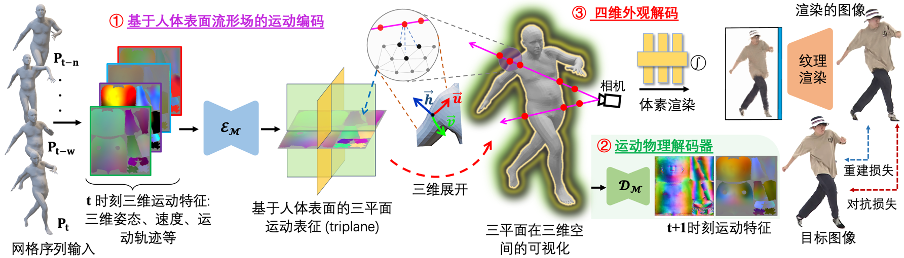

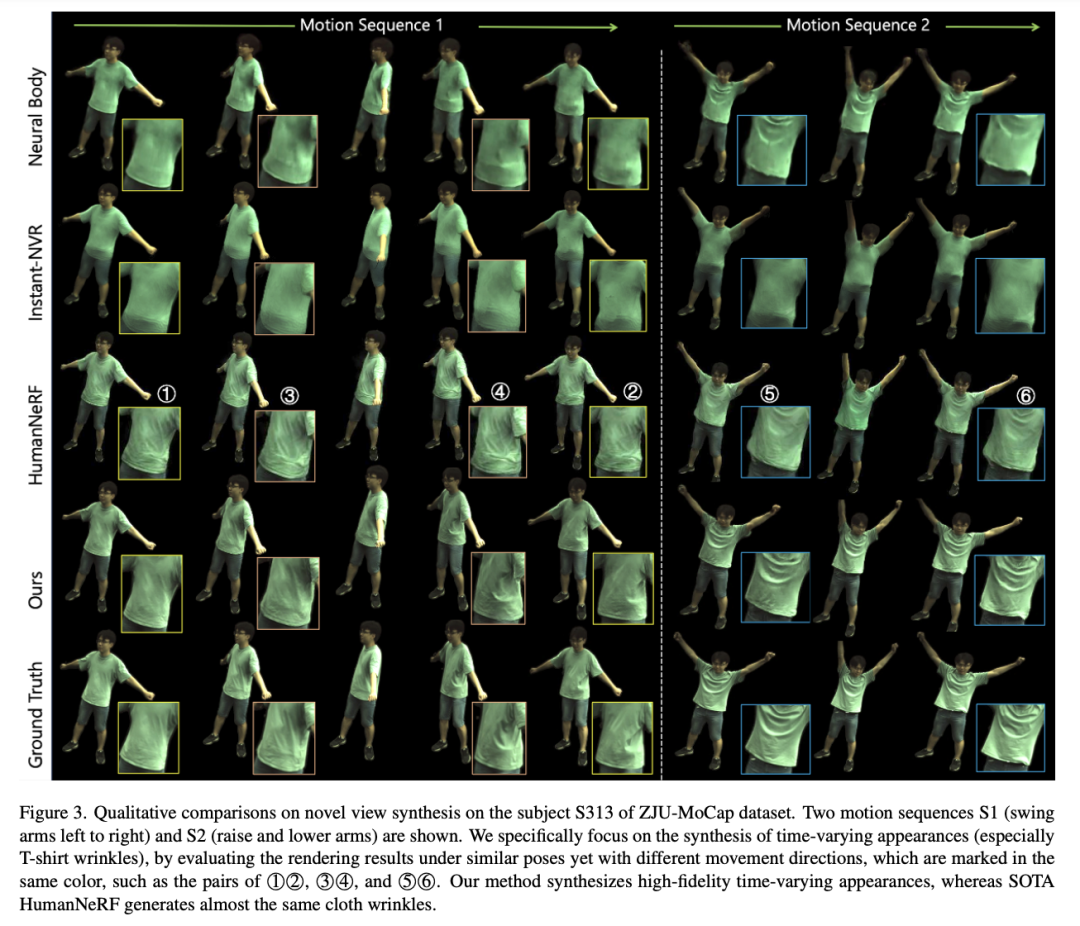

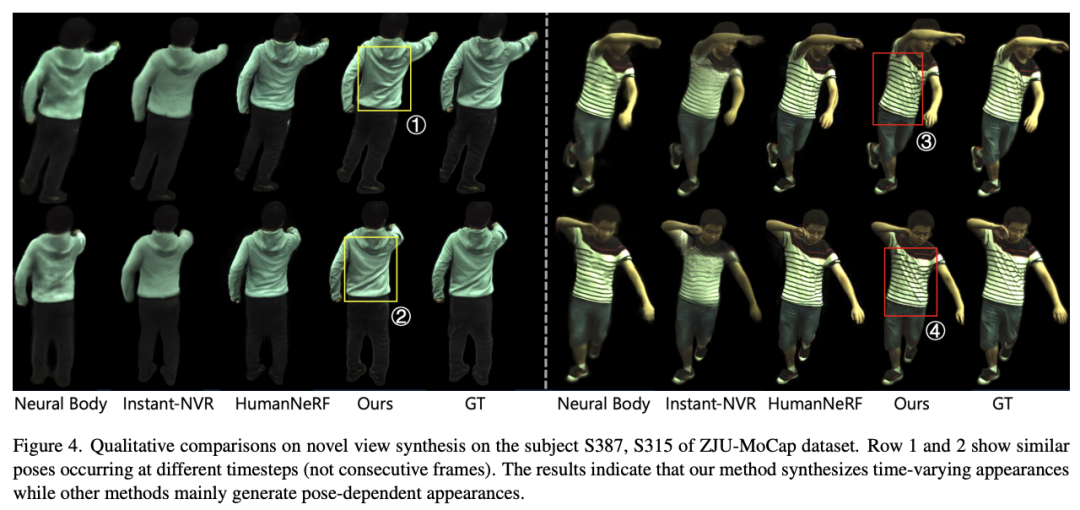

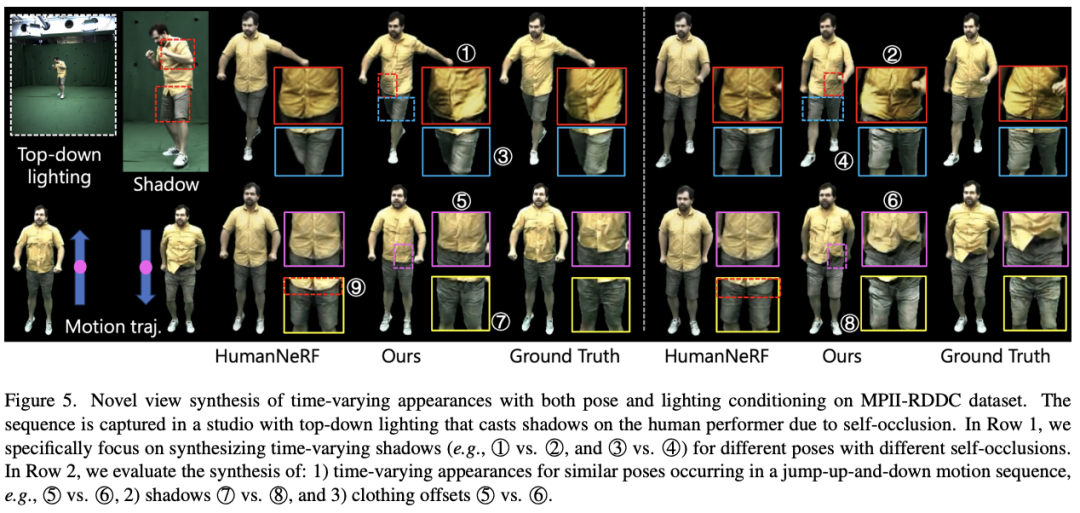

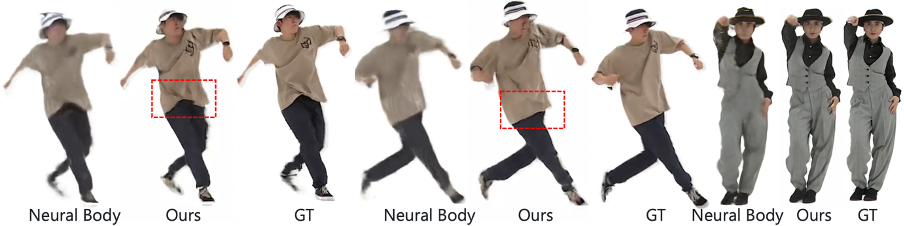

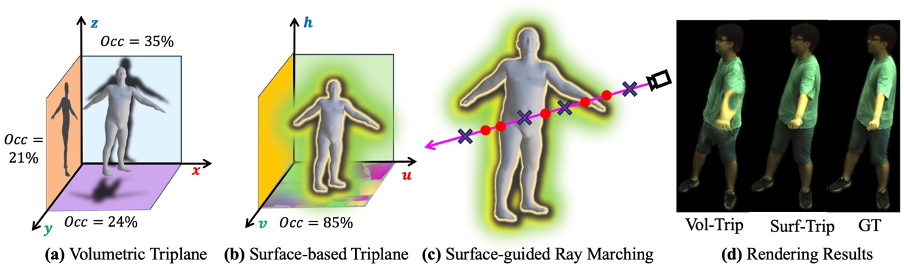

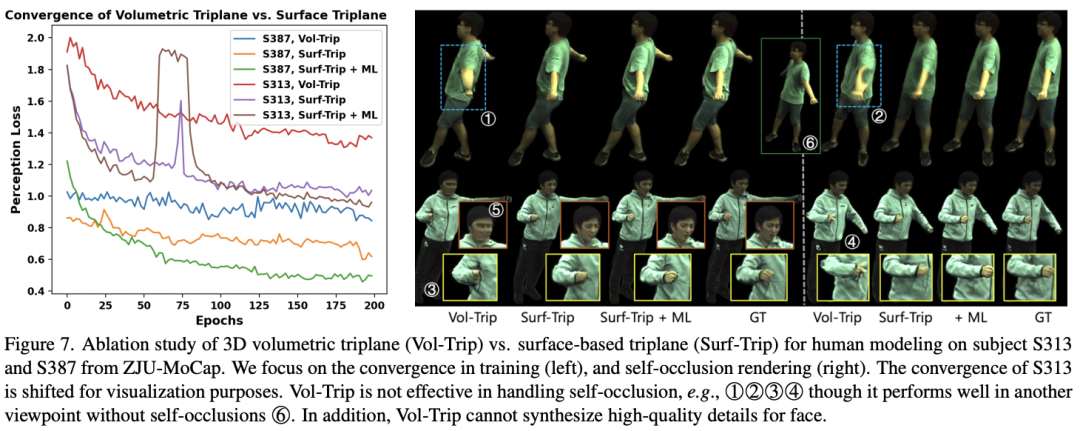

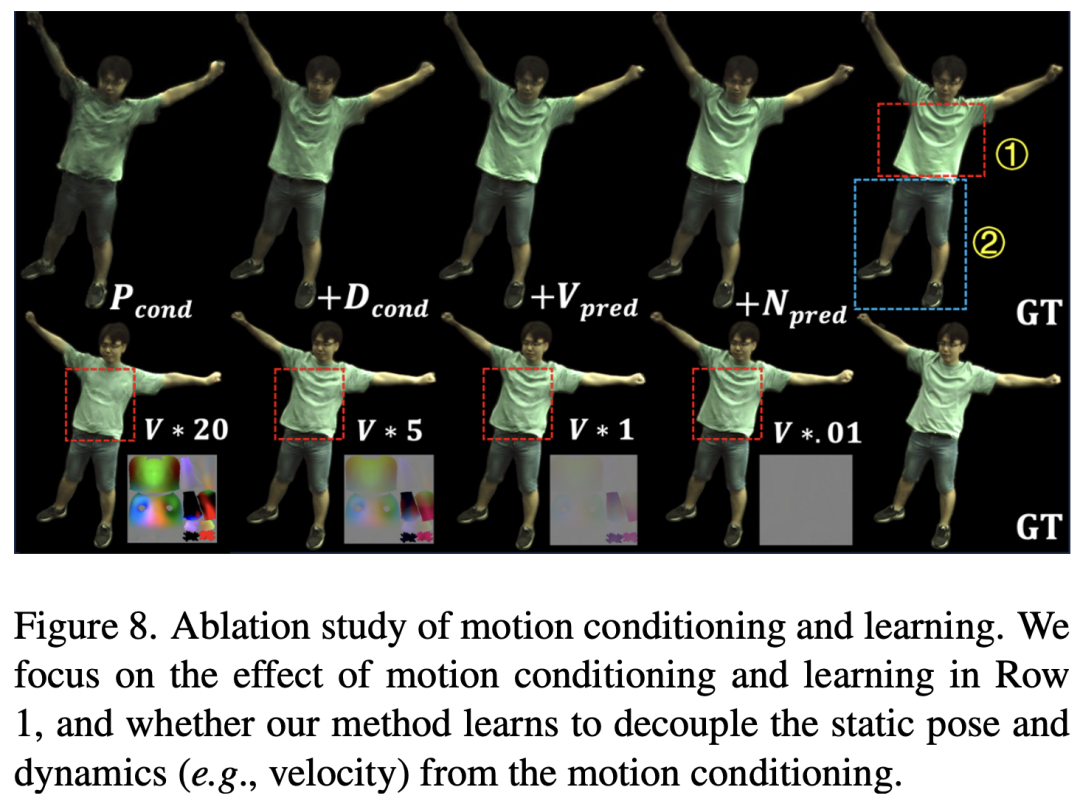

희소한 3차원 공간에서 움직임을 모델링하는 기존 방법과 달리 SurMo는 인간 표면 다양체 필드를 기반으로(또는 컴팩트)을 제안합니다. 2차원 텍스처 UV 공간) 4차원(XYZ-T) 모션 모델링을 수행하고 인체 표면에 정의된 3면 (표면 기반 3면)을 통해 모션을 표현합니다. 움직임의 공간적 편향(표면)과 같은 현재 움직임 특성(3차원 자세, 속도, 움직임 궤적 등)을 기반으로 다음 프레임의 움직임 상태를 예측하는 움직임 물리학 디코더를 제안합니다. 법선 벡터 및 시간 편향 - 속도 이는 모션 특징의 연속성을 모델링합니다. 4차원 외관 디코딩, 3차원 자유 시점 비디오를 렌더링하기 위한 모션 특징의 시간적 디코딩, 주로 하이브리드 복셀-텍스처 신경 렌더링을 통해 구현됨(Hybrid Volumetric-Textural Rendering, HVTR [Hu et al. 2022]) .

모션 관련 그림자 및 의복 관련 모션 렌더링

위 내용은 CVPR 2024 | AI는 춤을 출 때 날아다니는 치마도 고도로 복원할 수 있다. 난양폴리테크닉은 역동적인 인체 렌더링을 위한 새로운 패러다임을 제안한다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7445

7445

15

15

1374

1374

52

52

76

76

11

11

39

39

19

19

14

14

6

6

GO에서 플로팅 포인트 번호 작업에 어떤 라이브러리가 사용됩니까?

Apr 02, 2025 pm 02:06 PM

GO에서 플로팅 포인트 번호 작업에 어떤 라이브러리가 사용됩니까?

Apr 02, 2025 pm 02:06 PM

Go Language의 부동 소수점 번호 작동에 사용되는 라이브러리는 정확도를 보장하는 방법을 소개합니다.

비트 : 비즈니스는 비트 코인을 무시한 큰 추세를 구매합니다

Mar 05, 2025 pm 02:42 PM

비트 : 비즈니스는 비트 코인을 무시한 큰 추세를 구매합니다

Mar 05, 2025 pm 02:42 PM

주간 관찰 : 비트 코인을 비축하는 비즈니스 - 양조 변화는 종종 주간 메모에서 간과 된 시장 동향을 지적합니다. Microstrategy의 움직임은 뚜렷한 예입니다. 많은 사람들이 "Microstrategy와 Michaelsaylor는 이미 잘 알려져 있습니다. 이것은 무엇에주의를 기울일 것인가?" 이보기는 일방적입니다. 최근 몇 달 동안 비트 코인을 예비 자산으로 채택한 것에 대한 심층적 인 연구에 따르면 이것은 고립 된 사례가 아니라 가장 큰 추세임을 보여줍니다. 나는 향후 12-18 개월 동안 수백 개의 회사가 소송을 따르고 대량의 비트 코인을 구매할 것이라고 예측합니다.

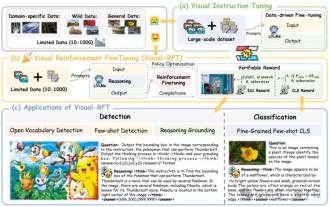

SFT를 상당히 능가하는 O1/DeepSeek-R1의 비밀은 멀티 모달 대형 모델에서도 사용할 수 있습니다.

Mar 12, 2025 pm 01:03 PM

SFT를 상당히 능가하는 O1/DeepSeek-R1의 비밀은 멀티 모달 대형 모델에서도 사용할 수 있습니다.

Mar 12, 2025 pm 01:03 PM

상하이 Jiaotong University, Shanghai Ailab 및 Chinese University of Hong Kong의 연구원들은 Visual-RFT (Visual Enhancement Fine Tuning) 오픈 소스 프로젝트를 시작했으며, 이는 LVLM (Language Big Model)의 성능을 크게 향상시키기 위해 소량의 데이터 만 필요합니다. Visual-Rft는 영리하게 DeepSeek-R1의 규칙 기반 강화 학습 접근 방식을 OpenAI의 RFT (Rencement Fine Tuning) 패러다임과 결합 하여이 접근법을 텍스트 필드에서 시야로 성공적으로 확장합니다. Visual-RFT는 시각적 하위 분류 및 객체 감지와 같은 작업에 대한 해당 규칙 보상을 설계함으로써 텍스트, 수학적 추론 및 기타 필드로 제한되는 DeepSeek-R1 메소드의 한계를 극복하여 LVLM 교육을위한 새로운 방법을 제공합니다. Vis

Gitee Pages 정적 웹 사이트 배포 실패 : 단일 파일 문제를 해결하고 해결하는 방법 404 오류?

Apr 04, 2025 pm 11:54 PM

Gitee Pages 정적 웹 사이트 배포 실패 : 단일 파일 문제를 해결하고 해결하는 방법 404 오류?

Apr 04, 2025 pm 11:54 PM

GiteEpages 정적 웹 사이트 배포 실패 : 404 오류 문제 해결 및 해결시 Gitee ...

GO의 어떤 라이브러리가 대기업에서 개발하거나 잘 알려진 오픈 소스 프로젝트에서 제공합니까?

Apr 02, 2025 pm 04:12 PM

GO의 어떤 라이브러리가 대기업에서 개발하거나 잘 알려진 오픈 소스 프로젝트에서 제공합니까?

Apr 02, 2025 pm 04:12 PM

GO의 어떤 라이브러리가 대기업이나 잘 알려진 오픈 소스 프로젝트에서 개발 했습니까? GO에 프로그래밍 할 때 개발자는 종종 몇 가지 일반적인 요구를 만납니다.

해외 버전의 배송 지역 데이터를 얻는 방법은 무엇입니까? 기성품 리소스는 무엇입니까?

Apr 01, 2025 am 08:15 AM

해외 버전의 배송 지역 데이터를 얻는 방법은 무엇입니까? 기성품 리소스는 무엇입니까?

Apr 01, 2025 am 08:15 AM

질문 설명 : 해외 버전의 배송 지역 데이터를 얻는 방법은 무엇입니까? 기성품 자원이 있습니까? 국경 간 전자 상거래 또는 세계화 된 비즈니스에서 정확하게 ...

Typecho 경로 일치 충돌 : 왜 내/test/tag/his/10086 testtagpage 대신 testtagindex와 일치 하는가?

Apr 01, 2025 am 09:03 AM

Typecho 경로 일치 충돌 : 왜 내/test/tag/his/10086 testtagpage 대신 testtagindex와 일치 하는가?

Apr 01, 2025 am 09:03 AM

Typecho 라우팅 일치 규칙 분석 및 문제 조사이 기사는 Typecho 플러그인 라우팅 등록 및 실제 일치 결과의 일관되지 않은 결과에 대한 질문을 분석하고 답변합니다.

파이썬 모래시 그래프 그리기 : 가변적 인 정의되지 않은 오류를 피하는 방법?

Apr 01, 2025 pm 06:27 PM

파이썬 모래시 그래프 그리기 : 가변적 인 정의되지 않은 오류를 피하는 방법?

Apr 01, 2025 pm 06:27 PM

Python : 모래 시계 그래픽 도면 및 입력 검증을 시작 하기이 기사는 모래 시계 그래픽 드로잉 프로그램에서 Python 초보자가 발생하는 변수 정의 문제를 해결합니다. 암호...