폭발 후 반전? '하룻밤 만에 MLP 죽였다' KAN : 사실 나도 MLP다

완전 연결된 피드포워드 신경망이라고도 알려진 다층 퍼셉트론(MLP)은 오늘날 딥 러닝 모델의 기본 구성 요소입니다. MLP는 비선형 함수를 근사화하기 위한 기계 학습의 기본 방법이기 때문에 MLP의 중요성은 아무리 강조해도 지나치지 않습니다.

그러나 최근 MIT와 다른 기관의 연구자들은 매우 유망한 대체 방법인 KAN을 제안했습니다. 이 방법은 정확성과 해석 가능성 측면에서 MLP보다 성능이 뛰어납니다. 또한 매우 적은 수의 매개변수로 훨씬 더 많은 수의 매개변수를 사용하여 실행되는 MLP보다 성능이 뛰어납니다. 예를 들어 저자는 KAN을 사용하여 매듭 이론의 수학적 법칙을 재발견하고 더 작은 네트워크와 더 높은 수준의 자동화로 DeepMind의 결과를 재현했다고 밝혔습니다. 구체적으로 DeepMind의 MLP에는 약 300,000개의 매개변수가 있는 반면 KAN에는 약 200개의 매개변수만 있습니다.

미세조정 내용은 다음과 같습니다. 이러한 놀라운 연구 결과로 인해 KAN은 빠르게 인기를 얻었고 많은 사람들이 KAN을 연구하게 되었습니다. 곧 일부 사람들은 의문을 제기했습니다. 그 중 'KAN은 MLP일 뿐이다'라는 제목의 Colab 문서가 화제의 대상이 되었습니다.

KAN 그냥 일반 MLP인가요?

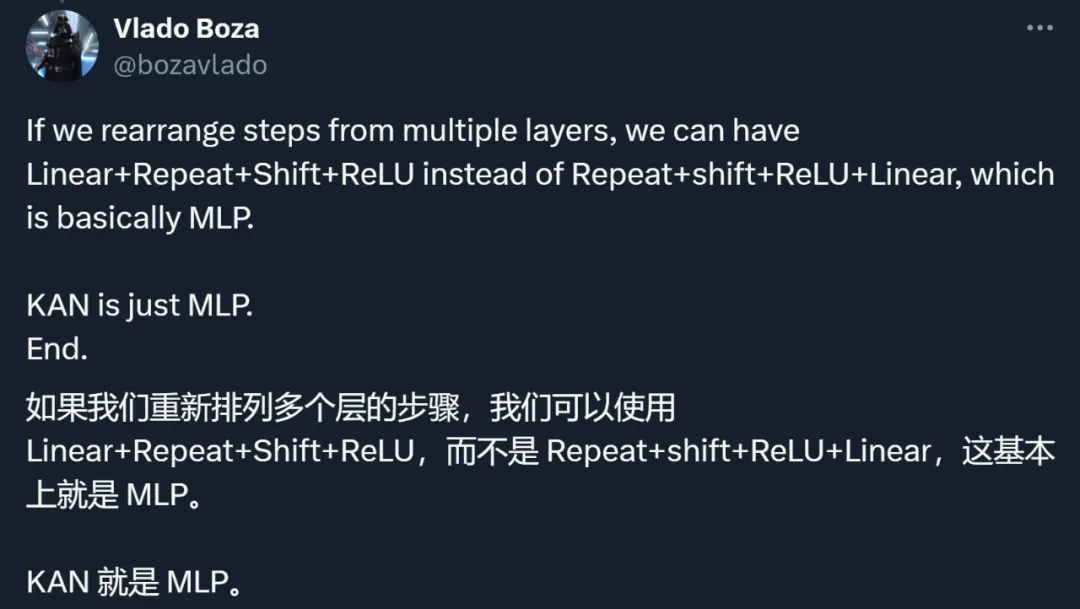

위 문서의 작성자는 ReLU 앞에 반복과 교대를 추가하면 KAN을 MLP로 작성할 수 있다고 명시했습니다.

짧은 예를 통해 저자는 동일한 수의 매개변수와 약간 비선형 구조를 사용하여 KAN 네트워크를 일반 MLP로 다시 작성하는 방법을 보여줍니다.

기억해야 할 것은 KAN이 가장자리에 활성화 기능을 가지고 있다는 것입니다. 그들은 B-스플라인을 사용합니다. 표시된 예에서 저자는 단순화를 위해 조각별 선형 함수만 사용합니다. 이는 네트워크의 모델링 기능을 변경하지 않습니다.

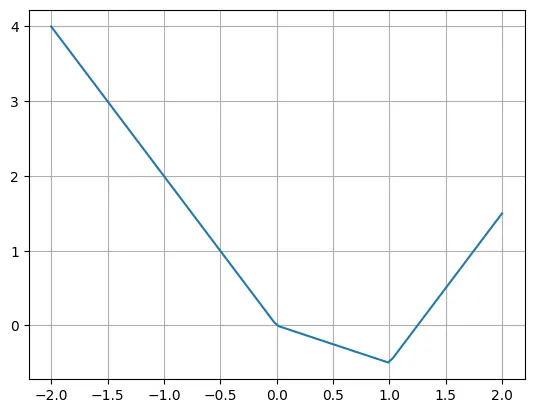

다음은 조각별 선형 함수의 예입니다.

def f(x):if x

저자는 여러 ReLU 및 선형 함수를 사용하여 이 함수를 쉽게 다시 작성할 수 있다고 말했습니다. 때로는 ReLU의 입력을 이동해야 하는 경우도 있습니다.

plt.plot(X, -2*X + torch.relu(X)*1.5 + torch.relu(X-1)*2.5)plt.grid()

실제 질문은 KAN 레이어를 일반적인 MLP 레이어로 다시 작성하는 방법입니다. n개의 입력 뉴런, m개의 출력 뉴런이 있고 조각별 함수에 k개의 조각이 있다고 가정합니다. 이를 위해서는 n*m*k 매개변수가 필요합니다(모서리당 k개의 매개변수, n*m 모서리가 있음).

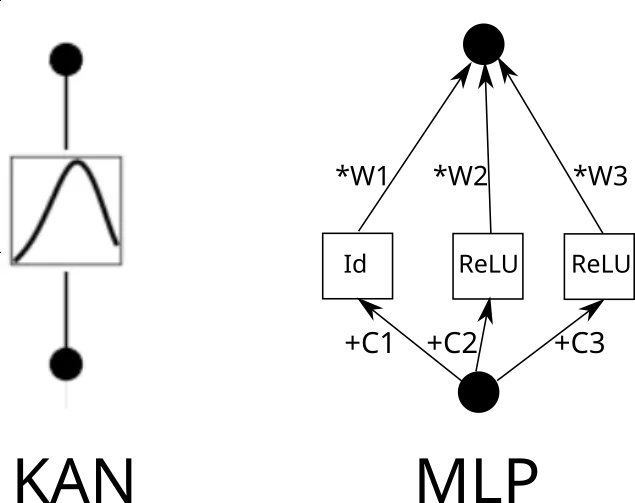

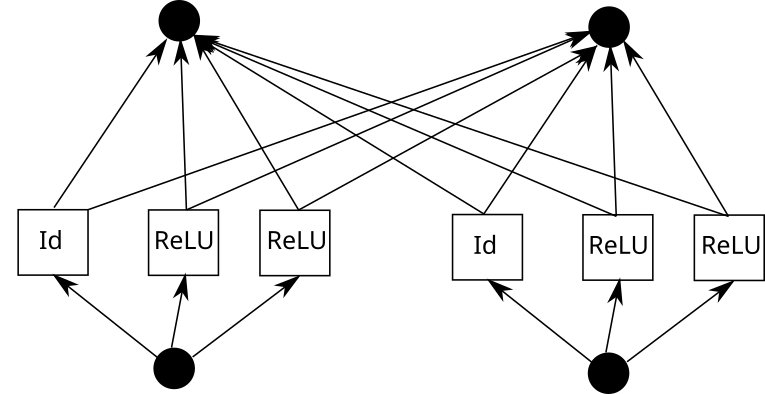

이제 KAN 에지를 고려해보세요. 이렇게 하려면 입력을 k 번 복사해야 하며 각 복사본은 상수에 의해 이동된 다음 ReLU 및 선형 레이어(첫 번째 레이어 제외)를 통해 실행되어야 합니다. 그래픽으로 보면 다음과 같습니다(C는 상수이고 W는 가중치).

이제 각 모서리에 대해 이 프로세스를 반복할 수 있습니다. 그러나 한 가지 주목해야 할 점은 조각별 선형 함수 그리드가 모든 곳에서 동일하다면 중간 ReLU 출력을 공유하고 여기에 가중치를 혼합할 수 있다는 것입니다.

Pytorch에서는 다음과 같이 번역됩니다.

k = 3 # Grid sizeinp_size = 5out_size = 7batch_size = 10X = torch.randn(batch_size, inp_size) # Our inputlinear = nn.Linear(inp_size*k, out_size)# Weightsrepeated = X.unsqueeze(1).repeat(1,k,1)shifts = torch.linspace(-1, 1, k).reshape(1,k,1)shifted = repeated + shiftsintermediate = torch.cat([shifted[:,:1,:], torch.relu(shifted[:,1:,:])], dim=1).flatten(1)outputs = linear(intermediate)

이제 레이어는 다음과 같습니다.

- Expand + Shift + ReLU

- Linear

세 레이어를 차례로 고려하세요.

- Expand + Shift + (레이어 1 여기에서 시작)

- linear

- expand + shift + relu (여기에서 레이어 2가 여기에서 시작됩니다)

- 린 aexpand + shift + relu (여기서 시작)

- Linear

입력 확장을 무시하고 다음과 같이 재정렬할 수 있습니다.

- Linear(레이어 1이 여기서 시작)

- Expand + Shift + ReLU

- Linear(레이어 2가 여기서 시작)

- Expand + Shift + ReLU

다음 레이어는 기본적으로 MLP라고 부를 수 있습니다. 선형 레이어를 더 크게 만들고, 확장 및 이동을 제거하고, 더 나은 모델링 기능을 얻을 수도 있습니다(비록 매개변수 비용은 더 높지만).

- Linear (Layer 2는 여기서 시작)

- Expand + Shift + ReLU

이 예를 통해 저자는 KAN이 일종의 MLP임을 보여줍니다. 이 진술은 모든 사람이 두 가지 유형의 방법을 다시 생각하게 만들었습니다.

KAN의 아이디어, 방법, 결과에 대한 재검토

실제로 KAN은 MLP와의 관계가 불분명한 것 외에도 여러 측면에서 의문을 제기해 왔습니다.

요약하면, 연구자들의 논의는 주로 다음과 같은 점에 집중되었습니다.

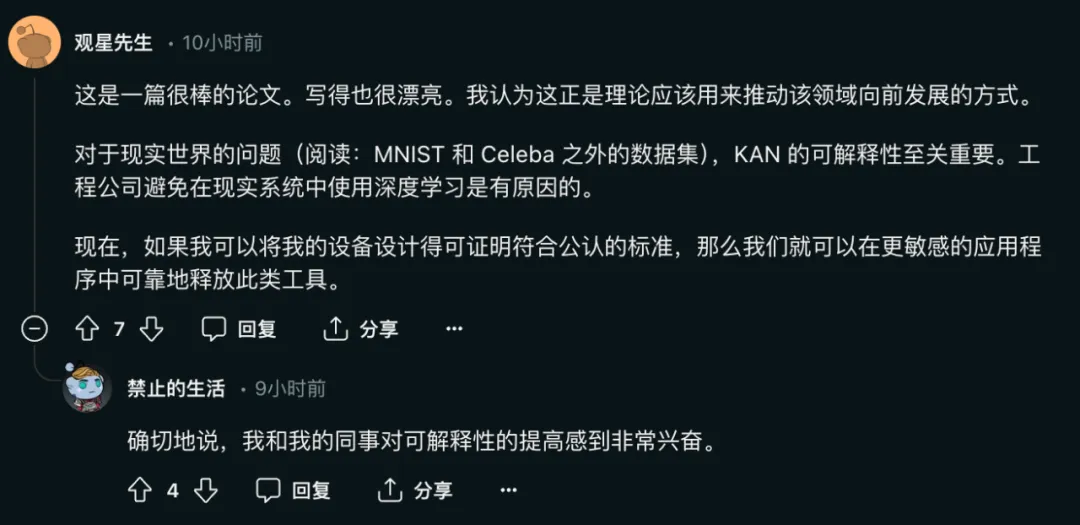

첫째, KAN의 주요 기여는 확장 속도, 정확성 등이 아닌 해석 가능성에 있습니다.

논문의 저자는 다음과 같이 말했습니다.

- KAN은 MLP보다 빠르게 확장됩니다. KAN은 더 적은 매개변수를 사용하여 MLP보다 정확도가 더 높습니다.

- KAN은 직관적으로 시각화할 수 있습니다. KAN은 MLP가 제공할 수 없는 해석성과 상호작용성을 제공합니다. KAN을 사용하면 잠재적으로 새로운 과학 법칙을 발견할 수 있습니다.

그 중에서 실제 문제를 해결하기 위한 모델에 대한 네트워크의 해석 가능성의 중요성은 자명합니다.

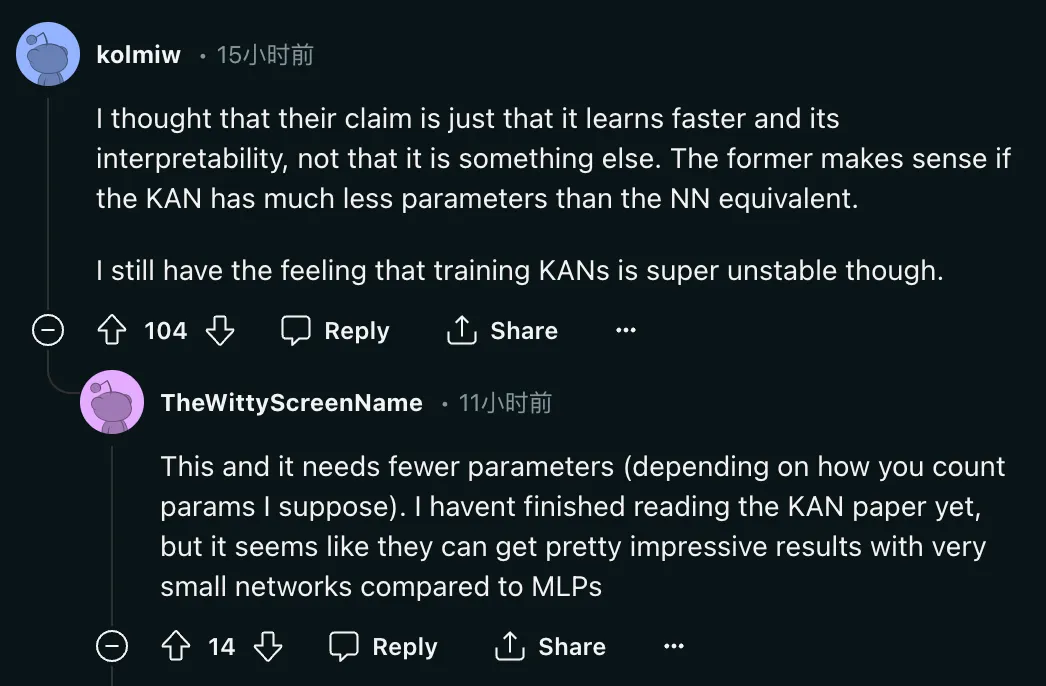

하지만 문제는 다음과 같습니다. "내 생각에 그들의 주장은 단지 학습한다는 것입니다. KAN이 동등한 NN보다 훨씬 적은 매개변수를 가지고 있다면 전자가 의미가 있습니다. KAN이 많은 것을 가질 수 없다면 어떻게 될까요? 동등한 NN보다 매개변수가 적습니까?

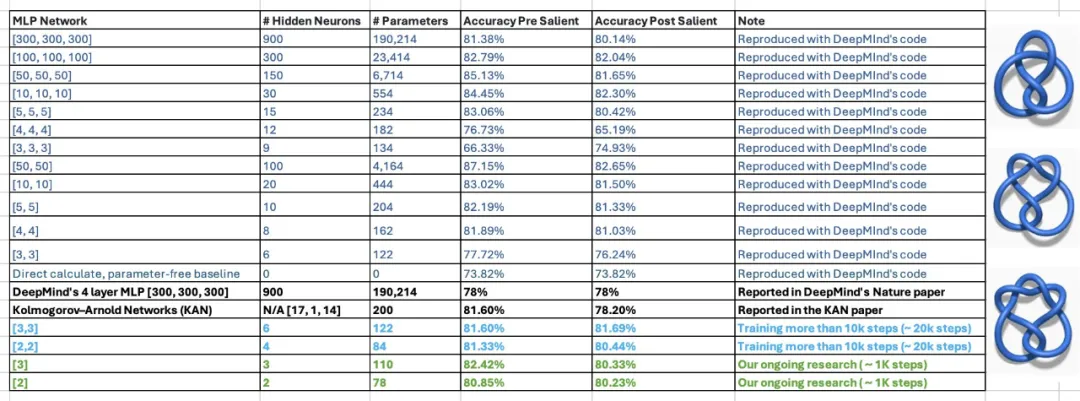

이 진술은 여전히 의심 스럽습니다. 논문에서 KAN의 저자들은 KAN의 200개 매개변수만을 사용하여 30만 매개변수의 MLP를 사용하여 DeepMind의 수학적 정리 연구를 재현할 수 있었다고 밝혔습니다. 결과를 본 후, Georgia Tech 부교수 Humphrey Shi의 학생 2명이 DeepMind의 실험을 재검토한 결과 단 122개의 매개변수만으로 DeepMind의 MLP가 KAN의 81.6% 정확도와 일치할 수 있음을 발견했습니다. 게다가 그들은 DeepMind 코드를 크게 변경하지 않았습니다. 이 결과를 얻기 위해 그들은 네트워크 크기를 줄이고, 무작위 시드를 사용하고, 훈련 시간을 늘렸습니다.

이 진술은 여전히 의심 스럽습니다. 논문에서 KAN의 저자들은 KAN의 200개 매개변수만을 사용하여 30만 매개변수의 MLP를 사용하여 DeepMind의 수학적 정리 연구를 재현할 수 있었다고 밝혔습니다. 결과를 본 후, Georgia Tech 부교수 Humphrey Shi의 학생 2명이 DeepMind의 실험을 재검토한 결과 단 122개의 매개변수만으로 DeepMind의 MLP가 KAN의 81.6% 정확도와 일치할 수 있음을 발견했습니다. 게다가 그들은 DeepMind 코드를 크게 변경하지 않았습니다. 이 결과를 얻기 위해 그들은 네트워크 크기를 줄이고, 무작위 시드를 사용하고, 훈련 시간을 늘렸습니다.

이에 대해 논문 작성자도 긍정적인 반응을 보였습니다.

둘째, KAN과 MLP는 근본적으로 방법이 다르지 않습니다.

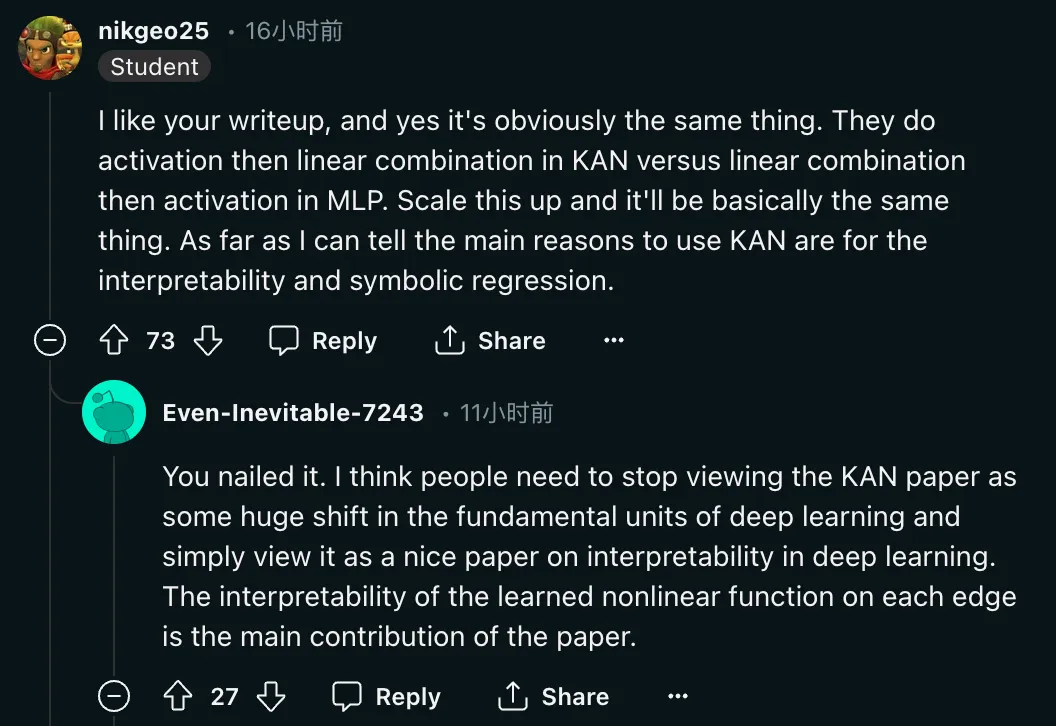

"네, 그건 분명히 똑같습니다. KAN에서는 활성화를 먼저 한 다음 선형 조합을 수행하는 반면, MLP에서는 선형 조합을 먼저 수행한 다음 활성화를 수행합니다. 증폭시키세요. 기본적으로는 똑같습니다. 제가 아는 한, KAN을 사용하는 주된 이유는 해석 가능성과 상징적 회귀입니다. "연구원들은 방법에 대한 의문 외에도 이 논문의 평가 반환을 요구했습니다. 이유:

“사람들이 생각하는 것 같습니다. KAN 논문을 딥 러닝의 기본 단위에 대한 큰 변화로 생각하는 것을 멈추고, 모든 에지에서 학습하기 위한 좋은 논문으로 생각해야 합니다. 비선형 함수의 해석 가능성이 이 논문의 주요 기여입니다. .”

“사람들이 생각하는 것 같습니다. KAN 논문을 딥 러닝의 기본 단위에 대한 큰 변화로 생각하는 것을 멈추고, 모든 에지에서 학습하기 위한 좋은 논문으로 생각해야 합니다. 비선형 함수의 해석 가능성이 이 논문의 주요 기여입니다. .”

셋째, 일부 연구자들은 KAN의 아이디어가 새로운 것이 아니라고 말했습니다.

"사람들은 1980년대에 이것을 연구하고 있었습니다. 해커 뉴스 토론에서 이 문제를 논의한 이탈리아 논문이 언급되었습니다. 따라서 이것은 전혀 새로운 것이 아닙니다. 40년 후, 이것은 다시 돌아오거나 거부된 것입니다.

하지만 KAN 논문의 저자들도 이 문제를 얼버무리지 않았음을 알 수 있습니다.

하지만 KAN 논문의 저자들도 이 문제를 얼버무리지 않았음을 알 수 있습니다.

“이 아이디어는 새로운 것이 아니지만 저자가 그것을 부끄러워하는 것 같지는 않습니다. 그는 모든 것을 멋지게 포장하고 장난감 데이터에 대한 멋진 실험을 했습니다. "

동시에 10여 년 전 Ian Goodfellow와 Yoshua Bengio의 논문 MaxOut(https://arxiv.org/pdf/1302.4389)도 언급되었습니다. 일부 연구자들은 두 가지가 "약간의 차이는 있지만, 생각이 좀 비슷해요.”

저자: 원래 연구 목표는 그야말로 해석 가능성이었습니다

열띤 토론 끝에 저자 중 한 명인 Sachin Vaidya가 나왔습니다.

이 논문의 저자 중 한 사람으로서 몇 마디 말씀드리고 싶습니다. KAN이 받고 있는 관심은 놀랍습니다. 이 토론은 신기술을 한계까지 밀어붙이고 무엇이 효과가 있고 무엇이 효과가 없는지 알아내는 데 꼭 필요한 것입니다.

동기 부여에 대한 배경 지식을 공유해야겠다고 생각했습니다. KAN을 구현하기 위한 우리의 주요 아이디어는 물리학자들이 자연법칙에 대해 발견한 통찰력을 "학습"할 수 있는 해석 가능한 AI 모델을 찾는 것에서 비롯됩니다. 따라서 다른 사람들이 깨달은 것처럼 전통적인 블랙박스 모델은 과학의 근본적인 발견에 중요한 통찰력을 제공할 수 없기 때문에 우리는 이 목표에 전적으로 집중하고 있습니다. 그런 다음 물리학 및 수학과 관련된 예를 통해 KAN이 해석 가능성 측면에서 기존 방법보다 훨씬 뛰어난 성능을 보여줍니다. 우리는 KAN의 유용성이 초기 동기를 훨씬 넘어 확장되기를 바랍니다.

동기 부여에 대한 배경 지식을 공유해야겠다고 생각했습니다. KAN을 구현하기 위한 우리의 주요 아이디어는 물리학자들이 자연법칙에 대해 발견한 통찰력을 "학습"할 수 있는 해석 가능한 AI 모델을 찾는 것에서 비롯됩니다. 따라서 다른 사람들이 깨달은 것처럼 전통적인 블랙박스 모델은 과학의 근본적인 발견에 중요한 통찰력을 제공할 수 없기 때문에 우리는 이 목표에 전적으로 집중하고 있습니다. 그런 다음 물리학 및 수학과 관련된 예를 통해 KAN이 해석 가능성 측면에서 기존 방법보다 훨씬 뛰어난 성능을 보여줍니다. 우리는 KAN의 유용성이 초기 동기를 훨씬 넘어 확장되기를 바랍니다.

GitHub 홈페이지에서 논문 저자 중 한 명인 Liu Ziming도 이 연구에 대한 평가에 다음과 같이 답변했습니다.

최근 제가 받은 가장 일반적인 질문은 KAN이 차세대가 될 것인가 하는 것입니다. LLM의. 이에 대해서는 명확한 판단이 없습니다.

KAN은 높은 정확성과 해석 가능성을 중시하는 애플리케이션을 위해 설계되었습니다. 우리는 LLM의 해석 가능성에 관심을 갖고 있지만 해석 가능성은 LLM과 과학에 있어 매우 다른 의미를 가질 수 있습니다. LLM의 높은 정확도에 관심이 있습니까? 스케일링 법칙은 그렇게 암시하는 것처럼 보이지만 아마도 매우 정확하지는 않을 것입니다. 게다가 정확성은 LLM과 과학에 있어 다른 의미를 가질 수도 있습니다.

KAN을 비판하는 사람들을 환영합니다. 진실을 테스트하는 유일한 기준은 실천입니다. 실제로 시도해보고 성공 또는 실패로 입증될 때까지 우리가 미리 알지 못하는 것들이 많이 있습니다. KAN이 성공하는 모습을 보고 싶지만 KAN의 실패도 궁금합니다.

KAN과 MLP는 각각 어떤 경우에는 장점이 있고 어떤 경우에는 한계가 있습니다. 나는 두 가지를 모두 포괄하는 이론적 틀에 관심이 있고 어쩌면 새로운 대안을 제시할 수도 있습니다(물리학자들은 통일 이론을 좋아합니다. 죄송합니다).

KAN 논문의 첫 번째 저자는 Liu Ziming입니다. 그는 물리학자이자 기계 학습 연구원이며 현재 Max Tegmark 산하의 MIT와 IAIFI에서 3년차 박사 과정을 밟고 있습니다. 그의 연구 관심분야는 인공지능과 물리학의 교차점이다.

위 내용은 폭발 후 반전? '하룻밤 만에 MLP 죽였다' KAN : 사실 나도 MLP다의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7488

7488

15

15

1377

1377

52

52

77

77

11

11

51

51

19

19

19

19

40

40

H5 프로젝트를 실행하는 방법

Apr 06, 2025 pm 12:21 PM

H5 프로젝트를 실행하는 방법

Apr 06, 2025 pm 12:21 PM

H5 프로젝트를 실행하려면 다음 단계가 필요합니다. Web Server, Node.js, 개발 도구 등과 같은 필요한 도구 설치. 개발 환경 구축, 프로젝트 폴더 작성, 프로젝트 초기화 및 코드 작성. 개발 서버를 시작하고 명령 줄을 사용하여 명령을 실행하십시오. 브라우저에서 프로젝트를 미리보고 개발 서버 URL을 입력하십시오. 프로젝트 게시, 코드 최적화, 프로젝트 배포 및 웹 서버 구성을 설정하십시오.

부트 스트랩 사진 중앙에 Flexbox를 사용해야합니까?

Apr 07, 2025 am 09:06 AM

부트 스트랩 사진 중앙에 Flexbox를 사용해야합니까?

Apr 07, 2025 am 09:06 AM

부트 스트랩 사진을 중심으로하는 방법에는 여러 가지가 있으며 Flexbox를 사용할 필요가 없습니다. 수평으로 만 중심으로 만 있으면 텍스트 중심 클래스가 충분합니다. 수직 또는 여러 요소를 중심으로 해야하는 경우 Flexbox 또는 그리드가 더 적합합니다. Flexbox는 호환성이 떨어지고 복잡성을 증가시킬 수 있지만 그리드는 더 강력하고 학습 비용이 더 높습니다. 방법을 선택할 때는 장단점을 평가하고 필요와 선호도에 따라 가장 적합한 방법을 선택해야합니다.

H5 페이지 생산에는 지속적인 유지 보수가 필요합니까?

Apr 05, 2025 pm 11:27 PM

H5 페이지 생산에는 지속적인 유지 보수가 필요합니까?

Apr 05, 2025 pm 11:27 PM

코드 취약점, 브라우저 호환성, 성능 최적화, 보안 업데이트 및 사용자 경험 개선과 같은 요소로 인해 H5 페이지를 지속적으로 유지해야합니다. 효과적인 유지 관리 방법에는 완전한 테스트 시스템 설정, 버전 제어 도구 사용, 페이지 성능을 정기적으로 모니터링하고 사용자 피드백 수집 및 유지 관리 계획을 수립하는 것이 포함됩니다.

혼자서 H5 페이지를 만드는 방법을 배울 수 있습니까?

Apr 06, 2025 am 06:36 AM

혼자서 H5 페이지를 만드는 방법을 배울 수 있습니까?

Apr 06, 2025 am 06:36 AM

자기 연구 H5 페이지 제작은 가능하지만 빠른 성공은 아닙니다. 디자인, 프론트 엔드 개발 및 백엔드 상호 작용 로직을 포함하는 HTML, CSS 및 JavaScript 마스터 링이 필요합니다. 연습은 핵심이며, 튜토리얼을 작성하고, 자료를 검토하고, 오픈 소스 프로젝트에 참여하여 배우십시오. 성능 최적화도 중요하며 이미지 최적화, HTTP 요청을 줄이고 적절한 프레임 워크를 사용해야합니다. 자기 학습으로가는 길은 길고 지속적인 학습과 의사 소통이 필요합니다.

부트 스트랩 목록의 크기를 변경하는 방법은 무엇입니까?

Apr 07, 2025 am 10:45 AM

부트 스트랩 목록의 크기를 변경하는 방법은 무엇입니까?

Apr 07, 2025 am 10:45 AM

부트 스트랩 목록의 크기는 목록 자체가 아니라 목록이 포함 된 컨테이너의 크기에 따라 다릅니다. Bootstrap의 그리드 시스템 또는 Flexbox를 사용하면 컨테이너의 크기를 제어하여 목록 항목을 간접적으로 크기로 조정할 수 있습니다.

CSS에서 요소를 회전시켜 수평 옵션의 수평 스크롤 효과를 달성하는 방법은 무엇입니까?

Apr 05, 2025 pm 10:51 PM

CSS에서 요소를 회전시켜 수평 옵션의 수평 스크롤 효과를 달성하는 방법은 무엇입니까?

Apr 05, 2025 pm 10:51 PM

CSS에서 수평 옵션의 수평 스크롤 효과를 달성하는 방법은 무엇입니까? 현대적인 웹 디자인에서 수평 탭과 같은 효과를 얻고 마우스를 지원하는 방법 ...

부트 스트랩 용 컨테이너의 이미지를 중앙을 중앙으로 중앙으로 만드는 방법

Apr 07, 2025 am 09:12 AM

부트 스트랩 용 컨테이너의 이미지를 중앙을 중앙으로 중앙으로 만드는 방법

Apr 07, 2025 am 09:12 AM

개요 : Bootstrap을 사용하여 이미지를 중앙으로 중앙에있는 방법에는 여러 가지가 있습니다. 기본 방법 : MX-AUTO 클래스를 사용하여 수평으로 중심하십시오. IMG-Fluid 클래스를 사용하여 부모 컨테이너에 적응하십시오. D- 블록 클래스를 사용하여 이미지를 블록 레벨 요소 (수직 센터링)로 설정하십시오. 고급 방법 : Flexbox 레이아웃 : 정당화 컨텐츠 중심 및 정렬 중심 센터 속성을 사용하십시오. 그리드 레이아웃 : 장소 항목을 사용하십시오 : 중앙 속성. 모범 사례 : 불필요한 중첩 및 스타일을 피하십시오. 프로젝트에 가장 적합한 방법을 선택하십시오. 코드의 유지 관리 가능성에주의를 기울이고 흥분을 추구하기 위해 코드 품질을 희생하지 마십시오.

부트 스트랩이 수정 된 후 결과를 보는 방법

Apr 07, 2025 am 10:03 AM

부트 스트랩이 수정 된 후 결과를 보는 방법

Apr 07, 2025 am 10:03 AM

수정 된 부트 스트랩 결과를보기위한 단계 : Bootstrap 파일이 올바르게 참조되도록 브라우저에서 직접 HTML 파일을 엽니 다. 브라우저 캐시를 지우십시오 (Ctrl Shift R). CDN을 사용하는 경우 개발자 도구에서 CSS를 직접 수정하여 효과를 실시간으로 볼 수 있습니다. 부트 스트랩 소스 코드를 수정 한 경우 로컬 파일을 다운로드하여 교체하거나 Webpack과 같은 빌드 도구를 사용하여 빌드 명령을 다시 실행하십시오.