集群间 Hive 数据 迁移 问题

1、 从hive中导出数据至本地目录 insert overwrite local directory /export/tmp select * from test1 where create_time = 2013-11-25; 列数据之间默认以^A隔开。 2、将本地数据上传另一个集群的hdfs /home/q/hadoop-2.2.0/bin/hdfs dfs -put /export/tmp hd

1、 从hive中导出数据至本地目录 insert overwrite local directory '/export/tmp' select * from test1 where create_time = '2013-11-25'; 列数据之间默认以^A隔开。 2、将本地数据上传另一个集群的hdfs /home/q/hadoop-2.2.0/bin/hdfs dfs -put /export/tmp hdfs://host:port/tmp 3、将hdfs中的数据文件导入hive表中 hive -e "load data inpath '/tmp' into table test1;" 但某些表创建时,设置的以 '\t' 分割数据,在读取不到 '\t' 时,会将整行数据都导入第一列。 如果是hive-0.11.0版本,可以这样导出:

hive> insert overwrite local directory '/export/tmp'

hive> row format delimited

hive> fields terminated by '\t'

hive> select * from test1 where create_time = '2013-11-25';

如果是低版本的hive,只好将导出的数据文件中的^A,替换为'\t':

sed -i 's/^A/\t/g' filename

同时需要将隐藏的.filename.crc校验文件删除掉,不然在上传的过程中,Hadoop将通过FSInputChecker判断需要上传的文件是否存在进行校验的crc文件,即.filename.crc,如果存在crc文件,将会对其内容一致性进行校验,如果校验 失败,会报fs.FSInputChecker: Found checksum error,停止上传该文件,最终导致整个MR任务无法执行。

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Gunakan ddrescue untuk memulihkan data pada Linux

Mar 20, 2024 pm 01:37 PM

Gunakan ddrescue untuk memulihkan data pada Linux

Mar 20, 2024 pm 01:37 PM

DDREASE ialah alat untuk memulihkan data daripada fail atau peranti sekat seperti cakera keras, SSD, cakera RAM, CD, DVD dan peranti storan USB. Ia menyalin data dari satu peranti blok ke peranti lain, meninggalkan blok data yang rosak dan hanya memindahkan blok data yang baik. ddreasue ialah alat pemulihan yang berkuasa yang automatik sepenuhnya kerana ia tidak memerlukan sebarang gangguan semasa operasi pemulihan. Selain itu, terima kasih kepada fail peta ddasue, ia boleh dihentikan dan disambung semula pada bila-bila masa. Ciri-ciri utama lain DDREASE adalah seperti berikut: Ia tidak menimpa data yang dipulihkan tetapi mengisi jurang sekiranya pemulihan berulang. Walau bagaimanapun, ia boleh dipotong jika alat itu diarahkan untuk melakukannya secara eksplisit. Pulihkan data daripada berbilang fail atau blok kepada satu

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

0. Apakah fungsi artikel ini? Kami mencadangkan DepthFM: model anggaran kedalaman monokular generatif yang serba boleh dan pantas. Sebagai tambahan kepada tugas anggaran kedalaman tradisional, DepthFM juga menunjukkan keupayaan terkini dalam tugas hiliran seperti mengecat kedalaman. DepthFM cekap dan boleh mensintesis peta kedalaman dalam beberapa langkah inferens. Mari kita baca karya ini bersama-sama ~ 1. Tajuk maklumat kertas: DepthFM: FastMonocularDepthEstimationwithFlowMatching Pengarang: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Cara memindahkan sejarah sembang WeChat ke telefon baharu

Mar 26, 2024 pm 04:48 PM

Cara memindahkan sejarah sembang WeChat ke telefon baharu

Mar 26, 2024 pm 04:48 PM

1. Buka aplikasi WeChat pada peranti lama, klik [Saya] di penjuru kanan sebelah bawah, pilih fungsi [Settings] dan klik [Chat]. 2. Pilih [Chat History Migration and Backup], klik [Migrate], dan pilih platform yang anda ingin pindahkan peranti. 3. Klik [Pilih sembang untuk dipindahkan], klik [Pilih semua] di penjuru kiri sebelah bawah, atau pilih rekod sembang sendiri. 4. Selepas memilih, klik [Mula] di sudut kanan bawah untuk log masuk ke akaun WeChat ini menggunakan peranti baharu. 5. Kemudian imbas kod QR untuk mula memindahkan rekod sembang Pengguna hanya perlu menunggu pemindahan selesai.

Bagaimana untuk mendapatkan emotikon mesej peribadi Douyin di WeChat? Bagaimana untuk mengeksport pakej emotikon mesej peribadi?

Mar 21, 2024 pm 10:01 PM

Bagaimana untuk mendapatkan emotikon mesej peribadi Douyin di WeChat? Bagaimana untuk mengeksport pakej emotikon mesej peribadi?

Mar 21, 2024 pm 10:01 PM

Dengan peningkatan berterusan media sosial, Douyin, sebagai platform video pendek yang popular, telah menarik sejumlah besar pengguna. Di Douyin, pengguna bukan sahaja boleh menunjukkan kehidupan mereka tetapi juga berinteraksi dengan pengguna lain. Dalam interaksi ini, emotikon secara beransur-ansur menjadi cara yang penting untuk pengguna meluahkan emosi mereka. 1. Bagaimana untuk mendapatkan emotikon mesej peribadi Douyin di WeChat? Pertama sekali, untuk mendapatkan emotikon mesej peribadi pada platform Douyin, anda perlu log masuk ke akaun Douyin anda, kemudian semak imbas dan pilih emotikon yang anda suka. Anda boleh memilih untuk menghantarnya kepada rakan atau mengumpulnya sendiri. Selepas menerima pakej emotikon pada Douyin, anda boleh menekan lama pakej emotikon melalui antara muka mesej peribadi, dan kemudian pilih fungsi "Tambah ke Emotikon". Dengan cara ini, anda boleh menambahkan pakej emotikon ini pada pustaka emotikon Douyin. 3. Seterusnya, kita perlu menambah perkataan dalam perpustakaan emotikon Douyin

Google gembira: prestasi JAX mengatasi Pytorch dan TensorFlow! Ia mungkin menjadi pilihan terpantas untuk latihan inferens GPU

Apr 01, 2024 pm 07:46 PM

Google gembira: prestasi JAX mengatasi Pytorch dan TensorFlow! Ia mungkin menjadi pilihan terpantas untuk latihan inferens GPU

Apr 01, 2024 pm 07:46 PM

Prestasi JAX, yang dipromosikan oleh Google, telah mengatasi Pytorch dan TensorFlow dalam ujian penanda aras baru-baru ini, menduduki tempat pertama dalam 7 penunjuk. Dan ujian tidak dilakukan pada TPU dengan prestasi JAX terbaik. Walaupun dalam kalangan pembangun, Pytorch masih lebih popular daripada Tensorflow. Tetapi pada masa hadapan, mungkin lebih banyak model besar akan dilatih dan dijalankan berdasarkan platform JAX. Model Baru-baru ini, pasukan Keras menanda aras tiga hujung belakang (TensorFlow, JAX, PyTorch) dengan pelaksanaan PyTorch asli dan Keras2 dengan TensorFlow. Pertama, mereka memilih satu set arus perdana

Kelajuan Internet Data Selular Perlahan pada iPhone: Pembetulan

May 03, 2024 pm 09:01 PM

Kelajuan Internet Data Selular Perlahan pada iPhone: Pembetulan

May 03, 2024 pm 09:01 PM

Menghadapi ketinggalan, sambungan data mudah alih perlahan pada iPhone? Biasanya, kekuatan internet selular pada telefon anda bergantung pada beberapa faktor seperti rantau, jenis rangkaian selular, jenis perayauan, dsb. Terdapat beberapa perkara yang boleh anda lakukan untuk mendapatkan sambungan Internet selular yang lebih pantas dan boleh dipercayai. Betulkan 1 – Paksa Mulakan Semula iPhone Kadangkala, paksa memulakan semula peranti anda hanya menetapkan semula banyak perkara, termasuk sambungan selular. Langkah 1 – Hanya tekan kekunci naikkan kelantangan sekali dan lepaskan. Seterusnya, tekan kekunci Turun Kelantangan dan lepaskannya semula. Langkah 2 - Bahagian seterusnya proses adalah untuk menahan butang di sebelah kanan. Biarkan iPhone selesai dimulakan semula. Dayakan data selular dan semak kelajuan rangkaian. Semak semula Betulkan 2 – Tukar mod data Walaupun 5G menawarkan kelajuan rangkaian yang lebih baik, ia berfungsi lebih baik apabila isyarat lemah

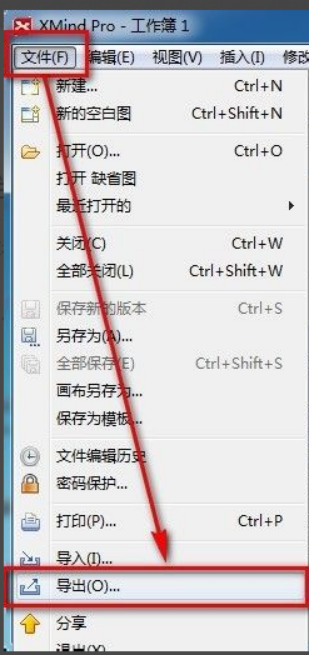

Bagaimana untuk mengeksport fail xmind ke fail pdf

Mar 20, 2024 am 10:30 AM

Bagaimana untuk mengeksport fail xmind ke fail pdf

Mar 20, 2024 am 10:30 AM

xmind adalah perisian pemetaan minda yang sangat praktikal Ia adalah bentuk peta yang dibuat menggunakan pemikiran dan inspirasi orang Selepas kami membuat fail xmind, kami biasanya menukarnya ke dalam format fail pdf untuk memudahkan penyebaran dan penggunaan semua orang ke fail pdf? Di bawah adalah langkah-langkah khusus untuk rujukan anda. 1. Mula-mula, mari kita tunjukkan cara mengeksport peta minda ke dokumen PDF. Pilih butang fungsi [Fail]-[Eksport]. 2. Pilih [dokumen PDF] dalam antara muka yang baru muncul dan klik butang [Seterusnya]. 3. Pilih tetapan dalam antara muka eksport: saiz kertas, orientasi, resolusi dan lokasi penyimpanan dokumen. Selepas melengkapkan tetapan, klik butang [Selesai]. 4. Jika anda klik butang [Selesai].

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Saya menangis hingga mati. Dunia sedang membina model besar. Data di Internet tidak mencukupi. Model latihan kelihatan seperti "The Hunger Games", dan penyelidik AI di seluruh dunia bimbang tentang cara memberi makan data ini kepada pemakan yang rakus. Masalah ini amat ketara dalam tugas berbilang modal. Pada masa mereka mengalami kerugian, pasukan pemula dari Jabatan Universiti Renmin China menggunakan model baharu mereka sendiri untuk menjadi yang pertama di China untuk menjadikan "suapan data yang dijana model itu sendiri" menjadi kenyataan. Selain itu, ia merupakan pendekatan serampang dua mata dari segi pemahaman dan sisi penjanaan Kedua-dua pihak boleh menjana data baharu berbilang modal yang berkualiti tinggi dan memberikan maklum balas data kepada model itu sendiri. Apakah model? Awaker 1.0, model berbilang modal besar yang baru sahaja muncul di Forum Zhongguancun. Siapa pasukan itu? Enjin Sophon. Diasaskan oleh Gao Yizhao, pelajar kedoktoran di Sekolah Kecerdasan Buatan Hillhouse Universiti Renmin.