百度高级架构师马如悦:我的Hadoop 2.0

当计算任务越来越多,作业提交越来越多,企业普通的做法是,在原有的系统架构上,不停地往上堆积硬件或者加服务器。的确,hadoop设计上的优秀和可扩展性可以方便的让集群管理员对集群增删机器,所以当集群计算资源紧缺,又有空闲的机器可用时,集群管理员很

当计算任务越来越多,作业提交越来越多,企业普通的做法是,在原有的系统架构上,不停地往上堆积硬件或者加服务器。的确,hadoop设计上的优秀和可扩展性可以方便的让集群管理员对集群增删机器,所以当集群计算资源紧缺,又有空闲的机器可用时,集群管理员很容易想到给集群加机器来解决这个问题,因为集群的计算槽位增多了,Jobtracker能调度的槽位也多了,集群里能并行的map数和reduce数也增多了。

但是,当集群规模扩大到一定程度,比如3000台,再往上加机器,用户会发现,计算作业没有增多,本应该运行的更快的作业并没有比预期的快,有时候甚至跟加机器前跑的一样,集群的槽位是变多了,但是被调度用来跑 task的槽位总是用不满,jobtracker的cpu使用率始终保持100%,但是集群的计算槽位总是达不到饱和,即使集群在最繁忙的时候,槽位的使用率也只能达到比如60%,每一个时刻总有一部分的计算槽位是空闲的但是无法往上分配task任务。

这是雅虎Hadoop当前正面临的问题,Hadoop下一步在哪?百度的Hadoop架构又当如何扩展?这是摆在所有人面前的一个重要问题。

在CSDN 第九期的TUP活动上,百度的高级架构师马如悦为广大的CTO、技术主管们分析了百度的Hadoop 2.0,并就Hadoop在百度的未来发展作了精彩的陈述。

百度高级系统架构师马如悦

百度hadoop集群现状

据马如悦透露,百度从07年开始使用Hadoop做离线处理,目前有80%的Hadoop集群用作日志处理,同雅虎面临的相同麻烦是,Hadoop在百度经过5、6年发展之后,也已经走到了一个岔路口,在百度每天的作业数千万,平均一个作业可以按1000来算,每天的数据处理量在6TB左右,以Hadoop目前所能支持的服务器性能上限来看,大大低于了系统的需求。

他表示,“目前百度的Hadoop服务器规模是1万多台,已经超过了Yahoo和Facebook,明年计划将达到2万台。以百度目前如果的Hadoop服务器配置来看,12GB内存最大能支持3000多万系统文件,如果扩张到10亿文件,内存将占用380GB。”

目前百度的服务器大部分是价格在两到三万元左右的,标配12个1TB硬盘,32GB内存,没有RAID卡,没有采用高端的服务器。但是随着Hadoop集群规模扩张后,成本正呈线性上升,能耗、散热、还有一些不需要的设备,都是需要解决的成本问题。因此百度这几年一直在走服务器定制化的路线,以此降低整个系统成本。

百度Hadoop 2.0解决方案

实际上,Yahoo最近已经公开了一篇博客,关于Hadoop重构的问题,在博客中,雅虎写道,集群的规模达到4000台机器的时候,Hadoop正遭遇到扩展性的瓶颈,MapReduce的JobTracker需要彻底改革,以解决其可扩展性,内存消耗,线程模型,可靠性和性能的几个缺陷。

而百度也在对其Hadoop集群进行技术革新,马如悦称其为Hadoop 2.0。

“百度的目标是10万节点,而且需要充分考虑跨机房部署的问题”,他表示“百度和雅虎在Hadoop上的研发区别在于,雅虎需要不断对Hadoop的扩展上限进行研发,而百度的研发着力点在于如果已经到了规模上限,那么需要进行拆分。”

马如悦谈到,Hadoop2.0主要是解决Hadoop主节点的Scalability的问题。Scalability现在的问题,有3000多万文件,内存占用12GB。如果扩张10亿文件,内存占用380GB。负载的话,集群规模扩大后,这种压力是3000台左右。

“存储一般分为块式存储,做云计算公司挂在一些虚拟机,挂到本地作为本地系统。上面还有分布式对象存储,很多用来存储像淘宝图片都是用分布式对象去存储。上面是分布式文件系统可以做很多工作,用户应用起来会好很多,但是他的扩展性会差很多。”

“将存储设备拆分成两层进行分别管理”,马如悦说道“这是Hadoop 2.0解决方案的理论原理。为了解决Hadoop的扩展性问题,在数据存储上,百度专门设立了一个对账管理层,目的在于将文件对象管理服务做到水平扩展,当某一用户将数据放在上面后可以给一个唯一标识,用户可以有自己的选择,“对账管理层的关键在于文件对象管理服务可以实现水平扩展,但难点在于扩展性的问题”。

他表示,在此架构中,由于NameSpace(名称空间)全在文件对象管理中,因此到逻辑对象中的负载降了很多,这就很便于做未来的扩展性设计。

1、分布式存储对象是S3,这是没有树状结构的NameSpace,二层命名空间从kb到GB都可以实现支持,这是百度线上评估的负载,内存10亿文件,10亿快文件约66GB,目录约1GB。

2、原来90GB只能支持1亿文件,而现在66GB可以支持到10亿文件

3、大规模耗能操作放到了对象管理层之上,因为是水平扩展,所以压力不大。

4、Namespace只占容量的13.7%。

Hadoop并非万能

在马如悦看来,业界对于分布式存储架构还存在着一些误区,比如,大家通常认为Hadoop集群规模越大越好。

“Hadoop集群规模不是越大越好,Mapreduce的好处在于共享,资源利用充分,但实现的前提在于底层的HDFS副本的放置策略,目前来看,Hadoop的放置策略不是很好。1000台机器,如果同时宕掉三台,一定会有副本丢失,这是Hadoop不好的地方,如果从1000台服务器中挑选三台机器,会发现相同的块有三四个。这是HDFS不好的地方。”

“如果将1000台服务器分成十组,每组100台机器,建议用户不要将数据分布于所有机器上”,马如悦表示,“100台就可以满足副本文件的存储需求。如果三个机器放到任何一个组里都不会丢数据。但是对百度来说,一旦真的丢失数据——10G、20G问题都差不多,一样严重。平常三个副本宕机正好撞到在一个小组的几率毕竟很少,因此,Hadoop现有放置副本不是最好,假设放置均匀库,理想中放置副本是需要要随机放置的。”

而Hadoop目前另一个缺陷在于数据的层次化管理,很多数据读取很高,写入却很小,因此对数据的时效性要求很高,并且要求能海量处理几PB的数据,这是Hadoop目前不太容易实现的。

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1371

1371

52

52

2 bulan kemudian, robot humanoid Walker S boleh melipat pakaian

Apr 03, 2024 am 08:01 AM

2 bulan kemudian, robot humanoid Walker S boleh melipat pakaian

Apr 03, 2024 am 08:01 AM

Editor Laporan Kuasa Mesin: Wu Xin Versi domestik robot humanoid + pasukan model besar menyelesaikan tugas operasi bahan fleksibel yang kompleks seperti melipat pakaian buat kali pertama. Dengan pelancaran Figure01, yang mengintegrasikan model besar berbilang modal OpenAI, kemajuan berkaitan rakan domestik telah menarik perhatian. Baru semalam, UBTECH, "stok robot humanoid nombor satu" China, mengeluarkan demo pertama robot humanoid WalkerS yang disepadukan secara mendalam dengan model besar Baidu Wenxin, menunjukkan beberapa ciri baharu yang menarik. Kini, WalkerS, diberkati oleh keupayaan model besar Baidu Wenxin, kelihatan seperti ini. Seperti Rajah01, WalkerS tidak bergerak, tetapi berdiri di belakang meja untuk menyelesaikan satu siri tugasan. Ia boleh mengikut perintah manusia dan melipat pakaian

Apakah seni bina dan prinsip kerja Spring Data JPA?

Apr 17, 2024 pm 02:48 PM

Apakah seni bina dan prinsip kerja Spring Data JPA?

Apr 17, 2024 pm 02:48 PM

SpringDataJPA adalah berdasarkan seni bina JPA dan berinteraksi dengan pangkalan data melalui pemetaan, ORM dan pengurusan transaksi. Repositorinya menyediakan operasi CRUD, dan pertanyaan terbitan memudahkan akses pangkalan data. Selain itu, ia menggunakan pemuatan malas untuk hanya mendapatkan semula data apabila perlu, sekali gus meningkatkan prestasi.

DeepSeek Web Versi Pintu Masuk Laman Web Rasmi DeepSeek

Feb 19, 2025 pm 04:54 PM

DeepSeek Web Versi Pintu Masuk Laman Web Rasmi DeepSeek

Feb 19, 2025 pm 04:54 PM

DeepSeek adalah alat carian dan analisis pintar yang kuat yang menyediakan dua kaedah akses: versi web dan laman web rasmi. Versi web adalah mudah dan cekap, dan boleh digunakan tanpa pemasangan; Sama ada individu atau pengguna korporat, mereka dapat dengan mudah mendapatkan dan menganalisis data besar-besaran melalui DeepSeek untuk meningkatkan kecekapan kerja, membantu membuat keputusan dan menggalakkan inovasi.

Seberapa curam keluk pembelajaran seni bina rangka kerja golang?

Jun 05, 2024 pm 06:59 PM

Seberapa curam keluk pembelajaran seni bina rangka kerja golang?

Jun 05, 2024 pm 06:59 PM

Keluk pembelajaran seni bina rangka kerja Go bergantung pada kebiasaan dengan bahasa Go dan pembangunan bahagian belakang serta kerumitan rangka kerja yang dipilih: pemahaman yang baik tentang asas bahasa Go. Ia membantu untuk mempunyai pengalaman pembangunan bahagian belakang. Rangka kerja yang berbeza dalam kerumitan membawa kepada perbezaan dalam keluk pembelajaran.

Pengenalan kepada cara mendapatkan Kerang Baidu Xiyang

Mar 28, 2024 am 09:11 AM

Pengenalan kepada cara mendapatkan Kerang Baidu Xiyang

Mar 28, 2024 am 09:11 AM

Terdapat ramai pengguna di Xirang yang tidak tahu di mana cengkerang berada dan cara mendapatkannya Beberapa pemain telah mencari selama beberapa jam tetapi masih tidak menemuinya Di bawah, editor akan membawa anda cara mendapatkan cengkerang Baidu Xirang Datang dan lihat. Bagaimana untuk mendapatkan Baidu Xirang Shell 1. Mula-mula kita perlu datang ke komuniti, dan kemudian datang ke lokasi dalam gambar di bawah. 2. Pilih destinasi di sini dan pilih untuk memasuki tingkat 188. 3. Selepas memasuki tingkat 188, anda akan melihat gesaan ini apabila berjalan-jalan. Hanya klik I Got It. 4. Lokasi cangkerang mungkin agak sukar dicari Di belakang lif 188, terdapat titik kecil bercahaya iaitu cangkerang. 5. Anda perlu menggunakan pengawal VR untuk mengambil cengkerang. Hanya klik pada cangkerang. Kaedah penebusan 1. Mula-mula klik ikon "Tetapan" di penjuru kanan sebelah atas halaman dan pilih "

Baidu Apollo mengeluarkan Apollo ADFM, model besar pertama di dunia yang menyokong pemanduan autonomi L4

Jun 04, 2024 pm 08:01 PM

Baidu Apollo mengeluarkan Apollo ADFM, model besar pertama di dunia yang menyokong pemanduan autonomi L4

Jun 04, 2024 pm 08:01 PM

Pada 15 Mei, Baidu Apollo mengadakan Hari Apollo 2024 di Wuhan Baidu Carrot Auto Robot Zhixing Valley, secara menyeluruh menunjukkan kemajuan utama Baidu dalam pemanduan autonomi sepanjang sepuluh tahun yang lalu, membawa lonjakan teknologi berdasarkan model besar dan definisi baharu keselamatan penumpang rangkaian operasi kenderaan autonomi terbesar di dunia, Baidu telah menjadikan pemanduan autonomi lebih selamat daripada pemanduan manusia. Terima kasih kepada ini, kaedah perjalanan yang lebih selamat, lebih selesa, hijau dan rendah karbon bertukar daripada ideal kepada realiti. Wang Yunpeng, naib presiden Kumpulan Baidu dan presiden Kumpulan Perniagaan Pemanduan Pintar, berkata di tempat kejadian: "Niat asal kami membina kenderaan autonomi adalah untuk memuaskan keinginan orang ramai untuk perjalanan yang lebih baik. Kepuasan orang ramai adalah penggerak kami. Kerana keselamatan, Begitu cantik, kami gembira melihat

Baidu Robin Li mengetuai pasukan melawat PetroChina untuk membincangkan perisikan industri minyak dan gas

May 07, 2024 pm 06:13 PM

Baidu Robin Li mengetuai pasukan melawat PetroChina untuk membincangkan perisikan industri minyak dan gas

May 07, 2024 pm 06:13 PM

Menurut berita dari laman web ini pada 7 Mei, pada 6 Mei, Robin Li, pengasas, pengerusi dan Ketua Pegawai Eksekutif Baidu, mengetuai pasukan untuk melawat China National Petroleum Corporation (selepas ini dirujuk sebagai "PetroChina") di Beijing dan bertemu dengan pengarah Pengerusi Perbadanan Petroleum Nasional China dan Setiausaha Parti Dai Houliang mengadakan perbincangan. Kedua-dua pihak mengadakan pertukaran mendalam mengenai pengukuhan kerjasama dan menggalakkan integrasi mendalam industri tenaga dengan kecerdasan digital. PetroChina akan mempercepatkan pembinaan Perbadanan Petroleum China digital, mengukuhkan kerjasama dengan Kumpulan Baidu, menggalakkan integrasi mendalam industri tenaga dengan kecerdasan digital, dan membuat sumbangan yang lebih besar untuk memastikan keselamatan tenaga negara. Robin Li berkata bahawa "kemunculan pintar" dan keupayaan teras pemahaman, penjanaan, logik, dan ingatan yang dipaparkan oleh model besar telah membuka ruang yang lebih luas untuk imaginasi untuk gabungan teknologi termaju dan perniagaan minyak dan gas. Sentiasa

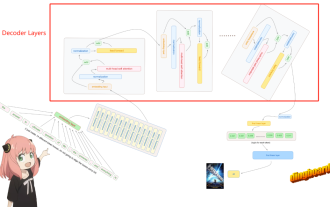

Llama3 yang mengoyak tangan lapisan 1: Melaksanakan llama3 dari awal

Jun 01, 2024 pm 05:45 PM

Llama3 yang mengoyak tangan lapisan 1: Melaksanakan llama3 dari awal

Jun 01, 2024 pm 05:45 PM

1. Seni Bina Llama3 Dalam siri artikel ini, kami melaksanakan llama3 dari awal. Keseluruhan seni bina Llama3: Gambarkan parameter model Llama3: Mari kita lihat nilai sebenar parameter ini dalam model Llama3. Gambar [1] Tetingkap konteks (tetingkap konteks) Apabila membuat instantiated kelas LlaMa, pembolehubah max_seq_len mentakrifkan tetingkap konteks. Terdapat parameter lain dalam kelas, tetapi parameter ini paling berkaitan secara langsung dengan model pengubah. Maks_seq_len di sini ialah 8K. Gambar [2] Saiz perbendaharaan kata dan PerhatianL