Pengarang kertas perbincangan ini, Wang Yulin, ialah pelajar kedoktoran langsung 2019 di Jabatan Automasi, Universiti Tsinghua. Beliau belajar di bawah Ahli Akademik Wu Cheng dan Profesor Madya Huang Gao. penglihatan komputer, dsb. Beliau telah menerbitkan kertas perbincangan sebagai pengarang pertama dalam jurnal dan persidangan seperti TPAMI, NeurIPS, ICLR, ICCV, CVPR, ECCV, dll. Beliau telah menerima Biasiswa Baidu, Microsoft Scholar, CCF-CV Academic Emerging Award, ByteDance Scholarship dan kepujian lain . Halaman utama peribadi: wyl.cool.

Artikel ini terutamanya memperkenalkan artikel yang baru sahaja diterima oleh IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI): EfficientTrain++: Pembelajaran Kurikulum Umum untuk Latihan Tulang Belakang Visual yang Cekap.

" dalam beberapa tahun kebelakangan ini, "menjadi salah satu penskalaan komputer" . Dengan peningkatan dalam saiz model dan skala data latihan, kemajuan algoritma pembelajaran, dan aplikasi meluas teknologi penyelarasan dan peningkatan data, rangkaian asas visual diperoleh melalui latihan berskala besar (seperti Vision Transformer dan MAE yang dilatih pada ImageNet1K/22K , DINOv2, dsb.) telah mencapai prestasi yang menakjubkan dalam banyak tugas visual penting seperti pengecaman visual, pengesanan sasaran dan pembahagian semantik. Walau bagaimanapun, "penskalaan" sering membawa

overhed latihan model tinggiyang melarang, yang dengan ketara menghalang pembangunan lanjut dan aplikasi industri model penglihatan asas. Untuk menyelesaikan masalah ini, pasukan penyelidik Universiti Tsinghua mencadangkan algoritma pembelajaran kurikulum umum:

EfficientTrain++. Idea teras adalah untuk mempromosikan paradigma pembelajaran kursus tradisional iaitu "menyaring dan menggunakan data daripada mudah kepada sukar, dan melatih model secara beransur-ansur" kepada "tidak menapis dimensi data, sentiasa menggunakan semua data latihan, tetapi secara beransur-ansur mendedahkan setiap ciri semasa proses latihan. " Ciri atau corak (corak) daripada mudah kepada sukar bagi setiap sampel data."

Dalam beberapa tahun kebelakangan ini, perkembangan pesat model asas berskala besar telah menggalakkan kemajuan kecerdasan buatan dan pembelajaran mendalam. Dalam bidang penglihatan komputer, kerja perwakilan seperti Vision Transformer (ViT), CLIP, SAM dan DINOv2 telah membuktikan bahawa meningkatkan saiz rangkaian saraf dan data latihan boleh mengembangkan tugas visual penting seperti kognisi, pengesanan dan segmentasi dengan ketara. sempadan prestasi.

Walau bagaimanapun, model asas yang besar selalunya mempunyai overhed latihan yang tinggi, Rajah 1 memberikan dua contoh tipikal. Mengambil lapan NVIDIA V100 atau GPU berprestasi tinggi sebagai contoh, ia akan mengambil masa bertahun-tahun atau bahkan beberapa dekad untuk menyelesaikan hanya satu sesi latihan untuk GPT-3 dan ViT-G. Kos latihan yang tinggi sedemikian adalah perbelanjaan yang besar yang sukar untuk dimiliki oleh kedua-dua ahli akademik dan industri Selalunya hanya beberapa institusi peringkat tinggi menggunakan sejumlah besar sumber untuk memajukan kemajuan pembelajaran mendalam. Oleh itu, masalah segera yang perlu diselesaikan ialah: bagaimana untuk meningkatkan kecekapan latihan model pembelajaran mendalam berskala besar secara berkesan? . proses pembelajaran Semasa proses latihan model, kami bermula dengan data latihan "paling mudah" dan secara beransur-ansur memperkenalkan data dari mudah kepada sukar. . asas visual Sebab utama kaedah umum model ialah terdapat dua kesesakan utama, seperti yang ditunjukkan dalam Rajah 3. Pertama, mereka bentuk kurikulum latihan (kurikulum) yang berkesan bukanlah mudah. Membezakan antara sampel "mudah" dan "sukar" selalunya memerlukan bantuan model pra-latihan tambahan, mereka bentuk algoritma AutoML yang lebih kompleks, memperkenalkan pembelajaran pengukuhan, dsb., dan mempunyai serba boleh yang lemah. Kedua, pemodelan pembelajaran kursus itu sendiri agak tidak munasabah. Data visual dalam pengedaran semula jadi selalunya mempunyai tahap kepelbagaian yang tinggi Contoh diberikan di bawah dalam Rajah 3 (gambar burung nuri dipilih secara rawak daripada ImageNet Data latihan model mengandungi sejumlah besar burung kakak tua dengan pergerakan yang berbeza, burung kakak tua pada jarak yang berbeza dari kamera, Burung kakak tua dari perspektif dan latar belakang yang berbeza, serta interaksi yang pelbagai antara burung kakak tua dan orang atau objek, dsb., ia sebenarnya merupakan kaedah yang agak kasar untuk membezakan data yang pelbagai itu hanya dengan penunjuk dimensi tunggal "mudah" dan "sukar". " dan kaedah pemodelan yang dibuat-buat.

Rajah 3 Dua kesesakan utama yang menghalang aplikasi pembelajaran kursus berskala besar dalam melatih model asas visual

Rajah 3 Dua kesesakan utama yang menghalang aplikasi pembelajaran kursus berskala besar dalam melatih model asas visual

2. Pengenalan Kaedah

Diinspirasikan oleh cabaran di atas, artikel ini mencadangkan paradigma pembelajaran kurikulum umum Idea teras adalah untuk "menyaring dan menggunakan data daripada mudah kepada sukar dan secara beransur-ansur melatih model" Paradigma pembelajaran kursus tradisional diperluaskan. kepada "

Diinspirasikan oleh cabaran di atas, artikel ini mencadangkan paradigma pembelajaran kurikulum umum Idea teras adalah untuk "menyaring dan menggunakan data daripada mudah kepada sukar dan secara beransur-ansur melatih model" Paradigma pembelajaran kursus tradisional diperluaskan. kepada "

", yang berkesan mengelakkan Had dan reka bentuk suboptimum yang disebabkan oleh paradigma saringan data dihapuskan, seperti yang ditunjukkan dalam Rajah 4.

Rajah 4 Pembelajaran kurikulum tradisional (dimensi sampel) vs pembelajaran kurikulum umum (dimensi ciri)

Dari perspektif domain frekuensi, "ciri frekuensi rendah" adalah "agak mudah" untuk model. Dalam Rajah 5, pengarang artikel ini melatih model DeiT-S menggunakan data latihan ImageNet-1K standard, dan menggunakan penapis laluan rendah dengan lebar jalur yang berbeza untuk menapis set pengesahan, mengekalkan hanya komponen frekuensi rendah imej pengesahan, dan melaporkan berdasarkan ini. Ketepatan DeiT-S pada data pengesahan lulus rendah semasa proses latihan Lengkung ketepatan yang diperolehi berbanding proses latihan ditunjukkan di sebelah kanan Rajah 5.

Kita dapat melihat fenomena menarik: pada peringkat awal latihan, hanya menggunakan data pengesahan ditapis lulus rendah tidak mengurangkan ketepatan dengan ketara, dan titik pemisahan antara lengkung dan ketepatan set pengesahan biasa meningkat dengan penapis lebar jalur meningkat dan beransur-ansur bergerak ke kanan. Fenomena ini menunjukkan bahawa walaupun model sentiasa mempunyai akses kepada bahagian frekuensi rendah dan tinggi dalam data latihan, proses pembelajarannya secara semula jadi bermula dengan memfokuskan hanya pada maklumat frekuensi rendah, dan keupayaan untuk mengenal pasti ciri frekuensi tinggi diperoleh secara beransur-ansur. kemudian dalam latihan (fenomena ini Untuk keterangan lanjut, sila rujuk teks asal). . model? Berikan input visual maklumat frekuensi rendah pada mulanya, dan kemudian secara beransur-ansur memperkenalkan maklumat frekuensi tinggi?

Rajah 6 menyiasat idea untuk melaksanakan penapisan laluan rendah pada data latihan hanya semasa fasa latihan awal dengan panjang tertentu, meninggalkan proses latihan yang selebihnya tidak berubah. Dapat diperhatikan daripada keputusan bahawa walaupun peningkatan prestasi akhir adalah terhad, adalah menarik untuk diperhatikan bahawa ketepatan akhir model boleh dikekalkan pada tahap yang besar walaupun hanya komponen frekuensi rendah disediakan kepada model untuk tempoh yang agak besar. tempoh fasa latihan awal, yang Ia juga bertepatan dengan pemerhatian dalam Rajah 5 bahawa "model ini memberi tumpuan terutamanya kepada pembelajaran mengenal pasti ciri frekuensi rendah pada peringkat awal latihan".

Penemuan ini memberi inspirasi kepada pengarang artikel ini untuk memikirkan tentang kecekapan latihan: Memandangkan model hanya memerlukan komponen frekuensi rendah dalam data pada peringkat awal latihan, dan komponen frekuensi rendah mengandungi kurang maklumat daripada data asal , bolehkah model memproses input asal pada kadar yang lebih cepat daripada Cekap belajar daripada komponen frekuensi rendah sahaja dengan kos pengiraan yang kurang?

Rajah 6 Menyediakan hanya komponen frekuensi rendah kepada model untuk tempoh latihan awal yang panjang tidak akan menjejaskan prestasi akhir dengan ketara

Malah, idea ini boleh dilaksanakan sepenuhnya. Seperti yang ditunjukkan di sebelah kiri Rajah 7, pengarang artikel ini memperkenalkan operasi pemangkasan dalam spektrum Fourier imej untuk memotong bahagian frekuensi rendah dan memetakannya kembali ke ruang piksel. Operasi pemangkasan frekuensi rendah ini dengan tepat mengekalkan semua maklumat frekuensi rendah sambil mengurangkan saiz input imej, jadi kos pengiraan model pembelajaran daripada input dapat dikurangkan secara eksponen.

Jika anda menggunakan operasi pemangkasan frekuensi rendah ini untuk memproses input model pada peringkat awal latihan, anda boleh menjimatkan kos latihan keseluruhan dengan ketara, tetapi masih tidak mengalami kerugian dalam prestasi kerana maklumat yang diperlukan untuk pembelajaran model adalah dikekalkan ke tahap maksimum Model akhir, keputusan eksperimen ditunjukkan di sudut kanan bawah Rajah 7.

Rajah 7 Pemotongan frekuensi rendah: Jadikan model cekap belajar hanya daripada maklumat frekuensi rendah

Selain daripada operasi domain frekuensi, dari perspektif transformasi domain spatial, model juga boleh didapati Dalam syarat ciri "agak mudah"

. Sebagai contoh, maklumat imej semula jadi yang terkandung dalam input visual mentah yang tidak mengalami peningkatan data yang kukuh atau pemprosesan herotan selalunya "lebih mudah" untuk model dan lebih mudah untuk model untuk belajar kerana ia diperoleh daripada pengedaran dunia sebenar, dan tambahan maklumat, invarian, dsb. yang diperkenalkan oleh teknik prapemprosesan seperti peningkatan data selalunya sukar untuk dipelajari oleh model (contoh biasa diberikan di sebelah kiri Rajah 8).

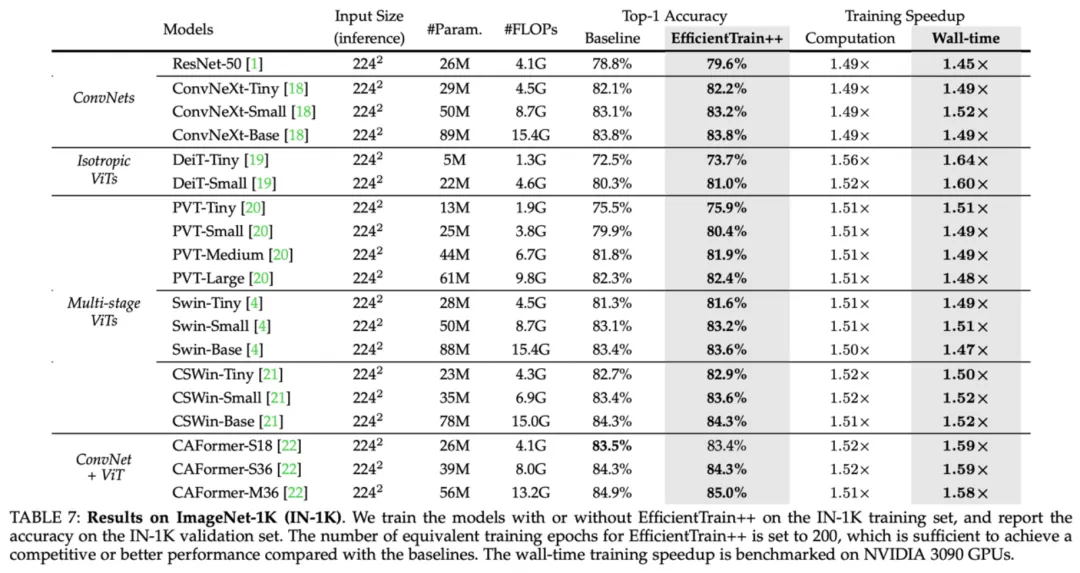

Malah, penyelidikan sedia ada juga mendapati bahawa penambahan data memainkan peranan terutamanya dalam peringkat latihan yang lebih akhir (seperti "Meningkatkan Auto-Augment melalui Perkongsian Berat Badan-Bijak Augmentasi", NeurIPS'20). Dalam dimensi ini, untuk mencapai paradigma pembelajaran kursus umum, ia boleh dicapai dengan mudah dengan hanya mengubah intensiti penambahan data untuk menyediakan model dengan hanya maklumat imej semula jadi yang lebih mudah dipelajari dalam data latihan dalam peringkat awal latihan. Bahagian kanan Rajah 8 menunjukkan idea ini menggunakan RandAugment sebagai contoh yang mewakili RandAugment mengandungi satu siri transformasi peningkatan data spatial biasa (seperti putaran rawak, perubahan ketajaman, transformasi afin, perubahan pendedahan, dll.). Boleh diperhatikan bahawa melatih model bermula daripada penambahan data yang lebih lemah boleh meningkatkan prestasi akhir model dengan berkesan, dan teknik ini serasi dengan pemangkasan frekuensi rendah. Sehingga ke tahap ini, artikel ini telah mencadangkan rangka kerja teras dan andaian kursus umum pembelajaran, dan dengan mendedahkan Dua fenomena utama dalam domain kekerapan dan domain spatial membuktikan rasionaliti dan keberkesanan pembelajaran kursus umum. Atas dasar ini, makalah ini melengkapkan lagi satu siri kerja sistematik, yang disenaraikan di bawah. Disebabkan keterbatasan ruang, sila rujuk kertas asal untuk mendapatkan butiran penyelidikan lanjut. Pelan pembelajaran kursus umum EfficientTrain++ akhirnya diperolehi dalam artikel ini ditunjukkan dalam Rajah 9. EfficientTrain++ secara dinamik melaraskan lebar jalur pemangkasan frekuensi rendah domain frekuensi dan keamatan peningkatan data domain spatial berdasarkan peratusan penggunaan daripada jumlah overhed pengkomputeran latihan model. Perlu diambil perhatian bahawa sebagai kaedah pasang dan main, EfficientTrain++ boleh digunakan secara langsung pada pelbagai rangkaian asas visual dan senario latihan model yang pelbagai tanpa pelarasan atau carian hiperparameter selanjutnya, dan kesannya agak stabil . Sebagai kaedah pasang dan main, EfficientTrain++ mengurangkan overhed latihan sebenar pelbagai rangkaian asas visual sebanyak kira-kira 1.5 kali pada ImageNet-1K tanpa kehilangan atau meningkatkan prestasi pada dasarnya. Keuntungan EfficientTrain++ adalah universal untuk belanjawan overhed latihan yang berbeza, prestasi yang lebih baik/Swin pada ImageNet Nisbah pecutan latihan pada -1K adalah kira-kira 2-3 kali. EfficientTrain++ boleh mencapai 2-3 kali prestasi tanpa kehilangan pecutan pra-latihan pada ImageNet-22k Untuk model yang lebih kecil, EfficientTrain++ boleh mencapai peningkatan prestasi yang ketara.  Rajah 8 Mencari ciri "lebih mudah dipelajari" model dari perspektif ruang udara: perspektif peningkatan data

Rajah 8 Mencari ciri "lebih mudah dipelajari" model dari perspektif ruang udara: perspektif peningkatan data

Rajah 9 Pelan pembelajaran kursus umum bersepadu dan bersepadu: EfficientTrain++

Rajah 9 Pelan pembelajaran kursus umum bersepadu dan bersepadu: EfficientTrain++ III. Keputusan percubaan

Rajah 10 Keputusan percubaan ImageNet-1K: Prestasi EfficientTrain++ pada pelbagai rangkaian asas visual

Rajah 10 Keputusan percubaan ImageNet-1K: Prestasi EfficientTrain++ pada pelbagai rangkaian asas visual  Rajah 11 Keputusan percubaan ImageNet-1K: Prestasi EfficientTrain++ di bawah belanjawan overhed latihan yang berbeza

Rajah 11 Keputusan percubaan ImageNet-1K: Prestasi EfficientTrain++ di bawah belanjawan overhed latihan yang berbeza  Rajah 12 Keputusan percubaan ImageNet-22K: Prestasi EfficientTrain++ pada data latihan berskala lebih besar

Rajah 12 Keputusan percubaan ImageNet-22K: Prestasi EfficientTrain++ pada data latihan berskala lebih besar

Atas ialah kandungan terperinci Mudah dan universal: 3 kali pecutan latihan tanpa kehilangan rangkaian asas visual, Tsinghua EfficientTrain++ dipilih untuk TPAMI 2024. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk mengikat data dalam senarai lungsur

Bagaimana untuk mengikat data dalam senarai lungsur

Peranan tag applet dalam html

Peranan tag applet dalam html

Bagaimana untuk membayar balik Douyin yang dicas semula Doucoin

Bagaimana untuk membayar balik Douyin yang dicas semula Doucoin

Apakah petua untuk menggunakan dezender?

Apakah petua untuk menggunakan dezender?

Bagaimana untuk menyelesaikan ralat aplikasi WerFault.exe

Bagaimana untuk menyelesaikan ralat aplikasi WerFault.exe

Gaya bar skrol CSS

Gaya bar skrol CSS

Mengapakah semua ikon di penjuru kanan sebelah bawah win10 muncul?

Mengapakah semua ikon di penjuru kanan sebelah bawah win10 muncul?

Pengenalan kepada perbezaan antara javascript dan java

Pengenalan kepada perbezaan antara javascript dan java