Model dunia juga tersebar! Ejen terlatih ternyata cukup bagus

Model dunia menyediakan cara untuk melatih agen pembelajaran pengukuhan dengan cara yang selamat dan cekap sampel. Baru-baru ini, model dunia kebanyakannya beroperasi pada jujukan pembolehubah pendam diskret untuk mensimulasikan dinamik persekitaran.

Walau bagaimanapun, kaedah pemampatan ini menjadi representasi diskret padat mungkin mengabaikan butiran visual yang penting untuk pembelajaran pengukuhan. Sebaliknya, model resapan telah menjadi kaedah dominan untuk penjanaan imej, menimbulkan cabaran kepada model terpendam diskret.

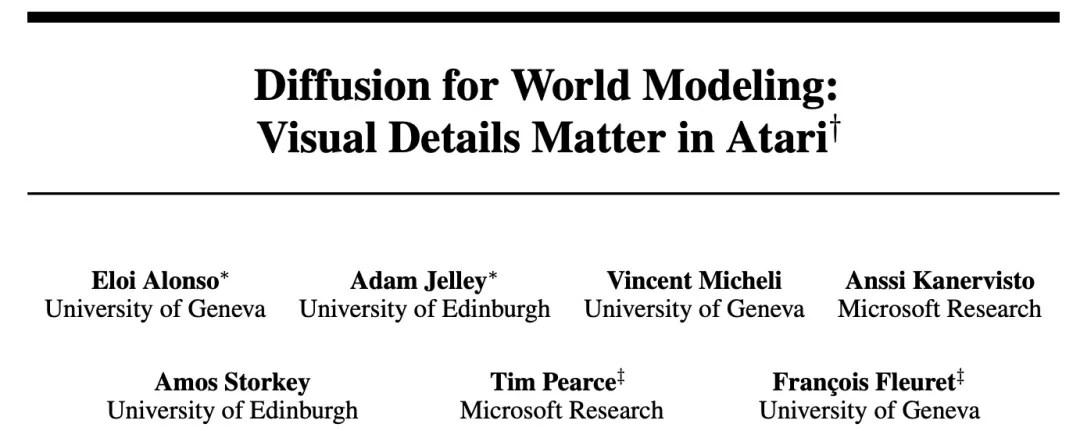

Dipromosikan oleh anjakan paradigma ini, penyelidik dari University of Geneva, University of Edinburgh, dan Microsoft Research bersama-sama mencadangkan agen pembelajaran pengukuhan yang dilatih dalam model dunia resapan - DIAMOND (DIffusion As a Model Of eNvironment Dreams ).

- Alamat kertas: https://arxiv.org/abs/2405.12399 /projek

- alamat berlian

- Tajuk kertas: Penyebaran untuk Pemodelan Dunia: Butiran Visual Penting dalam Atari

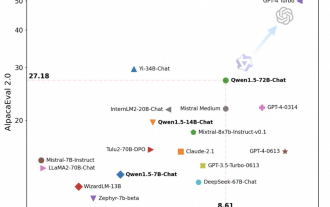

Pada penanda aras Atari 100k, DIAMOND+ mencapai Markah Purata 1H4NS6 Manusia. Ini bermakna ejen yang terlatih dalam model dunia boleh dilatih sepenuhnya di peringkat SOTA ejen terlatih dalam model dunia. Kajian ini menyediakan analisis kestabilan untuk menggambarkan bahawa pilihan reka bentuk DIAMOND adalah perlu untuk memastikan kestabilan jangka panjang yang cekap bagi model dunia penyebaran.

Selain manfaat beroperasi dalam ruang imej, ia membolehkan model dunia meresap menjadi perwakilan langsung persekitaran, sekali gus memberikan pemahaman yang lebih mendalam tentang model dunia dan tingkah laku ejen. Khususnya, kajian mendapati bahawa peningkatan prestasi dalam permainan tertentu terhasil daripada pemodelan butiran visual utama yang lebih baik.

Pengenalan Kaedah

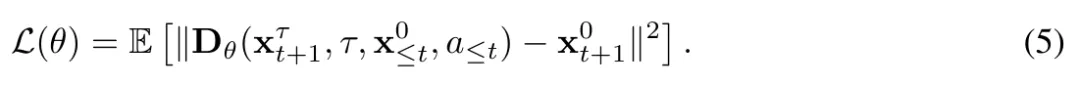

Seterusnya, artikel ini memperkenalkan DIAMOND, agen pembelajaran pengukuhan yang terlatih dalam model dunia penyebaran. Secara khusus, kami mendasarkan ini pada pekali hanyutan dan resapan f dan g yang diperkenalkan dalam Bahagian 2.2, yang sepadan dengan pilihan paradigma resapan tertentu. Tambahan pula, kajian ini juga memilih formulasi EDM berdasarkan Karras et al.

Mula-mula tentukan kernel gangguan,  , dengan

, dengan  ialah fungsi bernilai sebenar yang berkaitan dengan masa resapan, dipanggil jadual hingar. Ini sepadan dengan menetapkan pekali drift dan resapan kepada

ialah fungsi bernilai sebenar yang berkaitan dengan masa resapan, dipanggil jadual hingar. Ini sepadan dengan menetapkan pekali drift dan resapan kepada  dan

dan  . . (6)

. . (6)

di mana demi definisi yang ringkas,

di mana demi definisi yang ringkas,

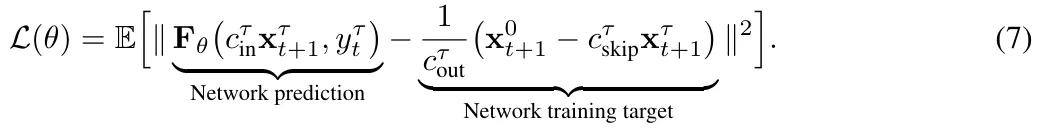

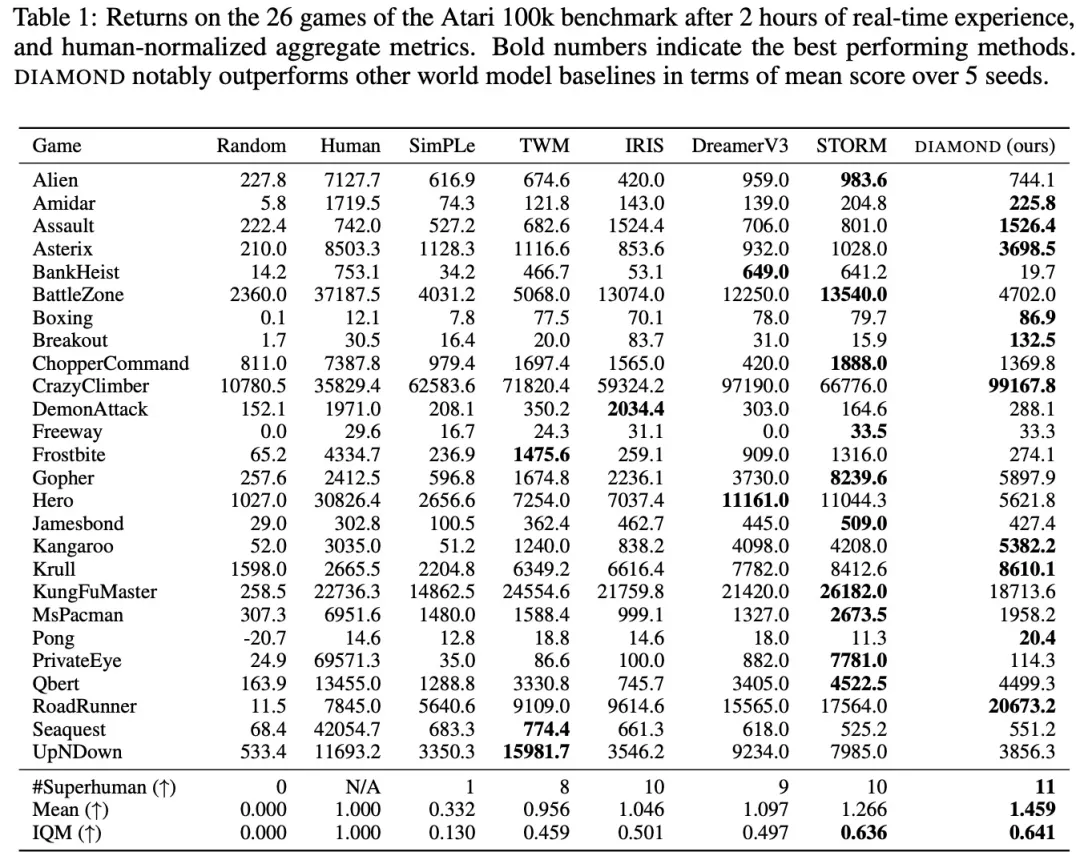

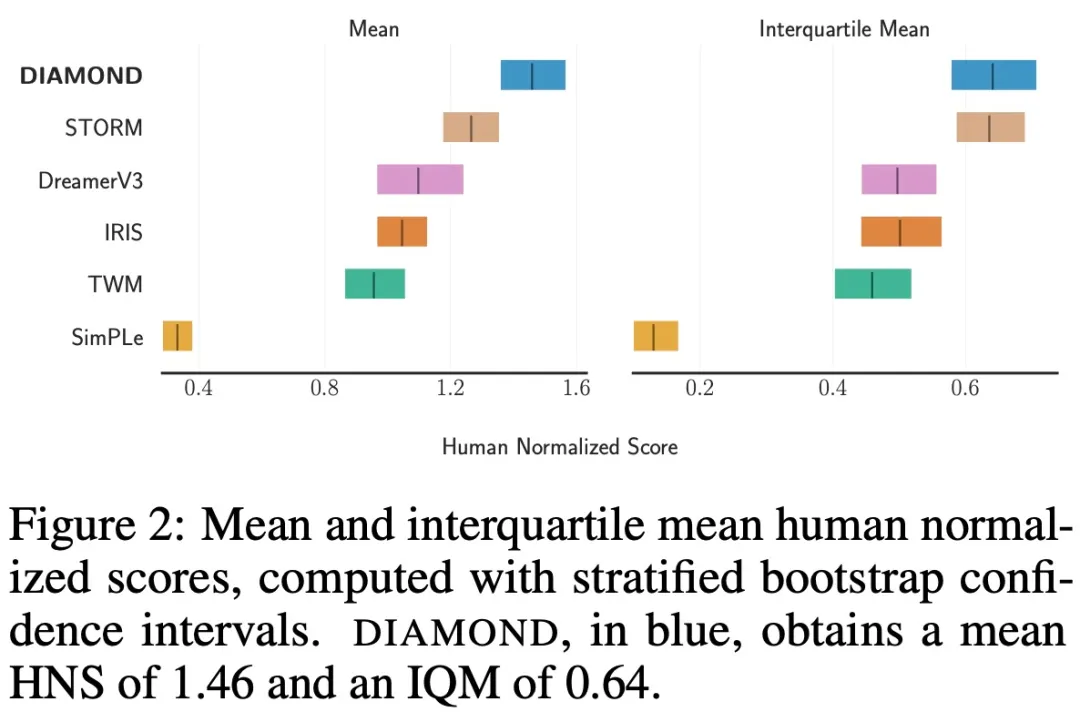

Pemilihan prapemproses. Prapemproses Menggabungkan formula 5 dan 6, kita mendapat Kajian ini Mengkondisikan model dengan menggunakan U-Net 2D standard untuk membina medan vektor dan mengekalkan penimbal yang mengandungi pemerhatian dan tindakan L yang lalu. Seterusnya mereka menggabungkan pemerhatian lepas ini dari segi saluran dengan pemerhatian bising seterusnya, dan memasukkan tindakan ke dalam blok sisa U-Net melalui lapisan normalisasi kumpulan penyesuaian. Seperti yang dibincangkan dalam Bahagian 2.3 dan Lampiran A, terdapat banyak kaedah persampelan yang mungkin untuk menjana pemerhatian seterusnya daripada model resapan terlatih. Walaupun asas kod yang dikeluarkan oleh kajian menyokong skema persampelan berbilang, kajian mendapati bahawa kaedah Euler berkesan tanpa memerlukan NFE tambahan (bilangan penilaian fungsi) dan mengelakkan kerumitan yang tidak perlu bagi pensampel peringkat tinggi atau persampelan rawak. Untuk menilai sepenuhnya DIAMOND, kajian itu menggunakan penanda aras Atari 100k yang mantap, yang merangkumi 26 permainan untuk menguji keupayaan luas ejen. Untuk setiap permainan, ejen hanya dibenarkan 100k tindakan dalam persekitaran, yang kira-kira bersamaan dengan 2 jam masa permainan manusia, untuk belajar bermain permainan sebelum dinilai. Sebagai rujukan, ejen Atari tanpa kekangan biasanya dilatih untuk 50 juta langkah, yang sepadan dengan peningkatan 500 kali ganda dalam pengalaman. Para penyelidik melatih DIAMOND dari awal pada setiap permainan menggunakan 5 biji rawak. Setiap larian menggunakan lebih kurang 12GB VRAM dan mengambil masa kira-kira 2.9 hari pada satu Nvidia RTX 4090 (jumlah tahun 1.03 GPU). Jadual 1 membandingkan markah yang berbeza untuk melatih ejen dalam model dunia: Min dan IQM (Min Interkuartil) selang keyakinan : : Untuk mengkaji kestabilan pembolehubah resapan, kajian ini menganalisis trajektori yang dibayangkan yang dijana oleh autoregresi, seperti yang ditunjukkan dalam Rajah 3 di bawah:

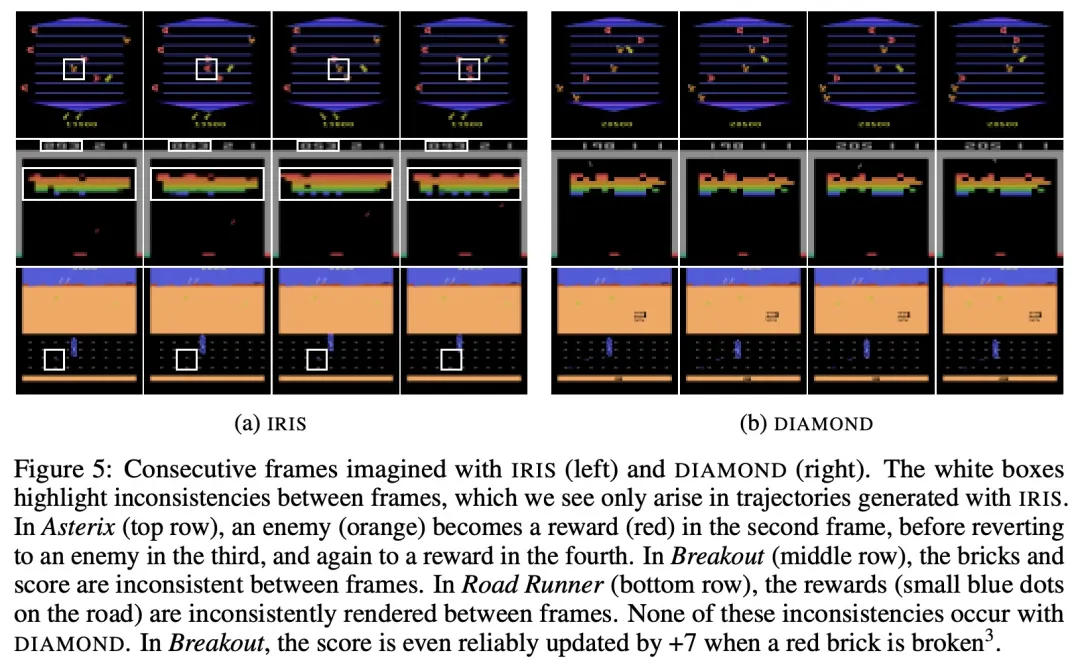

Kajian mendapati terdapat situasi di mana penyelesai berulang diperlukan untuk memacu proses pensampelan ke mod tertentu, seperti permainan tinju yang ditunjukkan dalam Rajah 4: yang ditunjukkan dalam Rajah 5 berbanding dengan Rajah 5. dibayangkan oleh IRIS , trajektori yang dibayangkan oleh DIAMOND umumnya mempunyai kualiti visual yang lebih tinggi dan lebih konsisten dengan persekitaran sebenar. Pembaca yang berminat boleh membaca teks asal kertas kerja untuk mengetahui lebih lanjut tentang kandungan penyelidikan.  dan

dan  dipilih untuk mengekalkan varians unit input dan output rangkaian pada sebarang tahap hingar

dipilih untuk mengekalkan varians unit input dan output rangkaian pada sebarang tahap hingar  .

.  ialah penukaran empirikal tahap hingar,

ialah penukaran empirikal tahap hingar,  diberikan oleh

diberikan oleh  dan sisihan piawai bagi taburan data

dan sisihan piawai bagi taburan data  , dan formulanya ialah

, dan formulanya ialah

sasaran latihan:

sasaran latihan:

Eksperimen

Keputusan menunjukkan bahawa DIAMOND berprestasi kukuh pada penanda aras, mengatasi pemain manusia dalam 11 perlawanan dan mencapai skor HNS 1.46, rekod baharu untuk ejen yang dilatih sepenuhnya pada model dunia. Kajian itu juga mendapati bahawa DIAMOND berprestasi baik terutamanya dalam persekitaran yang merakam perincian diperlukan, seperti Asterix, Breakout dan Road Runner.

Keputusan menunjukkan bahawa DIAMOND berprestasi kukuh pada penanda aras, mengatasi pemain manusia dalam 11 perlawanan dan mencapai skor HNS 1.46, rekod baharu untuk ejen yang dilatih sepenuhnya pada model dunia. Kajian itu juga mendapati bahawa DIAMOND berprestasi baik terutamanya dalam persekitaran yang merakam perincian diperlukan, seperti Asterix, Breakout dan Road Runner.

Atas ialah kandungan terperinci Model dunia juga tersebar! Ejen terlatih ternyata cukup bagus. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1667

1667

14

14

1426

1426

52

52

1328

1328

25

25

1273

1273

29

29

1255

1255

24

24

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

0. Apakah fungsi artikel ini? Kami mencadangkan DepthFM: model anggaran kedalaman monokular generatif yang serba boleh dan pantas. Sebagai tambahan kepada tugas anggaran kedalaman tradisional, DepthFM juga menunjukkan keupayaan terkini dalam tugas hiliran seperti mengecat kedalaman. DepthFM cekap dan boleh mensintesis peta kedalaman dalam beberapa langkah inferens. Mari kita baca karya ini bersama-sama ~ 1. Tajuk maklumat kertas: DepthFM: FastMonocularDepthEstimationwithFlowMatching Pengarang: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Tinggalkan seni bina pengekod-penyahkod dan gunakan model resapan untuk pengesanan tepi, yang lebih berkesan Universiti Teknologi Pertahanan Nasional mencadangkan DiffusionEdge

Feb 07, 2024 pm 10:12 PM

Tinggalkan seni bina pengekod-penyahkod dan gunakan model resapan untuk pengesanan tepi, yang lebih berkesan Universiti Teknologi Pertahanan Nasional mencadangkan DiffusionEdge

Feb 07, 2024 pm 10:12 PM

Rangkaian pengesanan tepi dalam semasa biasanya menggunakan seni bina penyahkod pengekod, yang mengandungi modul pensampelan atas dan bawah untuk mengekstrak ciri berbilang peringkat dengan lebih baik. Walau bagaimanapun, struktur ini mengehadkan rangkaian untuk mengeluarkan hasil pengesanan tepi yang tepat dan terperinci. Sebagai tindak balas kepada masalah ini, kertas kerja mengenai AAAI2024 menyediakan penyelesaian baharu. Tajuk tesis: DiffusionEdge:DiffusionProbabilisticModelforCrispEdgeDetection Penulis: Ye Yunfan (Universiti Teknologi Pertahanan Nasional), Xu Kai (Universiti Teknologi Pertahanan Kebangsaan), Huang Yuxing (Universiti Teknologi Pertahanan Nasional), Yi Renjiao (Universiti Teknologi Pertahanan Nasional), Cai Zhiping (Universiti Teknologi Pertahanan Negara) Pautan kertas: https ://ar

Tongyi Qianwen adalah sumber terbuka sekali lagi, Qwen1.5 membawakan enam model volum, dan prestasinya melebihi GPT3.5

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen adalah sumber terbuka sekali lagi, Qwen1.5 membawakan enam model volum, dan prestasinya melebihi GPT3.5

Feb 07, 2024 pm 10:15 PM

Pada masanya untuk Festival Musim Bunga, versi 1.5 Model Tongyi Qianwen (Qwen) berada dalam talian. Pagi ini, berita versi baharu itu menarik perhatian komuniti AI. Versi baharu model besar termasuk enam saiz model: 0.5B, 1.8B, 4B, 7B, 14B dan 72B. Antaranya, prestasi versi terkuat mengatasi GPT3.5 dan Mistral-Medium. Versi ini termasuk model Base dan model Sembang, dan menyediakan sokongan berbilang bahasa. Pasukan Tongyi Qianwen Alibaba menyatakan bahawa teknologi yang berkaitan juga telah dilancarkan di laman web rasmi Tongyi Qianwen dan Apl Tongyi Qianwen. Selain itu, keluaran Qwen 1.5 hari ini juga mempunyai sorotan berikut: menyokong panjang konteks 32K membuka pusat pemeriksaan model Base+Chat;

Model besar juga boleh dihiris, dan Microsoft SliceGPT sangat meningkatkan kecekapan pengiraan LLAMA-2

Jan 31, 2024 am 11:39 AM

Model besar juga boleh dihiris, dan Microsoft SliceGPT sangat meningkatkan kecekapan pengiraan LLAMA-2

Jan 31, 2024 am 11:39 AM

Model bahasa besar (LLM) biasanya mempunyai berbilion parameter dan dilatih menggunakan trilion token. Walau bagaimanapun, model sedemikian sangat mahal untuk dilatih dan digunakan. Untuk mengurangkan keperluan pengiraan, pelbagai teknik pemampatan model sering digunakan. Teknik pemampatan model ini secara amnya boleh dibahagikan kepada empat kategori: penyulingan, penguraian tensor (termasuk pemfaktoran peringkat rendah), pemangkasan dan kuantisasi. Kaedah pemangkasan telah wujud sejak sekian lama, tetapi banyak yang memerlukan penalaan halus pemulihan (RFT) selepas pemangkasan untuk mengekalkan prestasi, menjadikan keseluruhan proses mahal dan sukar untuk skala. Penyelidik dari ETH Zurich dan Microsoft telah mencadangkan penyelesaian kepada masalah ini yang dipanggil SliceGPT. Idea teras kaedah ini adalah untuk mengurangkan pembenaman rangkaian dengan memadamkan baris dan lajur dalam matriks berat.

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas secara rasmi memasuki era robot elektrik! Semalam, Atlas hidraulik hanya "menangis" menarik diri daripada peringkat sejarah Hari ini, Boston Dynamics mengumumkan bahawa Atlas elektrik sedang berfungsi. Nampaknya dalam bidang robot humanoid komersial, Boston Dynamics berazam untuk bersaing dengan Tesla. Selepas video baharu itu dikeluarkan, ia telah pun ditonton oleh lebih sejuta orang dalam masa sepuluh jam sahaja. Orang lama pergi dan peranan baru muncul. Ini adalah keperluan sejarah. Tidak dinafikan bahawa tahun ini adalah tahun letupan robot humanoid. Netizen mengulas: Kemajuan robot telah menjadikan majlis pembukaan tahun ini kelihatan seperti manusia, dan tahap kebebasan adalah jauh lebih besar daripada manusia Tetapi adakah ini benar-benar bukan filem seram? Pada permulaan video, Atlas berbaring dengan tenang di atas tanah, seolah-olah terlentang. Apa yang berikut adalah rahang-jatuh

LLaVA-1.6, yang mengejar Gemini Pro dan meningkatkan keupayaan penaakulan dan OCR, terlalu berkuasa

Feb 01, 2024 pm 04:51 PM

LLaVA-1.6, yang mengejar Gemini Pro dan meningkatkan keupayaan penaakulan dan OCR, terlalu berkuasa

Feb 01, 2024 pm 04:51 PM

Pada April tahun lepas, penyelidik dari Universiti Wisconsin-Madison, Penyelidikan Microsoft dan Universiti Columbia bersama-sama mengeluarkan LLaVA (Pembantu Bahasa dan Penglihatan Besar). Walaupun LLaVA hanya dilatih dengan set data arahan berbilang modal yang kecil, ia menunjukkan keputusan inferens yang hampir sama dengan GPT-4 pada beberapa sampel. Kemudian pada bulan Oktober, mereka melancarkan LLaVA-1.5, yang menyegarkan SOTA dalam 11 penanda aras dengan pengubahsuaian mudah kepada LLaVA asal. Hasil peningkatan ini sangat mengujakan, membawa kejayaan baharu kepada bidang pembantu AI berbilang modal. Pasukan penyelidik mengumumkan pelancaran versi LLaVA-1.6, menyasarkan penaakulan, OCR dan

Versi Kuaishou Sora 'Ke Ling' dibuka untuk ujian: menghasilkan video lebih 120-an, memahami fizik dengan lebih baik dan boleh memodelkan pergerakan kompleks dengan tepat

Jun 11, 2024 am 09:51 AM

Versi Kuaishou Sora 'Ke Ling' dibuka untuk ujian: menghasilkan video lebih 120-an, memahami fizik dengan lebih baik dan boleh memodelkan pergerakan kompleks dengan tepat

Jun 11, 2024 am 09:51 AM

Apa? Adakah Zootopia dibawa menjadi realiti oleh AI domestik? Didedahkan bersama-sama dengan video itu ialah model penjanaan video domestik berskala besar baharu yang dipanggil "Keling". Sora menggunakan laluan teknikal yang serupa dan menggabungkan beberapa inovasi teknologi yang dibangunkan sendiri untuk menghasilkan video yang bukan sahaja mempunyai pergerakan yang besar dan munasabah, tetapi juga mensimulasikan ciri-ciri dunia fizikal dan mempunyai keupayaan gabungan konsep dan imaginasi yang kuat. Mengikut data, Keling menyokong penjanaan video ultra panjang sehingga 2 minit pada 30fps, dengan resolusi sehingga 1080p dan menyokong berbilang nisbah aspek. Satu lagi perkara penting ialah Keling bukanlah demo atau demonstrasi hasil video yang dikeluarkan oleh makmal, tetapi aplikasi peringkat produk yang dilancarkan oleh Kuaishou, pemain terkemuka dalam bidang video pendek. Selain itu, tumpuan utama adalah untuk menjadi pragmatik, bukan untuk menulis cek kosong, dan pergi ke dalam talian sebaik sahaja ia dikeluarkan Model besar Ke Ling telah pun dikeluarkan di Kuaiying.

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Saya menangis hingga mati. Dunia sedang membina model besar. Data di Internet tidak mencukupi. Model latihan kelihatan seperti "The Hunger Games", dan penyelidik AI di seluruh dunia bimbang tentang cara memberi makan data ini kepada pemakan yang rakus. Masalah ini amat ketara dalam tugas berbilang modal. Pada masa mereka mengalami kerugian, pasukan pemula dari Jabatan Universiti Renmin China menggunakan model baharu mereka sendiri untuk menjadi yang pertama di China untuk menjadikan "suapan data yang dijana model itu sendiri" menjadi kenyataan. Selain itu, ia merupakan pendekatan serampang dua mata dari segi pemahaman dan sisi penjanaan Kedua-dua pihak boleh menjana data baharu berbilang modal yang berkualiti tinggi dan memberikan maklum balas data kepada model itu sendiri. Apakah model? Awaker 1.0, model berbilang modal besar yang baru sahaja muncul di Forum Zhongguancun. Siapa pasukan itu? Enjin Sophon. Diasaskan oleh Gao Yizhao, pelajar kedoktoran di Sekolah Kecerdasan Buatan Hillhouse Universiti Renmin.