Peranti teknologi

Peranti teknologi

AI

AI

Universiti Sains dan Teknologi China dan Huawei Noah mencadangkan Undang-undang Entropi untuk mendedahkan hubungan antara prestasi model besar, kadar pemampatan data dan kehilangan latihan.

Universiti Sains dan Teknologi China dan Huawei Noah mencadangkan Undang-undang Entropi untuk mendedahkan hubungan antara prestasi model besar, kadar pemampatan data dan kehilangan latihan.

Universiti Sains dan Teknologi China dan Huawei Noah mencadangkan Undang-undang Entropi untuk mendedahkan hubungan antara prestasi model besar, kadar pemampatan data dan kehilangan latihan.

Lajur AIxiv ialah lajur di mana kandungan akademik dan teknikal diterbitkan di laman web ini. Dalam beberapa tahun kebelakangan ini, lajur AIxiv laman web ini telah menerima lebih daripada 2,000 laporan, meliputi makmal terkemuka dari universiti dan syarikat utama di seluruh dunia, mempromosikan pertukaran dan penyebaran akademik secara berkesan. Jika anda mempunyai kerja yang sangat baik yang ingin anda kongsikan, sila berasa bebas untuk menyumbang atau hubungi kami untuk melaporkan. E-mel penyerahan: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

Pasukan: Pasukan Chen Enhong di National Key Laboratory of Cognitive Intelligence, University of Science and Technology of China, Huawei Noah's Ark Laboratory Pautan kertas: https://arxiv.org/pdf Pautan kod : https://github.com/USTC-StarTeam/ZIP

- Kehilangan latihan L: Menunjukkan sama ada data sukar untuk diingati oleh model. Di bawah model asas yang sama, kehilangan latihan yang tinggi biasanya disebabkan oleh kehadiran bunyi bising atau maklumat yang tidak konsisten dalam set data.

- Ketekalan data C: Ketekalan data dicerminkan oleh entropi kebarangkalian token seterusnya memandangkan situasi sebelumnya. Konsistensi data yang lebih tinggi biasanya membawa kepada kehilangan latihan yang lebih rendah.

- Kualiti data purata S: mencerminkan purata kualiti peringkat sampel data, yang boleh diukur melalui pelbagai aspek objektif dan subjektif.

di mana f ialah fungsi tersirat. Memandangkan model asas tertentu, skala L biasanya bergantung pada R dan C dan boleh dinyatakan sebagai:

Memandangkan set data dengan homogeniti yang lebih tinggi atau ketekalan data yang lebih baik lebih mudah dipelajari oleh model, L Ia dijangka menjadi monotonik dalam R dan C. Oleh itu, kita boleh menulis semula formula di atas sebagai:

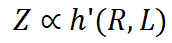

di mana g' ialah fungsi songsang. Dengan menggabungkan tiga persamaan di atas, kita mendapat:

Jika C dianggap sebagai pemalar, kehilangan latihan secara langsung dipengaruhi oleh kadar mampatan. Oleh itu, prestasi model dikawal oleh nisbah mampatan: jika nisbah mampatan data R lebih tinggi, maka Z biasanya lebih teruk, yang akan disahkan dalam eksperimen kami. Di bawah nisbah mampatan yang sama, kehilangan latihan yang lebih tinggi bermakna konsistensi data yang lebih rendah. Oleh itu, pengetahuan berkesan yang dipelajari oleh model mungkin lebih terhad. Ini boleh digunakan untuk meramalkan prestasi LLM pada data berbeza dengan nisbah mampatan dan kualiti sampel yang serupa. Kami akan menunjukkan aplikasi penaakulan ini dalam amalan kemudian. . jumlah maklumat berkesan di bawah bajet data latihan yang terhad. Atas sebab kecekapan, kami mengguna pakai paradigma tamak berbilang peringkat berulang untuk mendapatkan penyelesaian anggaran dengan cekap dengan kadar mampatan yang agak rendah. Dalam setiap lelaran, kami mula-mula menggunakan peringkat pemilihan global untuk memilih kumpulan sampel calon dengan nisbah mampatan rendah untuk mencari sampel dengan ketumpatan maklumat yang tinggi. Kami kemudiannya menggunakan peringkat pemilihan tempatan berbutir kasar untuk memilih set sampel yang lebih kecil yang mempunyai redundansi terendah dengan sampel yang dipilih. Akhir sekali, kami menggunakan peringkat pemilihan tempatan yang terperinci untuk meminimumkan persamaan antara sampel yang akan ditambah. Proses di atas diteruskan sehingga data yang mencukupi diperolehi. Algoritma khusus adalah seperti berikut:

Berdasarkan eksperimen pemilihan data SFT, kami berdasarkan kesan model, kadar mampatan data dan kehilangan data daripada model dalam langkah latihan sebelumnya, masing-masing Pelbagai keluk hubungan telah dipasang. Keputusan ditunjukkan dalam Rajah 2 dan 3, dari mana kita boleh melihat korelasi rapat antara tiga faktor. Pertama sekali, data kadar mampatan rendah biasanya membawa kepada hasil model yang lebih baik Ini kerana proses pembelajaran LLM sangat berkaitan dengan pemampatan maklumat Kita boleh menganggap LLM sebagai pemampat data, jadi data dengan kadar mampatan yang lebih rendah bermakna lebih banyak pengetahuan dan dengan itu lebih berharga kepada pemampat. Pada masa yang sama, boleh diperhatikan bahawa nisbah mampatan yang lebih rendah biasanya disertai dengan kehilangan latihan yang lebih tinggi Ini kerana data yang sukar untuk dimampatkan membawa lebih banyak pengetahuan, menimbulkan cabaran yang lebih besar untuk LLM menyerap pengetahuan yang terkandung di dalamnya.

到

Atas ialah kandungan terperinci Universiti Sains dan Teknologi China dan Huawei Noah mencadangkan Undang-undang Entropi untuk mendedahkan hubungan antara prestasi model besar, kadar pemampatan data dan kehilangan latihan.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1676

1676

14

14

1429

1429

52

52

1333

1333

25

25

1278

1278

29

29

1257

1257

24

24

Pengarang ControlNet mendapat satu lagi kejayaan! Seluruh proses menghasilkan lukisan daripada gambar, memperoleh 1.4k bintang dalam masa dua hari

Jul 17, 2024 am 01:56 AM

Pengarang ControlNet mendapat satu lagi kejayaan! Seluruh proses menghasilkan lukisan daripada gambar, memperoleh 1.4k bintang dalam masa dua hari

Jul 17, 2024 am 01:56 AM

Ia juga merupakan video Tusheng, tetapi PaintsUndo telah mengambil laluan yang berbeza. Pengarang ControlNet LvminZhang mula hidup semula! Kali ini saya menyasarkan bidang lukisan. Projek baharu PaintsUndo telah menerima 1.4kstar (masih meningkat secara menggila) tidak lama selepas ia dilancarkan. Alamat projek: https://github.com/lllyasviel/Paints-UNDO Melalui projek ini, pengguna memasukkan imej statik, dan PaintsUndo secara automatik boleh membantu anda menjana video keseluruhan proses mengecat, daripada draf baris hingga produk siap . Semasa proses lukisan, perubahan garisan adalah menakjubkan Hasil akhir video sangat serupa dengan imej asal: Mari kita lihat lukisan lengkap.

Mendahului senarai jurutera perisian AI sumber terbuka, penyelesaian tanpa ejen UIUC dengan mudah menyelesaikan masalah pengaturcaraan sebenar SWE-bench

Jul 17, 2024 pm 10:02 PM

Mendahului senarai jurutera perisian AI sumber terbuka, penyelesaian tanpa ejen UIUC dengan mudah menyelesaikan masalah pengaturcaraan sebenar SWE-bench

Jul 17, 2024 pm 10:02 PM

Lajur AIxiv ialah lajur di mana tapak ini menerbitkan kandungan akademik dan teknikal. Dalam beberapa tahun kebelakangan ini, lajur AIxiv laman web ini telah menerima lebih daripada 2,000 laporan, meliputi makmal terkemuka dari universiti dan syarikat utama di seluruh dunia, mempromosikan pertukaran dan penyebaran akademik secara berkesan. Jika anda mempunyai kerja yang sangat baik yang ingin anda kongsikan, sila berasa bebas untuk menyumbang atau hubungi kami untuk melaporkan. E-mel penyerahan: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com Semua pengarang kertas kerja ini adalah daripada pasukan guru Zhang Lingming di Universiti Illinois di Urbana-Champaign (UIUC), termasuk: Steven Code repair; pelajar kedoktoran tahun empat, penyelidik

Kertas arXiv boleh disiarkan sebagai 'bertubi-tubi', platform perbincangan Stanford alphaXiv dalam talian, LeCun menyukainya

Aug 01, 2024 pm 05:18 PM

Kertas arXiv boleh disiarkan sebagai 'bertubi-tubi', platform perbincangan Stanford alphaXiv dalam talian, LeCun menyukainya

Aug 01, 2024 pm 05:18 PM

sorakan! Bagaimana rasanya apabila perbincangan kertas adalah perkataan? Baru-baru ini, pelajar di Universiti Stanford mencipta alphaXiv, forum perbincangan terbuka untuk kertas arXiv yang membenarkan soalan dan ulasan disiarkan terus pada mana-mana kertas arXiv. Pautan laman web: https://alphaxiv.org/ Malah, tidak perlu melawati tapak web ini secara khusus. Hanya tukar arXiv dalam mana-mana URL kepada alphaXiv untuk terus membuka kertas yang sepadan di forum alphaXiv: anda boleh mencari perenggan dengan tepat dalam. kertas itu, Ayat: Dalam ruang perbincangan di sebelah kanan, pengguna boleh menyiarkan soalan untuk bertanya kepada pengarang tentang idea dan butiran kertas tersebut Sebagai contoh, mereka juga boleh mengulas kandungan kertas tersebut, seperti: "Diberikan kepada

Daripada RLHF kepada DPO kepada TDPO, algoritma penjajaran model besar sudah pun 'peringkat token'

Jun 24, 2024 pm 03:04 PM

Daripada RLHF kepada DPO kepada TDPO, algoritma penjajaran model besar sudah pun 'peringkat token'

Jun 24, 2024 pm 03:04 PM

Lajur AIxiv ialah lajur di mana tapak ini menerbitkan kandungan akademik dan teknikal. Dalam beberapa tahun kebelakangan ini, lajur AIxiv laman web ini telah menerima lebih daripada 2,000 laporan, meliputi makmal terkemuka dari universiti dan syarikat utama di seluruh dunia, mempromosikan pertukaran dan penyebaran akademik secara berkesan. Jika anda mempunyai kerja yang sangat baik yang ingin anda kongsikan, sila berasa bebas untuk menyumbang atau hubungi kami untuk melaporkan. E-mel penyerahan: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com Dalam proses pembangunan kecerdasan buatan, kawalan dan bimbingan model bahasa besar (LLM) sentiasa menjadi salah satu cabaran utama, bertujuan untuk memastikan model ini adalah kedua-duanya. berkuasa dan selamat untuk masyarakat manusia. Usaha awal tertumpu kepada kaedah pembelajaran pengukuhan melalui maklum balas manusia (RL

Kerja selepas kematian Pasukan Penyelarasan Super OpenAI: Dua model besar bermain permainan, dan output menjadi lebih mudah difahami

Jul 19, 2024 am 01:29 AM

Kerja selepas kematian Pasukan Penyelarasan Super OpenAI: Dua model besar bermain permainan, dan output menjadi lebih mudah difahami

Jul 19, 2024 am 01:29 AM

Jika jawapan yang diberikan oleh model AI tidak dapat difahami sama sekali, adakah anda berani menggunakannya? Memandangkan sistem pembelajaran mesin digunakan dalam bidang yang lebih penting, menjadi semakin penting untuk menunjukkan sebab kita boleh mempercayai output mereka, dan bila tidak mempercayainya. Satu cara yang mungkin untuk mendapatkan kepercayaan dalam output sistem yang kompleks adalah dengan menghendaki sistem menghasilkan tafsiran outputnya yang boleh dibaca oleh manusia atau sistem lain yang dipercayai, iaitu, difahami sepenuhnya sehingga apa-apa ralat yang mungkin boleh dilakukan. dijumpai. Contohnya, untuk membina kepercayaan dalam sistem kehakiman, kami memerlukan mahkamah memberikan pendapat bertulis yang jelas dan boleh dibaca yang menjelaskan dan menyokong keputusan mereka. Untuk model bahasa yang besar, kita juga boleh menggunakan pendekatan yang sama. Walau bagaimanapun, apabila mengambil pendekatan ini, pastikan model bahasa menjana

Satu kejayaan ketara dalam Hipotesis Riemann! Tao Zhexuan amat mengesyorkan kertas kerja baharu daripada MIT dan Oxford, dan pemenang Fields Medal berusia 37 tahun mengambil bahagian

Aug 05, 2024 pm 03:32 PM

Satu kejayaan ketara dalam Hipotesis Riemann! Tao Zhexuan amat mengesyorkan kertas kerja baharu daripada MIT dan Oxford, dan pemenang Fields Medal berusia 37 tahun mengambil bahagian

Aug 05, 2024 pm 03:32 PM

Baru-baru ini, Hipotesis Riemann, yang dikenali sebagai salah satu daripada tujuh masalah utama milenium, telah mencapai kejayaan baharu. Hipotesis Riemann ialah masalah yang tidak dapat diselesaikan yang sangat penting dalam matematik, berkaitan dengan sifat tepat taburan nombor perdana (nombor perdana ialah nombor yang hanya boleh dibahagikan dengan 1 dan dirinya sendiri, dan ia memainkan peranan asas dalam teori nombor). Dalam kesusasteraan matematik hari ini, terdapat lebih daripada seribu proposisi matematik berdasarkan penubuhan Hipotesis Riemann (atau bentuk umumnya). Dalam erti kata lain, sebaik sahaja Hipotesis Riemann dan bentuk umumnya dibuktikan, lebih daripada seribu proposisi ini akan ditetapkan sebagai teorem, yang akan memberi kesan yang mendalam terhadap bidang matematik dan jika Hipotesis Riemann terbukti salah, maka antara cadangan ini sebahagian daripadanya juga akan kehilangan keberkesanannya. Kejayaan baharu datang daripada profesor matematik MIT Larry Guth dan Universiti Oxford

LLM sememangnya tidak bagus untuk ramalan siri masa Ia bahkan tidak menggunakan keupayaan penaakulannya.

Jul 15, 2024 pm 03:59 PM

LLM sememangnya tidak bagus untuk ramalan siri masa Ia bahkan tidak menggunakan keupayaan penaakulannya.

Jul 15, 2024 pm 03:59 PM

Bolehkah model bahasa benar-benar digunakan untuk ramalan siri masa? Menurut Undang-undang Tajuk Berita Betteridge (sebarang tajuk berita yang berakhir dengan tanda soal boleh dijawab dengan "tidak"), jawapannya mestilah tidak. Fakta nampaknya benar: LLM yang begitu berkuasa tidak dapat mengendalikan data siri masa dengan baik. Siri masa, iaitu, siri masa, seperti namanya, merujuk kepada satu set jujukan titik data yang disusun mengikut urutan masa. Analisis siri masa adalah kritikal dalam banyak bidang, termasuk ramalan penyebaran penyakit, analisis runcit, penjagaan kesihatan dan kewangan. Dalam bidang analisis siri masa, ramai penyelidik baru-baru ini mengkaji cara menggunakan model bahasa besar (LLM) untuk mengelas, meramal dan mengesan anomali dalam siri masa. Makalah ini menganggap bahawa model bahasa yang pandai mengendalikan kebergantungan berjujukan dalam teks juga boleh digeneralisasikan kepada siri masa.

MLLM berasaskan Mamba yang pertama ada di sini! Berat model, kod latihan, dsb. semuanya telah menjadi sumber terbuka

Jul 17, 2024 am 02:46 AM

MLLM berasaskan Mamba yang pertama ada di sini! Berat model, kod latihan, dsb. semuanya telah menjadi sumber terbuka

Jul 17, 2024 am 02:46 AM

Lajur AIxiv ialah lajur di mana tapak ini menerbitkan kandungan akademik dan teknikal. Dalam beberapa tahun kebelakangan ini, lajur AIxiv laman web ini telah menerima lebih daripada 2,000 laporan, meliputi makmal terkemuka dari universiti dan syarikat utama di seluruh dunia, mempromosikan pertukaran dan penyebaran akademik secara berkesan. Jika anda mempunyai kerja yang sangat baik yang ingin anda kongsikan, sila berasa bebas untuk menyumbang atau hubungi kami untuk melaporkan. E-mel penyerahan: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com. Pengenalan Dalam beberapa tahun kebelakangan ini, aplikasi model bahasa besar multimodal (MLLM) dalam pelbagai bidang telah mencapai kejayaan yang luar biasa. Walau bagaimanapun, sebagai model asas untuk banyak tugas hiliran, MLLM semasa terdiri daripada rangkaian Transformer yang terkenal, yang