Mungkin salah satu kesukaran terbesar bagi mereka yang mula belajar Pembelajaran Mesin ialah bekerja, memproses data, membuat inferens kecil, dan kemudian menyusun model anda.

Dalam artikel ini saya akan memberikan contoh cara menganalisis set data untuk membina model Pembelajaran Mesin dengan lebih baik dengan melalui:

Tetapi mari kita mulakan dari awal, supaya kita boleh mengkontekstualisasikan, apakah Pembelajaran Mesin (ML)?

ML ialah salah satu cabang Kecerdasan Buatan (AI) yang berbeza, serta Rangkaian Neural atau Robotik, dan lain-lain. Jenis pembelajaran mesin bergantung pada cara data distrukturkan, jadi ia boleh dibahagikan kepada jenis yang berbeza, dari situ mencipta model. Model ML dicipta menggunakan algoritma yang memproses data input dan belajar untuk meramal atau mengklasifikasikan keputusan.

Untuk mencipta model ML, kami memerlukan set data, dalam set data mesti ada ciri input kami, yang pada asasnya adalah keseluruhan set data kami kecuali lajur sasaran bergantung pada jenis pembelajaran kami, jika Pembelajaran terpantau set data mesti mengandungi sasaran, atau label, atau jawapan yang betul, kerana maklumat ini akan digunakan untuk melatih dan menguji model.

Beberapa jenis pembelajaran dan struktur set data untuk mereka:

Oleh itu, set data pada dasarnya mentakrifkan keseluruhan tingkah laku dan proses pembelajaran model yang dihasilkan oleh mesin.

Untuk meneruskan contoh, saya akan menggunakan set data dengan label, mencontohkan model dengan Pembelajaran Terselia, yang objektifnya adalah untuk menentukan nilai bulanan insurans hayat untuk khalayak tertentu.

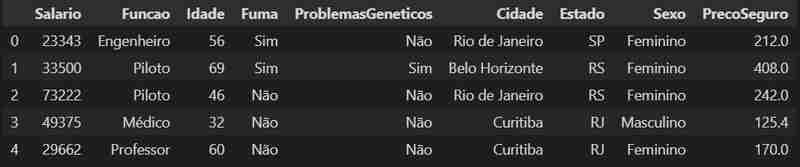

Mari kita mulakan dengan memuatkan set data kami dan lihat baris pertamanya.

import pandas as pd

data = pd.read_csv('../dataset_seguro_vida.csv')

data.head()

Mari kita memperincikan data kita dengan lebih lanjut, kita boleh melihat formatnya dan menemui bilangan baris dan lajur dalam set data.

data.shape

Kami mempunyai struktur data 500 baris dan 9 lajur di sini.

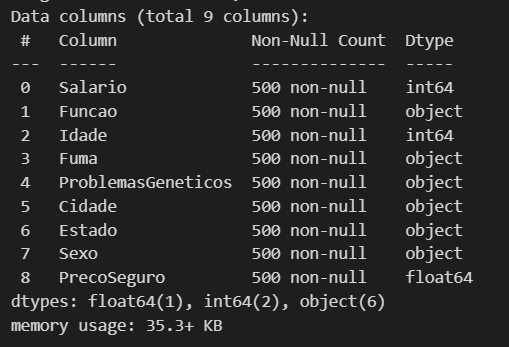

Sekarang mari kita lihat jenis data yang kita ada dan jika kita kehilangan sebarang data.

data.info()

Kami mempunyai 3 lajur berangka di sini, termasuk 2 int (nombor bulat) dan 1 apungan (nombor dengan tempat perpuluhan), dan 6 lagi adalah objek. Jadi kita boleh beralih ke langkah seterusnya memproses data sedikit.

Langkah yang baik ke arah menambah baik set data kami ialah memahami bahawa sesetengah jenis data diproses malah difahami dengan lebih mudah oleh model berbanding yang lain. Sebagai contoh, data jenis objek adalah lebih berat malah terhad untuk digunakan, jadi adalah lebih baik untuk mengubahnya kepada kategori, kerana ini membolehkan kita memperoleh beberapa keuntungan daripada prestasi kepada kecekapan dalam penggunaan memori (dalam Dalam akhirnya, kita juga boleh memperbaikinya dengan membuat satu lagi transformasi, tetapi apabila tiba masanya saya akan menerangkan dengan lebih baik).

object_columns = data.select_dtypes(include='object').columns

for col in object_columns:

data[col] = data[col].astype('category')

data.dtypes

Como o nosso objetivo é conseguir estipular o valor da mensalidade de um seguro de vida, vamos dar uma olhada melhor nas nossas variáveis numéricas usando a transposição.

data.describe().T

Podemos aqui ver alguns detalhes e valores dos nossos inputs numéricos, como a média aritmética, o valor mínimo e máximo. Através desses dados podemos fazer a separação desses valores em grupos baseados em algum input de categoria, por gênero, se fuma ou não, entre outros, como demonstração vamos fazer a separação por sexo, para visualizar a media aritmética das colunas divididas por sexo.

value_based_on_sex = data.groupby("Sexo").mean("PrecoSeguro")

value_based_on_sex

Como podemos ver que no nosso dataset os homens acabam pagando um preço maior de seguro (lembrando que esse dataset é fictício).

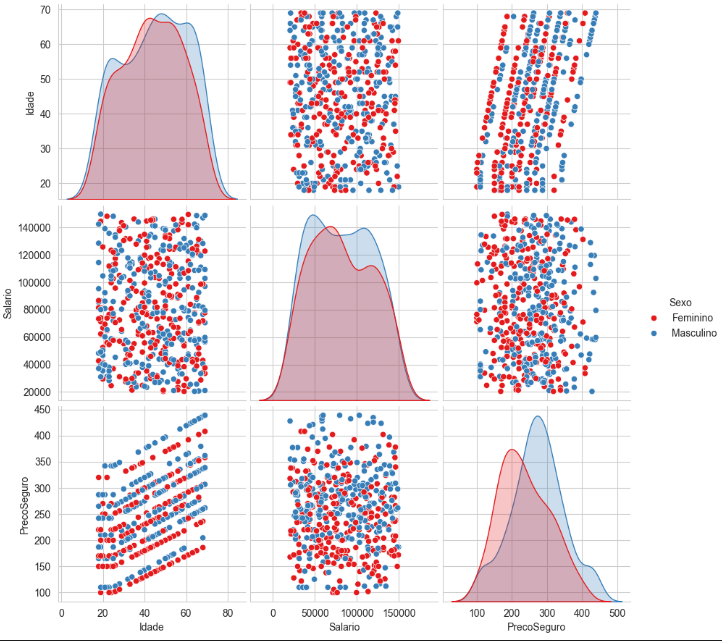

Podemos ter uma melhor visualização dos dados através do seaborn, é uma biblioteca construída com base no matplotlib usada especificamente para plotar gráficos estatísticos.

import seaborn as sns

sns.set_style("whitegrid")

sns.pairplot(

data[["Idade", "Salario", "PrecoSeguro", "Sexo"]],

hue = "Sexo",

height = 3,

palette = "Set1")

Aqui podemos visualizar a distribuição desses valores através dos gráficos ficando mais claro a separação do conjunto, com base no grupo que escolhemos, como um teste você pode tentar fazer um agrupamento diferente e ver como os gráficos vão ficar.

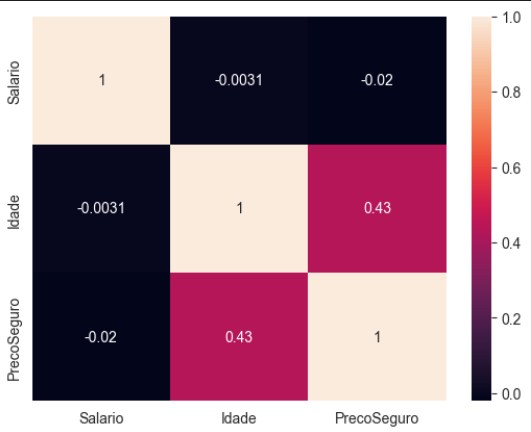

Vamos criar uma matriz de correlação, sendo essa uma outra forma de visualizar a relação das variáveis numéricas do dataset, com o auxilio visual de um heatmap.

numeric_data = data.select_dtypes(include=['float64', 'int64']) corr_matrix = numeric_data.corr() sns.heatmap(corr_matrix, annot= True)

Essa matriz transposta nos mostra quais variáveis numéricas influenciam mais no nosso modelo, é um pouco intuitivo quando você olha para a imagem, podemos observar que a idade é a que mais vai interferir no preço do seguro.

Basicamente essa matriz funciona assim:

Os valores variam entre -1 e 1:

1: Correlação perfeita positiva - Quando uma variável aumenta, a outra também aumenta proporcionalmente.

0: Nenhuma correlação - Não há relação linear entre as variáveis.

-1: Correlação perfeita negativa - Quando uma variável aumenta, a outra diminui proporcionalmente.

Lembra da transformada que fizemos de object para category nos dados, agora vem a outra melhoria comentada, com os dados que viraram category faremos mais uma transformada, dessa vez a ideia é transformar essa variáveis categóricas em representações numéricas, isso nos permitirá ter um ganho incrível com o desempenho do modelo já que ele entende muito melhor essas variáveis numéricas.

Conseguimos fazer isso facilmente com a lib do pandas, o que ele faz é criar nova colunas binarias para valores distintos, o pandas é uma biblioteca voltada principalmente para analise de dados e estrutura de dados, então ela já possui diversas funcionalidades que nos auxiliam nos processo de tratamento do dataset.

data = pd.get_dummies(data)

Pronto agora temos nossas novas colunas para as categorias.

Para a construção do melhor modelo, devemos saber qual o algoritmo ideal para o propósito da ML, na tabela seguinte vou deixar um resumo simplificado de como analisar seu problema e fazer a melhor escolha.

Olhando a tabela podemos ver que o problema que temos que resolver é o de regressão. Aqui vai mais uma dica, sempre comesse simples e vá incrementando seu e fazendo os ajustes necessários até os valores de previsibilidade do modelo ser satisfatório.

Para o nosso exemplo vamos montar um modelo de Regressão Linear, já que temos uma linearidade entre os nossos inputs e temos como target uma variável numérica.

Sabemos que a nossa variável target é a coluna PrecoSeguro , as outras são nossos inputs. Os inputs em estatísticas são chamadas de variável independente e o target de variável dependente, pelos nomes fica claro que a ideia é que o nosso target é uma variável que depende dos nosso inputs, se os inputs variam nosso target tem que vai variar também.

Vamos definir nosso y com o target

y = data["PrecoSeguro"]

E para x vamos remover a coluna target e inserir todas as outras

X = data.drop("PrecoSeguro", axis = 1)

Antes de montarmos o modelo, nosso dataset precisa ser dividido uma parte para teste e outra para o treino, para fazer isso vamos usar do scikit-learn o método train_test_split.

from sklearn.model_selection import train_test_split

X_train,X_test,y_train,y_test=train_test_split(

X,y,

train_size = 0.80,

random_state = 1)

Aqui dividimos o nosso dataset em 80% para treino e 20% para testes. Agora podemos montar o nosso modelo.

from sklearn.linear_model import LinearRegression lr = LinearRegression() lr.fit(X_train,y_train)

Modelo montado agora podemos avaliar seu desempenho

lr.score(X_test, y_test). lr.score(X_train, y_train)

Aqui podemos analisar a o coeficiente de determinação do nosso modelo para testes e para o treinamento.

Podemos usar um outro método para poder descobrir o desvio padrão do nosso modelo, e entender a estabilidade e a confiabilidade do desempenho do modelo para a amostra

<p>from sklearn.metrics import mean_squared_error<br> import math</p> <p>y_pred = lr.predict(X_test)<br> math.sqrt(mean_squared_error(y_test, y_pred))</p>

O valor perfeito do coeficiente de determinação é 1, quanto mais próximo desse valor, teoricamente melhor seria o nosso modelo, mas um ponto de atenção é basicamente impossível você conseguir um modelo perfeito, até mesmo algo acima de 0.95 é de se desconfiar.

Se você tiver trabalhando com dados reais e conseguir um valor desse é bom analisar o seu modelo, testar outras abordagens e até mesmo revisar seu dataset, pois seu modelo pode estar sofrendo um overfitting e por isso apresenta esse resultado quase que perfeitos.

Aqui como montamos um dataset com valores irreais e sem nenhum embasamento é normal termos esses valores quase que perfeitos.

Deixarei aqui um link para o github do código e dataset usados nesse post

Atas ialah kandungan terperinci Set data semasa membina model Pembelajaran Mesin. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Perbezaan antara gerbang dan penghala

Perbezaan antara gerbang dan penghala

Bagaimana untuk memulihkan fail yang dikosongkan daripada Recycle Bin

Bagaimana untuk memulihkan fail yang dikosongkan daripada Recycle Bin

Bagaimana untuk membetulkan libcurl.dll hilang dari komputer anda

Bagaimana untuk membetulkan libcurl.dll hilang dari komputer anda

Padamkan maklumat exif

Padamkan maklumat exif

WiFi tidak menunjukkan akses kepada Internet

WiFi tidak menunjukkan akses kepada Internet

Komputer saya tidak boleh membukanya dengan mengklik dua kali padanya

Komputer saya tidak boleh membukanya dengan mengklik dua kali padanya

Bagaimana untuk memulihkan rakan selepas disekat di TikTok

Bagaimana untuk memulihkan rakan selepas disekat di TikTok

Pengenalan kepada kod kesan khas javascript

Pengenalan kepada kod kesan khas javascript