DeepGemm Dikeluarkan pada Hari 3 Minggu Sumber Terbuka DeepSeek

DeepSeek melepaskan DeepGemm: Perpustakaan FP8 Gemm berprestasi tinggi untuk AI

Sebagai sebahagian daripada #OpensourceWeek, DeepSeek melancarkan DeepGemm, perpustakaan canggih yang dioptimumkan untuk pendaraban matriks umum FP8 yang cekap (GEMM). Perpustakaan ini menyokong kedua-dua GEMM yang padat dan campuran (MOE), membuktikan tidak ternilai untuk latihan dan kesimpulan model V3/R1. DeepGEMM bertujuan untuk meningkatkan prestasi dan kecekapan dalam beban kerja AI dengan ketara, memperkuat komitmen DeepSeek untuk inovasi sumber terbuka.

? Hari 3 dari #OpensourceWeek: DeepGemm

Memperkenalkan DeepGEMM - Perpustakaan FP8 GEMM yang menyokong padat dan MOE GEMM, memanfaatkan latihan dan kesimpulan V3/R1.

⚡ hingga 1350 fp8 tflops pada gpus hopper

✅ Ketergantungan minimum, direka untuk kemudahan penggunaan

✅ sepenuhnya dalam masa yang disusun ...- DeepSeek (@deepseek_ai) 26 Februari, 2025

Siaran ini mengikuti pelancaran kejayaan DeepSeek FlashML (Hari 1) dan DeepSeek Deepep (Hari 2).

Jadual Kandungan

- Apa itu Gemm?

- Apa itu fp8?

- Keperluan untuk DeepGemm

- Ciri -ciri utama DeepGemm

- Penanda aras prestasi

- Arahan Pemasangan

- Kesimpulan

Apa itu Gemm?

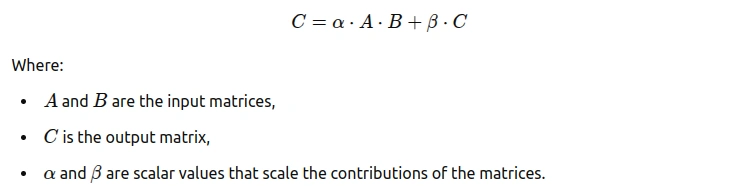

Pendaraban Matriks Umum (GEMM) adalah operasi algebra linear asas mengalikan dua matriks untuk menghasilkan satu pertiga. Digunakan secara meluas dalam pelbagai aplikasi, formulanya ialah:

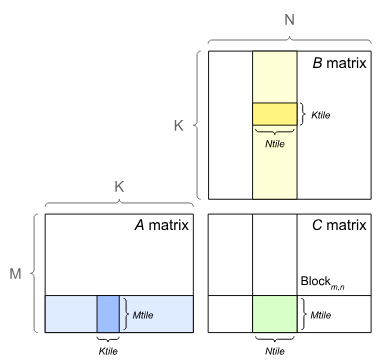

Ilustrasi ini menunjukkan GEMM, menonjolkan jubin (membahagikan matriks ke blok yang lebih kecil - mtile, ntile, ktile) untuk penggunaan cache yang dioptimumkan. Ini meningkatkan prestasi melalui kawasan data dan paralelisme yang dipertingkatkan.

Ilustrasi ini menunjukkan GEMM, menonjolkan jubin (membahagikan matriks ke blok yang lebih kecil - mtile, ntile, ktile) untuk penggunaan cache yang dioptimumkan. Ini meningkatkan prestasi melalui kawasan data dan paralelisme yang dipertingkatkan.

Apa itu fp8?

FP8 (8-bit floating-point) adalah format pengkomputeran berprestasi tinggi yang menawarkan ketepatan yang dikurangkan dan perwakilan data berangka yang cekap. Ia amat bermanfaat untuk mengendalikan tuntutan pengiraan dataset besar dalam pembelajaran mesin.

Format FP8 biasa termasuk:

1 tanda bit

- 5 bit eksponen

- 2 pecahan bit

- Struktur padat ini membolehkan pengiraan yang lebih cepat dan mengurangkan penggunaan memori, sesuai untuk melatih model besar. Walaupun ketepatan mungkin sedikit dikompromi, ini sering diterima, bahkan membawa kepada keuntungan prestasi akibat pengurangan overhead pengiraan.

Imej ini membandingkan FP8 (format E4M3 dan E5M2) dengan FP16 dan BF16, yang menggambarkan perdagangan antara ketepatan dan julat untuk format terapung yang berbeza.

Keperluan untuk DeepGemm

DeepGEMM menangani cabaran pendaraban matriks dengan menawarkan perpustakaan ringan, berprestasi tinggi, dan mesra pengguna untuk operasi GEMM yang pelbagai.

- memenuhi keperluan kritikal untuk FP8 GEMM yang dioptimumkan dalam komuniti AI.

- prestasi tinggi dengan jejak memori kecil.

- menyokong kedua -dua susun atur padat dan MOE.

- penting untuk latihan dan pelaksanaan model AI berskala besar.

- Mengoptimumkan seni bina MOE dengan jenis GEMM khusus.

- secara langsung meningkatkan model AI DeepSeek.

- memberi manfaat kepada ekosistem pembangunan AI yang lebih luas.

Kekuatan DeepGemm termasuk:

- Prestasi tinggi:

- mencapai sehingga 1350 fp8 tflops pada GPU NVIDIA HOPPER. Reka bentuk ringan:

- kebergantungan minimum untuk penggunaan mudah. kompilasi tepat masa:

- menyusun kernel pada runtime untuk pengalaman pengguna yang diselaraskan. Logik teras ringkas:

- Kira-kira 300 baris kod teras, mengatasi banyak biji-bijian yang ditunaikan oleh pakar. Sokongan untuk susun atur yang pelbagai:

- menyokong susun atur padat dan dua moe.

Kecekapan DeepGemM merentasi pelbagai konfigurasi matriks ditunjukkan di bawah:

3 /gaya tersuai untuk jadual

/ .custom-table { Lebar: 100%; Sempadan-keruntuhan: runtuh; /memastikan sempadan tidak menggandakan / Margin: 20px 0; } .Custom-table th, .Custom-table TD { Sempadan: 1px pepejal #000; / sempadan yang kelihatan / Padding: 12px; / padding selesa

Jadual 1: Penanda aras prestasi DeepGemm

Arahan pemasangan

Pemasangan DeepGemm adalah mudah:

Langkah 1: Prasyarat

- Hopper Architecture GPU (SM_90A)

- python 3.8

- CUDA 12.3 (disyorkan: 12.8)

- Pytorch 2.1

- cutlass 3.6 (boleh menjadi submodule git)

Langkah 2: klon repositori

git clone --recursive [email protected]:deepseek-ai/DeepGEMM.git

Langkah 3: Pasang perpustakaan

python setup.py install

Langkah 4: Import DeepGemm

import deep_gemm

Lihat repositori DeepGemm GitHub untuk arahan terperinci.

Kesimpulan

DeepGEMM adalah perpustakaan FP8 GEMM yang berprestasi tinggi, mesra pengguna yang sesuai untuk tugas pembelajaran mesin lanjutan. Reka bentuk, kelajuan, dan fleksibiliti ringan menjadikannya alat yang berharga untuk pemaju AI. Semak blog Analytics Vidhya untuk kemas kini mengenai pelepasan Hari 4 DeepSeek!

Atas ialah kandungan terperinci DeepGemm Dikeluarkan pada Hari 3 Minggu Sumber Terbuka DeepSeek. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Penjana Seni AI Terbaik (Percuma & amp; Dibayar) untuk projek kreatif

Apr 02, 2025 pm 06:10 PM

Penjana Seni AI Terbaik (Percuma & amp; Dibayar) untuk projek kreatif

Apr 02, 2025 pm 06:10 PM

Artikel ini mengkaji semula penjana seni AI atas, membincangkan ciri -ciri mereka, kesesuaian untuk projek kreatif, dan nilai. Ia menyerlahkan Midjourney sebagai nilai terbaik untuk profesional dan mengesyorkan Dall-E 2 untuk seni berkualiti tinggi dan disesuaikan.

Bermula dengan Meta Llama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Bermula dengan Meta Llama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Meta's Llama 3.2: Lompat ke hadapan dalam Multimodal dan Mobile AI META baru -baru ini melancarkan Llama 3.2, kemajuan yang ketara dalam AI yang memaparkan keupayaan penglihatan yang kuat dan model teks ringan yang dioptimumkan untuk peranti mudah alih. Membina kejayaan o

Adakah chatgpt 4 o tersedia?

Mar 28, 2025 pm 05:29 PM

Adakah chatgpt 4 o tersedia?

Mar 28, 2025 pm 05:29 PM

CHATGPT 4 kini tersedia dan digunakan secara meluas, menunjukkan penambahbaikan yang ketara dalam memahami konteks dan menjana tindak balas yang koheren berbanding dengan pendahulunya seperti ChATGPT 3.5. Perkembangan masa depan mungkin merangkumi lebih banyak Inter yang diperibadikan

CHATBOTS AI terbaik berbanding (Chatgpt, Gemini, Claude & amp; Lagi)

Apr 02, 2025 pm 06:09 PM

CHATBOTS AI terbaik berbanding (Chatgpt, Gemini, Claude & amp; Lagi)

Apr 02, 2025 pm 06:09 PM

Artikel ini membandingkan chatbots AI seperti Chatgpt, Gemini, dan Claude, yang memberi tumpuan kepada ciri -ciri unik mereka, pilihan penyesuaian, dan prestasi dalam pemprosesan bahasa semula jadi dan kebolehpercayaan.

Pembantu Menulis AI Teratas untuk Meningkatkan Penciptaan Kandungan Anda

Apr 02, 2025 pm 06:11 PM

Pembantu Menulis AI Teratas untuk Meningkatkan Penciptaan Kandungan Anda

Apr 02, 2025 pm 06:11 PM

Artikel ini membincangkan pembantu penulisan AI terkemuka seperti Grammarly, Jasper, Copy.ai, WriteSonic, dan Rytr, yang memberi tumpuan kepada ciri -ciri unik mereka untuk penciptaan kandungan. Ia berpendapat bahawa Jasper cemerlang dalam pengoptimuman SEO, sementara alat AI membantu mengekalkan nada terdiri

Memilih Penjana Suara AI Terbaik: Pilihan Teratas Ditinjau

Apr 02, 2025 pm 06:12 PM

Memilih Penjana Suara AI Terbaik: Pilihan Teratas Ditinjau

Apr 02, 2025 pm 06:12 PM

Artikel ini mengulas penjana suara AI atas seperti Google Cloud, Amazon Polly, Microsoft Azure, IBM Watson, dan Descript, memberi tumpuan kepada ciri -ciri mereka, kualiti suara, dan kesesuaian untuk keperluan yang berbeza.

Bagaimana cara mengakses Falcon 3? - Analytics Vidhya

Mar 31, 2025 pm 04:41 PM

Bagaimana cara mengakses Falcon 3? - Analytics Vidhya

Mar 31, 2025 pm 04:41 PM

Falcon 3: Model bahasa besar sumber terbuka revolusioner Falcon 3, lelaran terkini dalam siri Falcon yang terkenal LLMS, mewakili kemajuan yang ketara dalam teknologi AI. Dibangunkan oleh Institut Inovasi Teknologi (TII), ini terbuka

Sistem Rag Agentik 7 Teratas untuk Membina Ejen AI

Mar 31, 2025 pm 04:25 PM

Sistem Rag Agentik 7 Teratas untuk Membina Ejen AI

Mar 31, 2025 pm 04:25 PM

2024 menyaksikan peralihan daripada menggunakan LLMS untuk penjanaan kandungan untuk memahami kerja dalaman mereka. Eksplorasi ini membawa kepada penemuan agen AI - sistem pengendalian sistem autonomi dan keputusan dengan intervensi manusia yang minimum. Buildin