qwen2.5-max: Model bahasa yang besar, seperti manusia seperti manusia

Landskap AI berdengung dengan model yang kuat, kos efektif seperti DeepSeek, Mistral Small 3, dan Qwen2.5 Max. Qwen2.5-Max, khususnya, membuat gelombang sebagai model campuran-of-experts (MOE) yang kuat, bahkan mengatasi DeepSeek V3 dalam beberapa tanda aras. Senibina lanjutan dan dataset latihan besar -besaran (sehingga 18 trilion token) menetapkan piawaian baru untuk prestasi. Artikel ini meneroka seni bina Qwen2.5-Max, kelebihan daya saingnya, dan potensi untuk menyaingi Deepseek V3. Kami juga akan membimbing anda melalui model QWEN2.5 yang menjalankan tempatan.

Ciri -ciri Model Kunci Qwen2.5:

Jadual Kandungan:

menjalankan qwen2.5 secara tempatan dengan ollama:

Pertama, pasang Ollama: pautan muat turun ollama

Linux/Ubuntu Pengguna: curl -fsSL https://ollama.com/install.sh | sh

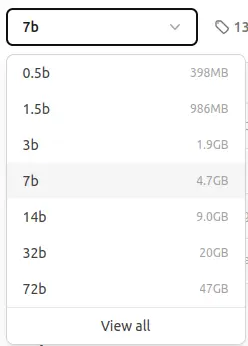

Model ollama ollama yang ada:

qwen2.5: 7b kesimpulan:

ollama pull qwen2.5:7b

akan memuat turun model. Anda akan melihat output yang serupa dengan ini: pull

<code>pulling manifest pulling 2bada8a74506... 100% ▕████████████████▏ 4.7 GB ... (rest of the output) ... success</code>

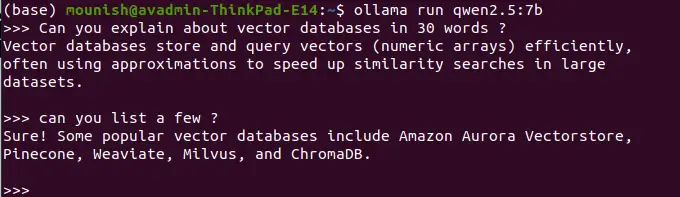

ollama run qwen2.5:7b

contoh pertanyaan:

contoh pertanyaan:

prompt:

Tentukan pangkalan data vektor dalam 30 perkataan.

<code>Vector databases efficiently store and query numerical arrays (vectors), often using approximations for fast similarity searches in large datasets.</code>

Senaraikan beberapa contoh.

<code>Popular vector databases include Pinecone, Weaviate, Milvus, ChromaDB, and Amazon Aurora Vectorstore.</code>

Nota: Model yang dikendalikan oleh tempatan tidak mempunyai akses masa nyata dan keupayaan carian web. Contohnya:

prompt:

apa tarikh hari ini?

<code>Today's date is unavailable. My knowledge is not updated in real-time.</code>

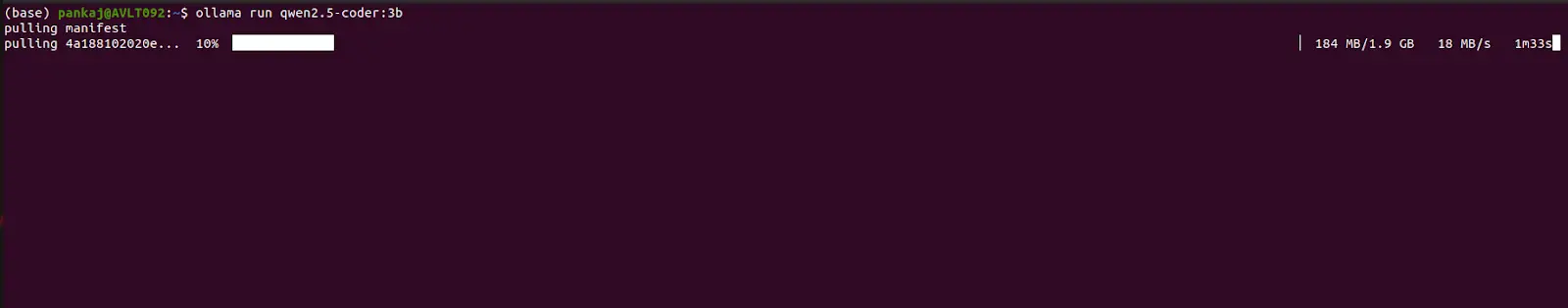

ikuti proses yang sama, menggantikan

ikuti proses yang sama, menggantikan

dalam

dan perintah. qwen2.5-coder:3b

qwen2.5:7b pull

run Contoh pengekodan Prompt:

prompt: menyediakan kod python untuk urutan Fibonacci.

(output: kod python untuk urutan Fibonacci akan dipaparkan di sini)

prompt: Buat kalkulator mudah menggunakan fungsi python.

Panduan ini menunjukkan cara menjalankan model QWEN2.5 secara tempatan menggunakan Ollama, menonjolkan kekuatan QWEN.5-MAX: panjang konteks 128K, sokongan berbilang bahasa, dan keupayaan yang dipertingkatkan. Walaupun pelaksanaan tempatan meningkatkan keselamatan, ia mengorbankan akses maklumat masa nyata. Qwen2.5 menawarkan keseimbangan antara kecekapan, keselamatan, dan prestasi, menjadikannya alternatif yang kuat untuk DeepSeek V3 untuk pelbagai aplikasi AI. Maklumat lanjut mengenai mengakses Qwen2.5-Max melalui Google Colab boleh didapati dalam sumber yang berasingan.

Atas ialah kandungan terperinci Bagaimana untuk menjalankan model Qwen2.5 secara tempatan dalam masa 3 minit?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk menyalakan telefon Xiaomi

Bagaimana untuk menyalakan telefon Xiaomi

Bagaimana untuk memusatkan div dalam css

Bagaimana untuk memusatkan div dalam css

Bagaimana untuk membuka fail rar

Bagaimana untuk membuka fail rar

Kaedah untuk membaca dan menulis fail java dbf

Kaedah untuk membaca dan menulis fail java dbf

Bagaimana untuk menyelesaikan masalah bahawa fail msxml6.dll hilang

Bagaimana untuk menyelesaikan masalah bahawa fail msxml6.dll hilang

Formula pilih atur dan gabungan yang biasa digunakan

Formula pilih atur dan gabungan yang biasa digunakan

Nombor telefon mudah alih maya untuk menerima kod pengesahan

Nombor telefon mudah alih maya untuk menerima kod pengesahan

album foto dinamik

album foto dinamik