Tutorial Komuniti DataCamp ini, disunting untuk kejelasan dan ketepatan, meneroka model asas teks imej, yang memberi tumpuan kepada model Captioner Contressve Inovatif (COCA). Coca secara unik menggabungkan objektif pembelajaran yang kontras dan generatif, mengintegrasikan kekuatan model seperti klip dan simvlm menjadi seni bina tunggal.

Model Yayasan: menyelam dalam

Model asas, yang terlatih pada dataset besar-besaran, boleh disesuaikan untuk pelbagai tugas hiliran. Walaupun NLP telah melihat lonjakan model asas (GPT, Bert), model penglihatan dan penglihatan masih berkembang. Penyelidikan telah meneroka tiga pendekatan utama: model penyenaraian tunggal, dwi-pengoder teks imej dengan kehilangan kontras, dan model pengekodkan pengekod dengan objektif generatif. Setiap pendekatan mempunyai batasan.

Istilah utama:

perbandingan model:

Coca bertujuan menyatukan kekuatan pendekatan yang kontras dan generatif. Ia menggunakan kerugian yang kontras untuk menyelaraskan imej dan perwakilan teks dan objektif generatif (kehilangan keterangan) untuk mewujudkan perwakilan bersama.

COCA Architecture:

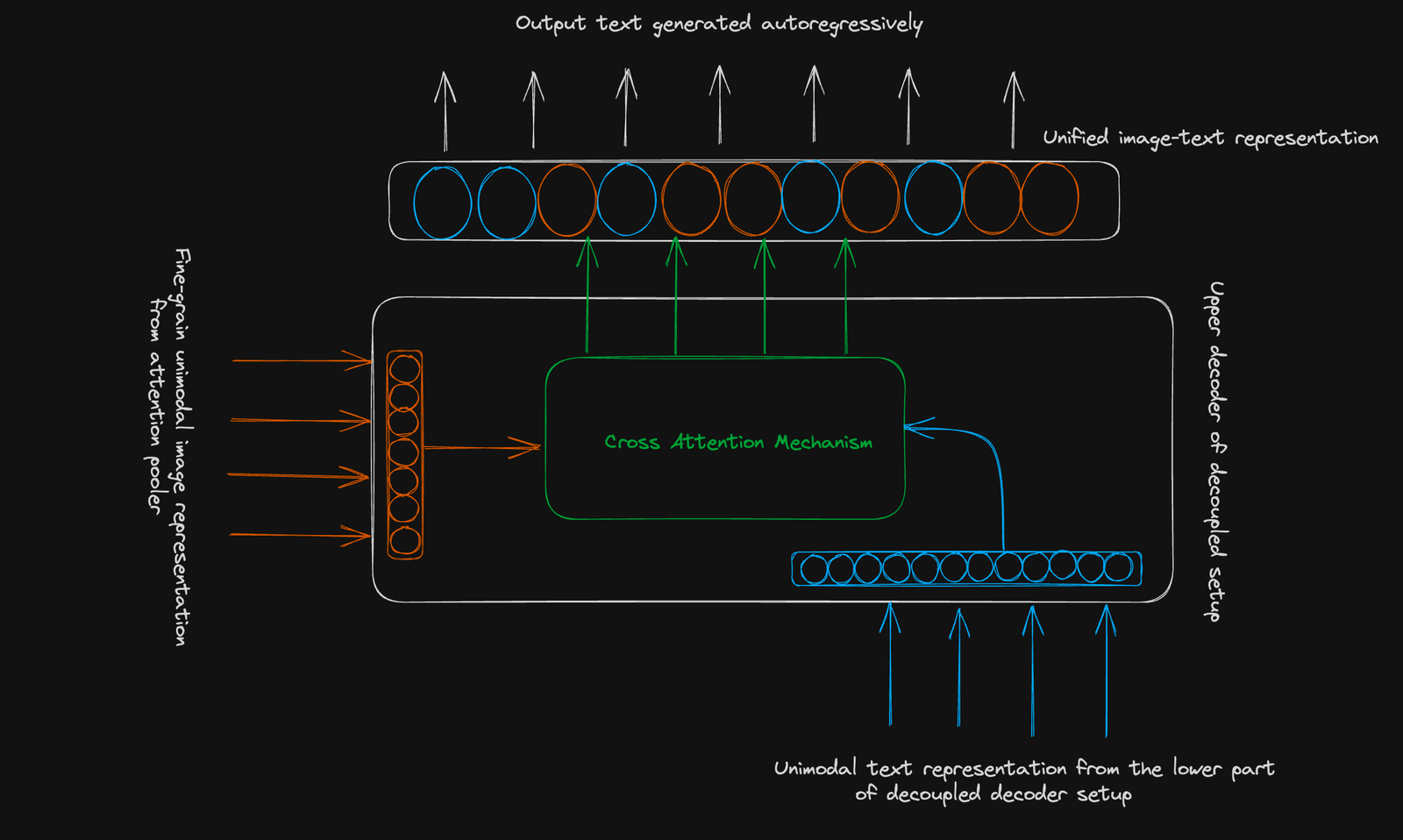

Coca menggunakan struktur pengekodan pengekod standard. Inovasinya terletak pada decoder

decoupled: Objektif Kontrasif: Belajar untuk pasangan pasangan imej yang berkaitan dengan kluster dan yang berasingan yang tidak berkaitan dalam ruang vektor bersama. Satu embedding imej yang dikumpulkan digunakan. Objektif Generatif: Menggunakan perwakilan imej halus (urutan 256 dimensi) dan perhatian silang modal untuk meramalkan teks secara autoregresif. Kesimpulan: Coca mewakili kemajuan yang ketara dalam model asas teks imej. Pendekatan gabungannya meningkatkan prestasi dalam pelbagai tugas, menawarkan alat serba boleh untuk aplikasi hiliran. Untuk meneruskan pemahaman anda tentang konsep pembelajaran yang maju, pertimbangkan pembelajaran mendalam DataCamp dengan kursus Keras. Bacaan Lanjut:

Atas ialah kandungan terperinci COCA: Kapsyen kontras adalah model asas teks imej yang dijelaskan secara visual. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!