Rangkaian Neural Berulang: LSTM vs Gru - Panduan Praktikal

Saya dengan jelas ingat menghadapi rangkaian saraf berulang (RNNs) semasa kerja kursus saya. Walaupun data urutan pada mulanya menawan saya, pelbagai seni bina dengan cepat menjadi mengelirukan. Tanggapan penasihat biasa, "ia bergantung," hanya menguatkan ketidakpastian saya. Eksperimen yang luas dan banyak projek kemudian, pemahaman saya tentang masa menggunakan LSTMS berbanding Grus telah bertambah baik. Panduan ini bertujuan untuk menjelaskan proses membuat keputusan untuk projek anda yang seterusnya. Kami akan menyelidiki butiran LSTM dan Grus untuk membantu anda membuat pilihan yang tepat.

Rangkaian memori jangka pendek (LSTM) yang panjang, yang diperkenalkan pada tahun 1997, menangani masalah kecerunan yang hilang dalam RNN tradisional. Inti mereka adalah sel memori yang mampu mengekalkan maklumat dalam tempoh yang panjang, yang diuruskan oleh tiga pintu:

Kawalan berbutir ini ke atas aliran maklumat membolehkan LSTMS untuk menangkap kebergantungan jarak jauh dalam urutan.

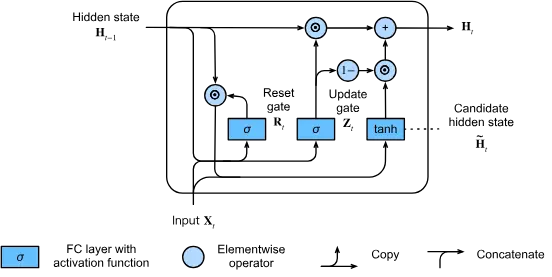

Unit Berulang Gated (Grus), yang dibentangkan pada tahun 2014, memudahkan seni bina LSTM sambil mengekalkan banyak keberkesanannya. Grus hanya menggunakan dua pintu:

Reka bentuk yang diselaraskan ini menghasilkan kecekapan pengiraan yang lebih baik sementara masih berkesan mengurangkan masalah kecerunan yang hilang.

Grus cemerlang dalam:

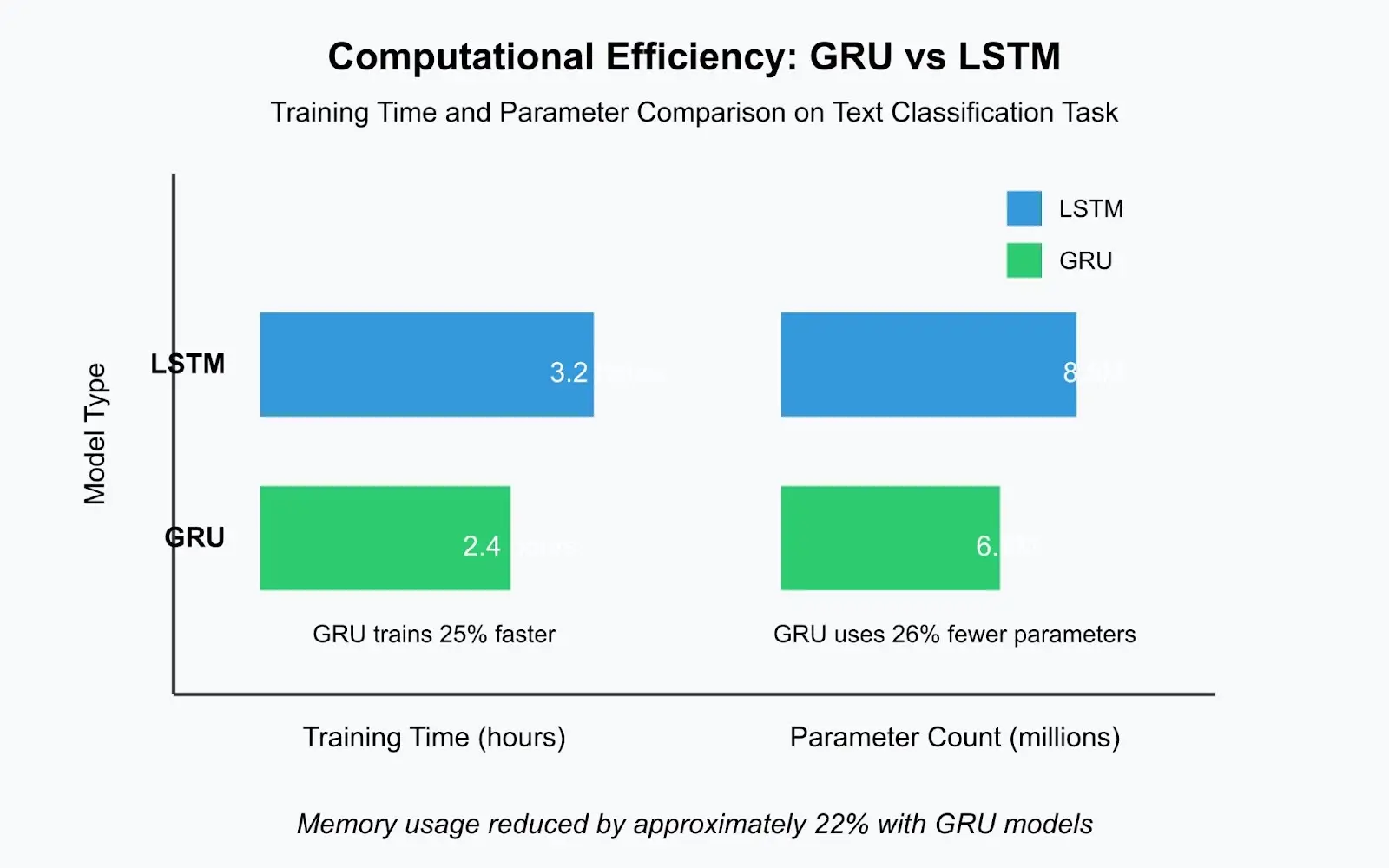

Grus biasanya melatih 20-30% lebih cepat daripada LSTM yang setanding kerana struktur yang lebih mudah dan parameter yang lebih sedikit. Dalam projek klasifikasi teks baru -baru ini, model GRU dilatih dalam 2.4 jam berbanding dengan 3.2 jam LSTM -perbezaan besar semasa pembangunan berulang.

LSTMS lebih unggul untuk:

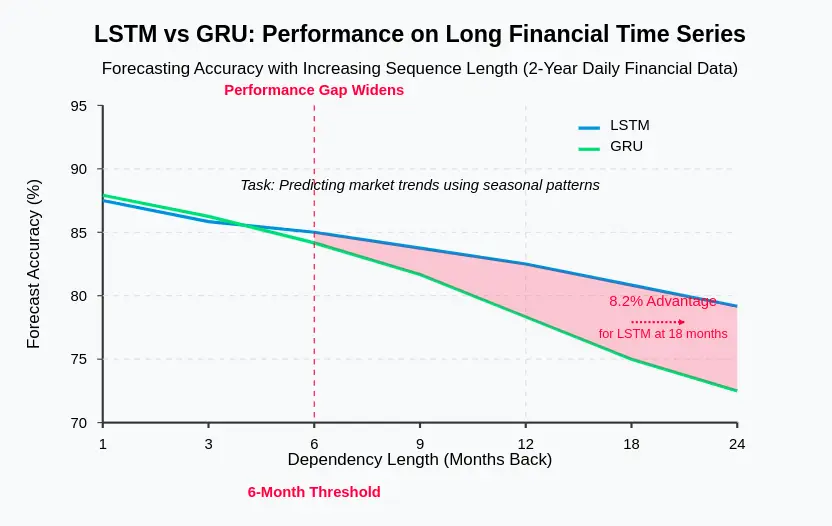

Dalam peramalan siri masa kewangan menggunakan data harian tahun, LSTMS secara konsisten mengatasi Grus dalam meramalkan trend yang bergantung kepada corak bermusim dari beberapa bulan sebelumnya. Sel memori yang berdedikasi di LSTMS menyediakan kapasiti yang diperlukan untuk pengekalan maklumat jangka panjang.

Grus sering menunjukkan:

Grus kerap berkumpul lebih cepat, kadang -kadang mencapai prestasi yang memuaskan dengan 25% lebih sedikit zaman daripada LSTMS. Ini mempercepatkan percubaan dan meningkatkan produktiviti.

Grus berfaedah untuk:

Model bahasa LSTM pengeluaran untuk aplikasi perkhidmatan pelanggan memerlukan penyimpanan 42MB, manakala setara GRU hanya memerlukan 31MB -pengurangan 26% pengurangan penggunaan ke peranti kelebihan.

Bagi kebanyakan tugas NLP dengan panjang urutan sederhana (20-100 token), Grus sering melakukan perbandingan atau lebih baik daripada LSTM semasa latihan lebih cepat. Walau bagaimanapun, untuk tugas yang melibatkan dokumen yang sangat panjang atau pemahaman bahasa yang rumit, LSTMS mungkin menawarkan kelebihan.

Untuk ramalan dengan pelbagai corak bermusim atau ketergantungan jangka panjang, LSTMS umumnya cemerlang. Sel memori eksplisit mereka secara berkesan menangkap corak temporal yang kompleks.

Dalam pengiktirafan pertuturan dengan panjang urutan sederhana, Grus sering mengalahkan LSTM dari segi kecekapan pengiraan sambil mengekalkan ketepatan yang setanding.

Apabila memilih antara LSTM dan Grus, pertimbangkan faktor -faktor ini:

Pertimbangkan pendekatan hibrid: Menggunakan Grus untuk pengekodan dan LSTM untuk penyahkodan, menyusun jenis lapisan yang berlainan, atau kaedah ensemble. Senibina berasaskan transformer telah banyak menggantikan LSTM dan GRUS untuk banyak tugas NLP, tetapi model berulang tetap berharga untuk analisis siri masa dan senario di mana mekanisme perhatian adalah mahal.

Memahami kekuatan dan kelemahan LSTM dan Grus adalah kunci untuk memilih seni bina yang sesuai. Umumnya, Grus adalah titik permulaan yang baik kerana kesederhanaan dan kecekapan mereka. Hanya beralih ke LSTM jika bukti menunjukkan peningkatan prestasi untuk aplikasi khusus anda. Ingatlah bahawa kejuruteraan ciri yang berkesan, pra -proses data, dan regularization sering memberi impak yang lebih besar kepada prestasi model daripada pilihan antara LSTM dan Grus. Dokumentasikan proses membuat keputusan dan keputusan eksperimen untuk rujukan masa depan.

Atas ialah kandungan terperinci Bilakah menggunakan Grus melalui LSTMS?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apakah pemalam komposer?

Apakah pemalam komposer?

Bolehkah data antara sistem Hongmeng dan sistem Android boleh beroperasi?

Bolehkah data antara sistem Hongmeng dan sistem Android boleh beroperasi?

Bagaimana untuk membuka fail nrg

Bagaimana untuk membuka fail nrg

Apa yang Matcha Exchange lakukan?

Apa yang Matcha Exchange lakukan?

Cara menggunakan fungsi datediff

Cara menggunakan fungsi datediff

Bagaimana untuk mewakili nombor negatif dalam binari

Bagaimana untuk mewakili nombor negatif dalam binari

acara oncontextmenu

acara oncontextmenu

Apakah kekunci yang dirujuk oleh anak panah dalam komputer?

Apakah kekunci yang dirujuk oleh anak panah dalam komputer?

Detik WeChat, dua sengkang dan satu titik

Detik WeChat, dua sengkang dan satu titik