总的来看Java在技术方面远远超过PHP,不考虑成本问题(大公司应该承受的起),为什么百度首页不用JSP写?及时搜索不需要分布式么?而且在输入的时候会自动加载一些结果什么的。

能把这本书发出来吗?

我要把这个出版社拉黑。

泻药。

首先我们来看看百度首页是不是真的用的是php,http://www.baidu,com/index.php无疑是可以打开的,但是我们也知道,可以通过对HTTP服务软件层面进行路由设置,使得这个地址实际解析到其他内容,比如静态文件或者是其他CGI处理的资源,比如伪静态的实现是将html路由到其他动态资源,比如php(考虑到缓存,也有可能是静态资源),所以单凭这个无法确定是否是php。

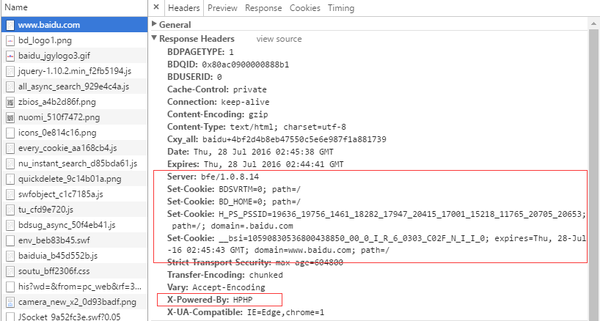

于是用chrome打开百度,

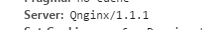

我们需要看的信息是红色框框出来的内容,首先我们看到Sever的值被设置成了bfe/1.0.8.14,http头中的server字段一般是http服务器的名称,比如知乎:

Qnginx,猜测可能是魔改Nginx吧。百度的bfe,要么是自家产品,要么有可能也是改动了nginx之类的源代码,这个参见百度首页用的什么服务器?

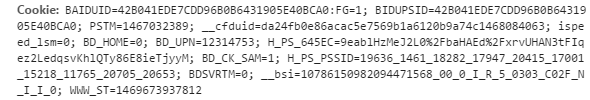

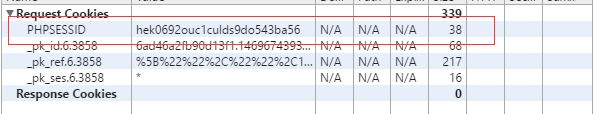

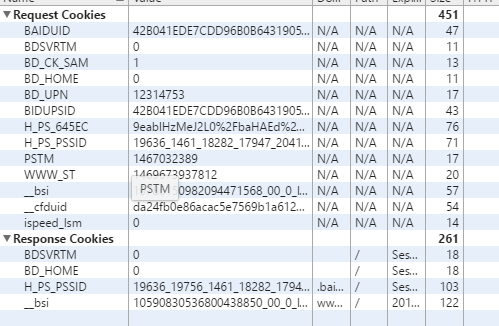

那么我们再看看setcookie里面,设置的cookie内容。我们知道,一般php自身设置的cookie会有类似下面这样的字段:

然而我们看看百度的:

有很多以百度命名的Token字段,没有采用php自带的cookie,也看起来不像很多语言/框架自带的cookie,后文会讲。

我们再看看在百度首页的请求中有一个字段:

HPHP,这是HHVM,如果不是百度使用代

理或者在HTTP服务器层面上修改头或者修改HHVM(百度应该也不会这么闲的蛋疼去改一个不是机密的东西),那么应该就是用PHP了。那么我们解释一下为什么不用默认的(默认的cookie会出现PHPSESSID的字段)

session_start()

facebook还是PHp写的呢,新浪微博和腾讯网也是。知乎还是用Python呢

不谈题主贴的资料准确与否

百度首页的PHP只是做结果渲染,搜索引擎本身应该不是基于PHP的

我勒个擦。。

身为一个百度员工,半夜看到这个问题,瞬间精神了。。

一个是笑的,一个是内心深处忍不住深深的吐槽之情。。

你是个学生吧?还是说没有接触过超大型的项目。你有机会去个大公司,接触一下,你就明白这个问题真的好蠢。。

最近公司很招黑,我还是匿名吧,懒得跟人吵架。

首先,php是可以做页面渲染的,但是你但凡搞过框架就应该知道,这个url请求会经过分发,分发到哪里就有很大的自主操作空间了。

首先,中间分发这个肯定不是你想象中的那么简单,每天上亿次请求,肯定会有各种cache,全国各地集群分布,等等。

况且,为了加快首页加载速度,肯定是要改成C优化的。

然后,你输入的时候,就分发到了相应的检索集群上。

这个的代码是C++,为什么?因为我亲自改过。。

这里又分成很多模块。。

举个例子,一个单词从你输入到搜索框,到最后取出数据,中间的过程,说简单的确很简单。。

就是爬虫抓取数据,然后根据这些数据建索引嘛。

问题是,每个细节做到最好,这复杂度就很高了。

分词的话,你如何能够更加准确?直接用个开源库?开玩笑呢你?就这个最好就要一个专业的团队去负责,还是偏研究性的,得招一堆博士,研究生去搞。

好了,分好词了,我们要取索引了。

如何在毫秒内,在千亿的结果中,找到对应的数据?

然后给他们排序,返回用户想要的结果?听起来是不是很复杂?

其实,这个说起来也不麻烦,倒排拉链嘛,然后做好cache,其实百分之九十的搜索都是百分之十的单词。

不过数据量有点大,所以这个索引可能全部放不到内存,部分放到硬盘上呗,问题是硬盘上速度慢,我们可否做点优化?

然后如何选择最合适的给用户?这个策略上又有不少优化点,做好了又得一批人。

这还只是检索。

爬虫那一块,我们每天爬下来的数据超出一般人的想象,如何高效的爬,好提供给检索端更加靠谱的数据。

这个又是一堆人搞。

但是问题又来了,你发现数据量太大了,这数据怎么存?怎么更好的管理?

这不都是要花大量的人力去搞。。

哦,还有凤巢,这个天天被你们黑的。

因为关系到钱,也是投入了大量的人力去做各种各样的策略,数据优化。

所以,看到你这个问题。。。。

真的是觉得,什么鬼,去接触下一个超大级别的项目。

你会发现,基本上都是在某个时刻就有一个最适应的语言,那就去用就好了。

百度一开始就几个人,用户有几十万就不错了,赶紧上个网站有的用就可以了,还考虑啥效率。后端索引,一开始没有hadoop的时候,机器维护老有问题,那就派几个人天天手工维护呗。

然后,后期发现php不好用了,就想想优化呗。

反正业务坐上去了,也有钱了,请一堆牛人使劲折腾,肯定能想出办法。

当然,搜索引擎从技术方面的确还是很有门槛的,现在各种框架,云计算成熟了,好做了很多,当年做起来的确还是有很大的技术壁垒的。

至少比搭个网站难度要高上个几十倍。

但语言绝对不是最大的问题。。

你就会发现,你竟然还在这里纠结语言,是不是很蠢?

php提供的数据库接口不统一。。。。。。多少年前的事了。。。pdo一出就早解决了。题主截取的很多观点都是比较片面和老旧了,现在的PHP综合来说已经是WEB业务的霸主了,jsp在大型业务虽然有优势,但是总体来说php在很多方面已经能和它平分秋色。还有。。。谁告诉你百度的搜索引擎是PHP了。。。

首页就是一层皮,用什么写都差距不大。搜索当然是分布式的,但是都是以服务方式提供,和首页也没有什么关系。至于自动加载些结果什么的,也是js发个请求,后台也是服务方式提供的。至于后台的服务,不知道百度具体是怎么实现的,有各种语言和方案可以选择,选个合适自己的就好。搜索的确有很多方案是基于java实现的,但是并不表示离了java就搞不了。php和jsp也不是什么升级替代关系,只能说各有所长,php之所以显得弱鸡,只是国内写php的人大部分弱鸡。即使facebook切到hhvm之前的php,也能轻松支撑每天10亿+请求,用的服务器也不是特别多。没有具体数据,但是有人推测fb当时的php单机qps在3000-5000左右,并不比jsp单机存在数量级差距。我任职某司php单机峰值在700qps左右,主要是代码写的混乱,性能太差。而淘宝的分享说明,某些php业务集群里的单机qps只有200-300。这只能说明是人的问题。最后建议多看看架构方面的文章,这类问题的答案自然蕴含其中。

你认为百度搜索引擎就一个首页么

PHP是世界上最美丽的语言

天啊~

以上就是既然JSP适合做大型网站,为什么百度主页还是PHP写的?的内容,更多相关内容请关注PHP中文网(www.php.cn)!

Bagaimana untuk melaksanakan fungsi paging jsp

Bagaimana untuk melaksanakan fungsi paging jsp

Bagaimana untuk membuka fail php

Bagaimana untuk membuka fail php

Bagaimana untuk membuka jsp

Bagaimana untuk membuka jsp

Bagaimana untuk membuka format jsp

Bagaimana untuk membuka format jsp

Bagaimana untuk mengalih keluar beberapa elemen pertama tatasusunan dalam php

Bagaimana untuk mengalih keluar beberapa elemen pertama tatasusunan dalam php

Apa yang perlu dilakukan jika penyahserialisasian php gagal

Apa yang perlu dilakukan jika penyahserialisasian php gagal

Cara menggunakan perisian pengaturcaraan jsp

Cara menggunakan perisian pengaturcaraan jsp

Bagaimana untuk menyambungkan php ke pangkalan data mssql

Bagaimana untuk menyambungkan php ke pangkalan data mssql