详解小程序的python和bash版本比较

最近有一个小需求:在一个目录下有很多文件,每个文件的第一行是BEGIN开头的,最后一行是END开头的,中间每一行有多列,数量不等,第一列称为"DN", 第二列称为"CV",DN和CV的联合作为主键,现在需要检测文件中是否有重复的DN-CV。

于是写了个简单的python程序

#! /usr/bin/python

import os

import sys

cmd = "cat /home/zhangj/hosts/* | grep -v BEGIN | grep -v END"

def check_dc_line():

has_duplicate = False

dc_set = set()

for dc_line in os.popen(cmd, 'r').readlines():

dc_token = dc_line.split()

dn = dc_token[0]

cv = dc_token[1]

dc = dn + "," + cv

if dc in dc_set:

print "duplicate dc found:", dc

has_duplicate = True

else:

dc_set.add(dc)

return has_duplicate

if not check_dc_line():

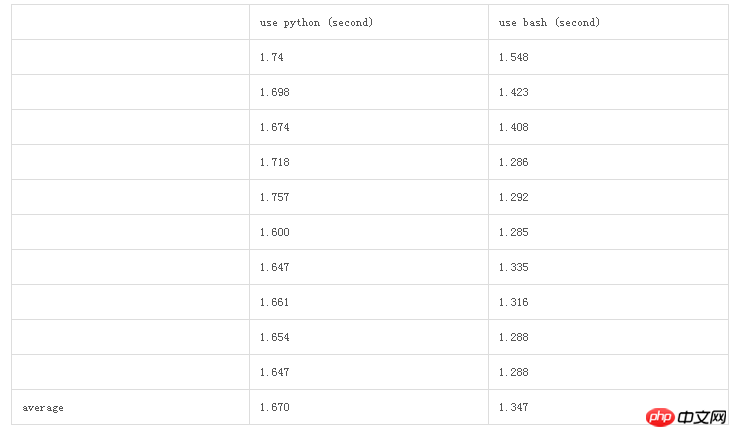

print "no duplicate dc"对于250个文件,共60万行的数据,过滤一遍约1.67秒

有点不甘心这个效率,于是又写了一个同样功能的shell脚本

#! /bin/bash

cat /home/zhangj/hosts/* | grep -v BEGIN | grep -v END | awk '

BEGIN {

has_duplicate = 0

}

{

dc = $1","$2;

if (dc in dc_set)

{

print "duplicate dc found", dc

has_duplicate = 1

}

else {

dc_set[dc] = 1

}

}

END {

if (has_duplicate ==0)

{

print "no duplicate dc found"

}

}

'为了进一步比较,重复了10次实验。

Atas ialah kandungan terperinci 详解小程序的python和bash版本比较. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1393

1393

52

52

37

37

110

110