Python爬取51cto数据并存入MySQL方法详解

【相关学习推荐:python教程】

实验环境

1.安装Python 3.7

2.安装requests, bs4,pymysql 模块

实验步骤1.安装环境及模块

可参考https://www.jb51.net/article/194104.htm

2.编写代码

# 51cto 博客页面数据插入mysql数据库

# 导入模块

import re

import bs4

import pymysql

import requests

# 连接数据库账号密码

db = pymysql.connect(host='172.171.13.229',

user='root', passwd='abc123',

db='test', port=3306,

charset='utf8')

# 获取游标

cursor = db.cursor()

def open_url(url):

# 连接模拟网页访问

headers = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) '

'Chrome/57.0.2987.98 Safari/537.36'}

res = requests.get(url, headers=headers)

return res

# 爬取网页内容

def find_text(res):

soup = bs4.BeautifulSoup(res.text, 'html.parser')

# 博客名

titles = []

targets = soup.find_all("a", class_="tit")

for each in targets:

each = each.text.strip()

if "置顶" in each:

each = each.split(' ')[0]

titles.append(each)

# 阅读量

reads = []

read1 = soup.find_all("p", class_="read fl on")

read2 = soup.find_all("p", class_="read fl")

for each in read1:

reads.append(each.text)

for each in read2:

reads.append(each.text)

# 评论数

comment = []

targets = soup.find_all("p", class_='comment fl')

for each in targets:

comment.append(each.text)

# 收藏

collects = []

targets = soup.find_all("p", class_='collect fl')

for each in targets:

collects.append(each.text)

# 发布时间

dates=[]

targets = soup.find_all("a", class_='time fl')

for each in targets:

each = each.text.split(':')[1]

dates.append(each)

# 插入sql 语句

sql = """insert into blog (blog_title,read_number,comment_number, collect, dates)

values( '%s', '%s', '%s', '%s', '%s');"""

# 替换页面 \xa0

for titles, reads, comment, collects, dates in zip(titles, reads, comment, collects, dates):

reads = re.sub('\s', '', reads)

comment = re.sub('\s', '', comment)

collects = re.sub('\s', '', collects)

cursor.execute(sql % (titles, reads, comment, collects,dates))

db.commit()

pass

# 统计总页数

def find_depth(res):

soup = bs4.BeautifulSoup(res.text, 'html.parser')

depth = soup.find('li', class_='next').previous_sibling.previous_sibling.text

return int(depth)

# 主函数

def main():

host = "https://blog.51cto.com/13760351"

res = open_url(host) # 打开首页链接

depth = find_depth(res) # 获取总页数

# 爬取其他页面信息

for i in range(1, depth + 1):

url = host + '/p' + str(i) # 完整链接

res = open_url(url) # 打开其他链接

find_text(res) # 爬取数据

# 关闭游标

cursor.close()

# 关闭数据库连接

db.close()

if __name__ == '__main__':

main()3..MySQL创建对应的表

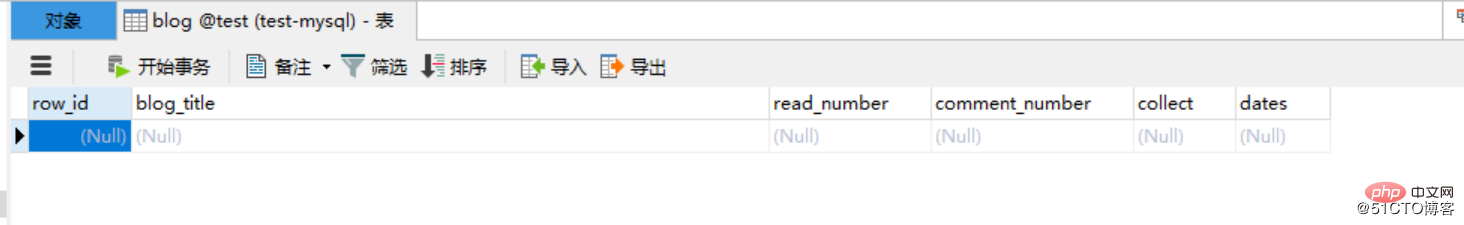

CREATE TABLE `blog` ( `row_id` int(11) NOT NULL AUTO_INCREMENT COMMENT '主键', `blog_title` varchar(52) DEFAULT NULL COMMENT '博客标题', `read_number` varchar(26) DEFAULT NULL COMMENT '阅读数量', `comment_number` varchar(16) DEFAULT NULL COMMENT '评论数量', `collect` varchar(16) DEFAULT NULL COMMENT '收藏数量', `dates` varchar(16) DEFAULT NULL COMMENT '发布日期', PRIMARY KEY (`row_id`) ) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8;

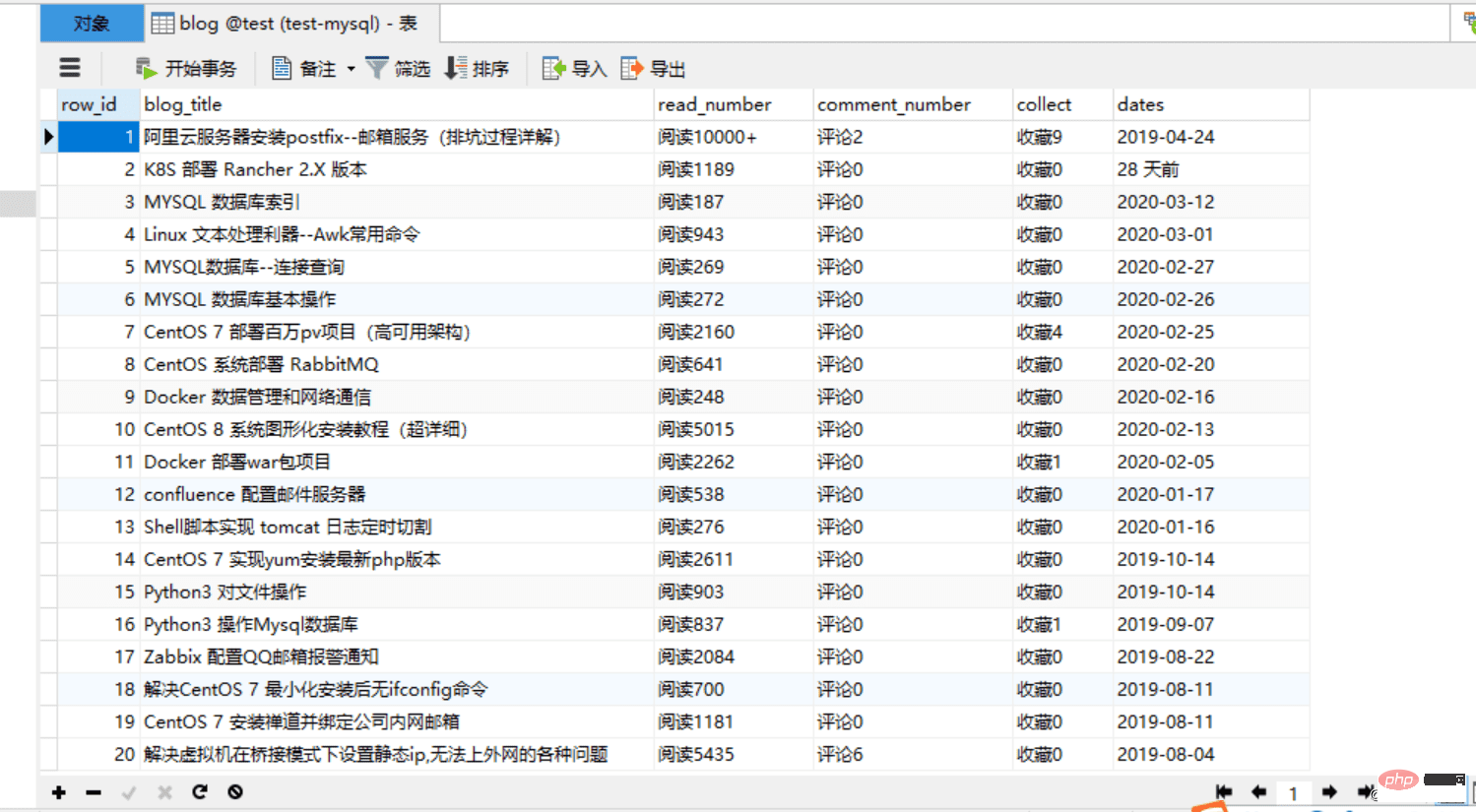

4.运行代码,查看效果:

改进版:

改进内容:

1.数据库里面的某些字段只保留数字即可

2.默认爬取的内容都是字符串,存放数据库的某些字段,最好改为整型,方便后面数据库操作

1.代码如下:

import re

import bs4

import pymysql

import requests

# 连接数据库

db = pymysql.connect(host='172.171.13.229',

user='root', passwd='abc123',

db='test', port=3306,

charset='utf8')

# 获取游标

cursor = db.cursor()

def open_url(url):

# 连接模拟网页访问

headers = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) '

'Chrome/57.0.2987.98 Safari/537.36'}

res = requests.get(url, headers=headers)

return res

# 爬取网页内容

def find_text(res):

soup = bs4.BeautifulSoup(res.text, 'html.parser')

# 博客标题

titles = []

targets = soup.find_all("a", class_="tit")

for each in targets:

each = each.text.strip()

if "置顶" in each:

each = each.split(' ')[0]

titles.append(each)

# 阅读量

reads = []

read1 = soup.find_all("p", class_="read fl on")

read2 = soup.find_all("p", class_="read fl")

for each in read1:

reads.append(each.text)

for each in read2:

reads.append(each.text)

# 评论数

comment = []

targets = soup.find_all("p", class_='comment fl')

for each in targets:

comment.append(each.text)

# 收藏

collects = []

targets = soup.find_all("p", class_='collect fl')

for each in targets:

collects.append(each.text)

# 发布时间

dates=[]

targets = soup.find_all("a", class_='time fl')

for each in targets:

each = each.text.split(':')[1]

dates.append(each)

# 插入sql 语句

sql = """insert into blogs (blog_title,read_number,comment_number, collect, dates)

values( '%s', '%s', '%s', '%s', '%s');"""

# 替换页面 \xa0

for titles, reads, comment, collects, dates in zip(titles, reads, comment, collects, dates):

reads = re.sub('\s', '', reads)

reads=int(re.sub('\D', "", reads)) #匹配数字,转换为整型

comment = re.sub('\s', '', comment)

comment = int(re.sub('\D', "", comment)) #匹配数字,转换为整型

collects = re.sub('\s', '', collects)

collects = int(re.sub('\D', "", collects)) #匹配数字,转换为整型

dates = re.sub('\s', '', dates)

cursor.execute(sql % (titles, reads, comment, collects,dates))

db.commit()

pass

# 统计总页数

def find_depth(res):

soup = bs4.BeautifulSoup(res.text, 'html.parser')

depth = soup.find('li', class_='next').previous_sibling.previous_sibling.text

return int(depth)

# 主函数

def main():

host = "https://blog.51cto.com/13760351"

res = open_url(host) # 打开首页链接

depth = find_depth(res) # 获取总页数

# 爬取其他页面信息

for i in range(1, depth + 1):

url = host + '/p' + str(i) # 完整链接

res = open_url(url) # 打开其他链接

find_text(res) # 爬取数据

# 关闭游标

cursor.close()

# 关闭数据库连接

db.close()

#主程序入口

if __name__ == '__main__':

main()2.创建对应表

CREATE TABLE `blogs` ( `row_id` int(11) NOT NULL AUTO_INCREMENT COMMENT '主键', `blog_title` varchar(52) DEFAULT NULL COMMENT '博客标题', `read_number` int(26) DEFAULT NULL COMMENT '阅读数量', `comment_number` int(16) DEFAULT NULL COMMENT '评论数量', `collect` int(16) DEFAULT NULL COMMENT '收藏数量', `dates` varchar(16) DEFAULT NULL COMMENT '发布日期', PRIMARY KEY (`row_id`) ) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8;

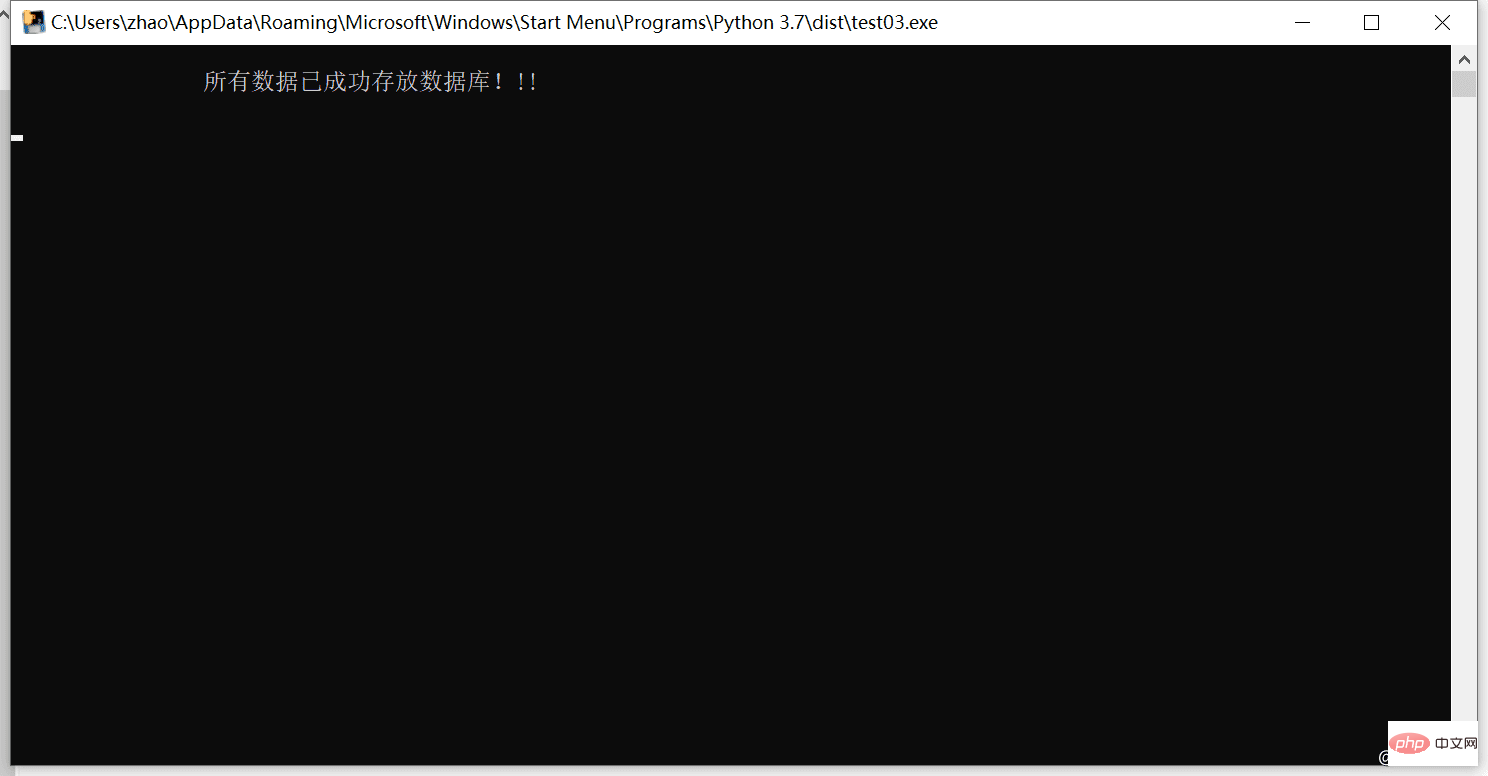

3.运行代码,验证

升级版

为了能让小白就可以使用这个程序,可以把这个项目打包成exe格式的文件,让其他人,使用电脑就可以运行代码,这样非常方便!

1.改进代码:

#末尾修改为:

if __name__ == '__main__':

main()

print("\n\t\t所有数据已成功存放数据库!!! \n")

time.sleep(5)2.安装打包模块pyinstaller(cmd安装)

pip install pyinstaller -i https://pypi.tuna.tsinghua.edu.cn/simple/

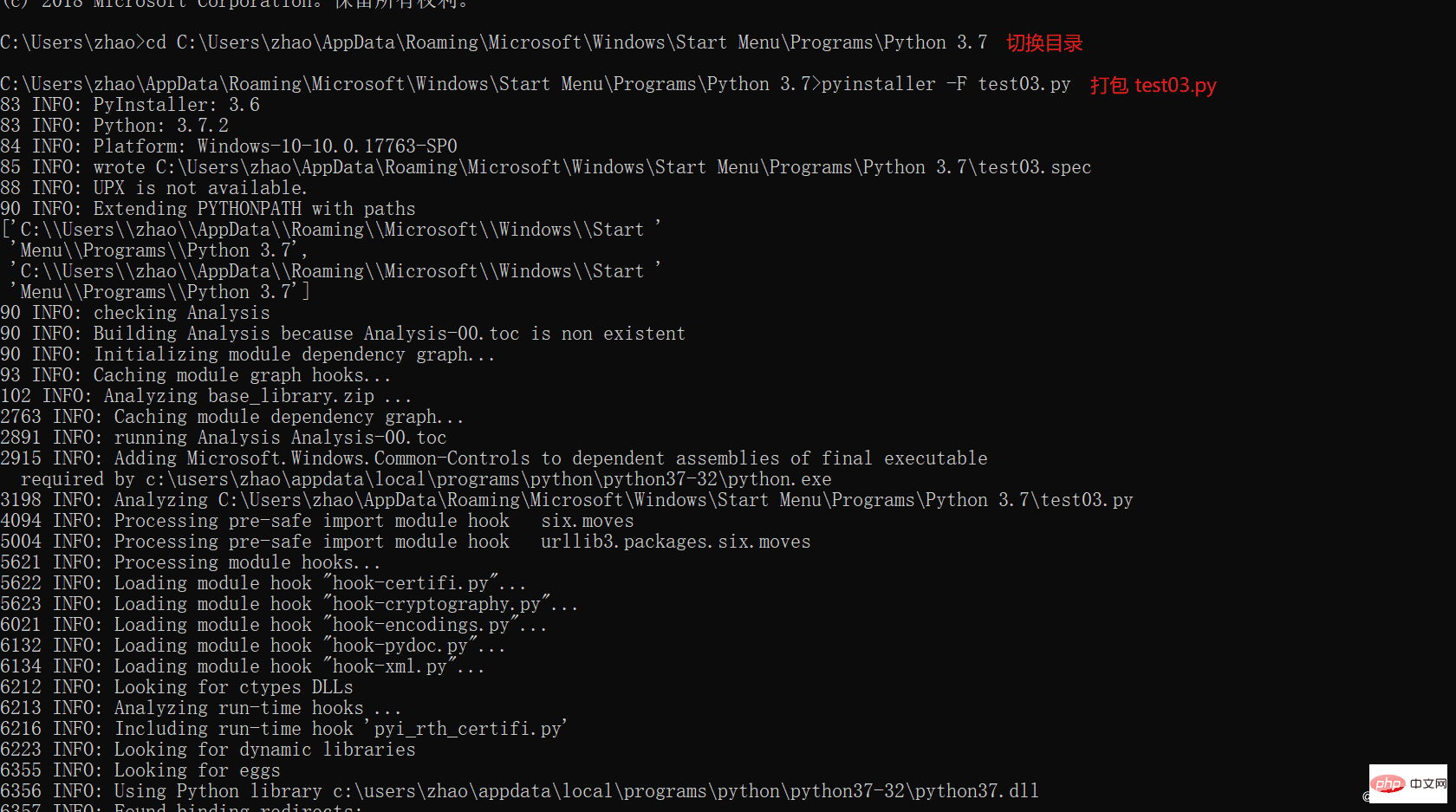

3.Python代码打包

1.切换到需要打包代码的路径下面

2.在cmd窗口运行 pyinstaller -F test03.py (test03为项目名称)

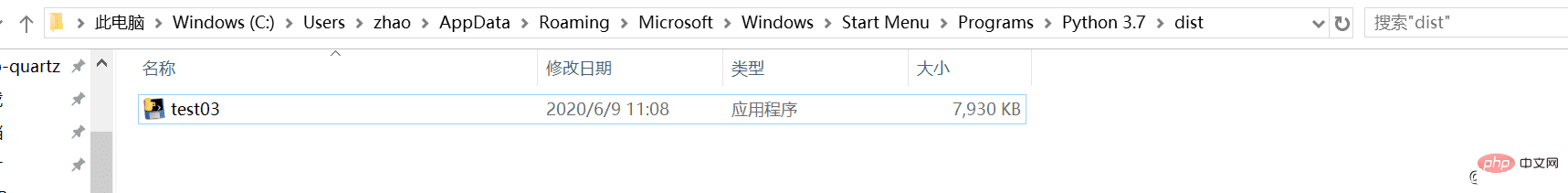

4.查看exe包

在打包后会出现dist目录,打好包就在这个目录里面

5.运行exe包,查看效果

检查数据库

相关学习推荐:mysql教程

Atas ialah kandungan terperinci Python爬取51cto数据并存入MySQL方法详解. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1393

1393

52

52

37

37

110

110

PHP dan Python: Paradigma yang berbeza dijelaskan

Apr 18, 2025 am 12:26 AM

PHP dan Python: Paradigma yang berbeza dijelaskan

Apr 18, 2025 am 12:26 AM

PHP terutamanya pengaturcaraan prosedur, tetapi juga menyokong pengaturcaraan berorientasikan objek (OOP); Python menyokong pelbagai paradigma, termasuk pengaturcaraan OOP, fungsional dan prosedur. PHP sesuai untuk pembangunan web, dan Python sesuai untuk pelbagai aplikasi seperti analisis data dan pembelajaran mesin.

Memilih antara php dan python: panduan

Apr 18, 2025 am 12:24 AM

Memilih antara php dan python: panduan

Apr 18, 2025 am 12:24 AM

PHP sesuai untuk pembangunan web dan prototaip pesat, dan Python sesuai untuk sains data dan pembelajaran mesin. 1.Php digunakan untuk pembangunan web dinamik, dengan sintaks mudah dan sesuai untuk pembangunan pesat. 2. Python mempunyai sintaks ringkas, sesuai untuk pelbagai bidang, dan mempunyai ekosistem perpustakaan yang kuat.

Peranan MySQL: Pangkalan Data dalam Aplikasi Web

Apr 17, 2025 am 12:23 AM

Peranan MySQL: Pangkalan Data dalam Aplikasi Web

Apr 17, 2025 am 12:23 AM

Peranan utama MySQL dalam aplikasi web adalah untuk menyimpan dan mengurus data. 1.MYSQL dengan cekap memproses maklumat pengguna, katalog produk, rekod urus niaga dan data lain. 2. Melalui pertanyaan SQL, pemaju boleh mengekstrak maklumat dari pangkalan data untuk menghasilkan kandungan dinamik. 3.MYSQL berfungsi berdasarkan model klien-pelayan untuk memastikan kelajuan pertanyaan yang boleh diterima.

PHP dan Python: menyelam mendalam ke dalam sejarah mereka

Apr 18, 2025 am 12:25 AM

PHP dan Python: menyelam mendalam ke dalam sejarah mereka

Apr 18, 2025 am 12:25 AM

PHP berasal pada tahun 1994 dan dibangunkan oleh Rasmuslerdorf. Ia pada asalnya digunakan untuk mengesan pelawat laman web dan secara beransur-ansur berkembang menjadi bahasa skrip sisi pelayan dan digunakan secara meluas dalam pembangunan web. Python telah dibangunkan oleh Guidovan Rossum pada akhir 1980 -an dan pertama kali dikeluarkan pada tahun 1991. Ia menekankan kebolehbacaan dan kesederhanaan kod, dan sesuai untuk pengkomputeran saintifik, analisis data dan bidang lain.

Cara menjalankan python dengan notepad

Apr 16, 2025 pm 07:33 PM

Cara menjalankan python dengan notepad

Apr 16, 2025 pm 07:33 PM

Running Python Code di Notepad memerlukan Python Executable dan NPPExec plug-in untuk dipasang. Selepas memasang Python dan menambahkan laluannya, konfigurasikan perintah "python" dan parameter "{current_directory} {file_name}" dalam plug-in nppexec untuk menjalankan kod python melalui kunci pintasan "f6" dalam notepad.

Selesaikan masalah sambungan pangkalan data: Kes praktikal menggunakan perpustakaan mini/db

Apr 18, 2025 am 07:09 AM

Selesaikan masalah sambungan pangkalan data: Kes praktikal menggunakan perpustakaan mini/db

Apr 18, 2025 am 07:09 AM

Saya menghadapi masalah yang rumit ketika membangunkan aplikasi kecil: keperluan untuk mengintegrasikan perpustakaan operasi pangkalan data ringan dengan cepat. Selepas mencuba beberapa perpustakaan, saya mendapati bahawa mereka mempunyai terlalu banyak fungsi atau tidak serasi. Akhirnya, saya dapati Minii/DB, versi mudah berdasarkan YII2 yang menyelesaikan masalah saya dengan sempurna.

Contoh Pengenalan Laravel

Apr 18, 2025 pm 12:45 PM

Contoh Pengenalan Laravel

Apr 18, 2025 pm 12:45 PM

Laravel adalah rangka kerja PHP untuk membina aplikasi web yang mudah. Ia menyediakan pelbagai ciri yang kuat termasuk: Pemasangan: Pasang Laravel CLI secara global dengan komposer dan buat aplikasi dalam direktori projek. Routing: Tentukan hubungan antara URL dan pengendali dalam laluan/web.php. Lihat: Buat pandangan dalam sumber/pandangan untuk menjadikan antara muka aplikasi. Integrasi Pangkalan Data: Menyediakan integrasi keluar-of-the-box dengan pangkalan data seperti MySQL dan menggunakan penghijrahan untuk membuat dan mengubah suai jadual. Model dan Pengawal: Model mewakili entiti pangkalan data dan proses pengawal permintaan HTTP.

Golang vs Python: Konvensyen dan Multithreading

Apr 17, 2025 am 12:20 AM

Golang vs Python: Konvensyen dan Multithreading

Apr 17, 2025 am 12:20 AM

Golang lebih sesuai untuk tugas -tugas kesesuaian yang tinggi, sementara Python mempunyai lebih banyak kelebihan dalam fleksibiliti. 1.Golang dengan cekap mengendalikan kesesuaian melalui goroutine dan saluran. 2. Pilihannya harus berdasarkan keperluan khusus.